Кластерные стандартные ошибки измерения, которые оценивают стандартная ошибка из регресс параметр в настройках, где наблюдения могут быть подразделены на группы меньшего размера («кластеры») и где выборка и / или назначение лечения коррелированы внутри каждой группы.[1][2] Кластерные стандартные ошибки широко используются в различных прикладных эконометрических условиях, включая разница в различиях[3] или эксперименты.[4] Аналогично тому, как Хубер-Уайт стандартные ошибки последовательный в присутствии гетероскедастичность и Ньюи – Уэст стандартные ошибки согласуются при наличии точно смоделированных автокорреляция, сгруппированные (или «Лян-Цигер»[5]) стандартные ошибки согласованы при наличии выборки на основе кластеров или назначения лечения. Кластерные стандартные ошибки часто оправдываются возможной корреляцией в остатки моделирования внутри каждого кластера; хотя недавняя работа предполагает, что это не точное оправдание кластеризации,[6] это может быть педагогически полезно.

Интуитивная мотивация

Кластерные стандартные ошибки часто полезны, когда лечение назначается на уровне кластер а не на индивидуальном уровне. Например, предположим, что исследователь в области образования хочет выяснить, улучшает ли новый метод обучения результаты тестов учащихся. Поэтому она назначает учителей в «обработанные» классы, чтобы они испробовали эту новую технику, не затрагивая «контрольные» классы. Анализируя свои результаты, она может захотеть сохранить данные на уровне ученика (например, чтобы контролировать наблюдаемые характеристики на уровне ученика). Однако при оценке стандартная ошибка или доверительный интервал своей статистической модели, она понимает, что классический или даже устойчивый к гетероскедастичности стандартные ошибки неуместны, потому что результаты тестов учащихся в каждом классе не независимо распределены. Вместо этого ученики в классах с лучшими учителями имеют особенно высокие результаты тестов (независимо от того, проходят ли они экспериментальное лечение), в то время как ученики в классах с худшими учителями имеют особенно низкие результаты тестов. Исследователь может сгруппировать свои стандартные ошибки на уровне классной комнаты, чтобы учесть этот аспект своего эксперимента.

Хотя этот пример очень конкретен, аналогичные проблемы возникают в самых разных условиях. Например, во многих настройках данных панели (таких как разница в различиях ) кластеризация часто предлагает простой и эффективный способ учета отсутствия независимости между периодами в каждой единице (иногда называемый «автокорреляцией остатков»).[3] Другое распространенное и логически отличное обоснование для кластеризации возникает в том случае, когда невозможно произвести случайную выборку из всей совокупности, и поэтому вместо этого выбираются кластеры, а затем единицы рандомизируются внутри кластера. В этом случае сгруппированные стандартные ошибки объясняют неопределенность, вызванную тем фактом, что исследователь не наблюдает за большими частями интересующей совокупности.[7]

Математическая мотивация

Полезную математическую иллюстрацию дает случай односторонней кластеризации в обыкновенный метод наименьших квадратов (OLS) модель. Рассмотрим простую модель с N наблюдения, которые подразделяются на C кластеры. Позволять

Как это принято в моделях OLS, мы минимизируем сумму квадратов остатков

Отсюда мы можем получить классическую оценку «сэндвича»:

Обозначение

Хотя можно разработать плагин для оценки, определив

Кластерные стандартные ошибки предполагают, что

Путем построения подключаемых матриц

использованная литература

- ^ Кэмерон, А. Колин; Миллер, Дуглас Л. (31 марта 2015 г.). «Практическое руководство по кластерно-устойчивому выводу». Журнал людских ресурсов. 50 (2): 317–372. Дои:10.3368 / jhr.50.2.317. ISSN 0022–166X. S2CID 1296789.

- ^ «АР 212». Фиона Берлиг. Получено 2020-07-05.

- ^ а б Бертран, Марианна; Дюфло, Эстер; Муллайнатан, Сендхил (1 февраля 2004 г.). «Насколько мы должны доверять оценкам разницы в различиях?». Ежеквартальный журнал экономики. 119 (1): 249–275. Дои:10.1162/003355304772839588. ISSN 0033-5533. S2CID 470667.

- ^ Исинь Тан (2019-09-11). «Анализ экспериментов с обратным переключением с помощью кластерной устойчивой стандартной ошибки для предотвращения ложноположительных результатов». Блог разработчиков DoorDash. Получено 2020-07-05.

- ^ Лян, Кунг-Йи; Зегер, Скотт Л. (1986-04-01). «Продольный анализ данных с использованием обобщенных линейных моделей». Биометрика. 73 (1): 13–22. Дои:10.1093 / biomet / 73.1.13. ISSN 0006-3444.

- ^ Абади, Альберто; Ати, Сьюзен; Имбенс, Гвидо; Вулдридж, Джеффри (2017-10-24). «Когда следует корректировать стандартные ошибки для кластеризации?». arXiv:1710.02926 [math.ST ].

- ^ «Когда следует кластеризовать стандартные ошибки? Новая мудрость от оракула эконометрики». blogs.worldbank.org. Получено 2020-07-05.

From Wikipedia, the free encyclopedia

Clustered standard errors (or Liang-Zeger standard errors)[1] are measurements that estimate the standard error of a regression parameter in settings where observations may be subdivided into smaller-sized groups («clusters») and where the sampling and/or treatment assignment is correlated within each group.[2][3] Clustered standard errors are widely used in a variety of applied econometric settings, including difference-in-differences[4] or experiments.[5]

Analogous to how Huber-White standard errors are consistent in the presence of heteroscedasticity and Newey–West standard errors are consistent in the presence of accurately-modeled autocorrelation, clustered standard errors are consistent in the presence of cluster-based sampling or treatment assignment. Clustered standard errors are often justified by possible correlation in modeling residuals within each cluster; while recent work suggests that this is not the precise justification behind clustering,[6] it may be pedagogically useful.

Intuitive motivation[edit]

Clustered standard errors are often useful when treatment is assigned at the level of a cluster instead of at the individual level. For example, suppose that an educational researcher wants to discover whether a new teaching technique improves student test scores. She therefore assigns teachers in «treated» classrooms to try this new technique, while leaving «control» classrooms unaffected. When analyzing her results, she may want to keep the data at the student level (for example, to control for student-level observable characteristics). However, when estimating the standard error or confidence interval of her statistical model, she realizes that classical or even heteroscedasticity-robust standard errors are inappropriate because student test scores within each class are not independently distributed. Instead, students in classes with better teachers have especially high test scores (regardless of whether they receive the experimental treatment) while students in classes with worse teachers have especially low test scores. The researcher can cluster her standard errors at the level of a classroom to account for this aspect of her experiment.[7]

While this example is very specific, similar issues arise in a wide variety of settings. For example, in many panel data settings (such as difference-in-differences) clustering often offers a simple and effective way to account for non-independence between periods within each unit (sometimes referred to as «autocorrelation in residuals»).[4] Another common and logically distinct justification for clustering arises when a full population cannot be randomly sampled, and so instead clusters are sampled and then units are randomized within cluster. In this case, clustered standard errors account for the uncertainty driven by the fact that the researcher does not observe large parts of the population of interest.[8]

Mathematical motivation[edit]

A useful mathematical illustration comes from the case of one-way clustering in an ordinary least squares (OLS) model. Consider a simple model with N observations that are subdivided in C clusters. Let

As is standard with OLS models, we minimize the sum of squared residuals

From there, we can derive the classic «sandwich» estimator:

Denoting

While one can develop a plug-in estimator by defining

Clustered standard errors assume that

By constructing plug-in matrices

Further reading[edit]

- Alberto Abadie, Susan Athey, Guido W Imbens, and Jeffrey M Wooldridge. 2022. «When Should You Adjust Standard Errors for Clustering?» Quarterly Journal of Economics.

References[edit]

- ^ Liang, Kung-Yee; Zeger, Scott L. (1986-04-01). «Longitudinal data analysis using generalized linear models». Biometrika. 73 (1): 13–22. doi:10.1093/biomet/73.1.13. ISSN 0006-3444.

- ^ Cameron, A. Colin; Miller, Douglas L. (2015-03-31). «A Practitioner’s Guide to Cluster-Robust Inference». Journal of Human Resources. 50 (2): 317–372. doi:10.3368/jhr.50.2.317. ISSN 0022-166X. S2CID 1296789.

- ^ «ARE 212». Fiona Burlig. Retrieved 2020-07-05.

- ^ a b Bertrand, Marianne; Duflo, Esther; Mullainathan, Sendhil (2004-02-01). «How Much Should We Trust Differences-In-Differences Estimates?». The Quarterly Journal of Economics. 119 (1): 249–275. doi:10.1162/003355304772839588. hdl:1721.1/63690. ISSN 0033-5533. S2CID 470667.

- ^ Yixin Tang (2019-09-11). «Analyzing Switchback Experiments by Cluster Robust Standard Error to prevent false positive results». DoorDash Engineering Blog. Retrieved 2020-07-05.

- ^ Abadie, Alberto; Athey, Susan; Imbens, Guido; Wooldridge, Jeffrey (2017-10-24). «When Should You Adjust Standard Errors for Clustering?». arXiv:1710.02926 [math.ST].

- ^ «CLUSTERED STANDARD ERRORS». Economic Theory Blog. 2016. Archived from the original on 2016-11-06. Retrieved 28 September 2021.

- ^ «When should you cluster standard errors? New wisdom from the econometrics oracle». blogs.worldbank.org. Retrieved 2020-07-05.

Кластерные стандартные ошибки — это измерения, которые оценивают стандартную ошибку параметра регрессии в условиях, когда наблюдения могут быть подразделены на группы меньшего размера («кластеры») и где отбор проб и/или назначение лечения коррелируют внутри каждой группы. [1] [2] Кластерные стандартные ошибки широко используются в различных прикладных эконометрических параметрах, включая разность в разности [3] или эксперименты. [4] Аналогично тому, как стандартные ошибки Хубера-Уайта согласуются при наличии гетероскедастичности и Ньюи-Уэста .стандартные ошибки непротиворечивы при наличии точно смоделированной автокорреляции , кластеризованные (или «Лянг-Цегер» [5] ) стандартные ошибки непротиворечивы при наличии выборки на основе кластеров или назначения лечения. Кластерные стандартные ошибки часто оправдываются возможной корреляцией при моделировании остатков внутри каждого кластера; в то время как недавняя работа предполагает, что это не точное обоснование кластеризации, [6] это может быть полезно

с педагогической точки зрения.

Кластерные стандартные ошибки часто полезны, когда лечение назначается на уровне кластера , а не на индивидуальном уровне. Например, предположим, что исследователь в области образования хочет выяснить, улучшает ли новая методика обучения результаты тестов учащихся. Поэтому она поручает учителям в «обработанных» классах опробовать эту новую технику, не затрагивая при этом «контрольные» классы. При анализе своих результатов она может захотеть сохранить данные на уровне учащегося (например, чтобы контролировать наблюдаемые характеристики на уровне учащегося). Однако, оценивая стандартную ошибку или доверительный интервал своей статистической модели, она понимает, что классическая или даже устойчивая к гетероскедастичностистандартные ошибки неуместны, потому что результаты тестов учащихся в каждом классе не распределяются независимо друг от друга. Вместо этого учащиеся в классах с лучшими учителями имеют особенно высокие результаты тестов (независимо от того, проходят ли они экспериментальное лечение), в то время как учащиеся в классах с худшими учителями имеют особенно низкие результаты тестов. Исследователь может сгруппировать свои стандартные ошибки на уровне класса, чтобы учесть этот аспект своего эксперимента. [7]

Хотя этот пример очень специфичен, подобные проблемы возникают в самых разных условиях. Например, во многих параметрах панельных данных (таких как разница в разности ) кластеризация часто предлагает простой и эффективный способ учета независимости между периодами в каждой единице (иногда называемой «автокорреляцией в остатках»). [3] Еще одно распространенное и логически отличное обоснование кластеризации возникает, когда полная совокупность не может быть отобрана случайным образом, и поэтому вместо выборки выбираются кластеры, а затем рандомизируются единицы внутри кластера. В этом случае сгруппированные стандартные ошибки объясняют неопределенность, вызванную тем фактом, что исследователь не наблюдает большие части интересующей совокупности. [8]

Полезную математическую иллюстрацию дает случай односторонней кластеризации в обычной модели наименьших квадратов (МНК). Рассмотрим простую модель с N наблюдениями, которые разбиты на C кластеров. Позвольте быть вектором результатов, матрицей ковариат, вектором неизвестных параметров и вектором необъяснимых остатков:

Перевод

Ссылка на автора

Введение

В этом посте мы рассмотрим несколько случаев, когда алгоритм KMC работает неэффективно или может давать неинтуитивные результаты. В частности, мы рассмотрим следующие сценарии:

- Наше предположение о количестве (реальных) кластеров неверно.

- Особенность пространства очень размерна.

- Кластеры бывают странной или неправильной формы.

Все эти условия могут привести к проблемам с K-Means, так что давайте посмотрим.

Неверное количество кластеров

Чтобы сделать это проще, давайте определим вспомогательную функциюcompare, который создаст и решит проблему кластеризации для нас, а затем сравнит результаты.

from sklearn import datasets

from sklearn.cluster import KMeans

from sklearn.datasets import make_blobs, make_circles, make_moons

from mpl_toolkits.mplot3d import Axes3Dimport numpy as np

import pandas as pd

import itertoolsdef compare(N_features, C_centers, K_clusters, dims=[0, 1],*args):

data, targets = make_blobs(

n_samples=n_samples if 'n_samples' in args else 400,

n_features=N_features,

centers=C_centers,

cluster_std=cluster_std if 'cluster_std' in args else 0.5,

shuffle=True,

random_state=random_state if 'random_state' in args else 0)FEATS = ['x' + str(x) for x in range(N_features)]

X = pd.DataFrame(data, columns=FEATS)

X['cluster'] =

KMeans(n_clusters=K_clusters, random_state=0).fit_predict(X)fig, axs = plt.subplots(1, 2, figsize=(12, 4))

axs[0].scatter(data[:, dims[0]], data[:, dims[1]],

c='white', marker='o', edgecolor='black', s=20)

axs[0].set_xlabel('x{} [a.u.]'.format(dims[0]))

axs[0].set_ylabel('x{} [a.u.]'.format(dims[1]))

axs[0].set_title('Original dataset')

axs[1].set_xlabel('x{} [a.u.]'.format(dims[0]))

axs[1].set_ylabel('x{} [a.u.]'.format(dims[1]))

axs[1].set_title('Applying clustering')colors = itertools.cycle(['r', 'g', 'b', 'm', 'c', 'y'])

for k in range(K_clusters):

x = X[X['cluster'] == k][FEATS].to_numpy()

axs[1].scatter(

x[:, dims[0]],

x[:, dims[1]],

color=next(colors),

edgecolor='k',

alpha=0.5

)

plt.show()

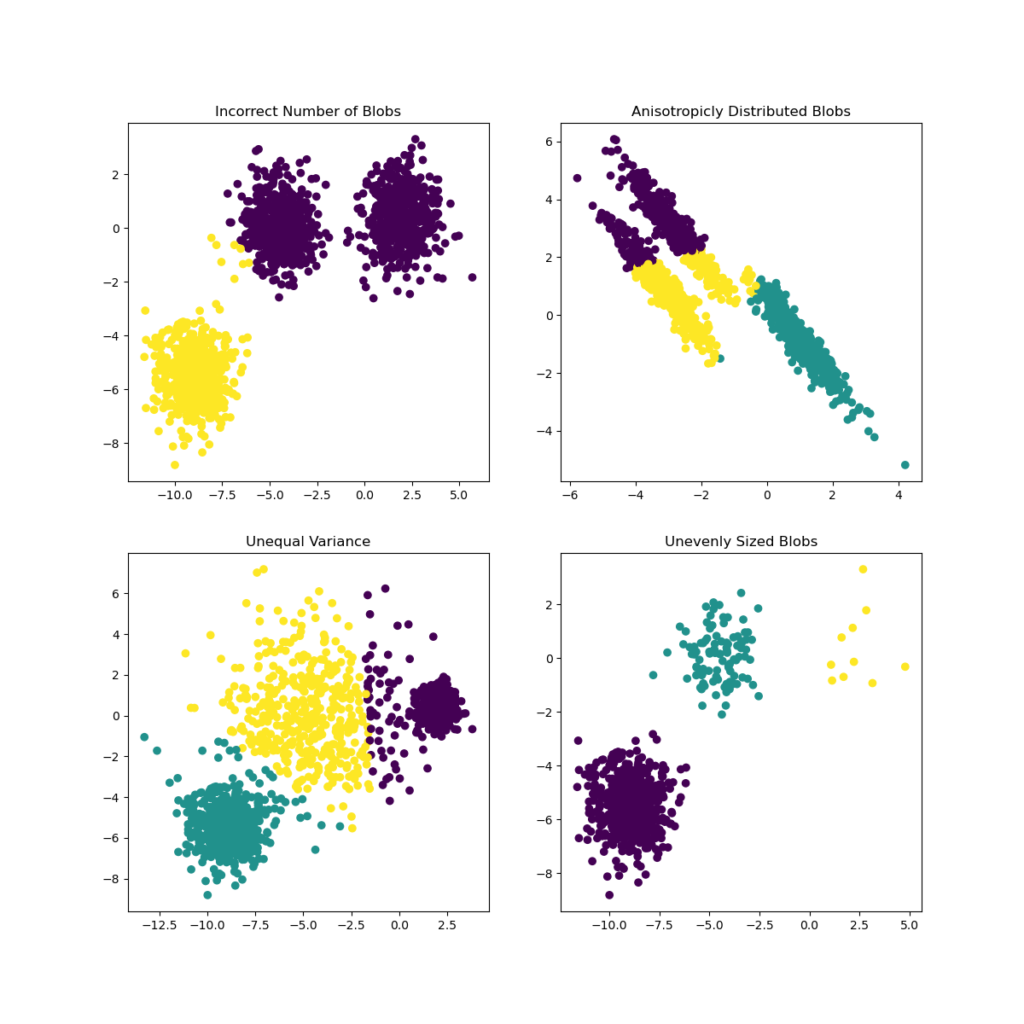

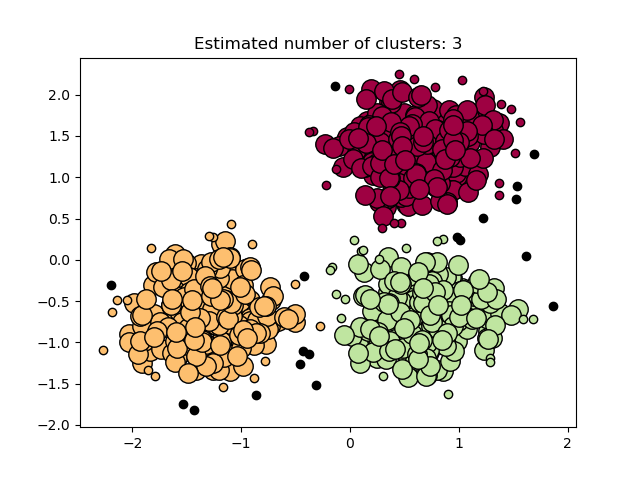

Слишком мало кластеров

compare(2, 4, 3)).Несмотря на наличие отдельных кластеров в данных, мы недооценили их количество. Как следствие, некоторые непересекающиеся группы данных вынуждены вписываться в один более крупный кластер.

Слишком много кластеров

compare(2, 2, 4)).В отличие от последней ситуации, попытка обернуть данные в слишком много кластеров создает искусственные границы внутри реальных кластеров данных.

Высокие (er) размерные данные

Набор данных не должен быть настолько высоким в размерности, прежде чем мы начнем видеть проблемы. Хотя визуализация и, следовательно, некоторый анализ многомерных данных уже сложны (ругаясь сейчас…), поскольку KMC часто используется для понимания данных, это не помогает быть представленным с неоднозначностями.

Чтобы объяснить это, давайте сгенерируем трехмерный набор данных с четко различимыми кластерами.

fig = plt.figure(figsize=(14, 8))

ax = fig.add_subplot(111, projection='3d')data, targets = make_blobs(

n_samples=400,

n_features=3,

centers=3,

cluster_std=0.5,

shuffle=True,

random_state=0)ax.scatter(data[:, 0], data[:, 1],

zs=data[:, 2], zdir='z', s=25, c='black', depthshade=True)

ax.set_xlabel('x0 [a.u.]')

ax.set_ylabel('x1 [a.u.]')

ax.set_zlabel('x2 [a.u.]')

ax.set_title('Original distribution.')

plt.grid()

plt.show()

Хотя существует множество способов проецировать этот 3D-набор данных на 2D, существует три основных ортогональных подпространства:

Глядя наx2 : x0проекция, набор данных выглядит так, как если бы он имел только два кластера. Нижний правый «суперкластер» на самом деле представляет собой две отдельные группы, и даже если мы предполагаем,Кправильно(К = 3)Это выглядит как очевидная ошибка, несмотря на то, что кластеры очень локализованы.

compare(2, 2, 4, dims=[0, 2])).Чтобы быть уверенным, мы должны взглянуть на оставшиеся проекции, чтобы увидеть проблему, буквально, с разных сторон.

compare(2, 2, 4, dims=[1, 2])).compare(2, 2, 4, dims=[0, 1])).Это имеет больше смысла!

С другой стороны, у нас было невероятное преимущество. Во-первых, с тремя измерениями мы смогли построить весь набор данных. Во-вторых, кластеры, которые существуют в наборе данных, были очень четкими, поэтому их легко обнаружить. Наконец, с трехмерным набором данных мы столкнулись только с тремя стандартными 2D-проекциями.

СлучайN, N> 3особенности, мы быне сможет построить весь набор данныхи число 2D проекций будет масштабироваться квадратично сN:

не говоря уже о том, что набор данных может иметь кластеры странной формы или нелокализованные, что является нашей следующей задачей.

Нерегулярные наборы данных

До сих пор мы упоминали о проблемах, которые «на нашей стороне». Мы посмотрели на очень «хорошо себя ведущий» набор данных и обсудили проблемы в области аналитики. Однако что делать, если набор данных не соответствует нашему решению или нашемуРешение проблемы не подходит?Это как раз тот случай, когда распределение данных происходит в странных или неправильных формах.

Если мы представим только этот график, мы можем обмануть себя, полагая, что в данных есть только два кластера. Однако при составлении графика остальных прогнозов мы быстро узнаем, что это не так.

fig, axs = plt.subplots(1, 3, figsize=(14, 4))# unequal variance

X, y = make_blobs(n_samples=1400,

cluster_std=[1.0, 2.5, 0.2],

random_state=2)

y_pred = KMeans(n_clusters=3, random_state=2).fit_predict(X)

colors = [['r', 'g', 'b'][c] for c in y_pred]axs[0].scatter(X[:, 0], X[:, 1],

color=colors, edgecolor='k', alpha=0.5)

axs[0].set_title("Unequal Variance")# anisotropically distributed data

X, y = make_blobs(n_samples=1400, random_state=156)

transformation = [

[0.60834549, -0.63667341],

[-0.40887718, 0.85253229]

]

X = np.dot(X, transformation)

y_pred = KMeans(n_clusters=3, random_state=0).fit_predict(X)

colors = [['r', 'g', 'b'][c] for c in y_pred]axs[1].scatter(X[:, 0], X[:, 1],

color=colors, edgecolor='k', alpha=0.5)

axs[1].set_title("Anisotropicly Distributed Blobs")# irregular shaped data

X, y = make_moons(n_samples=1400, shuffle=True,

noise=0.1, random_state=120)

y_pred = KMeans(n_clusters=2, random_state=0).fit_predict(X)

colors = [['r', 'g', 'b'][c] for c in y_pred]axs[2].scatter(X[:, 0], X[:, 1],

color=colors, edgecolor='k', alpha=0.5)

axs[2].set_title("Irregular Shaped Data")plt.show()

На левом графике показаны данные, чье распределение по Гауссу не имеет одинакового стандартного отклонения. Средний график представляетанизотропныйданные, означающие данные, которые вытянуты вдоль определенной оси. Наконец, правый график показывает данные, которые полностью негауссовы, несмотря на то, что они организованы в чистые кластеры.

В любом случае нерегулярность делает алгоритм KMC неэффективным. Поскольку алгоритм обрабатывает каждую точку данных одинаково и полностью независимо от других точек, алгоритмне в состоянии обнаружить любую возможную непрерывность или локальные изменения в кластере, То, что он делает, просто берет те же самые метрики и применяет это к каждой точке. В результате алгоритм KMC может производить странную или нелогичную кластеризацию в данных, даже если мы предполагаемКправильно и особенностиNне так много.

Выводы

В этом посте мы обсудили три основные причины, по которым алгоритм K-Means Clustering дает нам неправильные ответы.

- Во-первых, как количество кластеровКнужно решить априори, есть большая вероятность, что мы догадаемся

- Во-вторых, кластеризация в пространстве более высокого измерения становится громоздкой с аналитической точки зрения, и в этом случае KMC предоставит нам идеи, которые могут вводить в заблуждение.

- Наконец, для любых данных неправильной формы, KMC, скорее всего, искусственные кластеры, которые не соответствуют здравому смыслу.

Зная эти три ошибки, KMC остается полезным инструментом, особенно при проверке данных или создании меток.

Первоначально опубликовано на https://zerowithdot.com ,

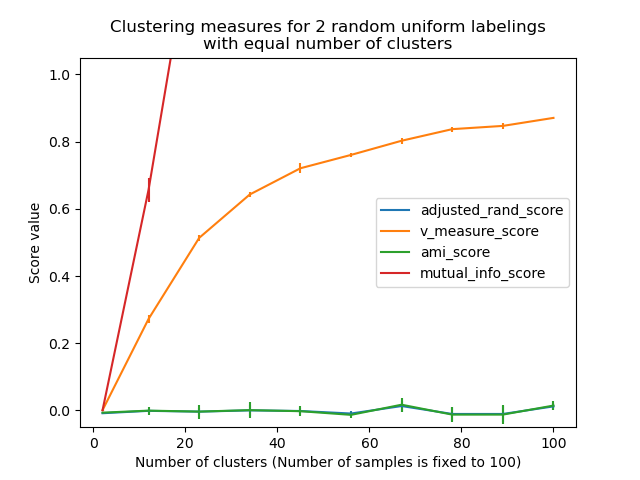

Проблема оценки качества в задаче кластеризации трудноразрешима, как минимум, по двум причинам:

- Теорема невозможности Клейнберга — не существует оптимального алгоритма кластеризации.

- Многие алгоритмы кластеризации не способны определить настоящее количество кластеров в данных. Чаще всего количество кластеров подается на вход алгоритма и подбирается несколькими запусками алгоритма.

Содержание

- 1 Методы оценки качества кластеризации

- 2 Внешние меры оценки качества

- 2.1 Обозначения

- 2.2 Индекс Rand

- 2.3 Индекс Adjusted Rand

- 2.4 Индекс Жаккара (англ. Jaccard Index)

- 2.5 Индекс Фоулкса – Мэллова (англ. Fowlkes-Mallows Index)

- 2.6 Hubert Г statistic

- 2.7 Индекс Phi

- 2.8 Minkowski Score

- 2.9 Индекс Гудмэна-Крускала (англ. Goodman-Kruskal Index)

- 2.10 Entropy

- 2.11 Purity

- 2.12 F-мера

- 2.13 Variation of Information

- 3 Внутренние меры оценки качества

- 3.1 Компактность кластеров (англ. Cluster Cohesion)

- 3.2 Отделимость кластеров (англ. Cluster Separation)

- 3.3 Индекс Данна (англ. Dunn Index)

- 3.4 Обобщенный Индекс Данна (gD31, gD41, gD51, gD33, gD43, gD53)

- 3.5 Индекс S_Dbw

- 3.6 Силуэт (англ. Silhouette)

- 3.7 Индекс Calinski–Harabasz

- 3.8 Индекс C

- 3.9 Индекс Дэвиcа-Болдуина (англ. Davies–Bouldin Index)

- 3.10 Score function

- 3.11 Индекс Gamma

- 3.12 Индекс COP

- 3.13 Индекс CS

- 3.14 Индекс Sym

- 3.15 Индексы SymDB, SymD, Sym33

- 3.16 Negentropy increment

- 3.17 Индекс SV

- 3.18 Индекс OS

- 4 Сравнение

- 5 См. также

- 6 Источники информации

- 7 Примечания

Методы оценки качества кластеризации

Метод оценки качества кластеризации — инструментарий для количественной оценки результатов кластеризации.

Принято выделять две группы методов оценки качества кластеризации:

- Внешние (англ. External) меры основаны на сравнении результата кластеризации с априори известным разделением на классы.

- Внутренние (англ. Internal) меры отображают качество кластеризации только по информации в данных.

Внешние меры оценки качества

Данные меры используют дополнительные знания о кластеризуемом множестве: распределение по кластерам, количество кластеров и т.д.

Обозначения

Дано множество из элементов, разделение на классы , и полученное разделение на кластеры , совпадения между и могут быть отражены в таблице сопряженности , где каждое обозначает число объектов, входящих как в , так и в : .

Пусть .

Также рассмотрим пары из элементов кластеризуемого множества . Подсчитаем количество пар, в которых:

- Элементы принадлежат одному кластеру и одному классу —

- Элементы принадлежат одному кластеру, но разным классам —

- Элементы принадлежат разным кластерам, но одному классу —

- Элементы принадлежат разным кластерам и разным классам —

Индекс Rand

Индекс Rand оценивает, насколько много из тех пар элементов, которые находились в одном классе, и тех пар элементов, которые находились в разных классах, сохранили это состояние после кластеризации алгоритмом.

Имеет область определения от 0 до 1, где 1 — полное совпадение кластеров с заданными классами, а 0 — отсутствие совпадений.

Индекс Adjusted Rand

где — значения из таблицы сопряженности.

В отличие от обычного индекса Rand, индекс Adjusted Rand может принимать отрицательные значения, если .

Индекс Жаккара (англ. Jaccard Index)

Индекс Жаккара похож на Индекс Rand, только не учитывает пары элементов находящиеся в разные классах и разных кластерах ().

Имеет область определения от 0 до 1, где 1 — полное совпадение кластеров с заданными классами, а 0 — отсутствие совпадений.

Индекс Фоулкса – Мэллова (англ. Fowlkes-Mallows Index)

Индекс Фоулкса – Мэллова используется для определения сходства между двумя кластерами.

Более высокое значение индекса означает большее сходство между кластерами. Этот индекс также хорошо работает на зашумленных данных.

Hubert Г statistic

Данная мера отражает среднее расстояние между объектами разных кластеров:

где , — матрица близости, а

Можно заметить, что два объекта влияют на , только если они находятся в разных кластерах.

Чем больше значение меры — тем лучше.

Индекс Phi

Классическая мера корреляции между двумя переменными:

Minkowski Score

Индекс Гудмэна-Крускала (англ. Goodman-Kruskal Index)

Entropy

Энтропия измеряет «чистоту» меток классов:

Стоит отметить, что если все кластера состоят из объектов одного класса, то энтропия равна 0.

Purity

Чистота ставит в соответствие кластеру самый многочисленный в этом кластере класс.

Чистота находится в интервале [0, 1], причём значение = 1 отвечает оптимальной кластеризации.

F-мера

F-мера представляет собой гармоническое среднее между точностью (precision) и полнотой (recall).

Variation of Information

Данная мера измеряет количество информации, потерянной и полученной при переходе из одного кластера в другой.

Внутренние меры оценки качества

Данные меры оценивают качество структуры кластеров опираясь только непосредственно на нее, не используя внешней информации.

Компактность кластеров (англ. Cluster Cohesion)

Идея данного метода в том, что чем ближе друг к другу находятся объекты внутри кластеров, тем лучше разделение.

Таким образом, необходимо минимизировать внутриклассовое расстояние, например, сумму квадратов отклонений:

- , где — количество кластеров.

Отделимость кластеров (англ. Cluster Separation)

В данном случае идея противоположная — чем дальше друг от друга находятся объекты разных кластеров, тем лучше.

Поэтому здесь стоит задача максимизации суммы квадратов отклонений:

- , где — количество кластеров.

Индекс Данна (англ. Dunn Index)

Индекс Данна имеет множество вариаций, оригинальная версия выглядит следующим образом:

- ,

где:

- — межкластерное расстояние (оценка разделения), ,

- — диаметр кластера (оценка сплоченности), .

Обобщенный Индекс Данна (gD31, gD41, gD51, gD33, gD43, gD53)

Все эти вариации являются комбинациями 3 вариантов вычисления оценки разделения и оценки компактности

Оценки разделения:

- ,

- ,

- .

Оценки компактности:

- ,

- .

Обобщенный индекс Данна, как и обычный, должен возрастать вместе с улучшением качества кластеризации.

Индекс S_Dbw

Основан на вычислении Евклидовой нормы

и стандартных отклонений

- ,

- .

Сам индекс определяется формулой:

- .

Здесь

- ,

- ,

- , если и в ином случае.

Должен снижаться с улучшением кластеризации.

Силуэт (англ. Silhouette)

Значение силуэта показывает, насколько объект похож на свой кластер по сравнению с другими кластерами.

Оценка для всей кластерной структуры:

- ,

где:

- — среднее расстояние от до других объектов из кластера (компактность),

- — среднее расстояние от до объектов из другого кластера (отделимость).

Можно заметить, что

- .

Чем ближе данная оценка к 1, тем лучше.

Есть также упрощенная вариация силуэта: и вычисляются через центры кластеров.

Индекс Calinski–Harabasz

Компактность основана на расстоянии от точек кластера до их центроидов, а разделимость — на расстоянии от центроид кластеров до глобального центроида. Должен возрастать.

Индекс C

Индекс C представляет собой нормализованную оценку компактности:

- ,

где:

- ,

- — сумма минимальных (максимальных) расстояний между парами всех объектов во всем датасете.

Индекс Дэвиcа-Болдуина (англ. Davies–Bouldin Index)

Это, возможно, одна из самых используемых мер оценки качества кластеризации.

Она вычисляет компактность как расстояние от объектов кластера до их центроидов, а отделимость — как расстояние между центроидами.

- ,

где:

Существует еще одна вариация данной меры, которая была предложена автором вместе с основной версией:

C-индекс и индекс Дэвиcа-Болдуина должны минимизироваться для роста кластеризации.

Score function

Индекс, основанный на суммировании. Здесь оценка компактности выражается в дистанции от точек кластера до его центроида, а оценка разделимости — в дистанции от центроидов кластеров до глобального центроида.

- ,

где:

- ,

Чтобы функция оценки была эффективной, она должна максимизировать bcd, минимизировать wcd и быть ограниченной. Чем больше данный индекс, тем выше качество.

Индекс Gamma

где:

- — число пар таких, что (1) и принадлежат разным кластерам, и (2) ,

- .

Индекс COP

В данной мере компактность вычисляется как расстояние от точек кластера до его центроиды, а разделимость основана на расстоянии до самого отдаленного соседа.

- .

Индекс CS

Был предложен в области сжатия изображений, но может быть успешно адаптирован для любого другого окружения. Он оценивает компактность по диаметру кластера, а отделимость — как дистанцию между ближайшими элементами двух кластеров.

- .

Чем меньше значение данного индекса, тем выше качество кластеризации.

Индекс Sym

- .

Здесь — дистанция симметрии для точки из кластера .

Чем выше данное значение, тем лучше.

Индексы SymDB, SymD, Sym33

Модифицируют оценку компактности для индексов Дэвиса-Боулдина, Данна и gD33 соответственно.

SymDB вычисляется аналогично DB с изменением вычисления на:

- .

Данная оценка должна уменьшаться для улучшения качества кластеризации.

В SymD переопределена функция :

- .

в Sym33 аналогично SymD переопределена :

- .

Последние две оценки должны расти для улучшения качества кластеризации.

Negentropy increment

В отличие от подавляющего большинства других оценок, не основывается на сравнении компактности и разделимости. Определяется следующим образом:

- .

Здесь , — определитель ковариационной матрицы кластера , — определитель ковариационной матрицы всего датасета.

Данная оценка должна уменьшаться пропорционально росту качества кластеризации.

Индекс SV

Одна из самых новых из рассматриваемых в данном разделе оценок. Измеряет разделимость по дистанции между ближайшими точка кластеров, а компактность — по расстоянию от пограничных точек кластера до его центроида.

- .

Данная оценка должна увеличиваться.

Индекс OS

Отличается от предыдущей оценки усложненным способом вычисления оценки разделимости.

- .

Где

- .

при , и в ином случае.

Функции и определены следующим образом:

- .

- .

Данная оценка, как и предыдущая, должна возрастать.

Сравнение

Не существует лучшего метода оценки качества кластеризации. Однако, в рамках исследования[1] была предпринята попытка сравнить существующие меры на различных данных. Полученные результаты показали, что на искусственных датасетах наилучшим образом себя проявили индексы , и . На реальных датасетах лучше всех показал себя .

В Таблице 1 приведены оценки сложности мер качества кластеризации ( — число объектов в рассматриваемом наборе данных):

Таблица 1 — Оценка сложности для 19 мер качества кластеризации.

Из всех рассмотренных мер, меры , , и наиболее полно соответствуют когнитивному представлению асессоров о качестве кластеризации[2].

См. также

- Кластеризация

- Оценка качества в задачах классификации и регрессии[на 28.01.19 не создан]

Источники информации

- Wikipedia — Category:Clustering criteria

- Сивоголовко Е. В. Методы оценки качества четкой кластеризации

- Cluster Validation

- Halkidi, M., Batistakis, Y., Vazirgiannis, M., 2001. On clustering validation techniques. Journal of intelligent information systems, 17(2-3), pp.107-145.

- Pal, N.R., Biswas, J., 1997. Cluster validation using graph theoretic concepts. Pattern Recognition, 30(6), pp.847-857.

Примечания

- ↑ An extensive comparative study of cluster validity indices

- ↑ Towards cluster validity index evaluation and selection

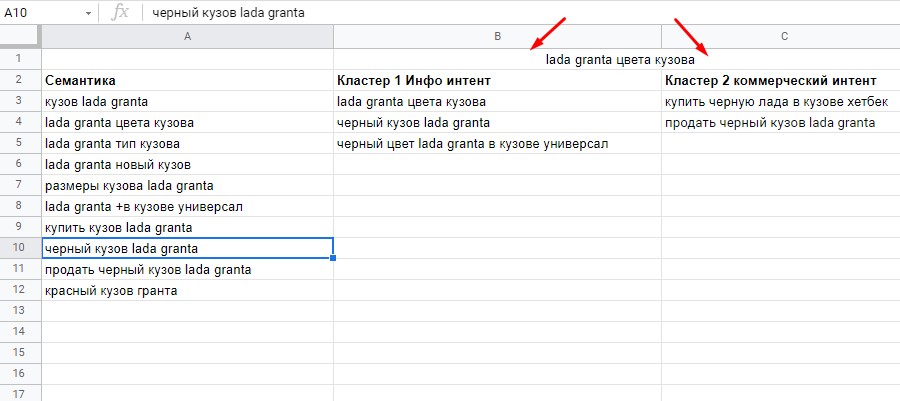

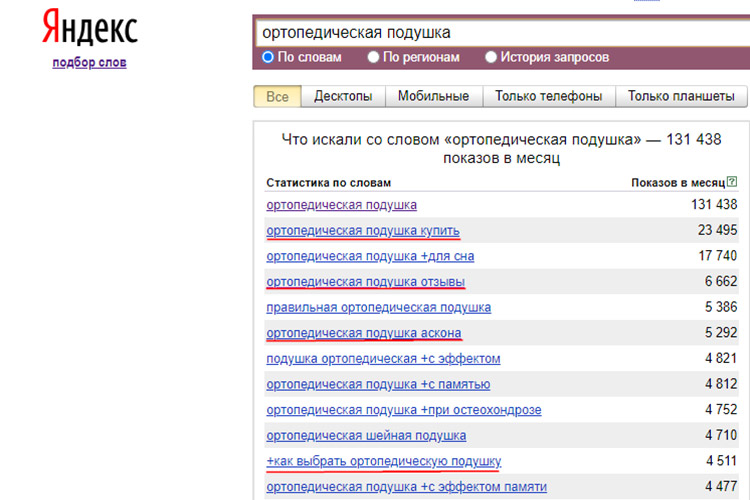

Кластеризация запросов (группировка) — это разделение семантического ядра на небольшие логические группы (кластеры),

которые можно продвигать на одной странице.

Кластеризация семантического ядра — главный источник головной боли и нервного тика при работе с семантикой у

начинающих оптимизаторов и предпринимателей, самостоятельно продвигающих свой сайт.

Сегодня мы разберем:

- Что скрывается за страшным словом «кластеризация».

- Какой поисковый интент у «поискового интента».

- Как выйти победителем при первой в своей жизни кластеризации.

А главное, как выбрать удобный способ кластеризации запросов без ущерба для точности сортировки и кошелька

оптимизатора.

Если вы не путаете «SEO» и «СЕО», но еще не знаете про разницу между Soft и Hard группировкой, то попали по адресу.

Погнали!

Определяем поисковый интент

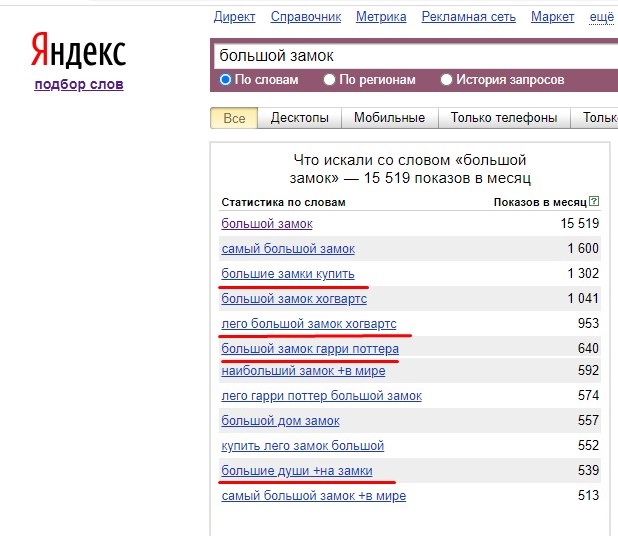

Итак, семантическое ядро вы уже

составили. После сбора семантики и очистки ядра от нецелевых вхождений можно приступать к кластеризации.

Первый этап сортировки поисковых запросов начинается с определения интента.

Поисковый интент — это цель, намерение пользователя, которое вкладывается в запрос при поиске.

Поисковый интент используется Google и «Яндексом» для формирования релевантной выдачи, когда сайты сортируются в

поиске с учетом смысловой содержательности поискового запроса и намерения пользователя. Интент может быть

коммерческим, когда намерение пользователя — найти товар или заказать услуги, или информационным, где основная цель —

узнать информацию о продукте.

Для корректного ранжирования на посадочной странице все ключевые слова должны принадлежать одному интенту. При этом,

в зависимости от сезонности и спроса на товары, поисковый запрос может приобретать в разное время коммерческий или

информационный интент.

Сортировать ключевые слова в зависимости от интента можно по фактору коммерческости — показателя, определяющего уровень преобладания продающего намерения над информационным при поиске. Поисковые запросы с высоким уровнем коммерческости следует размещать на коммерческих страницах, с низким — в информационных, при смешанном показателе придется искать баланс.

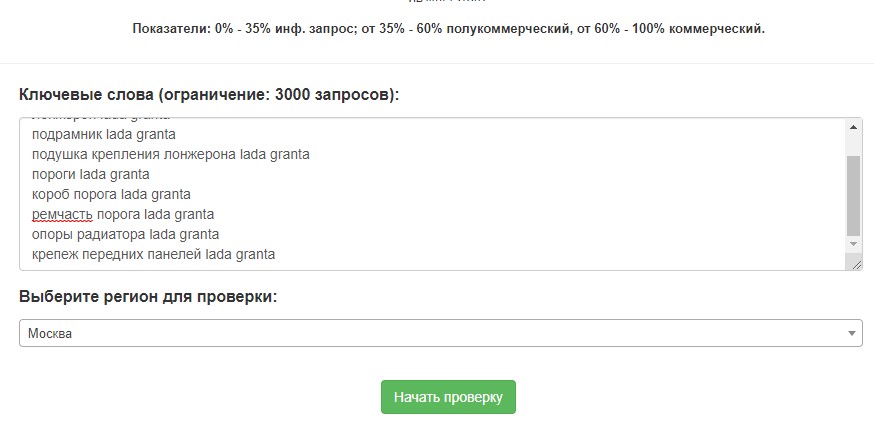

Разберем тонкости проверки на примере условно-бесплатного Arsenkin Tools Commerce. Сервис позволяет бесплатно проверять до 100 ключевых слов в день, также можно приобрести подписку за 549 рублей на 1 месяц и проверять до 2 500 запросов. Для проверки достаточно вставить семантическое ядро, выбрать регион и запустить анализ.

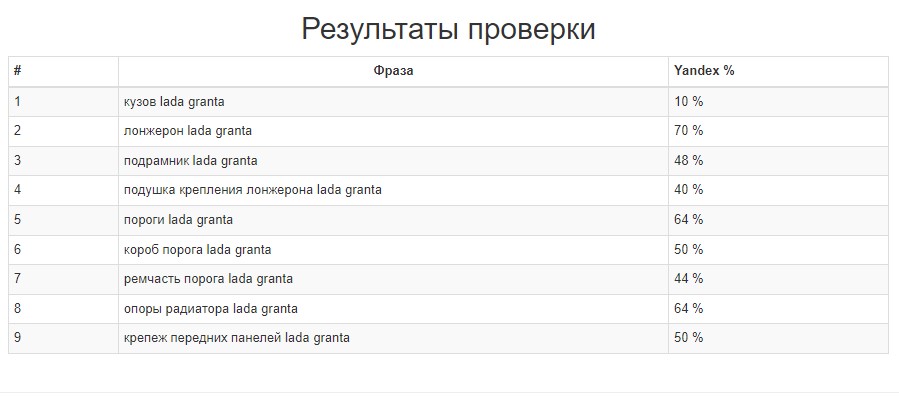

Результаты анализа выводятся в формате таблицы с отображением процента коммерческости.

Коммерческость поискового запроса — это доминирование коммерческого интента у пользователя, вводящего запрос в браузерной строке.

Запросы с коммерческостью менее 35 % имеют информационный интент и подходят для публикации в блоге, FAQ или гайдах, от 60 % — в каталоге товаров и коммерческих страницах. Поисковые запросы с коммерческостью в 35–60 % имеют смешанный интент — использовать их требуется аккуратно, иначе есть риск размыть релевантность страницы.

Для сортировки результаты копируем в таблицу Excel или «Google Таблицы», после чего выделяем столбец с процентным показателем комммерческости и сортируем.

Таким образом таблица отсортируется. Вверху будут поисковые запросы с информационным интентом, а в нижней части — с коммерческим.

Выбираем подходящий метод кластеризации

Методика кластеризации поисковых запросов подбирается с учетом объема собранной семантики и количества страниц на сайте. Чаще всего применяется комбинированный метод, где используется несколько вариантов кластеризации, что позволяет добиться наиболее точного результата. Мы же разберем каждый метод по отдельности.

Логическая кластеризация

Точечный инструмент для группировки небольших семантических ядер. Кластеризация ключевых слов проводится вручную: оптимизатор определяет цель поиска и смысловую релевантность для каждого поискового запроса. Муторно, но действенно.

Точность и качество логической группировки зависит от объема семантического ядра. Чем больше требуется отсортировать поисковых запросов, тем выше риск допустить ошибки: сбиться с логики кластеризации, пропустить слова или неправильно определить интент.

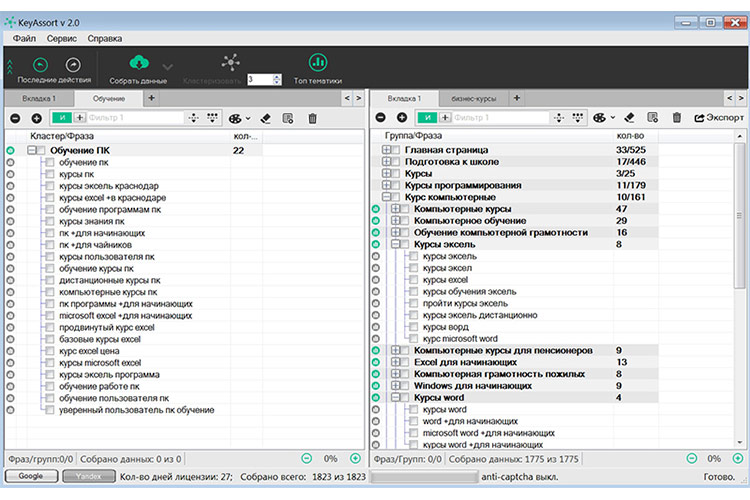

Кластеризация по семантической схожести

Для кластеризации семантического ядра используются сложные формулы и обучаемые нейросети. Смысл группировки сводится к объединению в кластеры семантически близких поисковых запросов. При этом ключевые слова могут не иметь лексикографического сходства, но всегда похожи по семантике.

Пример. Группа в семантическом ядре формируется, если у всех поисковых запросов есть пересечение с ключевым словом. Например, “lada check engine”, “купить коврики lada”, и ”как почистить коврики lada” попадут в одну группу, при этом 2 последних поисковых запроса сформируют еще один отдельный кластер.

Проводить кластеризацию по семантической схожести для молодого сайта нет смысла: такая задача поручается нейросетям при наличии большого семантического ядра. При этом такая группировка не учитывает коммерческость, ведь после кластеризации придется еще сортировать ключи в зависимости от поискового интента.

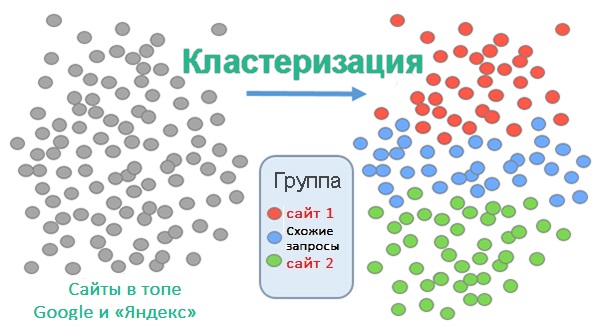

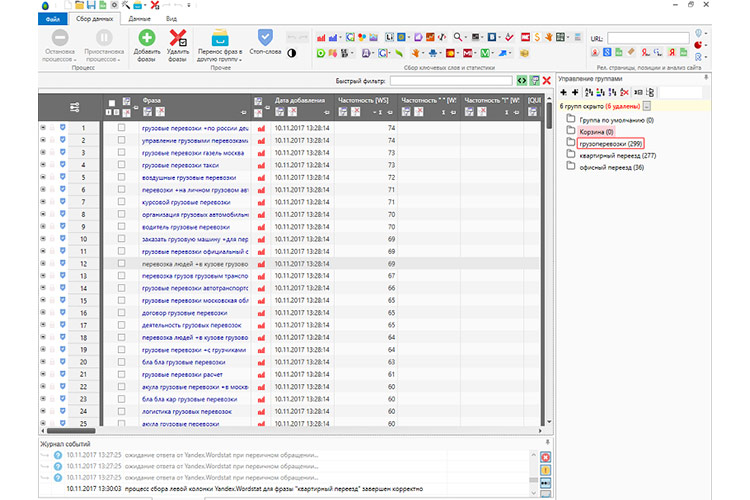

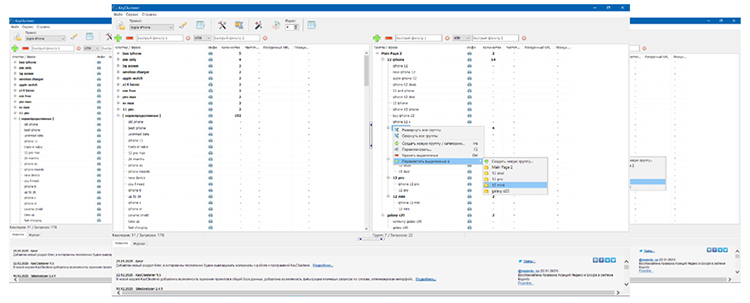

Кластеризация по топам

Наиболее правильный и популярный способ группировки семантики. Смысл кластеризации заключается в объединении поисковых запросов в кластеры согласно семантической базе сайтов, находящихся в топе выдачи «Яндекс» и Google.

Из популярных программ для кластеризации стоит выделить KeyClusterer, AllSubmitter, а также Key Collector. В отличие от онлайн-сервисов с оплатой по подписке, десктопное ПО приобретается единоразово по лицензии, а скорость кластеризации зависит от производительности компьютера.

Логика метода заключается в поиске пересечений ключевых слов на страницах сайтов, находящихся в топе поисковых систем. Обычно проводится кластеризация по топ-3 или топ-10, реже учитываются список из 50 сайтов в рейтинге.

Для увеличения точности группировки перед кластеризацией задается порог пересечений: ключевые слова объединяются в кластер только если будут найдены, например, на сразу двух, пяти или десяти сайтах.

| Логическая группировка | Кластеризация по топам | Группировка по семантической схожести | |

| Кому подойдет | Молодым сайтам, визиткам и лендингам | Многостраничным ресурсам и e-commerce | Маркетплейсам, онлайн-библиотекам |

| Когда подойдет | При небольшом семантическом ядре | Для работы с ядром среднестатистического сайта | Для группировки крупных семантических ядер |

| Преимущества | Точный результат, возможность учесть несколько переменных при кластеризации | Быстрый и недорогой способ обработать большое семантическое ядро | Возможность сегментировать большие массивы неструктурированных данных |

| Недостатки | Сложность группировки и высокий риск ошибок при долгой сортировке | Часто требуется повторная ручная кластеризация, чтобы сделать лучше, чем у конкурентов | Сложность реализации и необходимость повторной обработки семантики |

| Можно ли выполнить начинающему оптимизатору | Да, вручную | Да, через сервисы или софт | Нет, нужен сложный и дорогой софт |

На практике лучше совмещать несколько методов кластеризации. Например, группировать объемное ядро по топам, а сложные ключи со смешанным интентом сортировать вручную.

Подбираем алгоритм кластеризации семантического ядра по топам

Для корректной кластеризации даже для небольшого сайта рекомендуется сначала провести группировку семантики по топам поисковой выдачи и лишь затем сегментировать спорные ключевые слова вручную. Кластеризация на основании анализа поисковой выдачи может проводиться тремя способами-уровнями: Soft, Middle, Hard. Рассмотрим каждый из них.

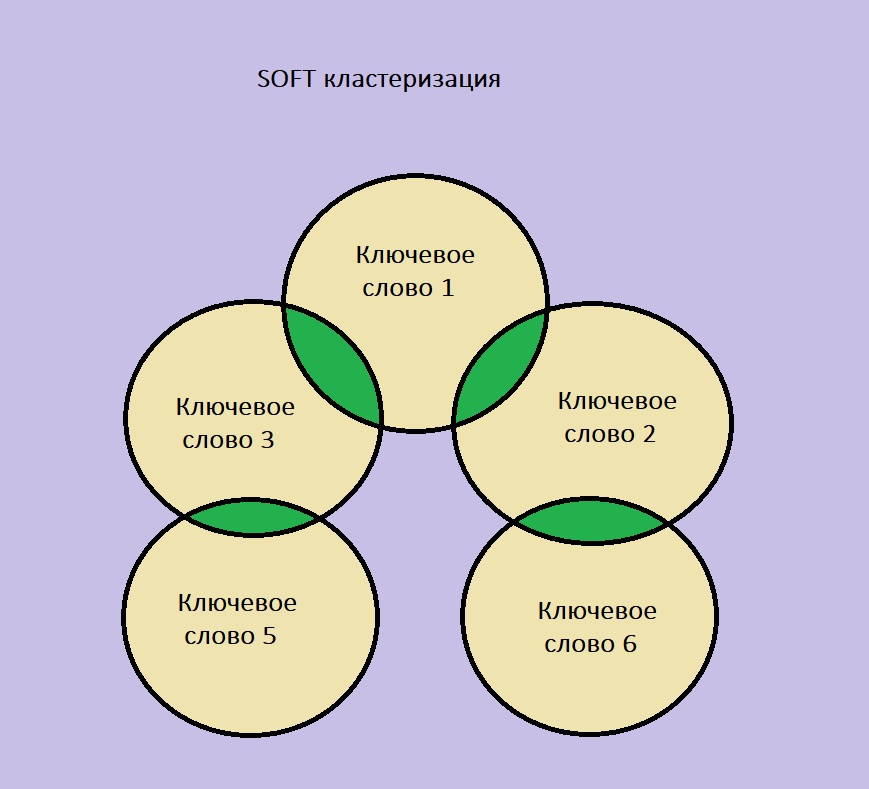

Soft-кластеризация

При мягкой кластеризации все поисковые запросы сравниваются с основным, тематико-задающим ключом, имеющим, как правило, наибольшую частотность. В кластер добавляются все ключевые слова, привязанные к URL в поисковой выдаче, которые пересекаются с главным поисковым запросом. Ключевое слово попадает в кластер семантического ядра, если количество одинаковых URL выше выбранного порога кластеризации. При этом второстепенные ключевые слова могут даже не пересечься между собой, из-за чего в кластер добавляется много поисковых запросов, но страдает точность группировки.

Метод предназначен для молодых проектов или неконкурентных тематик, где точность сортировки ключевых слов не столь важна.

Soft-кластеризация подойдет небольшим информационным сайтам или интернет-магазинам с маленьким ассортиментом товаров.

Soft-кластеризация может использоваться для сегментирования семантического ядра сайтов-визиток.

Hard-кластеризация

Это жесткий, но точный метод сегментации ключевых слов в семантическом ядре, который подходит для высококонкурентных и сложных тематик. При таком подходе отсеивается много поисковых запросов, однако удается создать кластер с максимально релевантными ключевыми словами к тематике посадочной страницы.

При Hard-кластеризации кластер создается только в случае пересечения всех ключевых фраз среди URL-адресов, входящих в топ-10 поисковой выдачи. Помимо пересечения главного ключевого слова также проводится сравнение вспомогательных поисковых запросов: кластер образуется только при выполнении обоих этих условий.

Порог кластеризации определяет число совпадений не только главного поискового запроса, но и всех входящих в кластер запросов. При этом чем выше порог кластеризации, тем меньше ключевых слов попадает в кластер семантического ядра.

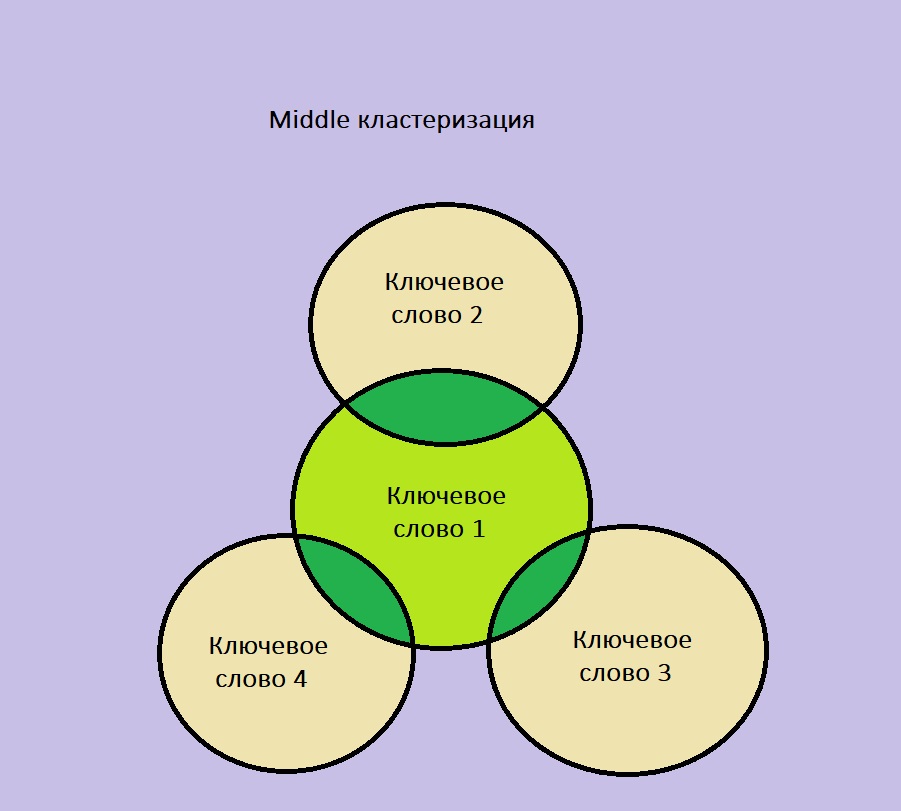

Middle-кластеризация

Middle-кластеризация — компромисс между слабой точностью Soft-метода и жесткостью к отбору Hard-группировки. Выбирается главный тематико-задающий поисковый запрос, к которому привязываются остальные ключевые слова, прошедшие порог кластеризации по количеству URL в выдаче Google или «Яндекс». При этом кластеризатор сравнивает все зависимые с главным запросом ключевые слова друг с другом.

Так поисковые запросы связываются между собой внутри кластера семантического ядра, но могут отличаться в разных парах проверяемых URL. У всех ключевых слов в кластере нет задачи пройти пересечение по URL-адресам в топе, сопутствующие поисковые запросы попадают в группу вместе с тематикозадающим запросом.

Middle-кластеризация подходит для информационных ресурсов с большим семантическим ядром или интернет-магазинам в слабоконкурентных нишах. Такой подход обеспечивает большую точность, чем при Soft-кластеризации, и не позволяет отсеивать большинство ключевых слов, как при Hard-группировке.

Сервисы и приложения для кластеризации семантического ядра

Для кластеризации семантики по анализу поисковых топов можно использовать десктопное ПО или онлайн-сервисы. Различие — в скорости, функциональности и цене. Рассмотрим, какой вариант кластеризации предпочтительнее исходя из задач оптимизатора.

Программы для кластеризации семантики

Desktop-программы предлагают большую функциональность, чем онлайн-сервисы, что позволяет тонко выбрать параметры группировки поисковых запросов или настроить интерфейс софта. У офлайн-программ для кластеризации есть ряд преимуществ и недостатков:

| Плюсы | Минусы |

| Можно гибко настроить параметры кластеризации и редактировать семантическое ядро внутри программы | Кластеризация выполняется на компьютере пользователя: для работы с большим семантическим ядром требуется стабильный интернет и производительное железо |

| Возможность полностью автоматизировать работу с семантикой. Например, в Key Collector ядро можно спарсить, очистить и сразу кластеризовать | Все функциональные программы для кластеризации платные. Цена наиболее популярного Key Collector — 2 200 рублей |

| Desktop-программы поддерживают больше форматов для импорта и экспорта, а также позволяют создать шаблон с настройками для дальнейшей работы с семантикой | Интерфейс desktop-программ сложнее, чем у онлайн-сервисов. Для удобной работы требуется пройти обучение и посмотреть гайды |

Наиболее популярным софтом для кластеризации считаются AllSubmitter, KeyClusterer и Key Collector.

Пример кластеризации запросов в Key Collector

Рассмотрим пример группировки семантического ядра на основе анализа поисковой выдаче на примере Key Collector — пожалуй, обязательного инструмента для SEO-специалистов.

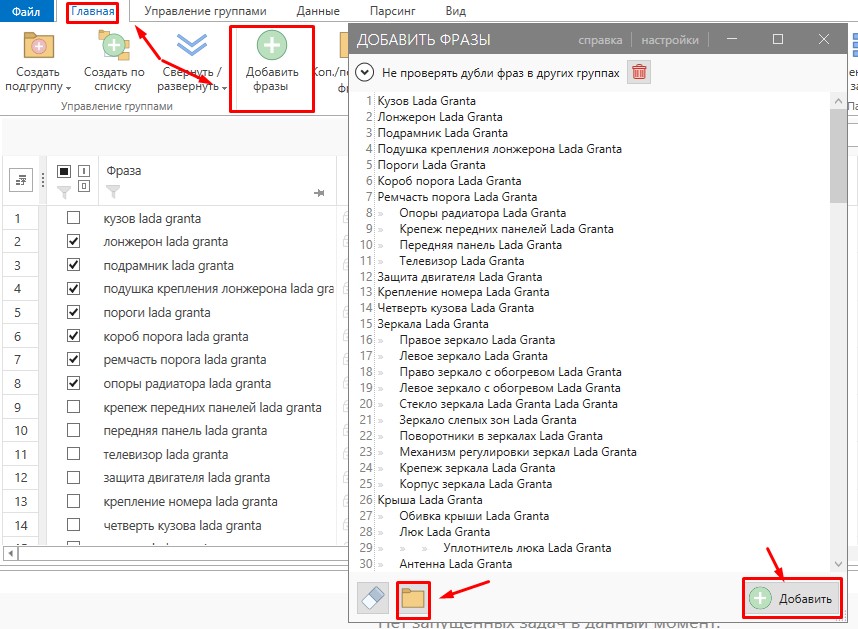

Прежде чем приступить к кластеризации, в программу требуется загрузить все семантическое ядро. Если данные собирались в Key Collector, нужно открыть сохраненный файл программы, если со сторонней программы — нужен импорт. Для импорта файлом или добавления вручную скопированных поисковых запросов переходим в раздел «Главная», где выбираем «Добавить фразы». Далее вставляем скопированную семантику или указываем адрес к файлу на компьютере:

Для группировки важно собрать по всем фразам частотность — это можно сделать здесь же в программе

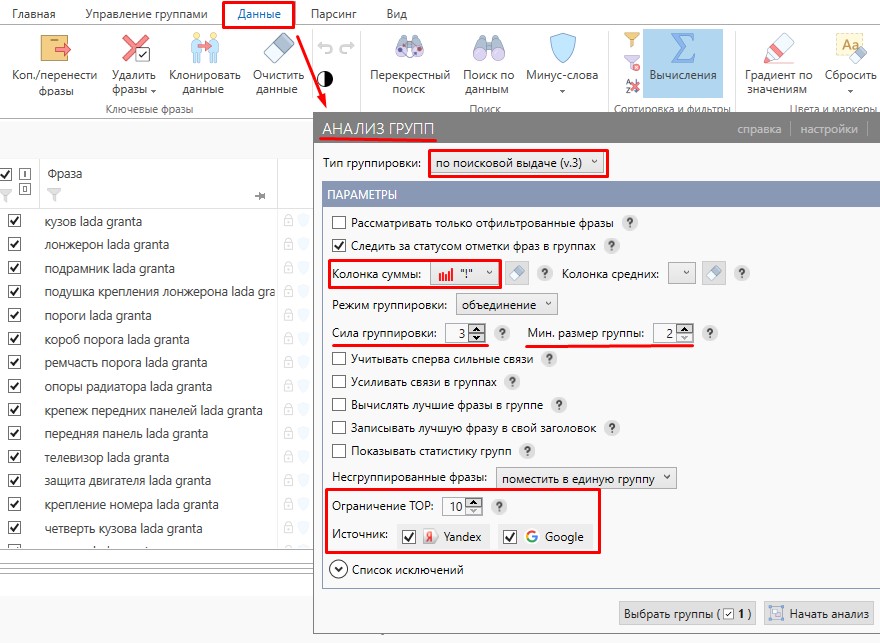

Отмечаем галочкой все поисковые запросы и переходим в раздел «Данные», где нажимаем «Анализ групп». Теперь выбираем параметр «По поисковой выдаче (улучшенная)», отмечаем поисковые системы и количество URL в выдаче для анализа. Далее нужно выбрать силу SERP для кластеризации — для семантики, где преобладают двух- или трехсловные поисковые запросы, будет достаточно порога в 3 пересечения.

На скриншоте показан пример Soft-кластеризации методом «объединения» запросов. Для проведения Hard-кластеризации режим группировки в настройках нужно заменить на «пересечение». При обновлении семантического ядра процедуру кластеризации придется повторить.

Онлайн-сервисы для кластеризации

Более простой подход к кластеризации производится с помощью онлайн-сервисов. Это позволяет обработать семантику быстрее и не требует обучения, как для профильного софта. Здесь также есть свои преимущества и недостатки:

| Плюсы | Минусы |

| Кластеризация проходит в максимально удобном формате — в пару кликов | Сервисы не позволяют обрабатывать большие семантические ядра |

| Оптимизатору не требуется вникать в технические нюансы. Интерфейс крайне дружественен пользователям | У онлайн-сервисов много ограничений: по количеству проверок, числу ключевых слов в ядре |

| Для разовых или нерегулярных работ онлайн-сервисы — наиболее удобный инструмент для кластеризации | В долгосрочной перспективе приобретение профильного ПО оказывается выгоднее и практичнее |

Наиболее популярные сервисы для кластеризации — Coolakov, Semantist и SeoQuick.

Пример онлайн кластеризации запросов в SeoQuick

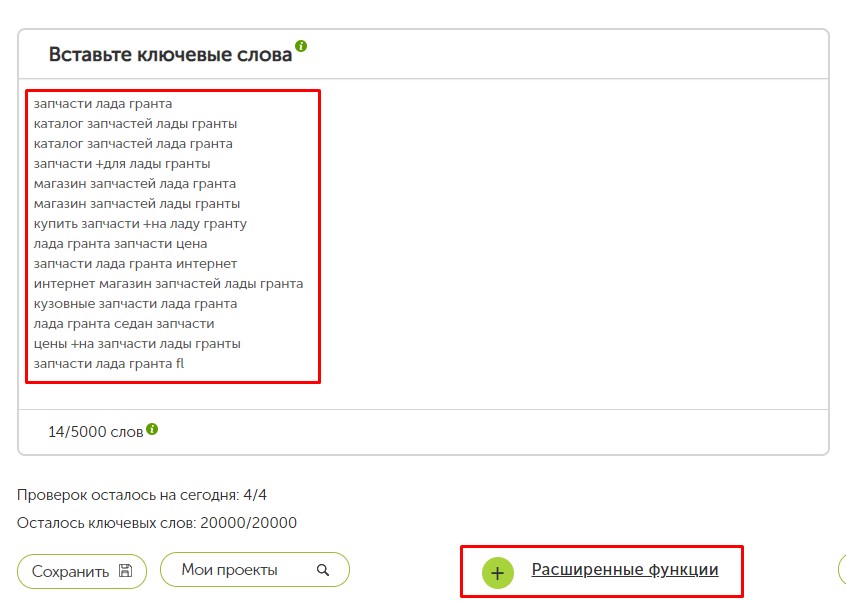

Для примера рассмотрим SeoQuick — это наиболее доступный и функциональный сервис. Он позволяет сделать за день 4 кластеризации с семантическим ядром до 5 000 ключевых слов.

Затем открываем «Расширенные функции». Также можно импортировать файлы txt, xls, xlsx, csv.

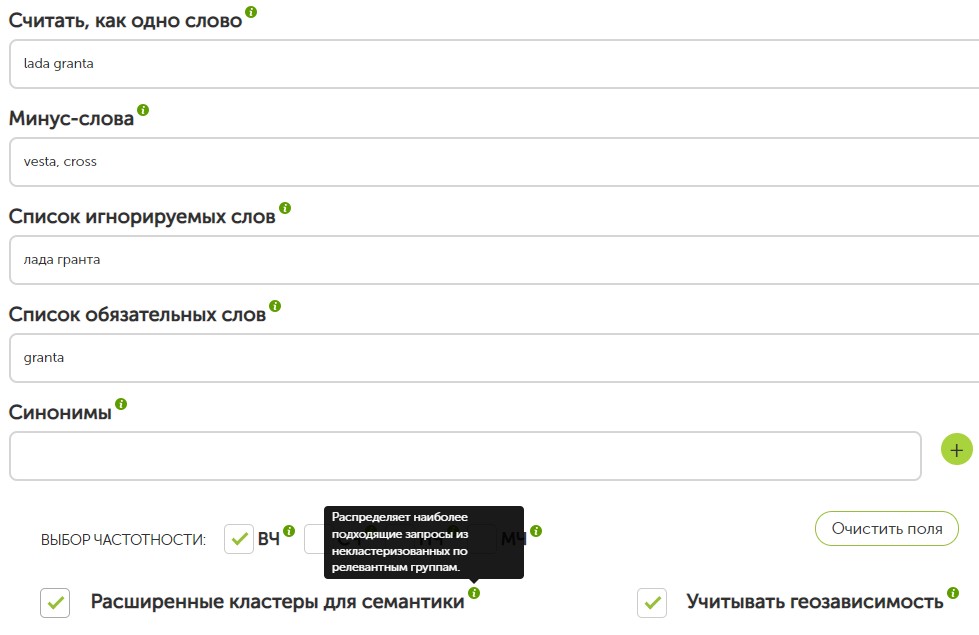

В дополнительных настройках можно задать список стоп-слов, обязательных поисковых запросов или приказать учитывать словосочетания как одно цельное ключевое слово.

Разбираем основные ошибки при кластеризации семантического ядра

Кластеризация считается самым сложным этапом при работе с семантическим ядром, на котором часто возникают ошибки. Рассмотрим топ популярных ошибок и дадим рекомендации по их упреждению.

| Распространенная проблема | Почему данная ошибка так популярна | Как не допустить ошибки при кластеризации |

| Запрос с разным интентом в одном семантическом кластере | Отсутствие четкого понимания интента и отказ от сегментирования ключевых слов по коммерческости | Обязательно сортировать семантику по коммерческости при кластеризации |

| Несоответствие ключевых слов тематике посадочной страницы | Нарушена логика группировки при ручной кластеризации или сегментирование объемного ядра Soft-кластеризатором | Провести чистку семантики, увеличить точность кластеризации, выбрав Middle- или Hard-метод сортировки. Отсортировать проблемные кластеры вручную после кластеризации |

| Слишком много ключевых слов в одном кластере | Попытка структурировать большое семантическое ядро Soft-кластеризацией | Повысить точность кластеризации для объемной семантики поможет middle или hard группировка |

| Ошибки в ключевых словах | Ручная кластеризация или неправильный перенос собранных ключевых слов после сбора семантики | Предупредить ошибки в ключевых словах помогает автоматический парсинг и экспорт собранной семантики в кластеризатор. Для удаления уже имеющихся ошибок перед кластеризацией нужно провести чистку ядра |

| Много дублей, мусорных вхождений и запросов с нулевой частотностью | Запуск кластеризации сразу после парсинга семантики, без чистки ядра | Провести чистку семантического ядра перед кластеризацией |

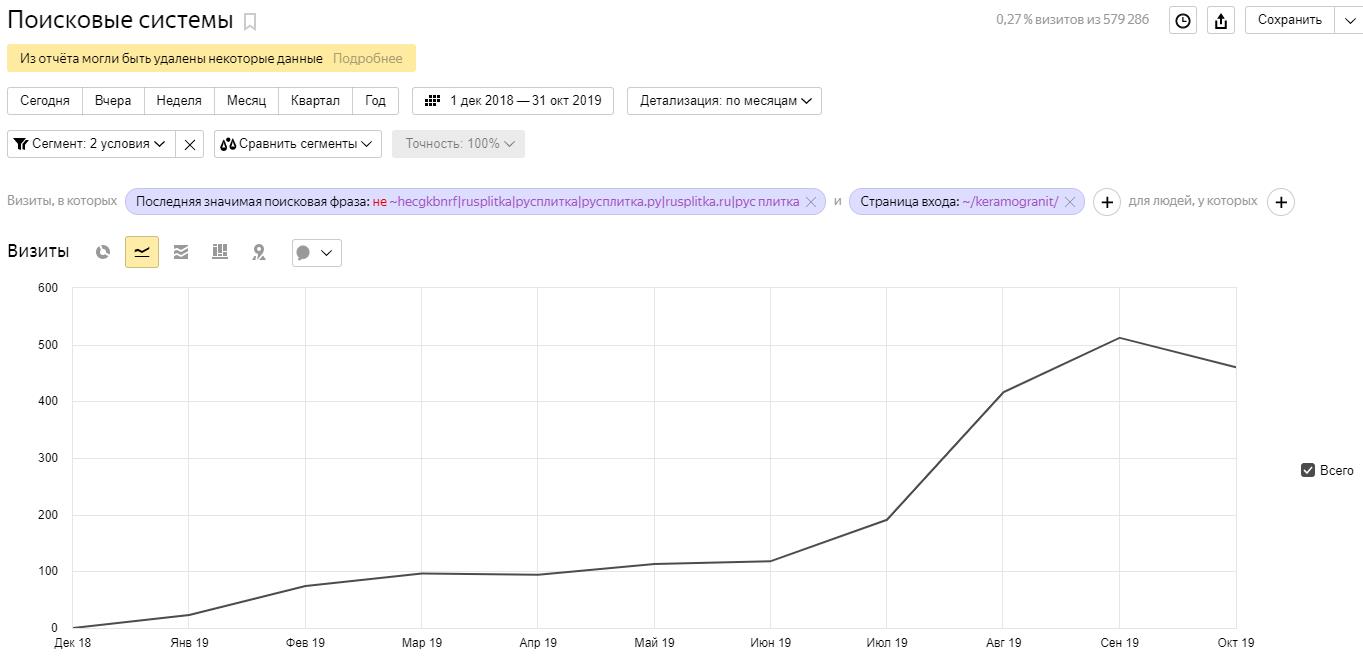

Кластеризация — обязательный этап поисковой оптимизации после расширения структуры сайта и обновления семантического ядра. Посмотрите, как это работает на практике, на примере кейса для Rusplitka.ru.

Грамотная кластеризация специалистов агентства Kokoc Group позволила сегментировать семантику после крупного обновления товарного ассортимента, помогла улучшить ранжирование сайта в поиске и увеличить количество уникальных визитов.

Это дало бонус при ранжировании и положительно повлияло на поведенческие факторы.

Если вам требуется помощь с кластеризацией большого семантического ядра или комплексное SEO-продвижение сайта, обращайтесь к специалистам Kokoc Group.

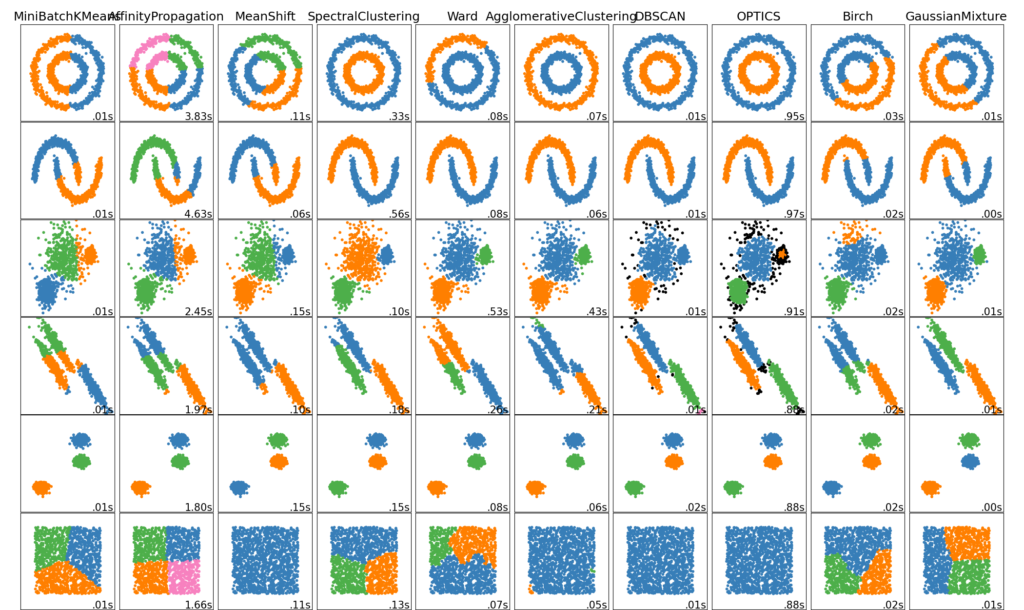

Кластеризация неразмеченных данных можно выполнить с помощью модуля sklearn.cluster.

Каждый алгоритм кластеризации имеет два варианта: класс, реализующий fit метод изучения кластеров на данных поезда, и функция, которая, учитывая данные поезда, возвращает массив целочисленных меток, соответствующих различным кластерам. Для класса метки над обучающими данными можно найти в labels_ атрибуте.

2.3.1. Обзор методов кластеризации

| Название метода | Параметры | Масштабируемость | Использование | Геометрия (используемая метрика) |

|---|---|---|---|---|

| К-средник | число кластеров | Очень большое значение n симплов среднее n_clusters вместе с Мини батчи K-средних | Универсальный, любой размер кластеров, плоская геометрия, не слишком много кластеров | Дистанция между точками |

| Афинное распространение | дамфинг, предпочтение выборки | Не масштабируется с помощью n_clusters | Много кластеров, не равномерный размер кластера, неплоская геометрия | Дистанция графа (например граф ближайших соседей) |

| Средний сдвиг | пропускная способность | Не масштабируется с помощью n_clusters | Много кластеров, не равномерный размер кластера, неплоская геометрия | Дистанция между точками |

| Спектральная кластеризация | число кластеров | Средняя n симплов маленькое n_clasters | Мало кластеров, или размер кластера, неплоская геометрия | Дистанция графа (например граф ближайших соседей) |

| Иерархическая кластеризация | чилсо кластеров или порог расстояния | Большое n симплов и n_clasters | Мало кластеров, возможно ограничене связей | Дистанция между точками |

| Агломеративная кластеризация | число кластеров, порог дистанции, тип связи, дистанция | Большое n симплов и n_clasters | Мало кластеров, возможно ограничене связей и не Евклидовое расстояние | Любая попарная дистанция |

| DBSCAN | размер окрестности | Очень большое n симплов и среднее n_clasters | не плоская геометрия, неравномерный размер кластеров | Дистанция между ближайшими точками |

| OPTICS | Минимальное количество элементов в кластере | Очень большое n симплов и большое n_clasters | не плоская геометрия, неравномерный размер кластеров, переменная плотность кластеров | Дистанция между точками |

| Гауссовская Смешаянная модель | много параметров | не масштабируемо | плоская геометрия, подходит для оценки плотности | Расстояния до центров Махаланобиса |

| Birch | факторы ветвления, порог, не обязательный глобальный кластер | Большое n симплов и n_clasters | Большой объем данных, удаление выбросов, сокращение данных | Евклидовое расстояние между точками |

Неплоская геометрия кластеризации полезно когда кластеры имеют специфичную форму, то есть многообразие и стандартное евклидовое расстояние в качестве метрики не подходят. Это случай возникает в двух верхних строках рисунка.

Гауссовская Смешаянная модель полезна для кластеризации описанные в другой статье документации, посвященная смешанным моделям. Метод K-средних можно расматривать как частный случай Гауссовской смешанной модели с равной ковариации для каждого компонента.

Методы трансдуктивной кластеризации (в отличие отметодов индуктивной кластеризации) не предназначены для применения к новым, невидимым данным.

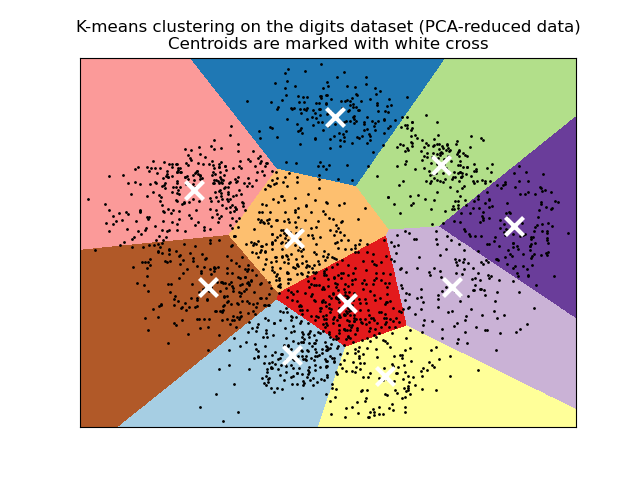

2.3.2. K-средних

Эти KMeans данные алгоритмы кластеров пытаются отдельными образцы в п групп одинаковой дисперсии, сводя к минимуму критерия , известный как инерция или внутри-кластера сумм квадратов (см ниже). Этот алгоритм требует указания количества кластеров. Он хорошо масштабируется для большого количества образцов и используется в широком диапазоне областей применения во многих различных областях.

Алгоритм k-средних делит набор $N$ образцы $X$ в $K$ непересекающиеся кластеры $C$, каждый из которых описывается средним $mu_j$ образцов в кластере. Средние значения обычно называют «центроидами» кластера; обратите внимание, что это, как правило, не баллы из $X$, хотя они живут в одном пространстве.

Алгоритм K-средних нацелен на выбор центроидов, которые минимизируют инерцию или критерий суммы квадратов внутри кластера : $$sum_{i=0}^{n}min_{mu_j in C}(||x_i — mu_j||^2)$$

Инерцию можно определить как меру того, насколько кластеры внутренне связаны. Он страдает различными недостатками:

- Инерция предполагает, что кластеры выпуклые и изотропные, что не всегда так. Он плохо реагирует на удлиненные кластеры или коллекторы неправильной формы.

- Инерция — это не нормализованная метрика: мы просто знаем, что более низкие значения лучше, а ноль — оптимально. Но в очень многомерных пространствах евклидовы расстояния имеют тенденцию становиться раздутыми (это пример так называемого «проклятия размерности»). Выполнение алгоритма уменьшения размерности, такого как анализ главных компонентов (PCA) перед кластеризацией k-средних, может облегчить эту проблему и ускорить вычисления.

K-средних часто называют алгоритмом Ллойда. В общих чертах алгоритм состоит из трех шагов. На первом этапе выбираются начальные центроиды, а самый простой метод — выбрать $k$ образцы из набора данных $X$. После инициализации K-средних состоит из цикла между двумя другими шагами. Первый шаг присваивает каждой выборке ближайший центроид. На втором этапе создаются новые центроиды, взяв среднее значение всех выборок, назначенных каждому предыдущему центроиду. Вычисляется разница между старым и новым центроидами, и алгоритм повторяет эти последние два шага, пока это значение не станет меньше порогового значения. Другими словами, это повторяется до тех пор, пока центроиды не переместятся значительно.

K-средних эквивалентно алгоритму максимизации ожидания с маленькой, все равной диагональной ковариационной матрицей.

Алгоритм также можно понять через концепцию диаграмм Вороного. Сначала рассчитывается диаграмма Вороного точек с использованием текущих центроидов. Каждый сегмент на диаграмме Вороного становится отдельным кластером. Во-вторых, центроиды обновляются до среднего значения каждого сегмента. Затем алгоритм повторяет это до тех пор, пока не будет выполнен критерий остановки. Обычно алгоритм останавливается, когда относительное уменьшение целевой функции между итерациями меньше заданного значения допуска. В этой реализации дело обстоит иначе: итерация останавливается, когда центроиды перемещаются меньше допуска.

По прошествии достаточного времени K-средние всегда будут сходиться, однако это может быть локальным минимумом. Это сильно зависит от инициализации центроидов. В результате вычисление часто выполняется несколько раз с разными инициализациями центроидов. Одним из способов решения этой проблемы является схема инициализации k-means++, которая была реализована в scikit-learn (используйте init='k-means++'параметр). Это инициализирует центроиды (как правило) удаленными друг от друга, что, вероятно, приводит к лучшим результатам, чем случайная инициализация, как показано в справочнике.

K-means++ также может вызываться независимо для выбора начальных значений для других алгоритмов кластеризации, sklearn.cluster.kmeans_plusplus подробности и примеры использования см. В разделе .

Алгоритм поддерживает выборочные веса, которые могут быть заданы параметром sample_weight. Это позволяет присвоить некоторым выборкам больший вес при вычислении центров кластеров и значений инерции. Например, присвоение веса 2 выборке эквивалентно добавлению дубликата этой выборки в набор данных $X$.

Метод K-средних может использоваться для векторного квантования. Это достигается с помощью метода преобразования обученной модели KMeans.

2.3.2.1. Низкоуровневый параллелизм

KMeans преимущества параллелизма на основе OpenMP через Cython. Небольшие порции данных (256 выборок) обрабатываются параллельно, что, кроме того, снижает объем памяти. Дополнительные сведения о том, как контролировать количество потоков, см. В наших заметках о параллелизме .

Примеры:

- Демонстрация предположений k-средних : демонстрация того, когда k-средних работает интуитивно, а когда нет

- Демонстрация кластеризации K-средних на данных рукописных цифр : Кластеризация рукописных цифр

Рекомендации:

- «K-means ++: преимущества тщательного посева» Артур, Дэвид и Сергей Васильвицкий, Труды восемнадцатого ежегодного симпозиума ACM-SIAM по дискретным алгоритмам , Общество промышленной и прикладной математики (2007)

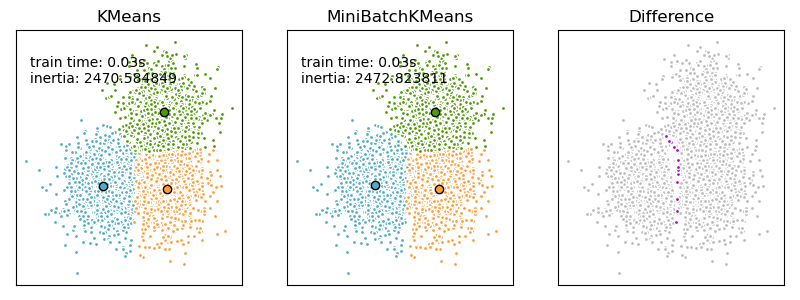

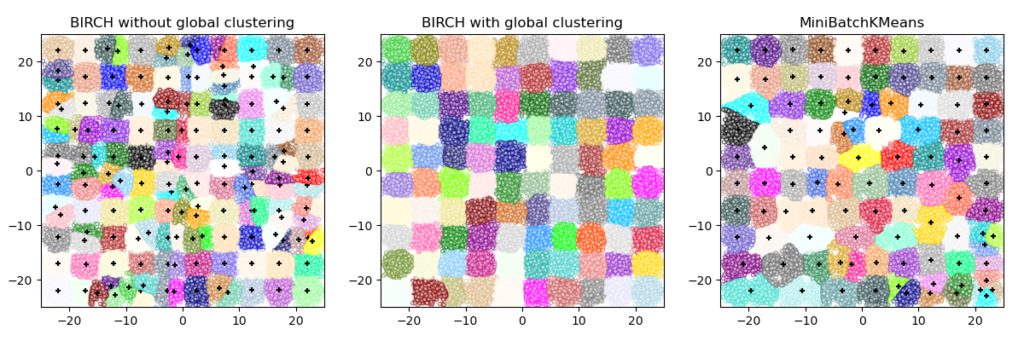

2.3.2.2. Мини-партия K-средних

Это MiniBatchKMeans вариант KMeans алгоритма, который использует мини-пакеты для сокращения времени вычислений, но при этом пытается оптимизировать ту же целевую функцию. Мини-пакеты — это подмножества входных данных, которые выбираются случайным образом на каждой итерации обучения. Эти мини-пакеты резко сокращают объем вычислений, необходимых для схождения к локальному решению. В отличие от других алгоритмов, которые сокращают время сходимости k-средних, мини-пакетные k-средние дают результаты, которые, как правило, лишь немного хуже, чем стандартный алгоритм.

Алгоритм повторяется между двумя основными шагами, аналогично обычным k-средним. На первом этапе $b$ образцы выбираются случайным образом из набора данных, чтобы сформировать мини-пакет. Затем они присваиваются ближайшему центроиду. На втором этапе обновляются центроиды. В отличие от k-средних, это делается для каждой выборки. Для каждой выборки в мини-пакете назначенный центроид обновляется путем взятия среднего потокового значения выборки и всех предыдущих выборок, назначенных этому центроиду. Это приводит к снижению скорости изменения центроида с течением времени. Эти шаги выполняются до тех пор, пока не будет достигнута сходимость или заранее определенное количество итераций.

MiniBatchKMeans сходится быстрее, чем KMeans, но качество результатов снижается. На практике эта разница в качестве может быть довольно небольшой, как показано в примере и цитированной ссылке.

Примеры:

- Сравнение алгоритмов кластеризации K-средних и MiniBatchKMeans : сравнение KMeans и MiniBatchKMeans

- Кластеризация текстовых документов с использованием k-средних : кластеризация документов с использованием разреженных MiniBatchKMeans

- Онлайн обучение словаря частей лиц

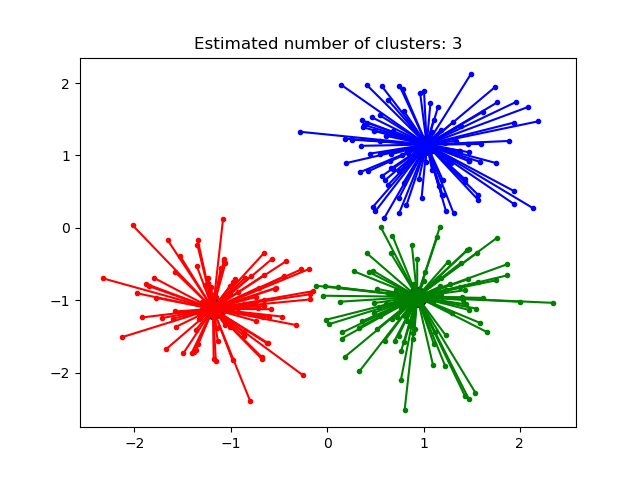

2.3.3. Распространения близости (Affinity Propagation)

AffinityPropagation создает кластеры, отправляя сообщения между парами образцов до схождения. Затем набор данных описывается с использованием небольшого количества образцов, которые определяются как наиболее репрезентативные для других образцов. Сообщения, отправляемые между парами, представляют пригодность одного образца быть образцом другого, который обновляется в ответ на значения из других пар. Это обновление происходит итеративно до сходимости, после чего выбираются окончательные образцы и, следовательно, дается окончательная кластеризация.

Метод Распространения близости может быть интересным, поскольку он выбирает количество кластеров на основе предоставленных данных. Для этой цели двумя важными параметрами являются предпочтение , которое контролирует, сколько экземпляров используется, и коэффициент демпфирования, который снижает ответственность и сообщения о доступности, чтобы избежать числовых колебаний при обновлении этих сообщений.

Главный недостаток метода Распространения близости — его сложность. Алгоритм имеет временную сложность порядка $O(N^2 T)$, где $N$ количество образцов и $T$ — количество итераций до сходимости. Далее, сложность памяти порядка $O(N^2)$ если используется плотная матрица подобия, но может быть сокращена, если используется разреженная матрица подобия. Это делает метод Распространения близости наиболее подходящим для наборов данных малого и среднего размера.

Примеры:

- Демонстрация алгоритма кластеризации распространения близости: метода Распространения близости на синтетических наборах данных 2D с 3 классами.

- Визуализация структуры фондового рынка Финансовые временные ряды метода Распространения близости для поиска групп компаний

Описание алгоритма: сообщения, отправляемые между точками, относятся к одной из двух категорий. Во-первых, это ответственность $r(i,k)$, которое является накопленным свидетельством того, что образец $k$ должен быть образцом для образца $i$. Второе — доступность $a(i,k)$ что является накопленным свидетельством того, что образец $i$ следует выбрать образец $k$ быть его образцом, и учитывает значения для всех других образцов, которые $k$ должен быть образцом. Таким образом, образцы выбираются по образцам, если они (1) достаточно похожи на многие образцы и (2) выбираются многими образцами, чтобы быть репрезентативными.

Более формально ответственность за образец $k$ быть образцом образца i дан кем-то: $$r(i, k) leftarrow s(i, k) — max [ a(i, k’) + s(i, k’) forall k’ neq k ]$$

Где $s(i,k)$ сходство между образцами $i$ а также $k$. Наличие образца $k$ быть образцом образца $i$ дан кем-то: $$a(i, k) leftarrow min [0, r(k, k) + sum_{i’~s.t.~i’ notin {i, k}}{r(i’, k)}]$$

Начнем с того, что все значения для $r$ и $a$ aустановлены в ноль, и расчет каждой итерации повторяется до сходимости. Как обсуждалось выше, чтобы избежать числовых колебаний при обновлении сообщений, коэффициент демпфирования $lambda$ вводится в итерационный процесс: $$r_{t+1}(i, k) = lambdacdot r_{t}(i, k) + (1-lambda)cdot r_{t+1}(i, k)$$ $$a_{t+1}(i, k) = lambdacdot a_{t}(i, k) + (1-lambda)cdot a_{t+1}(i, k)$$

где $t$ указывает время итерации.

2.3.4. Средний сдвиг

MeanShift кластеризация направлена на обнаружение капель в образцах с плавной плотностью. Это алгоритм на основе центроидов, который работает, обновляя кандидатов в центроиды, чтобы они были средними точками в данном регионе. Затем эти кандидаты фильтруются на этапе постобработки, чтобы исключить почти дубликаты и сформировать окончательный набор центроидов.

Учитывая центроид кандидата $x_i$ для итерации $t$, кандидат обновляется в соответствии со следующим уравнением: $$x_i^{t+1} = m(x_i^t)$$

Где $N(x_i)$ это соседство образцов на заданном расстоянии вокруг $x_i$ а также $m$ — вектор среднего сдвига, который вычисляется для каждого центроида, который указывает на область максимального увеличения плотности точек. Это вычисляется с использованием следующего уравнения, эффективно обновляющего центроид до среднего значения выборок в его окрестности: $$m(x_i) = frac{sum_{x_j in N(x_i)}K(x_j — x_i)x_j}{sum_{x_j in N(x_i)}K(x_j — x_i)}$$

Алгоритм автоматически устанавливает количество кластеров, вместо того, чтобы полагаться на параметр bandwidth, который определяет размер области для поиска. Этот параметр можно установить вручную, но можно оценить с помощью предоставленной estimate_bandwidth функции, которая вызывается, если полоса пропускания не задана.

Алгоритм не отличается высокой масштабируемостью, так как он требует многократного поиска ближайшего соседа во время выполнения алгоритма. Алгоритм гарантированно сходится, однако алгоритм прекратит итерацию, когда изменение центроидов будет небольшим.

Маркировка нового образца выполняется путем нахождения ближайшего центроида для данного образца.

Примеры:

- Демонстрация алгоритма кластеризации среднего сдвига: кластеризация среднего сдвига на синтетических наборах данных 2D с 3 классами.

Рекомендации:

- «Средний сдвиг: надежный подход к анализу пространства признаков». Д. Команичиу и П. Меер, IEEE Transactions on Pattern Analysis and Machine Intelligence (2002)

2.3.5. Спектральная кластеризация

SpectralClustering выполняет низкоразмерное встраивание матрицы аффинности между выборками с последующей кластеризацией, например, с помощью K-средних, компонентов собственных векторов в низкоразмерном пространстве. Это особенно эффективно с точки зрения вычислений, если матрица аффинности является разреженной, а amgрешатель используется для проблемы собственных значений (обратите внимание, amg что решающая программа требует, чтобы был установлен модуль pyamg ).

Текущая версия SpectralClustering требует, чтобы количество кластеров было указано заранее. Это хорошо работает для небольшого количества кластеров, но не рекомендуется для многих кластеров.

Для двух кластеров SpectralClustering решает выпуклую релаксацию проблемы нормализованных разрезов на графе подобия: разрезание графа пополам так, чтобы вес разрезаемых рёбер был мал по сравнению с весами рёбер внутри каждого кластера. Этот критерий особенно интересен при работе с изображениями, где вершинами графа являются пиксели, а веса ребер графа подобия вычисляются с использованием функции градиента изображения.

Предупреждение:

Преобразование расстояния в хорошее сходство

Обратите внимание, что если значения вашей матрицы подобия плохо распределены, например, с отрицательными значениями или с матрицей расстояний, а не с подобием, спектральная проблема будет сингулярной, а проблема неразрешима. В этом случае рекомендуется применить преобразование к элементам матрицы. Например, в случае матрицы расстояний со знаком обычно применяется тепловое ядро:

similarity = np.exp(-beta * distance / distance.std()) См. Примеры такого приложения.

Примеры:

- Спектральная кластеризация для сегментации изображения : сегментирование объектов на шумном фоне с использованием спектральной кластеризации.

- Сегментирование изображения греческих монет по регионам : спектральная кластеризация для разделения изображения монет по регионам.

2.3.5.1. Различные стратегии присвоения меток

Могут использоваться различные стратегии присвоения меток, соответствующие assign_labels параметру SpectralClustering. "kmeans" стратегия может соответствовать более тонким деталям, но может быть нестабильной. В частности, если вы не контролируете random_state, он может не воспроизводиться от запуска к запуску, так как это зависит от случайной инициализации. Альтернативная "discretize" стратегия воспроизводима на 100%, но имеет тенденцию создавать участки довольно ровной и геометрической формы.

2.3.5.2. Графики спектральной кластеризации

Спектральная кластеризация также может использоваться для разбиения графов через их спектральные вложения. В этом случае матрица аффинности является матрицей смежности графа, а SpectralClustering инициализируется с помощью affinity='precomputed':

>>> from sklearn.cluster import SpectralClustering >>> sc = SpectralClustering(3, affinity='precomputed', n_init=100, ... assign_labels='discretize') >>> sc.fit_predict(adjacency_matrix)

Рекомендации:

- «Учебное пособие по спектральной кластеризации» Ульрике фон Люксбург, 2007 г.

- «Нормализованные разрезы и сегментация изображения» Джианбо Ши, Джитендра Малик, 2000 г.

- «Случайный взгляд на спектральную сегментацию» Марина Мейла, Цзяньбо Ши, 2001

- «О спектральной кластеризации: анализ и алгоритм» Эндрю Й. Нг, Майкл И. Джордан, Яир Вайс, 2001 г.

- «Предварительно обусловленная спектральная кластеризация для задачи потокового графа стохастического разбиения блоков» Давид Жужунашвили, Андрей Князев

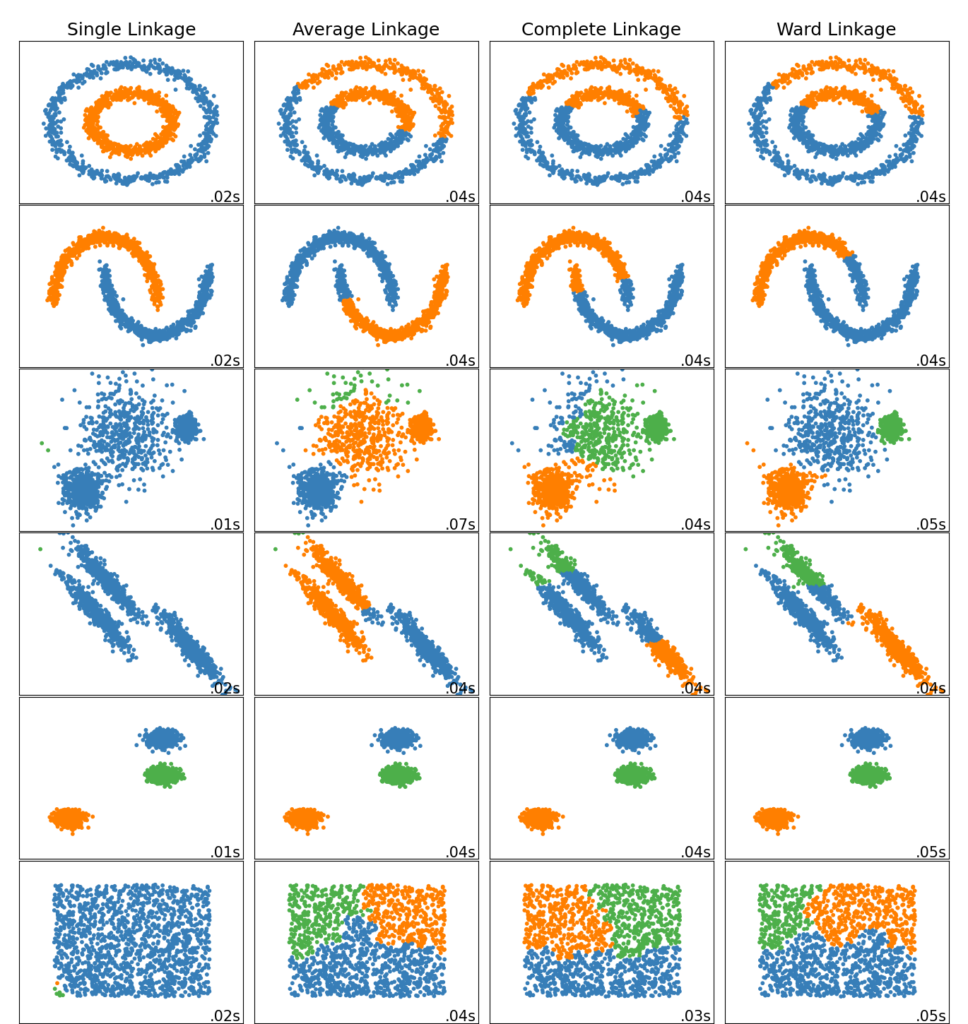

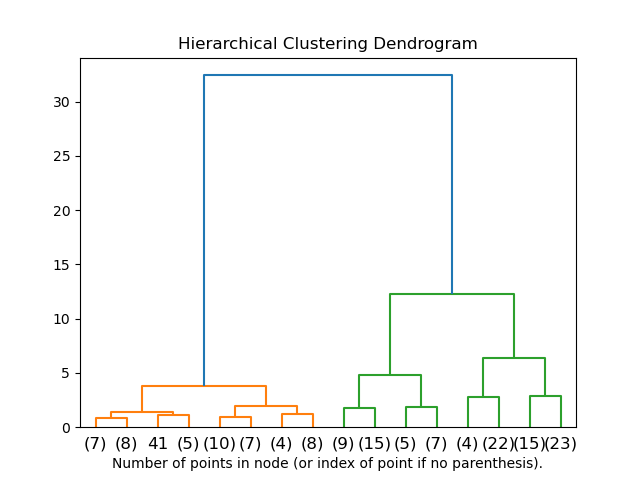

2.3.6. Иерархическая кластеризация

Иерархическая кластеризация — это общее семейство алгоритмов кластеризации, которые создают вложенные кластеры путем их последовательного слияния или разделения. Эта иерархия кластеров представлена в виде дерева (или дендрограммы). Корень дерева — это уникальный кластер, который собирает все образцы, а листья — это кластеры только с одним образцом. См. Страницу в Википедии для получения более подробной информации.

В AgglomerativeClustering объекте выполняет иерархическую кластеризацию с использованием подхода снизу вверх: каждый начинает наблюдения в своем собственном кластере, и кластеры последовательно объединены вместе. Критерии связывания определяют метрику, используемую для стратегии слияния:

- Ward минимизирует сумму квадратов разностей во всех кластерах. Это подход с минимизацией дисперсии, и в этом смысле он аналогичен целевой функции k-средних, но решается с помощью агломеративного иерархического подхода.

- Максимальное (Maximum) или полное связывание (complete linkage) сводит к минимуму максимальное расстояние между наблюдениями пар кластеров.

- Среднее связывание (Average linkage) минимизирует среднее расстояние между всеми наблюдениями пар кластеров.

- Одиночная связь (Single linkage) минимизирует расстояние между ближайшими наблюдениями пар кластеров.

AgglomerativeClustering может также масштабироваться до большого количества выборок, когда он используется вместе с матрицей связности, но требует больших вычислительных затрат, когда между выборками не добавляются ограничения связности: он рассматривает на каждом шаге все возможные слияния.

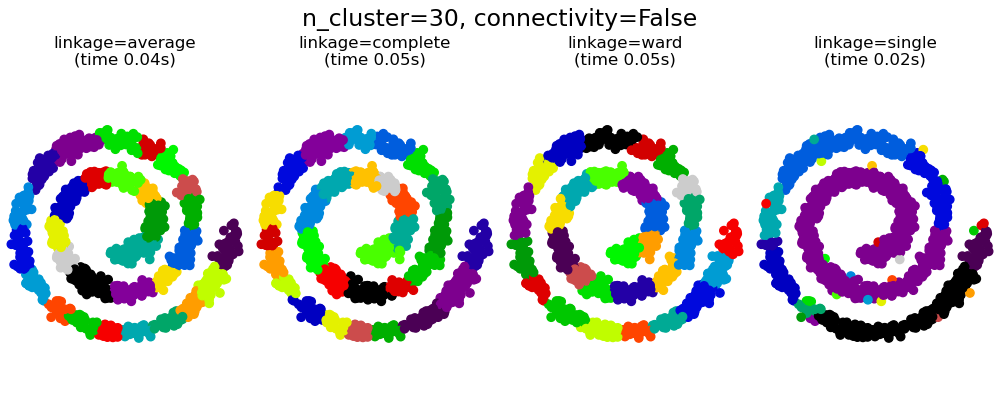

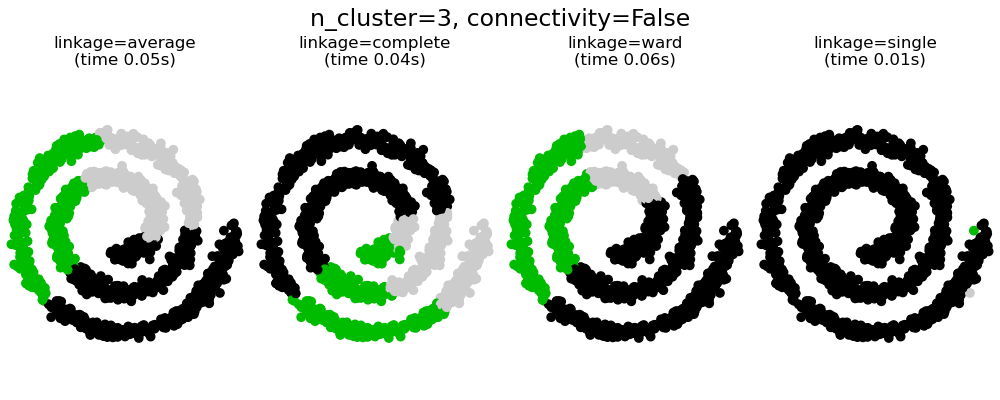

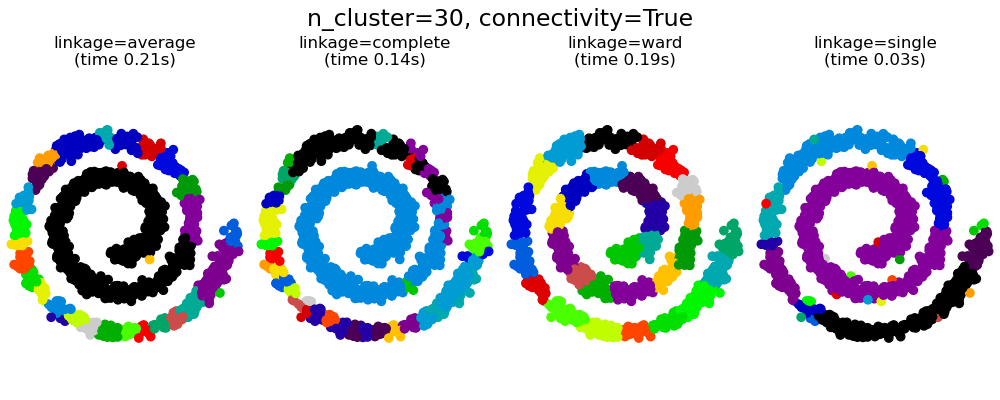

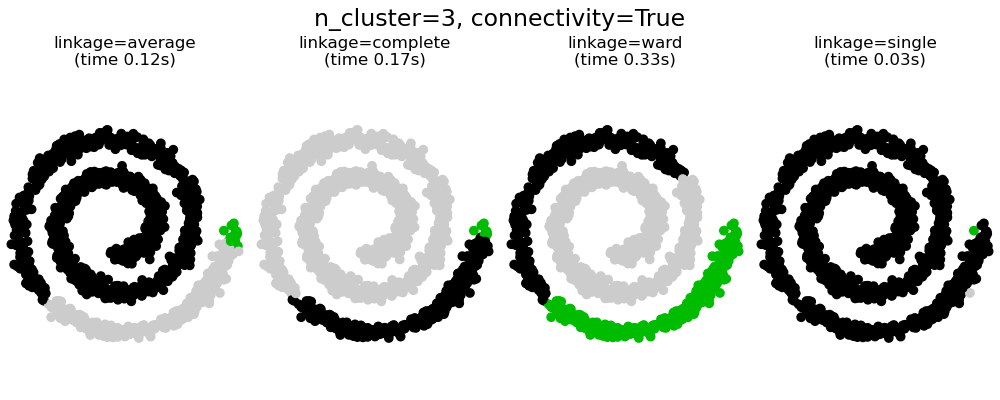

2.3.6.1. Различные типы связи: Ward, полный, средний и одиночный связь

AgglomerativeClustering поддерживает стратегии Ward, одиночного, среднего и полного связывания.

Агломеративный кластер ведет себя по принципу «богатый становится богатее», что приводит к неравномерному размеру кластера. В этом отношении одинарная связь — худшая стратегия, и Ward дает самые обычные размеры. Однако сродство (или расстояние, используемое при кластеризации) нельзя изменять с помощью Уорда, поэтому для неевклидовых показателей хорошей альтернативой является среднее связывание. Одиночная связь, хотя и не устойчива к зашумленным данным, может быть вычислена очень эффективно и поэтому может быть полезна для обеспечения иерархической кластеризации больших наборов данных. Одиночная связь также может хорошо работать с неглобулярными данными.

Примеры:

- Различная агломеративная кластеризация по двумерному встраиванию цифр : изучение различных стратегий связывания в реальном наборе данных.

2.3.6.2. Визуализация кластерной иерархии

Можно визуализировать дерево, представляющее иерархическое слияние кластеров, в виде дендрограммы. Визуальный осмотр часто может быть полезен для понимания структуры данных, особенно в случае небольших размеров выборки.

2.3.6.3. Добавление ограничений связи

Интересным аспектом AgglomerativeClustering является то, что к этому алгоритму могут быть добавлены ограничения связности (только соседние кластеры могут быть объединены вместе) через матрицу связности, которая определяет для каждой выборки соседние выборки, следующие заданной структуре данных. Например, в приведенном ниже примере швейцарского рулона ограничения связности запрещают объединение точек, которые не являются смежными на швейцарском рулоне, и, таким образом, избегают образования кластеров, которые проходят через перекрывающиеся складки рулона.

Эти ограничения полезны для наложения определенной локальной структуры, но они также ускоряют алгоритм, особенно когда количество выборок велико.

Ограничения связности накладываются через матрицу связности: scipy разреженную матрицу, которая имеет элементы только на пересечении строки и столбца с индексами набора данных, которые должны быть связаны. Эта матрица может быть построена из априорной информации: например, вы можете захотеть сгруппировать веб-страницы, объединяя только страницы со ссылкой, указывающей одну на другую. Это также можно узнать из данных, например, используя sklearn.neighbors.kneighbors_graph для ограничения слияния до ближайших соседей, как в этом примере , или с помощью, sklearn.feature_extraction.image.grid_to_graphчтобы разрешить слияние только соседних пикселей на изображении, как в примере с монетой.

Примеры:

- Демонстрация структурированной иерархической кластеризации Варда на изображении монет : Кластеризация Варда для разделения изображения монет на регионы.

- Иерархическая кластеризация: структурированная и неструктурированная палата : пример алгоритма Уорда в швейцарской системе, сравнение структурированных подходов и неструктурированных подходов.

- Агломерация признаков против одномерного выбора: пример уменьшения размерности с агломерацией признаков на основе иерархической кластеризации Уорда.

- Агломеративная кластеризация со структурой и без нее

Предупреждение Ограничения по подключению с одиночным, средним и полным подключением

Ограничения связности и одиночная, полная или средняя связь могут усилить аспект агломеративной кластеризации «богатый становится еще богаче», особенно если они построены на sklearn.neighbors.kneighbors_graph. В пределе небольшого числа кластеров они имеют тенденцию давать несколько макроскопически занятых кластеров и почти пустые. (см. обсуждение в разделе «Агломеративная кластеризация со структурой и без нее» ). Одиночная связь — самый хрупкий вариант связи в этом вопросе.

2.3.6.4. Варьируя метрику

Одиночная, средняя и полная связь может использоваться с различными расстояниями (или сходствами), в частности евклидовым расстоянием ( l2 ), манхэттенским расстоянием (или Cityblock, или l1 ), косинусным расстоянием или любой предварительно вычисленной матрицей аффинности.

- Расстояние l1 часто хорошо для разреженных функций или разреженного шума: то есть многие из функций равны нулю, как при интеллектуальном анализе текста с использованием вхождений редких слов.

- косинусное расстояние интересно тем, что оно инвариантно к глобальному масштабированию сигнала.

Рекомендации по выбору метрики — использовать метрику, которая максимизирует расстояние между выборками в разных классах и минимизирует его внутри каждого класса.

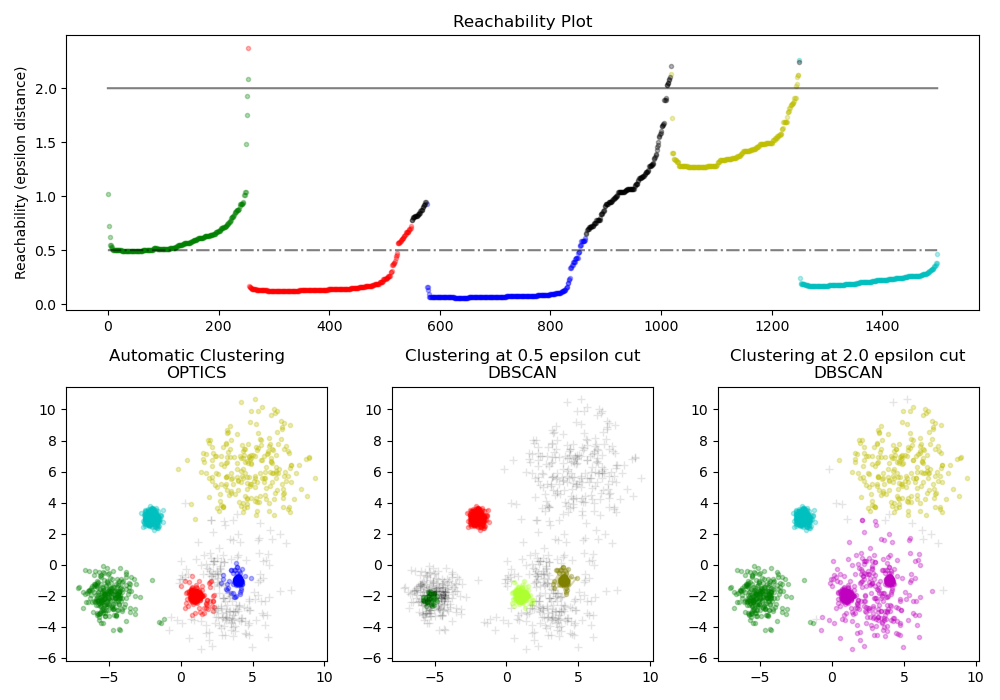

2.3.7. DBSCAN

Алгоритм DBSCAN рассматривает кластеры , как участки высокой плотности , разделенных районах с низкой плотностью. Из-за этого довольно общего представления кластеры, обнаруженные с помощью DBSCAN, могут иметь любую форму, в отличие от k-средних, которое предполагает, что кластеры имеют выпуклую форму. Центральным компонентом DBSCAN является концепция образцов керна , то есть образцов, находящихся в областях с высокой плотностью. Таким образом, кластер представляет собой набор образцов керна, каждый из которых находится близко друг к другу (измеряется с помощью некоторой меры расстояния), и набор образцов, не относящихся к керну, которые близки к образцу керна (но сами не являются образцами керна). В алгоритме есть два параметра, min_samples и eps, которые формально определяют, что мы имеем в виду, когда говорим «плотный» . Выше min_samples или ниже eps указывают на более высокую плотность, необходимую для формирования кластера.

Более формально мы определяем образец керна как образец в наборе данных, так что существуют min_samples другие образцы на расстоянии eps, которые определены как соседи образца керна. Это говорит нам о том, что основной образец находится в плотной области векторного пространства. Кластер — это набор образцов керна, который можно построить путем рекурсивного взятия образца керна, поиска всех его соседей, которые являются образцами керна, поиска всех их соседей, которые являются образцами керна, и т. Кластер также имеет набор неосновных выборок, которые представляют собой выборки, которые являются соседями керновой выборки в кластере, но сами не являются основными выборками. Интуитивно эти образцы находятся на периферии кластера.

Любой образец керна по определению является частью кластера. Любая выборка, не являющаяся образцом керна и находящаяся по крайней мере eps на расстоянии от любой выборки керна, считается алгоритмом выбросом.