From Wikipedia, the free encyclopedia

In signal processing, the Wiener filter is a filter used to produce an estimate of a desired or target random process by linear time-invariant (LTI) filtering of an observed noisy process, assuming known stationary signal and noise spectra, and additive noise. The Wiener filter minimizes the mean square error between the estimated random process and the desired process.

Description[edit]

The goal of the Wiener filter is to compute a statistical estimate of an unknown signal using a related signal as an input and filtering that known signal to produce the estimate as an output. For example, the known signal might consist of an unknown signal of interest that has been corrupted by additive noise. The Wiener filter can be used to filter out the noise from the corrupted signal to provide an estimate of the underlying signal of interest. The Wiener filter is based on a statistical approach, and a more statistical account of the theory is given in the minimum mean square error (MMSE) estimator article.

Typical deterministic filters are designed for a desired frequency response. However, the design of the Wiener filter takes a different approach. One is assumed to have knowledge of the spectral properties of the original signal and the noise, and one seeks the linear time-invariant filter whose output would come as close to the original signal as possible. Wiener filters are characterized by the following:[1]

- Assumption: signal and (additive) noise are stationary linear stochastic processes with known spectral characteristics or known autocorrelation and cross-correlation

- Requirement: the filter must be physically realizable/causal (this requirement can be dropped, resulting in a non-causal solution)

- Performance criterion: minimum mean-square error (MMSE)

This filter is frequently used in the process of deconvolution; for this application, see Wiener deconvolution.

Wiener filter solutions[edit]

Let

The Wiener filter problem has solutions for three possible cases: one where a noncausal filter is acceptable (requiring an infinite amount of both past and future data), the case where a causal filter is desired (using an infinite amount of past data), and the finite impulse response (FIR) case where only input data is used (i.e. the result or output is not fed back into the filter as in the IIR case). The first case is simple to solve but is not suited for real-time applications. Wiener’s main accomplishment was solving the case where the causality requirement is in effect; Norman Levinson gave the FIR solution in an appendix of Wiener’s book.

Noncausal solution[edit]

where

and the solution

Causal solution[edit]

where

This general formula is complicated and deserves a more detailed explanation. To write down the solution

- Start with the spectrum

in rational form and factor it into causal and anti-causal components:

where

contains all the zeros and poles in the left half plane (LHP) and

contains the zeroes and poles in the right half plane (RHP). This is called the Wiener–Hopf factorization.

- Divide

by

and write out the result as a partial fraction expansion.

- Select only those terms in this expansion having poles in the LHP. Call these terms

.

- Divide

by

. The result is the desired filter transfer function

.

Finite impulse response Wiener filter for discrete series[edit]

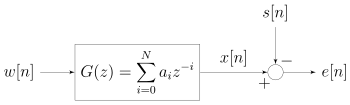

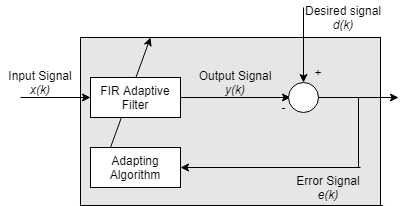

Block diagram view of the FIR Wiener filter for discrete series. An input signal w[n] is convolved with the Wiener filter g[n] and the result is compared to a reference signal s[n] to obtain the filtering error e[n].

The causal finite impulse response (FIR) Wiener filter, instead of using some given data matrix X and output vector Y, finds optimal tap weights by using the statistics of the input and output signals. It populates the input matrix X with estimates of the auto-correlation of the input signal (T) and populates the output vector Y with estimates of the cross-correlation between the output and input signals (V).

In order to derive the coefficients of the Wiener filter, consider the signal w[n] being fed to a Wiener filter of order (number of past taps) N and with coefficients

The residual error is denoted e[n] and is defined as e[n] = x[n] − s[n] (see the corresponding block diagram). The Wiener filter is designed so as to minimize the mean square error (MMSE criteria) which can be stated concisely as follows:

where ![E[cdot ]](https://wikimedia.org/api/rest_v1/media/math/render/svg/57d488a22bc9f41e976d3afb6036190bcbb36b2e)

To find the vector ![[a_{0},,ldots ,,a_{N}]](https://wikimedia.org/api/rest_v1/media/math/render/svg/23b15c3b4639ed827b254c60c133606cec814d33)

Assuming that w[n] and s[n] are each stationary and jointly stationary, the sequences ![R_{w}[m]](https://wikimedia.org/api/rest_v1/media/math/render/svg/6fd433a0ac1fe24b6b95d7bad92cea453be5c7f2)

![{displaystyle R_{ws}[m]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e7790e74796ce594e25ef54c65a4af6ea895803)

The derivative of the MSE may therefore be rewritten as:

Note that for real ![w[n]](https://wikimedia.org/api/rest_v1/media/math/render/svg/2a4e3e5afc2a8c6da9020b8c6b21450959101a18)

Letting the derivative be equal to zero results in:

which can be rewritten (using the above symmetric property) in matrix form

These equations are known as the Wiener–Hopf equations. The matrix T appearing in the equation is a symmetric Toeplitz matrix. Under suitable conditions on

In some articles, the cross correlation function is defined in the opposite way:

Then, the

![{displaystyle R_{sw}[0]ldots R_{sw}[N]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c74f1a47c80f31bc0f228f14d5efc080ecfb440e)

Whichever notation is used, note that for real ![{displaystyle w[n],s[n]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47e41c9959e941c5694db0af5c0634c4537c574c)

Relationship to the least squares filter[edit]

The realization of the causal Wiener filter looks a lot like the solution to the least squares estimate, except in the signal processing domain. The least squares solution, for input matrix

The FIR Wiener filter is related to the least mean squares filter, but minimizing the error criterion of the latter does not rely on cross-correlations or auto-correlations. Its solution converges to the Wiener filter solution.

Complex signals[edit]

For complex signals, the derivation of the complex Wiener filter is performed by minimizing ![{displaystyle Eleft[|e[n]|^{2}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ff9d46fcdf6b205655f7182df44cc92ec004ce5d)

![{displaystyle Eleft[e[n]e^{*}[n]right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/660e20966e374f35618b457d09451af5d0b1d7b1)

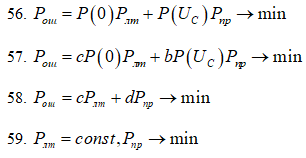

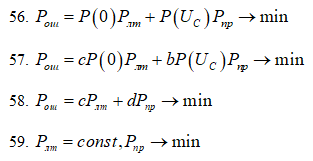

The resulting Wiener-Hopf equations are:

which can be rewritten in matrix form:

Note here that:

The Wiener coefficient vector is then computed as:

Applications[edit]

The Wiener filter has a variety of applications in signal processing, image processing,[3] control systems, and digital communications. These applications generally fall into one of four main categories:

- System identification

- Deconvolution

- Noise reduction

- Signal detection

Noisy image of an astronaut

The image after a Wiener filter is applied (full-view recommended)

For example, the Wiener filter can be used in image processing to remove noise from a picture. For example, using the Mathematica function:

WienerFilter[image,2] on the first image on the right, produces the filtered image below it.

It is commonly used to denoise audio signals, especially speech, as a preprocessor before speech recognition.

History[edit]

The filter was proposed by Norbert Wiener during the 1940s and published in 1949.[4][5] The discrete-time equivalent of Wiener’s work was derived independently by Andrey Kolmogorov and published in 1941.[6] Hence the theory is often called the Wiener–Kolmogorov filtering theory (cf. Kriging). The Wiener filter was the first statistically designed filter to be proposed and subsequently gave rise to many others including the Kalman filter.

See also[edit]

- Wiener deconvolution

- least mean squares filter

- similarities between Wiener and LMS

- linear prediction

- MMSE estimator

- Kalman filter

- generalized Wiener filter

- matched filter

- Information field theory

References[edit]

- ^ a b Brown, Robert Grover; Hwang, Patrick Y.C. (1996). Introduction to Random Signals and Applied Kalman Filtering (3 ed.). New York: John Wiley & Sons. ISBN 978-0-471-12839-7.

- ^ Welch, Lloyd R. «Wiener–Hopf Theory» (PDF). Archived from the original (PDF) on 2006-09-20. Retrieved 2006-11-25.

- ^ Boulfelfel, D.; Rangayyan, R. M.; Hahn, L. J.; Kloiber, R. (1994). «Three-dimensional restoration of single photon emission computed tomography images». IEEE Transactions on Nuclear Science. 41 (5): 1746–1754. Bibcode:1994ITNS…41.1746B. doi:10.1109/23.317385. S2CID 33708058.

- ^ Wiener N: The interpolation, extrapolation and smoothing of stationary time series’, Report of the Services 19, Research Project DIC-6037 MIT, February 1942

- ^ Wiener, Norbert (1949). Extrapolation, Interpolation, and Smoothing of Stationary Time Series. New York: Wiley. ISBN 978-0-262-73005-1.

- ^ Kolmogorov A.N: ‘Stationary sequences in Hilbert space’, (In Russian) Bull. Moscow Univ. 1941 vol.2 no.6 1-40. English translation in Kailath T. (ed.) Linear least squares estimation Dowden, Hutchinson & Ross 1977 ISBN 0-87933-098-8

Further reading[edit]

- Thomas Kailath, Ali H. Sayed, and Babak Hassibi, Linear Estimation, Prentice-Hall, NJ, 2000, ISBN 978-0-13-022464-4.

External links[edit]

- Mathematica WienerFilter function

Вариант

1 Стат.теория, Студент;

________________________гр__________

<br>1Линейные

фильтры, обеспечивающие минимум

среднеквадратичной ошибки, полезны в

том случае, если:

Требуется

наилучшее воспроизведение всего

колебания.

Требуется

наилучшее воспроизведение сообщения.

Решается

задача распознавания двух ненулевых

сигналов.

Решается

задача, бинарного приема сигнала.

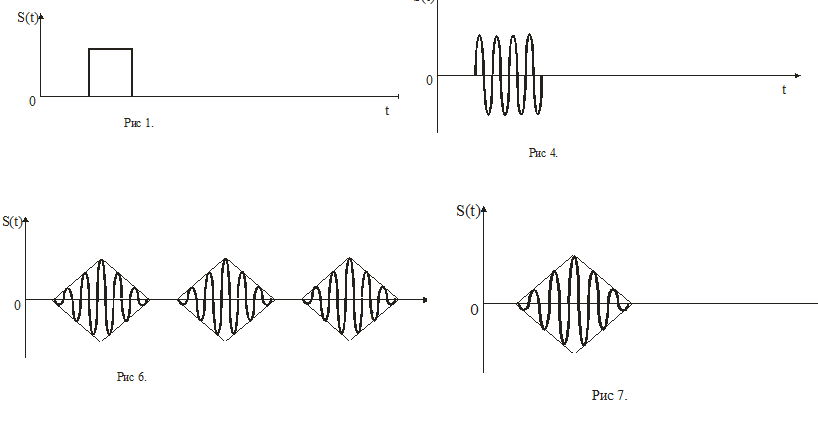

<br>2.Сообщение

передается в виде одиночного видеоимпульса

с прямоугольной огибающей. Как он будет

выглядеть на выходе оптимального фильтра

рис

7

<br>3.При

получении выводов для линейного фильтра,

обеспечивающего максимальное отношение

сигнал/шум, полагают что входной процесс

это:

аддитивная

смесь сигнала и белого шума.

мультипликативная

смесь сигнала и шума

аддитивная

смесь сигнал и помехи с произвольным

спектром

мультипликативная

смесь сигнала и помехи с произвольным

спектром

<br>4.

Коэффициент

в формуле 4 это:

весовой

коэффициент, определяемый из условия

нормировки

автокорреляционная

функция

взаимокорреляционная

функция

плотность

шума

<br>5.Кто

впервые сформулировал задачу

квазиоптимальной фильтрации за счет

оптимизации полосы пропускания фильтра

с П-образной АЧХ:

Тихонов

Котельников

Сифоров

Гудкин

<br>6.

При постановке задачи о линейном фильтре

Виннера считается, что:

помеха

и сигнал являются стационарными

случайными процессами с нулевым средним

значением и известной корреляционной

функцией;

помеха

и сигнал являются заранее известным

процессом с нулевым средним значением

и функцией корреляции, постоянной во

времени и равной единице;

функция

взаимной корреляции линейно зависит

от точки отсчета, а помеха и сигнал на

входе являются стационарным процессом;

помеха

и сигнал на входе фильтра являются

заранее известным процессом с ненулевым

средним значением и неизвестной функцией

корреляции;

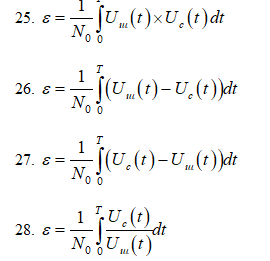

<br>7.

По какой формуле определяется функция

корреляции ε при распознавании двух

ненулевых сигналов:

25

<br>8.

Системы с пассивной паузой с точки

зрения потребления мощности оказывается:

менее

выгодной по сравнению с системой с

активной паузой.

более

выгодной по сравнению с системой с

активной паузой.

такой,

что средняя энергия больше, чем у других

систем.

не

отличается от других систем.

<br>9.В

каких цепях обычно осуществляется

первичная обработка сигналов?

в

цепях до детектора сигналов,

в

цепях после детектора сигналов

в

усилителе звуковой частоты

в

усилителе видеочастоты

<br>10.

Передающая функция оптимального фильтра,

максимизирующего отношение сигнал /

шум — соответствует комплексному спектру

сигнала

соответствует

спектру шума

является

комплексно-сопряжением величиной к

спектру сигнала.

имеет

прямоугольную форму

<br>11.

Какая длительность выходного импульса

оптимального фильтра при воздействии

на входе прямоугольного импульса

длительности T

T

2T

3T

0,5T

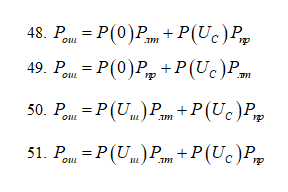

<br>12.

Какое из приведенных ниже выражений

правильно описывает вероятность ошибки

при бинарном обнаружении?

48

<br>13.

В каком случае ЧМ модуляция обеспечивает

более высокую помехоустойчивость по

сравнению с амплитудной модуляцией?

при

любых отношениях сигнал/шум

при

произвольном значении T

при

T1

и больших отношениях сигнал/шум

при

T1

и малых отношениях сигнал/шум

Вариант

2 Стат.теория. , Студент;

________________________гр__________

<br>1.

Линейные фильтры, обеспечивающие

максимальное отношение сигнал/шум,

полезны в том случае, если:

Требуется

наилучшее воспроизведение всего

колебания.

Требуется

фильтрация сигнала после детектора.

Требуется

снизить величину пульсаций питающего

напряжения.

Решается

задача фильтрации радиосигнала.

<br>2.Приемник

может воспроизвести сообщение Х абсолютно

точно если:

имеет

фильтр с минимальной среднеквадратичной

ошибкой

имеет

фильтр с максимальным отношением

сигнал/шум

имеет

в своем составе коррелятор

только

при отсутствии шумов

<br>3.

«Белый» шумом являются шумовые флуктуации

с

равномерным спектром и равномерным

распределением

с

равномерным спектром и гауссовым

распределением

с

равномерным спектром и рэлеевским

распределением

с

гауссовым спектром и гауссовым

распределением

<br>4.В

формуле 80 что такое К2?

весовой

коэффициент, определяемый из условия

нормировки

автокорреляционная

функция

взаимокорреляционная

функция

плотность

шума

<br>5.

Квазиоптимальный фильтр — это фильтр,

у которого

АЧХ

согласована со спектром полезного

сигнала

АЧХ

согласована со спектром помехи

АЧХ

имеет вид гауссовой кривой

оптимальной

является только полоса пропускания

<br>6.

В каком случае приемник должен дать

ответ «да» при бинарном обнаружении

сигналов:

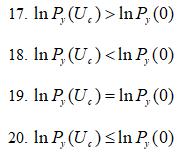

17

<br>7.

При распознавании двух не нулевых

сигналов коэффициент «а», определяемый

по формуле:

<br>8.

Возможные ошибки при бинарном обнаружении

сигнала:

ложная

тревога; обнаружение сигнала;

ложная

тревога; пропуск сигнала;

ложное

сравнение сигналов; пропуск сигнала;

ложное

сравнение сигналов; ложная тревога;

<br>9.В

каких цепях обычно осуществляется

вторичная обработка сигналов?

в

цепях до детектора сигналов,

в

цепях после детектора сигналов

в

усилителе звуковой частоты

в

усилителе видеочастоты

<br>10.

Зависит ли величина отношения сигнал/шум

на выходе согласованного линейного

фильтра от формы сигнала?

да

нет

затрудняюсь

ответить

<br>11.

За счет чего достигается максимум

отношения сигнал/шум в квазиоптимальном

линейном фильтре

за

счет выбора формы частотной характеристики;

за

счет выбора ширины полосы пропускания

при заданной форме амплитудно-частотной

характеристики;

за

счет выбора способа кодирования;

за

счет выбора способа модуляции;

<br>12.

В каком случае достигаются минимальные

ошибки при распознавании двух ненулевых

сигналов?

55

<br>13.

Какое из приведенных выражений

соответствует критерию минимальной

полной вероятности ошибки:

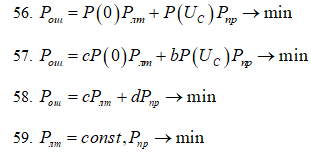

56

Вариант

3 Стат.теория. , Студент;

________________________гр__________

<br>1.Сообщение

передается в виде серии видеоимпульсов

с прямоугольной огибающей. Как он будет

выглядеть на выходе оптимального фильтра

Рис

3

<br>2.Приемник

оптимальный в том смысле, как он был

принят Котельниковым, определяет по

входному процессу У(t)

обратную

вероятность для всех значений Х.

априорную

вероятность присутствия сигнала

вероятность

ошибки

вероятность

правильного обнаружения

<br>3.В

каком из нижеперечисленных выражений

указана аддитивная смесь сигнала и

помехи:

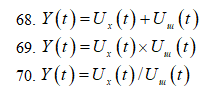

68

<br>4.В

формуле 80 что такое N0?

весовой

коэффициент, определяемый из условия

нормировки

автокорреляционная

функция;

взаимокорреляционная

функция;

плотность

шума;

<br>5.

Оптимальный фильтр — это фильтр у

которого

АЧХ

согласована со спектром полезного

сигнала

АЧХ

согласована со спектром помехи

АЧХ

имеет вид гауссовой кривой

оптимальной

является только полоса пропускания

<br>6.В

каком случае приемник должен дать ответ

«да» при бинарном обнаружении сигналов:

17

<br>7.В

случае если два сигнала ортогональны,

и имеют равные энергии и выполняется

условие U1=-U2

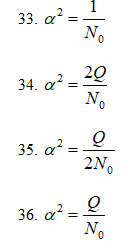

коэффициент «а»:

34

<br>8.Различие

общей теории связи и теории оптимальных

методов приема заключается в том, что

в теории оптимальных методов приема

оптимум

ищется по всем возможным видам сигналов

и способов обработки смеси сигнала и

шума;

по

всевозможным способам обработки смеси

сигнала при заданном типе сигнала;

по

всевозможным способам кодирования

сообщения;

по

всевозможным способам передачи сигналов;

<br>9.По

какому критерию работает оптимальный

линейный фильтр Винера?

по

критерию минимума среднеквадратичной

ошибки.

по

критерию максимального отношения сигнал

шум

по

критерию максимума среднеквадратичной

ошибки.

по

критерию минимального отношения сигнал

шум

<br>10.

Укажите условия физической реализуемости

согласованного линейного фильтра

37

<br>11.

При выборе какой полосы пропуска

достигается максимальное отношение

сигнала к шуму при приеме одиночного

радиоимпульса с прямоугольной огибающей

с длительностью Т0

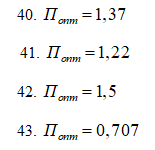

43

<br>12.

Какое выражение соответствует

фазоманипулированному сигналу

52

<br>13.

Какое из приведенных выражений

соответствует критерию минимального

среднего риска

58

Вариант

4 Стат.теория. , Студент;

<br>1.Сообщение

передается в виде серии радиоимпульсов

с прямоугольной огибающей. Как он будет

выглядеть на выходе оптимального фильтра

рис.

5

<br>2.ЧМ

дает существенный выигрыш по сравнению

с АМ:

никогда

всегда

если

произведение Ω*T>>1

если

произведение Ω*T<<1

<br>3.Что

можно вычислить, если приемник не может

произвести сообщение абсолютно точно?

априорную

вероятность

обратную

вероятность того или иного значения х

математическое

ожидание

дисперсию

<br>4.Кто

разработал теорию потенциальной

помехоустойчивости

Тихонов

Котельников

Сифоров

Гудкин

<br>5.Оптимальным

считается такой фильтр, у которого

функция взаимной корреляции:

максимальна

минимальна

равна

среднеквадратичной погрешности

меньше

среднеквадратичной погрешности

<br>6.Пороговое

значение напряжения U0

при бинарном обнаружении сигналов:

23

<br>7.В

случае если два сигнала имеют равные

энергии, но условие U1=-U2

не выполняется, то коэффициент «а»:

33

<br>8.Относится

ли поиск различных критериев оптимальности

к основным задачам, решаемым в теории

оптимальных методов приема.

да

нет.

только

для радиосвязи

только

для радиолокации

<br>9.По

какому критерию работает согласованный

линейный фильтр?

по

критерию минимума среднеквадратичной

ошибки.

по

критерию максимального отношения сигнал

шум

по

критерию максимума среднеквадратичной

ошибки.

по

критерию минимального отношения сигнал

шум

<br>10.

Форма выходного импульса на выходе

согласованного линейного фильтра

прямоугольная

с длительностью T

треугольная

с длительностью 2T

треугольная

с длительностью T

прямоугольная

с длительностью 2T

<br>11.

Укажите величину проигрыша в отношении

сигнал/шум на выходе квазиоптимального

фильтра с П- образной амплитудно-частотной

характеристикой при приеме одиночного

радиоимпульса

0,82

0,9

0,707

0.5

<br>12.

При частотном манипулировании, какое

из приведенных условий должно выполняться?

53

<br>13.

Какое из приведенных выражений

соответствует критерию минимальной

взвешенности вероятности ошибки:

57

Вариант

5 Стат.теория. , Студент;

________________________гр__________

<br>1.Сообщение

передается в виде одиночного радиоимпульса

с прямоугольной огибающей. Как он будет

выглядеть на выходе оптимального фильтра

Рис.

4

<br>2.При

бинарном обнаружении сигнала, надежность

обнаружения (вероятность ошибки) зависит

от:

формы

сигнала

частоты

сигнала

энергии

сигнала

фазы

сигнала

<br>3.Какая

величина в формуле 80

является неизвестной:

84

<br>4.В

формуле 80 что такое Qx?

весовой

коэффициент, определяемый из условия

нормировки

энергия

сигнала

взаимокорреляционная

функция

плотность

шума

<br>5.

Оптимальным считается тот фильтр, у

которого значение коэффициента r:

наибольшее

наименьшее

равно

0

равно

1

<br>6.

По какой формуле определяется функция

корреляции ε при бинарном обнаружении

сигнала:

<br>7.В

случае бинарного обнаружения сигнала

с пассивной паузой коэффициент «а»

определяется:

34

<br>8.Относится

ли оценка потенциальной помехоустойчивости

приемного устройства к основным задачам,

решаемым в теории оптимальных методов

приема.

да

нет.

только

для радиосвязи

только

для радиолокации

<br>9.

В каком случае используется согласованный

линейный фильтр?

при

фильтрации модулированного сигнала.

фильтрация

всего сигнала (после детектора, устройства

автоматики и телемеханики).

при

фильтрации сигнала в усилителе звуковой

частоты

при

фильтрации сигнала в усилителе

видеочастоты

<br>10.

Форма огибающей радиоимпульса на выходе

согласованного линейного фильтра

прямоугольная

с длительностью T;

треугольная

с длительностью 2T;

треугольная

с длительностью T;

прямоугольная

с длительностью 2T;

<br>11.

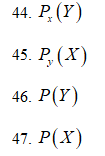

Какой параметр определяет оптимальный

приемник при приеме сигнала известного

типа по Котельникову? На входе оптимального

приемника действует смесь сигнала и

шума.

45

<br>12.

В системах с активной паузой, какой вид

манипуляции обладает максимальной

помехоустойчивостью

фазовая

частотная

амплитудная

<br>13.

Какое из приведенных выражений

соответствует критерию Неймана- Пирсона

59

5

В обработке сигналов фильтр Винера является фильтром используется для получения оценки желаемого или целевого случайного процесса посредством линейной не зависящей от времени (LTI ) фильтрации наблюдаемого зашумленного процесса, предполагая известные стационарные спектры сигнала и шума, а также аддитивные шум. Фильтр Винера минимизирует среднеквадратичную ошибку между оцененным случайным процессом и желаемым процессом.

Содержание

- 1 Описание

- 2 Решения с фильтром Винера

- 2.1 Непричинное решение

- 2.2 Причинное решение

- 3 Фильтр Винера с конечной импульсной характеристикой для дискретных серий

- 3.1 Связь с фильтром наименьших квадратов

- 3.2 Сложные сигналы

- 4 Приложения

- 5 История

- 6 См. Также

- 7 Ссылки

- 8 Внешние ссылки

Описание

Цель фильтра Винера — для вычисления статистической оценки неизвестного сигнала с использованием связанного сигнала в качестве входа и фильтрации этого известного сигнала для получения оценки в качестве выхода. Например, известный сигнал может состоять из интересующего неизвестного сигнала, который был искажен аддитивным шумом. Фильтр Винера может использоваться для фильтрации шума из искаженного сигнала, чтобы обеспечить оценку основного сигнала, представляющего интерес. Фильтр Винера основан на статистическом подходе, и более статистическое изложение теории дается в статье оценщика минимальной среднеквадратичной ошибки (MMSE).

Типичные детерминированные фильтры разработаны для желаемой частотной характеристики. Однако конструкция фильтра Винера использует другой подход. Предполагается, что кто-то знает спектральные свойства исходного сигнала и шума, а другой ищет линейный не зависящий от времени фильтр, выходной сигнал которого будет максимально приближен к исходному сигналу. Фильтры Винера характеризуются следующим:

- Допущение: сигнал и (аддитивный) шум являются стационарными линейными случайными процессами с известными спектральными характеристиками или известной автокорреляцией и взаимной корреляцией.

- Требование: фильтр должен быть физически реализуемым / причинным (это требование можно отбросить, что приведет к непричинному решению)

- Критерий эффективности: минимальный среднеквадратичный ошибка (MMSE)

Этот фильтр часто используется в процессе деконволюции ; для этого приложения см. деконволюция Винера.

Решения винеровского фильтра

Пусть s (t) { displaystyle s (t)}

Непричинное решение

- G (s) = S x, s (s) S x (s) e α s, { displaystyle G (s) = { frac {S_ {x, s}) (s)} {S_ {x} (s)}} e ^ { alpha s},}

где S { displaystyle S}

- E (e 2) Знак равно р s (0) — ∫ — ∞ ∞ г (τ) р Икс, s (τ + α) d τ, { displaystyle E (e ^ {2}) = R_ {s} (0) — int _ {- infty} ^ { infty} g ( tau) R_ {x, s} ( tau + alpha) , d tau,}

и решение g (t) { displaystyle g (t)}

Причинное решение

- G (s) = H (s) S Икс + (s), { Displaystyle G (s) = { frac {H (s)} {S_ {x} ^ {+} (s)}},}

где

Эта общая формула сложна и заслуживает более подробного объяснения. Чтобы записать решение G (s) { displaystyle G (s)}

- Начать со спектра S x ( s) { displaystyle S_ {x} (s)}

в рациональной форме и разложите его на причинные и антипричинные компоненты: S x (s) = S x + (s) S x — (s) { displaystyle S_ {x} (s) = S_ {x} ^ {+} (s) S_ {x} ^ {-} (s)}

где S + { displaystyle S ^ {+}}

содержит все нули и полюсы в левой полуплоскости (LHP), а S — { displaystyle S ^ {-}}

содержит нули и полюсы в правой полуплоскости (RHP). Это называется факторизацией Винера – Хопфа.

- Divide S x, s (s) e α s { displaystyle S_ {x, s} (s) e ^ { alpha s}}

на S x — (s) { displaystyle S_ {x} ^ {-} (s)}

и запишите результат в виде разложения частичной дроби.

- Выберите в этом расширении только те термины, у которых есть полюсы в LHP. Назовите эти термины H (s) { displaystyle H (s)}

.

- Разделите H (s) { displaystyle H (s)}

на S x + (s) { displaystyle S_ {x} ^ {+} (s)}

. Результатом является желаемая передаточная функция фильтра G (s) { displaystyle G (s)}

.

Фильтр Винера с конечной импульсной характеристикой для дискретных серий

Причинный конечный импульс response (FIR) Фильтр Винера вместо использования некоторой заданной матрицы данных X и выходного вектора Y находит оптимальные веса отводов, используя статистику входных и выходных сигналов. Он заполняет входную матрицу X оценками автокорреляции входного сигнала (T) и заполняет выходной вектор Y оценками взаимной корреляции между выходным и входным сигналами (V).

Чтобы вывести коэффициенты фильтра Винера, рассмотрим сигнал w [n], подаваемый на фильтр Винера порядка (количества прошедших отводов) N и с коэффициентами {a 0, ⋯, а N} { displaystyle {a_ {0}, cdots, a_ {N} }}

- x [n] = ∑ i = 0 N a i w [n — i]. { displaystyle x [n] = sum _ {i = 0} ^ {N} a_ {i} w [ni].}

Остаточная ошибка обозначается e [n] и определяется как e [n] = x [n] — s [n] (см. соответствующую блок-схему). Фильтр Винера разработан таким образом, чтобы минимизировать среднеквадратичную ошибку (критерии MMSE ), которую можно кратко сформулировать следующим образом:

- ai = arg min E [e 2 [n]], { displaystyle a_ {i} = arg min E left [e ^ {2} [n] right],}

где E [⋅] { displaystyle E [ cdot]}![E [ cdot]](https://wikimedia.org/api/rest_v1/media/math/render/svg/57d488a22bc9f41e976d3afb6036190bcbb36b2e)

- E [e 2 [n]] = E [(x [n] — s [n]) 2] = E [x 2 [n]] + E [s 2 [n]] — 2 E [x [n] s [n]] = E [(∑ i = 0 N aiw [n — i]) 2] + E [s 2 [n]] — 2 E [∑ я знак равно 0 N aiw [n — я] s [n]] { displaystyle { begin {выровнено} E left [e ^ {2} [n] right] = E left [(x [ n] -s [n]) ^ {2} right] \ = E left [x ^ {2} [n] right] + E left [s ^ {2} [n] right] -2E [x [n] s [n]] \ = E left [ left ( sum _ {i = 0} ^ {N} a_ {i} w [ni] right) ^ {2} right] + E left [s ^ {2} [n] right] -2E left [ sum _ {i = 0} ^ {N} a_ {i} w [ni] s [n] right ] end {align}}}

Найти вектор [a 0,…, a N] { displaystyle [a_ {0}, , ldots, , a_ {N}]}![[a_ {0}, , ldots, , a_ {N}]](https://wikimedia.org/api/rest_v1/media/math/render/svg/23b15c3b4639ed827b254c60c133606cec814d33)

- ∂ ∂ ai E [e 2 [n]] = ∂ ∂ ai {E [(∑ i = 0 N aiw [n — i]) 2] + E [s 2 [n]] — 2 E [∑ i = 0 N aiw [n — i] s [n]]} = 2 E [ (∑ j = 0 N ajw [n — j]) w [n — i]] — 2 E [w [n — i] s [n]] = 2 (∑ J = 0 NE [вес [N — J] вес [N — I]] aj) — 2 E [вес [N — I] s [N]] { Displaystyle { begin {align} { frac { partial} { partial a_ {i}}} E left [e ^ {2} [n] right] = { frac { partial} { partial a_ {i}}} left {E left [ left ( sum _ {i = 0} ^ {N} a_ {i} w [ni] right) ^ {2} right] + E left [s ^ {2} [n] right] -2E left [ sum _ {i = 0} ^ {N} a_ {i} w [ni] s [n] right] right } \ = 2E left [ left ( sum _ {j = 0} ^ {N} a_ {j} w [nj] right) w [ni] right] -2E [w [ni] s [n]] \ = 2 left ( sum _ {j = 0} ^ {N} E [w [nj] w [ni]] a_ {j} right) -2E [w [ni] s [n]] end {align}}}

Предполагая, что каждый из w [n] и s [n] является стационарным и вместе стационарным, последовательности R w [m] { displaystyle R_ {w} [m]}![R_ {w} [m]](https://wikimedia.org/api/rest_v1/media/math/render/svg/6fd433a0ac1fe24b6b95d7bad92cea453be5c7f2)

![{ displaystyle R_ {ws} [m]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e7790e74796ce594e25ef54c65a4af6ea895803)

- R w [m] = E {w [n] w [n + m]} R ws [m] = E {w [n] s [n + m]} { displaystyle { begin {выровнено} R_ {w} [m] = E {w [n] w [n + m] } \ R_ {ws} [m] = E {w [n] s [n + m ]}конец {выравнивается}}}

Следовательно, производная MSE может быть переписана как:

- ∂ ∂ ai E [e 2 [n]] = 2 (∑ j = 0 NR w [j — i] aj) — 2 R ws [i] i = 0, ⋯, N. { displaystyle { frac { partial} { partial a_ {i}}} E left [e ^ {2} [n] right] = 2 left ( sum _ {j = 0} ^ {N } R_ {w} [ji] a_ {j} right) -2R_ {ws} [i] qquad i = 0, cdots, N.}

Обратите внимание, что для реального w [n] { displaystyle w [n]}![w [n]](https://wikimedia.org/api/rest_v1/media/math/render/svg/2a4e3e5afc2a8c6da9020b8c6b21450959101a18)

R w [j — i] = R w [i — j] { displaystyle R_ {w} [ji] = R_ { w} [ij]}

![{ displaystyle R_ {w} [ji] = R_ {w} [ij]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0a7c44b249eb0d5faa8fd08516814ecedbebc451)

- ∑ j = 0 NR w [j — i] aj = R ws [i] i = 0, ⋯, N. { displaystyle sum _ {j = 0} ^ {N} R_ {w} [ji] a_ {j} = R_ {ws} [i] qquad i = 0, cdots, N.}

который можно переписать (используя указанное выше свойство симметрии) в матричной форме

- [R w [0] R w [1] ⋯ R w [N] R w [1] R w [0] ⋯ R w [N — 1] ] ⋮ ⋮ ⋱ ⋮ R w [N] R w [N — 1] ⋯ R w [0]] ⏟ T [a 0 a 1 ⋮ a N] ⏟ a = [R ws [0] R ws [1] ⋮ R ws [N]] ⏟ v { displaystyle underbrace { begin {bmatrix} R_ {w} [0] R_ {w} [1] cdots R_ {w} [N] \ R_ {w} [ 1] R_ {w} [0] cdots R_ {w} [N-1] \ vdots vdots ddots vdots \ R_ {w} [N] R_ {w} [N- 1] cdots R_ {w} [0] end {bmatrix}} _ { mathbf {T}} underbrace { begin {bmatrix} a_ {0} \ a_ {1} \ vdots \ a_ {N} end {bmatrix}} _ { mathbf {a}} = underbrace { begin {bmatrix} R_ {ws} [0] \ R_ {ws} [1] \ vdots \ R_ {ws} [N] end {bmatrix}} _ { mathbf {v}}}

Эти уравнения известны как уравнения Винера – Хопфа. Матрица T, встречающаяся в уравнении, является симметричной матрицей Теплица. При подходящих условиях на R { displaystyle R}

В некоторых статьях функция взаимной корреляции определяется противоположным образом:

R sw [m] = E {w [n] s [n + m]} { displaystyle R_ {sw} [m] = E {w [n] s [n + m] }}

![{ displaystyle R_ {sw} [m] = E {w [n] s [n + m] }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/674ae192cf58157ffa143e5a78c60150f9e0ec96)

v { displaystyle mathbf {v}}

R sw [0]… R sw [N] { displaystyle R_ {sw} [0] ldots R_ {sw} [N]}

![{ displaystyle R_ {sw } [0] ldots R_ {sw} [N]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c74f1a47c80f31bc0f228f14d5efc080ecfb440e)

Какое бы обозначение ни использовалось, обратите внимание, что для вещественного w [n], s [n] { displaystyle w [n], s [n]}![{ displaystyle w [n], s [n]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47e41c9959e941c5694db0af5c0634c4537c574c)

R sw [k] = R ws [- k] { displaystyle R_ {sw} [k] = R_ {ws} [- k]}

Отношение к фильтру наименьших квадратов

Реализация причинного фильтра Винера очень похожа на решение к оценке наименьших квадратов, за исключением области обработки сигналов. Решение методом наименьших квадратов для входной матрицы X { displaystyle mathbf {X}}

- β ^ = (XTX) — 1 XT y. { displaystyle { boldsymbol { hat { beta}}} = ( mathbf {X} ^ { mathbf {T}} mathbf {X}) ^ {- 1} mathbf {X} ^ { mathbf {T}} { boldsymbol {y}}.}

КИХ-фильтр Винера связан с фильтром наименьших средних квадратов, но минимизация критерия ошибки последнего не зависит от взаимной корреляции или автокорреляции. Его решение сходится к решению фильтра Винера.

Сложные сигналы

Для сложных сигналов вывод комплексного винеровского фильтра выполняется путем минимизации E [| e [n] | 2] { displaystyle E left [| e [n] | ^ {2} right]}![{ displaystyle E left [| e [n] | ^ {2} right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ff9d46fcdf6b205655f7182df44cc92ec004ce5d)

![{ displaystyle E left [e [n] e ^ {*} [n] справа]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/660e20966e374f35618b457d09451af5d0b1d7b1)

Результирующие уравнения Винера-Хопфа:

- ∑ j = 0 N R w [j — i] a j ∗ = R w s [i] i = 0, ⋯, N. { displaystyle sum _ {j = 0} ^ {N} R_ {w} [ji] a_ {j} ^ {*} = R_ {ws} [i] qquad i = 0, cdots, N.}

, который можно переписать в матричном виде:

- [R w [0] R w ∗ [1] ⋯ R w ∗ [N — 1] R w ∗ [N] R w [1] R w [0 ] ⋯ R w ∗ [N — 2] R w ∗ [N — 1] ⋮ ⋮ ⋱ ⋮ ⋮ R w [N — 1] R w [N — 2] ⋯ R w [0] R w ∗ [1] R w [N] R w [N — 1] ⋯ R w [1] R w [0]] ⏟ T [a 0 ∗ a 1 ∗ ⋮ a N — 1 ∗ a N ∗] ⏟ a ∗ = [R ws [ 0] R WS [1] ⋮ R WS [N — 1] R WS [N]] ⏟ v { displaystyle underbrace { begin {bmatrix} R_ {w} [0] R_ {w} ^ {*} [ 1] cdots R_ {w} ^ {*} [N-1] R_ {w} ^ {*} [N] \ R_ {w} [1] R_ {w} [0] cdots R_ { w} ^ {*} [N-2] R_ {w} ^ {*} [N-1] \ vdots vdots ddots vdots vdots \ R_ {w} [N-1 ] R_ {w} [N-2] cdots R_ {w} [0] R_ {w} ^ {*} [1] \ R_ {w} [N] R_ {w} [N-1] cdots R_ {w} [1] R_ {w} [0] end {bmatrix}} _ { mathbf {T}} underbrace { begin {bmatrix} a_ {0} ^ {*} \ a_ { 1} ^ {*} \ vdots \ a_ {N-1} ^ {*} \ a_ {N} ^ {*} end {bmatrix}} _ { mathbf {a ^ {*}}} = underbrace { begin {bmatrix} R_ {ws} [0] \ R_ {ws} [1] \ vdots \ R_ {ws} [N-1] \ R_ {ws} [N] конец {bmatrix}} _ { mathbf {v}}}

Обратите внимание, что:

R w [- k] = R w ∗ [k] R sw [k] = R ws ∗ [- k] { displaystyle { begin {выровнено } R_ {w} [- k] = R_ {w} ^ {*} [k] \ R_ {sw} [k] = R_ {ws} ^ {*} [- k] end {выровнено} }}

Затем вектор коэффициентов Винера вычисляется как:

a = (T — 1 v) ∗ { displaystyle mathbf {a} = {( mathbf {T} ^ {- 1} mathbf { v})} ^ {*}}

Приложения

Фильтр Винера имеет множество применений в обработке сигналов, обработке изображений, системах управления и цифровой связи. Эти приложения обычно относятся к одной из четырех основных категорий:

- Идентификация системы

- Деконволюция

- Подавление шума

- Обнаружение сигнала

Например, фильтр Винера может использоваться при обработке изображений для удаления шума из картина. Например, использование функции Mathematica: WienerFilter [image, 2]на первом изображении справа, создает отфильтрованное изображение под ним.

Обычно используется для подавления звуковых сигналов, особенно речи, в качестве препроцессора перед распознаванием речи.

История

Фильтр был предложен Норбертом Винером в 1940-х годах и опубликован в 1949 году. Дискретный эквивалент работы Винера был независимо выведен Андреем Колмогоровым и опубликован в 1941 году. Поэтому эту теорию часто называют теорией фильтрации Винера – Колмогорова (см. Кригинг ). Фильтр Винера был первым предложенным статистически разработанным фильтром, впоследствии породившим множество других, включая фильтр Калмана.

См. Также

- Норберт Винер

- Эберхард Хопф

- Винер деконволюция

- минимум фильтр средних квадратов

- сходства между Винером и LMS

- линейное прогнозирование

- оценка MMSE

- фильтр Калмана

- обобщенный фильтр Винера

- согласованный фильтр

- Теория информационного поля

Ссылки

- Томас Кайлат, Али Х. Сайед и Бабак Хассиби, Линейная оценка, Прентис-Холл, Нью-Джерси, 2000, ISBN 978-0-13-022464-4 .

- Винер Н.: Интерполяция, экстраполяция и сглаживание стационарных временных рядов », Отчет Службы 19, Исследовательский проект DIC-6037 MIT, февраль 1942 г.

- Колмогоров АН: Стационарные последовательности в гильбертовом пространстве, Бюл. Московский унив. 1941 том 2 номер 6 1-40. Английский перевод в Kailath T. (ред.) Оценка линейных наименьших квадратов Dowden, Hutchinson Ross 1977

Внешние ссылки

- Mathematica WienerFilter function

Обзор адаптивных фильтров и приложения

Адаптивные фильтры являются цифровыми фильтрами чье содействующее изменение с целью заставить фильтр сходиться к оптимальному состоянию. Критерий оптимизации является функцией стоимости, которая является обычно средним квадратичным сигнала ошибки между выходом адаптивного фильтра и желаемым сигналом. Когда фильтр адаптирует свои коэффициенты, среднеквадратичная погрешность (MSE) сходится к своему минимальному значению. В этом состоянии адаптируется фильтр, и коэффициенты сходились к решению. Фильтр вывел, y(k), как затем говорят, соответствует очень тесно к желаемому сигналу, d(k). Когда вы изменяете характеристики входных данных, иногда названные средой фильтра, фильтр адаптируется к новой среде путем генерации нового набора коэффициентов для новых данных.

Общий адаптивный алгоритм фильтра

Адаптивные фильтры в DSP System Toolbox

Основанный на Наименьшее количество средних квадратичных (LMS) КИХ адаптивные фильтры

|

Адаптивный объект фильтра |

Адаптация алгоритма |

|---|---|

|

|

Блокируйте КИХ LMS адаптивный алгоритм фильтра |

|

|

Фильтрованный-x КИХ LMS адаптивный алгоритм фильтра |

|

|

КИХ LMS адаптивный алгоритм фильтра Нормированный КИХ LMS адаптивный алгоритм фильтра КИХ Sign-data LMS адаптивный алгоритм фильтра КИХ Sign-error LMS адаптивный алгоритм фильтра КИХ Sign-sign LMS адаптивный алгоритм фильтра |

|

Адаптивный блок фильтра |

Адаптация алгоритма |

|---|---|

|

Block LMS Filter |

Блокируйте КИХ LMS адаптивный алгоритм фильтра |

|

Fast Block LMS Filter |

Блокируйте КИХ LMS адаптивный алгоритм фильтра в частотном диапазоне |

|

LMS Filter |

КИХ LMS адаптивный алгоритм фильтра Нормированный КИХ LMS адаптивный алгоритм фильтра КИХ Sign-data LMS адаптивный алгоритм фильтра КИХ Sign-error LMS адаптивный алгоритм фильтра КИХ Sign-sign LMS адаптивный алгоритм фильтра |

| LMS Update |

КИХ-вес LMS обновляет алгоритм Нормированный КИХ-вес LMS обновляет алгоритм КИХ-вес Sign-data LMS обновляет алгоритм КИХ-вес Sign-error LMS обновляет алгоритм КИХ-вес Sign-sign LMS обновляет алгоритм |

Основанный на Рекурсивных наименьших квадратах (RLS) КИХ адаптивные фильтры

|

Адаптивный объект фильтра |

Адаптация алгоритма |

|---|---|

|

|

Быстро трансверсальный алгоритм адаптации наименьших квадратов Раздвижное окно алгоритм адаптации FTF |

|

|

Алгоритм адаптации QR-decomposition RLS Домовладелец алгоритм адаптации RLS Домовладелец алгоритм адаптации SWRLS Алгоритм адаптации рекурсивных наименьших квадратов (RLS) Раздвижное окно (SW) алгоритм адаптации RLS |

|

Адаптивный блок фильтра |

Адаптация алгоритма |

|---|---|

|

RLS Filter |

Экспоненциально взвешенный алгоритм рекурсивных наименьших квадратов (RLS) |

КИХ Аффинной проекции (AP) адаптивные фильтры

|

Адаптивный объект фильтра |

Адаптация алгоритма |

|---|---|

|

|

Аффинный алгоритм проекции, который использует прямую матричную инверсию Аффинный алгоритм проекции, который использует рекурсивное матричное обновление Блокируйте аффинный алгоритм адаптации проекции |

КИХ адаптивные фильтры в частотном диапазоне (FD)

|

Адаптивный объект фильтра |

Адаптация алгоритма |

|---|---|

|

|

Ограниченный алгоритм адаптации частотного диапазона Неограниченный алгоритм адаптации частотного диапазона Разделенный и ограниченный алгоритм адаптации частотного диапазона Разделенный и неограниченный алгоритм адаптации частотного диапазона |

|

Адаптивный блок фильтра |

Адаптация алгоритма |

|---|---|

|

Frequency-Domain Adaptive Filter |

Ограниченный алгоритм адаптации частотного диапазона Неограниченный алгоритм адаптации частотного диапазона Разделенный и ограниченный алгоритм адаптации частотного диапазона Разделенный и неограниченный алгоритм адаптации частотного диапазона |

Основанный на решетке (L) КИХ адаптивные фильтры

|

Адаптивный объект фильтра |

Адаптация алгоритма |

|---|---|

|

|

Градиент адаптивный алгоритм адаптации фильтра решетки Наименьшие квадраты образовывают решетку алгоритм адаптации Разложение QR алгоритм адаптации RLS |

Для получения дополнительной информации об этих алгоритмах обратитесь к разделу алгоритма соответствующих страниц с описанием. Полные описания теории появляются в адаптивных ссылках фильтра [1] и [2].

Выбор адаптивного фильтра

В устойчивом состоянии, когда фильтр адаптировался, ошибка между фильтром, выход и желаемый сигнал минимальны, не нуль. Эта ошибка известна как установившуюся ошибку. Скорость, с которой фильтр сходится к оптимальному состоянию, известному как быстроту сходимости, зависит от нескольких факторов такая природа входного сигнала, выбор адаптивного алгоритма фильтра и размер шага алгоритма. Выбор алгоритма фильтра обычно зависит факторы, такие как производительность сходимости, требуемая для приложения, вычислительной сложности алгоритма, устойчивости фильтра в среде и любых других ограничений.

LMS-алгоритм прост реализовать, но имеет проблемы устойчивости. Нормированная версия LMS-алгоритма идет с улучшенной быстротой сходимости, большей устойчивостью, но увеличила вычислительную сложность. Для примера, который сравнивает эти два, смотрите, Сравнивают Производительность Сходимости Между LMS-алгоритмом и Нормированным LMS-алгоритмом. Алгоритмы RLS очень устойчивы, сделайте очень хорошо в изменяющихся во времени средах, но являются в вычислительном отношении более комплексными, чем LMS-алгоритмы. Для сравнения смотрите, Сравнивают RLS и Адаптивные Алгоритмы Фильтра LMS. Аффинные фильтры проекции преуспевают, когда вход окрашен, и имейте очень хорошую производительность сходимости. Адаптивные фильтры решетки обеспечивают хорошую сходимость, но идут с увеличенной вычислительной стоимостью. Выбор алгоритма зависит от среды и специфических особенностей приложения.

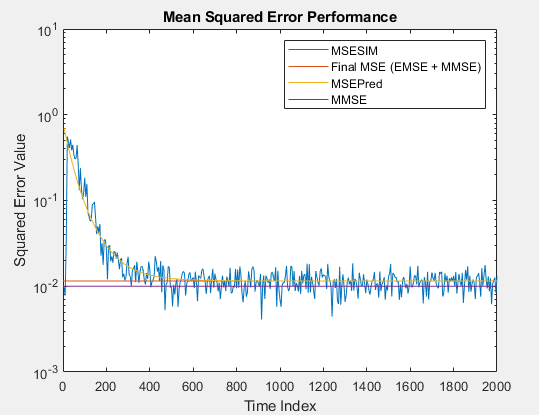

Производительность среднеквадратической ошибки

Минимизация среднего квадратичного сигнала ошибки между выходом адаптивного фильтра и желаемым сигналом является наиболее распространенным критерием оптимизации адаптивных фильтров. Фактический MSE (MSESIM) адаптивного фильтра, который вы реализуете, может быть определен с помощью msesim функция. Траектория этого MSE, как ожидают, будет следовать за тем из предсказанных MSE (MSEPred), который вычисляется с помощью msepred функция. Минимальная среднеквадратичная погрешность (MMSE) оценивается msepred функция с помощью Винеровского фильтра. Фильтр Вайнера минимизирует среднеквадратическую ошибку между желаемым сигналом и входным сигналом, отфильтрованным Винеровским фильтром. Большое значение среднеквадратической ошибки указывает, что адаптивный фильтр не может точно отследить желаемый сигнал. Минимальное значение среднеквадратической ошибки гарантирует, что адаптивный фильтр оптимален. Избыточная среднеквадратичная погрешность (EMSE), определенная msepred функционируйте, различие между MSE, введенным адаптивными фильтрами и MMSE, произведенным соответствующим Винеровским фильтром. Итоговый MSE, показанный ниже, является суммой EMSE и MMSE, и равняется предсказанному MSE после сходимости.

Распространенные приложения

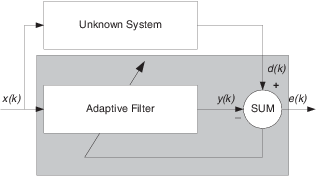

System Identification – Используя адаптивный фильтр, чтобы идентифицировать неизвестную систему

Одно общее адаптивное приложение фильтра должно использовать адаптивные фильтры, чтобы идентифицировать неизвестную систему, такую как ответ неизвестного коммуникационного канала или частотная характеристика аудитории, выбрать довольно расходящиеся приложения. Другие приложения включают отмену эха и идентификацию канала.

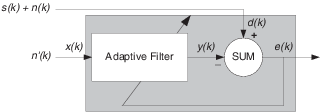

В фигуре неизвестная система помещается параллельно с адаптивным фильтром. Это размещение представляет только одну из многих возможных структур. Заштрихованная область содержит адаптивную систему фильтра.

Безусловно, когда e (k) очень мал, адаптивный ответ фильтра близко к ответу неизвестной системы. В этом случае тот же вход питает и адаптивный фильтр и неизвестное. Если, например, неизвестная система является модемом, вход часто представляет белый шум и является частью звука, вы получаете известие от своего модема, когда вы входите в систему своего поставщика интернет-услуг.

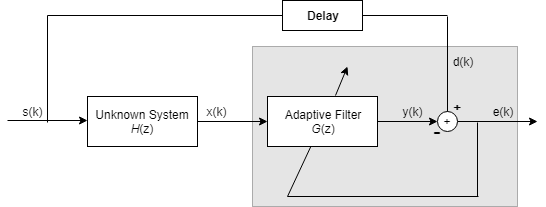

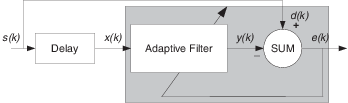

Обратный System Identification – определение обратного ответа на неизвестную систему

Путем размещения неизвестной системы последовательно с адаптивным фильтром фильтр адаптируется, чтобы стать инверсией неизвестной системы, когда e (k) становится очень маленьким. Как показано в фигуре, процесс требует, чтобы задержка, вставленная в желаемый путь к сигналу d (k), сохранила данные при суммировании синхронизируемыми. Добавление задержки сохраняет систему причинной.

Включая задержку, чтобы составлять задержку, вызванную неизвестной системой, предотвращает это условие.

Простые телефонные сети (POTS) обычно используют обратную систему идентификации, чтобы компенсировать медный носитель передачи. Когда вы отправляете данные или речь по телефонным линиям, медные провода ведут себя как фильтр, имея ответ, который прокручивается прочь на более высоких частотах (или скорости передачи данных) и наличие других аномалий также.

Добавление адаптивного фильтра, который имеет ответ, который является инверсией проводного ответа и конфигурирования фильтра, чтобы адаптироваться в режиме реального времени, позволяет фильтру компенсировать спад и аномалии, увеличивая доступную область значений частотного вывода и скорость передачи данных для телефонной сети.

Шумовая или интерференционная отмена – Используя адаптивный фильтр, чтобы удалить шум из неизвестной системы

В подавлении помех адаптивные фильтры позволяют вам удалить шум из сигнала в режиме реального времени. Здесь, желаемый сигнал, тот, чтобы вымыться, комбинирует шум и желаемую информацию. Чтобы удалить шум, накормите сигналом n’ (k) адаптивный фильтр, который коррелируется к шуму, который будет удален из желаемого сигнала.

Пока входной шум к фильтру остается коррелированым к нежелательному шуму, сопровождающему желаемый сигнал, адаптивный фильтр настраивает свои коэффициенты, чтобы уменьшать значение различия между y (k) и d (k), удаляя шум и приводя к чистому сигналу в e (k). Заметьте, что в этом приложении, сигнал ошибки на самом деле сходится к сигналу входных данных, вместо того, чтобы сходиться, чтобы обнулить.

Предсказание – предсказание будущих значений периодического сигнала

Предсказание сигналов требует, чтобы вы сделали некоторые ключевые предположения. Примите, что сигнал является или устойчивым или медленно различным в зависимости от времени и периодическим в зависимости от времени также.

Принимая эти предположения, адаптивный фильтр должен предсказать будущие значения желаемого сигнала на основе прошлых значений. Когда s (k) является периодическим, и фильтр достаточно длинен, чтобы помнить, что предыдущие значения, эта структура с задержкой входного сигнала, могут выполнить предсказание. Вы можете использовать эту структуру, чтобы удалить периодический сигнал из стохастических шумовых сигналов.

Наконец, заметьте, что большинство систем интереса содержит элементы больше чем одной из четырех адаптивных структур фильтра. Тщательно рассмотрение действительной структуры может потребоваться, чтобы определять то, к чему адаптируется адаптивный фильтр.

Кроме того, для ясности в фигурах не появляются аналого-цифровое (A/D) и цифро-аналоговые компоненты (D/A). Поскольку адаптивные фильтры приняты, чтобы быть цифровыми по своей природе, и многие проблемы производят аналоговые данные, преобразование входных сигналов к и от аналоговой области, вероятно, необходимо.

Ссылки

[1] Hayes, Монсон Х., Статистическая Цифровая обработка сигналов и Моделирование. Хобокен, NJ: John Wiley & Sons, 1996, pp.493–552.

[2] Haykin, Саймон, адаптивная теория фильтра. Верхний Сэддл-Ривер, NJ: Prentice-Hall, Inc., 1996.

Алгоритмы наименьших средних квадратов ( LMS ) представляют собой класс адаптивных фильтров, используемых для имитации желаемого фильтра путем нахождения коэффициентов фильтра, которые относятся к получению наименьшего среднего квадрата сигнала ошибки (разницы между желаемым и фактическим сигналами). Это метод стохастического градиентного спуска, в котором фильтр адаптируется только на основе ошибки в текущий момент времени. Он был изобретен в 1960 году профессором Стэнфордского университета Бернардом Видроу и его первым доктором философии. студент, Тед Хофф .

Постановка проблемы

Связь с фильтром Винера

Реализация причинного фильтра Винера очень похожа на решение оценки наименьших квадратов, за исключением области обработки сигналов. Решение методом наименьших квадратов для входной матрицы и выходного вектора

:

КИХ-фильтр наименьших средних квадратов связан с фильтром Винера, но минимизация критерия ошибки первого не зависит от взаимной корреляции или автокорреляции. Его решение сходится к решению фильтра Винера. Большинство задач линейной адаптивной фильтрации можно сформулировать с помощью приведенной выше блок-схемы. То есть должна быть идентифицирована неизвестная система, и адаптивный фильтр пытается адаптировать фильтр, чтобы сделать его как можно ближе к нему , используя только наблюдаемые сигналы , и ; но , и не наблюдаются напрямую. Его решение тесно связано с фильтром Винера .

Определение символов

-

номер текущего входного отсчета

-

количество отводов фильтра

-

( Эрмитовское транспонирование или сопряженное транспонирование )

-

оценочный фильтр; интерпретировать как оценку коэффициентов фильтра после n выборок

Идея

Основная идея фильтра LMS состоит в том, чтобы приблизиться к оптимальным весам фильтра , обновляя веса фильтра таким образом, чтобы они сходились к оптимальному весу фильтра. Это основано на алгоритме градиентного спуска. Алгоритм начинается с предположения малых весов (в большинстве случаев равных нулю), и на каждом шаге путем нахождения градиента среднеквадратичной ошибки веса обновляются. То есть, если MSE-градиент положительный, это означает, что ошибка будет продолжать увеличиваться в положительном направлении, если тот же вес используется для дальнейших итераций, что означает, что нам нужно уменьшить веса. Таким же образом, если градиент отрицательный, нам нужно увеличить веса. Уравнение обновления веса:

![W_ {n + 1} = W_n - mu nabla varepsilon [n]](https://wikimedia.org/api/rest_v1/media/math/render/svg/3408cbbe737f93c5eda40cefdc1af3feb0411f9c)

где

представляет собой среднеквадратичную ошибку, а — коэффициент сходимости.

Отрицательный знак показывает, что мы спускаемся по наклону ошибки, чтобы найти веса фильтра , которые минимизируют ошибку.

Среднеквадратичная ошибка как функция весов фильтра является квадратичной функцией, что означает, что она имеет только один экстремум, который минимизирует среднеквадратичную ошибку, которая является оптимальным весом. Таким образом, LMS приближается к этим оптимальным весам, поднимаясь / опускаясь вниз по кривой зависимости среднеквадратичной ошибки от веса фильтра.

Вывод

Идея фильтров LMS заключается в использовании наискорейшего спуска для нахождения весов фильтров, которые минимизируют функцию стоимости . Начнем с определения функции стоимости как

где — ошибка в текущей выборке n и обозначает ожидаемое значение .

Эта функция стоимости ( ) представляет собой среднеквадратическую ошибку, которая минимизируется LMS. Отсюда LMS получила свое название. Применение наискорейшего спуска означает получение частных производных по отдельным элементам вектора коэффициента (веса) фильтра.

где — оператор

градиента

Теперь это вектор, который указывает на самый крутой подъем функции стоимости. Чтобы найти минимум функции стоимости, нам нужно сделать шаг в противоположном направлении . Чтобы выразить это в математических терминах

где — размер шага (постоянная адаптации). Это означает, что мы нашли алгоритм последовательного обновления, который минимизирует функцию стоимости. К сожалению, этот алгоритм невозможно реализовать, пока мы не узнаем об этом .

Как правило, вышеприведенное ожидание не вычисляется. Вместо этого, чтобы запустить LMS в онлайн-среде (обновление после получения каждого нового образца), мы используем мгновенную оценку этого ожидания. См. ниже.

Упрощения

Для большинства систем функция ожидания должна быть аппроксимирована. Это можно сделать с помощью следующей объективной оценки

где указывает количество образцов, которые мы используем для этой оценки. Самый простой случай — это

Для этого простого случая алгоритм обновления выглядит следующим образом:

Фактически, это составляет алгоритм обновления для фильтра LMS.

Сводка алгоритма LMS

Алгоритм LMS для фильтра-го порядка можно резюмировать как

| Параметры: |

порядок фильтров порядок фильтров

|

размер шага размер шага

|

|

| Инициализация: |

|

| Расчет: | Для

|

|

|

|

|

|

|

Сходимость и стабильность в среднем

Поскольку алгоритм LMS не использует точные значения ожиданий, веса никогда не достигнут оптимальных весов в абсолютном смысле, но в среднем возможна сходимость. То есть, даже если веса могут изменяться на небольшие значения, они меняются примерно на оптимальные веса. Однако, если дисперсия, с которой изменяются веса, велика, сходимость средних значений может ввести в заблуждение. Эта проблема может возникнуть, если значение шага выбрано неправильно.

Если выбран большой, величина, с которой изменяются веса, сильно зависит от оценки градиента, и поэтому веса могут измениться на большое значение, так что градиент, который был отрицательным в первый момент, теперь может стать положительным. А во второй момент вес может сильно измениться в противоположном направлении из-за отрицательного градиента и, таким образом, будет продолжать колебаться с большим отклонением от оптимального веса. С другой стороны, если выбран слишком маленький, время для достижения оптимальных весов будет слишком большим.

Таким образом, требуется верхняя граница , которая задается как

где — наибольшее собственное значение автокорреляционной матрицы . Если это условие не выполняется, алгоритм становится нестабильным и расходится.

Максимальная скорость схождения достигается, когда

где — наименьшее собственное значение . При условии, что это значение меньше или равно этому оптимуму, скорость сходимости определяется , причем большее значение обеспечивает более быструю сходимость. Это означает , что более быстрое сближение может быть достигнуто , когда близко к , то есть максимально достижимая скорость сходимости зависит от разброса собственных значений от .

Сигнал белого шума имеет матрицу автокорреляции, где — дисперсия сигнала. В этом случае все собственные значения равны, а разброс собственных значений является минимальным по всем возможным матрицам. Таким образом, общая интерпретация этого результата состоит в том, что LMS сходится быстро для белых входных сигналов и медленно для цветных входных сигналов, таких как процессы с характеристиками нижних или верхних частот.

Важно отметить, что вышеупомянутая верхняя граница только обеспечивает стабильность в среднем, но коэффициенты все еще могут расти бесконечно большими, т.е. расхождение коэффициентов все еще возможно. Более практическая оценка

где обозначает след из . Эта граница гарантирует, что коэффициенты не расходятся (на практике значение не следует выбирать близко к этой верхней границе, поскольку это несколько оптимистично из-за приближений и предположений, сделанных при выводе оценки).

Нормализованный фильтр наименьших средних квадратов (NLMS)

Главный недостаток «чистого» алгоритма LMS заключается в том, что он чувствителен к масштабированию входных данных . Это делает очень трудным (если не невозможным) выбор скорости обучения , гарантирующей стабильность алгоритма (Хайкин, 2002). Фильтр Нормализованного минимум среднего квадратов (NLMS) представляет собой вариант LMS алгоритм , который решает эту проблему путем нормализации с силой входного сигнала. Алгоритм NLMS можно резюмировать как:

| Параметры: |

порядок фильтров порядок фильтров

|

размер шага размер шага

|

|

| Инициализация: |

|

| Расчет: | Для

|

|

|

|

|

|

|

Оптимальная скорость обучения

Можно показать, что при отсутствии помех ( ) оптимальная скорость обучения для алгоритма NLMS равна

и не зависит от входа и реальной (неизвестной) импульсной характеристики . В общем случае с помехой ( ) оптимальная скорость обучения равна

Приведенные выше результаты предполагают, что сигналы и не коррелируют друг с другом, что обычно и имеет место на практике.

Доказательство

Пусть рассогласование фильтра определяется как , мы можем получить ожидаемое рассогласование для следующего образца как:

Пусть и

Предполагая независимость, мы имеем:

Оптимальная скорость обучения найдена при , что приводит к:

Смотрите также

- Рекурсивный метод наименьших квадратов

- Для статистических методов, относящихся к фильтру LMS, см. Наименьшие квадраты .

- Сходства между Wiener и LMS

- Адаптивный фильтр с блоком с несколькими задержками в частотной области

- Эквалайзер с нулевым форсированием

- Адаптивный фильтр ядра

- согласованный фильтр

- Винеровский фильтр

Рекомендации

- Монсон Х. Хейс: Статистическая обработка и моделирование цифровых сигналов, Wiley, 1996,

ISBN 0-471-59431-8 - Саймон Хайкин: теория адаптивного фильтра, Prentice Hall, 2002, ISBN 0-13-048434-2

- Саймон С. Хайкин, Бернард Видроу (редактор): Адаптивные фильтры наименьшего среднего квадрата, Wiley, 2003, ISBN 0-471-21570-8

- Бернард Видроу, Сэмюэл Д. Стернс: адаптивная обработка сигналов, Прентис-Холл, 1985, ISBN 0-13-004029-0

- Вайфенг Лю, Хосе Принсипи и Саймон Хайкин: Адаптивная фильтрация ядра: всестороннее введение, Джон Вили, 2010, ISBN 0-470-44753-2

- Пауло С.Р. Диниц: Адаптивная фильтрация: алгоритмы и практическая реализация, Kluwer Academic Publishers, 1997, ISBN 0-7923-9912-9

Внешние ссылки

- Алгоритм LMS в адаптивных антенных решетках www.antenna-theory.com

- Демонстрация шумоподавления LMS www.advsolned.com

Алгоритм, который оценивает неизвестные из серии измерений во времени

x ^ k ∣ k — 1 { displaystyle { hat {x}} _ status {k mid k-1}}

P k ∣ k — 1 { displaystyle P_ {k mid k-1}}

В статистике и теории управления, Фильтрация Калмана, также известная как линейно-квадратичная оценка (LQE ), представляет собой алгоритм, который использует серию измерений наблюдаемый с течением времени, статистический шум и другие неточности, и дает оценку неизвестных чисел, которые имеют тенденцию быть более точными, чем оценки, основанные только на одном измерении, путем оценки совместного распределения вероятностей по переменным для каждого таймфрейма. Фильтр назван в честь Рудольфа Э. Кальмана, одного основного из разработчиков его теории.

Фильтр Калмана находит множество применений в технике. Распространенным приложением наведение, навигация и управление транспортными средствами, особенно самолетами, космическими кораблями и динамически позиционируемыми кораблями. Кроме того, фильтр Калмана — широко применяемая концепция в анализах временных рядов, используемом в таких областях, как обработка сигналов и эконометрика. Фильтры Калмана также являются одной из основных в области роботизированного планирования движения и управления и управления в оптимизации траектории. Фильтр Калмана также работает для моделирования управления движением центральной нервной системы. Из-за временной задержки между выдачей команд двигателя и получением сенсорной обратной связи использование фильтра Калмана поддерживает реалистичную модель для текущего состояния моторной системы и выдачи обновленных команд.

Алгоритм состоит из двух этапов. На этапе прогнозирования фильтр Калмана производит текущие данные состояния вместе с их неопределенностями. Как наблюдается результат следующего измерения (включая случайный шум), эти оценки обновляются с использованием средневзвешенного, при этом больший вес присваивается оценкам с большей достоверностью. Алгоритм рекурсивный. Он может работать в реального времени, используя только текущие входные измерения и ранее вычисленное состояние и его матрицу неопределенности; никакой дополнительной прошлой информации не требуется.

Оптимальность фильтра Калмана предполагает, что ошибки гауссовского. По словам Рудольфа Э. Кальмана : «Итак, в отношении случайных процессов делаются следующие предположения: физические явления можно рассматривать как следствие первичных случайных источников, возбуждающих случайные динамические системы. быть независимыми гауссовскими случайными процессами с нулевым средним; динамические системы будут линейными ». Несмотря на то, что независимо от гауссовости, если известны ковариации процесса и измерения, фильтр Калмана наилучшей возможной линейной оценкой в смысле минимальной средней квадратичной ошибки.

Расширения и обобщения способы также были разработаны, например, расширенный фильтр Калмана и фильтр Калмана без запаха, которые работают с нелинейными системами. Базовая модель — это , где пространство состояний для латентных чисел равно непрерывно, все скрытые и наблюдаемые переменные имеют гауссовский раздачи. Кроме того, фильтр Калмана успешно использовался в слиянии нескольких датчиков и в распределенных сетях датчиков для разработки распределенного или консенсусного фильтра Калмана.

Содержание

- 1 История

- 2 Обзор расчета

- 3 Пример приложения

- 4 Техническое описание и контекст

- 5 Базовая модель динамической системы

- 6 Подробности

- 6.1 Прогноз

- 6.2 Обновление

- 6.3 Инварианты

- 6.4 Оценка ковариаций шума Q k и R k

- 6.5 Оптимизация и производительность

- 7 Пример применения, технический

- 8 Асимптотическая форма

- 9 Выведение

- 9.1 Выведение ковариационной матрицы апостериорной оценки

- 9.2 Выведение коэффициента усиления Калмана

- 9.3 Упрощение формулы ковариации апостериорной ошибки

- 10 Анализ чувствительности

- 11 Форма квадратного корня

- 12 Связь с рекурсивной байесовской оценкой

- 13 Предельное правдоподобие

- 14 Информационный фильтр

- 15 Сглаживатель с фиксированным запаздыванием

- 16 Сглаживатель с фиксированным интервалом

- 16.1 Раух — Тунг –Striebel

- 16.2 Модифицированный сглаживание Брайсона — Фрейзера

- 16.3 Сглаживание сглаживания минимальной дисперсией

- 17 Частотно-взвешенные фильтры Калмана

- 18 Нелинейные фильтры

- 18.1 Расширенный фильтр Калмана

- 18.2 Безцентированный фильтр Калмана

- 18.2.1 Сигма-точки

- 18.2.2 Прогноз

- 18.2.3 Обновление

- 19 Фильтр Калмана — Бьюси

- 20 Гибридный фильтр Калмана

- 20.1 Инициализация

- 20.2 Прогноз

- 20.3 Обновление

- 21 Варианты восстановления разреженных сигналов

- 22 Приложения

- 23 См.

- 24 Ссылки

- 25 Дополнительная литература

- 26 Также Внешние ссылки

История

Фильтр назван в честь венгерского émigré Рудольфа Э. Кальмана, хотя Торвальд Николай Тиле и Питер Сверлинг разработали аналогичный алгоритм ранее. Ричард С. Бьюси из Лаборатории прикладной физики Джона Хопкинса внес вклад в теорию, в результате чего ее иногда называют фильтром Калмана — Бьюси. Стэнли Ф. Шмидту обычно приписывают первую реализацию фильтра Калмана. Он понял, что фильтр можно разделить на две части, одна часть для периодов времени между выходами датчиков, другая часть для включения измерений. Во время визита Кальмана в Исследовательский центр Эймса НАСА, Шмидт увидел применимость идей Кальмана к нелинейной задаче оценки траектории для программы Аполлон, что привело к ее достижению в Навигационный компьютер Apollo. Этот фильтр Калмана был впервые описан и частично разработан в технических статьях Сверлинга (1958 г.), Калмана (1960 г.) и Калмана и Бьюси (1961 г.).

Компьютер Apollo использовал 2k ОЗУ магнитного сердечника и трос 36k […]. ЦП был построен из микросхем […]. Тактовая частота была ниже 100 кГц […]. Тот факт, что инженеры института Массачусетского технологического института смогли упаковать такое хорошее программное обеспечение (одно из самых первых применений фильтра Калмана) в такой крошечный компьютер, поистине замечателен.

— Интервью Мэтью Рида с Джеком Креншоу, TRS-80. org (2009) [1]

Фильтр сыграли роль в реализации навигационных систем США. ВМС ядерные подводные лодки с баллистическими ракетами, а также системы наведения и навигации крылатых ракет, таких как ракета Томагавк ВМС США и США. Крылатая ракета воздушного базирования ВВС. Они также используются в системах наведения и навигации многоразовых ракет-носителей и управления ориентацией, а также в навигационных системах космических кораблей, которые состыкованы с Международной космической станцией.

Эта цифровая цифровая система. Фильтр иногда называют фильтром Стратоновича — Калмана — Бьюси, потому что это частный случай более общего нелинейного фильтра, разработанного несколько ранее советским математиком Русланом Стратоновичем. Фактически, некоторые частные уравнения линейных фильтров появились в этих статьях Стратоновича, которые были опубликованы до лета 1960 г., когда Калман встретился со Стратоновичем во время конференции в Москве.

Обзор вычислений

использует

Фильтр Калмана динамическую модель системы (например, физические законы движения), известные входные данные для этой системы и несколько последовательных измерений (например, чтобы от датчиков), сформировать оценку различных величин системы (ее состояние ), что лучше, чем оценка, полученная с использованием только одного измерения. Таким образом, это обычный алгоритм объединения датчиков и объединения данных.

Зашумленные данные датчика, приближения в уравнениях эволюции системы, и внешние факторы, которые не учитываются для всех, ограничения ограничения на то, насколько хорошо можно определить состояние системы. Фильтр Калмана эффективно справляется с неопределенностью из-за зашумленных данных датчика и, в некоторой степени, случайных факторов внешних факторов. Фильтр Калмана оценки состояния системы как среднее значение прогнозируемого состояния системы и измерения нового с использованием средневзвешенного значения. Назначение весов состоит в том, чтобы значения с лучшим (есть меньшим) оценочной неопределенности больше доверяли. Веса вычисляются на основе ковариации , оценочной неопределенности прогноза состояния системы. Результатом средневзвешенного значения является новая оценка состояния, которая находится между прогнозируемым и измеренным состояниями и имеет более точную оценку неопределенности, чем любой другой. Этот процесс повторяется на каждом временном шаге, при этом новая оценка и ее ковариация определяет прогноз, используется в следующей итерации. Это означает, что фильтр Калмана работает рекурсивно и требует только последнего «предположения», а не всего истории состояния системы для вычислений нового состояния.

Относительная достоверность измерений и оценки состояния обычно представляют собой важные особенности, и обсуждают отклик фильтра в терминах фильтра Калмана. Коэффициент Калмана — это относительный вес, придаваемый измерениям и оценка текущего состояния, и его можно «настроить» для достижения производительности. При высоком усилении фильтр придает больший вес самым последним измерением и, следовательно, более оперативно отслеживает их. При низком усилении фильтр более точно следует прогнозам модели. В крайних случаях высокое усиление, близкое к единице, к более скачкообразной расчетной траектории, в то время как низкое усиление, близкое к нулю, сгладит шум, но снизит отзывчивость.

При выполнении фактических вычислений для фильтра (как обсуждается ниже) оценка состояния и ковариации кодируются в матрицы для обработки нескольких измерений, задействованных в единственном наборе вычислений. Это позволяет представить линейные отношения между различными переменными состояниями (такими положениями, скоростью и ускорением) в любом из переходных моделей или ковариаций.

Пример приложения

В качестве приложения рассмотрим задачу определения точного местоположения грузовика. Грузовик может быть оснащен системой GPS, обеспечивающей определение местоположения в пределах нескольких метров. Оценка GPS, вероятно, будет зашумленной; показания быстро «прыгают», но остаются в пределах нескольких метров от реального положения. Кроме того, это должно быть интегрировано в систему управления движением колес и угла поворота рулевого колеса. Это метод, известный как расплата. Как правило, точный расчет обеспечивает очень плавную оценку положения грузовика, но он будет дрейфовать со временем по мере накопления небольших ошибок.

В этом примере фильтр Калмана можно представить как работающий в двух различных фазах: прогнозирование и обновление. На этапе прогнозирования старшего положения грузовика будет изменено в соответствии с физическими законами движения (динамическая модель или модель «перехода состояний»). Будет рассчитана не только новая оценка местоположения, но и новая ковариация. Определения скорости точного определения местоположения. Затем на этапе обновления данные о грузовика снимаются с устройства GPS. Наряду с этим измерением некоторая степень неопределенности, и ее степень ковариации прогноза из предыдущей фазы определяет, насколько новое измерение повлияет на обновленный прогноз. В идеале, поскольку оценка точного исчисления определяет отклонение от реального положения, измерения GPS подтягивает определение местоположения к реальному положению, но не мешает ей до такой степени, что она становится шумной и быстро прыгает.

Техническое описание и контекст

Фильтр Калмана — это эффективный рекурсивный фильтр, который оценивает внутреннее состояние линейной динамической системы из серии зашумленных измерений. Он используется в широком диапазоне инженерных и эконометрических приложений от радара и компьютерного зрения до структурных макроэкономических моделей, и важная тема в теории управления и разработка систем управления. Вместе с линейно-квадратичным регулятором (LQR) фильтр Калмана решает задачу линейно-квадратично-гауссовского управления (LQG). Фильтр Калмана, линейно-квадратичный регулятор и линейно-квадратично-гауссовский регулятор являются решениями, возможно, наиболее фундаментальных проблем теории управления.

В большинстве приложений внутреннее состояние намного больше (больше степеней свободы ), чем несколько «наблюдаемых» параметров, которые измеряются. Однако, объединив серию измерений, фильтр Калмана может оценить все внутреннее состояние.

В теории Демпстера — Шейфера уравнение состояния или рассмотрение как частный случай линейной функции доверия, а фильтр Калмана представляет собой частный случай объединения линейные функции доверия на дереве соединения или дереве Маркова. Дополнительные подходы включают байесовских или доказательных обновлений использования состояний.

На основе первичной формулировки Калмана было разработано большое количество фильтров Калмана, теперь называемых «общий» фильтром Калмана, фильтром Калмана — Бьюси, «расширенным» фильтром Шмидта, информационный фильтр и различные фильтры «квадратного корня», разработанные Бирманом, Торнтоном и другими. Калмана является контуром фазовой автоподстройки с частотой, который теперь повсеместно используется в радио, особенно с частотной модуляцией (FM) радио, телевизоры, <275.>приемники спутниковой связи, системы космической связи и почти любое другое электронное оборудование связи.

Базовая модель динамической системы

Фильтры Калмана основаны на линейных динамических систем, дискретизированных во временной области. Они моделируются на основе цепи Маркова, построенной на линейных операторов, возмущенных ошибками, которые могут включать гауссовский шум. Состояние системы как вектор из вещественных чисел. При каждом приращении дискретного времени к состоянию применяемого линейного оператора для генерации нового состояния с добавлением некоторого шума и, необязательно, некоторой информации от элементов управления в системе, если они известны. Затем другой линейный оператор, смешанный с большим количеством шума, генерирует наблюдаемые выходные данные из истинного («скрытого») состояния. Фильтр Калмана можно рассматривать как аналог скрытой модели Маркова с тем ключевыми отличием, что скрытые переменные состояния принимают значения в непрерывном пространстве (в отличие от дискретного пространства состояний, как в скрытой марковской модели). Существует сильная аналогия между уравнениями фильтра Калмана и уравнениями скрытой марковской модели. Обзор этой и других моделей дан в Roweis и Ghahramani (1999) и Hamilton (1994), глава 13.

Чтобы использовать фильтр Калмана для оценки состояния внутреннего процесса, учитывая только последовательность зашумленных наблюдений, необходимо моделировать процесс в соответствии с рамками фильтра Калмана. Это означает следующие матриц:

- Fk, модель перехода между состояниями;

- Hk, модель наблюдения;

- Qk, ковариация шумового процесса;

- Rk, ковариация наблюдения за шумом;

- и иногда Bk, модель управляющего входа, для каждого временного шага k, как описано ниже.

Модель фильтра Калмана предполагает истинное состояние в момент изменения k. из состояния в (k — 1) согласно

- xk = F kxk — 1 + B kuk + wk { displaystyle mathbf {x} _ {k} = mathbf {F} _ {k} mathbf { x} _ {k-1} + mathbf {B} _ {k} mathbf {u} _ {k} + mathbf {w} _ {k}}

где

В момент времени k наблюдение (или измерение) zkистинное состояние xkсоздается согласно

- zk = H kxk + vk { displaystyle mathbf {z} _ {k} = mathbf {H} _ {k} mathbf {x} _ {k} + mathbf {v} _ {k}}

где

- Hk- модель наблюдения, которая отображает истинное пространство состояний в наблюдаемое пространство, а

- vk- шум наблюдения, который предполагается равным нулевому среднему гауссову белый шум с ковариацией Rk: vk ∼ N (0, р К) { Displaystyle mathbf {v} _ {k} sim { mathcal {N}} left (0, mathbf {R} _ {k} right)}

.

Предполагается, что начальное состояние и векторы шума на каждом шаге {x0, w1,…, wk, v1… vk} взаимно независимы.