ГЛАВА 9

6

4

2

0

|

0 |

0.5 |

1 |

1.5 |

2 |

2.5 |

3 |

3.5 |

4 |

Адаптивные фильтры

При поиске оптимальных алгоритмов обработки сигнала неизбежно приходится опираться на некоторые статистические модели сигналов и шумов. Чаще всего при формировании этих моделей используются концепции линейности, стационарности и нормальности (гауссовости). Однако перечисленные принципы далеко не всегда выполняются на практике, а от адекватности выбранной модели в значительной мере зависит качество приема сигнала. Адаптивные фильтры позволяют системе подстраиваться под статистические параметры входного сигнала, не требуя при этом задания каких-либо моделей.

Появившись в конце 1950-х гг., адаптивные фильтры прошли большой путь, превратившись из экзотической технологии, применявшейся преимущественно в военных целях, в «ширпотреб», без которого сейчас была бы немыслима работа модемов, сотовых телефонов и многого другого.

Существует большое количество адаптивных алгоритмов, различающихся вычислительной сложностью, особенностями поведения, используемыми исходными данными и структурами самих адаптирующихся систем. В данной главе будут рассмотрены лишь несколько основных алгоритмов, но сначала следует остановиться на классификации адаптивных систем.

ЗАМЕЧАНИЕ

К сожалению, число книг на русском языке, посвященных адаптивной фильтрации, крайне ограничено. В списке литературы приведены книги [13] и [14], некоторая информация имеется также в классическом труде по цифровой связи [35]. Однако эти публикации не затрагивают целого ряда важных вопросов. В качестве дополнительных, но, к сожалению, менее доступных источников информации можно рекомендовать замечательную книгу Саймона Хайкина (S. Haykin. Adaptive Filter Theory. Prentice Hall, четыре издания вышли в 1986, 1991, 1996 и 2002 гг.), а также обзорную статью, содержащую сведения о большом числе адаптивных алгоритмов (Glentis G.-O., Berberidis K., Theodoridis S. Efficient Least Squares Adaptive Algorithms for FIR Transversal Filtering // IEEE Signal Processing Magazine, 1999, Vol. 16, No. 4, pp. 13–41).

Основные понятия адаптивной обработки сигналов

Важнейшим признаком классификации является наличие или отсутствие образцового, или опорного сигнала (desired signal, reference signal). При наличии образцового сигнала процесс адаптации называется обучением с учителем (supervised learning). В данном случае адаптивный фильтр стремится сделать свой выходной сигнал максимально близким к образцовому сигналу. О том, что именно подразумевается под близостью сигналов, сказано далее при описании конкретных алгоритмов. Адаптация без использования образцового сигнала называется слепой адаптацией (blind adaptation) или обучением без учителя (unsupervised learning). Разумеется, в этом случае требуется некоторая информация о структуре полезного входного сигнала (например, знание типа и параметров используемой модуляции). Очевидно, что слепая адаптация является более сложной вычислительной задачей, чем адаптация с использованием образцового сигнала.

ЗАМЕЧАНИЕ

У внимательного читателя должен возникнуть вопрос — какой практический смысл могут иметь алгоритмы с использованием образцового сигнала, если при этом выходной сигнал должен быть заранее известен? Однако есть целый ряд практических задач, при решении которых образцовый сигнал оказывается доступен. Подробнее об этом далее в разд. «Применение адаптивных фильтров» этой главы. Забегая вперед, заметим, что в ряде случаев при этом полезным сигналом является не выходной сигнал фильтра, а сигнал ошибки, т. е. разность между образцовым сигналом и выходным сигналом адаптивного фильтра.

Следующим признаком классификации является тип системы, осуществляющей обработку сигнала. Различают линейные и нелинейные адаптивные системы, при этом имеется в виду линейность по отношению не ко входному сигналу, а к параметрам системы, настраиваемым в процессе адаптации.

Наиболее распространены линейные адаптивные системы, в которых обработка сигнала производится нерекурсивным дискретным фильтром. Одним из главных достоинств такого варианта является то, что нерекурсивный фильтр является устойчивым при любых значениях его коэффициентов. Однако следует отметить, что алгоритм адаптации в любом случае вносит в систему обратную связь, вследствие чего адаптивная система в целом может стать неустойчивой.

К нелинейным адаптивным системам относятся, в частности, нейронные сети (neural networks), в определенной степени моделирующие работу нервной системы живых организмов. Рассмотрение таких систем выходит за рамки тематики данной книги. За дополнительной информацией можно обратиться, например, к книгам [43, 44].

Еще одна разновидность нелинейных адаптивных систем — рекурсивные адаптивные фильтры. Однако их создание связано с серьезными проблемами, прежде всего связанными с устойчивостью, поэтому такие фильтры не получили широкого распространения. Некоторые теоретические сведения на эту тему содержатся в [13].

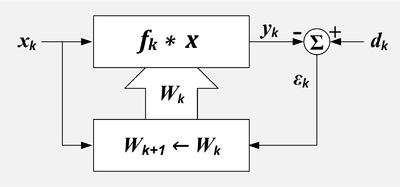

Итак, в данной главе речь пойдет об адаптивных фильтрах, использующих образцовый сигнал. Общая структура такой адаптивной системы показана на рис. 9.1.

Рис. 9.1. Общая структура адаптивного фильтра

Входной дискретный сигнал x(k) обрабатывается дискретным фильтром, в результате чего получается выходной сигнал y(k). Этот выходной сигнал сравнивается с образцовым сигналом d(k), разность между ними образует сигнал ошибки e(k). Задача адаптивного фильтра — минимизировать ошибку воспроизведения образцового сигнала. С этой целью блок адаптации после обработки каждого отсчета анализирует сигнал ошибки и дополнительные данные, поступающие из фильтра, используя результаты этого анализа для подстройки параметров (коэффициентов) фильтра.

В данной главе рассмотрены два адаптивных алгоритма, часто применяемых на практике в различных радиотехнических системах. Это алгоритмы LMS (Least Mean Square, метод наименьшего квадрата, в отечественных источниках иногда используется аббревиатура МНК), и RLS (Recursive Least Squares, рекурсивный метод наименьших квадратов, в отечественных источниках иногда используется аббревиатура РНК).

Вывод формул, описывающих данные алгоритмы, производится на основе уравнений оптимальной фильтрации сигнала. Возможны различные подходы к решению задачи оптимальной фильтрации. Статистический подход в сочетании с методом градиентной оптимизации дает алгоритм LMS, а детерминированный подход приводит к алгоритму RLS.

Далее мы рассмотрим перечисленные подходы к решению задачи оптимальной фильтрации и идеи, лежащие в основе адаптивных алгоритмов.

Все перечисленное относится к алгоритмам, использующим образцовый сигнал (т. е. к обучению с учителем).

Оптимальный фильтр Винера

Говоря об оптимальной фильтрации сигнала, следует помнить, что данная задача становится осмысленной лишь после задания двух вещей — математической модели входного сигнала и оптимизируемого критерия качества. Тогда задача оптимальной фильтрации сводится к математической оптимизационной задаче, которая может быть решена аналитически либо численно.

Итак, пусть входной дискретный случайный сигнал {x(k)} обрабатывается дискретным фильтром порядка N с коэффициентами {wn} , n = 0, 1, …, N (рис. 9.2).

|

594 |

Глава 9 |

|||||||||||||||||||||||||||||||||||||||

|

x(k) |

z–1 |

z–1 |

z–1 |

|||||||||||||||||||||||||||||||||||||

|

w0 |

w1 |

w2 |

wN–1 |

wN |

||||||||||||||||||||||||||||||||||||

|

d(k) |

||||||||||||||||||||||||||||||||||||||||

|

y(k) |

–1 |

e(k) |

||||||||||||||||||||||||||||||||||||||

|

Рис. 9.2. Формирование сигнала ошибки |

||||||||||||||||||||||||||||||||||||||||

|

Выходной сигнал фильтра равен |

||||||||||||||||||||||||||||||||||||||||

|

N |

||||||||||||||||||||||||||||||||||||||||

|

y(k) = ∑wn x(k − n) . |

(9.1) |

n=0

Кроме того, имеется образцовый (также случайный) сигнал d(k). Ошибка воспроизведения образцового сигнала равна

|

N |

|

|

e(k) = d(k) − y(k) = d(k) − ∑wn x(k − n) . |

(9.2) |

n=0

Наша задача — найти такие коэффициенты фильтра {wn} , которые обеспечивают максимальную близость выходного сигнала фильтра к образцовому, т. е. минимизируют ошибку e(k). Но поскольку e(k) также является случайным процессом, в качестве меры ее величины разумно принять средний квадрат. Таким образом, оптимизируемая функция выглядит так:

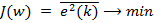

J ({wn}) = e2 (k) → min .

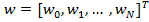

Для решения поставленной задачи прежде всего перепишем (9.2) в матричном виде. Для этого обозначим вектор-столбец коэффициентов фильтра как w, а векторстолбец содержимого линии задержки фильтра на k-м шаге как x(k):

|

x(k) |

||

|

x(k −1) |

||

|

x(k) = |

. |

|

x(k − N)

С учетом этих обозначений (9.2) принимает следующий вид:

|

e(k) = d (k) − xT (k)w . |

(9.3) |

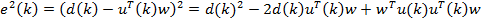

Квадрат ошибки будет равен

e2 (k) = (d (k) − xT (k)w)2 = d 2 (k) − 2d (k)xT (k)w + (xT (k)w)2 = = d 2 (k) − 2d (k)xT (k)w + wTx(k)xT (k)w.

|

Адаптивные фильтры |

595 |

|||||||||

|

Статистически усредняя это выражение, получаем следующее: |

||||||||||

|

− 2( |

)T w + wT |

w . |

||||||||

|

e2 (k) |

d 2 (k) |

x(k)xT (k) |

(9.4) |

|||||||

|

J (w) = |

= |

d (k)x(k) |

Рассмотрим подробнее входящие в полученную формулу усредненные величины:

d 2 (k) — это средний квадрат образцового сигнала. Он представляет собой отдельное слагаемое, которое не зависит от коэффициентов фильтра и потому может быть отброшено (однако оно влияет на величину среднего квадрата ошибки, получаемую при оптимальных значениях коэффициентов фильтра). Обозначим данную величину как σ2d ;

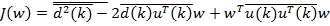

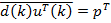

d (k)x(k) — это вектор-столбец взаимных корреляций между k-м отсчетом образцового сигнала и содержимым линии задержки фильтра на k-м шаге. Будем считать случайные процессы x(k) и d(k) совместно стационарными, тогда вектор взаимных корреляций не зависит от номера шага k. В дальнейших выкладках этот вектор будет обозначен как p:

|

d(k)x(k) |

|||||

|

p = d(k)x(k −1) |

. |

||||

d(k)x(k − N )

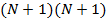

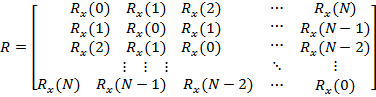

x(k)xT (k) — это квадратная матрица размером (N + 1) × (N + 1), являющаяся корреляционной матрицей сигнала (см. разд. «Дискретные случайные процессы» главы 3). Как отмечалось в указанном разделе, для стационарного случайного процесса корреляционная матрица имеет вид матрицы Теплица, вдоль диагоналей которой стоят значения корреляционной функции:

|

Rx (0) |

|||||

|

Rx (1) |

|||||

|

R = |

Rx (2) |

||||

|

R |

x ( |

N |

) |

||

|

Rx (1) |

Rx (2) |

|

Rx (0) |

Rx (1) |

|

Rx (1) |

Rx (0) |

Rx (N −1) Rx (N − 2)

…Rx (N)

…R (N −1)

…Rx(N − 2) ,

|

… |

R |

(0) |

|

|

x |

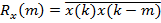

где Rx ( k) = x(k)x(k − k) — КФ входного сигнала.

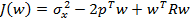

С учетом введенных обозначений (9.4) принимает следующий вид:

|

J (w) = σd2 − 2pTw + wT R w . |

(9.5) |

Данное выражение представляет собой квадратичную форму относительно w и потому при невырожденной матрице R имеет единственный минимум, для нахождения которого необходимо приравнять к нулю вектор градиента:

|

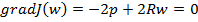

J (w) = −2p + 2R w = 0 . |

(9.6) |

Отсюда получаем равенство, называемое уравнением Винера — Хопфа (Wiener — Hopf equation):

Умножив слева обе части равенства на обратную корреляционную матрицу R−1 , получаем искомое решение для оптимальных коэффициентов фильтра:

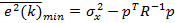

Такой фильтр называется фильтром Винера (Wiener filter). Подстановка (9.8) в (9.5) дает минимально достижимую дисперсию сигнала ошибки:

|

e2 (k)min = σd2 |

− pT R−1p . |

(9.9) |

|||

|

Несложно также показать, что e(k) y(k) = 0 |

и e(k)x(k) = 0 , т. е. что сигнал ошибки |

для фильтра Винера некоррелирован с входным и выходным сигналами фильтра.

В качестве примера с помощью MATLAB рассчитаем оптимальный фильтр для коррекции искажений, вносимых в передаваемый сигнал x0 (k) каналом связи, имеющим четырехэлементную импульсную характеристику следующего вида:

{hk } = {−2, − 4, 6, 3}, k = 0, 1, 2, 3.

Отсчеты передаваемого сигнала будем считать независимыми случайными величинами с нулевым средним значением и единичной дисперсией. В этом случае корреляционная функция сигнала, прошедшего через канал связи, будет совпадать с корреляционной функцией импульсной характеристики канала:

|

{R( k)} = ∑hk hk − k = {65, 2, –24, –6}, |

k = 0, 1, 2, 3. |

|

|

k |

Корреляционная матрица входного сигнала строится как матрица Теплица на основе данной корреляционной функции:

|

65 |

2 |

−24 −6 0 |

… 0 |

|||||

|

2 |

65 |

2 |

−24 −6 |

… 0 |

||||

|

−24 2 |

65 |

2 |

−24 |

… |

0 |

|||

|

R = |

−6 |

−24 2 |

65 |

2 |

… |

0 |

. |

|

|

0 |

−6 −24 2 |

65 … 0 |

||||||

|

… |

||||||||

|

0 |

0 |

0 |

0 |

0 |

65 |

Восстановление переданного сигнала неизбежно требует внесения некоторой временной задержки, поэтому образцовый сигнал должен представлять собой задержанную копию переданного:

d (k) = x0 (k − k) .

В линии задержки фильтра на k-м шаге находятся отсчеты искаженного сигнала с номерами k, k – 1, k – 2, …, k – N, где N — порядок фильтра. Каждый из этих отсчетов представляет собой линейную комбинацию отсчетов переданного сигнала:

|

∞ |

|

|

x(k − n) = ∑ x0 (m)hk −n−m . |

(9.10) |

m=−∞

Поскольку отсчеты исходного сигнала считаются статистически независимыми, при вычислении n-го элемента вектора p результат усреднения будет отличен от нуля только для одного слагаемого (9.10). Сразу же учтем тот факт, что средний квадрат сигнала x0 (k) равен единице:

∞

pn = x(k − n)d(k) = ∑ x0 (m) hk−n−m x0 (k − k) =

m=−∞

∞

= ∑ hk−n−m x0 (m) x0 (k − k) = h k−m.

m=−∞

Таким образом, вектор p содержит перевернутую импульсную характеристику канала, при необходимости обрезанную или дополненную нулями с одной или двух сторон:

h k

k−1

|

p = |

h1 |

. |

|

h |

||

|

0 |

||

|

0 |

||

|

0 |

||

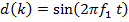

Далее приводится код MATLAB-программы, реализующей расчет оптимального фильтра. Код составлен так, чтобы можно было легко варьировать вид импульсной характеристики канала и порядок рассчитываемого фильтра (единственное ограничение — предполагается, что импульсная характеристика канала связи целиком укладывается в пределах вектора p):

h = [-2 -4 6 3]; % импульсная характеристика канала связи N = 32; % порядок рассчитываемого фильтра

r = xcorr(h, N); % двусторонняя КФ импульсной характеристики канала r = r(N+1:end); % односторонняя КФ импульсной характеристики канала R = toeplitz(r); % корреляционная матрица искаженного сигнала

p = zeros(N+1, 1);

delay = 16; % задержка фильтрации

p(delay-length(h)+2:delay+1) = fliplr(h); % вектор взаимных корреляций w = Rp; % коэффициенты оптимального фильтра

subplot(1,2,1)

|

598 |

Глава 9 |

|||||||||||||

|

impz(w) |

% график имп. х-ки рассчитанного фильтра |

|||||||||||||

|

subplot(1,2,2) |

||||||||||||||

|

impz(conv(h, w)) % график имп. х-ки скорректированного канала |

||||||||||||||

|

Impulse Response |

Impulse Response |

|||||||||||||

|

0.14 |

1.2 |

|||||||||||||

|

0.12 |

||||||||||||||

|

1 |

||||||||||||||

|

0.1 |

||||||||||||||

|

0.08 |

0.8 |

|||||||||||||

|

0.06 |

0.6 |

|||||||||||||

|

0.04 |

||||||||||||||

|

0.02 |

0.4 |

|||||||||||||

|

0 |

0.2 |

|||||||||||||

|

-0.02 |

||||||||||||||

|

0 |

||||||||||||||

|

-0.04 |

||||||||||||||

|

-0.06 |

-0.2 |

|||||||||||||

|

0 |

5 |

10 |

15 |

20 |

25 |

30 |

0 |

5 |

10 |

15 |

20 |

25 |

30 |

35 |

|

n (samples) |

n (samples) |

Рис. 9.3. Импульсные характеристики корректирующего фильтра (слева) и скорректированного канала связи (справа)

ЗАМЕЧАНИЕ

В приведенном коде следует обратить внимание на использование оператора матричного деления () для решения системы линейных уравнений (9.7).

На рис. 9.3 приведены графики импульсной характеристики корректирующего фильтра и сквозной импульсной характеристики скорректированного канала связи. Видно, что сквозная характеристика близка к единичному импульсу, что говорит о хорошем качестве коррекции. Столь качественная коррекция оказалась возможна потому, что частотная характеристика канала не имеет глубоких провалов (с помощью функции freqz легко убедиться в том, что неравномерность АЧХ канала составляет около 11 дБ).

Градиентный поиск оптимального решения

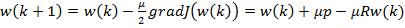

Один из наиболее распространенных адаптивных алгоритмов основан на поиске минимума целевой функции (9.4) методом наискорейшего спуска. При использовании данного способа оптимизации вектор коэффициентов фильтра зависит от номера итерации k: w(k). На каждой итерации вектор коэффициентов смещается на величину, пропорциональную градиенту целевой функции в данной точке (см. формулу (9.6)):

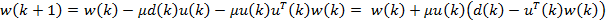

|

w(k +1) = w(k) − |

μ |

J (w(k)) = w(k) + μp − μR w(k) , |

(9.11) |

2

где μ — положительный коэффициент, называемый размером шага.

Анализ сходимости данного процесса приведен, например, в [13]. Показано, что алгоритм сходится, если

где λmax — максимальное собственное число корреляционной матрицы R. Скорость сходимости при этом зависит от разброса собственных чисел корреляционной матрицы R — чем меньше отношение λmax/λmin, тем быстрее сходится итерационный процесс.

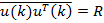

Адаптивный алгоритм LMS

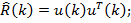

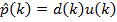

При реализации наискорейшего спуска по формуле (9.11) нужно вычислять значения градиента, а для их расчета, в свою очередь, необходимо знать значения матрицы R и вектора p. На практике могут быть доступны лишь оценки этих параметров, получаемые по входным данным. Простейшими такими оценками являются мгновенные значения корреляционной матрицы и вектора взаимных корреляций, получаемые без какого-либо усреднения:

pˆ (k) = d (k) x(k) .

При использовании данных оценок формула (9.11) принимает следующий вид:

w(k +1) = w(k) + µ d (k)x(k) − µ x(k)xT (k) w(k) =

(9.13)

= w(k) + µ x(k)(d (k) − xT (k) w(k)).

Выражение, стоящее в скобках, согласно (9.3), представляет собой разность между образцовым сигналом и выходным сигналом фильтра на k-м шаге, т. е. ошибку фильтрации e(k). С учетом этого выражение для рекурсивного обновления коэффициентов фильтра оказывается очень простым:

|

w(k +1) = w(k) + μ e(k) x(k) . |

(9.14) |

Алгоритм адаптивной фильтрации, основанный на формуле (9.14), получил название LMS (Least Mean Square, метод наименьшего квадрата). Можно получить ту же формулу и несколько иным образом: использовав вместо градиента статисти-

чески усредненного квадрата ошибки e2 (k) градиент его мгновенного значения e2 (k) .

Несмотря на простоту алгоритма LMS, анализ его поведения оказывается чрезвычайно сложной задачей, для которой не существует точного аналитического решения. Частные результаты, полученные при использовании различных приближений, можно найти в большом количестве книг и статей. Достаточно подробный анализ выполнен в упоминавшейся в начале главы книге С. Хайкина, при этом получены следующие результаты. Алгоритм LMS сходится в среднем (converges in the mean values; это означает, что математические ожидания коэффициентов фильтра при

k → ∞ стремятся к оптимальному решению (9.8)), если коэффициент μ удовлетворяет тому же условию (9.12), которое требуется для сходимости детерминированного градиентного спуска. Однако это еще не гарантирует того, что средние квадраты коэффициентов будут стремиться к фиксированным значениям. Алгоритм

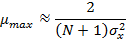

сходится в среднем квадрате (converges in the mean square) в более узком диапазоне значений μ:

|

2 |

2 |

2 |

|||||

|

μmax ≈ |

= |

= |

, |

(9.15) |

|||

|

N |

trace(R) |

2 |

|||||

|

∑λn |

(N +1) σx |

||||||

n=0

где λk — собственные числа корреляционной матрицы R, а σ2x — средний квадрат входного сигнала фильтра.

На формуле (9.15) основан нормированный (normalized) LMS-алгоритм, в котором коэффициент μ на каждом шаге рассчитывается исходя из энергии сигнала, содержащегося в линии задержки:

|

μ(k) = |

μ0 |

, |

(9.16) |

|

T |

|||

|

x x + ε |

где μ0 — нормированное значение μ, лежащее в диапазоне от 0 до 2, а ε — малая

положительная константа, назначение которой — ограничить рост μ при нулевом сигнале на входе фильтра (из формулы (9.16) видно, что максимально возможное значение μ составляет μ0

Даже если LMS-алгоритм сходится, дисперсии коэффициентов фильтра при k → ∞ не стремятся к нулю — коэффициенты флуктуируют вокруг оптимальных значений. Из-за этого ошибка фильтрации в установившемся режиме оказывается боль-

ше, чем ошибка для винеровского фильтра e2 (k)min (см. ранее формулу (9.9)):

e2 (k)LMS = e2 (k)min + Eex ,

где Eex — средний квадрат избыточной ошибки (excess error) алгоритма LMS. В той же книге С. Хайкина приводится следующая приближенная формула для так называемого коэффициента расстройки (misalignment), равного отношению средних квадратов избыточной и винеровской ошибок:

|

N |

|||||||||||||||||

|

μ∑λn |

|||||||||||||||||

|

2 |

(k) |

2 |

|||||||||||||||

|

Μ = |

e |

LMS |

−1 = |

Eex |

≈ |

n=0 |

= |

μ(N +1)σвх |

= |

μ |

. (9.17) |

||||||

|

N |

2 |

||||||||||||||||

|

e2 (k)min |

e2 (k)min |

μmax − μ |

|||||||||||||||

|

2 − μ∑λn |

2 |

− μ(N +1)σвх |

n=0

Значение коэффициента μ влияет на два главных параметра LMS-фильтра — скорость сходимости и коэффициент расстройки. Чем больше μ, тем быстрее сходится алгоритм, но тем больше, согласно (9.17), становится коэффициент расстройки, и наоборот.

Основным достоинством алгоритма LMS является предельная вычислительная простота — для подстройки коэффициентов фильтра на каждом шаге нужно выполнить N + 1 пар операций «умножение-сложение». Платой за простоту являются медленная сходимость и повышенная (по сравнению с минимально достижимым значением (9.9)) дисперсия ошибки в установившемся режиме.

Существует большое число модификаций алгоритма LMS (см., например, обзорную статью, упомянутую в начале этой главы), направленных на ускорение сходимости либо на уменьшение числа арифметических операций. Ускорение сходимости может быть достигнуто за счет улучшения используемой оценки градиента, а также за счет преобразования входного сигнала с целью сделать его отсчеты некоррелированными. Уменьшение вычислительной сложности может быть достигнуто, в частности, за счет использования в (9.14) не самих сигнала ошибки и содержимого линии задержки фильтра, а лишь их знаков. Это позволяет полностью избавиться от операций умножения при обновлении коэффициентов фильтра. В целом следует отметить, что требования ускорения сходимости и сокращения вычислительных затрат являются взаимоисключающими.

Детерминированная задача оптимальной фильтрации

Рассматривая статистическую задачу оптимизации, мы считали входной сигнал случайным процессом и минимизировали дисперсию ошибки воспроизведения образцового сигнала. Однако возможен и иной подход, не использующий статистические методы.

Итак, пусть обработке подвергается последовательность отсчетов {x(k)}, коэффициенты нерекурсивного фильтра порядка N образуют набор {wn} , n = 0, 1, …, N, а отсчеты образцового сигнала равны {d(k)}. Выходной сигнал фильтра определяется формулой (9.1), а ошибка воспроизведения образцового сигнала — формулой (9.2) или, в векторном виде, (9.3).

Теперь сформулируем детерминированную оптимизационную задачу: мы хотим отыскать такие коэффициенты фильтра {wn} , чтобы суммарная квадратичная ошибка воспроизведения образцового сигнала была минимальной:

|

K −1 |

|

|

J ({wn}) = ∑| e(k) |2 → min . |

(9.18) |

k =0

Для решения задачи необходимо перейти в формуле (9.3) к матричной записи, так сказать, вдоль координаты k, получив формулы для векторов-столбцов выходного сигнала y и ошибки воспроизведения входного сигнала e:

|

y = XTw , e = d − XT w . |

(9.19) |

Здесь d — вектор-столбец отсчетов образцового сигнала, а X — матрица, столбцы которой представляют собой содержимое линии задержки фильтра на разных тактах:

|

602 |

Глава 9 |

||

|

d(0) |

|||

|

d(1) |

|||

|

d = |

, X = [x(0) x(1) … x(N – 1)]. |

||

|

d(K − |

1) |

Выражение (9.18) для суммарной квадратичной ошибки в матричном виде можно записать следующим образом:

|

T |

(9.20) |

|

J (w) = e e → min . |

Подставив (9.19) в (9.20), имеем

J (w) = (d − XT w)T (d − XTw) =

=dTd − (XTw)T d − dT (XTw) + (XTw)T (XTw) =

=dTd − wT Xd − dT XTw + wT XXTw.

Для нахождения минимума необходимо вычислить градиент данного функционала и приравнять его к нулю:

J (w) = −2Xd + 2XXTw = 0.

Отсюда легко получается искомое оптимальное решение:

В формуле (9.21) прослеживается близкое родство с формулой (9.8), описывающей оптимальный в статистическом смысле фильтр Винера. Действительно, если

учесть, что (XXT )−1

Адаптивный алгоритм RLS

В принципе, в процессе приема сигнала можно на каждом очередном шаге пересчитывать коэффициенты фильтра непосредственно по формуле (9.21), однако это связано с неоправданно большими вычислительными затратами. Действительно, на каждом шаге увеличивается размер матрицы X; кроме того, необходимо каждый

раз заново вычислять обратную матрицу (X XT )−1 .

Сократить вычислительные затраты можно, если заметить, что на каждом шаге к матрице X добавляется лишь один новый столбец, а к вектору d — один новый элемент. Это дает возможность организовать вычисления рекурсивно. Соответствующий алгоритм получил название рекурсивного метода наименьших квадратов (Recursive Least Squares, RLS).

На k-м шаге оптимальный вектор коэффициентов фильтра, согласно (9.21), равен

w(k) = (X(k)XT (k))−1 X(k)d(k) . (9.22)

Посмотрим, какие новые данные добавляются к X(k) и d(k) на следующем шаге и как мы можем использовать их для обновления рассчитанного ранее решения — ведь именно в таком постоянном обновлении состоит суть работы адаптивного фильтра.

К матрице X на каждом шаге добавляется новый столбец x(k + 1), а к вектору d — новый элемент d(k + 1):

|

d(k) |

||||||||||||||||

|

X(k +1) = [X(k) |

x(k +1)] , |

d(k + 1) = |

. |

(9.23) |

||||||||||||

|

d (k + 1) |

В алгоритме RLS производится рекурсивное обновление оценки обратной корреляционной матрицы

P(k) = (X(k)XT (k))−1 .

При переходе к следующему шагу мы имеем

|

( |

T |

) |

−1 |

XT (k) |

−1 |

|||||||||||||||

|

[ |

] |

T |

||||||||||||||||||

|

P(k +1) = |

X(k +1)X |

(k +1) |

= |

X(k) |

x(k +1) |

x |

(k +1) |

= |

||||||||||||

|

(9.24) |

||||||||||||||||||||

|

= (X(k)XT (k) + x(k +1)xT (k +1))−1 . |

||||||||||||||||||||

|

Теперь воспользуемся матричным тождеством |

||||||||||||||||||||

|

(A + BCD)−1 = A−1 − A−1B(C−1 + DA−1B)−1 DA−1 , |

(9.25) |

которое является справедливым для произвольных квадратных невырожденных матриц A и C и произвольных матриц B и D совместимых размеров.

Установим между (9.24) и (9.25) следующее соответствие:

A = X(k)XT (k) = P−1(k) , A−1 = P(k) (квадратная матрица);

B = x(k + 1) (вектор-столбец);

C = 1 (скаляр);

D = xT (k +1) (вектор-строка).

В результате равенство (9.24) можно записать следующим образом:

P(k +1) = P(k) − P(k)x(k +1) (1 + xT (k +1)P(k)x(k +1))−1 xT (k +1)P(k) . (9.26)

Здесь следует заметить, что фрагмент выражения в круглых скобках, возводимый в минус первую степень, представляет собой скаляр. Далее используем (9.23) и (9.26) в выражении (9.22) для коэффициентов фильтра:

|

604 |

Глава 9 |

|||||||||||||||

|

d(k) |

||||||||||||||||

|

w(k +1) = P(k +1)X(k +1)d(k +1) = P(k +1)[X(k) |

x(k +1)] |

= |

||||||||||||||

|

d(k +1) |

= P(k +1) ( X(k)d(k) + x(k +1)d(k +1)) =

|

P(k)x(k +1)xT (k +1)P(k) |

|||||

|

= P(k) − |

( X(k)d(k) + x(k +1)d(k +1)). |

||||

|

1 + x |

T |

(k +1)P(k)x(k +1) |

|||

Раскроем скобки в этом выражении:

w(k +1) = P(k)X(k)d(k) − P(k)x(k +1)xT (k +1)P(k) X(k)d(k) + 1 + xT (k +1)P(k)x(k +1)

+ P(k)x(k +1)d (k +1) − P(k)x(k +1)xT (k +1)P(k) x(k +1)d(k +1). 1 + xT (k +1)P(k)x(k +1)

Первое слагаемое в полученной формуле, согласно (9.22), представляет собой коэффициенты оптимального фильтра для k-го шага — w(k). Этот же вектор можно выделить в качестве множителя во втором слагаемом. Что касается третьего и четвертого слагаемых, в них можно выделить общий множитель P(k) x(k + 1) d(k + 1):

|

w(k +1) = w(k) − |

P(k)x(k +1)xT (k +1) |

w(k) + |

||||

|

1 |

+ xT (k +1)P(k)x(k +1) |

|||||

|

xT (k +1)P(k)x(k +1) |

||||||

|

+P(k)x(k +1)d (k +1) 1 |

− |

. |

||||

|

+ xT (k +1)P(k)x(k +1) |

||||||

|

1 |

Выполнив вычитание в круглых скобках, получаем

|

w(k +1) = w(k) − |

P(k)x(k +1)xT (k +1) |

w(k) + |

P(k)x(k +1)d(k +1) |

. |

|

1 + xT (k +1)P(k)x(k +1) |

1 + xT (k +1)P(k)x(k +1) |

Теперь видно, что второе и третье слагаемые имеют общий множитель, который можно вынести за скобки:

|

w(k +1) = w(k) + |

P(k)x(k +1) |

(d (k +1) − xT (k +1)w(k)) . |

||

|

T |

(k +1)P(k)x(k +1) |

|||

|

1 + x |

Далее заметим, что произведение xT (k +1) w(k) есть результат обработки нового (поступившего на (k + 1)-м шаге) входного сигнала фильтром со старыми (т. е. имеющимися на данный момент) коэффициентами w(k). Иными словами, это произведение представляет собой выходной сигнал адаптивного фильтра y(k + 1). Соответственно, получается, что разность, стоящая в скобках, — не что иное, как ошибка фильтрации e(k + 1):

|

P(k)x(k +1) |

||

|

w(k +1) = w(k) + |

e(k +1) . |

|

|

1 + xT (k +1)P(k)x(k +1) |

Наконец, в качестве последнего штриха введем обозначение для вынесенного за скобки векторного множителя:

|

K(k +1) = |

P(k)x(k +1) |

. |

|

|

1 + xT (k +1)P(k)x(k +1) |

|||

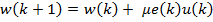

С учетом этого формула для коэффициентов фильтра примет вид

|

w(k + 1) = w(k) + K(k + 1) e(k + 1). |

(9.27) |

Вектор K(k + 1) называют вектором коэффициентов усиления.

ЗАМЕЧАНИЕ

Структура формулы (9.27) совпадает со структурой формулы (9.14), описывающей обновление коэффициентов фильтра для LMS-алгоритма — к текущему вектору коэффициентов фильтра добавляется слагаемое, рассчитываемое как произведение сигнала ошибки на некий вектор коэффициентов усиления. Различие состоит лишь в способе получения этого вектора — в алгоритме LMS он пропорционален содержимому линии задержки фильтра, а в алгоритме RLS рассчитывается более сложным образом.

Итак, при использовании адаптивного алгоритма RLS необходимо на каждом временном такте выполнить следующие шаги:

1.При поступлении новых входных данных x(k) производится фильтрация сигнала с использованием текущих коэффициентов фильтра w(k – 1) и вычисление величины ошибки воспроизведения образцового сигнала:

y(k) = x(k)T w(k −1) , e(k) = d (k) − y(k) .

2.Рассчитывается вектор-столбец коэффициентов усиления (обратите внимание на то, что при вычислениях не используются предыдущие значения — вектор K всякий раз рассчитывается заново, т. е. вычисления не являются рекурсивными; кроме того, еще раз отметим, что знаменатель дроби в следующих двух формулах является скаляром, а не матрицей):

|

K(k) = |

P(k −1)x(k ) |

. |

(9.28) |

|

|

1 + xT (k)P(k −1)x(k) |

||||

3. Выполняется обновление оценки обратной корреляционной матрицы сигнала:

|

P(k) = P(k −1) − |

P(k −1)x(k)x(k)T P(k −1) |

. |

(9.29) |

|

1+ x(k)T P(k −1)x(k) |

4. Наконец, производится обновление коэффициентов фильтра: w(k) = w(k −1) + K(k)e(k) .

Осталось разобраться с начальными значениями рекурсивно обновляемых матрицы P и вектора w. Вектор коэффициентов фильтра w перед началом работы алгоритма обычно заполняется нулями. Что касается матрицы P, то строгий анализ показыва-

606 Глава 9

ет, что после заполнения линии задержки фильтра отсчетами сигнала результат вычислений не будет зависеть от начальных условий, если

|

∞ |

0 |

0 |

… |

0 |

||||

|

0 |

∞ |

0 |

… |

0 |

||||

|

P(−1) = |

∞ … |

|||||||

|

0 |

0 |

0 |

. |

|||||

|

0 |

0 |

0 |

… ∞ |

|||||

На практике диагональ матрицы заполняется большими положительными значениями. Например, в [13] рекомендуется величина 100

По сравнению с LMS-алгоритмом алгоритм RLS требует значительно большего числа вычислительных операций. При оптимальной организации вычислений для

обновления коэффициентов фильтра необходимо 2,5N2 + 4N пар операций «ум- ножение—сложение» [13]. Под оптимальной организацией здесь, в частности, подразумевается учет симметрии матрицы P. Таким образом, число операций в алгоритме RLS квадратично возрастает с увеличением порядка фильтра.

Зато алгоритм RLS сходится значительно быстрее, чем алгоритм LMS. Строго говоря, само понятие сходимости применимо здесь лишь условно, поскольку данный алгоритм не является алгоритмом последовательного приближения. Алгоритм RLS на каждом шаге дает оптимальные коэффициенты фильтра, соответствующие формуле (9.21), и переходный процесс в начале работы связан лишь с рекурсивным расчетом оценки матрицы P и постепенным заполнением линии задержки фильтра отсчетами входного сигнала.

Экспоненциальное забывание

В формулах (9.18) и (9.20) значениям ошибки на всех временных тактах придается одинаковый вес. В результате, если статистические свойства входного сигнала со временем изменяются, это приведет к ухудшению качества фильтрации. Чтобы дать фильтру возможность отслеживать нестационарный входной сигнал, можно применить в (9.18) экспоненциальное забывание (exponential forgetting), при котором вес прошлых значений сигнала ошибки экспоненциально уменьшается:

K −1

J (w) = ∑λK −1−k | e(k) |2 ,

k=0

где λ — коэффициент забывания (forgetting factor), 0 <λ ≤ 1.

При использовании экспоненциального забывания формулы (9.28) и (9.29) принимают следующий вид:

|

K(k) = |

P(k −1)x(k) |

, |

||

|

λ + xT (k) P(k −1) x(n) |

||||

|

P(k) = |

1 |

(P(k −1) − K(k) xT (k)P(k −1)) . |

||

|

λ |

||||

Применение адаптивных фильтров

Адаптивные фильтры в настоящее время нашли применение во многих системах обработки сигналов. В данном разделе мы рассмотрим лишь некоторые из возможных областей их использования.

Идентификация систем

Все способы применения адаптивных фильтров так или иначе сводятся к решению задачи идентификации, т. е. определения характеристик, некоторой системы. Возможны два варианта идентификации — прямая и обратная. В первом случае адаптивный фильтр включается параллельно с исследуемой системой (рис. 9.4, а).

|

Исследуемая |

Исследуемая |

Вход |

Адаптивный |

|||||||||||

|

система |

система |

фильтр |

||||||||||||

|

Образец |

||||||||||||||

|

Адаптивный |

||||||||||||||

|

Вход |

фильтр |

Образец |

||||||||||||

|

а |

б |

Рис. 9.4. Идентификация систем с помощью адаптивного фильтра: а — прямая, б — обратная

Входной сигнал является общим для исследуемой системы и адаптивного фильтра, а выходной сигнал системы служит для адаптивного фильтра образцовым сигналом. В процессе адаптации временные и частотные характеристики фильтра будут стремиться к соответствующим характеристикам исследуемой системы.

При обратной идентификации адаптивный фильтр включается последовательно с исследуемой системой (см. рис. 9.4, б). Выходной сигнал системы поступает на вход адаптивного фильтра, а входной сигнал системы является для адаптивного фильтра образцом. Таким образом, фильтр стремится компенсировать влияние системы и восстановить исходный сигнал, устранив внесенные системой искажения.

Теперь перейдем от этих обобщенных схем к рассмотрению более конкретных вариантов.

Линейное предсказание

Согласно определению, данному в разд. «Авторегрессионная модель» главы 5 для предсказывающего фильтра, он минимизирует средний квадрат ошибки предсказания сигнала по его предыдущим отсчетам. Однако такую же задачу будет решать и рассмотренный в этой главе ранее фильтр Винера, если в качестве образца использовать текущий отсчет сигнала, а на вход фильтра подать сигнал, задержанный на один такт. Адаптивные алгоритмы в процессе работы сходятся к оптимальному винеровскому решению, поэтому для решения задачи линейного предсказания можно использовать адаптивный фильтр, включенный по схеме, показанной на рис. 9.5.

|

608 |

Глава 9 |

||||||||

Рис. 9.5. Линейное предсказание с помощью адаптивного фильтра

В процессе адаптации коэффициенты фильтра будут стремиться к коэффициентам авторегрессионной модели (см. рис. 5.16 в главе 5), а сигнал ошибки дает оценку белого шума, возбуждающего эту модель.

Подавление шума

Пусть нам необходимо обеспечить системой речевой связи пилота самолета или, скажем, водителя трактора. При этом воспринимаемый микрофоном речевой сигнал неизбежно окажется сильно зашумленным звуками работающего двигателя и т. п. Мы не можем избавиться от этих шумов, но можем получить образец шумового сигнала, установив второй микрофон в непосредственной близости от двигателя или иного источника шумов. Разумеется, этот шум нельзя просто вычесть из речевого сигнала, поскольку по дороге до двух микрофонов шум следует разными путями и, следовательно, претерпевает разные искажения (рис. 9.6). Однако шумовые случайные процессы, воспринимаемые двумя микрофонами, будут коррелированными, т. к. они происходят из общего источника. В то же время, очевидно, что шумовой сигнал не коррелирован с полезным речевым сигналом.

|

Источник |

||||

|

сигнала |

||||

|

Датчик |

Образец |

|||

|

Путь 1 |

сигнала |

|||

|

Сигнал |

||||

|

Источник |

Вход Адаптивный ошибки |

Очищенный от шумов |

||

|

шума |

Путь 2 |

фильтр |

речевой сигнал |

|

|

Датчик |

||||

|

шума |

Рис. 9.6. Подавление шума с помощью адаптивного фильтра

С помощью адаптивного фильтра в данном случае решается задача прямой идентификации преобразований шума на пути к сигнальному микрофону. Входным сигналом адаптивного фильтра является шумовой сигнал от дополнительного микрофона (на рис. 9.6 он обозначен как датчик шума), а в качестве образцового сигнала используется сигнально-шумовая смесь, воспринимаемая основным микрофоном (на рис. 9.6 — датчик сигнала).

Адаптивный фильтр стремится преобразовать входной сигнал так, чтобы сделать его как можно ближе (в смысле среднеквадратической ошибки) к образцовому. Поскольку с входным сигналом фильтра коррелирована лишь шумовая составляющая образцового сигнала, после завершения процесса адаптации на выходе фильтра будет получена оценка шума, присутствующего в образцовом сигнале. Сигнал ошиб-

ки, рассчитываемый как разность между образцовым сигналом и выходным сигналом адаптивного фильтра, будет в этом случае представлять собой очищенный от шума речевой сигнал.

Система речевой связи не является единственно возможным объектом применения рассматриваемой системы шумоподавления. Возможны и иные области использования данной идеи.

Выравнивание частотной характеристики канала связи

При передаче по каналу связи информационный сигнал неизбежно претерпевает некоторые искажения. В системах цифровой связи эти искажения могут привести к возникновению ошибок при приеме данных. Для устранения этих ошибок (или, во всяком случае, уменьшения их числа) необходимо компенсировать влияние канала связи, т. е. решить задачу обратной идентификации (см. рис. 9.4, б). В частотной области компенсация вносимых каналом искажений означает выравнивание (equalization) его частотной характеристики, поэтому фильтры, выполняющие такое выравнивание, получили название эквалайзеров (equalizer).

При использовании адаптивного фильтра в качестве эквалайзера возникает проблема получения образцового сигнала. Эта проблема решается путем передачи специального настроечного сигнала перед началом передачи данных. В качестве такого настроечного сигнала обычно используется псевдослучайная последовательность символов. Алгоритм формирования этого сигнала известен приемной стороне, поэтому образцовый сигнал может быть сгенерирован автономно и использован для обучения адаптивного фильтра. Этот режим работы называется режимом обучения (training mode) (рис. 9.7).

|

Выбор |

|||||||||||||

|

Вход |

Адаптивный |

Выход |

ближайшей |

||||||||||

|

фильтр |

точки |

||||||||||||

|

созвездия |

|||||||||||||

|

Образец |

|||||||||||||

|

Режим |

Режим |

||||||||||||

|

обучения |

оценивания |

||||||||||||

|

Генератор |

|||||||||||||

|

настроечного |

|||||||||||||

|

сигнала |

Рис. 9.7. Выравнивание частотной характеристики канала связи с помощью адаптивного фильтра

После окончания настроечного сигнала начинается собственно передача данных. Приемник при этом переключается в другой режим, называемый режимом оценивания (decision-directed mode). В этом режиме для получения образцового сигнала используется тот факт, что множество возможных значений сигнала в системе цифровой связи является конечным. После приема очередного отсчета (или целого фрагмента сигнала) ищется ближайшее к принятому сигналу допустимое значение.

Оно используется в качестве образцового сигнала, а разность между этим значением и принятым сигналом дает сигнал ошибки, используемый для адаптации. На рис. 9.8 это иллюстрируется применительно к 16-позиционной квадратурной модуляции.

Im

Принятый сигнал

Сигнал ошибки

Re

Ближайшее допустимое значение выбирается в качестве образцового сигнала

Рис. 9.8. Формирование образцового сигнала и сигнала ошибки в режиме оценивания

Если после настройки эквалайзера, произведенной в режиме обучения, уровень шумов на выходе фильтра оказывается таким, что ближайшая допустимая точка в большинстве случаев оказывается правильной (т. е. если вероятность ошибки мала), адаптивный алгоритм сохраняет стабильность.

ЗАМЕЧАНИЕ

В некоторых, в частности многопользовательских, системах связи передавать настроечный сигнал не представляется возможным. В этом случае может использоваться слепая (blind) адаптация, рассмотрение которой выходит за рамки данной книги. Некоторые алгоритмы слепой адаптации приведены в [35].

Эхоподавление

Данная технология, так же как и выравнивание канала связи, широко используется в современных модемах. Скоростные модемы для телефонных линий связи работают в дуплексном режиме, т. е. передают и принимают данные одновременно, при этом для передачи и приема используется одна и та же полоса частот. Однако сигнал собственного передатчика в данном случае неизбежно просачивается в приемник, мешая работе последнего. Просачивающийся сигнал может распространяться разными путями, приобретая при этом не известные заранее искажения (рис. 9.9).

Подавить эхо-сигнал можно с помощью адаптивного фильтра. При этом решается задача прямой идентификации тракта распространения эхо. На вход адаптивного фильтра поступает сигнал передатчика модема, а в качестве образцового сигнала используется принимаемый сигнал, содержащий эхо (рис. 9.10). Адаптивный фильтр формирует оценку эхо-сигнала, а сигнал ошибки представляет собой принимаемый сигнал, очищенный от эха.

Для правильной работы системы эхоподавления необходимо, чтобы передаваемый и принимаемый сигналы были некоррелированы. Для обеспечения некоррелиро-

ванности входные данные, поступающие в модем для передачи, прежде всего подвергаются скремблированию (scrambling), т. е. преобразуются в псевдослучайный битовый поток. При этом два взаимодействующих модема используют разные скремблеры, что и обеспечивает некоррелированность передаваемых ими сигналов.

Эхоподавление, осуществляемое согласно схеме рис. 9.10, используется во всех современных модемах.

|

Абонентская линия Цифровой канал связи Абонентская линия |

||||||||||||||||||||||||||||||||||

|

между АТС |

||||||||||||||||||||||||||||||||||

|

Передатчик |

Передатчик |

|||||||||||||||||||||||||||||||||

|

Приемник |

Приемник |

|||||||||||||||||||||||||||||||||

|

Пути прохождения эхо-сигнала |

Удаленный модем |

|||||||||||||||||||||||||||||||||

|

Рис. 9.9. Формирование эхо-сигнала |

||||||||||||||||||||||||||||||||||

|

Передатчик |

||||||||||||||||||||||||||||||||||

|

Вход |

Адаптивный |

Образец |

Линия |

|||||||||||||||||||||||||||||||

|

фильтр |

связи |

|||||||||||||||||||||||||||||||||

|

Приемник |

Сигнал ошибки |

Сигнал + эхо |

||||||||||||||||||||||||||||||||

Рис. 9.10. Эхоподавление, осуществляемое с помощью адаптивного фильтра

Объекты адаптивной фильтрации пакета Filter Design

В версии 4.7 пакета Filter Design (R2010a) адаптивные фильтры реализованы только в виде объектов MATLAB, а существовавшие ранее функции адаптивной фильтрации не только объявлены устаревшими, но и удалены.

Общие сведения об использовании объектов в MATLAB были приведены в главе 4. Для создания объекта адаптивного фильтра служит функция adaptfilt. При ее вызове необходимо указать требуемый алгоритм адаптивной фильтрации — для этого после имени функции ставится точка и указывается соответствующий идентификатор метода (конструктора):

ha = adaptfilt.algorithm(…)

В настоящее время в пакете Filter Design реализовано около тридцати разновидностей алгоритмов адаптивной фильтрации. К сожалению, автору неизвестен источник на русском языке, который содержал бы обзор этих алгоритмов. При наличии доступа к зарубежным книгам и журналам можно рекомендовать статьи, ссылки на

которые имеются в справочной системе MATLAB, а также литературу, упомянутую в начале этой главы.

Полный список реализованных алгоритмов адаптивной фильтрации и имена соответствующих конструкторов объектов adaptfilt приведены в табл. 9.1.

|

Таблица 9.1. Свойства объектов адаптивных фильтров |

|

|

Конструктор |

Алгоритм |

|

Семейство алгоритмов LMS |

|

|

adaptfilt.adjlms |

Сопряженный (adjoint) LMS-алгоритм |

|

adaptfilt.blms |

Блоковый LMS-алгоритм |

|

adaptfilt.blmsfft |

Блоковый LMS-алгоритм, реализованный в частотной области |

|

с применением БПФ |

|

|

adaptfilt.dlms |

LMS-алгоритм с задержкой обновления коэффициентов фильтра |

|

adaptfilt.filtxlms |

LMS-алгоритм с дополнительной фильтрацией выходного сигнала |

|

фильтра перед формированием сигнала ошибки (filtered-x LMS) |

|

|

adaptfilt.lms |

«Классический» LMS-алгоритм (см. формулу (9.14)) |

|

adaptfilt.nlms |

Нормированный LMS-алгоритм (расчет шага μ на каждом такте осу- |

|

ществляется автоматически по формуле (9.16) исходя из энергии |

|

|

фрагмента сигнала, содержащегося в линии задержки фильтра) |

|

|

adaptfilt.sd |

LMS-алгоритм с использованием для адаптации только знака дан- |

|

ных, содержащихся в линии задержки фильтра (sign-data; вместо x(k) |

|

|

в формуле (9.14) используется sign(x(k))) |

|

|

adaptfilt.se |

LMS-алгоритм с использованием для адаптации только знака сигнала |

|

ошибки (sign-error; вместо e(k) в формуле (9.14) используется |

|

|

sign(e(k))) |

|

|

adaptfilt.ss |

LMS-алгоритм с использованием для адаптации только знаков сиг- |

|

нала ошибки и данных, содержащихся в линии задержки фильтра |

|

|

(sign-sign; комбинация двух предыдущих вариантов) |

|

|

Семейство алгоритмов RLS |

|

|

adaptfilt.ftf |

Быстрый RLS-алгоритм |

|

adaptfilt.hrls |

RLS-алгоритм с использованием преобразования Хаусхолдера |

|

adaptfilt.hswrls |

RLS-алгоритм со скользящим окном и использованием преобразова- |

|

ния Хаусхолдера |

|

|

adaptfilt.qrdrls |

RLS-алгоритм с использованием QR-разложения матрицы |

|

adaptfilt.rls |

«Классический» RLS-алгоритм, в том числе с экспоненциальным |

|

забыванием данных |

|

|

adaptfilt.swftf |

Быстрый RLS-алгоритм со скользящим окном |

|

adaptfilt.swrls |

RLS-алгоритм со скользящим окном |

|

Адаптивные фильтры |

613 |

|

|

Таблица 9.1 (окончание) |

||

|

Конструктор |

Алгоритм |

|

|

Алгоритмы, основанные на методе аффинных проекций |

||

|

adaptfilt.ap |

Метод аффинных проекций с прямым обращением матрицы |

|

|

adaptfilt.apru |

Метод аффинных проекций с рекурсивным обновлением обратной |

|

|

матрицы |

||

|

adaptfilt.bap |

Блоковый алгоритм аффинных проекций |

|

|

Алгоритмы адаптации, работающие в частотной области |

||

|

adaptfilt.fdaf |

LMS-алгоритм в частотной области с индивидуальной нормировкой |

|

|

размера шага в каждом частотном канале (frequency domain adaptive |

||

|

filter, FDAF) |

||

|

adaptfilt.pbfdaf |

Нормированный LMS-алгоритм в частотной области, использующий |

|

|

деление сигнала на блоки малого размера во временной области |

||

|

(partitioned block frequency domain adaptive filter, PBFDAF) |

||

|

adaptfilt.pbufdaf |

Нормированный LMS-алгоритм в частотной области, использующий |

|

|

деление сигнала на блоки малого размера во временной области, без |

||

|

ограничения длины эквивалентной импульсной характеристики |

||

|

(partitioned block unconstrained frequency domain adaptive filter, |

||

|

PBUFDAF) |

||

|

adaptfilt.tdafdct |

Адаптивный фильтр, использующий LMS-алгоритм после предвари- |

|

|

тельного применения к входному сигналу дискретного косинусного |

||

|

преобразования |

||

|

adaptfilt.tdafdft |

Адаптивный фильтр, использующий LMS-алгоритм после предвари- |

|

|

тельного применения к входному сигналу дискретного преобразова- |

||

|

ния Фурье |

||

|

adaptfilt.ufdaf |

Нормированный LMS-алгоритм в частотной области без ограничения |

|

|

длины эквивалентной импульсной характеристики (unconstrained |

||

|

frequency domain adaptive filter, UFDAF) |

||

|

Адаптивные алгоритмы для решетчатых фильтров |

||

|

adaptfilt.gal |

Алгоритм адаптации для решетчатого фильтра, основанный |

|

|

на градиентном спуске (gradient-adaptive lattice, GAL) |

||

|

adaptfilt.lsl |

Алгоритм адаптации для решетчатого фильтра, основанный на |

|

|

рекурсивном методе наименьших квадратов (least squares lattice, LSL) |

||

|

adaptfilt.qrdlsl |

Вариант алгоритма LSL, использующий QR-разложение матрицы |

|

Набор входных параметров конструктора зависит от реализуемого алгоритма. Рассмотрим более подробно использование объектов адаптивных фильтров для тех алгоритмов, которые были ранее описаны в этой главе. Вызов конструкторов для них имеет следующий вид:

ha = adaptfilt.lms(L, step, leakage, coeffs, states)

ha = adaptfilt.nlms(L, step, leakage, offset, coeffs, states) ha = adaptfilt.sd(L, step, leakage, coeffs, states)

ha = adaptfilt.se(L, step, leakage, coeffs, states) ha = adaptfilt.ss(L, step, leakage, coeffs, states) ha = adaptfilt.rls(L, lambda, invcov, coeffs, states)

Назначение входных параметров расшифровано в табл. 9.2. Там же приведены и значения по умолчанию, которые имеются для всех параметров конструкторов.

Таблица 9.2. Параметры конструкторов рассматриваемых адаптивных фильтров

|

Параметр |

Назначение |

Имеет смысл |

|

|

для |

|||

|

L |

Длина фильтра (напомним, что это значение на единицу |

всех алгоритмов |

|

|

превышает порядок фильтра). По умолчанию L = 10 |

|||

|

coeffs |

Вектор (строка длиной L) начальных значений коэффици- |

всех алгоритмов |

|

|

ентов фильтра. По умолчанию этот вектор заполняется |

|||

|

нулями |

|||

|

states |

Вектор (столбец высотой L-1) начального содержимого |

всех алгоритмов |

|

|

линии задержки фильтра. По умолчанию этот вектор за- |

|||

|

полняется нулями |

|||

|

step |

Размер шага μ. По умолчанию step = 0.1 (в случае норми- |

всех разновид- |

|

|

рованного LMS step = 1) |

ностей LMS |

||

|

leakage |

Коэффициент утечки (в диапазоне 0…1). По умолчанию |

всех разновид- |

|

|

leakage = 1 |

ностей LMS |

||

|

offset |

Константа ε (см. формулу (9.16)). По умолчанию |

нормированного |

|

|

offset = 0 |

LMS |

||

|

lambda |

Коэффициент экспоненциального забывания λ (в диапазоне |

RLS |

|

|

0…1). По умолчанию lambda = 1 |

|||

|

invcov |

Начальное значение оценки обратной корреляционной мат- |

RLS |

|

|

рицы входного сигнала. По умолчанию используется мат- |

|||

|

рица, главная диагональ которой заполнена значением, рав- |

|||

|

ным 1000: invcov = 1000*eye(L) |

|||

ЗАМЕЧАНИЕ

В табл. 9.2 и далее в табл. 9.3 упоминается не рассматривавшийся в теоретической части главы параметр LMS-алгоритма — коэффициент утечки (leakage). Это коэффициент, лежащий в диапазоне от 0 до 1, на который может умножаться старый вектор коэффициентов w(k) в формуле (9.14) для улучшения стабильности алгоритма.

Список свойств объектов адаптивных фильтров для рассматриваемых алгоритмов приведен в табл. 9.3. Считывать и задавать значения этих свойств можно с помощью функций get и set соответственно (см. разд. «Общая информация об объектах MATLAB» главы 4).

|

Адаптивные фильтры |

615 |

|

|

Таблица 9.3. Свойства объектов адаптивных фильтров |

||

|

Имя свойства |

Описание |

|

|

Algorithm |

Строка, содержащая название используемого алгоритма |

|

|

адаптации (только для чтения) |

||

|

FilterLength |

Длина вектора коэффициентов фильтра (напомним, что это |

|

|

значение на единицу превышает порядок фильтра) |

||

|

Coefficients |

Вектор коэффициентов фильтра |

|

|

States |

Содержимое линии задержки фильтра |

|

|

PersistentMemory |

Данное свойство может принимать логические значения true |

|

|

(включено) и false (выключено). При включении данного |

||

|

режима (принято по умолчанию) перед каждой операцией |

||

|

фильтрации (метод filter) производится сброс фильтра |

||

|

в исходное состояние. При выключении данного режима |

||

|

текущее состояние фильтра сохраняется, что позволяет орга- |

||

|

низовать блоковую обработку сигнала |

||

|

NumSamplesProcessed |

Число обработанных отсчетов сигнала (только для чтения) |

|

|

StepSize (для всех вариантов |

Размер шага μ |

|

|

алгоритма LMS) |

||

|

Leakage (для всех вариантов |

Коэффициент утечки (в диапазоне 0…1, по умолчанию |

|

|

алгоритма LMS) |

равен 1) |

|

|

Offset (для алгоритма nlms) |

Константа ε (см. формулу (9.16)) |

|

|

ForgettingFactor |

Коэффициент забывания λ (в диапазоне 0…1, по умолча- |

|

|

(для алгоритма RLS) |

нию 1) |

|

|

KalmanGain |

Вектор коэффициентов усиления K (см. формулу (9.28); |

|

|

(для алгоритма RLS) |

только для чтения) |

|

|

InvCov (для алгоритма RLS) |

Оценка обратной корреляционной матрицы P |

|

Обработка сигнала адаптивным фильтром осуществляется с помощью функции

filter:

[y, e] = filter(ha, x, d)

Здесь ha — объект адаптивного фильтра, x — вектор отсчетов входного сигнала, d — вектор отсчетов образцового сигнала. Результатами работы функции являются векторы отсчетов выходного сигнала y и сигнала ошибки фильтрации e.

Как показывает синтаксис вызова функции фильтрации, образцовый сигнал должен быть известен заранее, что делает невозможным применение данных функций в режиме адаптации по оценке сигнала (decision-directed mode). Кроме того, реализация данной функции подразумевает на каждом временном такте сдвиг данных

влинии задержки фильтра на один отсчет. Это затрудняет применение объектов

втех ситуациях, когда данные обновляются иным образом (это имеет место, например, в так называемых дробных (fractionally-spaced equalizer) эквалайзерах).

Требуемое обновление можно реализовать путем осуществления поотсчетной обработки с ручной коррекцией состояния линии задержки, но такой код будет громоздким, медленным и надуманным.

ЗАМЕЧАНИЕ

Возможность адаптации по оценке сигнала реализована в пакете расширения Communications Toolbox, где для этого имеются специальные объекты эквалайзеров.

С объектами адаптивных фильтров можно использовать многие методы, описанные в главе 4 применительно к объектам класса dfilt. Поскольку адаптивный фильтр является системой с переменными параметрами, эти методы дают результаты, соответствующие текущему состоянию фильтра.

Аналогичным образом объекты адаптивных фильтров поддерживаются и визуализатором фильтров FVTool:

fvtool(ha)

К методам, специфическим именно для адаптивных фильтров, относятся три функции, перечисленные далее:

[mumax, mumaxmse] = maxstep(ha, x) — данная функция производит оценку максимально допустимой величины размера шага µ для объекта адаптивного фильтра ha (функция применима для следующих вариантов алгоритма LMS: lms, nlms, blms, blmsfft, se). Входной параметр x — пример возможного входного сигнала фильтра (для алгоритма nlms задавать этот параметр не нужно). Этот параметр может быть матрицей, тогда ее столбцы рассматриваются как различные реализации входного случайного сигнала. Выходной параметр mumax — предельная величина µ, при которой обеспечивается сходимость алгоритма в среднем (см. формулу (9.12)), выходной параметр mumaxmse — предельная величина µ, при которой обеспечивается сходимость алгоритма в среднем квадрате (см. формулу (9.15));

[mmse, emse, meanw, mse, tracek] = msepred(ha, x, d, m) — данная функция

производит оценку среднего квадрата ошибки фильтрации для объекта адаптивного фильтра ha (функция применима для следующих вариантов алгоритма LMS: lms, nlms, blms, blmsfft, se). Входные параметры x и d — векторы отсчетов входного и образцового сигнала соответственно. Выходные параметры: mmse — средний квадрат ошибки фильтрации в установившемся режиме, emse — избыточная ошибка фильтрации (см. формулу (9.17)), meanw — матрица предсказанных математических ожиданий коэффициентов фильтра для всех моментов времени, mse — вектор зависимости среднего квадрата ошибки от времени, tracek — вектор зависимости от времени для суммарного квадратичного отклонения коэффициентов фильтра от оптимальных. При расчете трех последних выходных параметров может производиться прореживание по времени с коэффициентом m (по умолчанию m = 1);

[mse, meanw, w, tracek] = msesim(ha, x, d, m) — данная функция по назначе-

нию аналогична предыдущей, но измерение среднего квадрата ошибки производится путем моделирования, без использования теоретических оценок. Поэтому

функция применима к любым объектам адаптивных фильтров, работающих во временной области, независимо от используемых ими алгоритмов адаптации. Производимое моделирование предполагает усреднение по ансамблю реализаций, поэтому входные параметры x и d должны быть матрицами, столбцы которых содержат отдельные реализации входного и образцового сигналов соответственно. Выходной параметр w представляет собой вектор финальных значений коэффициентов фильтра. Остальные входные и выходные параметры совпадают по назначению с одноименными параметрами функции msepred.

Примеры реализации адаптивной фильтрации

Приведем несколько примеров, показывающих, как различные задачи, рассмотренные ранее в разд. «Применение адаптивных фильтров» этой главы, могут быть смоделированы с использованием объектов адаптивных фильтров из пакета Filter Design.

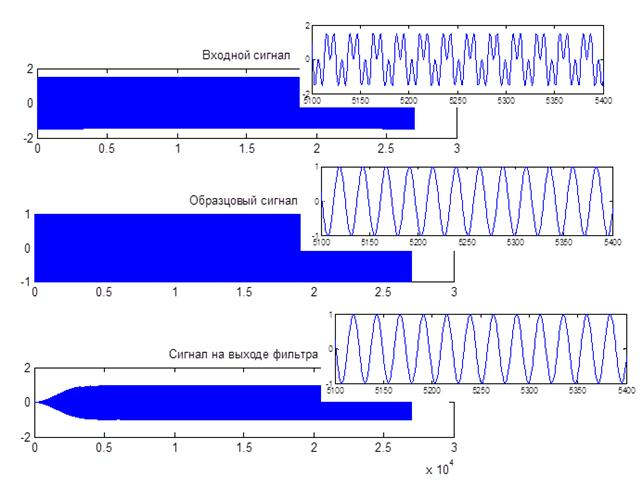

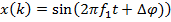

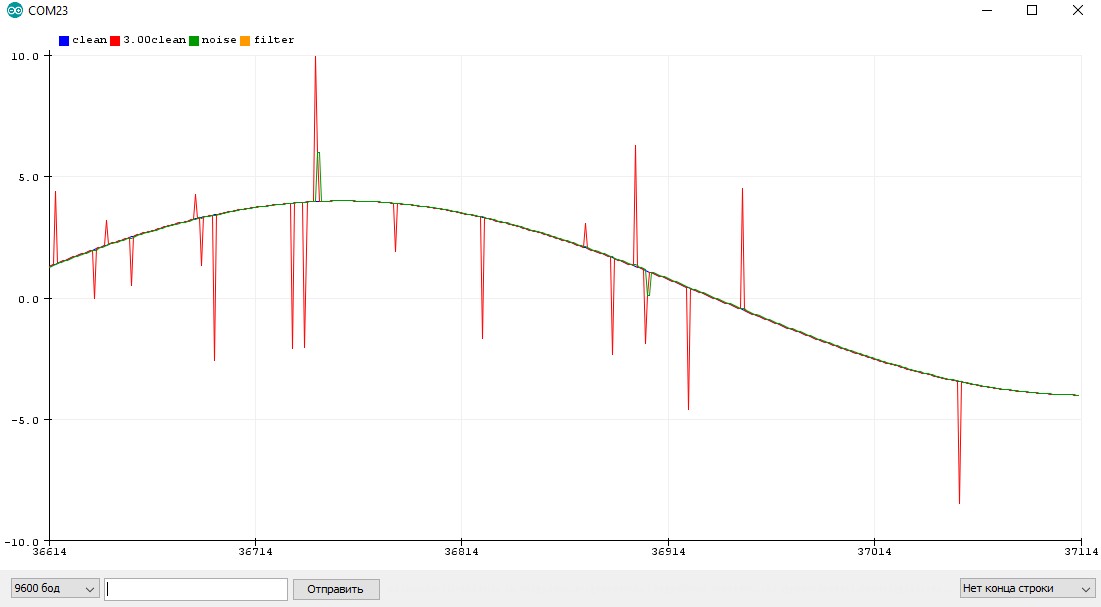

Идентификация системы

В данном примере мы реализуем решение задачи прямой идентификации системы согласно рис. 9.4, а. Входным сигналом системы будет служить дискретный белый гауссов шум, а сама система будет представлять собой нерекурсивный фильтр 31-го порядка с импульсной характеристикой в виде экспоненциально затухающей синусоиды, на период колебаний которой приходится 4 отсчета. Кроме того, после обработки половины входного сигнала параметры системы скачкообразно изменятся — у ее импульсной характеристики поменяется знак. Это позволит нам посмотреть на то, как реагируют алгоритмы LMS и RLS на резкое изменение статистических свойств обрабатываемого сигнала. Итак, формируем входной и выходной сигналы идентифицируемой системы:

>>x = randn(2000, 1); % дискретный белый гауссов шум

>>t = 0:31;

>>b = exp(-t/5) .* cos(t*pi/2); % импульсная характеристика системы

>>% генерируем первую половину выходного сигнала

>>[y(1:1000), state] = filter(b, 1, x(1:1000));

>>% генерируем вторую половину выходного сигнала

>>y(1001:2000) = filter(-b, 1, x(1001:2000), state);

Далее создадим объекты LMS- и RLS-адаптивных фильтров с помощью соответствующих конструкторов. Для LMS-алгоритма предварительно рассчитаем значение коэффициента µ, выбрав его в два раза меньшим предельного значения, определяемого формулой (9.15), для всех остальных параметров используем значения по умолчанию:

|

>> N = 16; |

% длина фильтров |

>>mu = 1/N/var(y); % расчет размера шага для алгоритма LMS

>>ha_lms = adaptfilt.lms(N, mu); % создание объекта LMS-фильтра

|

>> ha_rls = adaptfilt.rls(N); |

% создание объекта RLS-фильтра |

Теперь реализуем собственно фильтрацию, воспользовавшись функцией filter. В соответствии с рис. 9.4, а входной сигнал адаптивного фильтра совпадает с входным сигналом исследуемой системы (x), а образцовый сигнал — это выходной сигнал системы (y):

>>[y_lms, e_lms] = filter(ha_lms, x, y); % фильтрация LMS-фильтром

>>[y_rls, e_rls] = filter(ha_rls, x, y); % фильтрация RLS-фильтром

Построим для обоих фильтров графики зависимости сигнала ошибки от времени, а также выведем на экран их импульсные характеристики, полученные на момент завершения обработки сигнала (рис. 9.11):

>>subplot(2,2,1)

>>plot(e_lms)

>>title(‘LMS error’)

>>subplot(2,2,2)

>>impz(ha_lms.coefficients)

>>title(‘LMS impulse response’)

>>subplot(2,2,3)

>>plot(e_rls)

>>title(‘RLS error’)

>>subplot(2,2,4)

>>impz(ha_rls.coefficients)

>>title(‘RLS impulse response’)

|

LMS error |

|||||||||||

|

4 |

1 |

||||||||||

|

2 |

0.5 |

||||||||||

|

0 |

|||||||||||

|

0 |

|||||||||||

|

-2 |

|||||||||||

|

-4 |

-0.5 |

||||||||||

|

-6 |

-1 |

||||||||||

|

0 |

200 |

400 |

600 |

800 |

1000 |

1200 |

1400 |

1600 |

1800 |

2000 |

0 |

|

RLS error |

|||||||||||

|

10 |

0.04 |

||||||||||

|

5 |

0.02 |

||||||||||

|

0 |

0 |

||||||||||

|

-5 |

-0.02 |

||||||||||

|

-10 |

-0.04 |

||||||||||

|

0 |

200 |

400 |

600 |

800 |

1000 |

1200 |

1400 |

1600 |

1800 |

2000 |

0 |

LMS impulse response

n (samples) RLS impulse response

Рис. 9.11. Результаты идентификации системы с помощью адаптивных алгоритмов LMS (сверху) и RLS (снизу): слева — зависимость ошибки от времени,

справа — итоговые импульсные характеристики фильтров

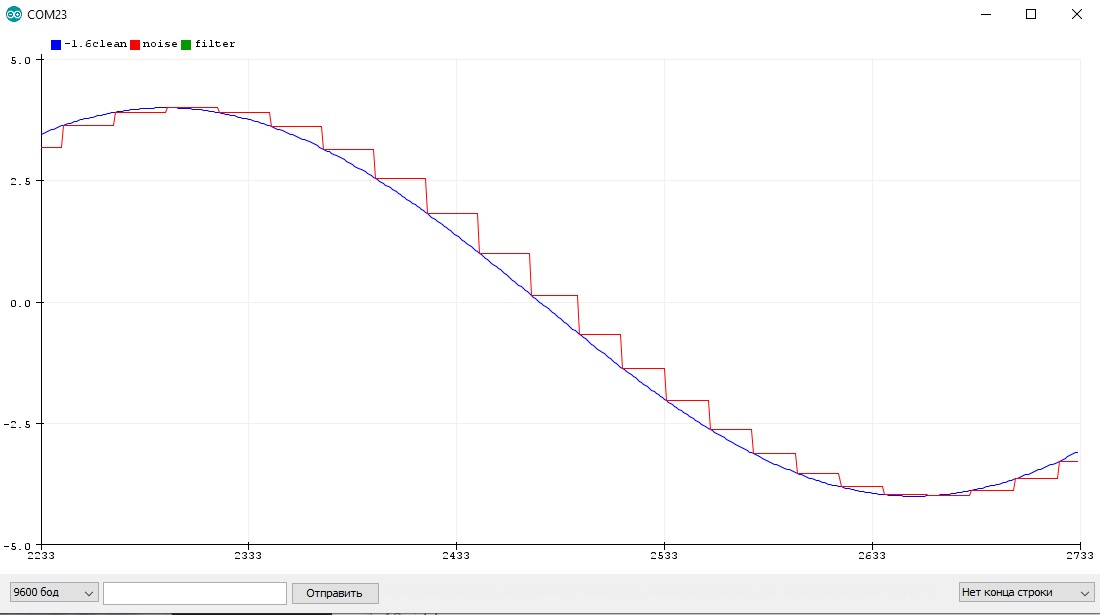

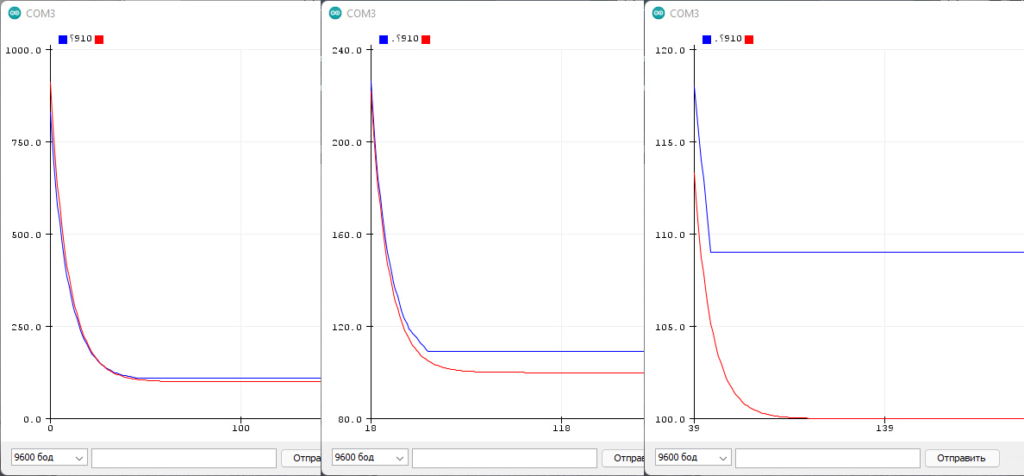

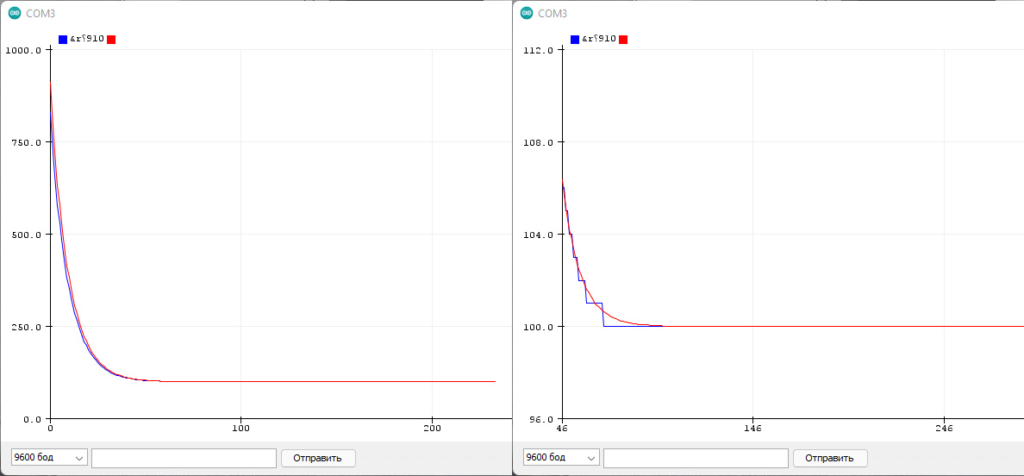

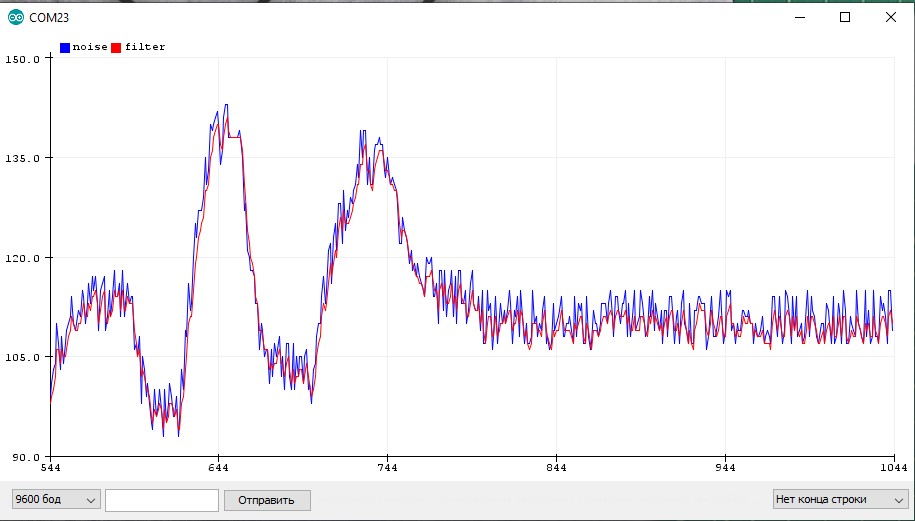

Полученные результаты наглядно демонстрируют основные особенности LMS- и RLS-алгоритмов. На начальном этапе RLS-алгоритм показал отсутствие скольконибудь заметного переходного процесса и меньшую (по сравнению с LMSалгоритмом) ошибку в установившемся режиме. Однако после скачкообразного изменения характеристик системы RLS-алгоритм так и не смог приспособиться

к новым условиям, тогда как LMS-фильтр после некоторого переходного процесса свел ошибку фильтрации к тому же уровню, который она имела раньше.

Сказанному соответствуют и итоговые импульсные характеристики фильтров (см. рис. 9.11, справа) — характеристика LMS-фильтра хорошо совпадает с экспоненциально затухающими колебаниями импульсной характеристики анализируемой системы, а характеристика RLS-фильтра выглядит абсолютно случайным набором значений.

ЗАМЕЧАНИЕ

В данном примере не использовалось экспоненциальное забывание, дающее RLSалгоритму возможность отслеживать изменения статистических свойств обрабатываемого сигнала. Чтобы использовать забывание, полю ForgettingFactor объекта RLS-фильтра в данном примере необходимо присвоить значение, меньшее единицы.

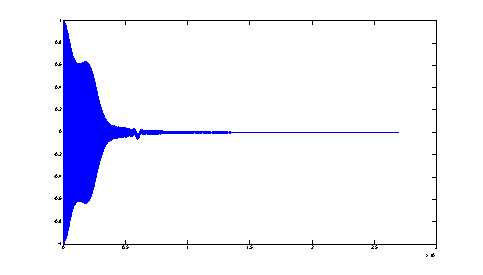

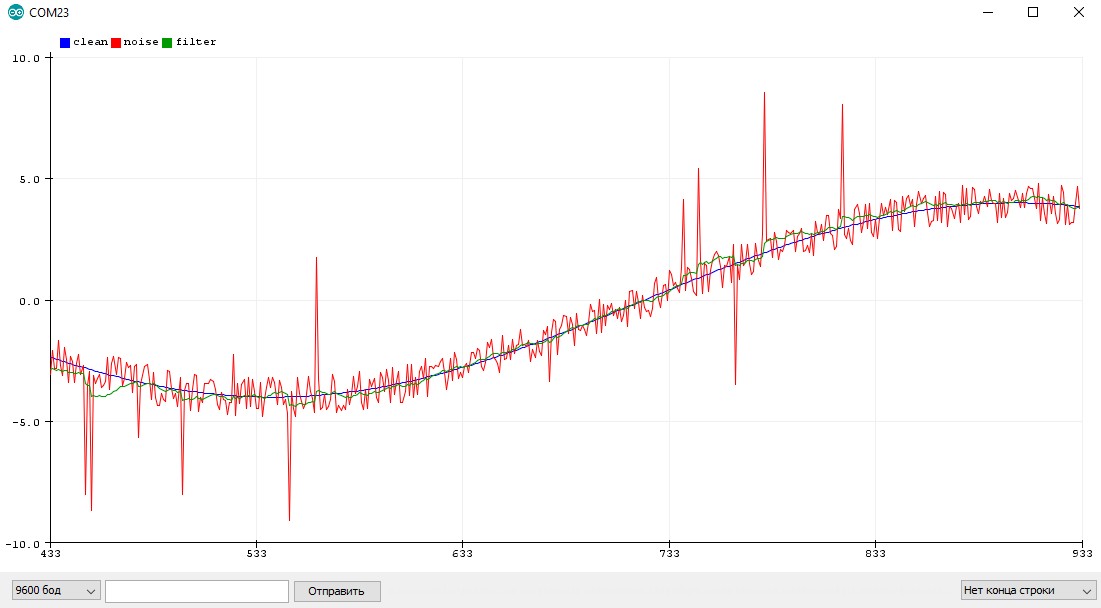

Линейное предсказание

Реализуем с помощью RLS-фильтра линейное предсказание сигнала, сформированного с помощью авторегрессионной модели. В качестве коэффициентов модели используем знаменатель фильтра Баттерворта 8-го порядка с частотой среза, равной 0,3 от частоты Найквиста:

|

>> [b, a] = butter(8, 0.3); |

% фильтр Баттерворта |

|

>> b = 1; |

% оставляем только знаменатель |

|

>> x = randn(1000, 1); |

% входной сигнал АР-модели |

|

>> y = filter(b, a, x); |

% формирование сигнала |

>>ha = adaptfilt.rls(16); % создание RLS-фильтра

>>% линейное предсказание с помощью адаптивного фильтра

>>[y1, e] = filter(ha, y(1:end-1), y(2:end));

>>subplot(2, 2, 1)

|

>> impz(a) |

% коэффициенты АР-модели |

|

>> subplot(2, 2, 2) |

|

|

>> impz(ha.coefficients) |

% имп. х-ка адаптивного фильтра |

|

>> subplot(2, 1, 2) |

|

|

>> plot(e) |

% ошибка фильтрации |

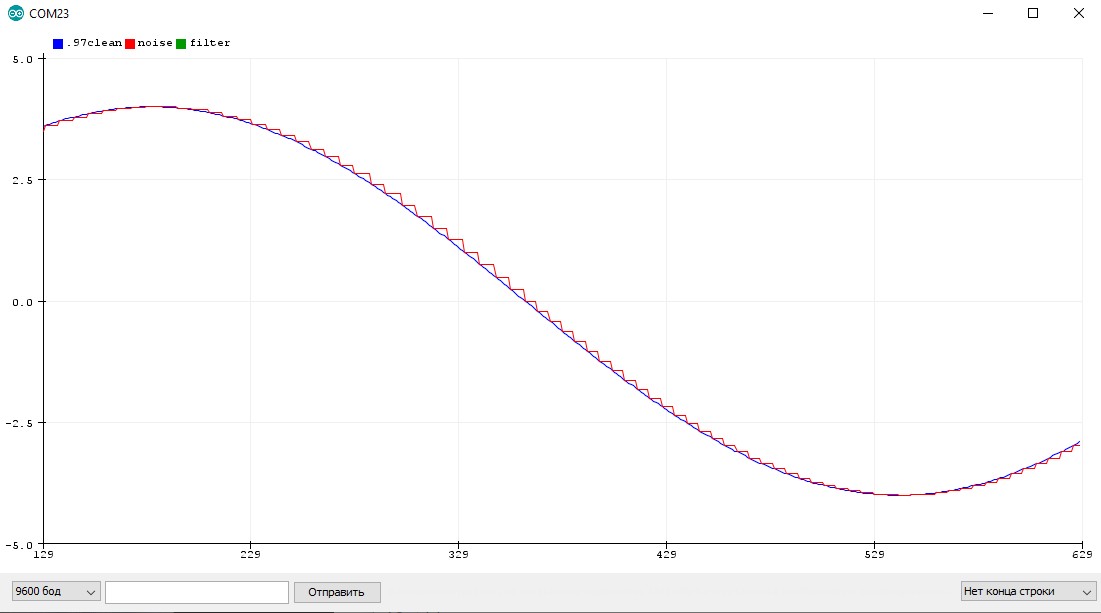

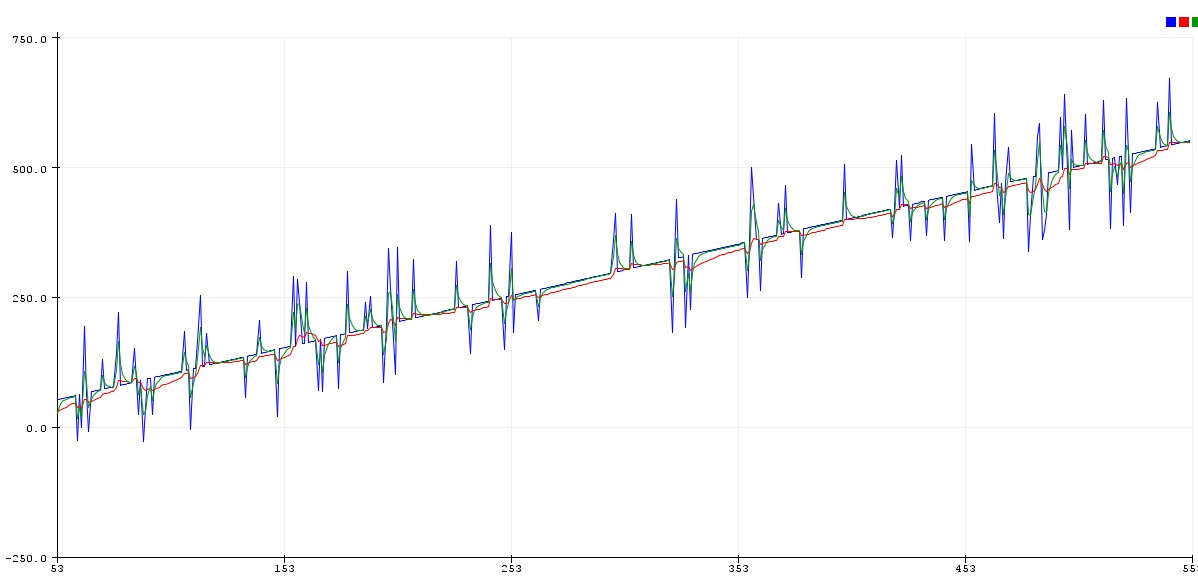

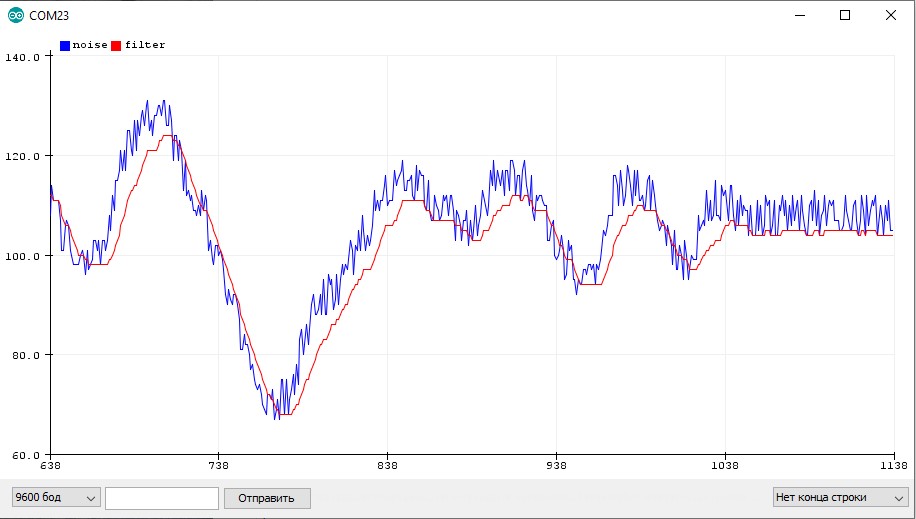

Результаты работы программы показаны на рис. 9.12. Видно, что коэффициенты адаптивного фильтра совпадают с коэффициентами использованной авторегрессионной модели (при сравнении верхних графиков на рис. 9.12 следует учесть, что первый элемент вектора a, равный единице, не входит в число коэффициентов модели; кроме того, коэффициенты модели и коэффициенты предсказывающего фильтра имеют разные знаки (см. рис. 5.13 в главе 5)). На нижнем графике рис. 9.12, демонстрирующем поведение ошибки фильтрации во времени, хорошо видно, что после начального переходного процесса устанавливается стационарный режим работы. Согласно идее линейного предсказания (см. разд. «Авторегрессионная модель» главы 5), сигнал ошибки фильтрации при этом является оценкой белого шума, возбуждающего авторегрессионную модель.

|

620 |

Глава 9 |

|||||||||||||

|

Impulse Response |

Impulse Response |

|||||||||||||

|

10 |

10 |

|||||||||||||

|

5 |

5 |

|||||||||||||

|

0 |

0 |

|||||||||||||

|

-5 |

-5 |

|||||||||||||

|

-10 |

-10 |

|||||||||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

0 |

5 |

10 |

15 |

||

|

n (samples) |

n (samples) |

|||||||||||||

|

20 |

||||||||||||||

|

10 |

||||||||||||||

|

0 |

||||||||||||||

|

-10 |

||||||||||||||

|

-20 |

||||||||||||||

|

0 |

100 |

200 |

300 |

400 |

500 |

600 |

700 |

800 |

900 |

1000 |

||||

|

Рис. 9.12. Линейное предсказание с помощью адаптивного фильтра: |

||||||||||||||

|

сверху — коэффициенты авторегрессионной модели (слева) и итоговая импульсная |

||||||||||||||

|

характеристика адаптивного фильтра (справа), |

||||||||||||||

|

снизу — зависимость ошибки фильтрации от времени |

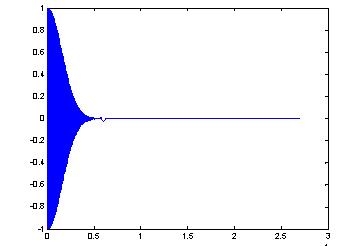

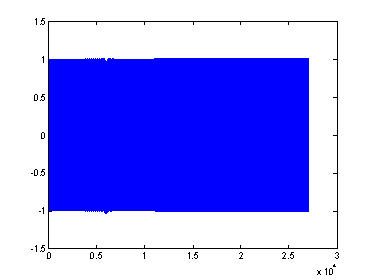

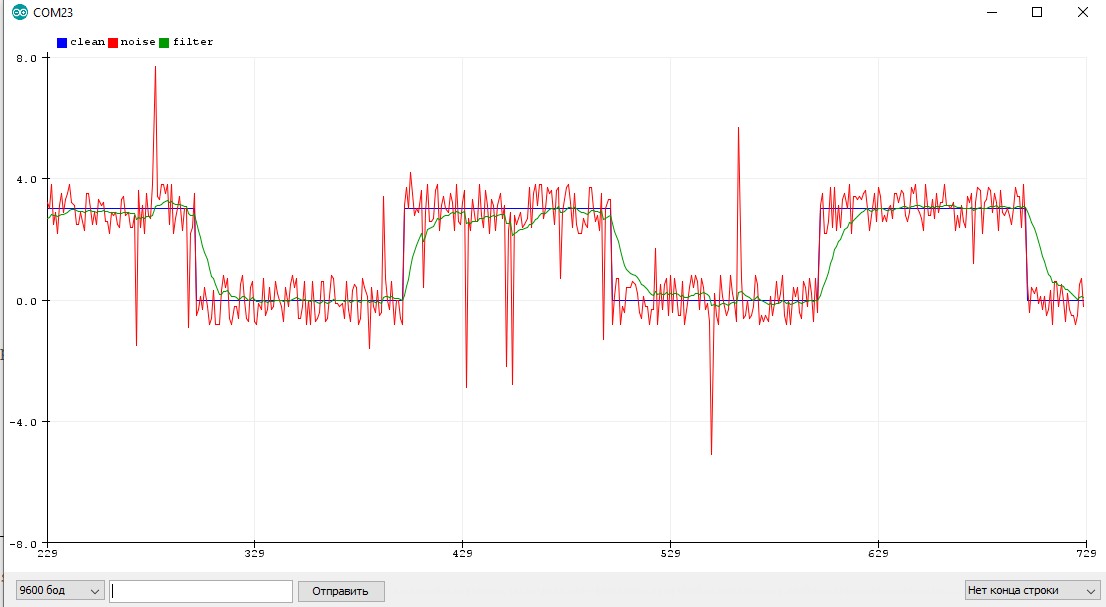

Шумоподавление

Для демонстрации шумоподавления используем входящий в состав поставки MATLAB файл mtlb.mat, в котором содержатся запись произнесенного слова «MATLAB» (переменная mtlb) и частота дискретизации данного сигнала (переменная Fs). Речевой сигнал является очень коротким, поэтому повторим его 10 раз с помощью функции repmat (график одного периода исходного речевого сигнала показан на рис. 9.13, сверху):

|

>> load mtlb |

% загрузка данных |

>>s = repmat(mtlb, 10, 1); % 10-кратное повторение сигнала

>>subplot(3, 1, 1)

>>plot(s(1:length(mtlb))) % график сигнала

Можно также прослушать исходный звук с помощью функции soundsc:

>> soundsc(s, Fs)

Теперь сформируем дискретный белый шум и пропустим его через два фильтра, чтобы получить коррелированные случайные сигналы. В данном эксперименте мы используем нерекурсивные фильтры первого порядка, один из которых будет вычислять сумму, а другой — разность пары соседних отсчетов. Эти фильтры являются простейшими ФНЧ и ФВЧ соответственно:

|

>> noise = randn(length(s), 1); |

% дискретный белый шум |

>>noise1 = filter([1 1], 1, noise); % шум, пропущенный через ФНЧ

>>noise2 = filter([1 -1], 1, noise); % шум, пропущенный через ФВЧ

Шум noise1 мы добавим к речевому сигналу. На графике (см. рис. 9.13, в центре) видно, что полезный сигнал визуально не выделяется над шумом:

>>sn = s + noise1; % добавляем шум к сигналу

>>subplot(3, 1, 2)

>>plot(sn(1:length(mtlb))) % график зашумленного сигнала

Воспроизведение зашумленного звука показывает, что и на слух полезный сигнал разобрать нельзя:

>> soundsc(sn, Fs)

Теперь создадим объект адаптивного фильтра длины 16, использующего алгоритм RLS, и в соответствии с рис. 9.6 подадим на вход фильтра шумовой сигнал noise2, использовав в качестве образцового зашумленный полезный сигнал sn:

>>ha1 = adaptfilt.rls(16);

>>[y, e] = filter(ha1, noise2, sn);

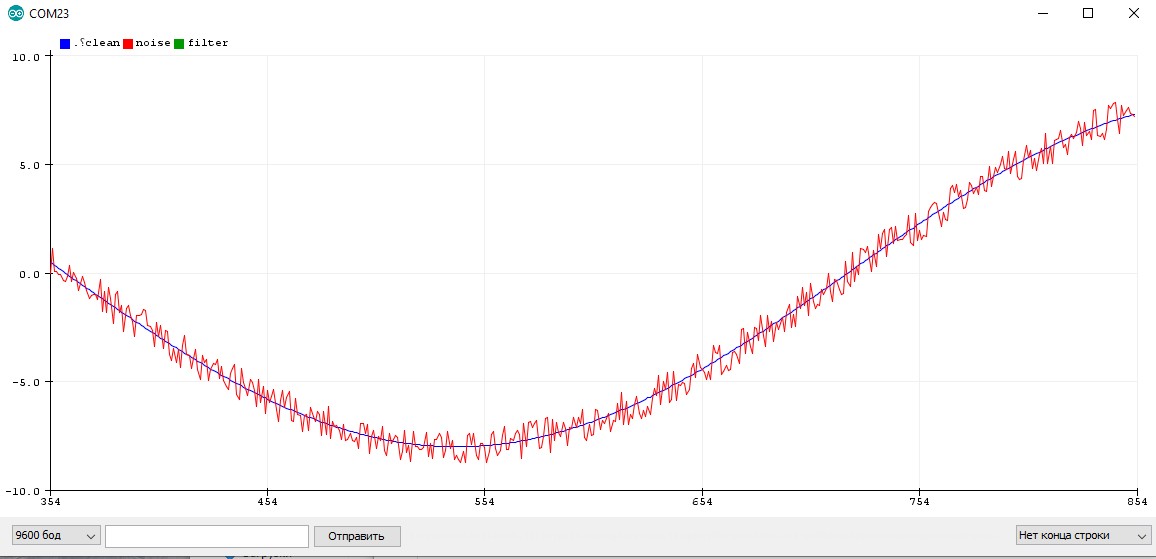

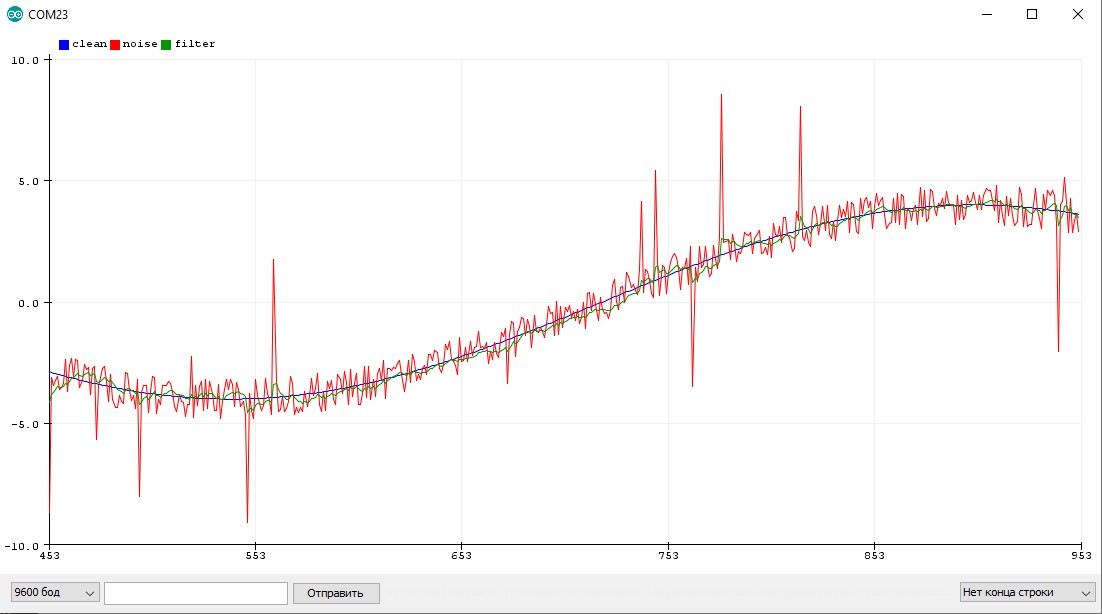

Полученный сигнал ошибки e представляет собой очищенный от шума полезный сигнал (график одного его периода показан на рис. 9.13, снизу):

>>subplot(3, 1, 3)

>>plot(e(1:length(mtlb)))

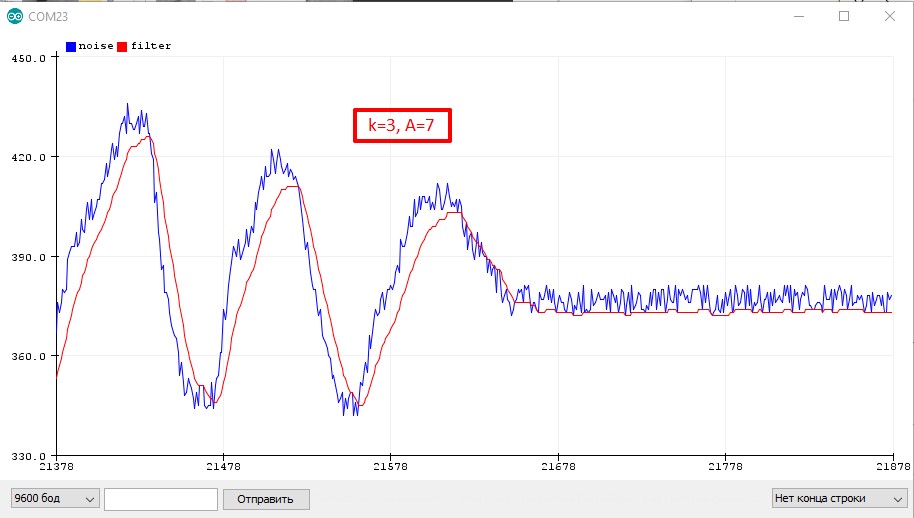

>>ylim([-5 5])

На рисунке хорошо видно, что сигнал ошибки визуально весьма близок к полезному сигналу, показанному на верхнем графике. Воспроизведем получившийся звук:

>> soundsc(e, Fs)

|

Прослушивание показывает, что остаточный шум все равно присутствует, но слова |

|||||||||

|

разбираются без труда. |

|||||||||

|

5 |

|||||||||

|

0 |

|||||||||

|

-5 |

|||||||||

|

0 |

500 |

1000 |

1500 |

2000 |

2500 |

3000 |

3500 |

4000 |

4500 |

|

10 |

|||||||||

|

0 |

|||||||||

|

-10 |

|||||||||

|

0 |

500 |

1000 |

1500 |

2000 |

2500 |

3000 |

3500 |

4000 |

4500 |

|

5 |

|||||||||

|

0 |

|||||||||

|

-5 |

|||||||||

|

0 |

500 |

1000 |

1500 |

2000 |

2500 |

3000 |

3500 |

4000 |

4500 |

Рис. 9.13. Исходный сигнал (сверху), зашумленный сигнал (в центре) и сигнал, очищенный от шума с помощью адаптивного фильтра (снизу)

Завершая рассмотрение данного примера, следует отметить, что сигнал был более чем в четыре раза (более чем на 6 дБ) слабее по мощности, чем шум:

>> 10*log10(var(s)/var(noise1)) % отношение С/Ш в децибелах ans =

-6.6026

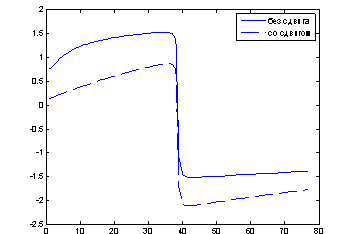

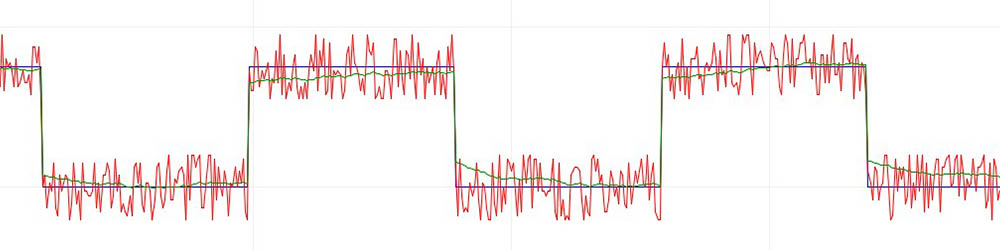

Компенсация искажений, вносимых каналом связи

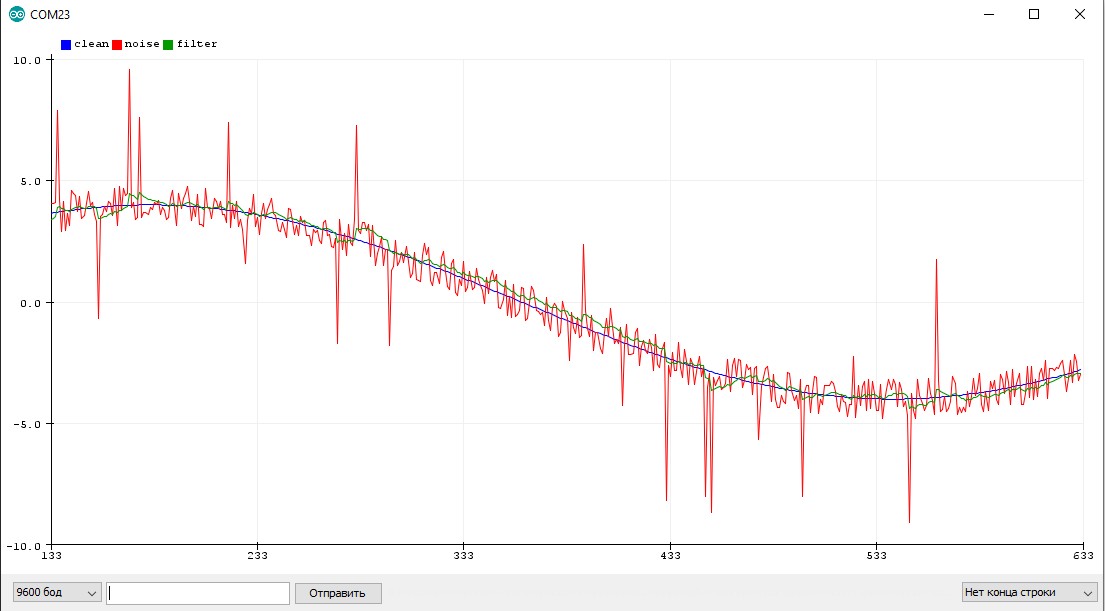

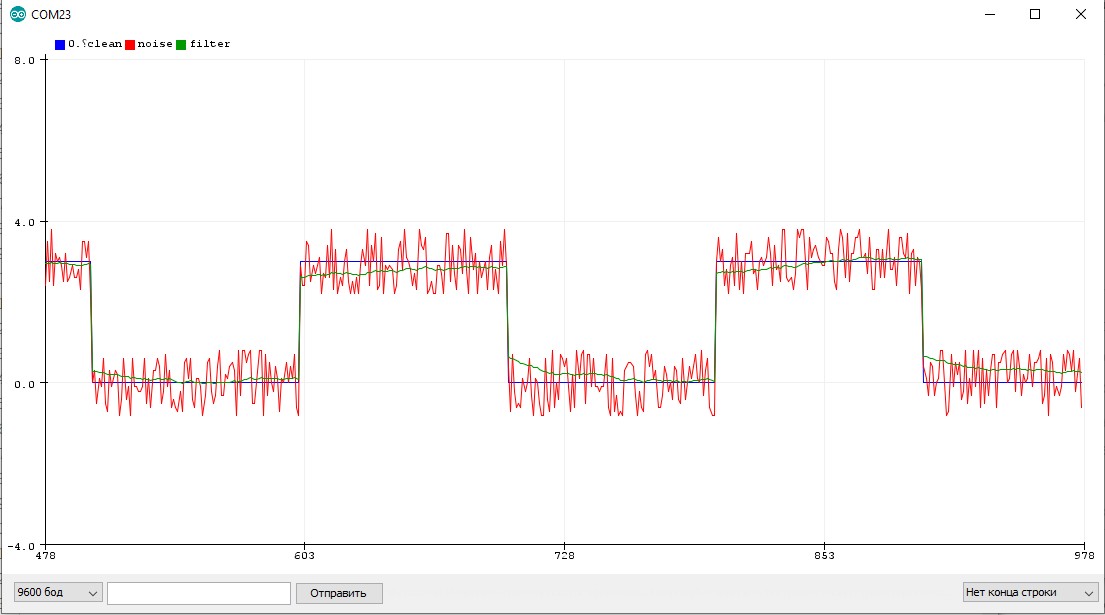

В качестве примера реализуем адаптивную коррекцию искажений, вносимых в сигнал тем же каналом связи, что использовался в примере расчета фильтра Винера. При этом сравним качество работы четырех версий алгоритма LMS — классического варианта и трех вариантов с использованием знаковых преобразований. Чтобы более наглядно показать результат компенсации, в качестве входного используем четырехуровневый цифровой сигнал, равновероятно и независимо принимающий значения –3, –1, 1 и 3. Код соответствующей MATLAB-программы приведен далее.

h = [-2 -4 6 3]; % импульсная характеристика канала связи

|

% генерация сигнала |

||

|

NX = 4000; |

% число отсчетов |

|

|

levels = [-3 -1 1 3]; |

% возможные уровни исходного сигнала |

|

|

x = randsrc(NX, 1, levels); |

% случайный сигнал |

|

|

y = conv(x, h); |

% искаженный сигнал |

|

|

N = 32; |

% длина адаптивного фильтра |

|

|

mu = 1/var(levels, 1)/sum(h.^2)/N; % размер шага для LMS |

||

|

% создание объектов |

||

|

ha_lms |

= adaptfilt.lms(N, mu); |

ha_lms_se = adaptfilt.se(N, mu/10);

ha_lms_sd = adaptfilt.sd(N, mu); ha_lms_ss = adaptfilt.ss(N, mu);

y = y(round(N/2)+1:end); % задержка фильтрации

[x, y] = eqtflength(x, y); % выравнивание длин векторов x и y % адаптивная фильтрация

[x1_lms, e_lms] = filter(ha_lms, y(1:1000), x(1:1000)); [x1_lms_se, e_lms_se] = filter(ha_lms_se, y, x); [x1_lms_sd, e_lms_sd] = filter(ha_lms_sd, y, x); [x1_lms_ss, e_lms_ss] = filter(ha_lms_ss, y, x);

% вывод графиков

subplot(4,2,1), plot(e_lms), title(‘LMS’) subplot(4,2,2), plot(x1_lms,’.’)

subplot(4,2,3), plot(e_lms_se), title(‘LMS — sign error’) subplot(4,2,4), plot(x1_lms_se,’.’)

subplot(4,2,5), plot(e_lms_sd), title(‘LMS — sign data’) subplot(4,2,6), plot(x1_lms_sd,’.’)

subplot(4,2,7), plot(e_lms_ss), title(‘LMS — sign sign’) subplot(4,2,8), plot(x1_lms_ss,’.’)

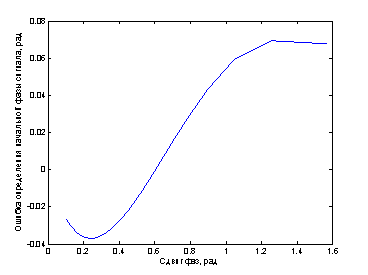

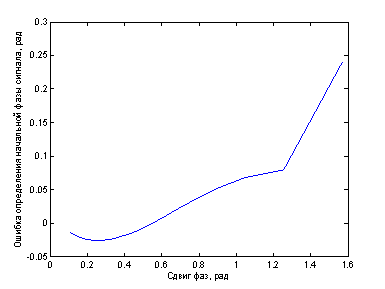

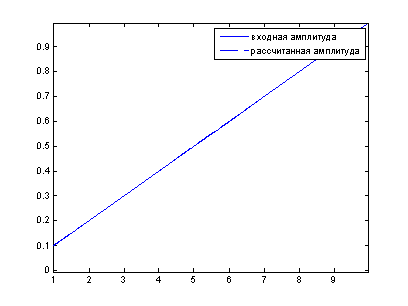

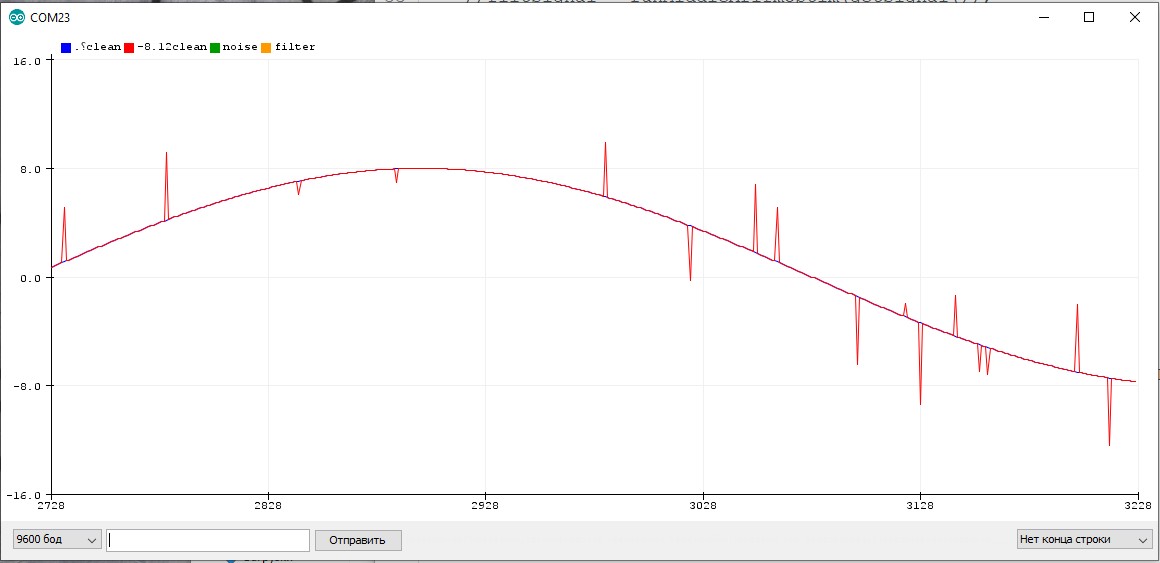

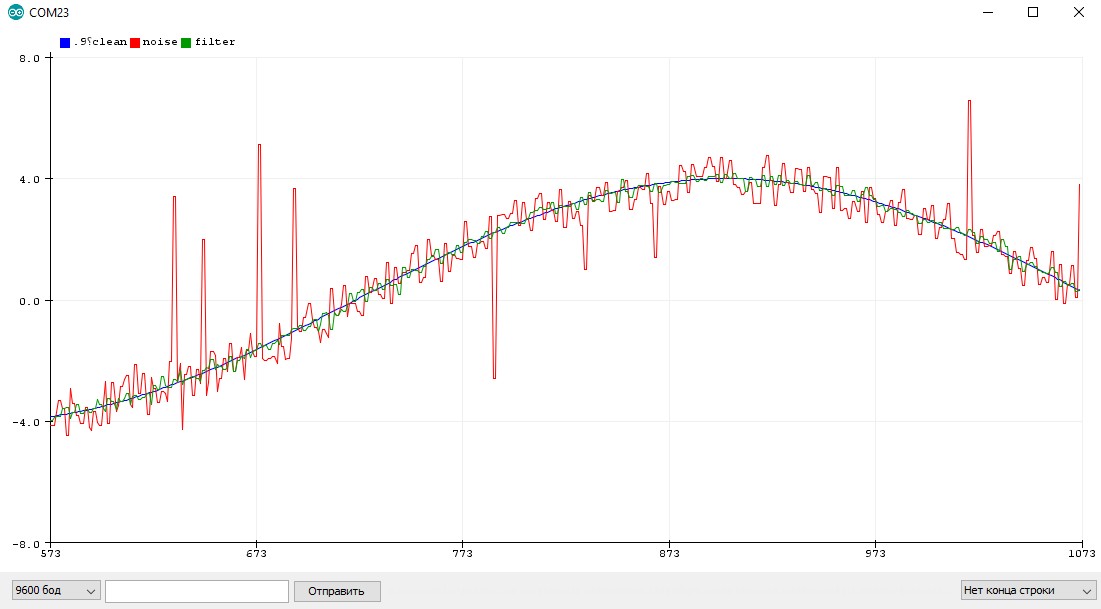

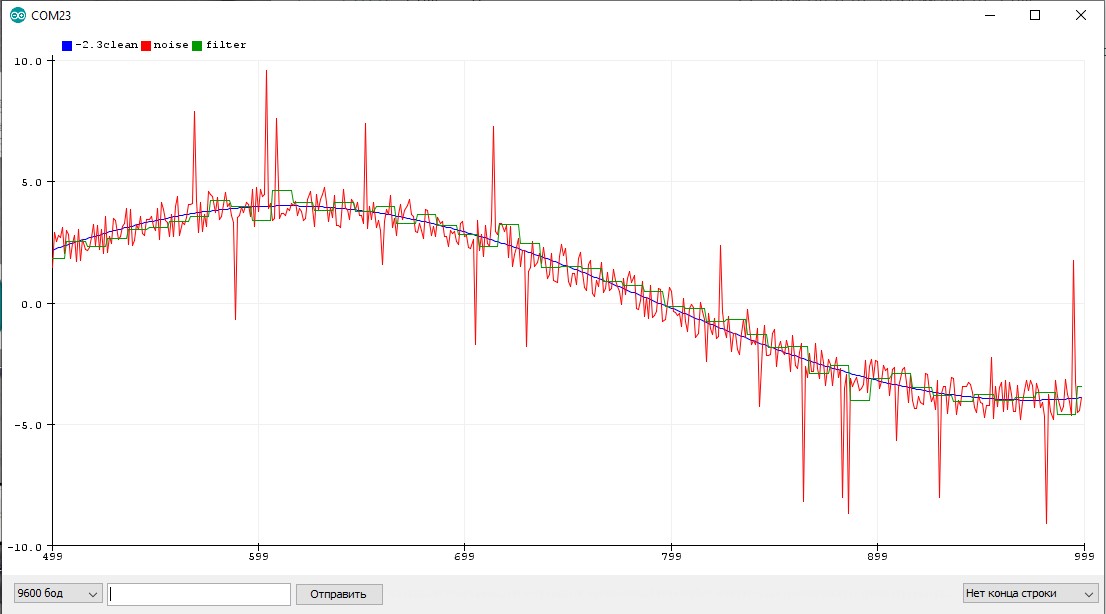

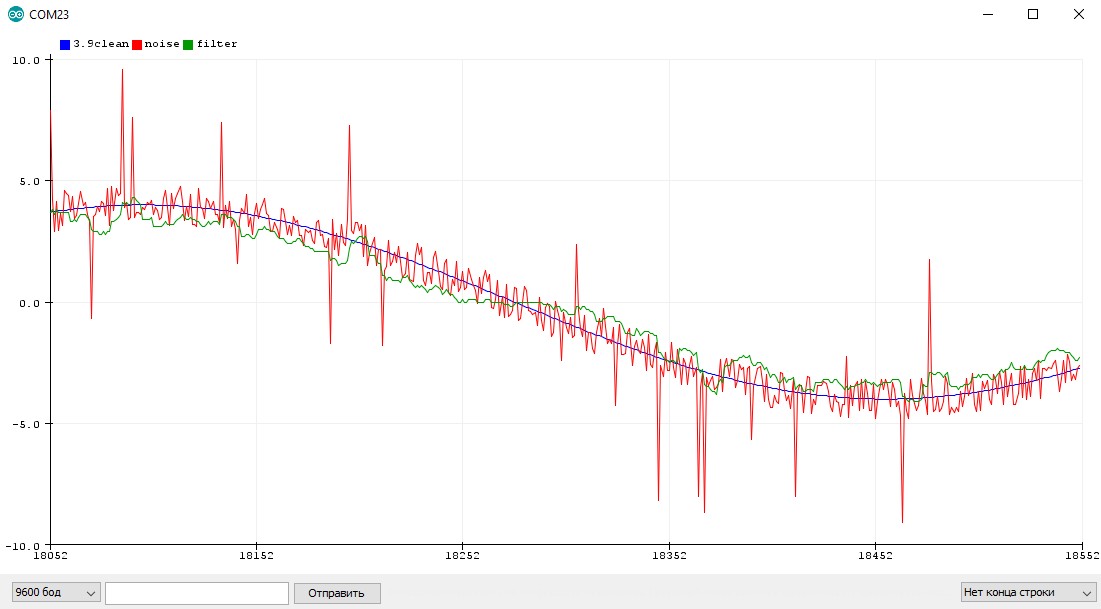

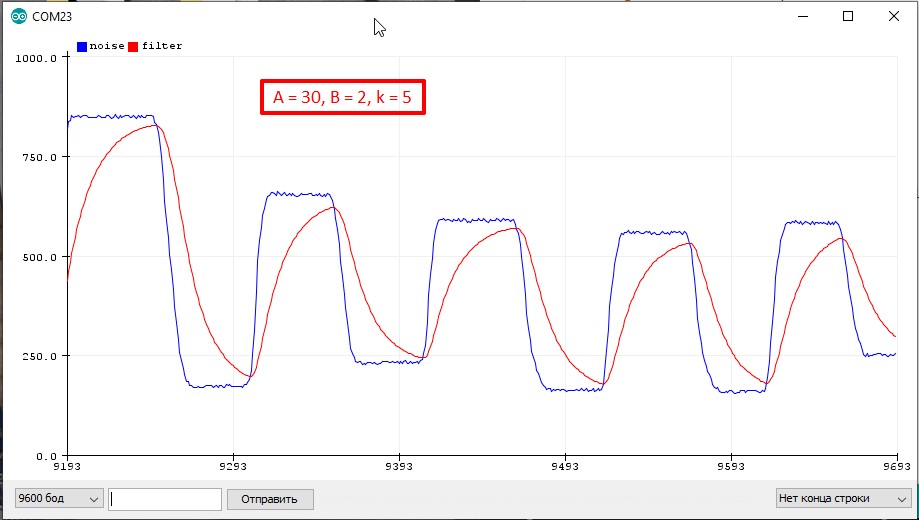

На рис. 9.14 показаны результаты работы программы. В левом столбце — зависимость сигнала ошибки от номера шага, в правом — график выходного сигнала