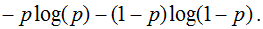

Эту функцию называют также «логлосс» (logloss / log_loss), перекрёстной / кросс-энтропией (Cross Entropy) и часто используют в задачах классификации. Разберёмся, почему её используют и какой смысл она имеет. Для чтения поста нужна неплохая ML-математическая подготовка, но даже новичкам я бы рекомендовал почитать (хотя я не очень заботился, чтобы «всё объяснялось на пальцах»).

Начнём издалека…

Вспомним, как решается задача линейной регрессии. Итак, мы хотим получить линейную функцию (т.е. веса w), которая приближает целевое значение с точностью до ошибки:

Здесь мы предположили, что ошибка нормально распределена, x – признаковое описание объекта (возможно, в нём есть и фиктивный константный признак, чтобы в линейной функции был свободный член). Тогда мы знаем как распределены ответы нашей функции и можем записать функцию правдоподобия выборки (т.е. произведение плотностей, в которые подставлены значения из обучающей выборки) и воспользоваться методом максимального правдоподобия (в котором для определения значений параметров берётся максимум правдоподобия, а чаще – его логарифма):

В итоге оказывается, что максимизация правдоподобия эквивалентна минимизации среднеквадратичной ошибки (MSE), т.е. эта функция ошибки не зря широко используется в задачах регрессии. Кроме того, что она вполне логична, легко дифференцируема по параметрам и легко минимизируется, она ещё и теоретически обосновывается с помощью метода максимального правдоподобия в случае, если линейная модель соответствует данным с точностью до нормального шума.

Давайте ещё посмотрим, как реализуется метод стохастического градиента (SGD) для минимизации MSE: надо взять производную функции ошибки для конкретного объекта и записать формулу коррекции весов в виде «шага в сторону антиградиента»:

Получили, что веса линейной модели при её обучении методом SGD корректируются с помощью добавки вектора признаков. Коэффициент, с которым добавляют, зависит от «агрессивности алгоритма» (параметр альфа, который называют темпом обучения) и разности «ответ алгоритма – правильный ответ». Кстати, если разница нулевая (т.е. на данном объекте алгоритм выдаёт точный ответ), то коррекция весов не производится.

Log Loss

Теперь давайте, наконец, поговорим о «логлоссе». Рассматриваем задачу классификации с двумя классами: 0 и 1. Обучающую выборку можно рассматривать, как реализацию обобщённой схемы Бернулли: для каждого объекта генерируется случайная величина, которая с вероятностью p (своей для каждого объекта) принимает значение 1 и с вероятностью (1–p) – 0. Предположим, что мы как раз и строим нашу модель так, чтобы она генерировала правильные вероятности, но тогда можно записать функцию правдоподобия:

После логарифмирования правдоподобия получили, что его максимизация эквивалентна минимизации последнего записанного выражения. Именно его и называют «логистической функции ошибки». Для задачи бинарной классификации, в которой алгоритм должен выдать вероятность принадлежности классу 1, она логична ровно настолько, насколько логична MSE в задаче линейной регрессии с нормальным шумом (поскольку обе функции ошибки выводятся из метода максимального правдоподобия).

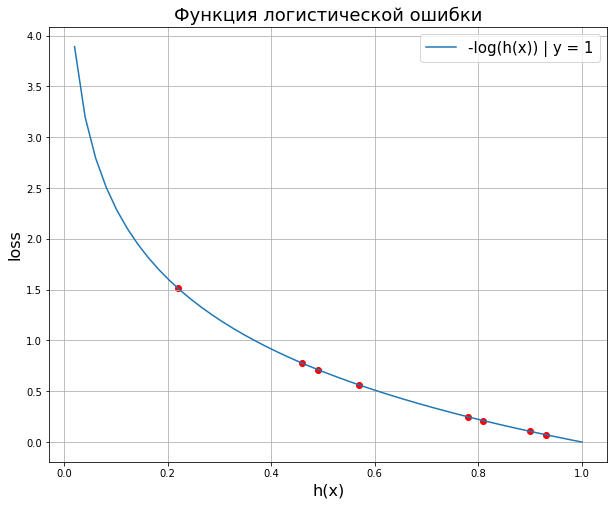

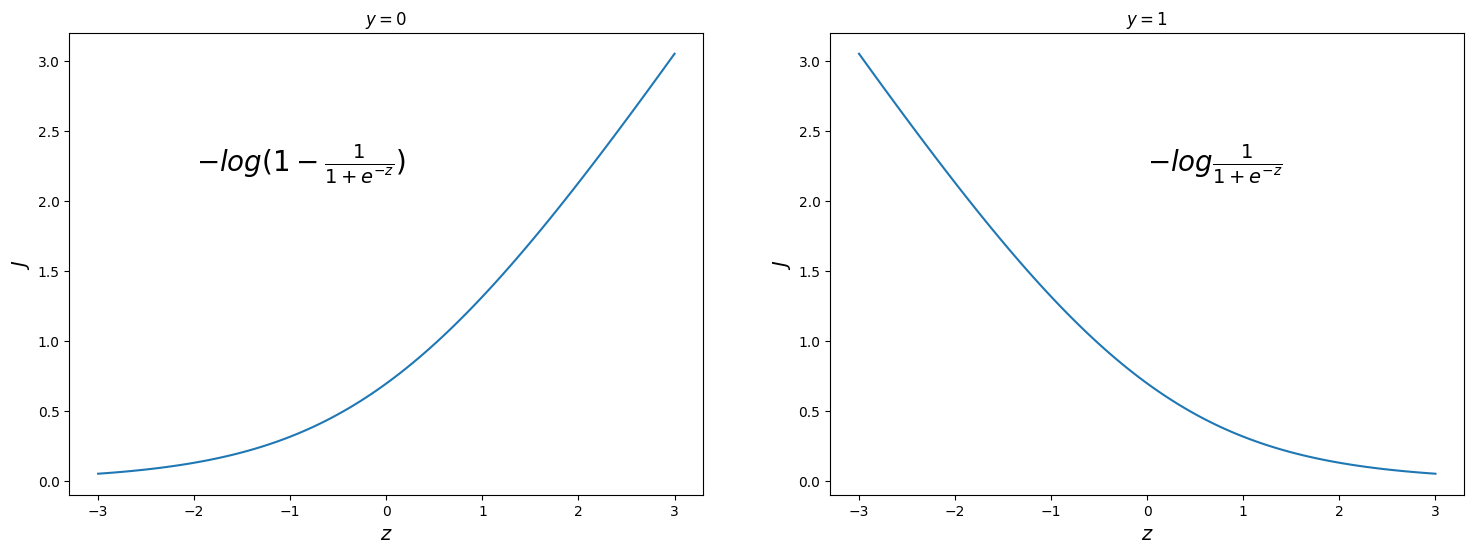

Часто гораздо более понятна такая запись logloss-ошибки на одном объекте:

Отметим неприятное свойство логосса: если для объекта 1го класса мы предсказываем нулевую вероятность принадлежности к этому классу или, наоборот, для объекта 0го – единичную вероятность принадлежности к классу 1, то ошибка равна бесконечности! Таким образом, грубая ошибка на одном объекте сразу делает алгоритм бесполезным. На практике часто логлосс ограничивают каким-то большим числом (чтобы не связываться с бесконечностями).

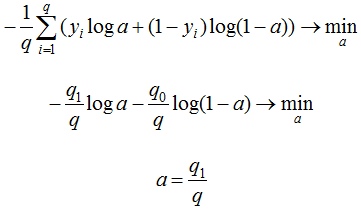

Если задаться вопросом, какой константный алгоритм оптимален для выборки из q_1 представителей класса 1 и q_0 представителей класса 0, q_1 + q_0 = q , то получим

Последний ответ получается взятием производной и приравниванием её к нулю. Описанную задачу приходится решать, например, при построении решающих деревьев (какую метку приписывать листу, если в него попали представители разных классов). На рис. 2 изображён график log_loss-ошибки константного алгоритма для выборки из четырёх объектов класса 0 и 6 объектов класса 1.

Представим теперь, что мы знаем, что объект принадлежит к классу 1 вероятностью p, посмотрим, какой ответ оптимален на этом объекте с точки зрения log_loss: матожидание нашей ошибки

Для минимизации ошибки мы опять взяли производную и приравняли к нулю. Мы получили, что оптимально для каждого объекта выдавать его вероятность принадлежности к классу 1! Таким образом, для минимизации log_loss надо уметь вычислять (оценивать) вероятности принадлежности классам!

Если подставить полученное оптимальное решение в минимизируемый функционал, то получим энтропию:

Это объясняет, почему при построении решающих деревьев в задачах классификации (а также случайных лесов и деревьях в бустингах) применяют энтропийный критерий расщепления (ветвления). Дело в том, что оценка принадлежности к классу 1 часто производится с помощью среднего арифметического меток в листе. В любом случае, для конкретного дерева эта вероятность будет одинакова для всех объектов в листе, т.е. константой. Таким образом, энтропия в листе примерно равна логлосс-ошибке константного решения. Используя энтропийный критерий мы неявно оптимизируем логлосс!

В каких пределах может варьироваться logloss? Ясно, что минимальное значение 0, максимальное – +∞, но эффективным максимальным можно считать ошибку при использовании константного алгоритма (вряд же мы в итоге решения задачи придумаем алгоритм хуже константы?!), т.е.

Интересно, что если брать логарифм по основанию 2, то на сбалансированной выборке это отрезок [0, 1].

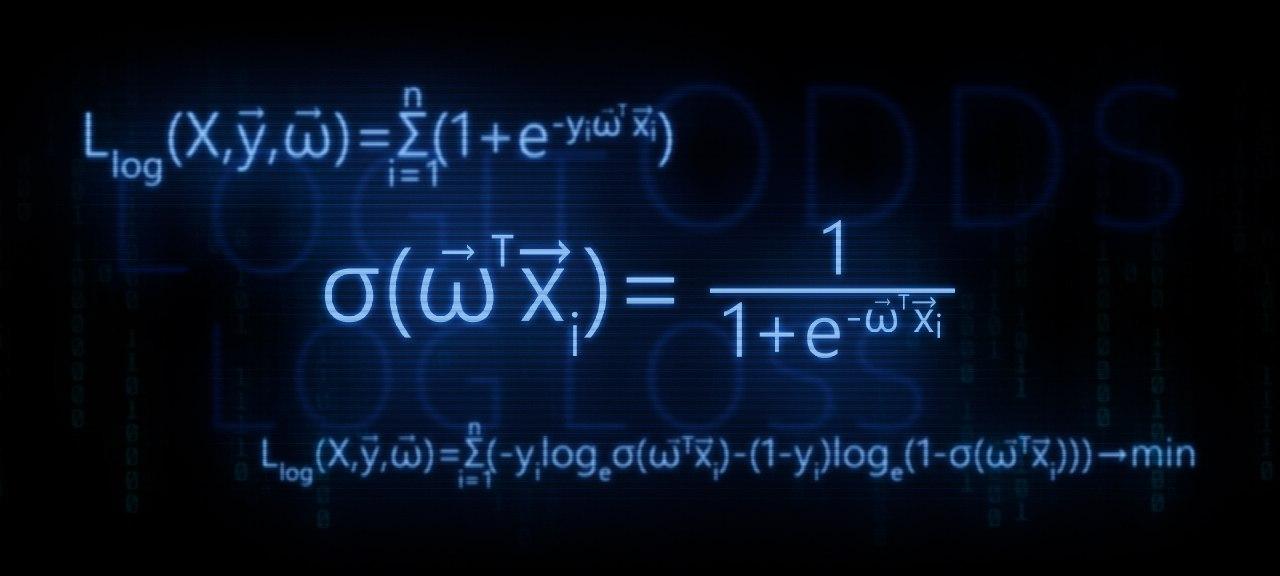

Связь с логистической регрессией

Слово «логистическая» в названии ошибки намекает на связь с логистической регрессией – это как раз метод для решения задачи бинарной классификации, который получает вероятность принадлежности к классу 1. Но пока мы исходили из общих предположений, что наш алгоритм генерирует эту вероятность (алгоритмом может быть, например, случайный лес или бустинг над деревьями). Покажем, что тесная связь с логистической регрессией всё-таки есть… посмотрим, как настраивается логистическая регрессия (т.е. сигмоида от линейной комбинации) на эту функцию ошибки методом SGD.

Как видим, корректировка весов точно такая же, как и при настройке линейной регрессии! На самом деле, это говорит о родстве разных регрессий: линейной и логистической, а точнее, о родстве распределений: нормального и Бернулли. Желающие могут внимательно почитать лекцию Эндрю Ына.

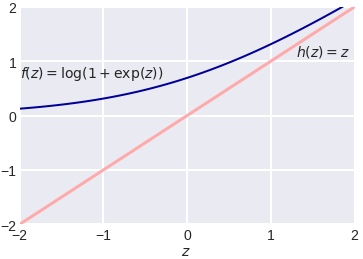

Во многих книгах логистической функцией ошибки (т.е. именно «logistic loss») называется другое выражение, которое мы сейчас получим, подставив выражение для сигмоиды в logloss и сделав переобозначение: считаем, что метки классов теперь –1 и +1, тогда

Полезно посмотреть на график функции, центральной в этом представлении:

Как видно, это сглаженный (всюду дифференцируемый) аналог функции max(0, x), которую в глубоком обучении принято называть ReLu (Rectified Linear Unit). Если при настройке весов минимизировать logloss, то таким образом мы настраиваем классическую логистическую регрессию, если же использовать ReLu, чуть-чуть подправить аргумент и добавить регуляризацию, то получаем классическую настройку SVM:

выражение под знаком суммы принято называть Hinge loss. Как видим, часто с виду совсем разные методы можно получать «немного подправив» оптимизируемые функции на похожие. Между прочим, при обучении RVM (Relevance vector machine) используется тоже очень похожий функционал:

Связь с расхождением Кульбака-Лейблера

Расхождение (дивергенцию) Кульбака-Лейблера (KL, Kullback–Leibler divergence) часто используют (особенно в машинном обучении, байесовском подходе и теории информации) для вычисления непохожести двух распределений. Оно определяется по следующей формуле:

где P и Q – распределения (первое обычно «истинное», а второе – то, про которое нам интересно, насколько оно похоже на истинное), p и q – плотности этих распределений. Часто KL-расхождение называют расстоянием, хотя оно не является симметричным и не удовлетворяет неравенству треугольника. Для дискретных распределений формулу записывают так:

P_i, Q_i – вероятности дискретных событий. Давайте рассмотрим конкретный объект x с меткой y. Если алгоритм выдаёт вероятность принадлежности первому классу – a, то предполагаемое распределение на событиях «класс 0», «класс 1» – (1–a, a), а истинное – (1–y, y), поэтому расхождение Кульбака-Лейблера между ними

что в точности совпадает с logloss.

Настройка на logloss

Один из методов «подгонки» ответов алгоритма под logloss – калибровка Платта (Platt calibration). Идея очень простая. Пусть алгоритм порождает некоторые оценки принадлежности к 1му классу – a. Метод изначально разрабатывался для калибровки ответов алгоритма опорных векторов (SVM), этот алгоритм в простейшей реализации разделяет объекты гиперплоскостью и просто выдаёт номер класса 0 или 1, в зависимости от того, с какой стороны гиперплоскости объект расположен. Но если мы построили гиперплоскость, то для любого объекта можем вычислить расстояние до неё (со знаком минус, если объект лежит в полуплоскости нулевого класса). Именно эти расстояния со знаком r мы будем превращать в вероятности по следующей формуле:

неизвестные параметры α, β обычно определяются методом максимального правдоподобия на отложенной выборке (calibration set).

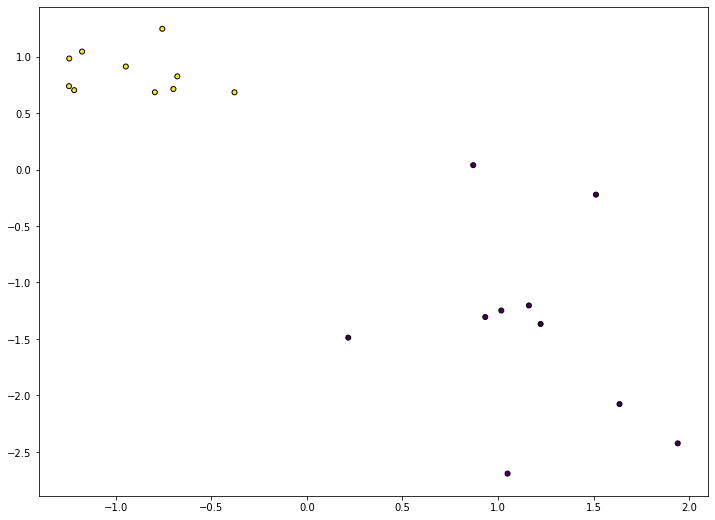

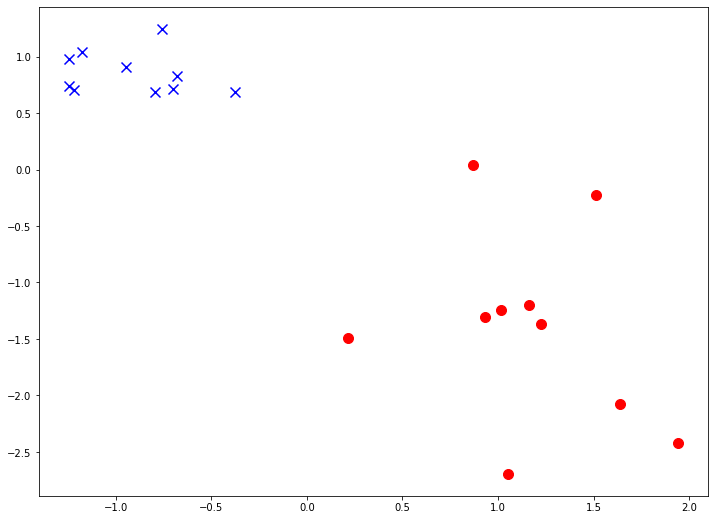

Проиллюстрируем применение метода на реальной задаче, которую автор решал недавно. На рис. показаны ответы (в виде вероятностей) двух алгоритмов: градиентного бустинга (lightgbm) и случайного леса (random forest).

Видно, что качество леса намного ниже и он довольно осторожен: занижает вероятности у объектов класса 1 и завышает у объектов класса 0. Упорядочим все объекты по возрастанию вероятностей (RF), разобьем на k равных частей и для каждой части вычислим среднее всех ответов алгоритма и среднее всех правильных ответов. Результат показан на рис. 5 – точки изображены как раз в этих двух координатах.

Нетрудно видеть, что точки располагаются на линии, похожей на сигмоиду – можно оценить параметр сжатия-растяжения в ней, см. рис. 6. Оптимальная сигмоида показана розовым цветом на рис. 5. Если подвергать ответы такой сигмоидной деформации, то логлосс-ошибка случайного леса снижается с 0.37 до 0.33.

Обратите внимание, что здесь мы деформировали ответы случайного леса (это были оценки вероятности – и все они лежали на отрезке [0, 1]), но из рис. 5 видно, что для деформации нужна именно сигмоида. Практика показывает, что в 80% ситуаций для улучшения logloss-ошибки надо деформировать ответы именно с помощью сигмоиды (для меня это также часть объяснения, почему именно такие функции успешно используются в качестве функций активаций в нейронных сетях).

Ещё один вариант калибровки – монотонная регрессия (Isotonic regression).

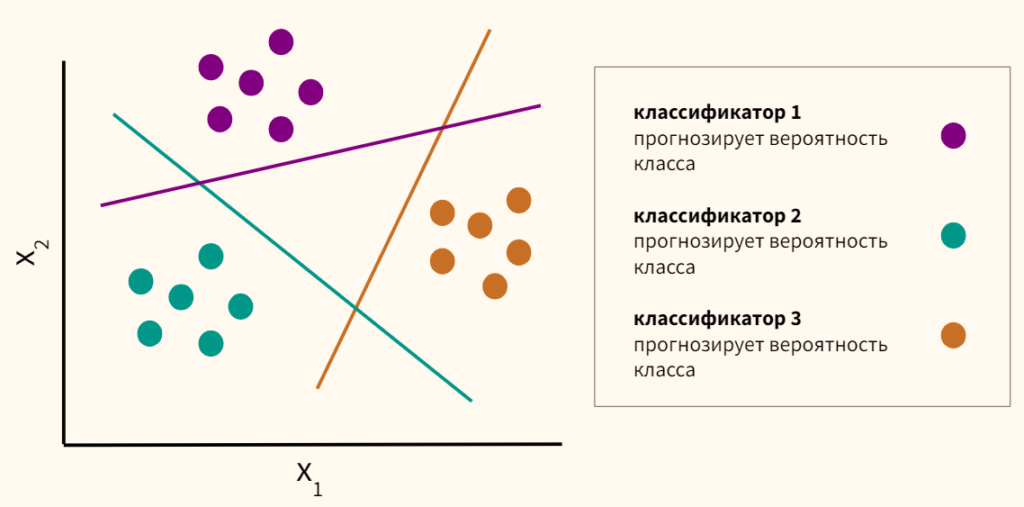

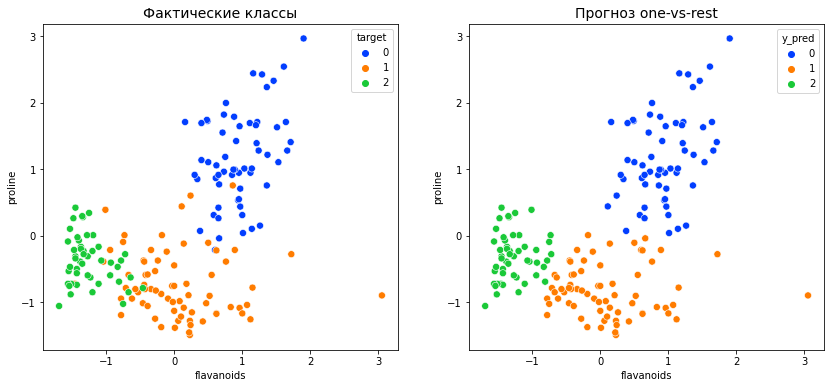

Многоклассовый logloss

Для полноты картины отметим, что logloss обобщается и на случай нескольких классов естественным образом:

здесь q – число элементов в выборке, l – число классов, a_ij – ответ (вероятность) алгоритма на i-м объекте на вопрос принадлежности его к j-му классу, y_ij=1 если i-й объект принадлежит j-му классу, в противном случае y_ij=0.

На посошок…

В каждом подобном посте я стараюсь написать что-то из мира машинного обучения, что, с одной стороны, просто и понятно, а с другой – изложение этого не встречается больше нигде. Например, есть такой естественный вопрос: почему в задачах классификации при построении решающих деревьев используют энтропийный критерий расщепления? Во всех курсах его (критерий) преподносят либо как эвристику, которую «вполне естественно использовать», либо говорят, что «энтропия похожа на кросс-энтропию». Сейчас стоимость некоторых курсов по машинному обучению достигает нескольких сотен тысяч рублей, но «профессиональные инструкторы» не могут донести простую цепочку:

- в статистической теории обучения настройка алгоритма производится максимизацией правдоподобия,

- в задаче бинарной классификации это эквивалентно минимизации логлосса, а сам минимум как раз равен энтропии,

- поэтому использование энтропийного критерия фактически эквивалентно выбору расщепления, минимизирующего логлосс.

Если Вы всё-таки отдали несколько сотен тысяч рублей, то можете проверить «профессиональность инструктора» следующими вопросами:

- Энтропия в листе примерно равна logloss-ошибке константного решения. Почему не использовать саму ошибку, а не приближённое значение? Или, как часто происходит в задачах оптимизации, её верхнюю оценку?

- Минимизации какой ошибки соответствует критерий расщепления Джини?

- Можно показать, что если в задаче бинарной классификации использовать в качестве функции ошибки среднеквадратичное отклонение, то также, как и для логлосса, оптимальным ответом на объекте будет вероятность его принадлежности к классу 1. Почему тогда не использовать такую функцию ошибки?

Ответы типа «так принято», «такой функции не существует», «это только для регрессии», естественно, заведомо неправильные. Если Вам не ответят с такой же степенью подробности, как в этом посте, то Вы точно переплатили;)

П.С. Что ещё почитать…

В этом блоге я публиковал уже несколько постов по метрикам качества…

- AUC ROC (площадь под кривой ошибок)

- Задачки про AUC (ROC)

- Знакомьтесь, Джини

И буквально на днях вышла классная статья Дмитрия Петухова про коэффициент Джини, читать обязательно:

- Коэффициент Джини. Из экономики в машинное обучение

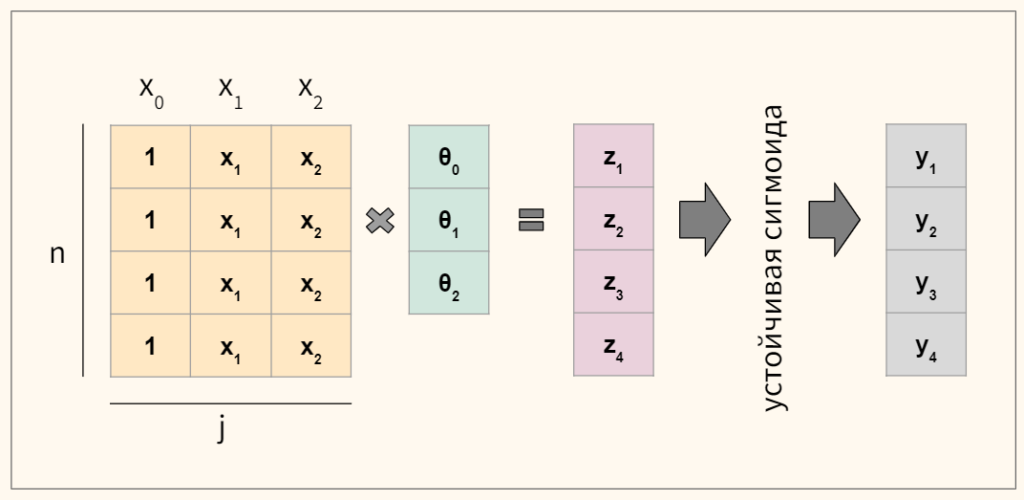

В этой статье, мы будем разбирать теоретические выкладки преобразования функции линейной регрессии в функцию обратного логит-преобразования (иначе говорят, функцию логистического отклика). Затем, воспользовавшись арсеналом метода максимального правдоподобия, в соответствии с моделью логистической регрессии, выведем функцию потерь Logistic Loss, или другими словами, мы определим функцию, с помощью которой в модели логистической регрессии подбираются параметры вектора весов

.

План статьи:

- Повторим о прямолинейной зависимости между двумя переменными

- Выявим необходимость преобразования функции линейной регрессии

в функцию логистического отклика

- Проведем преобразования и выведем функцию логистического отклика

- Попытаемся понять, чем плох метод наименьших квадратов при подборе параметров

функции Logistic Loss

- Используем метод максимального правдоподобия для определения функции подбора параметров

:

5.1. Случай 1: функция Logistic Loss для объектов с обозначением классов 0 и 1:

5.2. Случай 2: функция Logistic Loss для объектов с обозначением классов -1 и +1:

Статья изобилует простыми примерами, в которых все расчеты легко произвести устно или на бумаге, в некоторых случаях может потребоваться калькулятор. Так что подготовьтесь

Данная статья в большей мере рассчитана на датасайнтистов с начальным уровнем познаний в основах машинного обучения.

В статье также будет приведен код для отрисовки графиков и расчетов. Весь код написан на языке python 2.7. Заранее поясню о «новизне» используемой версии — таково одно из условий прохождения известного курса от Яндекса на не менее известной интернет-площадке онлайн образования Coursera, и, как можно предположить, материал подготовлен по мотивам этого курса.

01. Прямолинейная зависимость

Вполне резонно задать вопрос — причем здесь прямолинейная зависимость и логистическая регрессия?

Все просто! Логистическая регрессия представляет собой одну из моделей, которые относятся к линейному классификатору. Простыми словами, задачей линейного классификатора является предсказание целевых значений

от переменных (регрессоров)

. При этом считается, что зависимость между признаками

и целевыми значениями

линейная. Отсюда собственно и название классификатора — линейный. Если очень грубо обобщить, то в основе модели логистической регрессии лежит предположение о наличии линейной зависимости между признаками

и целевыми значениями

. Вот она — связь.

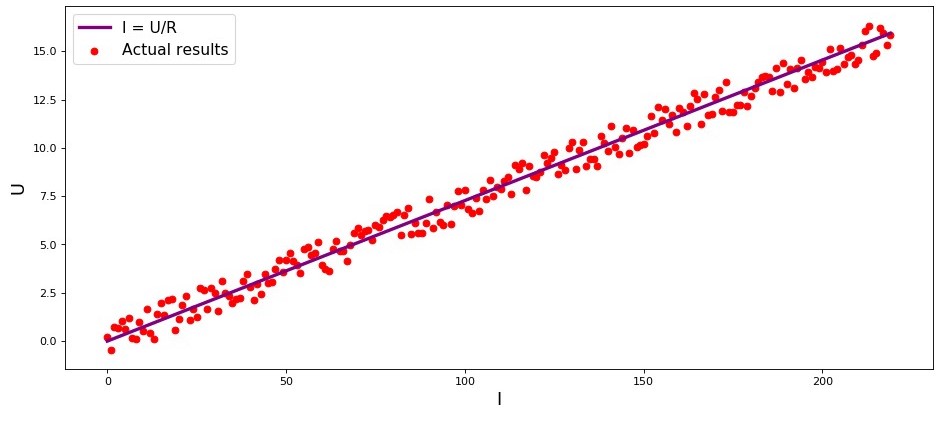

В студии первый пример, и он, правильно, о прямолинейной зависимости исследуемых величин. В процессе подготовки статьи наткнулся на пример, набивший уже многим оскомину — зависимость силы тока от напряжения («Прикладной регрессионный анализ», Н.Дрейпер, Г.Смит). Здесь мы его тоже рассмотрим.

В соответствии с законом Ома:

, где

— сила тока,

— напряжение,

— сопротивление.

Если бы мы не знали закон Ома, то могли бы найти зависимость эмпирически, изменяя

и измеряя

, поддерживая при этом

фиксированным. Тогда мы бы увидели, что график зависимости

от

дает более или менее прямую линию, проходящую через начало координат. Мы сказали «более или менее», так как, хотя зависимость фактически точная, наши измерения могут содержать малые ошибки, и поэтому точки на графике, возможно не попадут строго на линию, а будут разбросаны вокруг нее случайным образом.

График 1 «Зависимость

от

»

Код отрисовки графика

import matplotlib.pyplot as plt

%matplotlib inline

import numpy as np

import random

R = 13.75

x_line = np.arange(0,220,1)

y_line = []

for i in x_line:

y_line.append(i/R)

y_dot = []

for i in y_line:

y_dot.append(i+random.uniform(-0.9,0.9))

fig, axes = plt.subplots(figsize = (14,6), dpi = 80)

plt.plot(x_line,y_line,color = 'purple',lw = 3, label = 'I = U/R')

plt.scatter(x_line,y_dot,color = 'red', label = 'Actual results')

plt.xlabel('I', size = 16)

plt.ylabel('U', size = 16)

plt.legend(prop = {'size': 14})

plt.show()

02. Необходимость преобразований уравнения линейной регрессии

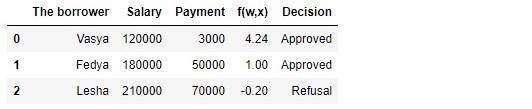

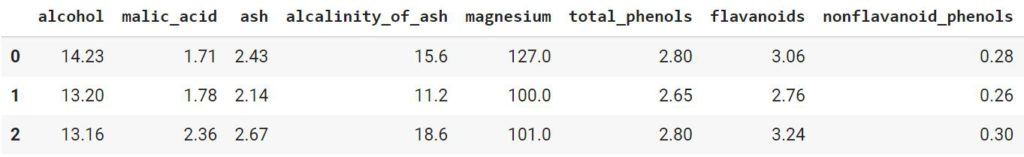

Рассмотрим очередной пример. Представим, что мы работаем в банке и перед нами задача определить вероятность возврата кредита заемщиком в зависимости от некоторых факторов. Для упрощения задачи, рассмотрим только два фактора: месячная зарплата заемщика и месячный размер платежа на погашение кредита.

Задача очень условная, но на этом примере мы сможем понять, почему для ее решения недостаточно применения функции линейной регрессии, а также узнаем какие преобразования с функцией требуется провести.

Возвращаемся к примеру. Понятно, что чем выше зарплата, тем больше заемщик сможет ежемесячно направлять на погашение кредита. При этом, для определенного диапазона зарплат эта зависимость будет вполне себе линейная. Например, возьмем диапазон зарплат от 60.000Р до 200.000Р и предположим, что в указанном диапазоне заработных плат, зависимость размера ежемесячного платежа от размера заработной платы — линейная. Допустим, для указанного диапазона размера заработных плат было выявлено, что соотношение зарплаты к платежу не может опускаться ниже 3 и еще у заемщика должно оставаться в запасе 5.000Р. И только в таком случае, мы будем считать, что заемщик вернет кредит банку. Тогда, уравнение линейной регрессии примет вид:

где

,

,

,

— зарплата

-го заемщика,

— платеж по кредиту

-го заемщика.

Подставляя в уравнение зарплату и платеж по кредиту с фиксированными параметрами

можно принять решение о выдаче или отказе кредита.

Забегая вперед, отметим, что, при заданных параметрах

функция линейной регрессии, применяемая в функции логистичиеского отклика будет выдавать большие значения, которые затруднят проведение расчетов по определению вероятностей погашения кредита. Поэтому, предлагается уменьшить наши коэффициенты, скажем так, в 25.000 раз. От этого преобразования в коэффициентах, решение о выдачи кредита не изменится. Запомним этот момент на будущее, а сейчас чтобы было еще понятнее, о чем речь, рассмотрим ситуация с тремя потенциальными заемщиками.

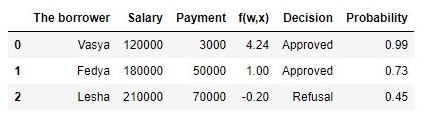

Таблица 1 «Потенциальные заемщики»

Код для формирования таблицы

import pandas as pd

r = 25000.0

w_0 = -5000.0/r

w_1 = 1.0/r

w_2 = -3.0/r

data = {'The borrower':np.array(['Vasya', 'Fedya', 'Lesha']),

'Salary':np.array([120000,180000,210000]),

'Payment':np.array([3000,50000,70000])}

df = pd.DataFrame(data)

df['f(w,x)'] = w_0 + df['Salary']*w_1 + df['Payment']*w_2

decision = []

for i in df['f(w,x)']:

if i > 0:

dec = 'Approved'

decision.append(dec)

else:

dec = 'Refusal'

decision.append(dec)

df['Decision'] = decision

df[['The borrower', 'Salary', 'Payment', 'f(w,x)', 'Decision']]

В соответствии с данными таблицы, Вася при зарплате в 120.000Р хочет получить такой кредит, чтобы ежемесячного гасить его по 3.000Р. Нами было определено, что для одобрения кредита, размер заработной платы Васи должен превышать в три раза размер платежа, и чтобы еще оставалось 5.000Р. Этому требованию Вася удовлетворяет:

. Остается даже 106.000Р. Несмотря на то, что при расчете

мы уменьшили коэффициенты

в 25.000 раз, результат получили тот же — кредит может быть одобрен. Федя тоже получит кредит, а вот Леше, несмотря на то, что он получает больше всех, придется поумерить свои аппетиты.

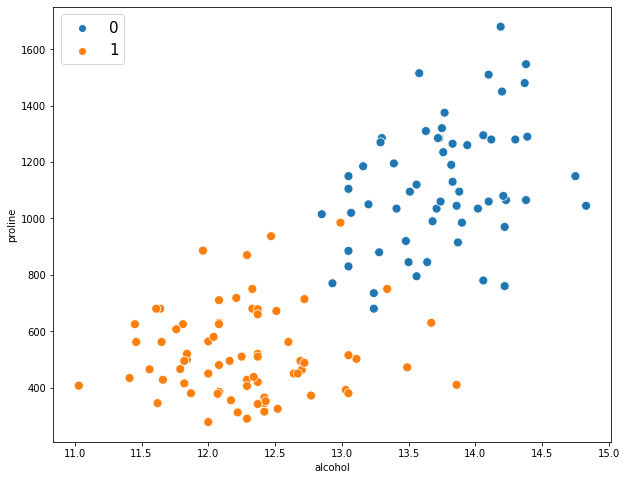

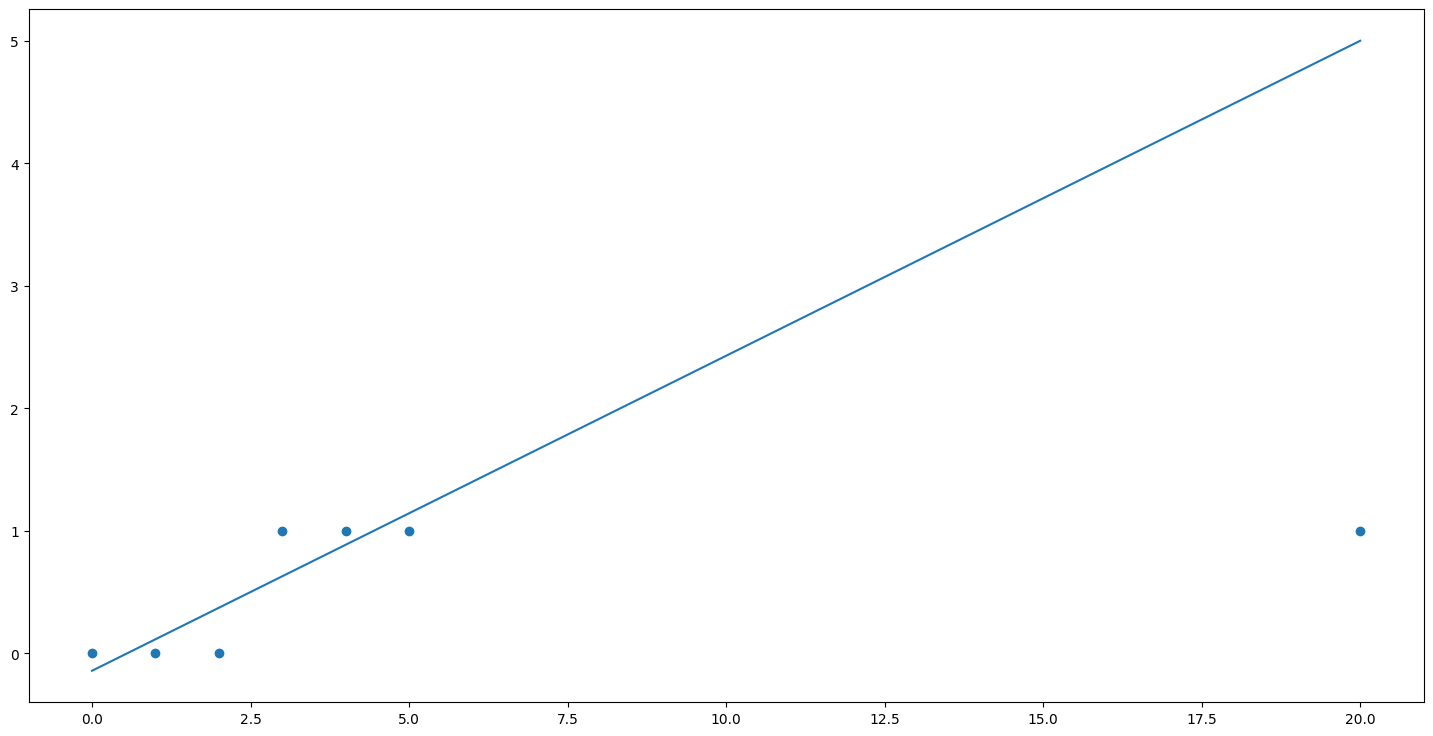

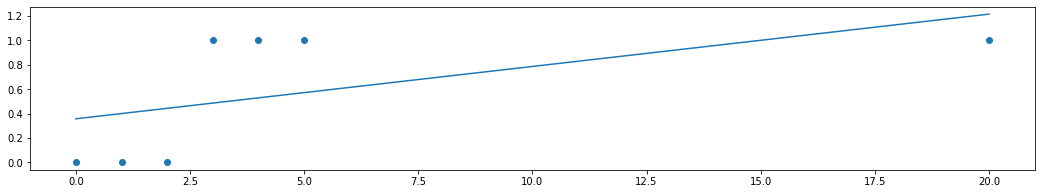

Нарисуем график по такому случаю.

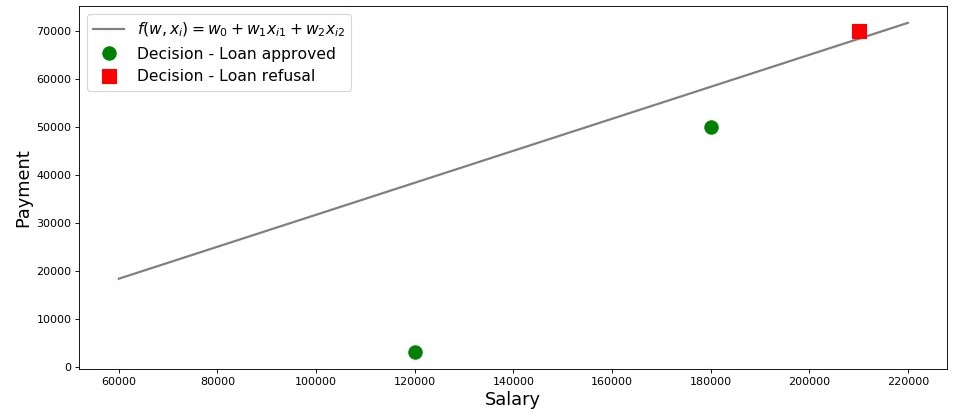

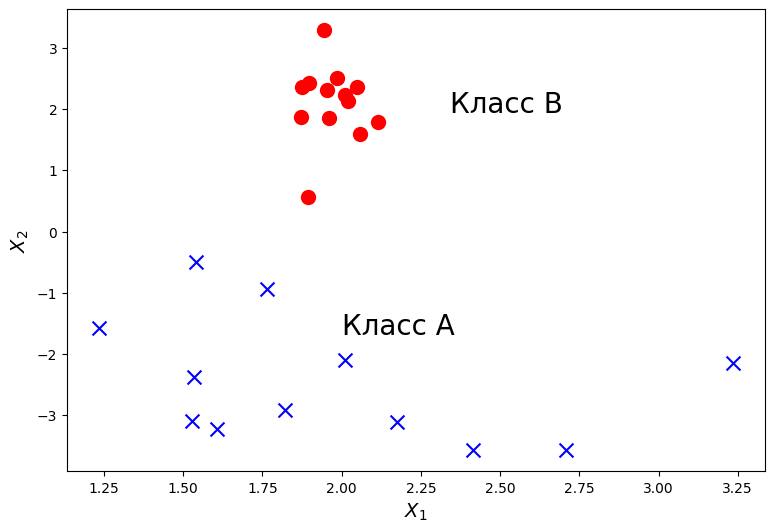

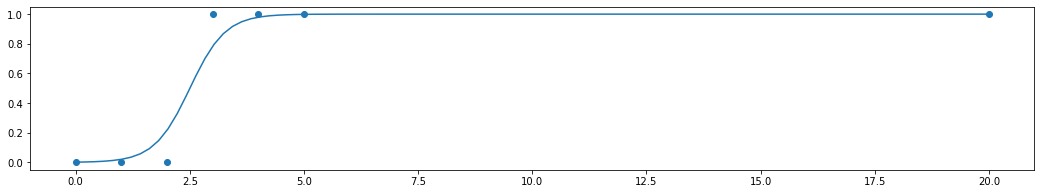

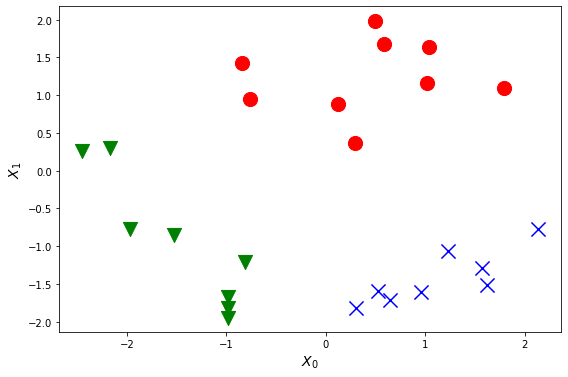

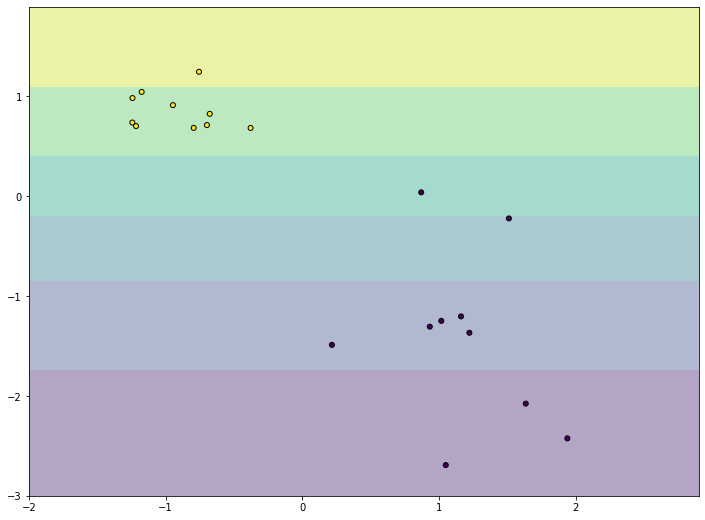

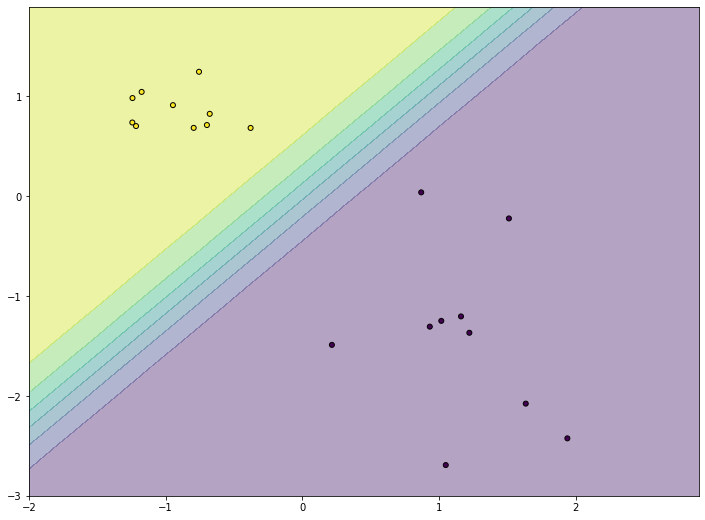

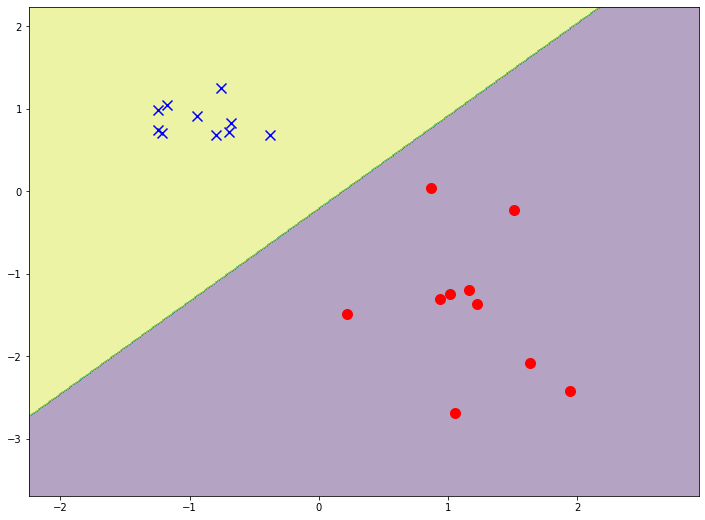

График 2 «Классификация заемщиков»

Код для отрисовки графика

salary = np.arange(60000,240000,20000)

payment = (-w_0-w_1*salary)/w_2

fig, axes = plt.subplots(figsize = (14,6), dpi = 80)

plt.plot(salary, payment, color = 'grey', lw = 2, label = '$f(w,x_i)=w_0 + w_1x_{i1} + w_2x_{i2}$')

plt.plot(df[df['Decision'] == 'Approved']['Salary'], df[df['Decision'] == 'Approved']['Payment'],

'o', color ='green', markersize = 12, label = 'Decision - Loan approved')

plt.plot(df[df['Decision'] == 'Refusal']['Salary'], df[df['Decision'] == 'Refusal']['Payment'],

's', color = 'red', markersize = 12, label = 'Decision - Loan refusal')

plt.xlabel('Salary', size = 16)

plt.ylabel('Payment', size = 16)

plt.legend(prop = {'size': 14})

plt.show()

Итак, наша прямая, построенная в соответствии с функцией

, отделяет «плохих» заемщиков от «хороших». Те заемщики, у кого желания не совпадают с возможностями находятся выше прямой (Леша), те же, кто способен согласно параметрам нашей модели, вернуть кредит, находятся под прямой (Вася и Федя). Иначе можно сказать так — наша прямая разделяет заемщиков на два класса. Обозначим их следующим образом: к классу

отнесем тех заемщиков, которые скорее всего вернут кредит, к классу

или

отнесем тех заемщиков, которые скорее всего не смогут вернуть кредит.

Обобщим выводы из этого простенького примера. Возьмем точку

и, подставляя координаты точки в соответствующее уравнение прямой

, рассмотрим три варианта:

- Если точка находится под прямой, и мы относим ее к классу

, то значение функции

будет положительным от

до

. Значит мы можем считать, что вероятность погашения кредита, находится в пределах

. Чем больше значение функции, тем выше вероятность.

- Если точка находится над прямой и мы относим ее к классу

или

, то значение функции будет отрицательным от

до

. Тогда мы будем считать, что вероятность погашения задолженности находится в пределах

и, чем больше по модулю значение функции, тем выше наша уверенность.

- Точка находится на прямой, на границе между двумя классами. В таком случае значение функции

будет равно

и вероятность погашения кредита равна

.

Теперь, представим, что у нас не два фактора, а десятки, заемщиков не три, а тысячи. Тогда вместо прямой у нас будет m-мерная плоскость и коэффициенты

у нас будут взяты не с потолка, а выведены по всем правилам, да на основе накопленных данных о заемщиках, вернувших или не вернувших кредит. И действительно, заметьте, мы сейчас отбираем заемщиков при уже известных коэффициентах

. На самом же деле, задача модели логистической регрессии как раз и состоит в том, чтобы определить параметры

, при которых значение функции потерь Logistic Loss будет стремиться к минимальному. Но о том, как рассчитывается вектор

, мы еще узнаем в 5-м разделе статьи. А пока возвращаемся на землю обетованную — к нашему банкиру и трем его клиентам.

Благодаря функции

мы знаем кому можно дать кредит, а кому нужно отказать. Но с такой информацией к директору идти нельзя, ведь от нас хотели получить вероятность возврата кредита каждым заемщиком. Что делать? Ответ простой — нам нужно как-то преобразовать функцию

, значения которой лежат в диапазоне

на функцию, значения которой будут лежать в диапазоне

. И такая функция существует, ее называют функцией логистического отклика или обратного-логит преобразования. Знакомьтесь:

Посмотрим по шагам как получается функция логистического отклика. Отметим, что шагать мы будем в обратную сторону, т.е. мы предположим, что нам известно значение вероятности, которое лежит в пределах от

до

и далее мы будем «раскручивать» это значение на всю область чисел от

до

.

03. Выводим функцию логистического отклика

Шаг 1. Переведем значения вероятности в диапазон

На время трансформации функции

в функцию логистического отклика

мы оставим в покое нашего кредитного аналитика, а вместо этого пройдемся по букмекерским конторам. Нет, конечно, ставки делать мы не будем, все что нас там интересует, так это смысл выражения, например, шанс 4 к 1. Шансы, знакомые всем делающим ставки игрокам, являются соотношением «успехов» к «неуспехам». С точки зрения вероятностей, шансы — это вероятность наступления события, деленная на вероятность того, что событие не произойдет. Запишем формулу шанса наступления события

:

, где

— вероятность наступления события,

— вероятность НЕ наступления события

Например, если вероятность того, что молодой, сильный и резвый конь по прозвищу «Ветерок» обойдет на скачках старую и дряблую старушку по кличке «Матильда» равняется

, то шансы на успех «Ветерка» составят

к

и наоборот, зная шансы, нам не составит труда вычислить вероятность

:

Таким образом, мы научились «переводить» вероятность в шансы, которые принимают значения от

до

. Сделаем еще один шаг и научимся «переводить» вероятность на всю числовую прямую от

до

.

Шаг 2. Переведем значения вероятности в диапазон

Шаг этот очень простой — прологарифмируем шансы по основанию числа Эйлера

и получим:

Теперь мы знаем, что если

, то вычислить значение

будет очень просто и, более того, оно должно быть положительным:

. Так и есть.

Ради любопытства проверим, что если

, тогда мы ожидаем увидеть отрицательное значение

. Проверяем:

. Все верно.

Теперь мы знаем как перевести значение вероятности от

до

на всю числовую прямую от

до

. В следующем шаге сделаем все наоборот.

А пока, отметим, что в соответствии с правилами логарифмирования, зная значение функции

, можно вычислить шансы:

Этот способ определения шансов нам пригодится на следующем шаге.

Шаг 3. Выведем формулу для определения

Итак, мы научились, зная

, находить значения функции

. Однако, на самом деле нам нужно все с точностью до наоборот — зная значение

находить

. Для этого обратимся к такому понятию как обратная функция шансов, в соответствии с которой:

В статье мы не будем выводить вышеобозначенную формулу, но проверим на цифрах из примера выше. Мы знаем, что при шансах равными 4 к 1 (

), вероятность наступления события равна 0.8 (

). Сделаем подстановку:

. Это совпадает с нашими вычислениями, проведенными ранее. Двигаемся далее.

На прошлом шаге мы вывели, что

, а значит можно сделать замену в обратной функции шансов. Получим:

Разделим и числитель и знаменатель на

, тогда:

На всякий пожарный, дабы убедиться, что мы нигде не ошиблись, сделаем еще одну небольшую проверку. На шаге 2, мы для

определили, что

. Тогда, подставив значение

в функцию логистического отклика, мы ожидаем получить

. Подставляем и получаем:

Поздравляю вас, уважаемый читатель, мы только что вывели и протестировали функцию логистического отклика. Давайте посмотрим на график функции.

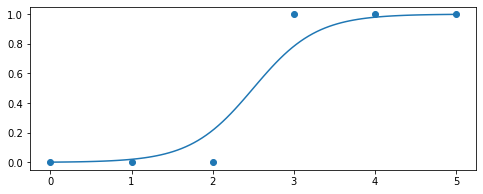

График 3 «Функция логистического отклика»

Код для отрисовки графика

import math

def logit (f):

return 1/(1+math.exp(-f))

f = np.arange(-7,7,0.05)

p = []

for i in f:

p.append(logit(i))

fig, axes = plt.subplots(figsize = (14,6), dpi = 80)

plt.plot(f, p, color = 'grey', label = '$ 1 / (1+e^{-w^Tx_i})$')

plt.xlabel('$f(w,x_i) = w^Tx_i$', size = 16)

plt.ylabel('$p_{i+}$', size = 16)

plt.legend(prop = {'size': 14})

plt.show()

В литературе также можно встретить название данной функции как сигмоид-функция. По графику хорошо заметно, что основное изменение вероятности принадлежности объекта к классу происходит на относительно небольшом диапазоне

, где-то от

до

.

Предлагаю вернуться к нашему кредитному аналитику и помочь ему с вычислением вероятности погашения кредитов, иначе он рискует остаться без премии

Таблица 2 «Потенциальные заемщики»

Код для формирования таблицы

proba = []

for i in df['f(w,x)']:

proba.append(round(logit(i),2))

df['Probability'] = proba

df[['The borrower', 'Salary', 'Payment', 'f(w,x)', 'Decision', 'Probability']]

Итак, вероятность возврата кредита мы определили. В целом, это похоже на правду.

Действительно, вероятность того что Вася при зарплате в 120.000Р сможет ежемесячно отдавать в банк 3.000Р близка к 100%. Кстати, мы должны понимать, что банк может выдать кредит и Леше в том случае, если политикой банка предусмотрено, например, кредитовать клиентов с вероятностью возврата кредита более, ну скажем, 0.3. Просто в таком случае банк сформирует больший резерв под возможные потери.

Также следует отметить, что соотношение зарплаты к платежу не менее 3 и с запасом в 5.000Р было взято с потолка. Поэтому нам нельзя было использовать в первоначальном виде вектор весов

. Нам требовалось сильно уменьшить коэффициенты и в таком случае мы разделили каждый коэффициент на 25.000, то есть по сути мы подогнали результат. Но это сделано было специально, чтобы упростить понимание материала на начальном этапе. В жизни, же нам потребуется не выдумывать и подгонять коэффициенты, а находить их. Как раз в следующих разделах статьи мы выведем уравнения, с помощью которых подбираются параметры

.

04. Метод наименьших квадратов при определении вектора весов  в функции логистического отклика

в функции логистического отклика

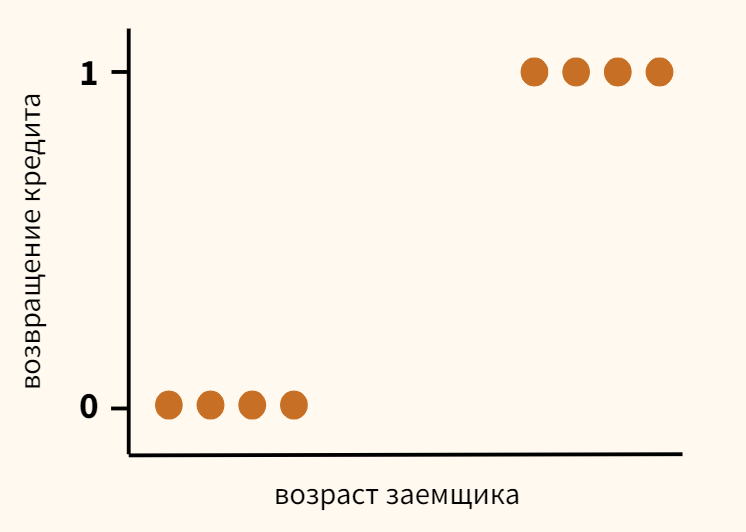

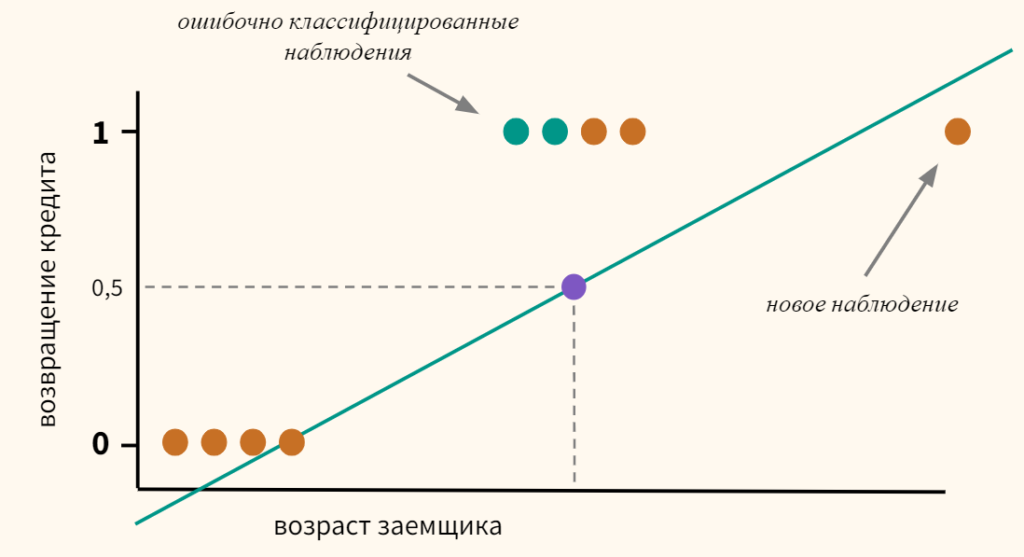

Нам уже известен такой метод подбора вектора весов

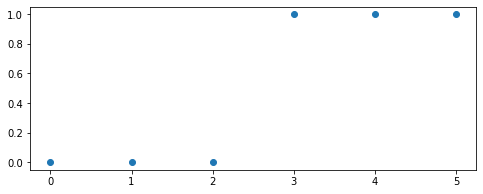

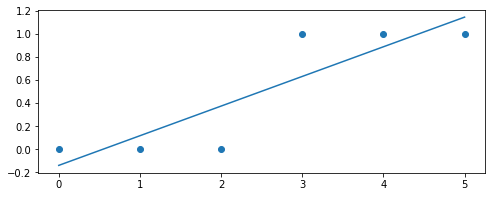

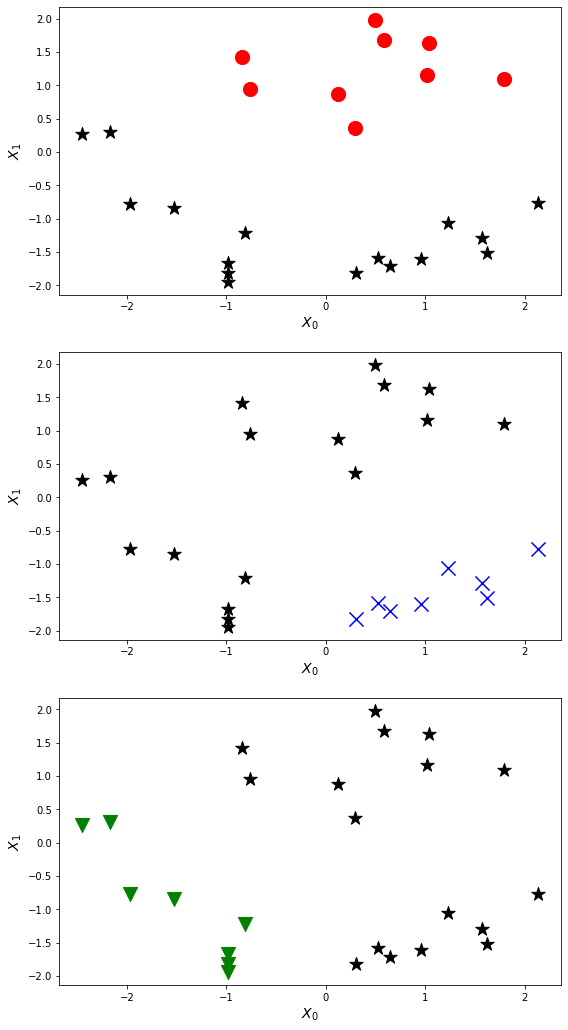

, как метод наименьших квадратов (МНК) и собственно, почему бы нам тогда не использовать его в задачах бинарной классификации? Действительно, ничто не мешает использовать МНК, только вот данный способ в задачах классификации дает результаты менее точные, нежели Logistic Loss. Этому есть теоретическое обоснование. Давайте для начала посмотрим на один простой пример.

Предположим, что наши модели (использующие MSE и Logistic Loss) уже начали подбор вектора весов

и мы остановили расчет на каком-то шаге. Неважно, в середине, в конце или в начале, главное, что у нас уже есть какие-то значения вектора весов и допустим, что на этом шаге, вектора весов

для обеих моделей не имеют различий. Тогда возьмем полученные веса и подставим их в функцию логистического отклика (

) для какого-нибудь объекта, который относится к классу

. Исследуем два случая, когда в соответствии с подобранным вектором весов наша модель сильно ошибается и наоборот — модель сильно уверена в том, что объект относится к классу

. Посмотрим какие штрафы будут «выписаны» при использовании МНК и Logistic Loss.

Код для расчета штрафов в зависимости от используемой функции потерь

# класс объекта

y = 1

# вероятность отнесения объекта к классу в соответствии с параметрами w

proba_1 = 0.01

MSE_1 = (y - proba_1)**2

print 'Штраф MSE при грубой ошибке =', MSE_1

# напишем функцию для вычисления f(w,x) при известной вероятности отнесения объекта к классу +1 (f(w,x)=ln(odds+))

def f_w_x(proba):

return math.log(proba/(1-proba))

LogLoss_1 = math.log(1+math.exp(-y*f_w_x(proba_1)))

print 'Штраф Log Loss при грубой ошибке =', LogLoss_1

proba_2 = 0.99

MSE_2 = (y - proba_2)**2

LogLoss_2 = math.log(1+math.exp(-y*f_w_x(proba_2)))

print '**************************************************************'

print 'Штраф MSE при сильной уверенности =', MSE_2

print 'Штраф Log Loss при сильной уверенности =', LogLoss_2

Случай с грубой ошибкой — модель относит объект к классу

с вероятностью в 0,01

Штраф при использовании МНК составит:

Штраф при использовании Logistic Loss составит:

Случай с сильной уверенностью — модель относит объект к классу

с вероятностью в 0,99

Штраф при использовании МНК составит:

Штраф при использовании Logistic Loss составит:

Этот пример хорошо иллюстрирует, что при грубой ошибке функция потерь Log Loss штрафует модель значительно сильнее, чем MSE. Давайте теперь разберемся, каковы теоретические предпосылки использования функции потерь Log Loss в задачах классификации.

05. Метод максимального правдоподобия и логистическая регрессия

Как и было обещано в начале, статья изобилует простыми примерами. В студии очередной пример и старые гости — заемщики банка: Вася, Федя и Леша.

На всякий пожарный, перед тем как развивать пример, напомню, что в жизни мы имеем дело с обучающей выборкой из тысяч или миллионов объектов с десятками или сотнями признаков. Однако здесь цифры взяты так, чтобы они легко укладывались в голове начинающего датасайнтеста.

Возвращаемся к примеру. Представим, что директор банка решил выдать кредит всем нуждающимся, несмотря на то, что алгоритм подсказывал не выдавать его Леше. И вот прошло достаточно времени и нам стало известно кто из трех героев погасил кредит, а кто нет. Что и следовало ожидать: Вася и Федя погасили кредит, а Леша — нет. Теперь давайте представим, что этот результат будет для нас новой обучающей выборкой и, при этом у нас как будто исчезли все данные о факторах, влияющих на вероятность погашения кредита (зарплата заемщика, размер ежемесячного платежа). Тогда интуитивно мы можем полагать, что каждый третий заемщик не возвращает банку кредит или другими словами вероятность возврата кредита следующим заемщиком

. Этому интуитивному предположению есть теоретическое подтверждение и основывается оно на методе максимального правдоподобия, часто в литературе его называют принципом максимального правдоподобия.

Для начала познакомимся с понятийным аппаратом.

Правдоподобие выборки — это вероятность получения именно такой выборки, получения именно таких наблюдений / результатов, т.е. произведение вероятностей получения каждого из результатов выборки (например, погашен или не погашен кредит Васей, Федей и Лешей одновременно).

Функция правдоподобия связывает правдоподобие выборки со значениями параметров распределения.

В нашем случае, обучающая выборка представляет собой обобщённую схему Бернулли, в которой случайная величина принимает всего два значения:

или

. Следовательно, правдоподобие выборки можно записать как функцию правдоподобия от параметра

следующим образом:

Вышеуказанную запись можно интерпретировать так. Совместная вероятность того, что Вася и Федя погасят кредит равна

, вероятность того что Леша НЕ погасит кредит равна

(так как имело место именно НЕ погашение кредита), следовательно совместная вероятность всех трех событий равна

.

Метод максимального правдоподобия — это метод оценки неизвестного параметра путём максимизации функции правдоподобия. В нашем случае требуется найти такое значение

, при котором

достигает максимума.

Откуда собственно идея – искать значение неизвестного параметра, при котором функция правдоподобия достигает максимума? Истоки идеи проистекают из представления о том, что выборка – это единственный, доступный нам, источник знания о генеральной совокупности. Все, что нам известно о генеральной совокупности, представлено в выборке. Поэтому, все, что мы можем сказать, так это то, что выборка – это наиболее точное отражение генеральной совокупности, доступное нам. Следовательно, нам требуется найти такой параметр, при котором имеющаяся выборка становится наиболее вероятной.

Очевидно, мы имеем дело с оптимизационной задачей, в которой требуется найти точку экстремума функции. Для нахождения точки экстремума необходимо рассмотреть условие первого порядка, то есть приравнять производную функции к нулю и решить уравнение относительно искомого параметра. Однако поиски производной произведения большого количества множителей могут оказаться делом затяжным, чтобы этого избежать существует специальный прием — переход к логарифму функции правдоподобия. Почему возможен такой переход? Обратим внимание на то, что мы ищем не сам экстремум функции

, а точку экстремума, то есть то значение неизвестного параметра

, при котором

достигает максимума. При переходе к логарифму точка экстремума не меняется (хотя сам экстремум будет отличаться), так как логарифм — монотонная функция.

Давайте, в соответствии с вышеизложенным, продолжим развивать наш пример с кредитами у Васи, Феди и Леши. Для начала перейдем к логарифму функции правдоподобия:

Теперь мы можем с легкостью продифференцировать выражение по

:

И наконец, рассмотрим условие первого порядка — приравняем производную функции к нулю:

Таким образом, наша интуитивная оценка вероятности погашения кредита

была теоретически обоснована.

Отлично, но что нам теперь делать с такой информацией? Если мы будем считать, что каждый третий заемщик не вернет банку деньги, то последний неизбежно разорится. Так-то оно так, да только при оценке вероятности погашения кредита равной

мы не учли факторы, влияющие на возврат кредита: заработная плата заемщика и размер ежемесячного платежа. Вспомним, что ранее мы рассчитали вероятность возврата кредита каждым клиентом с учетом этих самых факторов. Логично, что и вероятности у нас получились отличные от константы равной

.

Давайте определим правдоподобие выборок:

Код для расчетов правдоподобий выборок

from functools import reduce

def likelihood(y,p):

line_true_proba = []

for i in range(len(y)):

ltp_i = p[i]**y[i]*(1-p[i])**(1-y[i])

line_true_proba.append(ltp_i)

likelihood = []

return reduce(lambda a, b: a*b, line_true_proba)

y = [1.0,1.0,0.0]

p_log_response = df['Probability']

const = 2.0/3.0

p_const = [const, const, const]

print 'Правдоподобие выборки при константном значении p=2/3:', round(likelihood(y,p_const),3)

print '****************************************************************************************************'

print 'Правдоподобие выборки при расчетном значении p:', round(likelihood(y,p_log_response),3)

Правдоподобие выборки при константном значении :

Правдоподобие выборки при расчете вероятности погашения кредита с учетом факторов :

Правдоподобие выборки с вероятностью, посчитанной в зависимости от факторов оказалось выше правдоподобия при константном значении вероятности. О чем это говорит? Это говорит о том, что знания о факторах позволили подобрать более точно вероятность погашения кредита для каждого клиента. Поэтому, при выдаче очередного кредита, правильнее будет использовать, предложенную в конце 3-го раздела статьи, модель оценки вероятности погашения задолженности.

Но тогда, если нам требуется максимизировать функцию правдоподобия выборки, то почему бы не использовать какой-нибудь алгоритм, который будет выдавать вероятности для Васи, Феди и Леши, например, равными 0.99, 0.99 и 0.01 соответственно. Возможно такой алгоритм и хорошо себя проявит на обучающей выборке, так как приблизит значение правдоподобия выборки к

, но, во-первых, у такого алгоритма будут, скорее всего трудности с обобщающей способностью, во-вторых, этот алгоритм будет точно не линейным. И если, методы борьбы с переобучением (равно слабая обобщающая способность) явно не входят в план этой статьи, то по второму пункту давайте пройдемся подробнее. Для этого, достаточно ответить на простой вопрос. Может ли вероятность погашения кредита Васей и Федей быть одинаковой с учетом известных нам факторов? С точки зрения здравой логики конечно же нет, не может. Так на погашение кредита Вася будет отдавать 2.5% своей зарплаты в месяц, а Федя — почти 27,8%. Также на графике 2 «Классификация клиентов» мы видим, что Вася находится значительно дальше от линии, разделяющей классы, чем Федя. Ну и наконец, мы знаем, что функция

для Васи и Феди принимает различные значения: 4.24 для Васи и 1.0 для Феди. Вот если бы Федя, например, зарабатывал на порядок больше или кредит поменьше просил, то тогда вероятности погашения кредита у Васи и Феди были бы схожими. Другими словами, линейную зависимость не обманешь. И если бы мы действительно рассчитали коэффициенты

, а не взяли их с потолка, то могли бы смело заявить, что наши значения

лучше всего позволяют оценить вероятность погашения кредита каждым заемщиком, но так как мы условились считать, что определение коэффициентов

было проведено по всем правилам, то мы так и будем считать — наши коэффициенты позволяют дать лучшую оценку вероятности

Однако мы отвлеклись. В этом разделе нам надо разобраться как определяется вектор весов

, который необходим для оценки вероятности возврата кредита каждым заемщиком.

Кратко резюмируем, с каким арсеналом мы выступаем на поиски коэффициентов

:

1. Мы предполагаем, что зависимость между целевой переменной (прогнозным значением) и фактором, оказывающим влияние на результат — линейная. По этой причине применяется функция линейной регрессии вида

, линия которого делит объекты (клиентов) на классы

и

или

(клиенты, способные погасить кредит и не способные). В нашем случае уравнение имеет вид

.

2. Мы используем функцию обратного логит-преобразования вида

для определения вероятности принадлежности объекта к классу

.

3. Мы рассматриваем нашу обучающую выборку как реализацию обобщенной схемы Бернулли, то есть для каждого объекта генерируется случайная величина, которая с вероятностью

(своей для каждого объекта) принимает значение 1 и с вероятностью

– 0.

4. Мы знаем, что нам требуется максимизировать функцию правдоподобия выборки с учетом принятых факторов для того, чтобы имеющаяся выборка стала наиболее правдоподобной. Другими словами, нам нужно подобрать такие параметры, при которых выборка будет наиболее правдоподобной. В нашем случае подбираемый параметр — это вероятность погашения кредита

, которая в свою очередь зависит от неизвестных коэффициентов

. Значит нам требуется найти такой вектор весов

, при котором правдоподобие выборки будет максимальным.

5. Мы знаем, что для максимизации функции правдоподобия выборки можно использовать метод максимального правдоподобия. И мы знаем все хитрые приемы для работы с этим методом.

Вот такая многоходовочка получается

А теперь вспомним, что в самом начале статьи мы хотели вывести два вида функции потерь Logistic Loss в зависимости от того как обозначаются классы объектов. Так повелось, что в задачах классификации с двумя классами, классы обозначают как

и

или

. В зависимости от обозначения, на выходе будет соответствующая функция потерь.

Случай 1. Классификация объектов на  и

и

Раннее, при определении правдоподобия выборки, в котором вероятность погашения задолженности заемщиком рассчитывалась исходя из факторов и заданных коэффициентов

, мы применили формулу:

На самом деле

— это значение функции логистического отклика

при заданном векторе весов

Тогда нам ничто не мешает записать функцию правдоподобия выборки так:

Бывает так, что иногда, некоторым начинающим аналитикам сложно сходу понять, как эта функция работает. Давайте рассмотрим 4 коротких примера, которые все прояснят:

1. Если

(т.е. в соответствии с обучающей выборкой объект относится к классу +1), а наш алгоритм

определяет вероятность отнесения объекта к классу

равной 0.9, то вот этот кусочек правдоподобия выборки будет рассчитываться так:

2. Если

, а

, то расчет будет таким:

3. Если

, а

, то расчет будет таким:

4. Если

, а

, то расчет будет таким:

Очевидно, что функция правдоподобия будет максимизироваться в случаях 1 и 3 или в общем случае — при правильно отгаданных значениях вероятностей отнесения объекта к классу

.

В связи с тем, что при определении вероятности отнесения объекта к классу

нам не известны только коэффициенты

, то мы их и будем искать. Как и говорилось выше, это задача оптимизации, в которой для начала нам требуется найти производную от функции правдоподобия по вектору весов

. Однако предварительно имеет смысл упростить себе задачу: производную будем искать от логарифма функции правдоподобия.

Почему после логарифмирования, в функции логистической ошибки, мы поменяли знак с

на

. Все просто, так как в задачах оценки качества модели принято минимизировать значение функции, то мы умножили правую часть выражения на

и соответственно вместо максимизации, теперь минимизируем функцию.

Собственно, сейчас, на ваших глазах была много страдальчески выведена функция потерь — Logistic Loss для обучающей выборки с двумя классами:

и

.

Теперь, для нахождения коэффициентов, нам потребуется всего лишь найти производную функции логистической ошибки и далее, используя численные методы оптимизации, такие как градиентный спуск или стохастический градиентный спуск, подобрать наиболее оптимальные коэффициенты

. Но, учитывая, уже не малый объем статьи, предлагается провести дифференцирование самостоятельно или, быть может, это будет темой для следующей статьи с большим количеством арифметики без столь подробных примеров.

Случай 2. Классификация объектов на  и

и

Подход здесь будет такой же, как и с классами

и

, но сама дорожка к выводу функции потерь Logistic Loss, будет более витиеватой. Приступаем. Будем для функции правдоподобия использовать оператор «если…, то…». То есть, если

-ый объект относится к классу

, то для расчета правдоподобия выборки используем вероятность

, если объект относится к классу

, то в правдоподобие подставляем

. Вот так выглядит функция правдоподобия:

На пальцах распишем как это работает. Рассмотрим 4 случая:

1. Если

и

, то в правдоподобие выборки «пойдет»

2. Если

и

, то в правдоподобие выборки «пойдет»

3. Если

и

, то в правдоподобие выборки «пойдет»

4. Если

и

, то в правдоподобие выборки «пойдет»

Очевидно, что в 1 и 3 случае, когда вероятности были правильно определены алгоритмом, функция правдоподобия будет максимизироваться, то есть именно это мы и хотели получить. Однако, такой подход достаточно громоздок и далее мы рассмотрим более компактную запись. Но для начала, логарифмируем функцию правдоподобия с заменой знака, так как теперь мы будем минимизировать ее.

Подставим вместо

выражение

:

Упростим правое слагаемое под логарифмом, используя простые арифметические приемы и получим:

А теперь настало время избавиться от оператора «если…, то…». Заметим, что когда объект

относится к классу

, то в выражении под логарифмом, в знаменателе,

возводится в степень

, если объект относится к классу

, то $e$ возводится в степень

. Следовательно запись степени можно упростить — объединить оба случая в один:

. Тогда функция логистической ошибки примет вид:

В соответствии с правилами логарифмирования, перевернем дробь и вынесем знак «

» (минус) за логарифм, получим:

Перед вами функция потерь logistic Loss, которая применяется в обучающей выборке с объектами относимых к классам:

и

.

Что ж, на этом моменте я откланиваюсь и мы завершаем статью.

Предыдущая работа автора — «Приводим уравнение линейной регрессии в матричный вид»

Вспомогательные материалы

1. Литература

1) Прикладной регрессионный анализ / Н. Дрейпер, Г. Смит – 2-е изд. – М.: Финансы и статистика, 1986 (перевод с английского)

2) Теория вероятностей и математическая статистика / В.Е. Гмурман — 9-е изд. — М.: Высшая школа, 2003

3) Теория вероятностей / Н.И. Чернова — Новосибирск: Новосибирский государственный университет, 2007

4) Бизнес-аналитика: от данных к знаниям / Паклин Н. Б., Орешков В. И. — 2-е изд. — Санкт-Петербург: Питер, 2013

5) Data Science Наука о данных с нуля / Джоэл Грас — Санкт-Петербург: БХВ Петербург, 2017

6) Практическая статистика для специалистов Data Science / П.Брюс, Э.Брюс — Санкт-Петербург: БХВ Петербург, 2018

2. Лекции, курсы (видео)

1) Суть метода максимального правдоподобия, Борис Демешев

2) Метод максимального правдоподобия в непрерывном случае, Борис Демешев

3) Логистическая регрессия. Открытый курс ODS, Yury Kashnitsky

4) Лекция 4, Евгений Соколов (с 47 минуты видео)

5) Логистическая регрессия, Вячеслав Воронцов

3. Интернет-источники

1) Линейные модели классификации и регрессии

2) Как легко понять логистическую регрессию

3) Логистическая функция ошибки

4) Независимые испытания и формула Бернули

5) Баллада о ММП

6) Метод максимального правдоподобия

7) Формулы и свойства логарифмов

Почему число ?

9) Линейный классификатор

9) Jupyter notebook на гитхабе

Эту функцию называют также «логлосс» (logloss / log_loss), перекрёстной / кросс-энтропией (Cross Entropy) и часто используют в задачах классификации. Разберёмся, почему её используют и какой смысл она имеет. Для чтения поста нужна неплохая ML-математическая подготовка, но даже новичкам я бы рекомендовал почитать (хотя я не очень заботился, чтобы «всё объяснялось на пальцах»).

Начнём издалека…

Вспомним, как решается задача линейной регрессии. Итак, мы хотим получить линейную функцию (т.е. веса w), которая приближает целевое значение с точностью до ошибки:

Здесь мы предположили, что ошибка нормально распределена, x – признаковое описание объекта (возможно, в нём есть и фиктивный константный признак, чтобы в линейной функции был свободный член). Тогда мы знаем как распределены ответы нашей функции и можем записать функцию правдоподобия выборки (т.е. произведение плотностей, в которые подставлены значения из обучающей выборки) и воспользоваться методом максимального правдоподобия (в котором для определения значений параметров берётся максимум правдоподобия, а чаще – его логарифма):

В итоге оказывается, что максимизация правдоподобия эквивалентна минимизации среднеквадратичной ошибки (MSE), т.е. эта функция ошибки не зря широко используется в задачах регрессии. Кроме того, что она вполне логична, легко дифференцируема по параметрам и легко минимизируется, она ещё и теоретически обосновывается с помощью метода максимального правдоподобия в случае, если линейная модель соответствует данным с точностью до нормального шума.

Давайте ещё посмотрим, как реализуется метод стохастического градиента (SGD) для минимизации MSE: надо взять производную функции ошибки для конкретного объекта и записать формулу коррекции весов в виде «шага в сторону антиградиента»:

Получили, что веса линейной модели при её обучении методом SGD корректируются с помощью добавки вектора признаков. Коэффициент, с которым добавляют, зависит от «агрессивности алгоритма» (параметр альфа, который называют темпом обучения) и разности «ответ алгоритма – правильный ответ». Кстати, если разница нулевая (т.е. на данном объекте алгоритм выдаёт точный ответ), то коррекция весов не производится.

Log Loss

Теперь давайте, наконец, поговорим о «логлоссе». Рассматриваем задачу классификации с двумя классами: 0 и 1. Обучающую выборку можно рассматривать, как реализацию обобщённой схемы Бернулли: для каждого объекта генерируется случайная величина, которая с вероятностью p (своей для каждого объекта) принимает значение 1 и с вероятностью (1–p) – 0. Предположим, что мы как раз и строим нашу модель так, чтобы она генерировала правильные вероятности, но тогда можно записать функцию правдоподобия:

После логарифмирования правдоподобия получили, что его максимизация эквивалентна минимизации последнего записанного выражения. Именно его и называют «логистической функции ошибки». Для задачи бинарной классификации, в которой алгоритм должен выдать вероятность принадлежности классу 1, она логична ровно настолько, насколько логична MSE в задаче линейной регрессии с нормальным шумом (поскольку обе функции ошибки выводятся из метода максимального правдоподобия).

Часто гораздо более понятна такая запись logloss-ошибки на одном объекте:

Отметим неприятное свойство логосса: если для объекта 1го класса мы предсказываем нулевую вероятность принадлежности к этому классу или, наоборот, для объекта 0го – единичную вероятность принадлежности к классу 1, то ошибка равна бесконечности! Таким образом, грубая ошибка на одном объекте сразу делает алгоритм бесполезным. На практике часто логлосс ограничивают каким-то большим числом (чтобы не связываться с бесконечностями).

Если задаться вопросом, какой константный алгоритм оптимален для выборки из q_1 представителей класса 1 и q_0 представителей класса 0, q_1 + q_0 = q , то получим

Последний ответ получается взятием производной и приравниванием её к нулю. Описанную задачу приходится решать, например, при построении решающих деревьев (какую метку приписывать листу, если в него попали представители разных классов). На рис. 2 изображён график log_loss-ошибки константного алгоритма для выборки из четырёх объектов класса 0 и 6 объектов класса 1.

Представим теперь, что мы знаем, что объект принадлежит к классу 1 вероятностью p, посмотрим, какой ответ оптимален на этом объекте с точки зрения log_loss: матожидание нашей ошибки

Для минимизации ошибки мы опять взяли производную и приравняли к нулю. Мы получили, что оптимально для каждого объекта выдавать его вероятность принадлежности к классу 1! Таким образом, для минимизации log_loss надо уметь вычислять (оценивать) вероятности принадлежности классам!

Если подставить полученное оптимальное решение в минимизируемый функционал, то получим энтропию:

Это объясняет, почему при построении решающих деревьев в задачах классификации (а также случайных лесов и деревьях в бустингах) применяют энтропийный критерий расщепления (ветвления). Дело в том, что оценка принадлежности к классу 1 часто производится с помощью среднего арифметического меток в листе. В любом случае, для конкретного дерева эта вероятность будет одинакова для всех объектов в листе, т.е. константой. Таким образом, энтропия в листе примерно равна логлосс-ошибке константного решения. Используя энтропийный критерий мы неявно оптимизируем логлосс!

В каких пределах может варьироваться logloss? Ясно, что минимальное значение 0, максимальное – +∞, но эффективным максимальным можно считать ошибку при использовании константного алгоритма (вряд же мы в итоге решения задачи придумаем алгоритм хуже константы?!), т.е.

Интересно, что если брать логарифм по основанию 2, то на сбалансированной выборке это отрезок [0, 1].

Связь с логистической регрессией

Слово «логистическая» в названии ошибки намекает на связь с логистической регрессией – это как раз метод для решения задачи бинарной классификации, который получает вероятность принадлежности к классу 1. Но пока мы исходили из общих предположений, что наш алгоритм генерирует эту вероятность (алгоритмом может быть, например, случайный лес или бустинг над деревьями). Покажем, что тесная связь с логистической регрессией всё-таки есть… посмотрим, как настраивается логистическая регрессия (т.е. сигмоида от линейной комбинации) на эту функцию ошибки методом SGD.

Как видим, корректировка весов точно такая же, как и при настройке линейной регрессии! На самом деле, это говорит о родстве разных регрессий: линейной и логистической, а точнее, о родстве распределений: нормального и Бернулли. Желающие могут внимательно почитать лекцию Эндрю Ына.

Во многих книгах логистической функцией ошибки (т.е. именно «logistic loss») называется другое выражение, которое мы сейчас получим, подставив выражение для сигмоиды в logloss и сделав переобозначение: считаем, что метки классов теперь –1 и +1, тогда

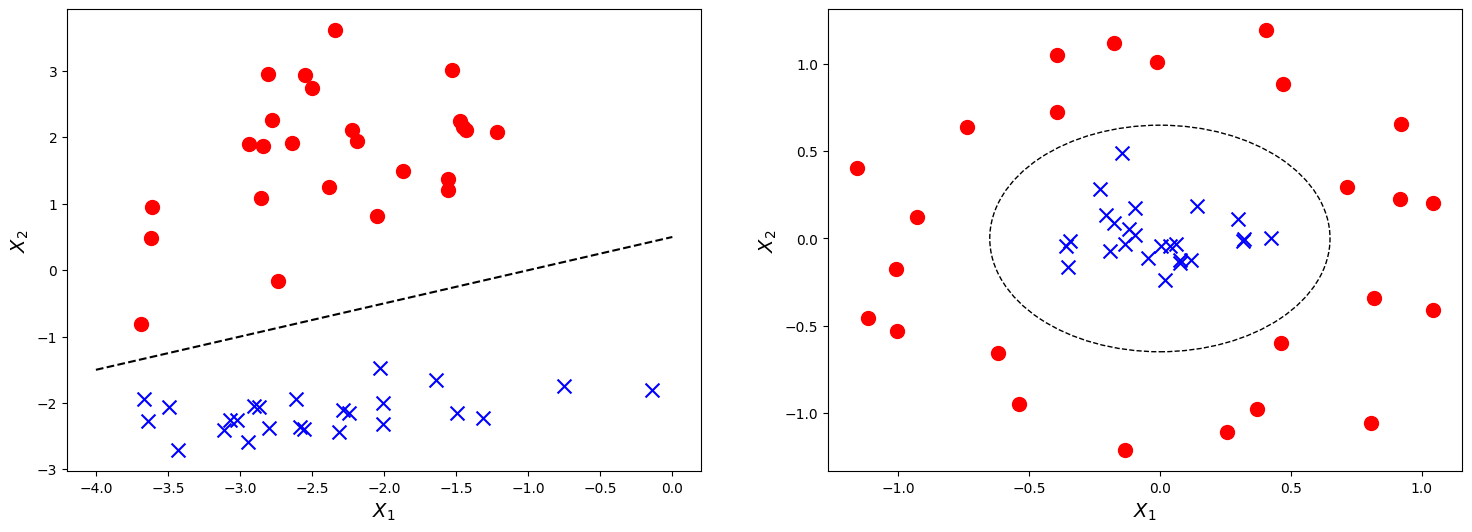

Полезно посмотреть на график функции, центральной в этом представлении:

Как видно, это сглаженный (всюду дифференцируемый) аналог функции max(0, x), которую в глубоком обучении принято называть ReLu (Rectified Linear Unit). Если при настройке весов минимизировать logloss, то таким образом мы настраиваем классическую логистическую регрессию, если же использовать ReLu, чуть-чуть подправить аргумент и добавить регуляризацию, то получаем классическую настройку SVM:

выражение под знаком суммы принято называть Hinge loss. Как видим, часто с виду совсем разные методы можно получать «немного подправив» оптимизируемые функции на похожие. Между прочим, при обучении RVM (Relevance vector machine) используется тоже очень похожий функционал:

Связь с расхождением Кульбака-Лейблера

Расхождение (дивергенцию) Кульбака-Лейблера (KL, Kullback–Leibler divergence) часто используют (особенно в машинном обучении, байесовском подходе и теории информации) для вычисления непохожести двух распределений. Оно определяется по следующей формуле:

где P и Q – распределения (первое обычно «истинное», а второе – то, про которое нам интересно, насколько оно похоже на истинное), p и q – плотности этих распределений. Часто KL-расхождение называют расстоянием, хотя оно не является симметричным и не удовлетворяет неравенству треугольника. Для дискретных распределений формулу записывают так:

P_i, Q_i – вероятности дискретных событий. Давайте рассмотрим конкретный объект x с меткой y. Если алгоритм выдаёт вероятность принадлежности первому классу – a, то предполагаемое распределение на событиях «класс 0», «класс 1» – (1–a, a), а истинное – (1–y, y), поэтому расхождение Кульбака-Лейблера между ними

что в точности совпадает с logloss.

Настройка на logloss

Один из методов «подгонки» ответов алгоритма под logloss – калибровка Платта (Platt calibration). Идея очень простая. Пусть алгоритм порождает некоторые оценки принадлежности к 1му классу – a. Метод изначально разрабатывался для калибровки ответов алгоритма опорных векторов (SVM), этот алгоритм в простейшей реализации разделяет объекты гиперплоскостью и просто выдаёт номер класса 0 или 1, в зависимости от того, с какой стороны гиперплоскости объект расположен. Но если мы построили гиперплоскость, то для любого объекта можем вычислить расстояние до неё (со знаком минус, если объект лежит в полуплоскости нулевого класса). Именно эти расстояния со знаком r мы будем превращать в вероятности по следующей формуле:

неизвестные параметры α, β обычно определяются методом максимального правдоподобия на отложенной выборке (calibration set).

Проиллюстрируем применение метода на реальной задаче, которую автор решал недавно. На рис. показаны ответы (в виде вероятностей) двух алгоритмов: градиентного бустинга (lightgbm) и случайного леса (random forest).

Видно, что качество леса намного ниже и он довольно осторожен: занижает вероятности у объектов класса 1 и завышает у объектов класса 0. Упорядочим все объекты по возрастанию вероятностей (RF), разобьем на k равных частей и для каждой части вычислим среднее всех ответов алгоритма и среднее всех правильных ответов. Результат показан на рис. 5 – точки изображены как раз в этих двух координатах.

Нетрудно видеть, что точки располагаются на линии, похожей на сигмоиду – можно оценить параметр сжатия-растяжения в ней, см. рис. 6. Оптимальная сигмоида показана розовым цветом на рис. 5. Если подвергать ответы такой сигмоидной деформации, то логлосс-ошибка случайного леса снижается с 0.37 до 0.33.

Обратите внимание, что здесь мы деформировали ответы случайного леса (это были оценки вероятности – и все они лежали на отрезке [0, 1]), но из рис. 5 видно, что для деформации нужна именно сигмоида. Практика показывает, что в 80% ситуаций для улучшения logloss-ошибки надо деформировать ответы именно с помощью сигмоиды (для меня это также часть объяснения, почему именно такие функции успешно используются в качестве функций активаций в нейронных сетях).

Ещё один вариант калибровки – монотонная регрессия (Isotonic regression).

Многоклассовый logloss

Для полноты картины отметим, что logloss обобщается и на случай нескольких классов естественным образом:

здесь q – число элементов в выборке, l – число классов, a_ij – ответ (вероятность) алгоритма на i-м объекте на вопрос принадлежности его к j-му классу, y_ij=1 если i-й объект принадлежит j-му классу, в противном случае y_ij=0.

На посошок…

В каждом подобном посте я стараюсь написать что-то из мира машинного обучения, что, с одной стороны, просто и понятно, а с другой – изложение этого не встречается больше нигде. Например, есть такой естественный вопрос: почему в задачах классификации при построении решающих деревьев используют энтропийный критерий расщепления? Во всех курсах его (критерий) преподносят либо как эвристику, которую «вполне естественно использовать», либо говорят, что «энтропия похожа на кросс-энтропию». Сейчас стоимость некоторых курсов по машинному обучению достигает нескольких сотен тысяч рублей, но «профессиональные инструкторы» не могут донести простую цепочку:

- в статистической теории обучения настройка алгоритма производится максимизацией правдоподобия,

- в задаче бинарной классификации это эквивалентно минимизации логлосса, а сам минимум как раз равен энтропии,

- поэтому использование энтропийного критерия фактически эквивалентно выбору расщепления, минимизирующего логлосс.

Если Вы всё-таки отдали несколько сотен тысяч рублей, то можете проверить «профессиональность инструктора» следующими вопросами:

- Энтропия в листе примерно равна logloss-ошибке константного решения. Почему не использовать саму ошибку, а не приближённое значение? Или, как часто происходит в задачах оптимизации, её верхнюю оценку?

- Минимизации какой ошибки соответствует критерий расщепления Джини?

- Можно показать, что если в задаче бинарной классификации использовать в качестве функции ошибки среднеквадратичное отклонение, то также, как и для логлосса, оптимальным ответом на объекте будет вероятность его принадлежности к классу 1. Почему тогда не использовать такую функцию ошибки?

Ответы типа «так принято», «такой функции не существует», «это только для регрессии», естественно, заведомо неправильные. Если Вам не ответят с такой же степенью подробности, как в этом посте, то Вы точно переплатили;)

П.С. Что ещё почитать…

В этом блоге я публиковал уже несколько постов по метрикам качества…

- AUC ROC (площадь под кривой ошибок)

- Задачки про AUC (ROC)

- Знакомьтесь, Джини

И буквально на днях вышла классная статья Дмитрия Петухова про коэффициент Джини, читать обязательно:

- Коэффициент Джини. Из экономики в машинное обучение

Кирилл Нестеркин представляет топ 10 самых частых ошибок, которые совершают абсолютно все логисты. Вы наверняка в каких-то пунктах узнаете себя. Этот материал основан на собственном опыте и опыте коллег, в частности Василия Дмитриенко, который поучаствовал косвенно в создании этого топа. Он предоставил информацию, которую я тоже взял за основу. Спасибо ему большое за то, что он поучаствовал в создании данного топа логистических ошибок.

Пойдем по списку в обратном порядке от 10-го к первому. Первые пункты — это те ошибки, которые приводят к максимальным финансовым потерям. Десятый пункт — это минимальные финансовые потери. Скажем так, это больше могут быть репутационные потери или какие-то неприятности в мелких ситуациях.

Этот топ ошибок логистов в основном основан на нашем практическом опыте по экспедированию грузов. Это не работы с собственным транспортом, а именно экспедирование грузов, то есть грубо говоря в сфере посреднических логистических услуг.

Ошибки — это не прерогатива начинающих! У опытных логистов их просто меньше!

- Работа с биржей автоперевозок АвтоТрансИнфо (АТИ)

- Работа с контактами нового клиента

- Контроль исполнения заявки со стороны логиста

- Проблемы с необъективными сроками и формой оплаты

- Проверка заявки перед отправкой

- Проблемы оплаты с НДС и без НДС

- Ошибки в стоимости доставки

- Ошибки в полноте данных для исполнения заявки

- Риски работы под честное слово

- Мошенничество в перевозках и безопасность

Работа с биржей автоперевозок АвтоТрансИнфо (АТИ)

Десятый пункт это неправильная работа с АТИ. любого логиста это происходит бывает выставляет груз забывает про этот груз он где-то висит уходит вниз списка его никто не обновляет соответственно нет нет нет звонков от перевозчиков логист влаги что звонит клиент спрашивает где груз? Особенно такое бывает зоопарке, когда несколько грузов логиста висит.

Он забывает про какой-то груз, не обновляет его, ему никто не звонит. Потом он не понимает, что такое происходит, почему этот груз не закрывается, водители не находятся.

Все банально просто. Работает такая человеческая психология естественно водителям перевозчикам интереснее забрать как можно быстрее груз по максимальной цене. Соответственно они будут смотреть первые строчки списка заявок что есть в нужном направлении и естественно водители в первую очередь звонят по первым строчкам. Грузы надо обновлять чаще, при этом надо корректно выставлять грузы. Любые некорректности или отсутствие значимых данных приводят к потерям времени и денег.

Работа с контактами нового клиента

Пункт номер девять это контакты нового клиента, что я имею под этим в виду? Зачастую бывает так, что клиент какой-то новый звонит на городской телефон на мобильный телефон. Звонит предоставляет какой-то груз. Логист записывает данные или сразу же выставляют в АСИ по этому грузу. Все хорошо, кладет трубку ищет по этому грузу транспорт, но вот проблема контактные данные то этого клиента он забыл записать. Да такое бывает. Иногда бывает так, что люди позвонят на городской номер, логист в спешке, если у него тем более несколько заявок висит, быстренько принял заявку, но не спросил, как вас зовут и как с вами связаться. Зачастую бывает так, что у городских телефонов нет определения номера и логисту уже некуда перезвонить. Или бывает такая ситуация, когда логиста много звонков ему на мобильный и он не записал , как зовут человека, как называется компании не сохранил у себя в контактах телефоне. Потом он просто открывает телефон видит вот такой вот список с разными номерами. Ему там и водители звонят и клиенты и какие-то личные там переговоры и так далее. И такой вот список приходится прозванивать, узнавать не вы ли давали груз. Может быть уже пока дозвонишься до этого человека груз уже заберут какие-то конкуренты, другие транспортные компании. Поэтому такая вот ошибка. Зачастую логисты держат перед собой такой вот блокнотик рабочий, где можно и нужно делать пометки. Принял груз обязательно записал контакты быстренько для себя. Как то это выделил рамочкой, скобками или маркером, что это важный какой-то груз. Но, во всяком случае, здесь уже на бумаге он будет даже если вам звонят на мобильный телефон — все равно записываете сюда номер телефона, кто вам звонил и и обязательно продублируйте номер телефона, потому что потом в длинном списке этих контактов будет тяжело найти этого клиента.

Контроль исполнения заявки со стороны логиста

Пункт номер восемь логист не контролирует исполнение заявки. Он заключил заявку, машина должна загрузиться. с клиентом оформил, с перевозчиком заключил заявку. Но помимо того, что он просто оформил заявки, необходимо все контролировать. Позвонить в день загрузки, позвонить в день следования, вот машина едет позвонить и узнать, как у тебя дела все ли нормально не сломался, где ты едешь. В день выгрузки — все ли нормально подписали тебе документы и так далее. Если не контролировать эту загрузку, то может получиться так, что, например, клиент звонит и спрашивает, а где машина? Почему она долго не едет, а логист понимает, что елки-палки, а я ж не позвонил по этой заявке. Я же не узнал, где он. Логист говорит, что да, сейчас узнаю и вам перезвоню. Это выглядит не очень компетентно, когда логист исполняет заявку, но при этом даже не знает, что происходит с этим водителем. Еще хуже, когда информацию получает первым клиент. Клиент вам звонит и говорит — вы в курсе, что у вас водитель сломался? Это выглядит очень некрасиво и более того, если не контролировать исполнение заявки, то на выгрузке могут произойти какие-то неприятности. Например, долго не выгружают машину, случилась проблема с краном и так далее, нет доверенности, вот тупо нет доверенности. Просто нужно сделать один звоночек, как у тебя дела? Водитель говорит, что на него нет доверенности. Соответственно мы звоним нашему клиенту и говорим, что машину не разгружают из-за отсутствия доверенности. Доверенность предоставляют и заявка исполняется. Это как пример, но ситуации бывают разные и из-за того, что логисты забывают контролировать само исполнение ситуация приходит к такому моменту, что решить оперативно уже сложно. А можно было бы, если контролировать на всем протяжении исполнения.

Проблемы с необъективными сроками и формой оплаты

Пункт номер семь — необъективные сроки и форма оплаты перевозчику. Например, когда клиент говорит, что он будет оплачивать по оригиналам ТТН бухгалтерских документов, а переводчик говорит, что я вам отправлю сканы. Я все отправлю, честное слово. Все вложу и отправлю, как есть. В общем хорошо, логист доверяется словам перевозчика, перевозчик присылает документы, оказывается в конверте нет таки ТТН В итоге вы знаете, что ТТН потерялась, мы не можем выставить документы на оплату клиенту, о перевозчику мы уже оплатили по скану, потому что так договорился логист и происходит такая вот нелепая ситуация. Вроде, как логист поверил в такую форму оплаты, с перевозчиком договорился по сканам, хотя клиент платит по оригиналам. Ну и получается, что нам приходится восстанавливать эти ТТН. Приходится тратить на это время. Перевозчику, как вы понимаете, уже наплевать, потому что он уже свои деньги получил. Он шевелится уже не особо-то хочет. Если клиент платит за 30 дней банковских по оригиналам ТТН, некоторые логисты берут и договаривается по сканам ТТН, да еще и наличкой, а клиент платит НДС, то здесь компания начинает терять, потому что эти деньги мы по сути замораживаем под этого перевозчика. Платим из своих средств, из своего фонда и эти деньги вернутся нам еще не скоро, поэтому вот такая ошибка.

Проверка заявки перед отправкой

Шестой пункт он уже более сильно влияет на финансовую ситуацию в компании. Отсутствие проверки заявки перед отправкой. Такая ошибка бывает и старых и у новых логистов, и опытных и у неопытных — без разницы. Что я имею ввиду, когда логист уже оформил заявку и необходимо отправить перевозчику и заказчику зачастую бывает так, что логист, который находится в запарке какой-то или находится где-то мысленно в другом месте , занят какими-то посторонними делами и так далее, его отвлекают. Тогда он может просто перепутать заявки и отправить заявку с заказчиком на электронку перевозчика, а заявку перевозчика может отправить на электронку заказчику. Происходит такая вот нелепая ситуация — все стороны сделки узнают, кто с кем работает по каким ставкам, по каким срокам оплаты по какой форме оплаты. Логисту приходится оправдываться, как перед переводчиком, так и перед заказчиком, выдумывать какие-то отмазки, поэтому смотрите внимательно перед тем, как отправить заявку по электронной почте и обязательно проверьте ту ли заявку вы прикрепили к вашему электронному письму и туда ли вы ее отправляете. Это очень важно.

Чем больше опыта у логиста, тем более сложные ошибки он совершает!

Проблемы оплаты с НДС и без НДС

Ошибка номер пять, который может привести к тому, что компания может потерять деньги. Я ее так назвал «с НДС и без НДС». Особенно часто это происходит с новичками в логистике, которые еще ненедопонимают, что такое безнал, что такое НДС, что такое без НДС. И зачастую бывают такие ситуации, когда, например, но клиент дал заявку, говорит вот заявка стоит 50 тысяч рублей надо отвезти с Москвы в Уфу от 50000 рублей с НДС. Логист начинает искать по этой заявке перевозчика, находит перевозчика за 45 тысяч рублей и думает о, как здорово сейчас я заработаю 5000 рублей. Это круто, когда приходит время оформления заявки он присылает заявку перевозчику, перевозчик говорит, что вы мне пишете 45 тысяч рублей с НДС — же мы же с вами без НДС договаривались. Новенький логист может не понимать, что с ндс и без ндс абсолютно разные вещи. У нас есть определенная инструкция по этой теме в формате word, как рассчитывается те или иные ситуации, когда клиент платит с НДС и без НДС наличкой, как рассчитываться с перевозчиком. Нужно сделать определенную инструкцию для ваших логистов, чтобы они понимали, что такое с НДС, что такое без НДС и как рассчитывать при этом выгоду со сделки, то есть вашу маржу. Очень важно донести то логистов умение правильно выбирать формы оплаты и понимать, в чем разница между с НДС и без НДС.

Постепенно мы с вами приближаемся к нашей тройки лидеров.

Ошибки в стоимости доставки

Четвертый пункт это некорректная стоимость доставки. Это, когда логист может, например, в транспорте быть, а ему клиент звонит — мне срочно нужно посчитать стоимость доставки. При этом иногда логисты забывают задать какие-то уточняющие вопросы, например, этот заказчик говорит мне нужно отвезти груз из Казани в московскую область , а куда там в московскую область не ясно. Надо было бы задать этому клиенту вопрос, куда именно, а может быть это вообще какой-то дальний район — область большая. Не очень приятно — может быть это вообще несколько точек московской области, может быть это в центре Москвы и тогда это уже вообще проблема. На садовое кольцо, вы сами знаете, заехать не каждый сможет, а он говорит мне рассчитайте стоимость на фуру в московскую область. А на разные районы московской области это совершенно разные ставки. Но клиент торопит и логист в спешке называют какую-то наобум цену. Через неделю этот клиент перезванивает говорит отвезти груз как вы мне называли там за 40 тысяч рублей. Тут логист начинает уже нормально разбираться с заказом, он начинает задавать какие-то конкретные наводящие вопросы и тут понимает, что фактически то он с ценой облажался. Если это клиент новый, то приходится как-то выкручиваться из ситуации, ставить прибыль в ноль, если вы хотите зацепиться за этого клиента. Либо ставить в небольшой минус, если это старый клиент, то приходится как-то оправдываться пытаться хоть что-то здесь выиграть. Хотя бы в ноль или с небольшой маржинальностью.

Такая вот ситуация происходит довольно часто. В итоге это приводит к тому, что фирма теряет деньги.

Ошибки в полноте данных для исполнения заявки

Позиция номер три это, когда логист не указывает полные данные в заявке. Здесь очень важно указывать конкретные четкие данные по дате загрузки, по времени загрузки, особенно маршрут загрузки с полным указанием адреса области, района, региона и так далее. Важно указывать габариты и обязательно какие-то особые требования к погрузке. Например, требуется двенадцать крепежных ремней, требуются коники. Требуется, например, верхняя расстановка со снятием задней балки. Забудет написать дату и время погрузки. Машина приезжает к шести вечера оказывается ее ждали к 14-00, а никто не знал в заявке это не прописано. Клиент кричит, выставляет опоздание, мы ничего не можем предъявить перевозчику, так как мы его об этом не уведомили в письменном виде по поводу населенных пунктов. Логисты зачастую забывают написать, что это определенно какая-то область, не просто там населенный пункт особенно это касается, когда прописывают в заявках акие-то маленькие населенные пункты. Забывают прописать, что это такая-то область нижегородская область и такой-то район. Бывает так, что даже в одном регионе в одной области бывает несколько поселков с одним именем и они находятся на больших расстояниях друг друга. Поэтому обязательно нужно прописывать — какая область, какой район у этого населенного пункта. Все это нужно обязательно указывать в заявке и более того нужно обязательно прописывать контактные данные на выгрузке и на загрузке, чтобы водитель максимально быстро нашел эту загрузку и лишний раз вас не теребил, не спрашивал, как доехать, куда повернуть. То есть обязательно указывать полные данные в заявке максимально полные какие только можно. И, чтобы к вам потом юридически не было никаких вопросов вот эта ситуация может привести действительно к финансовым потерям вплоть до штрафных санкций за срыв погрузки за опоздание это все очень серьезно.

Риски работы под честное слово

Пункт номер два это работа под честное слово, что я имею ввиду этот пункт он вытекает по сути из пункта 3. Очень важно, чтобы у вас было документально закреплены все ваши отношения, как с перевозчиком так и с заказчиком. У вас обязательно должны быть подтвержденные заявки, как минимум с перевозчиком и заказчиком, а еще лучше, чтобы были оформлены договоры либо, чтобы это было договор-заявка, где были прописаны определенные штрафные санкции, требования и обязанности. У нас произошла ситуация, когда, например, наш постоянный клиент подогнал нам скажем так другого клиента. Есть такой вот заказчик — ищет транспорт, помогите ему найти. Мы находим заявку.

При этом клиент грамотно вошел в доверие, что и без заявки там все нормально. Мы не заключили заявку с этим заказчиком и в итоге получилось так, что этот груз оказался ненадлежащего качества. Нам пришлось этот груз возвращать обратно в точку загрузки. При этом клиент не подписал никакие ТТН, не подписал заявки, договор не подписал и мы не можем подать в суд и обосновать сумму претензии. Работа под честное слово это худшее, что можно придумать. Под любыми предлогами обязательно требуйте подтвержденные заявки от заказчика и тем более от переводчика. Это все очень важно, потому что это действительно приводит к серьезным финансовым потерям. Если перевозчик вам сорвал загрузку, то заказчик естественно вам выставит штраф, перевозчику вы в свою очередь ничего не сможете предъявить, потому что заявки, так как таковой и нет. Это всё серьёзно, к этому нужно отнестись очень внимательно.

Ошибок не совершает только тот, кто ничего не делает! Вопрос только в том все ли вы делаете, чтобы их было меньше!

Мошенничество в перевозках и безопасность