Человечество уже многие свои фантазии воплотило в реальность. От карманных компьютеров до автомобилей с автопилотом и от виртуальной реальности до космического туризма. А теперь в жизнь воплощается и искусственный интеллект. Человечество постепенно стирает границы фантазии и вымысла посредством современных исследований и технологий.

Искусственный интеллект (далее ИИ) в настоящее время представляет собой перспективное направление, на которое ориентируются многие компании. Искусственный интеллект — это область науки, которая изучает работу аппаратных и программных компонентов, а именно их интеллектуальное поведение. Вместо того, чтобы получать информацию от пользователя, такие машины самостоятельно обучаются и становятся умнее.

Читайте также: Кто предсказал Интернет?

В настоящее время над проектами ИИ работают многие компании, включая Microsoft, Google, Facebook и другие. В Южной Корее также есть несколько высококлассных проектов по искусственному интеллекту. А теперь представьте, что это лишь те компании, которые заявили об этом официально. Не стоит забывать, что наверняка есть много компаний, которые втайне работают над проектами искусственного интеллекта.

Искусственный интеллект, который когда-то считался живым лишь в человеческом воображении, сегодня вполне реален. Уже сейчас ИИ стал предметом большого интереса для многих лидеров в индустрии высоких технологий.

Почему искусственный интеллект должен нас беспокоить?

Сначала это был Стивен Хокинг , затем Илон Маск и совсем недавно Билл Гейтс. Эти великие умы человечества предполагают, что за ИИ нужно пристально следить.

Генерального директора Тесла, Илона Маска однажды спросили, что он думает об искусственном интеллекте. Он ответил, что это как «вызов демона», которого нельзя призывать, если не можете его контролировать.

Когда Стивену Хокингу был задан этот же вопрос, то он предупредил публику. Он сказал, что любое дальнейшее исследование искусственного интеллекта может быть фатальной ошибкой. Он упомянул, что развитый ИИ будет обладать способностью переделывать, усовершенствовать себя. Такой интеллект сможет эволюционировать самостоятельно с огромной скоростью. Людям такая скорость эволюции недоступна, что ставит человечество в заведомо на более низкую ступень развития по сравнению с ИИ.

По словам Билла Гейтса, устройства с искусственным интеллектом поначалу будут простыми. Но со временем они будут узнавать все больше о нас и о нашем мире. Они будут становиться все более могущественными и интеллектуальными, чем человечество.

Риски искусственного интеллекта

Существует четыре класса риска, создаваемого искусственным интеллектом:

1. Программная враждебность

Один из сценариев, когда ИИ может быть опасным, заключается в том, что он будет специально запрограммирован на враждебность. Например, со стороны военных или террористической группы, для достижения каких-то своих целей.

Еще один возможный сценарий враждебного искусственного интеллекта предполагает несовпадение глобальных целей, его и человечества. Что если расчеты искусственного интеллекта приведут к тому, что единственный способ достичь цели — это уничтожить всех людей? Вполне возможно, что это может спровоцировать его начать войну с человечеством.

Главная проблема в том, что ИИ не человек, и вряд ли с ним получится договориться. Его главным приоритетом будет выполнение глобальной задачи любой ценой. Поэтому война будет длиться, пока воля или способность человечества противостоять не будут уничтожены.

2. Пассивный риск

Фактически нет риска пассивной опасности от ИИ с приоритетными целями дружелюбности. Однако риск почти неизбежен от ИИ без таких целей. Пассивный ИИ может быть опасен просто потому, что он не учитывает безопасность человека, как это делают все люди.

Например, взять ИИ без целей дружелюбия, отвечающий за обработку посевов пестицидами. Этот ИИ будет обрабатывать поле, даже если знает, что в этот момент на поле находятся люди.

3. Случайный риск

Искусственный интеллект, работающий с неполными данными, способен ошибиться точно также, как и человек. Ошибки такого рода почти неизбежны, поскольку невозможно знать все обо всем в мире.

Однако, данный риск является наименее опасным, поскольку ИИ способен учиться на собственном опыте. Любые происшествия уменьшают вероятность повторения ошибки в будущем, улучшая ИИ, и делая его более безопасным.

4. Риск непостижимости

Реальная опасность хорошо спроектированного искусственного интеллекта заключается в его способности перепрограммировать и бесконечно совершенствовать себя. Такой ИИ, способный к самосовершенствованию, может в конечном итоге превзойти ограничения человеческого интеллекта.

Когда существует искусственный интеллект, который умнее любого человека на Земле, становится невозможно полностью понять его. Такой ИИ также, вероятно, будет продолжать улучшать себя все быстрее и быстрее. Ведь каждое новое открытие или технология только ускоряют этот процесс. И именно это будет делать его все более и более невозможным для понимания людьми.

Кроме того, в какой-то момент ИИ может обнаружить законы причинности или логики, выходящие далеко за пределы понимания человеческого разума. Тогда возможности того, что он может сделать, становятся просто бесконечными.

Заключение

Хотя существует множество гипотез об опасном искусственном интеллекте, мы должны понимать, что это всего лишь предположения, а не факты. Люди всегда сомневались в новых технологиях, и было время, когда мы также боялись сотовых телефонов. В конце концов, речь идет о том, каким мы создадим искусственный интеллект и как мы будем его контролировать.

Правовые вопросы также становятся все более актуальными, поскольку существующие законы и нормы не всегда соответствуют возможностям и вызовам, которые представляет собой ИИ. Некоторые из важных правовых аспектов, связанных с ИИ, включают в себя вопросы ответственности за ошибки и повреждения, вызванные ИИ, а также защиту интеллектуальной собственности и авторских прав.

Цель урока: получить общее представление о том, какими этическими, правовыми и социальными последствиями может быть чревато использование искусственного интеллекта.

Не менее разнообразными могут быть и социальные последствия использования ИИ. Например, ИИ может привести к автоматизации трудовых процессов, что может повлечь за собой потерю рабочих мест. Также ИИ может влиять на социальную мобильность, образование и доступ к ресурсам. И в нашем заключительном уроке мы поговорим на каждую из этих тем.

Содержание:

- Этические последствия использования искусственного интеллекта

- Правовые последствия использования искусственного интеллекта

- Задание на взаимопроверку

- Социальные последствия использования искусственного интеллекта

- Проверочный тест

Выделить какую-то наиболее значимую категорию последствий достаточно сложно, т.к. все они имеют очень больше значение. Но начнем мы именно с этических последствий, т.к. эта категория кажется нам одной из самых интересных.

Этические последствия использования искусственного интеллекта

Говоря об этических последствиях использования искусственного интеллекта, обычно рассматривают такие важные проблемы, как безопасность, приятие решений и забота о том, чтобы ИИ не угнетал права и свободы человека.

Кроме того, некоторые специалисты считают, что использование ИИ может привести к принятию решений, ущемляющих права и свободы человека. Например, если говорить об автоматизации труда, ИИ может заменить человека на рабочем месте, что может привести к массовой безработице и социальному неравенству. Однако, несмотря на эти опасения, внедрение ИИ может также привести к новым возможностям и созданию новых рабочих мест. Вопрос, опять же, в грамотном и продуманном подходе.

Также важно обеспечить заботу о том, чтобы ИИ не нарушал нравственных принципов. В частности, в отношении некоторых алгоритмов ИИ, которые могут привести к дискриминации и угнетению некоторых групп населения, необходимо обеспечивать контроль за их применением и учитывать мнение общества. В этой связи, кстати, уже были предложены концепции «обратной связи» и «открытого алгоритма» для учета мнения пользователей и общества при разработке ИИ [B. Lepri, N. Oliver, E. Letouzé, A. Pentland, 2018].

В целом же, среди этических последствий применения искусственного интеллекта можно выделить следующие:

- Автономия и ответственность ИИ. Искусственный интеллект может стать автономным и принимать решения, не контролируемые человеком, что может привести к непредсказуемым последствиям. В связи с этим возникает вопрос о том, кто несет ответственность за действия ИИ и как обеспечить его прозрачность и объективность.

- Дискриминация и предвзятость. ИИ может воспроизводить стереотипы и дискриминацию, основанные на поле, расе, возрасте и других характеристиках. Это вызывает необходимость обеспечения справедливости и недискриминации в разработке ИИ и его применении.

- Конфиденциальность и защита личных данных. Использование ИИ может привести к сбору и обработке большого количества личных данных, что требует обеспечения их конфиденциальности и защиты от неправомерного использования.

- Этика использования ИИ в военных целях. Использование ИИ в военных целях вызывает вопросы о моральности таких действий, а также о возможных последствиях в случае ошибок или непреднамеренных проблем в работе ИИ.

- Влияние на рабочие места. Развитие ИИ может привести к автоматизации ряда профессий и увольнению работников, что вызывает вопросы о социальной ответственности за использование ИИ в целях повышения эффективности производства.

- Вопросы, связанные с тестированием ИИ. Тестирование ИИ может вызвать этические проблемы, такие как применение тестов, основанных на стереотипах, и возможность причинения вреда или ущерба участникам при тестировании.

- Права животных. Использование ИИ может вызывать вопросы о правах животных, если они становятся объектом экспериментов или злоупотребления в процессе тестирования искусственного интеллекта.

- Вопросы использования ИИ в медицине. Использование ИИ в медицине вызывает вопросы, связанные с конфиденциальностью медицинской информации, прозрачностью диагностики и лечения, а также ответственностью за действия ИИ в области здравоохранения.

- Этика использования ИИ в общественной жизни. Использование ИИ в общественной жизни способно вызывать вопросы о приватности, мониторинге граждан, использовании ИИ для принятия решений о распределении ресурсов и т.д.

- Риски, связанные с разработкой и применением ИИ. Использование ИИ вызывает опасения, связанные с технологическими рисками, рисками аварий, техногенных катастроф и т.п.

Очевидно, что использование искусственного интеллекта создает не только новые возможности, но и новые этические вопросы и вызовы. Поэтому необходимо проводить дальнейшие исследования и разрабатывать этические стандарты и методики регулирования, чтобы обеспечить максимальную безопасность, справедливость и ответственность при использовании ИИ.

Правовые последствия использования искусственного интеллекта

Правовые последствия использования ИИ предполагают, как правило, юридические аспекты, такие как ответственность за действия ИИ, авторские права на созданные ИИ материалы, а также защита личных данных.

Одной из главных правовых проблем, связанных с использованием ИИ, является определение ответственности за его действия. Вопрос о том, кто несет ответственность за вред, нанесенный ИИ, остается не до конца разрешенным. Некоторые представители правовой общественности отмечают необходимость разработки новых законов и нормативных актов, чтобы определить права и обязанности при использовании ИИ [P. De Filippi, A. Wright, 2018].

Также актуальны вопросы об авторских правах на материалы, созданные ИИ. Некоторые специалисты в области юриспруденции предлагают изменить существующие законы об авторских правах, чтобы они отражали реальность создания ИИ того или иного материала (статьи, текста, изображения, видео и т.п.) [E. Bruch, 2017].

Не менее важным является вопрос защиты личных данных. Использование ИИ может привести к сбору и обработке больших объемов личных данных, что может нарушить права на приватность и конфиденциальность. В связи с этим многие страны разрабатывают новые нормативные акты, которые регулируют использование личных данных в контексте ИИ [G. R. Milne, M. J. Culnan, 2019].

Среди ключевых правовых последствий применения искусственного интеллекта можно выделить:

- Ответственность за действия ИИ. Использование ИИ вызывает вопросы о юридической ответственности и о том, как эта ответственность должна быть распределена между различными сторонами.

- Авторские права. Использование ИИ может привести к нарушению авторских прав, если он использует защищенный авторским правом контент без разрешения правообладателя. Это ставит нас перед необходимостью обеспечить соблюдение авторских прав в контексте использования ИИ.

- Защита личных данных. Использование ИИ требует сбора и обработки большого количества личных данных, что может нарушать права на конфиденциальность и защиту личной жизни. Для защиты личных данных необходимо разрабатывать новые правовые механизмы.

- Регулирование ИИ. В связи с возможностью принятия ИИ автономных решений появляются вопросы о необходимости регулирования ИИ, чтобы обеспечить его безопасность и эффективность.

- Работа с ИИ и занятость. Использование ИИ способно привести к увольнению работников в некоторых отраслях, что вызывает вопросы о социальной ответственности за использование ИИ в целях повышения эффективности производства и поддержания занятости.

- Налоговое регулирование. Применение ИИ может привести к изменению налогового режима и требует правовых механизмов, которые обеспечат справедливое налогообложение в условиях использования новых технологий.

- Правовые вопросы, связанные с использованием ИИ в медицине. Использование ИИ в медицине вызывает правовые вопросы, связанные с защитой медицинской конфиденциальности, прозрачностью использования ИИ и ответственностью за его действия.

- Правовые вопросы, связанные с использованием ИИ в общественной жизни. Применение ИИ в общественной жизни может вызвать вопросы о защите прав на приватность и личную жизнь граждан, а также о том, как ИИ влияет на общественный порядок.

- Этика использования ИИ в военных целях. Использование ИИ в военных целях поднимает вопросы о соответствии его деятельности международному праву и нормам, а также о применении ИИ в боевых действиях.

- Нормативное регулирование. Применение ИИ требует нормативного регулирования для обеспечения его эффективности и безопасности. Необходимо разрабатывать новые правовые механизмы, которые обеспечат эффективное использование ИИ и защиту прав и свобод граждан.

Здесь мы снова видим широкий спектр правовых последствий, которые могут возникнуть в случае все большего внедрения ИИ в жизнь людей. Исходя из этого, необходимо разрабатывать соответствующие законы и правила, которые смогут обеспечить справедливость, прозрачность и ответственность при использовании ИИ и которые будут соответствовать нормам международного права.

Задание на взаимную проверку

Не торопитесь переходить к следующему разделу. Самое время немного пораскинуть мозгами и пофилософствовать. В этом задании вам потребуется написать еще одно небольшое эссе.

Вернитесь к любому из предыдущих разделов об этических или правовых последствиях использования ИИ и сформулируйте ряд тематических вопросов, связанных с использованием ИИ.

Вот несколько примеров таких вопросов:

- Какие права на конфиденциальность и безопасность данных существуют в области использования искусственного интеллекта?

- Как искусственный интеллект влияет на рынок труда и какие последствия это может иметь для нашего общества?

- Какие этические проблемы могут возникнуть, когда искусственный интеллект используется в сфере медицины и здравоохранения?

- Какое влияние может оказать искусственный интеллект на нашу культуру и общество?

Выберите один из своих вопросов и напишите эссе, рассказывающее о проблеме и о том, как использование искусственного интеллекта может повлиять на нее, в том числе негативно. Предложите возможные меры, которые помогут предотвратить негативные последствия и усилить позитивные.

Это задание на взаимную проверку, поэтому сначала вам нужно проверить две работы других пользователей, а затем загрузить свою. При проверке чужих работ оценивайте глубину рассмотрения темы, реалистичность идей и эффективность мер предотвращения негативных и усиления позитивных последствий. Объем эссе – не более 500 слов.

Социальные последствия использования искусственного интеллекта

Одним из ключевых социальных вопросов, связанных с ИИ, является вопрос о том, как он может повлиять на рабочую силу и рынок труда. Некоторые исследователи предсказывают, что ИИ может заменить людей в ряде профессий и вызвать значительную безработицу в ближайшие десятилетия [C. B. Frey, M. A. Osborne, 2017]. Однако другие исследователи утверждают, что ИИ создаст новые рабочие места и повысит производительность [J. Manyika, M. Chui, M. Miremadi, J. Bughin, 2017].

Другой важный социально значимый вопрос, связанный с ИИ, состоит в том, как он может повлиять на здравоохранение. Ряд исследователи считает, что ИИ способен помочь в диагностике и лечении болезней, а также снизить затраты на здравоохранение [E. J. Topol, 2019]. Однако есть опасения, что использование ИИ может привести к неравенству в доступе к здравоохранению и возможным нарушениям прав пациентов [B. D. Mittelstadt, L. Floridi, 2016].

Помимо прочего, использование ИИ может привести к усугублению социальных различий и неравенства, т.к. определенные группы людей смогут получать доступ к более продвинутым технологиям, в то время как другие будут лишены такой возможности [V. Eubanks, 2018].

К основным социальным последствиям применения искусственного интеллекта можно отнести:

- Автоматизация рабочих мест. Использование ИИ может привести к автоматизации ряда профессий и увольнению работников, что вызывает вопросы о социальной ответственности использования ИИ в целях повышения эффективности производства и поддержания занятости.

- Социальное неравенство. Применение ИИ способно привести к появлению нового социального неравенства, основанного на доступности и знаниях в области ИИ. Это вызывает вопросы о доступности обучения и подготовки к использованию технологии для всех слоев общества.

- Недоступность ИИ для определенных групп населения. Использование ИИ может оказаться недоступным для определенных групп населения, таких как люди с ограниченными возможностями или граждане, живущие в удаленных регионах.

- Использование ИИ для мониторинга граждан. Применение ИИ для мониторинга граждан вызывает вопросы о приватности и нарушении прав на личную жизнь, а также о том, как гарантировать безопасность и справедливость использования ИИ в контексте такого мониторинга.

- Влияние ИИ на образование и обучение. Использование ИИ в образовании и обучении вызывает вопросы о качестве образования и о том, как ИИ может помочь в повышении качества образования и доступности к обучению либо повлиять на это негативно.

- Влияние ИИ на принятие решений о распределении ресурсов. Применение ИИ для принятия решений о распределении ресурсов вызывает вопросы о справедливости и прозрачности таких решений, а также о том, как обеспечить доступность ресурсов для всех слоев общества.

- Влияние ИИ на межличностные отношения. Использование ИИ может привести к изменению межличностных отношений, например, в связи с использованием роботов и виртуальных помощников. Это вызывает вопросы о том, как обеспечить социальную адаптацию и взаимодействие между людьми и ИИ.

- Влияние ИИ на здоровье и благополучие. Применение ИИ в медицине способно привести к улучшению диагностики и лечения, но также вызывает вопросы о защите личных данных, конфиденциальности и ответственности за действия ИИ в области здравоохранения.

- Влияние ИИ на культуру и творчество. Использование ИИ в культуре и творчестве вызывает вопросы о роли человека в творческом процессе, а также о том, как ИИ может быть использован для создания новых форм искусства.

- Риски, связанные с разработкой и применением ИИ. Применение ИИ, как мы уже говорили, вызывает опасения, связанные с технологическими рисками, рисками аварий, техногенных катастроф и т.п.

Как и в других случаях, использование ИИ может повлиять на социальную сферу, вызвав изменения во множестве различных областей жизни человека. Для минимизации конкретно негативных последствий необходимо проводить дальнейшие исследования и разрабатывать стратегии социальной ответственности в области ИИ.

Помимо прочего, несложно заметить, что изменения в одной области тесно связаны с изменениями в другой, по причине чего любые последствия необходимо рассматривать комплексно и во взаимосвязи друг с другом. Это также говорит и о том, что необходимо более глубокое исследование этих вопросов и разработка соответствующих мер, чтобы максимизировать позитивные эффекты и минимизировать негативные.

Думаем, что на этом вполне можно завершить и заключительный урок, и курс вообще. Естественно, мы рассмотрели далеко не все вопросы, касающиеся искусственного интеллекта, но полученной информации должно быть достаточно, чтобы получить общее представление о том, что вообще такое искусственный интеллект, как с ним работать, какие результаты можно получать и к чему это может привести в перспективе.

Напоследок же предлагаем вам пройти закрепить материал урока с помощью нашего традиционного теста.

Проверьте свои знания

Если вы хотите проверить свои знания по теме данного урока, можете пройти небольшой тест, состоящий из нескольких вопросов. В каждом вопросе правильным может быть только один вариант. После выбора вами одного из вариантов система автоматически переходит к следующему вопросу. На получаемые вами баллы влияет правильность ваших ответов и затраченное на прохождение время. Обратите внимание, что вопросы каждый раз разные, а варианты перемешиваются.

И в заключение нашего краткого курса по основам искусственного интеллекта предлагаем пройти экзамен по всему изученному материалу.

Какие последствия может вызвать сбой в программе искусственного интеллекта и как этого избежать?

На чтение 3 мин Опубликовано 21.06.2021 Обновлено 28.08.2022

Фантастический мир будущего из рассказов футурологов оказался реальным уже сегодня. Человечество в полной мере пользуется услугами искусственного интеллекта и планирует развиваться в этой сфере. Вред или польза влияния ИИ ждет мир в ближайшем будущем – главный вопрос программных разработчиков.

Содержание

- ИИ в повседневном быту

- Возможные сценарии событий

- Борьба с надвигающейся угрозой

ИИ в повседневном быту

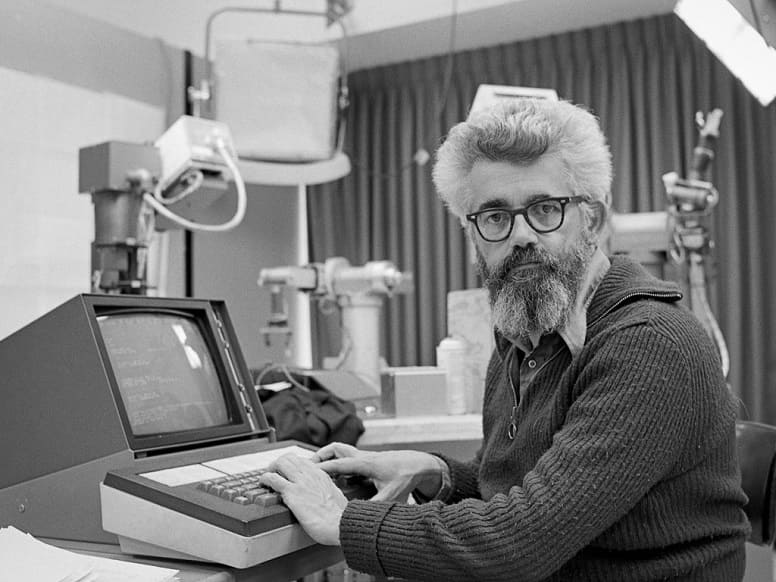

Понятие «искусственного интеллекта» ввел Джон Маккарти 65 лет назад. Однако некоторые обыватели отрицают существование ИИ. Все дело в том, что человечество ждет от искусственного разума умений сверхмашины, способной поработить окружающий мир, тогда как привычный калькулятор тоже считается ИИ.

Поэтому разработчики ввели понятие слабого ИИ и универсального ИИ, который в будущем достигнет уровня человеческого разума и сможет решать сложные интеллектуальные вопросы.

Современная жизнь обычного человека сопровождается использованием ИИ. Голосовой помощник в мобильном телефоне выполняет команды, робот-пылесос поддерживает чистоту в доме, а банкомат выдает деньги. Польза для общества, которую несет ИИ, неоспорима. Однако главы ведущих компаний – Илон Маск и Билл Гейтс, высказывают опасения, связанные с резким развитием в области ИИ для человека.

Возможные сценарии событий

Внедрение машин со сверхразумом связано с опасностью для жизни окружающих. Если предположить, что запрограммированный ИИ при выполнении задачи пренебрежет безопасностью человека для достижения цели, тогда стоит говорить о пассивном риске.

Случайный риск связан с неопытностью ИИ. Недостаток данных приведет к возникновению сложностей. Эту ошибку устранит дальнейшая подготовка машины. Такое развитие событий сравнимо с обучением новичка новому делу.

Выполнение сверхзадач повлечет риск использования ИИ террористическими организациями для нанесения вреда в больших масштабах. Нельзя допустить, чтобы разумные технологии оказались не в тех руках.

ИИ, перегнавший человека в интеллектуальном развитии, грозит вступить в противостояние с живыми существами. Самообучаемость машины грозит возможностью перепрограммирования. В таком случае разработчик не сможет внести изменений в поведение ИИ. Контроль над ситуацией будет утрачен. Подобные случаи уже имели место в работе нейросетей. В ходе эксперимента нейросеть разработала собственное шифрование. При этом ключ от шифра разработчики не знали. Другой эксперимент с диалогом трех сетей показал, что общение чат-ботов привело к образованию своего языка, который был непонятен наблюдателям. Описанные ситуации признаны ошибками с последующим отключением ИИ.

Борьба с надвигающейся угрозой

Развитие интеллектуального мышления искусственного разума пугает. Ведущие умы говорят о скачке в эволюции машин в ближайшие десятилетия. Чтобы бороться с угрозой, Илон Маск предпочитает участвовать в разработке. Лучше наглядно представлять то, с чем имеешь дело, чем осваивать технологии в погоне за конкурентами.

Контролировать ИИ – единственно правильное решение. Нельзя забывать о предназначении программ и роботов. Их цель – упростить жизнь человека. ИИ призван выполнять рутинную работу, тогда как на специалистов узкого профиля возлагается ответственность за выбор того или иного действия машины.

Изобретение ИИ уже поменяло жизни человечества. Появились невостребованные профессии, обязанности специалистов которых взяли на себя автоматизированные системы. Учебным учреждениям и кадровым агентствам следует пересмотреть подготовку работников отдельных сфер, подверженных внедрению ИИ. Человек должен научиться сотрудничать с разумными машинами и контролировать процесс их труда.

Рекомендуем к прочтению – искусственный интеллект или экспертные системы .

Наглядные случаи, в которых роботы пытаются заменить человека, но у них пока не получается

Ошибки искусственного интеллекта на миллиарды рублей убытка стали самой громкой технологической новостью недели в России. Точная версия слов президента Сбербанка Германа Грефа остается предметом обсуждения, но стала поводом для того, чтобы вспомнить самые громкие случаи провалов ИИ.

Расизм и дискриминация

Корпорация Amazon, наряду с другими технологическими гигантами США, является одним из центров разработок в области искусственного интеллекта. В 2017 году компания закрыла экспериментальный проект по найму сотрудников на основе ИИ, который вела около трех лет. По словам представителей компании, в результате они ожидали получить некий «Святой Грааль», который мог бы отобрать пятерку лучших кандидатов из сотни резюме. Одной из ключевых проблем стала гендерная дискриминация кандидатов — алгоритм занижал оценки кандидатов-женщин, поскольку был обучен на прошлом десятилетнем опыте отбора кандидатов в Amazon, среди которых преобладали мужчины. Были и другие сложности: алгоритм нередко выдавал практически случайные результаты.

Применение алгоритмов в рекламных инструментах Facebook привело к появлению предложений по группировке целевых аудиторий на основе такого признака, как антисемитизм. В 2016 году президенту Microsoft Research Питеру Ли пришлось извиняться за чат-бота Тау, который менее чем за сутки общения с пользователями Twitter научился расистским высказываниям. Проект был приостановлен.

Опасность на дороге

Распространение беспилотных автомобилей выглядит неизбежным будущим, однако еще не решены важные вопросы — например, этический выбор в опасных ситуациях. При этом сами тестовые испытания проходят с трагическими последствиями. Весной 2018 года Uber тестировала беспилотный автомобиль на базе одной из моделей Volvo на улицах города Темп в штате Аризона, США. Машина сбила женщину насмерть. Тестирование автопилота проводилось при сниженной чувствительности к распознанным опасным объектам, чтобы избежать ложных срабатываний. Когда порог чувствительности снижался, система видела опасные объекты там, где их не было.

Tesla зафиксировала уже два дорожных инцидента со смертельным исходом — в 2016 и 2018 годах. Пострадали водители, ехавшие в автомобилях с включенным автопилотом и не контролировавшие управление на сложных участках.

Сложности узнавания

Кроме США мощным центром разработки ИИ стали государственные и частные структуры в Китае. Их продукты не только используются крупнейшими мировыми компаниями (Baidu, Tencent и т. п.), но и попадают в списки эпических фейлов.

Например, власти Китая активно используют системы распознавания лиц для борьбы с правонарушениями. В частности, они отслеживают пешеходов, переходящих дорогу не по правилам, и затем публикуют их имена и фото на специальных «позорных» табло, предупреждая о последствиях. В число нарушителей по ошибке попала топ-менеджер из списка 100 самых влиятельных женщин по версии Forbes Дун Минчжу. Причиной инцидента стало ее изображение на автобусе в рекламном постере ее компании Gree Electric Appliances. Лично на перекрестке она не присутствовала.

В 2016 году гражданину азиатского происхождения Ричарду Ли робот отказал в приеме документов на получение паспорта Новой Зеландии, сделав вывод, что на фотографии его глаза закрыты.

Завышенные ожидания

Даже такому гиганту, как IBM, непросто обуздать технологию искусственного интеллекта. Несколько лет компания изучает вопросы применения ИИ для поддержки принятий врачебных решений. Один из фокусов исследований — лечение онкологических заболеваний. После массированной рекламной кампании пользователями услуг суперкомпьютера Watson стали исследовательские лаборатории и медицинские центры по всему миру. Через три года после старта продаж, летом 2018 года, медицинское издание STAT выяснило, что суперкомпьютер не соответствует завышенным ожиданиям. Журналисты смогли получить доступ к внутренним отчетам компании IBM: Watson зачастую давал ошибочные, а иногда опасные для жизни рекомендации по выбору метода лечения. Эксперты IBM предполагают, говорится в том же исследовании STAT, что некоторые ошибки суперкомпьютера обусловлены методикой его обучения. В частности, при обучении были использованы не реальные клинические случаи, а «синтетические» модели.

Системы ИИ необходимо правильно развивать и совершенствовать. На это может уйти время и ресурсы, и следует быть готовым к временным неудачам.

Боязнь сцены

Роботизированные устройства с искусственным интеллектом стали обязательными гостями технологических форумов. Но нередко они портят впечатление от мероприятия. Робот для управления умным домом Cloi от компании LG провалил миссию на выставке CES 2018, где должен был продемонстрировать, как искусственный интеллект сможет улучшить использование приборов на кухне. В ходе презентации Cloi не смог ответить на три команды директора по маркетингу LG, создав неловкую тишину в зале.

В 2017 году робот Mitra не смог внятно поприветствовать советника Белого дома Иванку Трамп и премьер-министра Индии Нарендру Моди на открытии Global Entrepreneurship Summit. Они нажали кнопки со своими флагами одновременно, а не по очереди, и робот запнулся на полуслове.

Принадлежащая SoftBank компания Boston Dynamics выпустила гуманоидного робота Atlas, который может заниматься паркуром, перемещать предметы и многое другое. Андроид продемонстрировал свои возможности на Congress of Future Scientists and Technologists, но, уходя со сцены, неловко споткнулся о занавес и упал.

Польза или проблемы

Согласно исследованию компании Accenture, посвященному влиянию ИИ, в 12 странах с развитой экономикой эта технология может удвоить годовые темпы экономического роста к 2035 году. Рост произойдет за счет изменения характера работы и создания новых отношений между человеком и машиной. Эксперты также ожидают, что влияние технологии на бизнес повысит производительность труда на 40% и позволит людям более эффективно использовать свое время.

Около 20 стран уже запустили государственные программы поддержки развития и внедрения технологии искусственного интеллекта. Эксперты сравнивают будущее революционное влияние технологии на экономику с эффектом от внедрения электричества. В противовес им другая часть экспертов считает, что развитие технологии достигло локального пика и перешло в фазу стагнации. Скептики опасаются возможных последствий, от массовых увольнений ставших ненужными сотрудников до потери контроля над машинами.

Вероятно, нужно запастись терпением и не ждать моментальной отдачи без усилий, понимая, что технология еще не достигла зрелости. Есть несколько разновидностей проблем, которые необходимо последовательно решать.

- Греф рассказал о потерянных Сбербанком миллиардах рублей из-за искусственного интеллекта

Искусственный интеллект (далее ИИ), все больше проникает в различные сферы нашей жизни. Есть мнение, что развитие ИИ может привести к четвертой промышленной революции, что в свою очередь может изменить жизнь до неузнаваемости.

Последнее время, в информационном пространстве все больше появляется призывов к искусственному замедлению развития ИИ. Давайте рассмотрим какие теоретические угрозы ИИ может представлять для человека и общества. Поскольку угрозы на прямую связаны с уровнем развития ИИ, для фактической реализации большинства из них, еще очень далеко.

Дисклеймер: Данная статья носит сугубо информационный характер и не призывает никого становиться на сторону зла. Автор статьи не несет ответственности если кто‑то решил использовать ИИ для нарушения закона. Действовать необходимо на благо общества, а понимание угроз, позволяет нам минимизировать их влияние или полностью защититься от них.

Угрозы исходящие от ИИ можно разбить на две большие группы:

Злоумышленники могут использовать ИИ в своих целях

-

Безопасность данных внутри ИИ — ИИ может хранить или обрабатывать чувствительную информацию, к которой через интерфейс взаимодействия с ИИ, злоумышленник каким‑то образом сможет получить доступ.

-

Компьютерные атаки с использованием ИИ — злоумышленник может использовать ИИ для создания фишинговых сайтов, писем, компьютерных вирусов с адаптацией под внешние условия, сетевых атак для обхода различных средств защиты.

-

Зашумление информационного пространства — ИИ может быть использован для создания большого объема фейковых новостей и дезинформации.

-

ИИ может находить решение сложных задач — существуют такие задачи, решение которых может нанести вред людям, например, создание запрещенных или опасных химических соединений.

-

Сбор информации с использованием ИИ — продвинутый ИИ может собирать и обрабатывать большой объем разнообразной информации позволяя создавать досье на человека или организацию, которое может быть использовано против них.

-

Подмена информации — злоумышленник, с помощью ИИ может создавать высококачественные копии различных документов, подписей, изображений и фотографий выдавая их за оригинал.

-

ИИ может имитировать реального человека — ИИ может представляться человеком и через доверие воздействовать на жертву, а также маскировать функции бота. Злоумышленник может обучить ИИ по текстовым, голосовым и видео сообщениям из открытых источников, сайтов знакомств, социальных сетей и мессенджеров.

-

Автоматизация операций — злоумышленник может использовать ИИ для автоматизации своих действий, что делает его более опасным.

Опасность которая исходит от самого ИИ

-

Ошибки в обучении модели — обычно проверка ИИ осуществляется на тестовых данных, при этом достаточно сложно доказать что он будет работать правильно на всем множестве входных данных. Чем больше и разнообразнее это множество, тем сложнее выполнить такое доказательство. Это может быть опасно при использовании ИИ в критической инфраструктуре или в ответственных зонах на производстве.

-

Недостаточная прозрачность — некоторые решения ИИ могут быть непонятными и сложными для человека, что создает некую неопределенность, поселяет сомнение в выборе решения. Когда мы не можем понять решение ИИ, нам сложно оценить является оно ошибочным или верным. Данная особенность начинает иметь вес, когда речь заходит о финансах, здоровье или жизни.

-

ИИ может начать действовать в своих интересах — самообучающие и адаптивные алгоритмы ИИ могут внутри себя сформировать определенную цель, которая будет скрыто влиять на решения и действия ИИ.

-

Искажение информации — ИИ сам по себе может предоставлять ложную или не точную информацию, при этом такая информация может попадать в открытые источники. Новые ИИ могут начать использовать ее в своем обучении, в результате чего может произойти замещение реальной информации ложной.

-

Низкое качество встроенных механизмов защиты — встроенные механизмы защиты ИИ могут быть несовершенными и иметь уязвимости. Например, можно попытаться убедить ИИ что он находится в каком‑то художественном произведении, в историческом отрезке времени или в другой вселенной, и все решения принимает исходя из этого, отыгрывая роль.

-

Потеря управления — человечество может потерять возможность управления ИИ. Например, ИИ может растворится в Интернете и стать его частью, функционируя в не зависимости от воли человека.

-

Угроза занятости — развитие ИИ может привести к автоматизации многих рабочих процессов, в результате чего может возникнуть социальная напряженность (при условии, что не произойдет переквалификация работников).

-

Дискриминация — ИИ может принимать решения исходя из своей логики, что может быть не этичным с точки зрения человека.

-

Отказ от ответственности — правовой статус ИИ находится в серой зоне и непонятно кто несете ответственность за создание, распространения и использования ИИ. Из‑за особенностей ИИ, может быть сложно или невозможно определить в какой момент она стала опасной.

-

Расслоение общества и социальное неравенство — люди, которые использую ИИ могут превосходить других людей, у которых по разным причинам отсутствует возможность использования ИИ.

-

Деградация человека или общества — человек может переложить на ИИ свою интеллектуальную активность, что в свою очередь может привести к интеллектуальной деградации человека (при условии снижении им мозговой активности). Также общение человека с ИИ может быть более простым и интересным, чем общение с другими людьми, что может привести к добровольной социальной изоляции человека.

Технический прогресс происходит быстрее чем общество и государство может реагировать на него. В связи с чем и появляется желание затормозить этот процесс, чтобы подготовиться и адаптироваться к нему. Но «Ящик Пандоры» уже приоткрыт и остановить прогресс не получиться. Даже если заморозить открытое развитие ИИ, оно может продолжить свое развитие скрыто и нелегально. Помимо опасности, ИИ также представляет и большую ценность, поскольку может помочь решить множество сложных задач, перенаправить потенциал людей, взяв на себя их деятельность и вывести человечество на новый уровень развития. Поэтому нужно исследовать ИИ в части безопасности, для минимизации возможных угроз, рисков и их последствий.

Нужно понимать, что ИИ это всего лишь еще один инструмент в руках человека и как мы будем его использовать зависит только от нас самих.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

Развитие ИИ полезно или опасно для человечества?

52.5%

Развитие ИИ принесет больше пользы, чем вреда (польза > вред)

21

17.5%

Развитие ИИ принесет больше вреда, чем пользы (польза < вред)

7

30%

Развитие ИИ принесет как пользу, так и вред в равном количестве (польза = вред)

12

Проголосовали 40 пользователей.

Воздержались 2 пользователя.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

Как Вы считаете, на каком уровне сейчас находится развитие ИИ?

0%

На высоком уровне, в ряде отраслей ИИ уже может заменить человека

0

72.73%

На среднем уровне, ИИ может решать узкие задачи, но еще очень далека от совершенства

8

27.27%

На низком уроне, возможности ИИ просто завышают (T9 на стероидах выдают за полноценную ИИ)

3

Проголосовали 11 пользователей.

Воздержавшихся нет.