Эта работа о безопасности информационных систем, в которых принимаются серьезные информационные решения и которые можно подразделить на три типа:

- во-первых, системы извлечения информации (информационно-поисковые системы (ИПС), информационно-измерительные системы (ИИС) и другие);

- во-вторых, приемопередающие системы (системы передачи данных (СПД), запросно-ответные системы (ЗОС) и другие);

- в-третьих, системы разрушения, уничтожения информации (постановки помех, подавления сигналов, радиоглушители и другие).

Во всех системах управление — важное явление, процесс, деятельность, которые включают в себя как компоненты организацию системы, распределение ресурсов (планирование), принятие решения и связь.

Трудно назвать область деятельности, в которой не принимались бы время от времени решения. Эта ситуация и явление имеет место всегда и раньше, и теперь, и в будущем.Человек пальцем не пошевелит, не приняв решения об этом. Не всегда это осознается, но это именно так.

Здесь (в работе) основное внимание уделим теории выбора и принятия решений, которая исследует математические модели принятия решений и их свойства. Наука о принятии решений долгое время развивалась, можно сказать, однобоко. Классическая схема охватывается статистической теорией, основывающейся на функции риска, на ошибках первого и второго рода.

Этот подход к принятию решений сыграл свою положительную роль и применимость его сегодня не отрицается, но ограничивается принципами рациональности. Подход не лишен и недостатков. Известно крылатое выражение, приписываемое классику (Госсету (псевдоним Стьюдент)) от статистической теории «о трех видах лжи: преднамеренной, непреднамеренной и статистике».

Другое направление теории принятия решения — алгебраическое возникло несколько позже, но оказалось малодоступным для понимания (и как следствие, для применения). В основе подхода лежит теория отношений частичного порядка и ее частного варианта — отношений предпочтения. Я об этом недавно писал, но публикацию мягко говоря не одобрили.

Порочность такой практики вижу в том, что такое отношение к публикации, читателей, имеющих возможность выставлять минусовые оценки, подтормаживает и отвращает от знакомства с ней других читателей, полагающихся на чужое мнение.

Возможно, спустя небольшое время, горячие головы поостыли, ничего обидного в публикации не было сказано, но кто-то мои замечания принял на свой счет. Даже учебная литература второго подхода весьма ограничена, а монографии, хотя и имеются, но для восприятия сложны, что является определенным тормозом развития подхода.

Занимаясь информационной безопасностью (ИБ) желательно видеть весь спектр проблем и задач присущих ей, и, конечно, важной в полном перечне задач является задача управления ИБ, в частности, выбора и принятия решения.

В общем, здесь я возвращаюсь к теории отношений и ее приложениям, одним из которых является механизм принятия решений и результаты теории принятия решений. В этой публикации раскрою основные положения теории, а в следующей приведу пример с показом вычислительных аспектов и деталей. Вначале назову основные предметные элементы статистического подхода в теории принятия решений и далее кратко приведу их описания.

Функция риска (ФР). Ошибки, род ошибки;

Исходное множество альтернатив (ИМА);

Принцип оптимальности (ОП);

Лицо принимающее решение (ЛПР);

Функция выбора (ФВ);

Функция полезности (ФП);

Критерии принятия решения.

Принятие решений и способы минимизации риска

Решение всегда принимается в ситуации выбора, предполагающего потери, случайность и определенные риски, которые желательно минимизировать. Если же выбор отсутствует, то и решать нечего, действуй единственным образом или вообще бездействуй, как указывает альтернатива.

Смысл и цель минимизации риска состоит в том, чтобы применить эффективные меры защиты таким образом, чтобы остаточный риск в системе стал приемлемым.

Минимизация риска Предполагает решение трех вопросов: определения тех областей, где риск является недопустимо большим; выбора наиболее эффективных средств защиты; оценивания мер защиты и определения, приемлем ли остаточный риск в системе.

В научном исследовании используются гипотезы, которые выдвигаются, формулируются, проверяются, подтверждаются или опровергаются, это естественный путь исследования. Гипотезы могут быть весьма отличающимися по содержанию, способам их формулирования и методам проверки. Важный класс — статистические гипотезы, которые формулируются либо относительно вида закона распределения случайной величины, либо относительно параметров этого закона, либо относительно ранговой упорядоченности значений случайной величины.

Гипотезы сформулированные относительно вероятностно и- статистических и ранговых величин проверяются и оцениваются с помощью разного рода статистических приемов и критериев. Результаты проверки и оценивания статистических гипотез позволяют делать качественные выводы относительно исследуемых явлений. Например, степень близости эмпирического закона распределения случайной величины к теоретическому закону нормальному или Пуассона.

Нулевая и альтернативная гипотезы. Обычно нулевая гипотеза

состоит в том, что выдвигается предположение о виде закона распределения вероятностей случайной величины или о параметре такого закона, либо о ранговой последовательности. Другая гипотеза —

называется альтернативной.

Пример. Пусть гипотеза

— состоит в том, что случайная величина подчиняется Пуассоновскому закону распределения или нормальному закону распределения. Альтернативная гипотеза

— случайная величина не подчиняется ни Пуассоновскому закону распределения, ни нормальному закону распределения. Альтернативных гипотез может быть несколько. Гипотеза

выступает как отрицание.

Проверка истинности гипотез выполняется всегда на случайной выборке. Но выборка ограничена (конечна), а потому она не может идеально точно отразить закон распределения вероятности в генеральной совокупности. Всегда имеется риск сформулировать такую гипотезу, что «неудачная» выборка может дать совершенно ложную информацию о существе дела. Таким образом, всегда есть шанс прийти к ложному решению.

По результатам применения одного из критериев статистической проверки гипотез возникает одна из четырех ситуаций:

-нулевая гипотеза

принимается, и она верна (соответственно

отвергается ложная альтернативная гипотеза

);

-нулевая гипотеза

отвергается, и она ложна (соответственно

принимается верная альтернативная гипотеза

);

-нулевая гипотеза

отвергается, хотя она и верна ( соответственно принимается ложная гипотеза

);

-нулевая гипотеза

принимается, хотя она и ложна (соответственно отвергается истинная альтернативная гипотеза

);

Первые две ситуации представляют собой правильное решение, а две последние — ошибочное решение.

Ошибки первого и второго рода.

Ошибкой первого рода α1 называется решение, состоящее в отвержении правильной гипотезы

(третья ситуация, часто называемая «пропуск цели»).

Ошибкой второго рода α2 называется решение принять нулевую гипотезу

, хотя она ложна (названа «ложная тревога»).

Ошибки 1-го и 2-го рода могут иметь разную значимость и тогда выбор в качестве основной гипотезы

при решении стоящей проблемы становится важным. Ошибкой первого рода должна считаться та, из возможных ошибок, которую важнее избежать, т.е. лучше правильное доработать, чем принять в работу неправильное.

Пусть наблюдается событие, представленное вектором

в n–мерном пространстве, которое может принадлежать только одному из двух множеств V1 или V2. Интерес представляет метод, который бы на основе изучения события представленного вектором, позволил бы с минимальной вероятностью ошибки получить ответ на вопрос о том, к какому из двух V1 или V2 множеств следует отнести исследуемое событие или соответствующий ему вектор.

Другими словами, метод должен классифицировать событие и завершаться принятием решения об отнесении его к определенному классу. Теоретически, в процессе принятия такого решения возможны ошибки двоякого рода, которые как раз и называют ошибками первого и второго рода. При этом выдвигают две гипотезы:

– гипотеза, предполагающая, что событие S принадлежит множеству V1 и

– гипотеза, предполагающая, что событие S принадлежит множеству V2.

Будем полагать, что ошибка первого рода допускается тогда, когда отклоняется гипотеза

, хотя она справедлива, и допускается ошибка второго рода, если принимается гипотеза

тогда, когда справедливой оказывается гипотеза

(1).

Обычно нулевая гипотеза

состоит в том, что выдвигается предположение об изучаемом явлении. Другая гипотеза

называется альтернативной.

Альтернативных гипотез может быть несколько, и все они выступают как отрицание нулевой.

Проверка гипотез выполняется всегда на случайной выборке, но в эксперименте выборка всегда конечна, а посему она не может идеально точно отразить закон распределения вероятностей в генеральной совокупности.

Всегда имеется риск сформулировать такую гипотезу, что “неудачная” выборка может дать совершенно ложную информацию о существе дела. Всегда есть шанс прийти к ложному решению. Часто ошибку первого рода называют “пропуском цели”, а ошибку второго рода – “ложной тревогой’.

В конфликтных ситуациях принцип максимальной эффективности полностью сохраняет свою силу. Спецификой конфликта является неопределенность ситуации, которая порождает риск. Следовательно, общим принципом рационального поведения в конфликте является максимальная эффективность при допустимом риске (либо достижение эффективности не ниже заданной при минимальном оперативном риске). Риск понятие далеко неоднозначное.

Анализ различных событий и возможностей позволяет найти правило, определяющее решение для каждой точки рассматриваемого n–мерного пространства. Действительно, если наблюдаемым событием является угроза при ее проявлении в форме атаки

(2), которую следует отнести к одному из двух образов (классов) V1 или V2, то возникает ситуация, имеющая место при распознавании образов.

Пусть известна вероятность появления угрозы (атаки)

, при условии, что ее образ принадлежит классу V1. Эту вероятность, которая характеризует плотность образов (членов) класса V1, называют условной плотностью вероятности в классе V1, и обозначают

или

(3).

Аналогично вводится обозначение условной плотности распределения вероятностей в классе V2, т.е.

(4).

Вероятность “ложной тревоги”, т.е. решения о том, что имеет место атака, принадлежащая классу V1, в то время, как в действительности атака принадлежит классу V2, записывается в виде,

где

– априорная вероятность атаки объектом из класса V2.

Аналогично вероятность “пропуска цели”, можно записать в виде

где

– априорная вероятность атаки объектом из класса V1; и

– области пространства, соответствующие классам V1 и V2.

Практический интерес представляет такое решающее правило, которое минимизировало бы риск W или среднюю стоимость принятия решения, определяемую по следующей формуле

(7), где α1 – вес ошибки первого рода, α2 – вес ошибки второго рода.

Учитывая, что области

образуют все пространство возможных значений, а интеграл от плотности вероятности по всему пространству, равен единице, получаем

Интерпретация такого подхода может быть следующей. Задача выбора оптимального решения сводится к разделению пространства образов атак на две области

, так чтобы риск W оказался минимальным. Из выражения для W видим, что с этой целью область

надо выбрать так, чтобы интеграл в (8) принял бы наибольшее отрицательное значение.

Подынтегральное выражение при этом должно принимать наибольшее отрицательное значение, и вне области

не существует никакой другой, где подынтегральное выражение отрицательно, т.е.

Из соотношения (9) легко получается следующее решающее правило SєV1 если

которое состоит в сравнении отношений плотностей вероятностей с некоторым порогом θ, который является постоянным для определенных значений весов α1 и α2. Это правило относят к классу байесовских правил, и отношение плотностей вероятностей называется коэффициентом подобия.

В случае α1=α2 и

=

порог θ, очевидно, равен единице, и здесь все более, менее ясно. Проблемы возникают в левой части решающего правила (10). Условные плотности распределения вероятностей

и

предполагаются известными.

На самом деле это не так. Более того, получение их аналитического или даже численного значения предоставляет существенные трудности. Поэтому чаще всего ограничиваются приближенными значениями, определяя относительную частоту, с которой возникают атаки объекта из класса V1. Ограниченная выборка обрабатывается соответствующим образом и по результатам обработки оцениваются неизвестные распределения.

Исходное множество альтернатив (вариантов) Ω, задаваемых ситуацией, ограничениями, ресурсами и др. условиями. Множество Ω необходимо упорядочить. Определение.Нестрогим упорядочением называется бинарное отношение, рефлексивное, транзитивное и асимметричное.

Если такое БО нерефлексивное, то упорядочение называют строгим. Если в упорядочении любые две альтернативы сравнимы, то упорядочение — линейное или совершенное. Если не все альтернативы сравнимы, то упорядочение называют частичным. Отношение предпочтения — частный случай упорядочения.

Принцип оптимальности задает понятие лучших альтернатив путем отображения φ: Ω → Е1. Такое свойство альтернатив называют критерием, число φ(х)- оценкой альтернативы х по критерию, Е1 — критериальное пространство, в котором координаты точек являются количественными оценками по соответствующим критериям.

Центральной в теории является общая задача принятия решений, в которой могут быть неизвестными как множество альтернатив Ω, так и принцип оптимальности. При известных альтернативах возникает задача выбора, а дополнительно и при известном принципе оптимальности — общая задача оптимизации.

Определение. Лицо принимающее решение(ЛПР) — субъект решения, наделённый определёнными полномочиями и несущий ответственность за последствия принятого и реализованного управленческого решения.

Это человек (или группа лиц), имеющие цель, служащую мотивом постановки задачи принятия решения, и поиска ее решения.

Предпочтение ЛПР — бинарное отношение, заданное на множестве альтернатив, описывающее предпочтения ЛПР, например, на основе парных сравнений.

Определение. Функция риска описывает риск или возможные потери (ущерб) при выборе конкретной альтернативы. Риск — математическое ожидание функции потерь вследствие принятия решения. Является количественной оценкой последствий принятого решения. Минимизация риска является главным критерием оптимальности в теории принятия решений.

Согласно теории статистических решений требуется найти такое правило, которое минимизировало бы риск

, или среднюю стоимость принятия решения, определяемую по формуле

, где

— стоимость (вес) ошибки первого рода;

— стоимость ошибки второго рода.

Определение. Функция выбора С служит математическим выражением принципа оптимальности и является отображением, сопоставляющим каждому Х ⊆ Ω его подмножество С(Х) ⊆ Х [8, стр.32].

Задано множество вариантов (альтернатив) Ω = {

}.

Рассмотрим функцию выбора С на этом множестве Ω.

, где

, где

.

Эта функция может быть представлена и в логической форме таблицей.

В таблице β(Х) — предъявленное множество альтернатив, β(С(х))- результат выбора в логических (булевых) переменных

Сущность решения, его принятия состоит в выборе подходящей альтернативы.

Определение. Фу́нкция поле́зности

— функция, с помощью которой можно представить предпочтения на некотором множестве допустимых альтернатив. Функция

, определенная на упорядоченном множестве Х, называется функцией полезности, если для всех

.

Если множество альтернатив Х содержит малое их число, то определив на этом множестве бинарное отношение (БО) предпочтения, т. е. произведя упорядочение альтернатив, нетрудно выбрать подходящую.

Наличие большого множества альтернатив, которые необходимо упорядочить становится трудоемким процессом. трудность преодолима при возможности измерять предпочтения и заменять их числовыми показателями качества.

Вопросы представления предпочтений в форме числовых функций принадлежат математической теории полезности.

Если функция полезности существует, то для нахождения оптимального решения (максимальной по заданному предпочтению альтернативы) достаточно найти максимум функции U(x) на X, для чего можно использовать классический математический анализ или оптимизационные методы.

Теорема (существования функции полезности). Если на бесконечном множестве Х задано строгое предпочтение (>), то для существования функции полезности необходимо и достаточно, чтобы Х содержало плотное по упорядочению счетное множество.

Определение. Множество А называется плотным в Х по упорядочению, если для любых

существует такой

.

Пусть V — любая монотонно возрастающая функция от

, тогда

также будет функцией полезности.

Далее, если предпочтение не является совершенным (линейным) упорядочением, то и тогда можно доказать теорему существования функции полезности

), но с ограничением. Это естественно, так как любая функция порождает совершенное упорядочение, но не порождает информацию о первоначальном предпочтении.

Более простой функцией полезности является линейная,

, в которой α’ и β’ определяются как константы.

Теорема (существования линейной функции полезности). Если множество Х и упорядочение (*>) удовлетворяют условиям:

— множество альтернатив Х является выпуклым множеством векторного пространства;

— предпочтение на множестве альтернатив непрерывно;

— смеси, составленные из безразличных альтернатив, безразличны, то существует такая действительная линейная функция U(x), что для всех

На практике интерес представляет двумерный случай для переменных у и х.

Функция полезности принимает следующий вид для двумерного случая

При разных значениях параметра p можно получить частные случаи.

Если p=1, то функция является линейной и описывает совершенные заменители. В этом случае предельная норма замещения равна отношению параметров α/β,

Если p → — ∞, то получается функция Леонтьева, которая описывает совершенные дополнители. Предельная норма замещения в этом случае бесконечна.

При p → 0 получается функция Кобба-Дугласа, если наложить дополнительное условие α + β = 1

Моделирование процесса принятия решения

Понятие модели в современной науке стало привычным и необходимость выяснения содержания понятия перестала осознаваться. На практике понятие моделей, процедур, схем и методов принятия решений часто смешиваются и перестают отличать одно от другого. Возможности моделирования предпочтений многократно перекрывают таковые у человека и часто возможности модели оказываются богаче реальности.

Говорить о модели принятия решения следует лишь в связи с конкретной задачей принятия решения (ЗПР), которую предстоит решить. Это означает, что выбран класс базовых структур предпочтений, в рамках которого будет осуществляться поиск лучшего решения.

Различные модели решения одной и той же ЗПР будут различаться именно принципами, положенными в их основу. Полагаем, что рассматривается некоторое множество исходных структур предпочтений (отношений), заданных в матричной форме, например, матриц парных сравнений. На этом множестве исследуется определенная ЗПР и говорят, что на множестве исходных структур задана модель решения поставленной ЗПР.

К моделям принятия решений предъявляются достаточно жесткие требования: корректность, адекватность, полнота, универсальность и др.

Корректность в математике определяется существованием решения, единственностью решения и его устойчивостью.

Адекватность — соответствие оригиналу, т. е. правильность отражения в модели моделируемых принципов и особенностей процесса принятия решения. Существенными являются различия между нормативным (прескриптивным) и дескриптивным подходами.

В первом главенствуют априорные предположения о том, какими должны быть общие принципы, формулируемые как аксиомы, которым должны удовлетворять разрабатываемые модели принятия решения.

Во втором — особенности разрабатываемых моделей описываются не аксиоматически, а атрибутивно, при помощи системы свойств, каждое из которых содержательно интерпретируется ЛПР и представляется ему разумным и в той или иной степени желательным.

Полнота для моделей заключается в том, что основные принципы, лежащие в основе принятия решения, должны отражаться не только точно, но и в достаточном объеме.

Универсальность модели — определяется возможностью ее применения к широкому классу исходных структур предпочтений.

Методы принятия статистических решений

Задача принятия решения формулируется следующим образом.

Имеется m + 1 состояний

объекта исследования, образующих полную группу несовместных событий, априорные вероятности состояний соответственно равны

и

.

Для каждого из состояний задаются

— функции правдоподобия

;

— набор решений

;

— функции потерь

;

— критерий качества выбора решения f(П), связанный с функцией потерь.

Требуется определить наилучшее в смысле используемого в задаче принятого критерия правило

использования результатов наблюдений

для принятия решения.

Легко устанавливаются соответствия: множеству Е соответствуют выборки

, вероятностной мере Р соответствует функция правдоподобия

Задать предпочтения на множестве Р в смысле принятых критериев — это означает определить правило принятия решения при принятых критериях.

Критерии в теории статистических решений используются в зависимости от полноты исходной информации. Рассматривают следующее множество критериев:

— Байеса;

— максимума апостериорной вероятности,;

— максимального правдоподобия;

— минимаксный;

— Неймана-Пирсона;

— Вальда.

В основу метода кладется критерий выбора альтернативы. В соответствии с названными критериями в задаче формулируются правила принятия решений. Сами критерии сравниваются по качеству правил принятия решения, например, по условной функции риска

, которая представляет среднюю величину потерь для заданного состояния

.

Определение. Байесовским правилом (критерием) — называется правило принятия оптимального решения минимизирующее среднюю функцию риска. Минимальное значение средней функции риска называют байесовским риском.

Использование этого критерия предполагает наличие:

— функции потерь

;

— условных функций распределения вероятностей выборочных значений

;

— априорное распределение вероятностей состояний

.

Определение. Специальным случаем байесовского критерия называется любое минимаксное правило выбора решения в условиях наименее благоприятного априорного распределения вероятностей (

) состояний

.

При неизвестном априорном распределении состояний устанавливается специальный критерий качества принятия решения, использующий лишь условную функцию риска

.

Интерпретация следующая. Имеется множество К правил принятия решения, для каждого из которых определено значение максимальной величины условного риска по всем возможным состояниям объекта исследования

. Из этих значений далее выбирается наименьшее значение

При этом обеспечивается, что потери (в среднем) не будут больше некоторой величины r*. Это правило, вообще говоря, является очень осторожным критерием.

Определение. Максимумом апостериорной вероятности состояний

при наблюдаемой выборке

называют критерий вида

При этом утверждается истинной та из гипотез относительно состояний

,

j =1(1)m, для которой апостериорная вероятность максимальна.

Этот критерий используется при известном априорном распределении состояний

и отсутствии обоснований относительно величины потерь

. В этой ситуации выполняют разбиение пространства выборок. К области

относят те выборки

, для которых при всех j ≠ k

.

Критерием принятия решения выбирается максимум апостериорной вероятности.

Определение. Критерием максимального правдоподобия называют частный случай максимума апостериорной вероятности при отсутствии априорных сведений о распределении вероятностей состояний, о возможных потерях и допущении, что все состояния равновероятны, т.е.

Согласно критерию при анализе и наблюдении выборки

принимается та из гипотез относительно состояний

, для которой функция правдоподобия

больше других функций правдоподобия

Теперь будем рассматривать ситуацию с двумя альтернативами, что на практике часто встречается.

Задача принятия решения несколько упрощается и сводится при использовании любого из рассмотренных ранее критериев к вычислению отношения функций правдоподобия по наблюдаемой выборке

и сравнению полученного результата с наперед заданным порогом С* (порогами

и

), т.е.

При выполнении неравенства принимается решение

, свидетельствующее о том, что объект исследования находится в состоянии

. Противоположному неравенству соответствует состояние

и решение принимается другое

.

Значение порога С* определяется используемым критерием. В случае критерия Байеса

— соответственно априорные вероятности появления событий

;

— потери, когда имеет место событие

и соответственно принимаемые решения

;

— потери при правильных решениях.

При критерии максимум апостериорной вероятности формула упрощается

, а

для критерия максимального правдоподобия становится константой С* = 1.

При использовании минимаксного критерия порог вычисляется по формуле с неравенством, в которую вместо

подставляют значения априорных вероятностей

, при которых величина среднего риска принимает максимальное значение

Определение Критерием Неймана-Пирсона называют правило выбора альтернативы, при котором величина порога определяется исходя из заданной величины вероятности ошибки первого рода (α).

Ошибка первого рода возникает, когда выборка попадает в критическую область

, хотя изучаемое явление находится в состоянии

, т.е. верна гипотеза

, и она отвергается.

Ошибка второго рода возникает, когда выборка попадает в допустимую область

, хотя изучаемое явление находится в состоянии

, т.е. принимается ложная гипотеза —

Чтобы определить величину порога, необходимо решить следующее интегральное уравнение (для α) относительно С*

где

— одномерная плотность распределения отношения функции правдоподобия при гипотезе

.

В свою очередь, вероятность ошибки второго рода β определится из решения правого интегрального уравнения, где

— одномерная плотность распределения отношения функции правдоподобия при гипотезе

.

Определение. Критерием Вальда называют такое правило выбора решения, при котором отношение функций правдоподобия сравнивается с двумя порогами

Точное определение порогов

сопряжено со значительными математическими трудностями.

Заключение

В работе дан краткий обзор возможностей существующей теории принятия статистических решений. Названы основные элементы и составные части теории, приложений и моделей. Приводится краткая характеристика названным элементам и приведены их описания.

В образовательном плане важно знать о существовании такой теории и при возникновении и осознании потребности принимать решения обращаться к ее азам. Замечу, что в этой сфере как и в сфере воспитания все считают себя (особенно родители) вполне компетентными.

Но именно следствием воспитания является алкоголизм и процветает наркомания среди молодых, а следствием недообразованности — принимаемые решения, которые приводят нас к тому, что мы имеем в своей стране.

Не исключаю, что опять найдется кто-нибудь и скажет, что заключение не в тему.

Список используемой литературы

1. Азгальдов Г.Г., Райхман Э.П. О квалиметрии. -М.: Изд. стандартов, 1973. – 172с.

2. Грушо А.А., Тимонина Е.Е. Теоретические основы защиты информации.- М.: Яхтсмен, 1996. — 192с.

3. Девянин П.Н. Модели безопасности компьютерных систем. – М.: Изд.ц. «Академия», 2005. – 144с.

4. Теоретические основы компьютерной безопасности/Девянин.Н., Михальский О.О. и др.–М.: Радио и связь, 2000.

5. Пфанцагль И. Теория измерений. — М.: МИР, 1976. – 248с.

6. Фишберн П. Теория полезности для принятия решений. –М.: Наука, 1978. – 352 с.

7. Куратовский К., Мостовский А. Теория множеств. – М.: Мир,1976.– 416с.

8. Макаров И.М. и др.Теория выбора и принятия решений: учебное пособие для вузов / И. М. Макаров [и др.]. — М.: Наука, 1982.

9. Мейер Д. Теория реляционных баз данных.– М.: Мир,1987. –608с.

10. Гнеденко Б.В. Курс теории вероятностей. – М.: Наука,1969. – с.

11. Лоэв М. Теория вероятностей. –М.: ИЛ, 1962. – с.

12. Ярочкин В.И. Система безопасности фирмы. – М.: Ось – 89, 2003. –352с.

13. Общие критерии оценки безопасности информационных технологий CCEB-96/011. Часть 1: Введение и общая модель. Версия 1.0. 96/01/31. E/E. ИТК НАН Беларуси.

14. Дружинин В.В. и др. Введение в теорию конфликта. — М.: Радио и связь,1989. — 288с.

15. Расторгуев С.П. Информационная война. — М.: Радио и связь,1998. — 416с.

16. Большая советская энциклопедия – М.: ГНИ БСЭ,1953.-

17. Словарь иностранных слов. — М.: Гиз иностранных и национальных словарей,1950. — 806с.

18. ДёчГ. Руководство к практическому применению преобразования Лапласа и Z-преобразования. — М.: Наука, 1971.- 288с.

19. FIPS PUB 191, Руководство по анализу безопасности ЛВС. 9 ноября 1994 г. E/E.

21. Katzke, Stuart W. ,Phd., “A Framework for Computer Security Risk Management”, NIST, October, 1992.

22. Саати Т.Л. Математические модели конфликтных ситуаций. — М.: Сов радио, 1977. — 302с.

23. Крапивин В.Ф. Теоретико-игровые методы синтеза сложных систем в конфликтных ситуациях.– М.: Сов радио, 1972. — 117с.

24. Гаврилов В.М. Оптимальные процессы в конфликтных ситуациях. — М.: Сов радио, 1969. — 160с.

25. Ватель И.А., Ерешко Ф.И. Математика конфликта и сотрудничества. — М.: Знание, 1973. — 64с.

26. Нейман Дж. фон, Моргенштерн О. Теория игр и экономическое поведение. — М.: Наука,1970. 27. Нартов Б.К. и др. Конфликт сложных систем. Модели и управление. — М.: МАИ, 1995. — 120с.

28. Айзекс Р. Дифференциальные игры. — М.: Мир, 1967. —

29. Петросян Л.А. Дифференциальные игры преследования. — М.: ЛГУ, 1977. — 30. Хеллман О. Введение в теорию оптимального поиска. -М.: Наука ,1985. —

31. Ансофф И. Стратегическое управление. — М.: Прогресс, 1989. –

32. Плэтт В. Стратегическая разведка. — М.: Форум, 1997. — 376с.

Вчера мне в очередной раз пришлось объяснять почему DataScientist-ы не используют ошибки первого и второго рода и зачем же ввели полноту и точность. Вот прямо заняться нам нечем, лишь бы новые критерии вводить.

И если ошибка второго рода выражается просто:

где Π — это полнота;

то вот ошибка первого рода весьма нетривиально выражается через полноту и точность (см.ниже).

Но это лирика. Самый важный вопрос:

Почему в DataScience используют полноту и точность и почти никогда не говорят об ошибках первого и второго рода?

Кто не знает или забыл — прошу под кат.

Бизнес-задача

Так как Хабр — это блог IT-шников, постараюсь по минимуму использовать мат.абстракции и рассказывать сразу на примере. Предположим, что мы решаем задачу Fraud-мониторинга в ДБО условного банка Roga & Copyta, сокращённо R&C.

Предположим, что у мы разработали некую автоматизированную экспертную систему (ЭС), определяющую для каждой платёжной транзакции: является ли данная транзакция мошеннической (fraud, F) или легитимной (genuine, G).

Необходимо определить «хорошие» критерии оценки качества системы и дать формулы расчета этих критериев.

Так как Roga & Copyta — это хоть и маленький, но всё же банк, то в нём работают люди меркантильные и ничего кроме денег их не интересует. Поэтому разрабатываемые критерии должны максимально прозрачно показывать: насколько выгодно им использовать нашу ЭС? Может быть выгодно установить ЭС конкурентов?

События и вероятности

Для каждой транзакции могут быть определены четыре события:

- Fr (fraud real) — событие того, что транзакция в действительности окажется мошеннической;

- Gr (genuine real) — событие того, что транзакция в действительности окажется легитимной;

- F — событие того, что ЭС «определит» транзакцию как мошенническую;

- G — событие того, что ЭС «определит» транзакцию как легитимную

Очевидно, что Fr и Gr — несовместные события; аналогично F и G — несовместные. По этой причине разумно рассматривать четыре вероятности:

Аббревиатуры читаются так:

- tn — true negative

- fn — false negative

- fp — false positive

- tp — true positive

Мы можем рассматривать условные вероятности:

Так же нам будут интересны и «обратные» условные вероятности:

Например вероятность означает следующее:

Какова вероятность того, что транзакция действительно окажется мошеннической, если ЭС «определила» это событие как мошенническое.

Не следует путать с

, которое можно определить словами:

Какова вероятность того, что ЭС «назовёт» транзакцию мошеннической, если данная транзакция действительно мошенническая.

Аналогично можно определить словами и другие условные вероятности.

Вспомним определения

В статистике любят говорить о нулевой гипотезе (H0) и альтернативной (H1) гипотезе. Обычно под нулевой гипотезой определяют «естественное» состояние. В случае фрод-мониторинга «естественным» состоянием является то, что транзакция легитимная. Это действительно разумно, хотя бы по той причине, что количество мошеннических транзакций гораздо меньше количества легитимных.

Поэтому за нулевую гипотезу примем Gr, а за альтернативную Fr.

Ошибки первого (O1) и второго (O2) рода определяются так:

Словами

Ошибка первого рода (O1) — это вероятность того, что ЭС «определит» транзакцию как мошенническую, при условии, что она легитимная.

Ошибка второго рода (O2) — это вероятность того, что ЭС «определит» транзакцию как легитимную, при условии, что она мошенническая.

Замечание: часто ошибку первого рода называют false positives а ошибку второго рода как false negatives. В том числе, таковы определения в википедии. Это верно по сути. Но

и

. Очень многие новички в DataScience делают такую ошибку и путаются.

Полнота (П) и точность (Т) по определению:

Т.е. полнота — это вероятность того, что ЭС «определит» транзакцию мошеннической, при условии, что она действительно мошенническая. А точность — это вероятность того, что транзакция действительно мошенническая, при условии, что ЭС «определила» транзакцию как мошенническую.

Полноту и точность можно выразить через tp, fp, fn следующим образом:

Вывод формул

Выводим тупо в лоб.

Для полноты:

Для точности:

Следует заметить, что именно эти формулы очень частно приводят в качестве определения полноты и точности. Тут вопрос во вкусе. Можно сказать, что квадрат — это прямоугольник, у которого все стороны равны и доказать, что ромб с прямым углом — это квадрат. А можно наоборот. Например, когда я учился в школе, у меня квадрат определяли как ромб с прямым углом и доказывали, что прямоугольник с равными сторонами — это квадрат.

Но все же определение полноты как и точности как T

мне кажется более правильным. Сразу понятно в чем физический смысл этих величин. Понятно, зачем они нужны.

Бизнес-смысл полноты и точности

Предположим, что для Roga & Copyta мы создали систему с полнотой в 80% и точностью в 10%.

Предположим, что без ЭС банк теряет на мошенничестве 1 миллиард тугриков (₮) в год. Это значит, что благодаря ЭС они смогут предотвратить хищение на сумму в 800 миллионов ₮. Останется еще 200 миллионов ₮ — это ущерб банку (или клиентам банка), который не смогла предотвратить ЭС.

А что на счет точности в 10%? Данная величина значит, что из 100 сработок ЭС только 10 будут попадать по цели, а в остальных случаях мы приостановим легитимные транзакции. Хорошо это или плохо?

Во-первых при остановки транзакции банк совершает какие-либо действия. Например звонит клиентам с просьбой подтвердить операции.

Во-вторых заблокировать легитимные транзакции тоже не всегда хорошая идея. Представьте, что вы сидите с девушкой в ресторане, просите счёт, оплачиваете картой… А тут бах… ЭС ошибочно подсчитала что вы — мошенник… Наверное не очень удобно будет перед барышней… Но мы, чтобы не усложнять, пока опустим эту проблему.

Итак, предположим один звонок стоит 1000 ₮. Так же предположим что средний чек хакера у нас составляет 100 тысяч ₮.

Так как мы предотвращаем мошенничества на 800 миллионов ₮, то в среднем у нас будет 8000 правильных мошеннических сработок. Но 8000 — это, судя по точности, лишь 10%; следовательно всего мы позвоним 80000 раз. Умножаем эту цифру на стоимость одного звонка (1000 ₮) и получаем аж 80 миллионов ₮!

Итоговый ущерб в год для банка R&C равен: 200 + 80 = 280 миллионов ₮. Но без ЭС банк терял бы один один миллиард. Следовательно выгода R&C составляет 720 миллионов тугриков.

нюанс

Следует различать полноту и точность по количеству транзакций и по суммам. Это четыре разные величины. Здесь я «смешал все в кучу», что, конечно не верно! ;)) Будем считать что полнота и точность 80% и 10% как по количеству транзакций, так и по денежным суммам.

Бизнес-смысл ошибок первого и второго рода

Ошибка второго рода элементарно выводится через полноту:

Вывод формулы элементарен (см. следующий параграф)

Поэтому что считать — полноту или упущенный фрод (ошибка второго рода) особой разницы не представляет.

А что на счет ошибки первого рода?

Это вероятность того, что ЭС назовёт мошеннической операцией транзакцию, при условии что она легитимная. Проблема в том, что легитимных транзакций существенно больше мошеннических. Есть банки, в которых более 50 платёжных транзакций в секунду… И это совсем не предел.

R&C — банк небольшой, там всего пять платёжных транзакций в секунду. Давайте посчитаем, сколько это в сутки:

В прошлом параграфе мы узнали, что в R&C 80000 сработок в год, это значит что в сутки в среднем 80000 / 365 = 219,17 сработок. Из них только 10% попали в цель (такова точность), то есть 22. Значит остальные — подлинные: 432000 — 22 = 431978.

Так как полнота 80%, то из этих 22 мы только 4.4 будем упускать.

Значит ошибка первого рода:

Слишком маленькая величина! Бизнес не любит такие числа. Так же сложнее, чем для точности высчитать пользу и ущерб для бизнеса. И есть еще одна проблема:

через ошибку первого рода, можно косвенно понять об объемах платёжных операций в банке!

Что касается точности, то такой проблемы нет. Специалисты из отдела безопасности R&C знают об объемах мошенничества. Они узнают о допустимой нагрузке на контактный центр у самой главной девочки + спрашивают руководство банка о желаемой полноте. Зная абсолютную нагрузку, желаемую полноту и объем фрода можно без труда вычислить приемлемую точность. Эти две цифры вписываются в техническое задание (или тендер).

Разработчику выдают выборку из мошеннических транзакций и легитимных. Если выборка репрезентативна, этих данных достаточно.

«Неправильность» точности с точки зрения чистой математики

Если объем транзакций увеличится в два раза, то точность уменьшится. Если объем мошенничества увеличится в два раза, то точность так же будет больше… С ошибкой первого рода такой проблемы нет, поэтому с точки зрения «чистой математики», эта величина гораздо более «правильная»…

Но на практике, если и резко увеличивается объем мошенничества, то как правило это фрод нового типа и ЭС просто не обучена его ловить… Точность останется той же (а вот полнота уменьшиться, т.к. появится фрод, который мы не умеем ловить). Что касается увеличения количества легитимных транзакций — то это увеличение постепенное и никаких «рывков» не будет.

Поэтому на практике точность — замечательный, понятный для бизнеса критерий оценки качества ЭС.

Вывод ошибок первого рода и второго рода из полноты и точности

Но может быть существует изящная формула вывода ошибки первого рода через точность?

Вот с ошибкой второго рода как все красиво:

Вывод формулы

К сожалению с O1 так изящно не получится. Вот отношение через точность (Т) и полноту (П):

Вывод формулы

Эй! Ты что такой ленивый! А ну давай сам попробуй!

Я сегодня плохо спал, Павел! Ну покажи!

Из и

можно составить выражение:

Откуда следует:

Уже из этого отношения легко получить формулу для O1

Заключение

Точность и полнота «не хуже» и «не лучше» чем ошибки первого и второго рода. Всё зависит от задачи. Мы же не едим столовой ложкой торт, а чайной борщ? Хотя это возможно.

Точность и полнота более понятные критерии качества. Ими легче оперировать. С помощью них просто вычислить предотвращённый ущерб в задаче фрод-мониторинга.

Если вы обнаружили описку или грамматическую ошибку — прошу написать в личку.

В машинном обучении различают оценки качества для задачи классификации и регрессии. Причем оценка задачи классификации часто значительно сложнее, чем оценка регрессии.

Содержание

- 1 Оценки качества классификации

- 1.1 Матрица ошибок (англ. Сonfusion matrix)

- 1.2 Аккуратность (англ. Accuracy)

- 1.3 Точность (англ. Precision)

- 1.4 Полнота (англ. Recall)

- 1.5 F-мера (англ. F-score)

- 1.6 ROC-кривая

- 1.7 Precison-recall кривая

- 2 Оценки качества регрессии

- 2.1 Средняя квадратичная ошибка (англ. Mean Squared Error, MSE)

- 2.2 Cредняя абсолютная ошибка (англ. Mean Absolute Error, MAE)

- 2.3 Коэффициент детерминации

- 2.4 Средняя абсолютная процентная ошибка (англ. Mean Absolute Percentage Error, MAPE)

- 2.5 Корень из средней квадратичной ошибки (англ. Root Mean Squared Error, RMSE)

- 2.6 Cимметричная MAPE (англ. Symmetric MAPE, SMAPE)

- 2.7 Средняя абсолютная масштабированная ошибка (англ. Mean absolute scaled error, MASE)

- 3 Кросс-валидация

- 4 Примечания

- 5 См. также

- 6 Источники информации

Оценки качества классификации

Матрица ошибок (англ. Сonfusion matrix)

Перед переходом к самим метрикам необходимо ввести важную концепцию для описания этих метрик в терминах ошибок классификации — confusion matrix (матрица ошибок).

Допустим, что у нас есть два класса и алгоритм, предсказывающий принадлежность каждого объекта одному из классов.

Рассмотрим пример. Пусть банк использует систему классификации заёмщиков на кредитоспособных и некредитоспособных. При этом первым кредит выдаётся, а вторые получат отказ. Таким образом, обнаружение некредитоспособного заёмщика () можно рассматривать как «сигнал тревоги», сообщающий о возможных рисках.

Любой реальный классификатор совершает ошибки. В нашем случае таких ошибок может быть две:

- Кредитоспособный заёмщик распознается моделью как некредитоспособный и ему отказывается в кредите. Данный случай можно трактовать как «ложную тревогу».

- Некредитоспособный заёмщик распознаётся как кредитоспособный и ему ошибочно выдаётся кредит. Данный случай можно рассматривать как «пропуск цели».

Несложно увидеть, что эти ошибки неравноценны по связанным с ними проблемам. В случае «ложной тревоги» потери банка составят только проценты по невыданному кредиту (только упущенная выгода). В случае «пропуска цели» можно потерять всю сумму выданного кредита. Поэтому системе важнее не допустить «пропуск цели», чем «ложную тревогу».

Поскольку с точки зрения логики задачи нам важнее правильно распознать некредитоспособного заёмщика с меткой , чем ошибиться в распознавании кредитоспособного, будем называть соответствующий исход классификации положительным (заёмщик некредитоспособен), а противоположный — отрицательным (заемщик кредитоспособен ). Тогда возможны следующие исходы классификации:

- Некредитоспособный заёмщик классифицирован как некредитоспособный, т.е. положительный класс распознан как положительный. Наблюдения, для которых это имеет место называются истинно-положительными (True Positive — TP).

- Кредитоспособный заёмщик классифицирован как кредитоспособный, т.е. отрицательный класс распознан как отрицательный. Наблюдения, которых это имеет место, называются истинно отрицательными (True Negative — TN).

- Кредитоспособный заёмщик классифицирован как некредитоспособный, т.е. имела место ошибка, в результате которой отрицательный класс был распознан как положительный. Наблюдения, для которых был получен такой исход классификации, называются ложно-положительными (False Positive — FP), а ошибка классификации называется ошибкой I рода.

- Некредитоспособный заёмщик распознан как кредитоспособный, т.е. имела место ошибка, в результате которой положительный класс был распознан как отрицательный. Наблюдения, для которых был получен такой исход классификации, называются ложно-отрицательными (False Negative — FN), а ошибка классификации называется ошибкой II рода.

Таким образом, ошибка I рода, или ложно-положительный исход классификации, имеет место, когда отрицательное наблюдение распознано моделью как положительное. Ошибкой II рода, или ложно-отрицательным исходом классификации, называют случай, когда положительное наблюдение распознано как отрицательное. Поясним это с помощью матрицы ошибок классификации:

-

Истинно-положительный (True Positive — TP) Ложно-положительный (False Positive — FP) Ложно-отрицательный (False Negative — FN) Истинно-отрицательный (True Negative — TN)

Здесь — это ответ алгоритма на объекте, а — истинная метка класса на этом объекте.

Таким образом, ошибки классификации бывают двух видов: False Negative (FN) и False Positive (FP).

P означает что классификатор определяет класс объекта как положительный (N — отрицательный). T значит что класс предсказан правильно (соответственно F — неправильно). Каждая строка в матрице ошибок представляет спрогнозированный класс, а каждый столбец — фактический класс.

# код для матрицы ошибок # Пример классификатора, способного проводить различие между всего лишь двумя # классами, "пятерка" и "не пятерка" из набора рукописных цифр MNIST import numpy as np from sklearn.datasets import fetch_openml from sklearn.model_selection import cross_val_predict from sklearn.metrics import confusion_matrix from sklearn.linear_model import SGDClassifier mnist = fetch_openml('mnist_784', version=1) X, y = mnist["data"], mnist["target"] y = y.astype(np.uint8) X_train, X_test, y_train, y_test = X[:60000], X[60000:], y[:60000], y[60000:] y_train_5 = (y_train == 5) # True для всех пятерок, False для в сех остальных цифр. Задача опознать пятерки y_test_5 = (y_test == 5) sgd_clf = SGDClassifier(random_state=42) # классификатор на основе метода стохастического градиентного спуска (англ. Stochastic Gradient Descent SGD) sgd_clf.fit(X_train, y_train_5) # обучаем классификатор распозновать пятерки на целом обучающем наборе # Для расчета матрицы ошибок сначала понадобится иметь набор прогнозов, чтобы их можно было сравнивать с фактическими целями y_train_pred = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3) print(confusion_matrix(y_train_5, y_train_pred)) # array([[53892, 687], # [ 1891, 3530]])

Безупречный классификатор имел бы только истинно-положительные и истинно отрицательные классификации, так что его матрица ошибок содержала бы ненулевые значения только на своей главной диагонали (от левого верхнего до правого нижнего угла):

import numpy as np

from sklearn.datasets import fetch_openml

from sklearn.metrics import confusion_matrix

mnist = fetch_openml('mnist_784', version=1)

X, y = mnist["data"], mnist["target"]

y = y.astype(np.uint8)

X_train, X_test, y_train, y_test = X[:60000], X[60000:], y[:60000], y[60000:]

y_train_5 = (y_train == 5) # True для всех пятерок, False для в сех остальных цифр. Задача опознать пятерки

y_test_5 = (y_test == 5)

y_train_perfect_predictions = y_train_5 # притворись, что мы достигли совершенства

print(confusion_matrix(y_train_5, y_train_perfect_predictions))

# array([[54579, 0],

# [ 0, 5421]])

Аккуратность (англ. Accuracy)

Интуитивно понятной, очевидной и почти неиспользуемой метрикой является accuracy — доля правильных ответов алгоритма:

Эта метрика бесполезна в задачах с неравными классами, что как вариант можно исправить с помощью алгоритмов сэмплирования и это легко показать на примере.

Допустим, мы хотим оценить работу спам-фильтра почты. У нас есть 100 не-спам писем, 90 из которых наш классификатор определил верно (True Negative = 90, False Positive = 10), и 10 спам-писем, 5 из которых классификатор также определил верно (True Positive = 5, False Negative = 5).

Тогда accuracy:

Однако если мы просто будем предсказывать все письма как не-спам, то получим более высокую аккуратность:

При этом, наша модель совершенно не обладает никакой предсказательной силой, так как изначально мы хотели определять письма со спамом. Преодолеть это нам поможет переход с общей для всех классов метрики к отдельным показателям качества классов.

# код для для подсчета аккуратности: # Пример классификатора, способного проводить различие между всего лишь двумя # классами, "пятерка" и "не пятерка" из набора рукописных цифр MNIST import numpy as np from sklearn.datasets import fetch_openml from sklearn.model_selection import cross_val_predict from sklearn.metrics import accuracy_score from sklearn.linear_model import SGDClassifier mnist = fetch_openml('mnist_784', version=1) X, y = mnist["data"], mnist["target"] y = y.astype(np.uint8) X_train, X_test, y_train, y_test = X[:60000], X[60000:], y[:60000], y[60000:] y_train_5 = (y_train == 5) # True для всех пятерок, False для в сех остальных цифр. Задача опознать пятерки y_test_5 = (y_test == 5) sgd_clf = SGDClassifier(random_state=42) # классификатор на основе метода стохастического градиентного спуска (Stochastic Gradient Descent SGD) sgd_clf.fit(X_train, y_train_5) # обучаем классификатор распозновать пятерки на целом обучающем наборе y_train_pred = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3) # print(confusion_matrix(y_train_5, y_train_pred)) # array([[53892, 687] # [ 1891, 3530]]) print(accuracy_score(y_train_5, y_train_pred)) # == (53892 + 3530) / (53892 + 3530 + 1891 +687) # 0.9570333333333333

Точность (англ. Precision)

Точностью (precision) называется доля правильных ответов модели в пределах класса — это доля объектов действительно принадлежащих данному классу относительно всех объектов которые система отнесла к этому классу.

Именно введение precision не позволяет нам записывать все объекты в один класс, так как в этом случае мы получаем рост уровня False Positive.

Полнота (англ. Recall)

Полнота — это доля истинно положительных классификаций. Полнота показывает, какую долю объектов, реально относящихся к положительному классу, мы предсказали верно.

Полнота (recall) демонстрирует способность алгоритма обнаруживать данный класс вообще.

Имея матрицу ошибок, очень просто можно вычислить точность и полноту для каждого класса. Точность (precision) равняется отношению соответствующего диагонального элемента матрицы и суммы всей строки класса. Полнота (recall) — отношению диагонального элемента матрицы и суммы всего столбца класса. Формально:

Результирующая точность классификатора рассчитывается как арифметическое среднее его точности по всем классам. То же самое с полнотой. Технически этот подход называется macro-averaging.

# код для для подсчета точности и полноты: # Пример классификатора, способного проводить различие между всего лишь двумя # классами, "пятерка" и "не пятерка" из набора рукописных цифр MNIST import numpy as np from sklearn.datasets import fetch_openml from sklearn.model_selection import cross_val_predict from sklearn.metrics import precision_score, recall_score from sklearn.linear_model import SGDClassifier mnist = fetch_openml('mnist_784', version=1) X, y = mnist["data"], mnist["target"] y = y.astype(np.uint8) X_train, X_test, y_train, y_test = X[:60000], X[60000:], y[:60000], y[60000:] y_train_5 = (y_train == 5) # True для всех пятерок, False для в сех остальных цифр. Задача опознать пятерки y_test_5 = (y_test == 5) sgd_clf = SGDClassifier(random_state=42) # классификатор на основе метода стохастического градиентного спуска (Stochastic Gradient Descent SGD) sgd_clf.fit(X_train, y_train_5) # обучаем классификатор распозновать пятерки на целом обучающем наборе y_train_pred = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3) # print(confusion_matrix(y_train_5, y_train_pred)) # array([[53892, 687] # [ 1891, 3530]]) print(precision_score(y_train_5, y_train_pred)) # == 3530 / (3530 + 687) print(recall_score(y_train_5, y_train_pred)) # == 3530 / (3530 + 1891) # 0.8370879772350012 # 0.6511713705958311

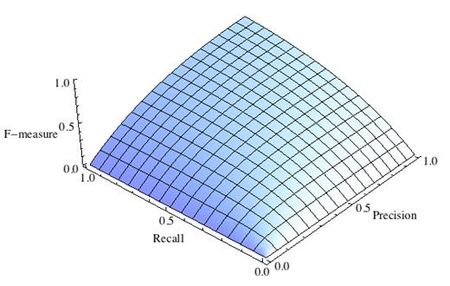

F-мера (англ. F-score)

Precision и recall не зависят, в отличие от accuracy, от соотношения классов и потому применимы в условиях несбалансированных выборок.

Часто в реальной практике стоит задача найти оптимальный (для заказчика) баланс между этими двумя метриками. Понятно что чем выше точность и полнота, тем лучше. Но в реальной жизни максимальная точность и полнота не достижимы одновременно и приходится искать некий баланс. Поэтому, хотелось бы иметь некую метрику которая объединяла бы в себе информацию о точности и полноте нашего алгоритма. В этом случае нам будет проще принимать решение о том какую реализацию запускать в производство (у кого больше тот и круче). Именно такой метрикой является F-мера.

F-мера представляет собой гармоническое среднее между точностью и полнотой. Она стремится к нулю, если точность или полнота стремится к нулю.

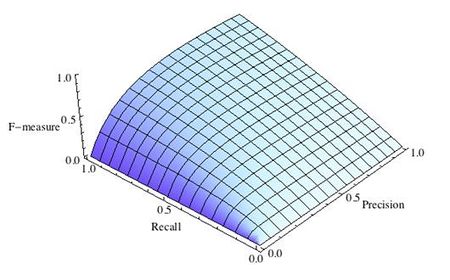

Данная формула придает одинаковый вес точности и полноте, поэтому F-мера будет падать одинаково при уменьшении и точности и полноты. Возможно рассчитать F-меру придав различный вес точности и полноте, если вы осознанно отдаете приоритет одной из этих метрик при разработке алгоритма:

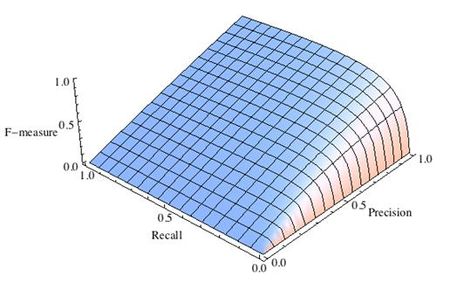

где принимает значения в диапазоне если вы хотите отдать приоритет точности, а при приоритет отдается полноте. При формула сводится к предыдущей и вы получаете сбалансированную F-меру (также ее называют ).

-

Рис.1 Сбалансированная F-мера,

-

Рис.2 F-мера c приоритетом точности,

-

Рис.3 F-мера c приоритетом полноты,

F-мера достигает максимума при максимальной полноте и точности, и близка к нулю, если один из аргументов близок к нулю.

F-мера является хорошим кандидатом на формальную метрику оценки качества классификатора. Она сводит к одному числу две других основополагающих метрики: точность и полноту. Имея «F-меру» гораздо проще ответить на вопрос: «поменялся алгоритм в лучшую сторону или нет?»

# код для подсчета метрики F-mera: # Пример классификатора, способного проводить различие между всего лишь двумя # классами, "пятерка" и "не пятерка" из набора рукописных цифр MNIST import numpy as np from sklearn.datasets import fetch_openml from sklearn.model_selection import cross_val_predict from sklearn.linear_model import SGDClassifier from sklearn.metrics import f1_score mnist = fetch_openml('mnist_784', version=1) X, y = mnist["data"], mnist["target"] y = y.astype(np.uint8) X_train, X_test, y_train, y_test = X[:60000], X[60000:], y[:60000], y[60000:] y_train_5 = (y_train == 5) # True для всех пятерок, False для в сех остальных цифр. Задача опознать пятерки y_test_5 = (y_test == 5) sgd_clf = SGDClassifier(random_state=42) # классификатор на основе метода стохастического градиентного спуска (Stochastic Gradient Descent SGD) sgd_clf.fit(X_train, y_train_5) # обучаем классификатор распознавать пятерки на целом обучающем наборе y_train_pred = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3) print(f1_score(y_train_5, y_train_pred)) # 0.7325171197343846

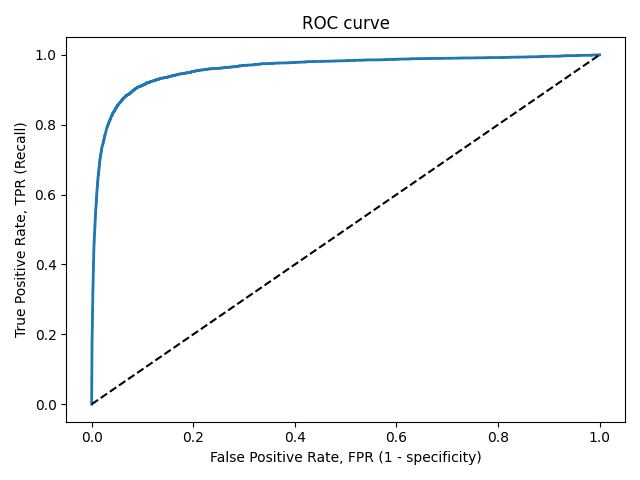

ROC-кривая

Кривая рабочих характеристик (англ. Receiver Operating Characteristics curve).

Используется для анализа поведения классификаторов при различных пороговых значениях.

Позволяет рассмотреть все пороговые значения для данного классификатора.

Показывает долю ложно положительных примеров (англ. false positive rate, FPR) в сравнении с долей истинно положительных примеров (англ. true positive rate, TPR).

Доля FPR — это пропорция отрицательных образцов, которые были некорректно классифицированы как положительные.

- ,

где TNR — доля истинно отрицательных классификаций (англ. Тrие Negative Rate), представляющая собой пропорцию отрицательных образцов, которые были корректно классифицированы как отрицательные.

Доля TNR также называется специфичностью (англ. specificity). Следовательно, ROC-кривая изображает чувствительность (англ. seпsitivity), т.е. полноту, в сравнении с разностью 1 — specificity.

Прямая линия по диагонали представляет ROC-кривую чисто случайного классификатора. Хороший классификатор держится от указанной линии настолько далеко, насколько это

возможно (стремясь к левому верхнему углу).

Один из способов сравнения классификаторов предусматривает измерение площади под кривой (англ. Area Under the Curve — AUC). Безупречный классификатор будет иметь площадь под ROC-кривой (ROC-AUC), равную 1, тогда как чисто случайный классификатор — площадь 0.5.

# Код отрисовки ROC-кривой # На примере классификатора, способного проводить различие между всего лишь двумя классами # "пятерка" и "не пятерка" из набора рукописных цифр MNIST from sklearn.metrics import roc_curve import matplotlib.pyplot as plt import numpy as np from sklearn.datasets import fetch_openml from sklearn.model_selection import cross_val_predict from sklearn.linear_model import SGDClassifier mnist = fetch_openml('mnist_784', version=1) X, y = mnist["data"], mnist["target"] y = y.astype(np.uint8) X_train, X_test, y_train, y_test = X[:60000], X[60000:], y[:60000], y[60000:] y_train_5 = (y_train == 5) # True для всех пятерок, False для в сех остальных цифр. Задача опознать пятерки y_test_5 = (y_test == 5) sgd_clf = SGDClassifier(random_state=42) # классификатор на основе метода стохастического градиентного спуска (Stochastic Gradient Descent SGD) sgd_clf.fit(X_train, y_train_5) # обучаем классификатор распозновать пятерки на целом обучающем наборе y_train_pred = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3) y_scores = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3, method="decision_function") fpr, tpr, thresholds = roc_curve(y_train_5, y_scores) def plot_roc_curve(fpr, tpr, label=None): plt.plot(fpr, tpr, linewidth=2, label=label) plt.plot([0, 1], [0, 1], 'k--') # dashed diagonal plt.xlabel('False Positive Rate, FPR (1 - specificity)') plt.ylabel('True Positive Rate, TPR (Recall)') plt.title('ROC curve') plt.savefig("ROC.png") plot_roc_curve(fpr, tpr) plt.show()

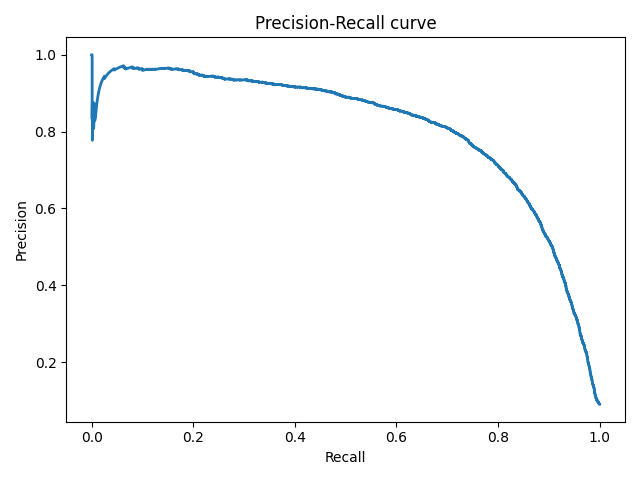

Precison-recall кривая

Чувствительность к соотношению классов.

Рассмотрим задачу выделения математических статей из множества научных статей. Допустим, что всего имеется 1.000.100 статей, из которых лишь 100 относятся к математике. Если нам удастся построить алгоритм , идеально решающий задачу, то его TPR будет равен единице, а FPR — нулю. Рассмотрим теперь плохой алгоритм, дающий положительный ответ на 95 математических и 50.000 нематематических статьях. Такой алгоритм совершенно бесполезен, но при этом имеет TPR = 0.95 и FPR = 0.05, что крайне близко к показателям идеального алгоритма.

Таким образом, если положительный класс существенно меньше по размеру, то AUC-ROC может давать неадекватную оценку качества работы алгоритма, поскольку измеряет долю неверно принятых объектов относительно общего числа отрицательных. Так, алгоритм , помещающий 100 релевантных документов на позиции с 50.001-й по 50.101-ю, будет иметь AUC-ROC 0.95.

Precison-recall (PR) кривая. Избавиться от указанной проблемы с несбалансированными классами можно, перейдя от ROC-кривой к PR-кривой. Она определяется аналогично ROC-кривой, только по осям откладываются не FPR и TPR, а полнота (по оси абсцисс) и точность (по оси ординат). Критерием качества семейства алгоритмов выступает площадь под PR-кривой (англ. Area Under the Curve — AUC-PR)

# Код отрисовки Precison-recall кривой # На примере классификатора, способного проводить различие между всего лишь двумя классами # "пятерка" и "не пятерка" из набора рукописных цифр MNIST from sklearn.metrics import precision_recall_curve import matplotlib.pyplot as plt import numpy as np from sklearn.datasets import fetch_openml from sklearn.model_selection import cross_val_predict from sklearn.linear_model import SGDClassifier mnist = fetch_openml('mnist_784', version=1) X, y = mnist["data"], mnist["target"] y = y.astype(np.uint8) X_train, X_test, y_train, y_test = X[:60000], X[60000:], y[:60000], y[60000:] y_train_5 = (y_train == 5) # True для всех пятерок, False для в сех остальных цифр. Задача опознать пятерки y_test_5 = (y_test == 5) sgd_clf = SGDClassifier(random_state=42) # классификатор на основе метода стохастического градиентного спуска (Stochastic Gradient Descent SGD) sgd_clf.fit(X_train, y_train_5) # обучаем классификатор распозновать пятерки на целом обучающем наборе y_train_pred = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3) y_scores = cross_val_predict(sgd_clf, X_train, y_train_5, cv=3, method="decision_function") precisions, recalls, thresholds = precision_recall_curve(y_train_5, y_scores) def plot_precision_recall_vs_threshold(precisions, recalls, thresholds): plt.plot(recalls, precisions, linewidth=2) plt.xlabel('Recall') plt.ylabel('Precision') plt.title('Precision-Recall curve') plt.savefig("Precision_Recall_curve.png") plot_precision_recall_vs_threshold(precisions, recalls, thresholds) plt.show()

Оценки качества регрессии

Наиболее типичными мерами качества в задачах регрессии являются

Средняя квадратичная ошибка (англ. Mean Squared Error, MSE)

MSE применяется в ситуациях, когда нам надо подчеркнуть большие ошибки и выбрать модель, которая дает меньше больших ошибок прогноза. Грубые ошибки становятся заметнее за счет того, что ошибку прогноза мы возводим в квадрат. И модель, которая дает нам меньшее значение среднеквадратической ошибки, можно сказать, что что у этой модели меньше грубых ошибок.

- и

Cредняя абсолютная ошибка (англ. Mean Absolute Error, MAE)

Среднеквадратичный функционал сильнее штрафует за большие отклонения по сравнению со среднеабсолютным, и поэтому более чувствителен к выбросам. При использовании любого из этих двух функционалов может быть полезно проанализировать, какие объекты вносят наибольший вклад в общую ошибку — не исключено, что на этих объектах была допущена ошибка при вычислении признаков или целевой величины.

Среднеквадратичная ошибка подходит для сравнения двух моделей или для контроля качества во время обучения, но не позволяет сделать выводов о том, на сколько хорошо данная модель решает задачу. Например, MSE = 10 является очень плохим показателем, если целевая переменная принимает значения от 0 до 1, и очень хорошим, если целевая переменная лежит в интервале (10000, 100000). В таких ситуациях вместо среднеквадратичной ошибки полезно использовать коэффициент детерминации —

Коэффициент детерминации

Коэффициент детерминации измеряет долю дисперсии, объясненную моделью, в общей дисперсии целевой переменной. Фактически, данная мера качества — это нормированная среднеквадратичная ошибка. Если она близка к единице, то модель хорошо объясняет данные, если же она близка к нулю, то прогнозы сопоставимы по качеству с константным предсказанием.

Средняя абсолютная процентная ошибка (англ. Mean Absolute Percentage Error, MAPE)

Это коэффициент, не имеющий размерности, с очень простой интерпретацией. Его можно измерять в долях или процентах. Если у вас получилось, например, что MAPE=11.4%, то это говорит о том, что ошибка составила 11,4% от фактических значений.

Основная проблема данной ошибки — нестабильность.

Корень из средней квадратичной ошибки (англ. Root Mean Squared Error, RMSE)

Примерно такая же проблема, как и в MAPE: так как каждое отклонение возводится в квадрат, любое небольшое отклонение может значительно повлиять на показатель ошибки. Стоит отметить, что существует также ошибка MSE, из которой RMSE как раз и получается путем извлечения корня.

Cимметричная MAPE (англ. Symmetric MAPE, SMAPE)

Средняя абсолютная масштабированная ошибка (англ. Mean absolute scaled error, MASE)

MASE является очень хорошим вариантом для расчета точности, так как сама ошибка не зависит от масштабов данных и является симметричной: то есть положительные и отрицательные отклонения от факта рассматриваются в равной степени.

Обратите внимание, что в MASE мы имеем дело с двумя суммами: та, что в числителе, соответствует тестовой выборке, та, что в знаменателе — обучающей. Вторая фактически представляет собой среднюю абсолютную ошибку прогноза. Она же соответствует среднему абсолютному отклонению ряда в первых разностях. Эта величина, по сути, показывает, насколько обучающая выборка предсказуема. Она может быть равна нулю только в том случае, когда все значения в обучающей выборке равны друг другу, что соответствует отсутствию каких-либо изменений в ряде данных, ситуации на практике почти невозможной. Кроме того, если ряд имеет тенденцию к росту либо снижению, его первые разности будут колебаться около некоторого фиксированного уровня. В результате этого по разным рядам с разной структурой, знаменатели будут более-менее сопоставимыми. Всё это, конечно же, является очевидными плюсами MASE, так как позволяет складывать разные значения по разным рядам и получать несмещённые оценки.

Недостаток MASE в том, что её тяжело интерпретировать. Например, MASE=1.21 ни о чём, по сути, не говорит. Это просто означает, что ошибка прогноза оказалась в 1.21 раза выше среднего абсолютного отклонения ряда в первых разностях, и ничего более.

Кросс-валидация

Хороший способ оценки модели предусматривает применение кросс-валидации (cкользящего контроля или перекрестной проверки).

В этом случае фиксируется некоторое множество разбиений исходной выборки на две подвыборки: обучающую и контрольную. Для каждого разбиения выполняется настройка алгоритма по обучающей подвыборке, затем оценивается его средняя ошибка на объектах контрольной подвыборки. Оценкой скользящего контроля называется средняя по всем разбиениям величина ошибки на контрольных подвыборках.

Примечания

- [1] Лекция «Оценивание качества» на www.coursera.org

- [2] Лекция на www.stepik.org о кросвалидации

- [3] Лекция на www.stepik.org о метриках качества, Precison и Recall

- [4] Лекция на www.stepik.org о метриках качества, F-мера

- [5] Лекция на www.stepik.org о метриках качества, примеры

См. также

- Оценка качества в задаче кластеризации

- Кросс-валидация

Источники информации

- [6] Соколов Е.А. Лекция линейная регрессия

- [7] — Дьяконов А. Функции ошибки / функционалы качества

- [8] — Оценка качества прогнозных моделей

- [9] — HeinzBr Ошибка прогнозирования: виды, формулы, примеры

- [10] — egor_labintcev Метрики в задачах машинного обучения

- [11] — grossu Методы оценки качества прогноза

- [12] — К.В.Воронцов, Классификация

- [13] — К.В.Воронцов, Скользящий контроль

Ошибки первого рода (англ. type I errors, α errors, false positives) и ошибки второго рода (англ. type II errors, β errors, false negatives) в математической статистике — это ключевые понятия задач проверки статистических гипотез. Тем не менее, данные понятия часто используются и в других областях, когда речь идёт о принятии «бинарного» решения (да/нет) на основе некоего критерия (теста, проверки, измерения), который с некоторой вероятностью может давать ложный результат.

Содержание

- 1 Определения

- 2 О смысле ошибок первого и второго рода

- 3 Вероятности ошибок (уровень значимости и мощность)

- 4 Примеры использования

- 4.1 Радиолокация

- 4.2 Компьютеры

- 4.2.1 Компьютерная безопасность

- 4.2.2 Фильтрация спама

- 4.2.3 Вредоносное программное обеспечение

- 4.2.4 Поиск в компьютерных базах данных

- 4.2.5 Оптическое распознавание текстов (OCR)

- 4.2.6 Досмотр пассажиров и багажа

- 4.2.7 Биометрия

- 4.3 Массовая медицинская диагностика (скрининг)

- 4.4 Медицинское тестирование

- 4.5 Исследования сверхъестественных явлений

- 5 См. также

- 6 Примечания

Определения

Пусть дана выборка

где

,

сопоставляющий каждой реализации выборки

- Распределение

выборки

соответствует гипотезе

, и она точно определена статистическим критерием, то есть

.

- Распределение

выборки

соответствует гипотезе

, но она неверно отвергнута статистическим критерием, то есть

.

- Распределение

выборки

соответствует гипотезе

, и она точно определена статистическим критерием, то есть

.

- Распределение

выборки

соответствует гипотезе

, но она неверно отвергнута статистическим критерием, то есть

.

Во втором и четвертом случае говорят, что произошла статистическая ошибка, и её называют ошибкой первого и второго рода соответственно. [1][2]

| Верная гипотеза | |||

|---|---|---|---|

|

|

||

| Результат применения критерия |

|

верно принята верно принята |

неверно принята неверно принята (Ошибка второго рода) |

|

неверно отвергнута неверно отвергнута (Ошибка первого рода) |

верно отвергнута верно отвергнута |

О смысле ошибок первого и второго рода

Как видно из вышеприведённого определения, ошибки первого и второго рода являются взаимно-симметричными, то есть если поменять местами гипотезы

С учётом этого ошибку первого рода часто называют ложной тревогой, ложным срабатыванием или ложноположительным срабатыванием — например, анализ крови показал наличие заболевания, хотя на самом деле человек здоров, или металлодетектор выдал сигнал тревоги, сработав на металлическую пряжку ремня. Слово «положительный» в данном случае не имеет отношения к желательности или нежелательности самого события.

Термин широко используется в медицине. Например, тесты, предназначенные для диагностики заболеваний, иногда дают положительный результат (т.е. показывают наличие заболевания у пациента), когда на самом деле пациент этим заболеванием не страдает. Такой результат называется ложноположительным.

В других областях обычно используют словосочетания со схожим смыслом, например, «ложное срабатывание», «ложная тревога» и т.п. В информационных технологиях часто используют английский термин false positive без перевода.

Из-за возможности ложных срабатываний не удаётся полностью автоматизировать борьбу со многими видами угроз. Как правило, вероятность ложного срабатывания коррелирует с вероятностью пропуска события (ошибки второго рода). То есть: чем более чувствительна система, тем больше опасных событий она детектирует и, следовательно, предотвращает. Но при повышении чувствительности неизбежно вырастает и вероятность ложных срабатываний. Поэтому чересчур чувствительно (параноидально) настроенная система защиты может выродиться в свою противоположность и привести к тому, что побочный вред от неё будет превышать пользу.

Соответственно, ошибку второго рода иногда называют пропуском события или ложноотрицательным срабатыванием — человек болен, но анализ крови этого не показал, или у пассажира имеется холодное оружие, но рамка металлодетектора его не обнаружила (например, из-за того, что чувствительность рамки отрегулирована на обнаружение только очень массивных металлических предметов).

Слово «отрицательный» в данном случае не имеет отношения к желательности или нежелательности самого события.

Термин широко используется в медицине. Например, тесты, предназначенные для диагностики заболеваний, иногда дают отрицательный результат (т.е. показывают отсутствие заболевания у пациента), когда на самом деле пациент страдает этим заболеванием. Такой результат называется ложноотрицательным.

В других областях обычно используют словосочетания со схожим смыслом, например, «пропуск события», и т.п. В информационных технологиях часто используют английский термин false negative без перевода.

Степень чувствительности системы защиты должна представлять собой компромисс между вероятностью ошибок первого и второго рода. Где именно находится точка баланса, зависит от оценки рисков обоих видов ошибок.

Вероятности ошибок (уровень значимости и мощность)

Вероятность ошибки первого рода при проверке статистических гипотез называют уровнем значимости и обычно обозначают греческой буквой

Вероятность ошибки второго рода не имеет какого-то особого общепринятого названия, на письме обозначается греческой буквой

Обе эти характеристики обычно вычисляются с помощью так называемой функции мощности критерия. В частности, вероятность ошибки первого рода есть функция мощности, вычисленная при нулевой гипотезе. Для критериев, основанных на выборке фиксированного объема, вероятность ошибки второго рода есть единица минус функция мощности, вычисленная в предположении, что распределение наблюдений соответствует альтернативной гипотезе. Для последовательных критериев это также верно, если критерий останавливается с вероятностью единица (при данном распределении из альтернативы).

В статистических тестах обычно приходится идти на компромисс между приемлемым уровнем ошибок первого и второго рода. Зачастую для принятия решения используется пороговое значение, которое может варьироваться с целью сделать тест более строгим или, наоборот, более мягким. Этим пороговым значением является уровень значимости, которым задаются при проверке статистических гипотез. Например, в случае металлодетектора повышение чувствительности прибора приведёт к увеличению риска ошибки первого рода (ложная тревога), а понижение чувствительности — к увеличению риска ошибки второго рода (пропуск запрещённого предмета).

Примеры использования

Радиолокация

В задаче радиолокационного обнаружения воздушных целей, прежде всего, в системе ПВО ошибки первого и второго рода, с формулировкой «ложная тревога» и «пропуск цели» являются одним из основных элементов как теории, так и практики построения радиолокационных станций. Вероятно, это первый пример последовательного применения статистических методов в целой технической области.

Компьютеры

Понятия ошибок первого и второго рода широко используются в области компьютеров и программного обеспечения.

Компьютерная безопасность

Наличие уязвимостей в вычислительных системах приводит к тому, что приходится, с одной стороны, решать задачу сохранения целостности компьютерных данных, а с другой стороны — обеспечивать нормальный доступ легальных пользователей к этим данным (см. компьютерная безопасность). Moulton (1983, с.125) отмечает, что в данном контексте возможны следующие нежелательные ситуации:

- когда нарушители классифицируются как авторизованные пользователи (ошибки первого рода)

- когда авторизованные пользователи классифицируются как нарушители (ошибки второго рода)

Фильтрация спама

Ошибка первого рода происходит, когда механизм блокировки/фильтрации спама ошибочно классифицирует легитимное email-сообщение как спам и препятствует его нормальной доставке. В то время как большинство «антиспам»-алгоритмов способны блокировать/фильтровать большой процент нежелательных email-сообщений, гораздо более важной задачей является минимизировать число «ложных тревог» (ошибочных блокировок нужных сообщений).

Ошибка второго рода происходит, когда антиспам-система ошибочно пропускает нежелательное сообщение, классифицируя его как «не спам». Низкий уровень таких ошибок является индикатором эффективности антиспам-алгоритма.

Пока не удалось создать антиспамовую систему без корреляции между вероятностью ошибок первого и второго рода. Вероятность пропустить спам у современных систем колеблется в пределах от 1% до 30%. Вероятность ошибочно отвергнуть валидное сообщение — от 0,001 % до 3 %. Выбор системы и её настроек зависит от условий конкретного получателя: для одних получателей риск потерять 1% хорошей почты оценивается как незначительный, для других же потеря даже 0,1% является недопустимой.

Вредоносное программное обеспечение

Понятие ошибки первого рода также используется, когда антивирусное программное обеспечение ошибочно классифицирует безвредный файл как вирус. Неверное обнаружение может быть вызвано особенностями эвристики, либо неправильной сигнатурой вируса в базе данных. Подобные проблемы могут происходить также и с антитроянскими и антишпионскими программами.

Поиск в компьютерных базах данных

При поиске в базе данных к ошибкам первого рода можно отнести документы, которые выдаются поиском, несмотря на их иррелевантность (несоответствие) поисковому запросу. Ошибочные срабатывания характерны для полнотекстового поиска, когда поисковый алгоритм анализирует полные тексты всех хранимых в базе данных документов и пытается найти соответствия одному или нескольким терминам, заданным пользователем в запросе.

Большинство ложных срабатываний обусловлены сложностью естественных языков, многозначностью слов: например, «home» может обозначать как «место проживания человека», так и «корневую страницу веб-сайта». Число подобных ошибок может быть снижено за счёт использования специального словаря. Однако это решение относительно дорогое, поскольку подобный словарь и разметка документов (индексирование) должны создаваться экспертом.

Оптическое распознавание текстов (OCR)

Разнообразные детектирующие алгоритмы нередко выдают ошибки первого рода. Программное обеспечение оптического распознавания текстов может распознать букву «a» в ситуации, когда на самом деле изображены несколько точек, которые используемый алгоритм расценил как «a».

Досмотр пассажиров и багажа

Ошибки первого рода регулярно встречаются каждый день в компьютерных системах предварительного досмотра пассажиров в аэропортах. Установленные в них детекторы предназначены для предотвращения проноса оружия на борт самолёта; тем не менее, уровень чувствительности в них зачастую настраивается настолько высоко, что много раз за день они срабатывают на незначительные предметы, такие как ключи, пряжки ремней, монеты, мобильные телефоны, гвозди в подошвах обуви и т.п. (см. обнаружение взрывчатых веществ, металлодетекторы).