Научиться настраивать MikroTik с нуля или систематизировать уже имеющиеся знания можно на углубленном курсе по администрированию MikroTik. Автор курса, сертифицированный тренер MikroTik Дмитрий Скоромнов, лично проверяет лабораторные работы и контролирует прогресс каждого своего студента. В три раза больше информации, чем в вендорской программе MTCNA, более 20 часов практики и доступ навсегда.

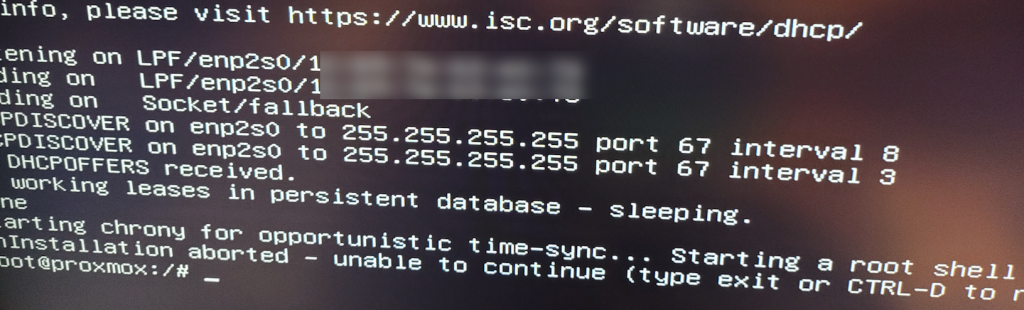

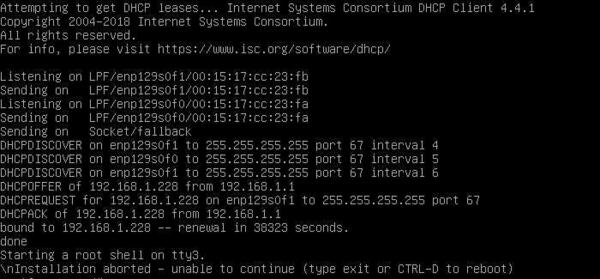

Данной ошибке подвержены все версии Proxmox Virtual Environment 6.х и возникает она на системах, содержащих процессоры AMD со встроенным видеоядром. Причина — установщик не может запуститься в графическом режиме, а текстовый вариант установщика не предусмотрен. Внешне это проявляется так: система получает сетевые настройки по DHCP, затем долго задумывается после сообщения:

Starting a root shell on tty3.И наконец «радует» нас сообщением:

nInstallation aborted - unable to continue (type exit or CTRL-D to reboot)

Второй — попытаться исправить все прямо здесь и сейчас. Предложенный ниже способ не панацея, однако в большинстве случаев способен помочь.

Прежде всего переключаемся в третью консоль — tty3. Для этого используйте сочетание клавиш Alt + F3. Уже в ней установим необходимые права на директорию временных файлов:

chmod 1777 /tmpИ обновим систему:

apt update && apt upgradeНа все запросы отвечаем положительно.

Теперь перенастроим графическую подсистему:

Xorg -configureОбратите внимание на регистр команд, в Linux это важно. Переместим полученный нами файл настроек в /etc:

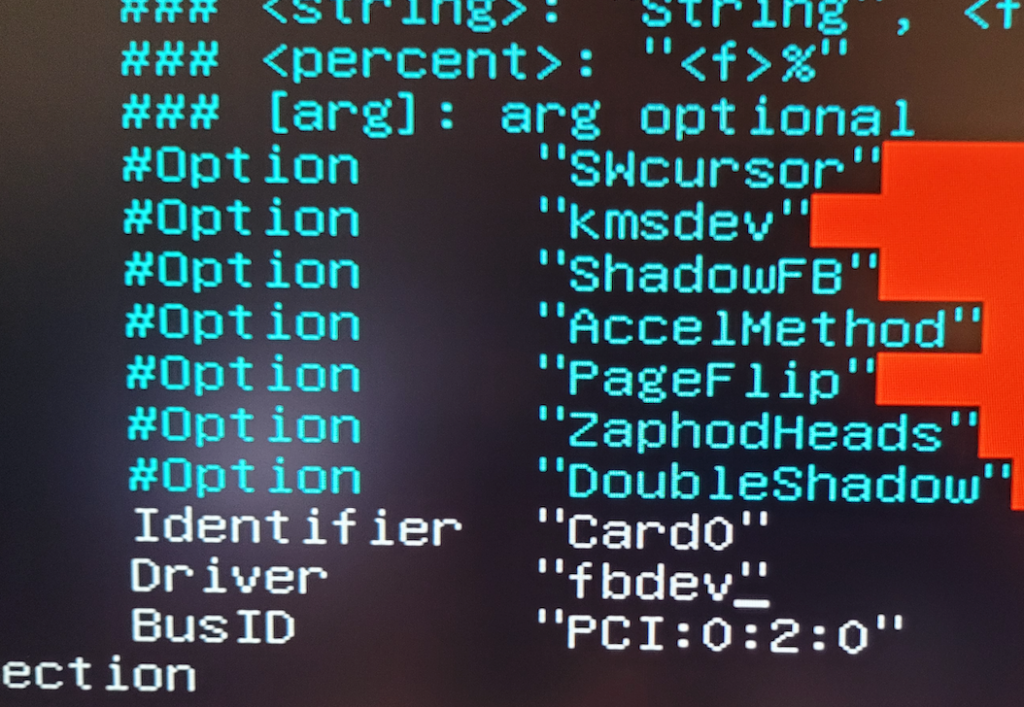

mv /root/xorg.conf.new /etc/X11/xorg.confПосле чего заменим в нем все вхождения amdgpu на fbdev:

sed -i "s/amdgpu/fbdev/g" /etc/X11/xorg.confЗатем снова вернемся в первую консоль tty1 — Alt + F1 и запустим графическую оболочку:

startxВ большинстве случаев это должно помочь, и установка успешно продолжится. Иначе следует прислушаться к совету разработчиков и установить сначала Debian 10, а уже на него Proxmox.

По материалам: Proxmox 6.2-1 installation fails after DHCP lease obtained.

Научиться настраивать MikroTik с нуля или систематизировать уже имеющиеся знания можно на углубленном курсе по администрированию MikroTik. Автор курса, сертифицированный тренер MikroTik Дмитрий Скоромнов, лично проверяет лабораторные работы и контролирует прогресс каждого своего студента. В три раза больше информации, чем в вендорской программе MTCNA, более 20 часов практики и доступ навсегда.

-

#5

Note that I would like the root partition in zfs raid1…

in that case i’d recommend going via 6.4 and upgrading first

if nothing is on it, the upgrade should not take long and there should not be any issues

-

#10

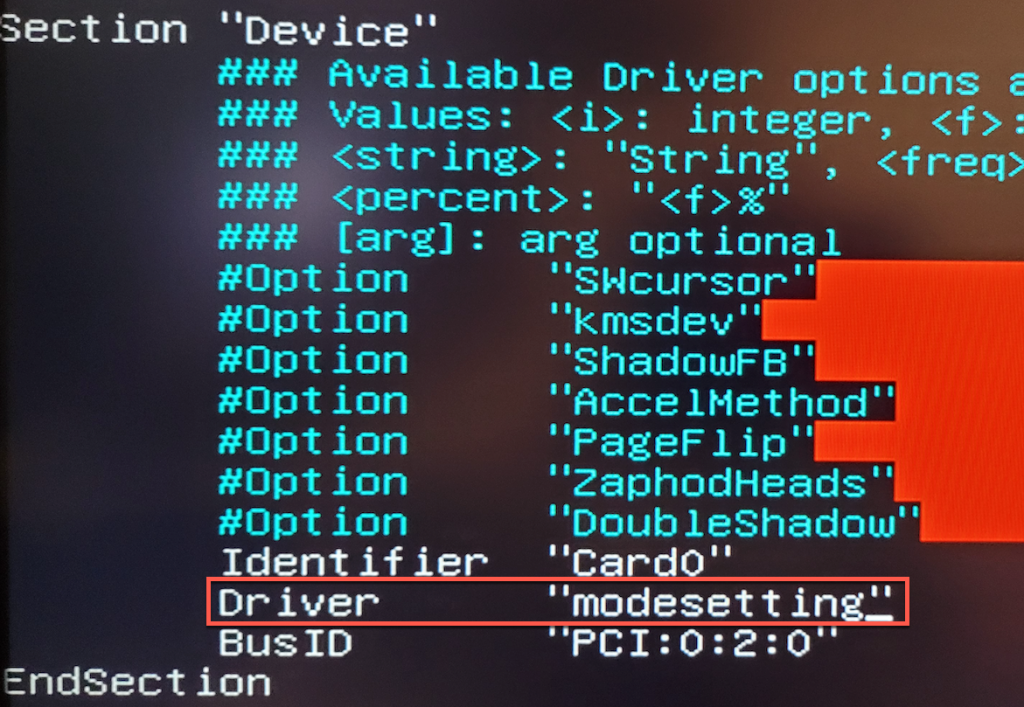

I solved this problem as follows:

On the initial installation screen I chose the option «with DEBUG», at the first stop, I gave the sequence (CTRL+D), at the second stop I switched to another console (ALT+F3) for example, I typed Xorg -configure, it will generate a file called xorg.conf.new in /root or / , then copied it to the directory /etc/X11/ with the name of xorg.conf (cp /root/xorg.conf.new /etc/X11/xorg.conf and in then I edited this file with nano /etc/X11/xorg.conf and in the «Device» section I changed the «Driver» option to «fbdev», save the change. Return to the installation console (ALT+F1) and press CTRL +D to continue, after finishing the installation of everything it will return to the F1 console, just press CTRL+D again and it will finish the installation.

Last edited: Apr 14, 2022

I have done a lot of Proxmox installations inside my lab, but one with the NUC 11 was toughest I ever did. I had a lot of issues and one of them was “installation aborted – unable to continue” on every Proxmox installation I started.

Before we begin

I have a small lab which consist of various Intel NUC machines, I love them because they don’t take a lot of space, they are pretty powerful for the size and a lot of “enterprise” software works on them without a lot of fiddling.

So far, my Proxmox installations on these NUCs went mostly trouble free, but the last one was – well troublesome at best.

- Installation would end with “unable to continue”

- I also got “failed to prepare EFI boot using Grub” error

- Not all of my network adapters would work

I lost cca 8 hours in the end to get everything to work, and it was pretty frustrating, because I planned other things to do on these machines, but instead I was wrestling with the Proxmox.

In the end I managed to get everything to work, I found some bits on the internet, a lot of parts I figured myself after I did some diagnostics.

I can see that other people are struggling too with the NUC 11 configurations.

Here is what I have:

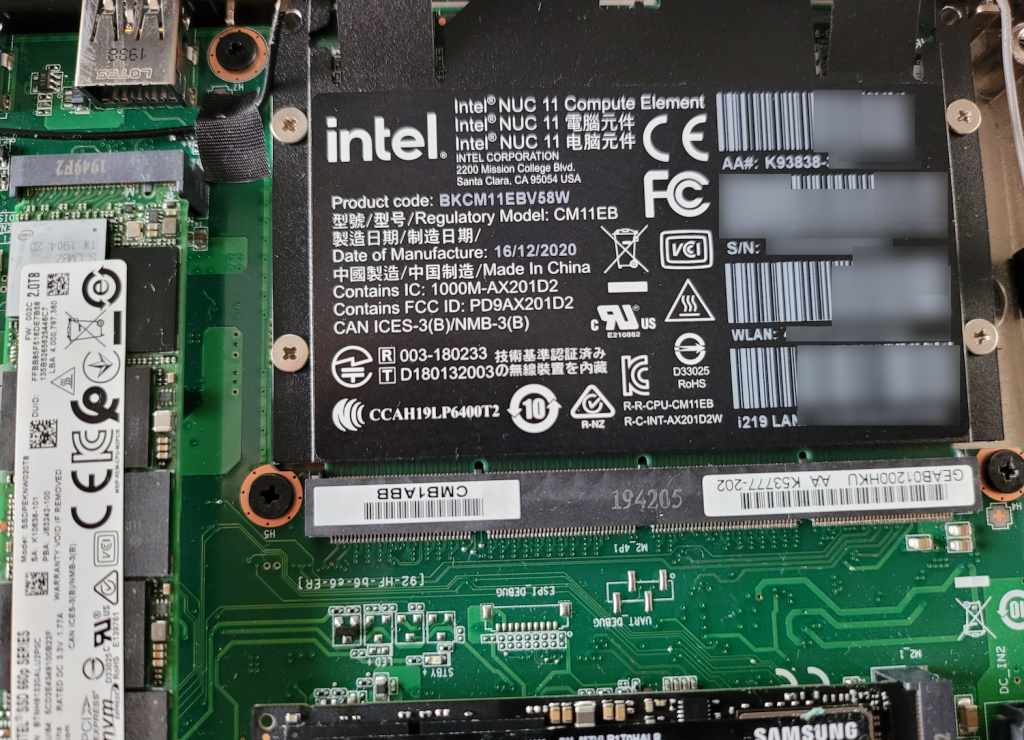

Intel NUC Rugged Chassis Element BKCMCR1ABB2 – that is chassis with board in it – board itself has two network cards on it (Intel I219-LM and I211-AT). Great for my needs, it also has two NVMe slots.

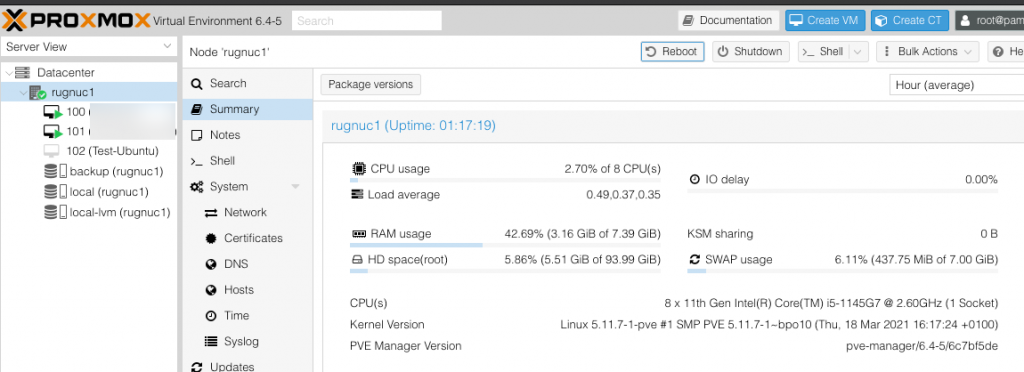

On that board I plugged in Intel NUC11 Compute Element – it has Intel i5 1145G7 CPU on it with 8GB of RAM

I can see that people with various other NUC11 configs have problems with Proxmox installation.

Installation errors

Installation aborted – unable to continue

I downloaded latest Proxmox 6.4.4 install from the Proxmox website (for the first time, I have older 6.xx installers).

I prepared ISO on USB drive with Rufus and made UEFI install in DD mode.

I also disabled Secure Boot on the new NUC11.

After the first installer boot, it would try to get address from DHCP, but would fail and after that I got “installation aborted – unable to continue”

Sorry for the poor screenshots, it was late and I wasn’t really in the good mood.

I tried with older Proxmox installs and on both ports on my NUC – but no luck. I would stuck here every time.

If you want to use network during install you can use USB dongle (you should also have DHCP available on your network).

Let’s now resolve the error above.

After you get the “installation aborted – unable to continue” error press ALT + F3 to switch to TTY3 console

Enter following commands

Xorg -configure

mv /root/xorg.conf.new /etc/X11/xorg.confAfter that we need to edit xorg.conf file

nano /etc/X11/xorg.confFind value Driver “modesetting” in that file.

Change it to “fbdev”

Save and exit file

Type in following command in order to exit TTY3

exitGo back to TTY 1 by pressing ALT+F1.

Type in following command to start your installation

startxIf you only have this error, that will be the end for you.

In case this procedure above does not work for some reason for you (lack of rights…), after you get error just type following commands

Do this only if the above procedure does not work!

chmod 1777 /tmp

apt update

Xorg -configure

mv /xorg.conf.new /etc/X11/xorg.conf

nano /etc/X11/xorg.confAfter you enter xorg.conf change driver value to fbdev, like depicted above. Save and exit file

Type in

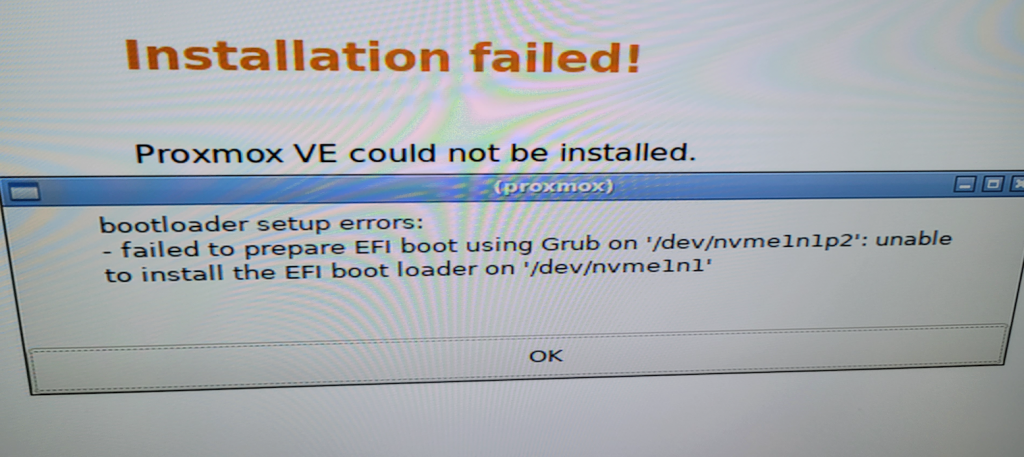

startxFailed to prepare EFI boot using Grub

I was able to start installation procedure, but in the end, on 99% of the installation done, I got following

“bootloader setup errors: failed to prepare efi boot using Grub”

“unable to install the EFI boot loader on…”

I really tried a lot of thing the get around this.

One of the things to get around all these issues was to use Debian and then Proxmox on top of it – but I was stubborn to do that. 🙂

On new NUCs there is no more “legacy BIOS” and trick to Disable Secure Boot and Modern Standby in NUCs BIOS to get “legacy BIOS” does not work.

I tried different drives, repair procedures, setup tricks, but I couldn’t get past this error.

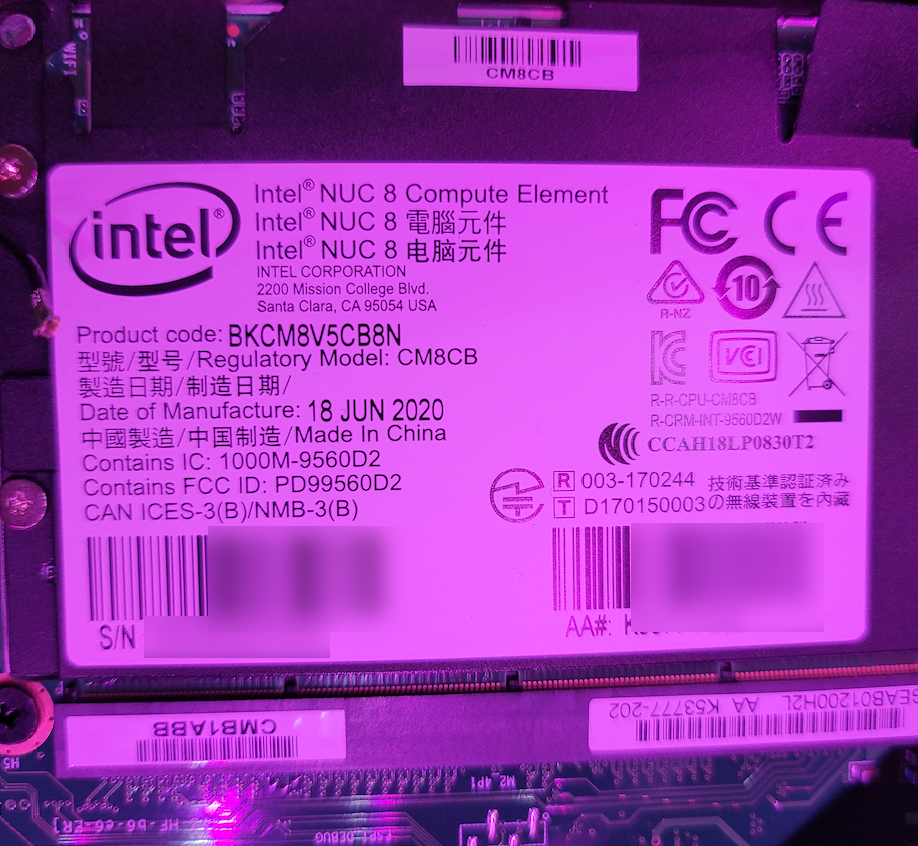

What I did in the end is that I used older NUC8 Compute Element inside my new chassis to install Proxmox.

So, I unplugged mu NUC11 Compute Element

And installed NUC 8 Compute Element I got at hand

With NUC 8 Compute Element everyhing went smooth – no errors, no hickups, and I got past the boot error.

After installer was done and I was into Proxmox GUI – i turned it off and put my NUC 11 card back into the Chassis.

It was able to boot and I finally was able to have working installation of Proxmox

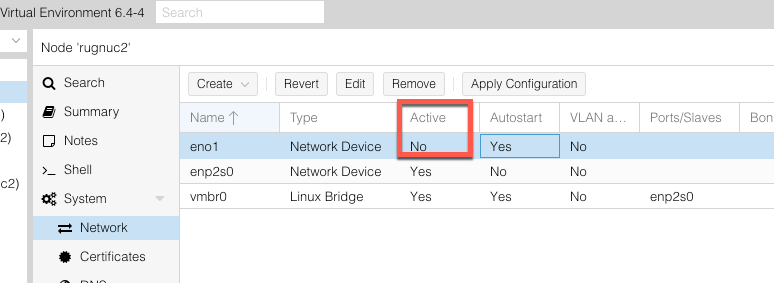

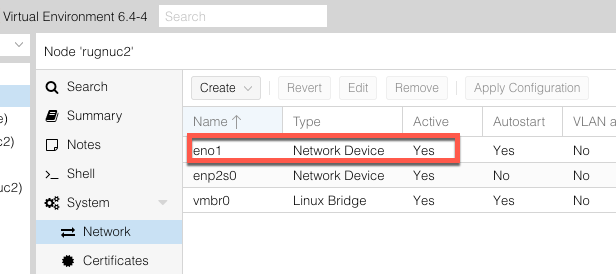

But, not all was great. I have two network adapters. Only one was working – I211-AT.

Networking issues

Interface eno1 would not go up (be in active mode) whatever I do.

Second card enp2s0 (Intel I 211) was working ok, and I was using it to manage my Proxmox install. But, it is crucial for me to have both card working, and I didn’t want to use USB network cards.

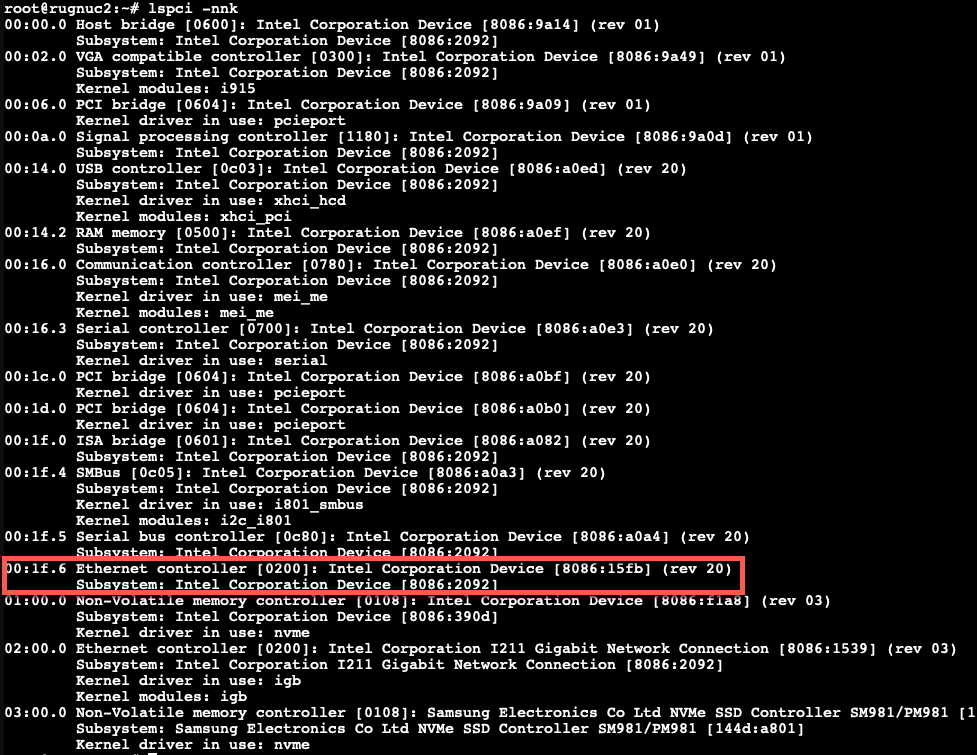

In shell after I executed lspci -nnk command, I could see that 00:1f:6 which is my dirst NIC, does not have proper drivers displayed.

I know for a fact that Intel I219 is recognized inside Proxmox 6.xx, so this is another weird glitch.

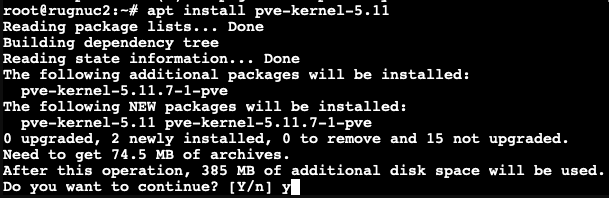

To resolve this I run first (you need to enable pvetest repos before you do this). Here is how to enable repos on Proxmox

apt updateand then I run following

apt install pve-kernel-5.11After installation reboot your Proxmox install

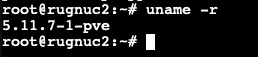

After reboot, again open shell and type in

uname -rYou should be running 5.11 kernel

and now my network interfaces are working

To be honest, if I put network adapter in passthrough mode and assign it to VM, it still doesn’t work, but as a workaround, I create Linux Bridge and assign it to VM.

That is it, we now have functioning Proxmox on NUC 11

Disclaimer

Используемые термины: Proxmox VE, Linux.

В данной инструкции мы пошагово разберем способы установки Proxmox VE, базовую настройку и создание виртуальной машины. Proxmox основан на Debian — поэтому установку будем выполнять на данный дистрибутив Linux. В данной инструкции работа ведется на Proxmox версии 6.

Системные требования

Установка Proxmox

Из готового образа

Установка на Debian

Проверка установки

Базовая настройка

Как загрузить ISO-образ

Создание сетей

Bridge

NAT

Сеть между виртуалками

Создание виртуальной машины

Настройка виртуальной машины

Базовые настройки

Добавление диска

Добавление сетевого адаптера

Установка гостевого агента

Удаление виртуальной машины

Тюнинг Proxmox

Предупреждения об отсутствии подписки

Правильный сертификат

Создание нового пользователя

Ubuntu и CentOS

Решение возможных проблем

Дополнительная информация

Системные требования

Требования разделены на минимальные и рекомендованные:

| Минимальные | Рекомендованные | |

|---|---|---|

| Процессор | 64bit с поддержкой технологии виртуализации Intel VT или AMD-V | |

| Память | 1 Гб | 2 Гб для системы + для виртуальных машин. Дополнительно, если используется хранилище Ceph или ZFS, 1 Гб на наждый ТБ данных. |

| Накопитель | HDD | SSD или NVMe |

| Сеть | Сетевой адаптер | Минимум, 2 сетевых адаптера на 10 Гбит/сек. |

Поддержка виртуализации Intel VT или AMD-V может быть отключена на материнской плате. Для проверки заходим в БИОС — находим раздел настройки процессора (как правило, в пункте меню Advanced) — проверяем, что технология виртуализации (Intel VT, AMD-V, Virtualization Technology, VMX) включена (Enabled). Если мы хотим протестировать платформу и устанавливаем ее на виртуальную машину, то в ее настройках включаем поддержку технологии виртуализации. Например, в VMware ESX 6 в настройке виртуальной машины на вкладке Virtual Hardware раскрываем CPU и ставим галочку Expose hardware assisted virtualization to the guest OS:

Установка

Есть два варианта установки Proxmox VE — использовать готовый образ или установка на Debian. Мы рассмотрим оба.

Установка готового образа ISO

1. Переходим на страницу загрузки Proxmox официального сайта. Загружаем дистрибутив, например, Proxmox VE 6.1:

2. Если установка выполняется на виртуальную машину, монтируем образ. Если нет — создаем установочную флешку, например, с помощью WinSetupFromUsb или загрузочный диск с помощью InfraRecorder.

3. Загружаем сервер с установочного ISO — мы увидим окно приветствия Proxmox — выбираем пункт меню Install Proxmox VE:

4. Принимаем лицензионное соглашения, кликнув по I agree.

5. Выбираем диск, на который будет установлена система:

* при необходимости, кликаем по Options и задаем настройки файловой системы и размера раздела.

6. Пишем страну, временную зону, язык раскладки клавиатуры по умолчанию:

7. Вводим дважды пароль, который будет использоваться для пользователя root:

8. Прописываем сетевые настройки:

* где:

- Management Interface: сетевой интерфейс для управления сервером виртуальных машин.

- Hostname (FQDN): имя хоста для сервера.

- IP Address: IP-адрес нашего сервера.

- Netmask: маска подсети для сервера.

- Gateway: шлюз по умолчанию.

- DNS Server: сервер DNS.

9. В окне «Summary» проверяем введенные данные и кликаем по Install. Начнется процесс установки, который займет не более 10 минут.

10. После установки мы должны увидеть «Installation Successful» — перезагружаем сервер, кликнув по кнопке Reboot.

После переходим к проверке установки.

Установка на Debian

Если мы решили установить Proxmox на уже установленный Debian, выполняем следующую инструкцию.

При установке среды виртуализации меняется ядро Linux. Это может привести к потери работоспособности уже установленных сервисов. Таким образом, установку Proxmox следует выполнять на чистый сервер, а не тот, который уже используется для каких-либо задач.

1. Имя сервера должно разрешаться по его IP-адресу. Для этого либо добавляем А-запись в DNS, либо настраиваем на сервере файл hosts:

nano /etc/hosts

… и добавляем:

192.168.1.55 proxmox.dmosk.local proxmox

* где 192.168.1.55 — IP-адрес нашего сервера; proxmox — имя сервера; dmosk.local — наш домен, если используется.

2. Добавляем репозитории, которые будем устанавливать для установки Proxmox PE и дополнительных компонентов:

nano /etc/apt/sources.list

deb http://mirror.yandex.ru/debian/ buster main non-free contrib

deb-src http://mirror.yandex.ru/debian/ buster main non-free contrib

deb http://download.proxmox.com/debian/pve buster pve-no-subscription

Чтобы мы могли работать с репозиторием proxmox добавляем в систему цифровую подпись:

wget http://download.proxmox.com/debian/proxmox-ve-release-6.x.gpg -O /etc/apt/trusted.gpg.d/proxmox-ve-release-6.x.gpg

Обновляем список пакетов:

apt update

3. Устанавливаем Proxmox PE и компоненты:

apt install proxmox-ve open-iscsi

* где proxmox-ve — собственно, сам гипервизор; open-iscsi — iSCSI-клиент для подключения iSCSI-target-ов.

4. Перезагружаем сервер:

systemctl reboot

Проверка установки

В браузере открываем панель управления системой виртуализации по адресу https://<IP-адрес сервера>:8006. В открывшемся окне выбираем язык, вводим логин и пароль от пользователя root:

Должно открыться окно управления.

Начальная настройка

Чтобы начать использовать Proxmox и создать первую виртуальную машину, внесем небольшие настройки и подготовим гипервизор к работе.

1. Загрузка образов

Кликаем по Датацентр — и дважды по storage:

* мы можем создать отдельное хранилище для образов ISO. Для этого переходим в раздел Датацентр — Хранилище — Создать — Каталог.

Переходим в раздел Содержимое и кликаем по Загрузить:

В открывшемся окне выбираем ISO-образ системы, который будем устанавливать в качестве гостевой и кликаем по Загрузить. Ждем окончания копирования файла на сервер.

2. Создание сети для виртуальных машин

Мы рассмотрим примеры создания 2-х режимов сети — Bridge и NAT.

Независимо от способа установки Proxmox, необходимо подключиться к хосту по SSH и установить пакет ifupdown2 командой:

apt install ifupdown2

* ifupdown2 — утилита для конфигурации сетевого интерфейса (по сути, аналог ifupdown, написанный на языке Python).

… в противном случае, при попытке применить сетевые настройки мы получим ошибку you need ifupdown2 to reload networking (500).

Bridge

Сеть, работающая в данном режиме позволяет виртуальной машине видеть локальную сеть, как будто это отдельно стоящее устройство. Данный режим лучше всего подойдет для серверов, стоящих в локальной сети компании.

Работать с режимом Bridge нужно очень осторожно. Любое неправильное действие и удаленный доступ к серверу будет потерян. Если работы ведутся на удаленном сервере, рекомендуется сначала потренироваться на какой-нибудь локальной машине.

Также стоит отметить, что при установке PVE из установочного ISO-образа, один Bridge уже будет создан.

Для создания бриджа в панели управления кликаем по нашему серверу Proxmox — переходим в раздел Система — Сеть — обратите внимание, чтобы в системе не было bridge-интерфейсов:

… иначе, создавать его не обязательно.

Открываем настройки сетевого интерфейса, через который будет работать наш мост и удаляем шлюз:

* если мы не сделаем этого, то при настройке Bridge мы получим ошибку Parameter verification failed. (400). gateway: Default gateway already exists on interface ‘ens160’.

Нажимаем Создать и выбираем Linux Bridge:

В открывшемся окне заполняем поля IPv4/CIDR, Шлюз (IPv4), Порты сетевого моста:

* в данном примере мы задаем IP-адрес, на котором будет работать Proxmox (чтобы ничего не перепутать, можно задать IP-адрес физического интерфейса, который будет задействован под Bridge); маска указывается в нотации CIDR и в нашем примере это 24 или 255.255.255.0; в качестве физического интерфейса наш bridge будет использовать ens160.

… нажимаем Создать.

Кликаем по Apply Configuration, чтобы применить сетевые настройки:

Подтверждаем действия.

NAT

Данный режим сети активно применяется в случае аренды сервера, где количество IP-адресов лимитировано. В данном случае, все виртуальные машины будут находисться за NAT, в качестве которого выступает сам Proxmox.

Сам интерфейс мы делаем из панели управления. Но чтобы виртуальные машины могли выходить в Интернет через сеть NAT, необходимо на самом хосте включить редирект и маскарадинг.

Создание нового bridge-интерфеса

Итак, кликаем по нашему серверу Proxmox — переходим в раздел Система — Сеть — нажимаем Создать и выбираем Linux Bridge:

Оставляем имя vmbr1 или пишем любое другое, прописываем IP-адрес с маской сети, в которой будут находиться серверы за NAT:

Нажимаем Создать. Применяем настройки:

Сеть настроена.

Настройка ядра и брандмауэра

Подключаемся к серверу по SSH. Открываем на редактирование файл настройки ядра:

nano /etc/sysctl.d/99-sysctl.conf

… и добавляем разрешение на редирект:

net.ipv4.ip_forward=1

После применяем настройки:

sysctl -p /etc/sysctl.d/99-sysctl.conf

Добавляем правило в брандмауэр:

iptables -t nat -I POSTROUTING -s ‘192.168.122.0/24’ -o vmbr0 -j MASQUERADE

* в данном примере мы создали правило для маскарадинга всех пакетов из подсети 192.168.122.0/24 и для исходящего интерфейса vmbr0. Обратите внимание, что если у нас будет другая подсеть и исходящий интерфейс для сети Интернет, то нужно будет задать другие значения.

Ставим утилиту для сохранения правил iptables:

apt install iptables-persistent

… и сохраняем правила в процессе установки или командой:

netfilter-persistent save

Наш NAT настроен.

Сеть между виртуалками

Данная сеть — частный случай NAT без выхода в Интернет. Мы должны создать бридж с отдельной подсетью без шлюза. При добавлении виртуальным машинам данного сетевого адаптера мы сможем настроить их взаимодействие по внутренней сети.

Создаем бридж, как делали это ранее:

Настраиваем новый интерфейс — задаем имя или оставляем тот, что предложит система, а также указываем IP-адрес:

Создаем интерфейс. Готово — при создании или редактировании виртуалок, мы можем указывать с качестве интерфейса созданный бридж (в данном примере, vmbr2) для изоляции их в отдельную подсеть 192.168.150.0/24.

Создание виртуальной машины

Базовая настройка закончена — можно опробовать наш гипервизор в деле.

В правой верхней части панели управления кликаем по Создать VM:

В открывшемся окне снизу сразу ставим галочку Расширенный:

Задаем имя виртуальной машине и ставим галочку Запуск при загрузке (если хотим, чтобы виртуалка запускалась автоматически с сервером PVE):

* в данном примере мы задали имя FS. При желании, также можно изменить VM ID, но он проставляется автоматически и имеет правильное значение.

Выбираем загруженный нами ISO-образ, с которого будем ставить операционную систему, задаем тип гостевой операционной системы и ее версию:

* в данном примере мы будем устанавливать Linux Ubuntu. Среди списка операционных систем также доступны Microsoft Windows, Solaris и Other.

На вкладке Система можно оставить все значения по умолчанию:

* в некоторых случаях, необходимо выбрать другую видеокарту (при установке систем с GUI), а также особый вариант БИОС.

Задаем размер жесткого диска:

* 16 Гб для Ubuntu достаточно, однако, для наших задач расчет должен быть индивидуальным для каждой создаваемой виртуальной машины.

Мы можем задать количество процессоров и ядер:

* в данном примере мы создаем виртуалку с 2 процессорами, каждый из который с 2 ядрами, итого, 4. Для ненагруженных систем можно оставить значение по умолчанию.

Выделяем память:

* наша Ubuntu будет работать с 2 Гб оперативной памяти.

Выбираем созданный нами бридж — либо для получения прямого адреса из сети, либо для NAT:

* в данном примере, мы указали vmbr0 для подключения к сети напрямую.

Ставим галочку, чтобы виртуальная машина сразу запустилась после создания:

… и нажимаем Готово. Ждем окончания процесса и переходим к консоли:

Мы должны увидеть загрузку с ISO-образа.

Настройка виртуальной машины

После создания виртуальной машины нам может понадобиться ее изменить. Рассмотрим процесс настройки на примере изменения некоторых параметром, а также добавления диска и сетевого адаптера.

Полезные настройки

Для начала, переходим к виртуальной машине — Параметры:

На мой взгляд, чаще всего могут понадобиться следующие настройки:

- Имя — имя виртуальной машины.

- Запуск при загрузке — для серверов данный параметр должен быть активирован.

- Порядок загрузки — позволяет определить, с какого устройства должна запуститься виртуалка в первую очередь.

Для изменения параметра, просто кликаем по нему дважды, меняем значение и нажимаем OK.

Добавление дискового накопителя

Переходим в подраздел Оборудование — кликаем по Добавить и выбираем Жесткий диск:

В открывшемся окне задаем размер диска и нажимаем OK.

Для увеличения размера имеющегося диска устанавливаем на него курсов и кликаем по Изменить размер диска:

В открывшемся окне задаем объем, на который нужно увеличить дисковое пространство.

Добавление сетевого адаптера

Переходим в подраздел Оборудование — кликаем по Добавить и выбираем Сетевое устройство:

Как при создании ВМ, выбираем тип сетевого адаптера (бридж или нат) и нажимаем Добавить.

Установка гостевого агента

Обязательная процедура для повышения производительности и возможностей работы с виртуальной машиной. Настройка выполняется как на гипервизоре, так и в самой виртуальной машине. Рассмотрим пример установки агента на базе системы Linux.

В гипервизоре переходим в Параметры, находим пункт QEMU Guest Agent и кликаем по нему:

Ставим галочку Use QEMU Guest Agent и нажимаем OK:

Для применения настройки нужно выключить и включить виртуальную машину.

Теперь подключаемся к виртуальной машине и устанавливаем утилиту. В зависимости от типа Linux команды будут отличаться.

а) DEB-based:

apt update

apt install qemu-guest-agent

б) RPM-based:

yum install qemu-guest-agent

Установка завершена.

Для запуска сервиса выполняем:

systemctl enable qemu-guest-agent —now

В сводке виртуальной машины мы теперь можем увидеть информацию об IP-адресе, которая получена при помощи гостевого агента.

Подробнее процесс описан на странице https://pve.proxmox.com/wiki/Qemu-guest-agent.

Удаление виртуальной машины

Для удаления виртуальной машины, сначала ее отключаем — это можно сделать из операционной системы или из панели управления, нажав на стрелку вниз рядом с Выключить — Остановка:

После кликаем по Дополнительно — Удалить:

В открывшемся окне мы должны подтвердить свои намерения удалить виртуальную машину, вписав ее идентификатор:

* если мы поставим галочку Purge, то виртуальная машина будет удалена полностью вместе с виртуальным диском.

Кликаем по Удалить — готово.

Тюнинг сервера PVE

Внесем несколько изменений, которые сделают работу с Proxmox VE удобнее.

Отключение предупреждения об отсутствии подписки

Каждый раз при заходе в панель управления мы будем видеть такое предупреждение:

Оно говорит нам о том, что мы используем бесплатную версию программного продукта. Чтобы сообщение нас не беспокоило, выполним 2 действия:

- Отключим платный репозиторий для получения пакетов proxmox.

- Отредактируем файл js для отключения данного сообщения.

И так, в SSH открываем на редактирование репозиторий proxmox:

nano /etc/apt/sources.list.d/pve-enterprise.list

Приводим его к виду:

#deb https://enterprise.proxmox.com/debian/pve buster pve-enterprise

deb http://download.proxmox.com/debian/pve stretch pve-no-subscription

* мы закомментировали репозиторий pve-enterprise и добавили pve-no-subscription.

** при большом желании, можно удалить файл репозитория с именем pve-enterprise.list и создать новый — кому как будет удобнее.

Добавляем gpg-ключ для репозитория:

apt-key adv —keyserver keyserver.ubuntu.com —recv-keys 0D9A1950E2EF0603

После обновим список пакетов:

apt update

Последнее — редактируем файл /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js (перед этим его сохраняем):

cp /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js /usr/share/javascript/proxmox-widget-toolkit/backup_proxmoxlib.js

sed -i «s/getNoSubKeyHtml:/getNoSubKeyHtml_:/» /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js

* данной командой мы находим getNoSubKeyHtml в файле /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js и меняем на getNoSubKeyHtml_.

Закрываем окно браузера с Proxmox, если оно было открыто и запускаем его снова. Входим в систему — сообщение не должно появиться.

Сертификаты

Сервер PVE устанавливается с самоподписанным сертификатом. Это означает, что при подключении к панели управления мы будем видеть предупреждение от системы безопасности. Чтобы браузер принимал сертификат, он должен соответствовать следующим требованиям:

- Быть выдан доверенным центром сертификации или зарегистрированным в вашей локальной сети, например, локальный AD CS.

- Быть для доменного имени, по которому мы заходим в панель управления.

- Иметь актуальные даты начала действия и окончания.

При этом, мы не должны заходить в панель управления по IP-адресу — в противном случае, независимо от сертификата, мы все-равно, получим предупреждение.

И так, сам сертификат можно купить, запросить бесплатно у Let’s Encrypt или создать с использованием локального центра сертификации, например, по данной инструкции. После у нас есть, как минимум, два способа загрузить его.

а) Установка сертификата с помощью графического интерфейса

Получив сертификат, открываем панель управления PVE и переходим к серверу — Система — Сертификаты — кликаем по Загрузить пользовательский сертификат:

В открывшемся окне заполняем поля для закрытого и открытого ключей:

… и нажимаем Загрузить. Система предупредит, что загрузится с новым сертификатом — необходимо закрыть вкладку в браузере и открыть консоль управления снова. Если сертификат загружен правильный, мы не увидим предупреждения.

б) Установка сертификата из командной строки

После развертывания Proxmox создается 2 файла в каталоге /etc/pve/nodes/<имя ноды> (например, /etc/pve/nodes/pve/) с именами pve-ssl.key и pve-ssl.pem. Их нужно заменить.

Сначала создадим их копию:

mkdir -p /backup/proxmox/ssl

cp /etc/pve/nodes/pve/pve-ssl.* /backup/proxmox/ssl/

Предположим, что мы получили сертификаты с помощью Let’s Encrypt и они находятся по пути /etc/letsencrypt/live/pve.dmosk.ru. Тогда копируем нужны ключи:

cp /etc/letsencrypt/live/pve.dmosk.ru/fullchain.pem /etc/pve/nodes/pve/pve-ssl.pem

cp /etc/letsencrypt/live/pve.dmosk.ru/privkey.pem /etc/pve/nodes/pve/pve-ssl.key

Возможно, вы подумаете, что для сертификатов Let’s Encrypt лучше создавать симлинки, вместо копирования файлов. Однако, для каталога /etc/pve создается FUSE файловая система, которая не поддерживает симлинки.

Перезапускаем сервисы:

systemctl restart pvestatd pvedaemon pve-cluster corosync

Создание нового пользователя

При установке PVE создается пользователь root. Рассмотрим процесс добавления еще одного через командную строку.

Подключаемся по SSH или открываем консоль из панели управления. Создаем пользователя в системе:

useradd user

* где user — имя создаваемого пользователя.

После создаем нового пользователя в Proxmox:

pveum useradd user@pam

* в данном примере мы создали пользователя user в области pam.

Задаем пароль:

pveum passwd user@pam

Задаем роль для созданного пользователя, например, административную:

pveum aclmod / -user user@pam -role Administrator

* весь список ролей можно посмотреть в панели администрирования в разделе Датацентр — Разрешения — Роли.

Ubuntu и CentOS

Возможно, кому-то захочется установить Proxmox именно на Ubuntu или CentOS. К сожалению, разработчики остановились на Debian. Возможно, есть неофициальные обходные пути установки Proxmox на другие дистрибутивы Linux, однако такой путь не является приемлемым для продуктивной среды. Для настройка виртуализации на Ubuntu и CentOS предлагаю инструкции:

1. Установка и настройка KVM на CentOS 7

2. Настройка KVM на Ubuntu Server

Возможные ошибки

Рассмотрим некоторые ошибки, с которыми столкнулся я.

Falling back to a fallback locale

Ошибка появляется при установке гостевой утилиты на компьютер с Linux, а также выполнении некоторых других команд.

Причина: это связано с настройками локали в вашей системе. Скорее всего, среди вариантов языковых настроек не перечислен en_US.UTF-8.

Решение: исходя из причины, нам нужно правильно настроить локаль. Это можно сделать в интерактивном режиме командой:

dpkg-reconfigure locales

После выбираем нужные локали, например: en_US.UTF-8 и ru_RU.UTF-8.

Также можно просто отредактировать файл:

vi /etc/locale.gen

Необходимо снять комментарий с en_US.UTF-8:

…

en_US.UTF-8 UTF-8

…

После вводим:

locale-gen

Настраиваем формат времени и определяем язык интерфейса:

export LC_TIME=ru_RU.utf8

update-locale LANG=en_US.UTF-8

Гостевая служба помечена как masked

Мы можем заметить, что служба qemu-guest-agent не запускается со статусом masked:

qemu-guest-agent.service

Loaded: masked (/dev/null; bad)

Active: inactive (dead)

Причина: в некоторых операционных системах (я столкнулся в Astra Linux) по умолчанию сервис qemu-guest-agent маскируется.

Решение: маскировку можно снять простой командой:

systemctl unmask qemu-guest-agent

После перечитываем конфигурацию daemon-reload:

systemctl daemon-reload

Можно разрешить запуск сервиса и стартовать его:

systemctl enable qemu-guest-agent —now

Читайте также

Следующие инструкции также могут показаться вам полезными:

1. Настройка кластера Proxmox VE.

2. Конвертирование виртуального диска Proxmox в диск VMware.

3. Включение вложенной виртуализации в Proxmox.

0

1

Доброе время суток форумчане!

Есть не большие проблемы с установкой proxmox.

Прошу сильно тапками и камнями не закидывать, а кот носом натыкать можно )))

Не большая предыстория:

на протяжении последнего месяца бьюсь над установкой proxmox на сервер.

Характеристики сервера: h

p proliant dl380 g7

2 Xeon e5620

50Gb ram

Raid контролер 410i

4 sas 500gb

4 sata 1Tb

(2 raid 1+0 (2 по 500Gb) и raid5 (2.7Tb)

Если что то из характеристики нежно будет могу дополнить.

что я вообще делал:

пробовал поставить Proxmox 7.2.0 — при установки на экран выводит вне диапазона 80Mhz/100Hz, через iLo Тоже самое, только без таблички просто черный экран, плюнул, подумал попробую поставить версию по младше 7.1.2.

Тут все хорошо все устанавливается, указываю все характеристики после установки как обычно перезагружается сервер и выводится экран с ip доступа (на перед да я всегда писал порт 8006) и на этом моя радость была не долгой, попробовал подключится выходит белый экран (попробовал посмотреть кож html вроде как есть (в нем тоже не селен) на закладке появляется значке иконки proxmox. По думаю может у меня комп глючный попробовал еще на 3 ноутбуках и 1 ПК планшете. к сожаления не чего не выходит планшет выдает не удалось установить защищенное соединения остальные все выдают ошибку ERR_EMPTY_RESPONSE, самое что интересное на 1 ноутбуке показывал только internet explorer, а на других компах даже он не чего не выдает, на днях установил лису и тоже самое (да на перед ключи сбрасывал, куки чистил, загружался с 1 компа через Life-CD, история с internet explorer повторяется).

после были предприняты установку через дебиан 10 ( 11 к сожаления не видит диски в рейде тоже не знаю по чему) по верх него уже ставил proxmox 6.4 и обновления дебиана и proxmox до последнего релиза, история все так же сохраняется из 5 устройств частично видит только лишь одно.

уже высосан пробовал другой гипер поставить VMware и тут получил болт, проци не подходящие для этого гипера

да по характеристикам сети стоит старенький d-link dir 320 на нем OpenWrt, пробовал TP-Link Тоже старенький на родной прошивке история таже

p.s. гуглил яндексил ))), не только российские форумы статьи и какие то блоги но и зарубежные, у всег все просто и быстро, как говорится без сучка и задоринки, буду благодарен за помощь каждому