Ошибочность рассуждений, вызванная эффектом подтверждения (Confirmation bias, Систематическая ошибка согласованности) — тенденция проверять гипотезы исключительно путём прямого тестирования, вместо того, чтобы тестировать возможные альтернативные гипотезы

«Не предлагайте решения, до тех пор, пока проблема не будет исследована

так тщательно, как это только возможно»

В 1960 году Питер Уосон (Peter Wason) провел ныне классический эксперимент, известный как задача ‘2-4-6’ [Wason, 1960.] Испытуемые должны были определить правило, известное экспериментатору, но не самому испытуемому — так, как оно бывает при научном исследовании. Испытуемые писали три числа, таких как ‘2-4-6′ или ’10-12-14’ на карточках, и экспериментатор говорил, соответствуют ли данные три числа правилу или нет. Изначально субъектам была выдана тройка чисел 2-4-6 и сказано, что она соответствует правилу. Испытуемые могли продолжать испытывать тройки до тех пор, пока они не чувствовали себя уверенными, что знают правило экспериментатора, и тогда испытуемым объявляли правило.

Хотя участники обычно выражали высокую уверенность в своих догадках, только 21% из них в этом эксперименте правильно угадали правило, и при повторениях эксперимента уровень успеха обычно составлял 20%. Вопреки совету Карла Поппера, испытуемые в эксперименте Уосона пытались подтвердить свои гипотезы, а не опровергнуть. Таким образом, те, кто сформулировали гипотезу «Числа увеличиваются каждый раз на два», проверяли тройки 8-10-12 или 20-22-24, слышали, что они подходят, и уверенно объявляли правило. Во всех случаях подлинное правило было одно и тоже: три номера должны следовать один за другим по возрастающей. В некоторых случаях испытуемые выдумывали, «тестировали» и объявляли правила, гораздо более сложные, чем действительное.

Задача Уосона «2-4-6» является «прохладной» формой интеллектуальной ошибки, связанной с подтверждением: люди предпочитают подтверждающие, а не опровергающие свидетельства. «Прохладный» означает, что задача «2-4-6» является эмоционально нейтральным случаем интеллектуальной ошибки подтверждения: вывод подтверждается логикой, а не эмоциями. «Горячий» случай имеет место, когда вера эмоционально заряжена, например, в случае политических рассуждений. Неудивительно, что «горячая» ошибочность сильнее — больше по размаху и более устойчивая к изменениям. Активная, полная усилий склонность к подтверждению обычно называется мотивированным мышлением (motivated cognition) (обычно известным как «рационализация»). Как отмечает Бреннер [Brenner, 2002] в «Заметках к теории одобрения»:

«Очевидно, что во многих обстоятельствах желание уверенности в гипотезе может заметно повлиять на воспринимаемую степень ее подтверждения… Канда [Kunda, 1990] обсуждает, как люди, нацеленные на то, чтобы достичь определенных выводов, пытаются сконструировать (в ошибочной манере) убедительный случай для своей любимой гипотезы, который мог бы убедить беспристрастную аудиторию. Джилович [Gilovich, 2000] предполагает, что выводы, в которые человек не хочет верить, рассматриваются гораздо требовательнее, чем те, в которые он хочет верить. В первом случае человек требует, чтобы свидетельство с необходимостью вело к данному выводу, а во втором — спрашивает, позволяет ли некоторое свидетельство придти к данному выводу».

Когда люди подвергают те свидетельства, которые противоречат их точке зрения, более пристрастному анализу, чем те, которые ее подтверждают, это называется мотивированный скептицизм или интеллектуальная ошибка несогласия (disconfirmation bias). Ошибка несогласия особенно деструктивна по двум причинам: во-первых, два подверженных этой ошибке спорщика, рассматривая один и тот же поток свидетельств, могут изменить свою веру в противоположных направлениях — обе стороны выборочно принимают только привлекательные для них свидетельства. Накопление большего числа свидетельств не приведет этих спорщиков к согласию. Во-вторых, люди, которые являются более опытными скептиками: которые знают больший набор логических нестыковок, но применяют этот навык избирательно, могут изменять свою точку зрения гораздо медленнее, чем неопытные спорщики

Тэйбер и Лодж [Taber and Lodge, 2000] исследовали изначальное отношение и изменение отношения у студентов, под воздействием прочтения политической литературы за и против контроля и выдачи разрешений на оружие. Это исследование проверило шесть следующих гипотез в двух экспериментах:

* Эффект предшествующего отношения. (Prior attitude effect.) Испытуемые, имевшие изначальную точку зрения на проблему — даже когда их поощряли в том, чтобы они были объективными — находили поддерживающие аргументы более охотно, чем опровергающие.

* Систематическая ошибка опровержения. Испытуемые тратили больше времени и умственных усилий, стараясь отклонить опровергающие аргументы, чем поддерживающие аргументы.

* Систематическая ошибка подтверждения. Испытуемые, свободные выбирать источники информации, скорее искали подтверждающие, чем опровергающие источники.

* Поляризация отношения. Предъявление субъектам очевидно уравновешенного набора аргументов за и против приводило к увеличению изначальной поляризации их мнений.

* Эффект силы мнения (Attitude strength effect). Испытуемые, имеющие более ярко выраженное мнение, были более подвержены вышеназванным склонностям к ошибке.

* Эффект усложнения. (Sophistication effect) Более искушенные в политике испытуемые, по причине обладания более тяжелым вооружением для опровержения противных фактов и доводов, были более подвержены вышеприведенным систематическим ошибкам.

Забавно, что эксперименты Тэйбера и Лоджа (Taber and Lodge) подтвердили все шесть изначальных гипотез авторов. Вы можете сказать: «Вероятно, эти эксперименты только отражают верования, на которые опирались их авторы, и это как раз пример систематической ошибки подтверждения». Если так, то, сделав вас более опытным спорщиком, а именно, научив вас еще одной систематической ошибке, в которой можно обвинить людей, я, в действительности, навредил вам: я ослабил вашу реакцию на новую информацию. Я дал вам еще один шанс всякий раз терпеть неудачу, когда вы сталкиваетесь с возможностью изменить свой стиль мышления.

Модели рассуждения и систематические ошибки широко распространены в человеческих размышлениях. Их знание позволяет нам замечать большое разнообразие логических ошибок, которые, в противном случае, были бы недоступны для нашего наблюдения. Но, как и любая способность обнаруживать ошибки в рассуждениях, это знание должно применяться обоюдосторонне: как к нашим собственным идеям, так и к идеям других; к идеям, которые нам нравятся, и которые нам не нравятся. Знание человеческой склонности ошибаться — это опасное знание, если вы напоминаете себе об ошибочности тех, кто не согласен с вами. Если я избирателен в отношении тех аргументов, которые я исследую на предмет ошибок, или даже того, насколько глубоко я исследую эти ошибки, тогда каждый новый закон логики, каждая новая логическая несообразность, которую я научаюсь обнаруживать, делает меня глупее. Ум, чтобы быть полезным, должен быть использован не для того, чтобы дурачить самого себя.

Нельзя рационализировать то, что не рационально с самого начала — как если ложь назвать «правдизацией». Нельзя сделать утверждение более истинным посредством взяточничества, лести или даже страстной аргументации — можно заставить больше людей верить в утверждение, но нельзя сделать его вернее. Для того, чтобы сделать наши верования более истинными, мы должны изменить сами эти верования. Не каждое изменение — это улучшение, но каждое улучшение — это изменение по определению.

Наши верования гораздо более подвижны, чем мы привыкли думать. Гриффин и Тверский [Griffin and Tversky, 1992] осторожно опросили 24-х своих коллег на тему выбора между двумя предложениями по работе и попросили их оценить вероятность того, что они его выберут, для каждого из предложений. Средняя вероятность выбора, высказанная в отношении более привлекательного предложения, составила умеренные 66%. Но только один из 24 опрошенных выбрал в конечном счетt вариант, которому он приписал в начале более низкую вероятность, увеличив общую точность предсказания до 96 процентов. (Это — один из немногих известных примеров, когда имеет место не «сверх-уверенность», а «недо-уверенность».)

Мораль в том, что как только вы начинаете догадываться, каков будет ваш ответ, как только вы приписываете большую вероятность тому, что вы ответите так, а не иначе, вы, на самом деле, уже решили. И если вы будете честны с самим собой, вы должны признать, что обычно вы догадываетесь об окончательном ответе через секунды после того, как услышите вопрос. Мы меняем наши мнения гораздо реже, чем мы думаем. Насколько скоротечен этот короткий незаметный момент, когда мы даже не можем догадаться, каков будет наш ответ, малюсенькое хрупкое мгновение, которое нам отведено, чтобы на самом деле подумать — как в вопросах выбора, так и в вопросах установления фактов.

Шенкель (Shenkel) говорил: «Нет необходимости в вере, пока ситуация может быть легко рассмотрена тем или другим образом».

Норман Майер (Norman R. F. Maier): «Не предлагайте решения, до тех пор, пока проблема не будет исследована так тщательно, как это только возможно».

Робин Доуз (Robyn Dawes), комментируя Майера, писал: «Я часто предлагал это правило группам, которые я вел, в частности, когда они сталкивались с особенно трудной проблемой. Это — типичная ситуация, когда члены группы особенно склонны предлагать мгновенные решения».

В компьютерной безопасности «система, которой доверяют» (trusted system) — это та, которой вы на самом деле доверяете, а не та, которая достойна доверия. «Система, которой доверяют» — это система, которая, будучи скомпрометированной, способна вызвать ошибку. Когда вы читаете статью, утверждающую, что глобальная катастрофа невозможна, или имеет определенную годовую вероятность, или может быть преодолена с использованием определенной стратегии — вы доверяете рациональности авторов. Вы доверяете способности авторов переходить от удобных выводов к неудобным, даже в случае отсутствия сногсшибательных экспериментальных свидетельств, опровергающих любимую гипотезу. Вы доверяете авторам в том, что они не искали немного более интенсивно ошибки в тех уравнениях, которые указывали на неверный, с их точки зрения, путь, до того, как к вам попал окончательный вариант статьи.

И если власти вводят закон, по которому даже мельчайший риск существованию человечества достаточен для того, чтобы закрыть проект; или если становится нормой политики де-факто, что ни одно возможное вычисление не может перевесить груз однажды высказанного предположения, то тогда ни один ученый не рискнет больше высказывать предположения. Я не знаю, как решить эту проблему. Но я думаю, что тем, кто оценивает глобальные риски, следует иметь общие представления о человеческих моделях рассуждений и систематических ошибках при рассуждениях, и об ошибке неподтверждения в частности.

В рамках подготовки к выходу большой статьи о методах манипуляции сознанием, привожу информацию о эффекте подтверждения. Кратенько, своими словами, а подробно — под катом. Крайне рекомендую любому человеку, стремящемуся мыслить рационально и без ошибок, прочитать всю статью. Ваша адекватность в ваших руках.

Эффект этот не теоретический, мы сталкиваемся с ним каждый день, и он реально меняет жизнь 95% населения земного шара.

Представьте, что группе испытуемых предлагают найти закономерность в тройках чисел. Испытуемый может предложить свою тройку, и спросить, подходит ли она под закономерность или нет. Он может предлагать свои тройки и узнавать, подходят ли они до бесконечности. Но если он назовёт закономерность, и не угадает — то он проиграл. И для затравки предлагают тройку «2 — 4 — 6»

Допустим, наш испытуемый выдвигает версию — что закономерность — это +2. Следующее число в тройке больше предыдущего на 2.

Он хочет проверить — и спрашивает: «6-8-10 подходит?» — и получает ответ «да»

14 — 16 — 18? (14, 14+2, 14+2+2)

— Да.

— 2002, 2004, 2006?

— Да.

— 92222224, 92222226, 92222228?

— Да.

Убедившись, что его теория верна, испытуемый радостно называет её и… проигрывает.

Опыты показывают, что более умные выдвигают более сложные теории и… тоже ошибаются!!!

В чём же фокус?

Фокус в том, что закономерность, загаданная экспериментатором, настолько общая, что задумки большинства испытуемых являются её частными случаями. На самом деле, числа должны быть … расположены по возрастанию. Всего-то…

Так вот, доказано, что чем умнее человек, тем изворотливее он убеждает себя, что первая выдвинутая им теория — верна. Тем сложнее эта теория. Тем тщательнее он её проверяет. И тем больше подтверждений находит…

А в чём же засада? Почему человек редко способен найти ошибку в этом случае?

Да потому, что методика не верная. Надо не подтверждения своей теории искать, а опровержения. Например, назвать тройки «7 — 15 — 4» и «18 — 200 — 500». И уже вторая из этих попыток разрушает самую очевидную теорию про «+2». И только если опровержений нет, можно неуверенно, но всё-же обоснованно говорить о том, что найден ответ.

Кстати, эксперимент 2-4-6 — это самая простая задача, демонстрирующая особенности научного поиска.

Как это находит отражение в нашей жизни?

Да очень просто. Заметили ли вы, что люди не способны договорится по политическим взглядам и по поводу истинности той или иной религии?

Предположив однажды, что та или иная религия, политический взгляд верен, человек начинает искать этому подтверждения. И находит их!!! Вне зависимости от верности взгляда/религии. Подтверждений больше, больше — и крепнет убеждение.

Ему бы тут остановится и спросить, «а что может опровернуть мою идею?» — и осмотрется по сторонам. Возможно, опровержения его мыслям тут же найдутся рядом… Но… увы

Это действие могущественного эффекта 2-4-6, эффекта подтверждения!!!

Эффект подтверждения — страшное оружие в руках манипулятора. Стоит только закинуть в голову человеку правдоподобное убеждение, хоть немножко похожее на правду, и человек сам найдёт ему «доказательства», «подтверждения», и чем умнее он будет, тем упёртее он будет стоять на своём, тем более изворотливо он будет защищать свою точку зрения, даже если она… подброшенная манипулятором деза!!! Главное (хотя и не обязательно), чтобы человек считал, что он сам эту идею придумал.

А уж если за убеждением стоит не только ложно понятый опыт, но и сильные эмоции… Тут уж пиши пропало!!!

Оригинал взят у

Елиезер Юдковски. Перевод: А.В. Турчин

5. Ошибочность рассуждений, вызванная эффектом подтверждения

В 1960 году Питер Уосон (Peter Wason) провел ныне классический эксперимент, известный как задача ‘2-4-6’ [Wason, 1960.] Испытуемые должны были определить правило, известное экспериментатору, но не самому испытуемому — так, как оно бывает при научном исследовании. Испытуемые писали три числа, таких как ‘2-4-6′ или ’10-12-14’ на карточках, и экспериментатор говорил, соответствуют ли данные три числа правилу или нет. Изначально субъектам была выдана тройка чисел 2-4-6 и сказано, что она соответствует правилу. Испытуемые могли продолжать испытывать тройки до тех пор, пока они не чувствовали себя уверенными, что знают правило экспериментатора, и тогда испытуемым объявляли правило.

Хотя участники обычно выражали высокую уверенность в своих догадках, только 21% из них в этом эксперименте правильно угадали правило, и при повторениях эксперимента уровень успеха обычно составлял 20%. Вопреки совету Карла Поппера, испытуемые в эксперименте Уосона пытались подтвердить свои гипотезы, а не опровергнуть. Таким образом, те, кто сформулировали гипотезу «Числа увеличиваются каждый раз на два», проверяли тройки 8-10-12 или 20-22-24, слышали, что они подходят, и уверенно объявляли правило. Во всех случаях подлинное правило было одно и тоже: три номера должны следовать один за другим по возрастающей. В некоторых случаях испытуемые выдумывали, «тестировали» и объявляли правила, гораздо более сложные, чем действительное.

Задача Уосона «2-4-6» является «прохладной» формой интеллектуальной ошибки, связанной с подтверждением: люди предпочитают подтверждающие, а не опровергающие свидетельства. «Прохладный» означает, что задача «2-4-6» является эмоционально нейтральным случаем интеллектуальной ошибки подтверждения: вывод подтверждается логикой, а не эмоциями. «Горячий» случай имеет место, когда вера эмоционально заряжена, например, в случае политических рассуждений. Неудивительно, что «горячая» ошибочность сильнее — больше по размаху и более устойчивая к изменениям. Активная, полная усилий склонность к подтверждению обычно называется мотивированным мышлением (motivated cognition) (обычно известным как «рационализация»). Как отмечает Бреннер [Brenner, 2002] в «Заметках к теории одобрения»:

«Очевидно, что во многих обстоятельствах желание уверенности в гипотезе может заметно повлиять на воспринимаемую степень ее подтверждения… Канда [Kunda, 1990] обсуждает, как люди, нацеленные на то, чтобы достичь определенных выводов, пытаются сконструировать (в ошибочной манере) убедительный случай для своей любимой гипотезы, который мог бы убедить беспристрастную аудиторию. Джилович [Gilovich, 2000] предполагает, что выводы, в которые человек не хочет верить, рассматриваются гораздо требовательнее, чем те, в которые он хочет верить. В первом случае человек требует, чтобы свидетельство с необходимостью вело к данному выводу, а во втором — спрашивает, позволяет ли некоторое свидетельство придти к данному выводу».

Когда люди подвергают те свидетельства, которые противоречат их точке зрения, более пристрастному анализу, чем те, которые ее подтверждают, это называется мотивированный скептицизм или когнитивное искажение несогласия (disconfirmation bias). Ошибка несогласия особенно деструктивна по двум причинам: во-первых, два подверженных этой ошибке спорщика, рассматривая один и тот же поток свидетельств, могут изменить свою веру в противоположных направлениях — обе стороны выборочно принимают только привлекательные для них свидетельства. Накопление большего числа свидетельств не приведет этих спорщиков к согласию. Во-вторых, люди, которые являются более опытными скептиками, – то есть которые знают больший набор типичных логических нестыковок, но применяют этот навык избирательно, – склонны изменять свою точку зрения гораздо медленнее, чем неопытные спорщики.

Тэйбер и Лодж [Taber and Lodge, 2000] исследовали изначальное отношение к теме ношения огнестрельного оружия и изменение его у студентов, под воздействием прочтения политической литературы за и против контроля и выдачи разрешений на оружие. Это исследование проверило шесть следующих гипотез в двух экспериментах:

1. Эффект предшествующего отношения. Испытуемые, имевшие изначальную точку зрения на проблему — даже когда их поощряли в том, чтобы они были объективными — находили поддерживающие аргументы более охотно, чем опровергающие.

2. Систематическая ошибка опровержения. Испытуемые тратили больше времени и умственных усилий, стараясь отклонить опровергающие аргументы, чем поддерживающие аргументы.

3. Систематическая ошибка подтверждения. Испытуемые, свободные выбирать источники информации, скорее искали подтверждающие, чем опровергающие источники.

4. Поляризация отношения. Предъявление субъектам очевидно уравновешенного набора аргументов за и против приводило к увеличению изначальной поляризации их мнений.

5. Эффект силы мнения. Испытуемые, имеющие более ярко выраженное мнение, были более подвержены вышеназванным склонностям к ошибке.

6. Эффект усложнения. Более искушенные в политике испытуемые, по причине обладания более тяжелым вооружением для опровержения противных фактов и доводов, были более подвержены вышеприведенным систематическим ошибкам.

Забавно, что эксперименты Тэйбера и Лоджа (Taber and Lodge) подтвердили все шесть изначальных гипотез авторов. Вы можете сказать: «Вероятно, эти эксперименты только отражают верования, на которые опирались их авторы, и это как раз пример систематической ошибки подтверждения». Если так, то, сделав вас более опытным спорщиком, а именно, научив вас еще одной систематической ошибке, в которой можно обвинить людей, я, в действительности, навредил вам: я ослабил вашу реакцию на новую информацию. Я дал вам еще один шанс всякий раз терпеть неудачу, когда вы сталкиваетесь с возможностью изменить свой стиль мышления.

Эвристика и когнитивные искажения широко распространены в человеческих размышлениях. Знание о них позволяет нам замечать большое разнообразие логических ошибок, которые, в противном случае, были бы недоступны для нашего наблюдения. Но, как и любая способность обнаруживать ошибки в рассуждениях, это знание должно применяться обоюдосторонне: как к нашим собственным идеям, так и к идеям других; к идеям, которые нам нравятся, и которые нам не нравятся. Знание человеческой склонности ошибаться — это опасное знание, если вы напоминаете себе об ошибочности тех, кто не согласен с вами. Если я избирателен в отношении тех аргументов, которые я исследую на предмет ошибок, или даже того, насколько глубоко я исследую эти ошибки, тогда каждый новый закон логики, каждая новая логическая несообразность, которую я научаюсь обнаруживать, делает меня глупее. Ум, чтобы быть полезным, должен быть использован не для того, чтобы дурачить самого себя.

Нельзя рационализировать то, что не рационально с самого начала — как если ложь назвать «правдизацией». Нельзя сделать утверждение более истинным посредством взяточничества, лести или даже страстной аргументации — можно заставить больше людей верить в утверждение, но нельзя сделать его вернее. Для того, чтобы сделать наши верования более истинными, мы должны изменить сами эти верования. Не каждое изменение — это улучшение, но каждое улучшение — это изменение по определению.

Наши верования гораздо более подвижны, чем мы привыкли думать. Гриффин и Тверский [Griffin and Tversky, 1992] осторожно опросили 24-х своих коллег на тему выбора между двумя предложениями по работе и попросили их оценить вероятность того, что они его выберут, для каждого из предложений. Средняя вероятность выбора, высказанная в отношении более привлекательного предложения, составила умеренные 66%. Но только один из 24 опрошенных выбрал в конечном счетt вариант, которому он приписал в начале более низкую вероятность, увеличив общую точность предсказания до 96 процентов. (Это — один из немногих известных примеров, когда имеет место не «сверх-уверенность», а «недо-уверенность».)

Мораль в том, что как только вы начинаете догадываться, каков будет ваш ответ, как только вы приписываете большую вероятность тому, что вы ответите так, а не иначе, вы, на самом деле, уже решили. И если вы будете честны с самим собой, вы должны признать, что обычно вы догадываетесь об окончательном ответе через секунды после того, как услышите вопрос. Мы меняем наши мнения гораздо реже, чем мы думаем. Насколько скоротечен этот короткий незаметный момент, когда мы даже не можем догадаться, каков будет наш ответ, малюсенькое хрупкое мгновение, которое нам отведено, чтобы на самом деле подумать — как в вопросах выбора, так и в вопросах установления фактов.

Шенкель (Shenkel) говорил: «Нет необходимости в вере, пока ситуация может быть легко рассмотрена тем или другим образом».

Норман Майер (Norman R. F. Maier): «Не предлагайте решения до тех пор, пока проблема не будет исследована так тщательно, как это только возможно».

Робин Доуз (Robyn Dawes), комментируя Майера, писал: «Я часто предлагал это правило группам, которые я вел, в частности, когда они сталкивались с особенно трудной проблемой. Это – типичная ситуация, когда члены группы особенно склонны предлагать мгновенные решения».

В компьютерной безопасности «система, которой доверяют» (trusted system) — это та, которой вы на самом деле доверяете, а не та, которая достойна доверия. «Система, которой доверяют» — это система, которая, будучи скомпрометированной, способна вызвать ошибку. Когда вы читаете статью, утверждающую, что глобальная катастрофа невозможна, или имеет определенную годовую вероятность, или может быть преодолена с использованием определенной стратегии — вы доверяете рациональности авторов. Вы доверяете способности авторов переходить от удобных выводов к неудобным, даже в случае отсутствия сногсшибательных экспериментальных свидетельств, опровергающих любимую гипотезу. Вы доверяете авторам в том, что они не искали немного более интенсивно ошибки в тех уравнениях, которые указывали на неверный, с их точки зрения, путь, до того, как к вам попал окончательный вариант статьи.

И если власти вводят закон, по которому даже мельчайший риск существованию человечества достаточен для того, чтобы закрыть проект; или если становится нормой политики де-факто, что ни одно возможное вычисление не может перевесить груз однажды высказанного предположения, то тогда ни один ученый не рискнет больше высказывать предположения. Я не знаю, как решить эту проблему. Но я думаю, что тем, кто оценивает глобальные риски, следует иметь общие представления о человеческих моделях рассуждений и когнитивных искажениях, и об ошибке неподтверждения в частности.

Статья вышла в 2008 году в сборнике «Риски глобальной катастрофы» под редакцией Ника Бострома и Милана Цирковича, Оксфорд.

Благодарности автора: Я благодарю Майкла Роя Эймса (Michael Roy Ames), Ника Бострома (Nick Bostrom), Милана Чирковича (Milan Cirkovic), Оли Лэмб (Olie Lamb), Тамаса Мартинеса (Tamas Martinec), Робина Ли Пауэла (Robin Lee Powell), Кристиана Ровнера (Christian Rovner) и Майкла Уилсона (Michael Wilson) за их комментарии, предложения и критику. Нет необходимости говорить, что все оставшиеся ошибки в этой работе — мои.

Введение

При всех прочих равных, мало кто из людей хотел бы уничтожить мир. Даже безликие корпорации, лезущие не в свои дела правительства, безрассудные ученые и прочие опасные люди нуждаются в окружающем мире, чтобы достигать в нем своих целей, таких как нажива, власть, собственность или другие малоприятные вещи. Если гибель человечества будет происходить настолько медленно, что успеет произойти ужасное осознание этого процесса, то деятели, запустившие его, будут, вероятно, ошеломлены пониманием того, что они, в действительности, уничтожили мир. Поэтому я предполагаю, что, если Земля будет все-таки уничтожена, то произойдет это, вероятно, по ошибке.

Систематическое экспериментальное исследование повторения ошибок в человеческих рассуждениях и того, что эти ошибки говорят о предшествующих им ментальных процессах, изучается в когнитивной психологии в рамках исследований эвристики и предубеждений. Эти исследования привели к открытиям, очень существенным для экспертов по рискам глобальных катастроф. Допустим, вы беспокоитесь о рисках, связанных с неким взрывчатым веществом Р, способным разрушить всю планету, если оно подвергнется достаточно сильному радиосигналу. К счастью, имеется знаменитый эксперт, который открыл субстанцию Р, потратил тридцать лет, работая с ней, и знает ее лучше, чем любой другой на Земле. Вы звоните эксперту и спрашиваете, насколько сильным должен быть радиосигнал, чтобы вещество взорвалось. Эксперт отвечает, что критический порог находится, вероятно, на уровне 4000 тераватт. «Вероятно?» — Спрашиваете вы. «Можете ли вы мне сообщить интервал мощности запускающего сигнала с 98-ми процентной уверенностью?» — «Конечно, — отвечает эксперт. — Я на 99 % уверен, что критический порог больше 500 тераватт, и на 99 % уверен, что он меньше 80000 тераватт». «А как насчет 10 тераватт?» — спрашиваете вы. «Невозможно», — отвечает эксперт.

Приведенная выше методология опроса эксперта выглядит совершенно резонной, такой, какую должен использовать любой компетентный работник, сталкиваясь с подобной проблемой. И в действительности, эта методология была использована при исследовании безопасности реакторов [Rasmussen, 1975], ныне считающемся первой значительной попыткой вероятностной оценки рисков. Но исследователь моделей рассуждений и погрешностей в рассуждениях может распознать, по крайней мере, два больших недостатка в этом методе, — не просто логически слабых места, а пару обстоятельств, чрезвычайно уязвимых к человеческой ошибке.

Исследования эвристики и когнитивных искажений открыли результаты, которые могут напугать и привести в уныние неподготовленного ученого. Некоторые читатели, впервые сталкивающиеся с экспериментальными результатами, цитируемыми здесь, могут удивиться и спросить: «Это действительно экспериментальные результаты? Действительно ли люди так плохо предсказывают? Может быть, эксперименты были плохо организованы, и результаты изменятся, если совершить такие-то и такие-то манипуляции?» Не имея достаточно места для объяснений, я могу только призвать читателя проконсультироваться с основополагающей литературой. Очевидные изменения условий опытов уже применялись, и результаты от этого не становились другими.

Доступность информации

Предположим, вы возьмете случайное слово из трех или более букв из английского текста. Что более вероятно: что слово начинается с буквы R (rope), или что его третья буква R (park)? Основная идея исследований когнитивных искажений (euristic and biases program) состоит в том, что люди используют методы мышления, называемые эвристикой, которые дают хорошие приблизительные ответы в большинстве случаев, но которые также приводят к увеличению системных ошибок, называемых когнитивными искажениями (bias). Примером эвристики является суждение о частоте или вероятности события по его информационной доступности (availability), то есть по легкости, с которой примеры подобного события приходят на ум. «R» появляется в качестве третьей буквы в большем числе английских слов, чем на первом месте, но гораздо легче вспомнить слова, которые начинаются на эту букву. Таким образом, большинство респондентов предполагают, что слова, начинающиеся на букву R, встречаются чаще. [Tversky and Kahneman, 1973.]

Когнитивные искажения, основанные на эвристике доступности, влияют на оценки риска. Пионерское исследование Лихтенштейна [Lichtenstein, 1978] описывает абсолютную и относительную достоверность суждений о риске. Люди в общих чертах представляют, какие риски причиняют большее число смертей, и какие – меньшее. Однако, когда их просят посчитать риски точнее, они весьма переоценивают частоты редких причин смерти, и сильно недооценивают частоты обычных. Другие повторяющиеся ошибки, выявленные в этом исследовании, также были очевидными: аварии считались причинами такого же количества смертей, что и болезни (на самом деле болезни в 16 раз чаще становятся причинами смертей, чем аварии). Убийство неверно считалось более частой причиной смерти, чем диабет или рак желудка. В исследовании Комбса и Словица [Combs and Slovic, 1979] был проведен подсчет сообщений о смерти в двух газетах, в результате была обнаружена высокая корреляция между суждениями о достоверности и выборочностью репортажей в газетах (0,85 и 0,89).

Также люди отказываются покупать страховку от наводнений, даже если она хорошо субсидируется и стоит гораздо ниже справедливой рыночной цены. Канрейсер [Kunreuther,1993] предполагает, что слабая реакция на угрозы наводнений может происходить из неспособности индивида представить себе наводнение, которое на их глазах никогда не случалось. Жители затапливаемых равнин оказываются в плену своего опыта. По-видимому, люди не могут всерьез беспокоиться о возможности потерь и разрушений больших, чем пережитые во время последних наводнений. Бертон [Burton, 1978] сообщает, что после строительства дамб и насыпей наводнения происходят реже, что, видимо, создает фальшивое чувство безопасности, ведущее к снижению мер предосторожности. В то время как строительство дамб уменьшает частоту наводнений, ущерб от каждого наводнения все-таки происходящего настолько возрастает, что среднегодовой ущерб увеличивается.

Кажется, что люди не экстраполируют опыт пережитых малых опасностей на возможности более серьезных рисков; наоборот, прошлый опыт малых опасностей устанавливает верхнюю границу ожиданий максимально возможного риска. Общество, хорошо защищенное от малых опасностей, не будет предпринимать никаких действий по отношению к большим рискам. Например, часто ведется строительство на затапливаемых равнинах после того, как регулярные малые наводнения устранены. Общество, подверженное регулярным малым опасностям, будет считать эти малые опасности в качестве верхней границы возможных рисков (защищаясь от регулярных малых наводнений, но не от неожиданных больших).

Аналогично, риск человеческого вымирания может быть недооценен, поскольку, очевидно, человечество никогда не сталкивалось с этим событием.

Когнитивные искажения, связанные со знанием «задним числом»

Когнитивные искажения, связанные со знанием «задним числом», происходят, когда испытуемый, узнав окончательный итог событий, дает гораздо большую оценку предсказуемости именно этого итога, чем испытуемые, которые предсказывают итог без знания результата. Эта ошибка иногда называется «я-все-это-время-чувствовал-что-так-оно-и-есть».

Фишхофф и Бейт [Fischhoff и Beyth, 1975] представили студентам исторические отчеты о малоизвестных событиях, таких, как конфликт между гуркхами и англичанами в 1814 году. Пять групп студентов, получивших эту информацию, были опрошены в отношении того, как бы они оценили степень вероятности каждого из четырех исходов: победа англичан, победа гуркхов, патовая ситуация с мирным соглашением или пат без соглашения. Каждое из этих событий было описано как реальный итог ситуации одной из четырех экспериментальных групп. Пятой, контрольной группе о реальном исходе не говорили ничего. Каждая экспериментальная группа приписала сообщенному ей итогу гораздо большую вероятность, чем любая другая или контрольная группа.

Эффект знания «задним числом» важен в суде, где судья или присяжные должны определить, виновен ли обвиняемый в преступной халатности, не предвидев опасность. [Sanchiro, 2003]. В эксперименте, основанном на реальном деле, Камин и Рахлинский [Kamin and Rachlinski, 1995] попросили две группы оценить вероятность ущерба от наводнения, причиненного закрытием принадлежащего городу разводного моста. Контрольной группе сообщили только базовую информацию, бывшую известной городу, когда власти решили не нанимать мостового смотрителя. Экспериментальной группе была дана эта же информация плюс сведения о том, что наводнение действительно случилось. Инструкции устанавливают, что город проявляет халатность, если поддающаяся предвидению вероятность наводнения больше 10 процентов. 76 % опрашиваемых из контрольной группы заключили, что наводнение было настолько маловероятным, что никакие предосторожности не были нужны. 57 % экспериментальной группы заключили, что наводнение было настолько вероятно, что неспособность принять меры предосторожности была преступной халатностью. Третьей группе сообщили итог и также ясным образом инструктировали избегать оценки задним числом, что не привело ни к каким результатам: 56 % респондентов этой группы заключили, что город был преступно халатен. Отсюда видно, что судьи не могут просто инструктировать присяжных, чтобы те избежали эффекта знания задним числом: Меры против предвзятости (debiasing manipulation) не работают.

Рассматривая историю сквозь линзы нашего последующего знания, мы сильно недооцениваем затраты на предотвращения катастрофы. Так, в 1986 году космический челнок Челленджер взорвался по причине того, что кольцевой уплотнитель потерял гибкость при низкой температуре [Rogers, 1986]. Были предупреждающие сигналы о проблемах, связанных с кольцевым уплотнителем. Но предотвращение катастрофы Челленджера должно было потребовать не только внимания к проблемам с кольцевым уплотнителем, но и озабоченности каждым аналогичным предупреждающим сигналом, который бы казался столь же серьезным, как проблема уплотнителей, без преимущества последующего знания.

Черные лебеди

Талеб [Taleb, 2005] предположил, что ошибки последующего знания и доступности несут первостепенную ответственность за нашу неспособность защититься от того, что Талеб назвал Черными Лебедями. «Черные лебеди» являются особенно серьезным аспектом проблемы мощных последствий: иногда большая часть вариативности процесса происходит из исключительно редких, но исключительно масштабных событий. Представьте себе финансовый инструмент, который зарабатывает 10 долларов с 98% вероятностью, но теряет 1000 долларов с 2% вероятностью. В конечном счете, расход перевешивает доход, но инструмент выглядит как устойчиво выигрышный. Талеб (2001) приводит пример трейдера, чья стратегия работала 6 лет без единого убыточного квартала, принеся около 80 миллионов долларов — и затем он потерял 300 миллионов долларов в одной катастрофе.

Другим примером является Long-Term Capital Management, инвестиционный фонд, в состав основателей которого входили два Нобелевских лауреата по экономике. В течение Азиатского кризиса и российского дефолта 1998 года рынки вели себя совершенно беспрецедентным образом, имевшим пренебрежимо малую вероятность по исторической модели, использованной LTCM. В результате LTCM начал терять по 100 миллионов долларов в день, день за днем. За один день в 1998 году он потерял более 500 миллионов долларов [Taleb, 2005]

Основатели LTCM позже назвали рыночные условия 1998 года очень маловероятным событием с вероятным отклонением в десять сигма. Но очевидно, что это событие, раз оно случилось, не было столь невероятным. Ошибочно веря, что прошлое предсказуемо, люди пришли к выводу, что будущее тоже предсказуемо. Как пишет Фишхофф [Fischhoff, 1982]:

«Когда мы пытаемся понять события прошлого, мы косвенным образом проверяем гипотезы и правила, применяемые нами, чтобы интерпретировать и воспринимать мир вокруг нас. Если, благодаря последующему знанию, мы систематически недооцениваем сюрпризы, которые могли быть в прошлом, мы подвергаем эти гипотезы ненадлежаще слабым тестам и, вероятно, не находим никаких оснований для их изменений».

Урок истории состоит в том, что такие неприятности, как «черные лебеди», случаются. Люди удивляются катастрофам, которых они не ожидали, которые лежат за пределами известных им исторически вероятных распределений. Но почему мы бываем так ошеломлены, когда «черные лебеди» случаются? Почему LTCM занял 125 миллиардов долларов под 4,72 миллиарда долларов собственности, практически гарантируя, что любая крупная неприятность их обанкротит?

По причине ошибки из-за последующего знания, мы выучиваем очень специфические уроки. После 11 сентября американское управление авиации запретило использование ножей для разрезания бумаги на самолетах. В ретроспективе это событие выглядит слишком предсказуемым, позволяя разъяренным жертвам считать случившееся результатом халатности — такой, как неспособность разведывательных агентств различить предупреждения об активности Аль-Каиды среди тысяч других предупреждений. Мы научились не позволять захваченным самолетам летать над нашими городами. Но мы не выучили урок: «черные лебеди» случаются. Делай, что можешь, чтобы приготовиться к неожиданному».

Талеб [Taleb, 2005] пишет:

«Трудно мотивировать людей к предотвращению «черных лебедей»… Защита с трудом воспринимается, измеряется и вознаграждается; это обычно незаметный и неблагодарный труд. Представьте себе, что некая дорогостоящая мера была предпринята, чтобы предотвратить такое явление. Легко вычислить стоимость этих мер, тогда как результат трудно измерим. Как мы можем говорить об эффективности, когда есть два альтернативных варианта объяснения: или принятые меры были эффективны, или просто ничего существенного не случилось. Оценка качества работы в таких случаях не просто сложна, но искажена наблюдением «актов героизма»… В исторических книгах не пишут о героических превентивных мерах».

Ошибочное включение лишнего элемента

Линде 31 год, она незамужняя, искренняя и оптимистичная девушка. В колледже она специализировалась на философии. Как студентка, она была глубоко озабочена проблемами дискриминации и социальной справедливости, а также участвовала в антиядерных демонстрациях.

Расположите следующие утверждения в порядке уменьшения их вероятности.

- Линда — учитель в начальной школе

- Линда работает в книжном магазине и занимается йогой

- Линда — активистка феминистского движения

- Линда — социальный работник в области психиатрии

- Линда — член общества женщин, имеющих право голоса

- Линда — кассир в банке

- Линда — страховой агент

- Линда — кассир в банке и активистка феминистского движения

89 % из 88 студентов посчитали пункт 8 более вероятным, чем пункт 6 [Tversky и Kahneman, 1982]. Поскольку выбранное описание Линды похоже на описание феминистки, а не банковского кассира, п.8 в большей мере характерен для описания Линды. Однако, считая п.8 более вероятным, чем п.6, мы нарушаем закон суммирования вероятностей, который утверждает, что P(A & B) ≤ P(A). Представьте себе выборку из 1000 женщин. Наверняка в этой выборке больше женщин — банковских кассиров, чем женщин-феминисток и одновременно банковских кассиров. Может быть, ошибочное включение лишнего элемента связана с тем, что участники воспринимали экспериментальные инструкции неправильно? Например, они могли понять под «вероятностью» вероятность того, что женщина, для которой верны утверждения 6 и 8, соответствует приведенному выше описанию Линды, а не вероятность утверждений 6 и 8 в отношении Линды? Или, возможно, они интерпретировали 6 как означающее «Линда — кассир и не феминистская активистка»? И, хотя, чтобы объяснить склонность к этой логической ошибке, было предложено много интересных альтернативных гипотез, она пережила все экспериментальные попытки ее опровержения (см. обзор [Sides, 2002].) Например, следующий эксперимент исключает обе альтернативные гипотезы, предложенные выше. Представьте себе правильный 6-сторонний кубик с четырьмя зелеными сторонами и двумя красными. Кубик будет брошен 20 раз и последовательность выпадения зеленых (G) и красных (R) сторон будет записана. Испытуемый должен выбрать одну последовательность из трех предложенных, и он выиграет 25 $, если выбранная им последовательность выпадет в серии бросков кубика. Вот эти три последовательности, надо выбрать одну из них.

- RGRRR

- GRGRRR

- GRRRRR

125 студентов в Стэнфордском университете играли в эту игру с реальными ставками. 65 % из них выбрали последовательность 2. [Tversky и Kahneman, 1982]. Последовательность 2 наиболее типична для игральной кости, поскольку кость большей частью зеленая и последовательность 2 содержит наибольшую пропорцию зеленых сторон. Однако, последовательность 1 превосходит последовательность 2, поскольку полностью входит в нее. Чтобы получилось 2, у вас должна выпасть последовательность 1 и зеленая грань кости перед ней.

В приведенной выше задаче студенты могли вычислить точные вероятности каждого события. Однако вместо того, чтобы тратить время на арифметические вычисления, 65 % студентов, по-видимому, полагались на интуицию, исходя из того, что казалось более типичным для игральной кости. Когда мы называем это умозаключением по типичности, мы не настаиваем на том, что студенты специально решили, что они будут оценивать вероятность, исходя из типичности. Скорее, умозаключение по типичности является как раз тем, что создает интуитивное чувство, будто последовательность 2 более вероятна, чем последовательность 1. Другими словами, умозаключение по типичности является встроенной характеристикой мозга, предназначенной, чтобы давать быстрые достоверные суждения, а не сознательно выбранной процедурой. Мы не осознаем подмены суждением о типичности суждения о достоверности. Ошибочное включение лишнего элемента подобным же образом происходят в футурологических прогнозах. Две независимых группы профессиональных аналитиков на Втором международном конгрессе по предвидению будущего были опрошены, соответственно, о вероятности «полного разрыва дипломатических отношений между СССР и США в 1983 году» и «русского вторжения в Польшу, и последующего полного разрыва дипломатических отношений между СССР и США в 1983 году». Вторая группа аналитиков сообщила о значительно более высокой вероятности. [Tversky и Kahneman, 1982].

В исследовании Джонсона [Johnson, 1993], группа студентов MBA из Уортона должна была отправиться в Бангкок в качестве части своей образовательной программы. Несколько подгрупп студентов было опрошено на тему, как много они готовы заплатить за антитеррористическую страховку. Первой группе был задан вопрос, сколько она готова заплатить за антитеррористическую страховку, покрывающую перелет из Таиланда в США. Вторую группу студентов спросили, сколько она готова заплатить за страховку, покрывающую перелет туда-обратно. А третью — о страховке, которая бы покрывала все путешествие. Эти три группы оказались в среднем готовы заплатить 17,19, 13,90, и 7,44 долларов соответственно.

С точки зрения теории вероятностей, добавление дополнительной детали к истории делает ее менее вероятной. Менее вероятно, что Линда является кассиром-феминисткой, чем просто кассиром, поскольку все кассиры-феминистки по определению являются кассирами. Но с точки зрения человеческой психологии добавление каждой новой детали делает историю все более достоверной.

Люди могут предпочесть заплатить больше за международную дипломатию, направленную на предотвращение нанотехнологической войны с Китаем, чем за инженерный проект, предназначенный, чтобы защитить от нанотехнологической атаки с любой возможной стороны. Второй сценарий предотвращения выглядит менее зрелищным и побуждающим, но универсальная технологическая защита будет более полезной по причине своей многосторонности. Более ценными выглядят стратегии, которые уменьшают вероятности истребления человечества без жесткой зацикленности только на нанотехнологических угрозах — такие, как колонизация космического пространства или искусственный интеллект (см. работы автора на эту тему). Брюс Шнейер заметил что правительство Соединенных Штатов (и до, и после урагана 2005 года в Новом орлеане), защищало отдельные объекты на территории страны от террористических угроз в стиле киносценариев ценой отвлечения ресурсов из средств гражданской обороны, которые могли бы быть использованы в любой ситуации [Schneier, 2005]. Сверхдетальные заверения также могут создать ложное ощущение безопасности: «Х не является риском существованию, и вы не должны заботиться о нем, потому что верны утверждения A, B, C, D, и E». В то время как ошибка в любом из предположений является потенциально гибельной для человеческого рода. «Мы не должны беспокоиться о нанотехнологической войне, потому что комиссия ООН в начале разовьет эту технологию и предотвратит ее распространение до тех пор, пока не будет разработана активная защита, способная защитить от всех случайных или злонамеренных проявлений, которые современная нанотехнология способна породить, и это условие будет выполняться всегда». Яркие, четко определенные сценарии могут увеличить нашу вероятностную оценку безопасности, равно как и неправильно направить инвестиции в безопасность с учетом излишне суженных или невероятно детализированных сценариев рисков.

В целом, людям свойственно переоценивать вероятность совпадений всех событий в серии и недооценивать вероятность хотя бы одного события из серии. [Tversky и Kahneman, 1982]. То есть, людям свойственно переоценивать вероятность того, что, например, семь событий, с вероятностью 90 % каждое, все вместе совпадут. Наоборот, людям свойственно недооценивать вероятность того, что хотя бы одно событие из семи, имеющих каждое вероятность 10 %, все-таки случится. Некто, оценивающий, стоит ли, например, открыть новую компанию, должен вычислить вероятность того, что множество отдельных событий произойдет одновременно нужным образом (что будет достаточное финансирование, компетентные рабочие, покупатели будут хотеть купить товар), учитывая также вероятность того, что, по крайней мере, одна критическая неприятность случится (банк откажется дать ссуду, главный проект закончится неудачей, ведущий ученый проекта умрет). Это может объяснить, почему только 44 % предприятий выживают в течение первых четырех лет. [Knaup, 2005.]

Адвокаты в своих речах предпочитают избегать выводов, основанных на истинности, по крайней мере, одной из нескольких посылок («либо одно, либо другое, либо третье должно было случится и каждый из этих вариантов приводит к одному и тому же выводу»), в пользу выводов, основанных на совпадении сразу нескольких посылок. Однако с рациональной точки зрения первые случаи гораздо более вероятны, чем вторые. Вымирание человечества в следующем столетии может произойти в результате хотя бы одной из многих причин. Оно может случиться по причине любого глобального риска, обсужденного в статье Бострома «Угрозы существованию», или по какой-нибудь другой причине, которую никто из нас не предвидел. Даже для футурологов описания в духе «или то, или другое, или третье» неудобны, и пророчества, с помощью них сформулированные, звучат непоэтично.

Ошибочность рассуждений, вызванная эффектом подтверждения

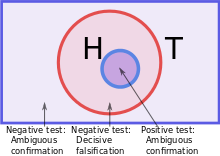

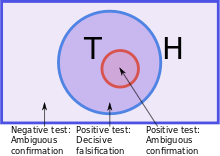

В 1960 году Питер Уосон (Peter Wason) провел ныне классический эксперимент, известный как задача «2-4-6» [Wason, 1960.] Испытуемые должны были определить правило, известное экспериментатору, но не самому испытуемому — так, как оно бывает при научном исследовании. Испытуемые писали три числа, таких как «2-4-6» или «10-12-14» на карточках, и экспериментатор говорил, соответствуют ли данные три числа правилу или нет. Изначально испытуемым была выдана тройка чисел 2-4-6 и сказано, что она соответствует правилу. Испытуемые могли продолжать испытывать тройки до тех пор, пока они не чувствовали себя уверенными, что знают правило экспериментатора, и тогда испытуемым объявляли правило.

Хотя участники обычно выражали высокую уверенность в своих догадках, только 21 % из них в этом эксперименте правильно угадали правило, и при повторениях эксперимента уровень успеха обычно составлял 20 %. Вопреки совету Карла Поппера, испытуемые в эксперименте Уосона пытались подтвердить свои гипотезы, а не опровергнуть. Таким образом, те, кто сформулировали гипотезу «Числа увеличиваются каждый раз на два», проверяли тройки 8-10-12 или 20-22-24, слышали, что они подходят, и уверенно объявляли правило. Во всех случаях подлинное правило было одно и то же: три номера должны следовать один за другим по возрастающей. В некоторых случаях испытуемые выдумывали, «тестировали» и объявляли правила, гораздо более сложные, чем действительное.

Задача Уосона «2-4-6» является «прохладной» формой интеллектуальной ошибки, связанной с подтверждением: люди предпочитают подтверждающие, а не опровергающие свидетельства. «Прохладный» означает, что задача «2-4-6» является эмоционально нейтральным случаем интеллектуальной ошибки подтверждения: вывод подтверждается логикой, а не эмоциями. «Горячий» случай имеет место, когда вера эмоционально заряжена, например, в случае политических рассуждений. Неудивительно, что «горячая» ошибочность сильнее — больше по размаху и более устойчивая к изменениям. Активная, полная усилий склонность к подтверждению обычно называется мотивированным мышлением (motivated cognition) (обычно известным как «рационализация»). Как отмечает Бреннер [Brenner, 2002] в «Заметках к теории одобрения»:

«Очевидно, что во многих обстоятельствах желание уверенности в гипотезе может заметно повлиять на воспринимаемую степень ее подтверждения… Кунда [Kunda, 1990] обсуждает, как люди, нацеленные на то, чтобы достичь определенных выводов, пытаются сконструировать (в ошибочной манере) убедительный случай для своей любимой гипотезы, который мог бы убедить беспристрастную аудиторию. Гилович [Gilovich, 2000] предполагает, что выводы, в которые человек не хочет верить, рассматриваются гораздо требовательнее, чем те, в которые он хочет верить. В первом случае человек требует, чтобы свидетельство с необходимостью вело к данному выводу, а во втором — спрашивает, позволяет ли некоторое свидетельство прийти к данному выводу».

Когда люди подвергают те свидетельства, которые противоречат их точке зрения, более пристрастному анализу, чем те, которые ее подтверждают, это называется мотивированный скептицизм или когнитивное искажение несогласия (disconfirmation bias). Ошибка несогласия особенно деструктивна по двум причинам: во-первых, два подверженных этой ошибке спорщика, рассматривая один и тот же поток свидетельств, могут изменить свою веру в противоположных направлениях — обе стороны выборочно принимают только привлекательные для них свидетельства. Накопление большего числа свидетельств не приведет этих спорщиков к согласию. Во-вторых, люди, которые являются более опытными скептиками, – то есть которые знают больший набор типичных логических нестыковок, но применяют этот навык избирательно, – склонны изменять свою точку зрения гораздо медленнее, чем неопытные спорщики.

Тэйбер и Лодж [Taber and Lodge, 2000] исследовали изначальное отношение к теме ношения огнестрельного оружия и изменение его у студентов, под воздействием прочтения политической литературы за и против контроля и выдачи разрешений на оружие. Это исследование проверило шесть следующих гипотез в двух экспериментах:

- Эффект предшествующего отношения. Испытуемые, имевшие изначальную точку зрения на проблему — даже когда их поощряли в том, чтобы они были объективными — находили поддерживающие аргументы более охотно, чем опровергающие.

- Систематическая ошибка опровержения. Испытуемые тратили больше времени и умственных усилий, стараясь отклонить опровергающие аргументы, чем поддерживающие аргументы.

- Систематическая ошибка подтверждения. Испытуемые, свободные выбирать источники информации, скорее искали подтверждающие, чем опровергающие источники.

- Поляризация отношения. Предъявление испытуемым очевидно уравновешенного набора аргументов за и против приводило к увеличению изначальной поляризации их мнений.

- Эффект силы мнения. Испытуемые, имеющие более ярко выраженное мнение, были более подвержены вышеназванным склонностям к ошибке.

- Эффект усложнения. Более искушенные в политике испытуемые, по причине обладания более тяжелым вооружением для опровержения противных фактов и доводов, были более подвержены вышеприведенным систематическим ошибкам.

Забавно, что эксперименты Тэйбера и Лоджа (Taber and Lodge) подтвердили все шесть изначальных гипотез авторов. Вы можете сказать: «Вероятно, эти эксперименты только отражают убеждения, на которые опирались их авторы, и это как раз пример систематической ошибки подтверждения». Если так, то, сделав вас более опытным спорщиком, а именно, научив вас еще одной систематической ошибке, в которой можно обвинить людей, я, в действительности, навредил вам: я ослабил вашу реакцию на новую информацию. Я дал вам еще один шанс всякий раз терпеть неудачу, когда вы сталкиваетесь с возможностью изменить свой стиль мышления. Эвристика и когнитивные искажения широко распространены в человеческих размышлениях. Знание о них позволяет нам замечать большое разнообразие логических ошибок, которые, в противном случае, были бы недоступны для нашего наблюдения. Но, как и любая способность обнаруживать ошибки в рассуждениях, это знание должно применяться как к нашим собственным идеям, так и к идеям других; к идеям, которые нам нравятся, и которые нам не нравятся. Знание человеческой склонности ошибаться — это опасное знание, если вы напоминаете себе об ошибочности тех, кто не согласен с вами. Если я избирателен в отношении тех аргументов, которые я исследую на предмет ошибок, или даже того, насколько глубоко я исследую эти ошибки, тогда каждый новый закон логики, каждая новая логическая несообразность, которую я научаюсь обнаруживать, делает меня глупее. Ум, чтобы быть полезным, должен быть использован не для того, чтобы дурачить самого себя.

Нельзя рационализировать то, что не рационально с самого начала — как если ложь назвать «правдизацией». Нельзя сделать утверждение более истинным посредством взяточничества, лести или даже страстной аргументации — можно заставить больше людей верить в утверждение, но нельзя сделать его вернее. Для того, чтобы сделать наши убеждения более истинными, мы должны изменить сами эти убеждения. Не каждое изменение — это улучшение, но каждое улучшение — это изменение по определению.

Наши убеждения гораздо менее гибкие, чем мы привыкли думать. Гриффин и Тверский [Griffin and Tversky, 1992] аккуратно опросили каждого из двадцати четырёх сотрудников, которые оказались в ситуации выбора из двух предложенных вакансий и попросили их оценить, с какой вероятностью они примут то или иное предложение. Средняя вероятность выбора, высказанная в отношении более привлекательного предложения, составила умеренные 66%. Но только один из 24 опрошенных выбрал в конечном счёте вариант, которому он приписал в начале более низкую вероятность, доведя таким образом точность до 96%. (Это — один из немногих известных примеров, когда имеет место не «сверх-уверенность», а «недо-уверенность».)

Мораль в том, что как только вы начинаете догадываться, каков будет ваш ответ, как только вы приписываете большую вероятность тому, что вы ответите так, а не иначе, вы, на самом деле, уже решили. И если вы будете честны с самим собой, вы должны признать, что обычно вы догадываетесь об окончательном ответе через секунды после того, как услышите вопрос. Мы меняем наши мнения гораздо реже, чем мы думаем. Насколько скоротечен этот короткий незаметный момент, когда мы даже не можем догадаться, каков будет наш ответ, малюсенькое хрупкое мгновение, которое нам отведено, чтобы на самом деле подумать — как в вопросах выбора, так и в вопросах установления фактов.

Шенкель (Shenkel) говорил: «Нет необходимости в вере, пока ситуация может быть легко рассмотрена тем или другим образом».

Норман Майер (Norman R. F. Maier): «Не предлагайте решения до тех пор, пока проблема не будет исследована так тщательно, как это только возможно».

Робин Доуз (Robyn Dawes), комментируя Майера, писал: «Я часто предлагал это правило группам, которые я вел, в частности, когда они сталкивались с особенно трудной проблемой. Это – типичная ситуация, когда члены группы особенно склонны предлагать мгновенные решения».

В компьютерной безопасности «система, которой доверяют» (trusted system) — это та, которой вы на самом деле доверяете, а не та, которая достойна доверия. «Система, которой доверяют» — это система, которая, будучи скомпрометированной, способна вызвать ошибку. Когда вы читаете статью, утверждающую, что глобальная катастрофа невозможна, или имеет определенную годовую вероятность, или может быть преодолена с использованием определенной стратегии — вы доверяете рациональности авторов. Вы доверяете способности авторов переходить от удобных выводов к неудобным, даже в случае отсутствия сногсшибательных экспериментальных свидетельств, опровергающих любимую гипотезу. Вы доверяете авторам в том, что они не искали немного более интенсивно ошибки в тех уравнениях, которые указывали на неверный, с их точки зрения, путь, до того, как к вам попал окончательный вариант статьи.

И если власти вводят закон, по которому даже мельчайший риск существованию человечества достаточен для того, чтобы закрыть проект; или если становится нормой политики де-факто, что ни одно возможное вычисление не может перевесить груз однажды высказанного предположения, то тогда ни один ученый не рискнет больше высказывать предположения. Я не знаю, как решить эту проблему. Но я думаю, что тем, кто оценивает глобальные риски, следует иметь общие представления о человеческих моделях рассуждений и когнитивных искажениях, и об ошибке неподтверждения в частности.

Якорение, настройка и наложение

Экспериментатор крутит у вас на глазах рулетку, и она указывает на некое число, в первом случае, на 65, а во втором — на 15. Экспериментатор затем спрашивает вас, больше или меньше процент африканских стран в ООН этого числа. Затем экспериментатор спрашивает вас о вашей оценке процента африканских стран в ООН. Тверский и Канеман [Tversky и Kahneman, 1974] продемонстрировали, что испытуемые, которых вначале попросили оценить, находится ли искомое число выше или ниже 15, затем давали значительно более низкие оценки процента африканских стран в ООН, чем те испытуемые, которых в начале просили оценить, выше или ниже этот процент 65. Средняя оценка по группе была в первом случае 25, во втором — 45 процентов. Это происходило, несмотря на то, что испытуемые видели, что номера генерируются очевидно случайным образом, рулеткой, и потому могли быть уверены, что эти номера не имеют никакого отношения к реальному проценту африканских стран в ООН. Денежные выплаты за точность не изменили интенсивность этого эффекта. Тверский и Канеман предположили, что этот эффект вызван якорением и настройкой; испытуемые принимали изначальное неинформативное число за точку отсчета, или якорь, и затем увеличивали или уменьшали это число, до тех пор, пока не достигали результата, который выглядел убедительно для них; тогда они прекращали подстройку. Этот результат был недооценкой, связанной с данным якорем.

В примере в начале статьи мы сперва попросили эксперта по веществу P предположить точное значение силы радиосигнала, который приведет к взрыву P, и только затем попросили оценить верхние и нижние границы для этого параметра. Этот метод опроса заставляет людей подстраивать свой ответ о верхней и нижней границе к изначальной оценке, до тех пор, пока они не достигают значений, которые звучат невероятно и прекращают подстройку. Это приводит к недооценке и слишком узким границам интервала уверенности.

После статьи Тверского и Канемана 1974 года стало накапливаться все больше свидетельств широкого круга эффектов якорения и псевдо-якорения. Якорение происходило, даже когда якорь давал абсолютно невероятный ответ на вопрос, например, при опросе студентов относительно года первого визита Эйнштейна в США, после рассмотрения якорей 1215 или 1992. Эти недостоверные якоря создавали эффект якорения такой же силы, как и более достоверные якоря, такие как 1905 и 1939 [Strack and Mussweiler, 1997].

Допустим, вы идете по супермаркету и видите стойку с банками консервированной томатной пасты с надписью: «Только 12 штук в руки». Заставляет ли это людей на самом деле покупать больше томатной пасты? Согласно экспериментальным данным, заставляет [Wansink et. al., 1998].

Более общая форма этого феномена стала известна как эффект загрязнения, поскольку оказалось, что почти любая информация может повлиять на интеллектуальное суждение [Chapman and Johnson, 2002]. Предпринимались попытки ослабить эффект загрязнения путем выплаты испытуемым вознаграждения за правильные ответы. Тверский и Канеман [Tversky и Kahneman, 1974] инструктировали испытуемых о необходимости избежать якорения начальным показателем [Quattrone et. al., 1981] или о необходимости уделять внимание проблемам реального мира [Wansink et. al., 1998]. Эти действия не уменьшили или уменьшили только в незначительной степени интенсивность эффектов якорения и наложения. Более того, испытуемые, спрошенные о том, были ли они подвергнуты действию эффекта загрязнения, обычно не верили, что он на них повлиял, хотя эксперименты показывали обратное. [Wilson et. al., 1996].

Действия, существенно увеличивающие эффект загрязнения – это действия, помещающие испытуемых в интеллектуально трудные условия, такие, как непрерывное прослушивание последовательности слов в процессе работы [Gilbert et. al., 1988] или требование от испытуемых быстрых ответов [Gilbert and Osborne, 1989]. Гилберт [Gilbert et. al., 1988] связывает это с тем, что дополнительная задача влияет на способность отстроиться от якоря; иначе говоря, в интеллектуально загруженных условиях происходит меньшая корректировка. Этот эффект уменьшения корректировки, а значит, увеличения недокорректировки, известен как якорение.

Суммируем: явно нерелевантная информация по-прежнему якорит суждения и искажает догадки. Когда люди начинают с информации, про которую заранее известно, что она нерелевантная, и затем производят подстройку, пока не достигают убедительно звучащего ответа, они обычно недооценивают величину некого параметра. Люди недооценивают величину параметра в гораздо большей степени в ситуациях интеллектуальной нагрузки и других воздействий, что делает проблему более серьезной. Люди отрицают, что были заякорены и недооценивали, даже когда эксперименты показывают противоположное. Эти эффекты не ослабляются или ослабляются незначительно при финансовом вознаграждении, явных инструкциях избежать наложения и в ситуациях из реальной жизни. А теперь вспомните, сколько историй из лент новостей об искусственном интеллекте ссылаются на фильмы о Терминаторе, как если бы они были документальными, и как много медийных историй о взаимодействии мозга и компьютера упоминают боргов из фильма «Звездный путь».

Если даже короткая демонстрация якоря оказывает существенное воздействие на испытуемых, насколько больший эффект мы можем ожидать от чтения целой книги или просмотра остросюжетного телевизионного шоу? В прошлом не было фильмов — все, что вы видели своими глазами, было правдой. Людям следует осознавать, в той мере, в какой осознанные мысли принимаются в расчет, что фантастика есть фантастика. Журналистские упоминания о «Терминаторе» обычно не рассматривают сценарий Камерона в качестве пророчества или установленной правды. Вместо этого репортер как бы считает видения Камерона чем-то, что уже однажды имело место в прошлом и вполне может случиться вновь — фильм вспоминается как если бы он был иллюстрирующим случаем из истории человечества. Я называю эту смесь якорения и доступности для восприятия логической ошибкой генерализации на основании художественного вымысла.

Похожей концепцией является ошибка «хорошей истории», предложенная Бостромом [Bostrom, 2001]. Художественные свидетельства часто состоят из «хороших историй» в бостромском смысле. Отметьте, что не все возможные «хорошие истории» уже представлены в литературе.

Рассказчики историй соблюдают строгие правила повествовательности, не имеющие отношения к реальности. Драматическая логика — это не логика. Вдохновленные писатели знают, что одной правды мало: нельзя заставить поверить в невероятное событие из вашего произведения путем цитирования примеров из реальной жизни. Хорошая история раскрашена яркими деталями, расцвечена цветущими метафорами; рассказчик историй должен быть конкретным, твердым и точным, как камень. Но в предвидении будущего каждая добавленная деталь является дополнительной нагрузкой! Правда — это тяжелая работа, и — не для рассказчиков историй. Мы должны избегать не только одурачивания фантастикой в виде нашей неспособности совершить ментальное усилие, чтобы разувериться в ней, но также того, чтобы фантастика наложилась на наше мышление и стала точкой отсчета для наших суждений. И мы должны осознавать, что мы не всегда осознаем это наложение. В дискуссиях о глобальных рисках отнюдь не необыкновенны категории, выборы, последствия и стратегии, пришедшие из фильмов, книг и телевизионных шоу. Бывают красивые неудачи, но это — откровенная капитуляция.

Рассуждения, обусловленные аффектом

Рассуждения, обусловленные аффектом, возникают, когда субъективные представления о хорошем и плохом выступают в качестве эвристики и способны порождать быстрые, основанные на непосредственном восприятии, суждения, а также систематические ошибки.

В исследовании Словича [Slovic, 2002] две группы испытуемых рассматривали такой сценарий: аэропорт должен решить, следует ли ему потратить деньги на новое оборудование, или на другие аспекты системы безопасности. Шкала ответов ранжирована от 0 (никакой поддержки этому решению) до 20 (очень сильная поддержка). Оказалось, что мероприятие, описанное как «Спасти 150 жизней» получило среднюю поддержку 10,4, в то время как мероприятие, описанное как «Спасти 98 % от 150 жизней» имело среднюю поддержку в 13,6. Даже предложение «спасти 85 % от 150 жизней» имело большую поддержку, чем «спасение 150 жизней». Гипотеза, лежащая в основе этого эксперимента, состояла в том, что «спасение 150 жизней» звучит довольно расплывчато и потому имеет небольшую ценность, в то время как спасение 98 % чего-нибудь это очень хорошо, потому что это очень близко к верхней границе процентной шкалы.

Файнакэйн [Finucane, 2000] исследовал, объединяют ли люди свои оценки возможных преимуществ от некой технологии, такой как, например, ядерная энергетика, со своими оценками возможных рисков, в едином хорошем или плохом ощущении по поводу этой технологии. Он тестировал эту гипотезу, предлагая испытуемым четыре разных сообщения, которые должны были увеличить или ослабить воспринимаемые риски и воспринимаемые преимущества. Не было никакой логической связи между предоставленной информацией о рисках и о преимуществах. В каждом случае новая информация оказывала противоположный эффект на эмоционально противоположную характеристику. Информация, которая увеличивала восприятие риска, ослабляла восприятие преимуществ. Информация, которая ослабляла восприятие преимуществ, увеличивала восприятие рисков. Файнакэйн обнаружил, что нехватка времени обычно усиливает отрицательную взаимосвязь между воспринимаемыми рисками и воспринимаемыми преимуществами — предположительно потому, что эта нехватка усиливает преобладание эмоциональных моделей рассуждений над аналитическим анализом.

Ганзах [Ganzach, 2001] обнаружил тот же эффект в царстве финансов: аналитики делают прогнозы рисков и доходов незнакомых активов на основании эмоционального отношения. Акции, воспринимавшиеся как «хорошие», были определены как имеющие низкий риск и высокий доход; акции, воспринимавшиеся как «плохие», определялись как имеющие низкий доход и высокий риск. Таким образом, для незнакомых акций, воспринимаемый риск и воспринимаемый доход имели отрицательную корреляцию, в соответствии с эмоциональной логикой. (Отметьте, что в этом эксперименте нехватка информации играет ту же роль, что занятость ума или нехватка времени в усилении эффекта эмоциональной логики.) Для знакомых акций воспринимаемый риск и воспринимаемый доход имели позитивную корреляцию, как это и предсказывается в норме экономической теорией. (Если акции безопасны, покупатель платит премию за их безопасность, и они являются более дорогими, что уменьшает ожидаемый доход.)

Люди обычно имеют недостаточную информацию о будущих технологиях. Поэтому неудивительно, что их отношение эмоционально поляризовано. Когда я только начал думать об этих материях, я считал, что биотехнология имеет относительно меньше достоинств сравнительно с нанотехнологией, и я больше боялся сконструированных супервирусов, чем вредоносного применения нанотехнологий. Искусственный интеллект, от которого я ожидал наибольших выгод, нисколько не беспокоил меня. Позже, когда я исследовал проблему гораздо более детально, моя оценка относительных преимуществ осталась относительно такой же, но мои тревоги стали противоположными: более мощные технологии, с большими ожидаемыми выгодами, теперь выглядят имеющими соответственно большие риски. С ретроспективной точки зрения это вполне предсказуемо. Но анализ, основанный на недостаточной информации, склонен оценивать технологии эмоционально, в результате чего информация о преимуществах имеет тенденцию смягчать воспринимаемый риск.

Пренебрежение масштабом

(2000 / 20000 / 200000) перелетных птиц тонут каждый год в незакрытых нефтехранилищах, которые птицы по ошибке принимают за пруды с водой. Эти смерти могут быть предотвращены путем накрывания хранилищ сетями. Сколько денег вы были бы готовы заплатить за установку таких сетей?

Три группы испытуемых, рассматривавших этот вопрос, были опрошены о том, какое увеличение налога они были бы готовы принять, чтобы спасти 2000, 20000 или 200000 птиц. Ответ, названный Установленная Готовность Платить (УГП), был в среднем 80 $ за 2000 птиц, 78 $ за 20000 и 88 $ за 200000 птиц. [Desvousges, 1993]. Этот феномен известен как нечувствительность к масштабу или пренебрежение масштабом.

Подобные исследовании показали, что жители Торонто готовы заплатить только немногим больше, чтобы очистить все озера Онтарио, чем чтобы очистить загрязенные озера только части штата [Kahneman, 1986], и что жители четырех западных штатов в США готовы заплатить только на 28 % больше, чтобы защитить все 57 уголков дикой природы в этих штатах, чем чтобы защитить только один такой уголок. [McFadden и Leonard, 1995]. Наиболее широко распространенное объяснение эффекта пренебрежения масштабом апеллирует к эмоциональной логике. Канеман [Kahneman, 1999] пишет:

«История о птицах из опытов Девужа (Desvousges), вероятно, вызывает у многих читателей ментальное представление о неком событии, возможно — образ истощенной птицы с намоченными черной нефтью крыльями, неспособной спастись. Гипотеза об оценке по первоначальному образу утверждает, что эмоциональное влияние этого образа будет доминировать над отношением к проблеме, включая готовность платить за решение. Оценка по первоначальному образу автоматически означает пренебрежение к остальным деталям ситуации»

Две другие гипотезы о пренебрежении масштабом включают в себя покупку морального удовлетворения [Kahneman и Knetsch, 1992] и пожертвование монетки ради доброго дела [Harrison, 1992]. Гипотеза о моральном удовлетворении предполагает, что люди тратят достаточно денег, чтобы создать ощущение «внутренней теплоты» в себе, и требующийся на это объем денег зависит от человеческой психологии и не имеет ничего общего с птицами. Гипотеза о «монетке на благотворительность» предполагает, что люди готовы выделить определенную сумму «на экологию», и любой вопрос о проблемах окружающей среды просто проявляет это количество.

Пренебрежение масштабом было продемонстрировано и по отношению к человеческим жизням. Карсон и Митчелл [Carson and Mitchell„ 1995] сообщают, что информации об увеличении риска, связанного с питьем хлорированной воды с 0,004 до 2,43 на 1000 смертей в год (то есть в 600 раз) увеличивает установленную готовность платить (УГП) платить с 3,78 до 15,23 долларов (то есть 4 раза). Бэйрон и Грин [Baron and Greene, 1996] обнаружили, что изменение числа спасенных жизней в 10 раз не оказывает никакого эффекта на этот индекс.

Фезерстонхоу [Fetherstonhaugh, 1997], в статье, озаглавленной «Нечувствительность к ценности человеческой жизни: исследование психологического восприятия чисел», обнаружил свидетельства того, что наше восприятие человеческих смертей и ощущение ценности человеческих жизней следует закону Вебера, это значит, что мы используем логарифмическую шкалу. И действительно, исследования эффекта пренебрежения масштабом, в которых количественные изменения были достаточно велики, чтобы вызвать хотя бы какую-то чувствительность, показали небольшие линейные изменения готовности платить, соответствующие экспоненциальным изменениям масштаба. Канеман [Kahneman, 1999] интерпретирует это как дополнительный эффект эмоциональной реакции на масштаб к реакции на первоначальный образ: первоначальный образ вызывает большую часть эмоции, а масштаб вызывает меньшую часть эмоции, которая добавляется (но не умножается) к первоначальному количеству.

Альберт Сент-Дьёрди (Albert Szent-Györgyi) говорит: «На меня производят сильное впечатление страдания одного человека, и я готов рисковать своей жизнью ради него. Но я могу говорить совершенно отстранённо о заражении наших больших городов с сотнями миллионов погибших. Я не способен умножить страдания одного на сто миллионов». Человеческие эмоции возникают внутри аналогового ума. Человеческий мозг не способен выработать достаточно нейротрансмиттеров, чтобы почувствовать эмоцию в тысячу раз более сильную, чем горе на похоронах. Увеличение возможного риска с десяти миллионов смертей до ста миллионов не увеличивает в десять раз нашу решимость не допустить этого. Это просто добавление еще одного нолика на бумаге у нас перед глазами, что имеет столь небольшой эффект, что обычно необходимо изменить количество жертв на несколько порядков, чтобы заметить разницу экспериментально.

Калибровка и сверхуверенность

Насколько люди уверены в своих ошибочных оценках? В первом разделе этой статьи, посвященном эффекту доступности информации, мы обсудили эксперимент по восприятию риска, в котором испытуемые переоценивали типичные для сообщений средств массовой информации причины смерти в пропорции, коррелирующей с избирательными сообщениями в газетах. Словик [Slovic, 1982] также отмечает:

«Одним из пагубных аспектов моделей рассуждений (эвристик) является то, что люди обычно имеют очень большую уверенность в суждениях, основанных на них. В другом исследовании по поводу причин смерти, людей просили сделать ставки на то, что они правы в своем выборе более частой среди двух причин смерти. [Fischoff, Slovic, и Lichtenstein, 1977]. В эксперименте №1 испытуемые были довольно точны, когда делали ставки 1:1, 1.5:1, 2:1, и 3:1. То есть, процент правильных ответов был близок к значению, которое следовало из этих ставок. Однако, по мере увеличения ставок от 3:1 к 100:1 почти никакого прироста точности не происходило. Только 73 % ответов, на которые сделали ставки 100:1, были верны (вместо 99.1 %). Точность возросла до 81 % при ставках 1000:1 и до 87 % при 10000:1. Для ответов, на которые ставили 1000000:1, точность составляла 90 %, то есть, соответствующий уровень доверия должен был бы порождать ставки 9:1. В итоге, испытуемые часто ошибались даже при высочайших уровнях ставок. Более того, они были склонны делать очень высокие ставки. Более половины ставок была выше, чем 50:1. Почти четверть — выше, чем 100:1. 30% респондентов в эксперименте № 1 сделали ставку 50:1 на неверное утверждение, что убийства более часты, чем самоубийства».

Этот кажущийся удивительным результат вполне обычен в литературе, посвященной моделям рассуждений и систематическим ошибкам в мышлении, где он известен как сверхуверенность. Допустим, я попрошу вас сделать наилучшее возможное предположение насчет неизвестного числа, такого, как количество «Врачей и хирургов» в желтых страницах бостонской телефонной книге, или о суммарной продукции яиц в США в миллионах штук. Вы дадите в ответ некую величину, которая наверняка не будет совершенно точной; подлинная величина будет больше или меньше, чем вы предположили. Затем я попрошу вас назвать нижнюю границу этого показателя, такую, насчет которой вы уверены на 99 %, что подлинная величина лежит выше этой границы, и верхнюю границу, по отношению к которой вы на 99 % уверены, что искомая величина лежит ниже нее. Эти две границы образуют ваш интервал 98 % уверенности. Если вы хорошо откалиброваны, то на 100 подобных вопросов у вас будет только примерно 2 выпадения за границы интервала.

Альперт и Раиффа [Alpert и Raiffa, 1982] задали испытуемым 1000 вопросов по общеизвестным темам, подобных приведенным выше. Оказалось, что для 426 из них подлинные значения лежали за пределами 98 % интервалов уверенности, данных испытуемыми. Если бы испытуемые были правильно откалиброваны, было бы только 20 сюрпризов. Иными словами, события, которым испытуемые приписывали вероятность 2%, случались в 42,6%. Другую группу из тридцати пяти испытуемых попросили оценить 99,9% верхние и нижние границы уверенности. Они оказались неправы в 40 % случаев. Другие 35 испытуемых были опрошены о максимальных и минимальных значениях некого параметра и ошиблись в 47% случаев. Наконец, четвертая группа из 35 испытуемых должна была указать «невероятно малое» и «невероятно большое» значение параметра; они ошиблись в 38% случаев.