From Wikipedia, the free encyclopedia

In statistics the mean squared prediction error (MSPE), also known as mean squared error of the predictions, of a smoothing, curve fitting, or regression procedure is the expected value of the squared prediction errors (PE), the square difference between the fitted values implied by the predictive function

Knowledge of g would be required in order to calculate the MSPE exactly; in practice, MSPE is estimated.[1]

Formulation[edit]

If the smoothing or fitting procedure has projection matrix (i.e., hat matrix) L, which maps the observed values vector

The MSPE can be decomposed into two terms: the squared bias (mean error) of the fitted values and the variance of the fitted values:

The quantity SSPE=nMSPE is called sum squared prediction error.

The root mean squared prediction error is the square root of MSPE: RMSPE=√MSPE.

Computation of MSPE over out-of-sample data[edit]

The mean squared prediction error can be computed exactly in two contexts. First, with a data sample of length n, the data analyst may run the regression over only q of the data points (with q < n), holding back the other n – q data points with the specific purpose of using them to compute the estimated model’s MSPE out of sample (i.e., not using data that were used in the model estimation process). Since the regression process is tailored to the q in-sample points, normally the in-sample MSPE will be smaller than the out-of-sample one computed over the n – q held-back points. If the increase in the MSPE out of sample compared to in sample is relatively slight, that results in the model being viewed favorably. And if two models are to be compared, the one with the lower MSPE over the n – q out-of-sample data points is viewed more favorably, regardless of the models’ relative in-sample performances. The out-of-sample MSPE in this context is exact for the out-of-sample data points that it was computed over, but is merely an estimate of the model’s MSPE for the mostly unobserved population from which the data were drawn.

Second, as time goes on more data may become available to the data analyst, and then the MSPE can be computed over these new data.

Estimation of MSPE over the population[edit]

When the model has been estimated over all available data with none held back, the MSPE of the model over the entire population of mostly unobserved data can be estimated as follows.

For the model

Using in-sample data values, the first term on the right side is equivalent to

Thus,

If

Colin Mallows advocated this method in the construction of his model selection statistic Cp, which is a normalized version of the estimated MSPE:

where p the number of estimated parameters p and

That concludes this proof.

See also[edit]

- Akaike information criterion

- Bias-variance tradeoff

- Mean squared error

- Errors and residuals in statistics

- Law of total variance

- Mallows’s Cp

- Model selection

References[edit]

- ^ Pindyck, Robert S.; Rubinfeld, Daniel L. (1991). «Forecasting with Time-Series Models». Econometric Models & Economic Forecasts (3rd ed.). New York: McGraw-Hill. pp. 516–535. ISBN 0-07-050098-3.

Среднеквадратичная ошибка (Mean Squared Error) – Среднее арифметическое (Mean) квадратов разностей между предсказанными и реальными значениями Модели (Model) Машинного обучения (ML):

Рассчитывается с помощью формулы, которая будет пояснена в примере ниже:

$$MSE = frac{1}{n} × sum_{i=1}^n (y_i — widetilde{y}_i)^2$$

$$MSEspace{}{–}space{Среднеквадратическая}space{ошибка,}$$

$$nspace{}{–}space{количество}space{наблюдений,}$$

$$y_ispace{}{–}space{фактическая}space{координата}space{наблюдения,}$$

$$widetilde{y}_ispace{}{–}space{предсказанная}space{координата}space{наблюдения,}$$

MSE практически никогда не равен нулю, и происходит это из-за элемента случайности в данных или неучитывания Оценочной функцией (Estimator) всех факторов, которые могли бы улучшить предсказательную способность.

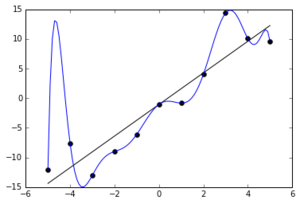

Пример. Исследуем линейную регрессию, изображенную на графике выше, и установим величину среднеквадратической Ошибки (Error). Фактические координаты точек-Наблюдений (Observation) выглядят следующим образом:

Мы имеем дело с Линейной регрессией (Linear Regression), потому уравнение, предсказывающее положение записей, можно представить с помощью формулы:

$$y = M * x + b$$

$$yspace{–}space{значение}space{координаты}space{оси}space{y,}$$

$$Mspace{–}space{уклон}space{прямой}$$

$$xspace{–}space{значение}space{координаты}space{оси}space{x,}$$

$$bspace{–}space{смещение}space{прямой}space{относительно}space{начала}space{координат}$$

Параметры M и b уравнения нам, к счастью, известны в данном обучающем примере, и потому уравнение выглядит следующим образом:

$$y = 0,5252 * x + 17,306$$

Зная координаты реальных записей и уравнение линейной регрессии, мы можем восстановить полные координаты предсказанных наблюдений, обозначенных серыми точками на графике выше. Простой подстановкой значения координаты x в уравнение мы рассчитаем значение координаты ỹ:

Рассчитаем квадрат разницы между Y и Ỹ:

Сумма таких квадратов равна 4 445. Осталось только разделить это число на количество наблюдений (9):

$$MSE = frac{1}{9} × 4445 = 493$$

Само по себе число в такой ситуации становится показательным, когда Дата-сайентист (Data Scientist) предпринимает попытки улучшить предсказательную способность модели и сравнивает MSE каждой итерации, выбирая такое уравнение, что сгенерирует наименьшую погрешность в предсказаниях.

MSE и Scikit-learn

Среднеквадратическую ошибку можно вычислить с помощью SkLearn. Для начала импортируем функцию:

import sklearn

from sklearn.metrics import mean_squared_errorИнициализируем крошечные списки, содержащие реальные и предсказанные координаты y:

y_true = [5, 41, 70, 77, 134, 68, 138, 101, 131]

y_pred = [23, 35, 55, 90, 93, 103, 118, 121, 129]Инициируем функцию mean_squared_error(), которая рассчитает MSE тем же способом, что и формула выше:

mean_squared_error(y_true, y_pred)

Интересно, что конечный результат на 3 отличается от расчетов с помощью Apple Numbers:

496.0Ноутбук, не требующий дополнительной настройки на момент написания статьи, можно скачать здесь.

Автор оригинальной статьи: @mmoshikoo

Фото: @tobyelliott

Анализ временных рядов

- Общее введение

- Две основные цели

- Идентификация модели

временных рядов- Систематическая

составляющая и случайный шум - Два общих типа компонент

временных рядов - Анализ тренда

- Анализ сезонности

- Систематическая

- АРПСС (Бокс и Дженкинс) и

автокорреляции- Общее введение

- Два основных процесса

- Модель АРПСС

- Идентификация

- Оценивание параметров

- Оценивание модели

- Прерванные временные ряды

- Экспоненциальное

сглаживание- Общее введение

- Простое экспоненциальное

сглаживание - Выбор лучшего значения

параметра a (альфа) - Индексы качества подгонки

- Сезонная и несезонная модели

с трендом или без тренда

- Сезонная декомпозиция (метод

Census I)- Общее введение

- Вычисления

- Сезонная корректировка X-11

(метод Census II)- Сезонная корректировка:

основные идеи и термины - Метод Census II

- Таблицы результатов

корректировки X-11 - Подробное описание всех

таблиц результатов, вычисляемых в методе X-11

- Сезонная корректировка:

- Анализ распределенных лагов

- Общая цель

- Общая модель

- Распределенный лаг Алмона

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Общее введение

- Основные понятия и принципы

- Результаты для каждой

переменной - Кросс-периодограмма,

кросс-плотность, квадратурная плотность и

кросс-амплитуда - Квадрат когерентности,

усиление и фазовый сдвиг - Как создавались данные для

примера

- Спектральный анализ —

Основные понятия и принципы- Частота и период

- Общая структура модели

- Простой пример

- Периодограмма

- Проблема рассеяния

- Добавление констант во

временной ряд (пэддинг) - Косинус-сглаживание

- Окна данных и оценки

спектральной плотности - Подготовка данных к анализу

- Результаты для случая, когда в

ряде отсутствует периодичность

- Быстрое преобразование Фурье

- Общее введение

- Вычисление БПФ во временных

рядах

В следующих разделах мы вначале представим

обзор методов, используемых для идентификации

моделей временных рядов (таких как сглаживание,

подгонка и автокорреляции). Затем опишем общий

класс моделей, которые могут быть использованы

для описания рядов и построения прогнозов

(модели авторегрессии и скользящего среднего).

Наконец, расскажем о некоторых простых, но часто

используемых методах, основанных на линейной

регрессии. За дальнейшей информацией обратитесь

к соответствующим разделам.

Общее введение

Вначале дадим краткий обзор методов анализа

данных, представленных в виде временных рядов,

т.е. в виде последовательностей измерений,

упорядоченных в неслучайные моменты времени. В

отличие от анализа случайных выборок, анализ

временных рядов основывается на предположении,

что последовательные значения в файле данных

наблюдаются через равные промежутки времени

(тогда как в других методах нам не важна и часто

не интересна привязка наблюдений ко времени).

Подробное обсуждение этих методов можно найти

в следующих работах: Anderson (1976), Бокс и Дженкинс

(1976), Kendall (1984), Kendall and Ord (1990), Montgomery, Johnson, and Gardiner (1990),

Pankratz (1983), Shumway (1988), Vandaele (1983), Walker (1991), Wei (1989).

Две основные цели

Существуют две основные цели анализа временных

рядов: (1) определение природы ряда и (2)

прогнозирование (предсказание будущих значений

временного ряда по настоящим и прошлым

значениям). Обе эти цели требуют, чтобы модель

ряда была идентифицирована и, более или менее,

формально описана. Как только модель определена,

вы можете с ее помощью интерпретировать

рассматриваемые данные (например, использовать в

вашей теории для понимания сезонного изменения

цен на товары, если занимаетесь экономикой). Не

обращая внимания на глубину понимания и

справедливость теории, вы можете

экстраполировать затем ряд на основе найденной

модели, т.е. предсказать его будущие значения.

Идентификация модели временных

рядов

- Систематическая

составляющая и случайный шум - Два общих типа компонент

временных рядов - Анализ тренда

- Анализ сезонности

За более полной информацией о простых

автокорреляциях (обсуждаемых в этом разделе) и

других автокорреляциях, см. Anderson (1976), Box and Jenkins

(1976), Kendall (1984), Pankratz (1983), and Vandaele (1983). См. также:

- АРПСС (Бокс и Дженкинс) и

автокорреляции - Прерванные временные ряды

- Экспоненциальное

сглаживание - Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Систематическая составляющая и

случайный шум

Как и большинство других видов анализа, анализ

временных рядов предполагает, что данные

содержат систематическую составляющую (обычно

включающую несколько компонент) и случайный шум

(ошибку), который затрудняет обнаружение

регулярных компонент. Большинство методов

исследования временных рядов включает различные

способы фильтрации шума, позволяющие увидеть

регулярную составляющую более отчетливо.

Два общих типа компонент

временных рядов

Большинство регулярных составляющих временных

рядов принадлежит к двум классам: они являются

либо трендом, либо сезонной составляющей. Тренд

представляет собой общую систематическую

линейную или нелинейную компоненту, которая

может изменяться во времени. Сезонная

составляющая — это периодически повторяющаяся

компонента. Оба эти вида регулярных компонент

часто присутствуют в ряде одновременно.

Например, продажи компании могут возрастать из

года в год, но они также содержат сезонную

составляющую (как правило, 25% годовых продаж

приходится на декабрь и только 4% на август).

Эту общую модель можно понять на

«классическом» ряде — Ряд G (Бокс и

Дженкинс, 1976, стр. 531), представляющем месячные

международные авиаперевозки (в тысячах) в

течение 12 лет с 1949 по 1960 (см. файл Series_g.sta).

График месячных перевозок ясно показывает почти

линейный тренд, т.е. имеется устойчивый рост

перевозок из года в год (примерно в 4 раза больше

пассажиров перевезено в 1960 году, чем в 1949). В то же

время характер месячных перевозок повторяется,

они имеют почти один и тот же характер в каждом

годовом периоде (например, перевозок больше в

отпускные периоды, чем в другие месяцы). Этот

пример показывает довольно определенный тип

модели временного ряда, в которой амплитуда

сезонных изменений увеличивается вместе с

трендом. Такого рода модели называются моделями

с мультипликативной сезонностью.

Анализ тренда

Не существует «автоматического» способа

обнаружения тренда в временном ряде. Однако если

тренд является монотонным (устойчиво возрастает

или устойчиво убывает), то анализировать такой

ряд обычно нетрудно. Если временные ряды

содержат значительную ошибку, то первым шагом

выделения тренда является сглаживание.

Сглаживание. Сглаживание всегда включает

некоторый способ локального усреднения данных,

при котором несистематические компоненты

взаимно погашают друг друга. Самый общий метод

сглаживания — скользящее среднее, в котором

каждый член ряда заменяется простым или

взвешенным средним n соседних членов, где n

— ширина «окна» (см. Бокс и Дженкинс, 1976; Velleman

and Hoaglin, 1981). Вместо среднего можно использовать

медиану значений, попавших в окно. Основное

преимущество медианного сглаживания, в

сравнении со сглаживанием скользящим средним,

состоит в том, что результаты становятся более

устойчивыми к выбросам (имеющимся внутри окна).

Таким образом, если в данных имеются выбросы

(связанные, например, с ошибками измерений), то

сглаживание медианой обычно приводит к более

гладким или, по крайней мере, более

«надежным» кривым, по сравнению со

скользящим средним с тем же самым окном. Основной

недостаток медианного сглаживания в том, что при

отсутствии явных выбросов, он приводит к более

«зубчатым» кривым (чем сглаживание

скользящим средним) и не позволяет использовать

веса.

Относительно реже, когда ошибка измерения

очень большая, используется метод сглаживания

методом наименьших квадратов, взвешенных

относительно расстояния или метод отрицательного

экспоненциально взвешенного сглаживания. Все

эти методы отфильтровывают шум и преобразуют

данные в относительно гладкую кривую (см.

соответствующие разделы, где каждый из этих

методов описан более подробно). Ряды с

относительно небольшим количеством наблюдений и

систематическим расположением точек могут быть

сглажены с помощью бикубических сплайнов.

Подгонка функции. Многие монотонные

временные ряды можно хорошо приблизить линейной

функцией. Если же имеется явная монотонная

нелинейная компонента, то данные вначале следует

преобразовать, чтобы устранить нелинейность.

Обычно для этого используют логарифмическое,

экспоненциальное или (менее часто)

полиномиальное преобразование данных.

Анализ сезонности

Периодическая и сезонная зависимость

(сезонность) представляет собой другой общий тип

компонент временного ряда. Это понятие было

проиллюстрировано ранее на примере

авиаперевозок пассажиров. Можно легко видеть,

что каждое наблюдение очень похоже на соседнее;

дополнительно, имеется повторяющаяся сезонная

составляющая, это означает, что каждое

наблюдение также похоже на наблюдение, имевшееся

в том же самом месяце год назад. В общем,

периодическая зависимость может быть формально

определена как корреляционная зависимость

порядка k между каждым i-м элементом ряда и

(i-k)-м элементом (Kendall, 1976). Ее можно измерить с

помощью автокорреляции (т.е. корреляции между

самими членами ряда); k обычно называют лагом

(иногда используют эквивалентные термины:

сдвиг, запаздывание). Если ошибка измерения не

слишком большая, то сезонность можно определить

визуально, рассматривая поведение членов ряда

через каждые k временных единиц.

Автокорреляционная коррелограмма. Сезонные

составляющие временного ряда могут быть найдены

с помощью коррелограммы. Коррелограмма

(автокоррелограмма) показывает численно и

графически автокорреляционную функцию (AКФ),

иными словами коэффициенты автокорреляции (и их

стандартные ошибки) для последовательности

лагов из определенного диапазона (например, от 1

до 30). На коррелограмме обычно отмечается

диапазон в размере двух стандартных ошибок на

каждом лаге, однако обычно величина

автокорреляции более интересна, чем ее

надежность, потому что интерес в основном

представляют очень сильные (а, следовательно,

высоко значимые) автокорреляции (см. Элементарные

понятия статистики).

Исследование коррелограмм. При изучении

коррелограмм следует помнить, что

автокорреляции последовательных лагов

формально зависимы между собой. Рассмотрим

следующий пример. Если первый член ряда тесно

связан со вторым, а второй с третьим, то первый

элемент должен также каким-то образом зависеть

от третьего и т.д. Это приводит к тому, что

периодическая зависимость может существенно

измениться после удаления автокорреляций

первого порядка, т.е. после взятия разности с

лагом 1).

Частные автокорреляции. Другой полезный

метод исследования периодичности состоит в

исследовании частной автокорреляционной

функции (ЧАКФ), представляющей собой

углубление понятия обычной автокорреляционной

функции. В ЧАКФ устраняется зависимость между

промежуточными наблюдениями (наблюдениями внутри

лага). Другими словами, частная автокорреляция на

данном лаге аналогична обычной автокорреляции,

за исключением того, что при вычислении из нее

удаляется влияние автокорреляций с меньшими

лагами (см. Бокс и Дженкинс, 1976; см. также McDowall,

McCleary, Meidinger, and Hay, 1980). На лаге 1 (когда нет

промежуточных элементов внутри лага), частная

автокорреляция равна, очевидно, обычной

автокорреляции. На самом деле, частная

автокорреляция дает более «чистую» картину

периодических зависимостей.

Удаление периодической зависимости. Как

отмечалось выше, периодическая составляющая для

данного лага k может быть удалена взятием

разности соответствующего порядка. Это означает,

что из каждого i-го элемента ряда вычитается (i-k)-й

элемент. Имеются два довода в пользу таких

преобразований.

Во-первых, таким образом можно определить

скрытые периодические составляющие ряда.

Напомним, что автокорреляции на

последовательных лагах зависимы. Поэтому

удаление некоторых автокорреляций изменит

другие автокорреляции, которые, возможно,

подавляли их, и сделает некоторые другие

сезонные составляющие более заметными.

Во-вторых, удаление сезонных составляющих

делает ряд стационарным,

что необходимо для применения АРПСС

и других методов, например, спектрального

анализа.

АРПСС

- Общее введение

- Два основных процесса

- Модель АРПСС

- Идентификация

- Оценивание параметров

- Оценивание модели

Дополнительная информация о методах Анализа

временных рядов дана также в следующих

разделах:

- Идентификация модели

временных рядов - Прерванные временные ряды

- Экспоненциальное

сглаживание - Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Общее введение

Процедуры оценки параметров и прогнозирования,

описанные в разделе Идентификация

модели временных рядов, предполагают, что

математическая модель процесса известна. В

реальных данных часто нет отчетливо выраженных

регулярных составляющих. Отдельные наблюдения

содержат значительную ошибку, тогда как вы

хотите не только выделить регулярные компоненты,

но также построить прогноз. Методология АРПСС,

разработанная Боксом и Дженкинсом (1976), позволяет

это сделать. Данный метод чрезвычайно популярен

во многих приложениях, и практика подтвердила

его мощность и гибкость (Hoff, 1983; Pankratz, 1983; Vandaele, 1983).

Однако из-за мощности и гибкости, АРПСС — сложный

метод. Его не так просто использовать, и

требуется большая практика, чтобы овладеть им.

Хотя часто он дает удовлетворительные

результаты, они зависят от квалификации

пользователя (Bails and Peppers, 1982). Следующие разделы

познакомят вас с его основными идеями. Для

интересующихся кратким, рассчитанным на

применение, (нематематическим) введением в АРПСС,

рекомендуем книгу McCleary, Meidinger, and Hay (1980).

Два основных процесса

Процесс авторегрессии. Большинство

временных рядов содержат элементы, которые

последовательно зависят друг от друга. Такую

зависимость можно выразить следующим

уравнением:

xt =

+ 1*x(t-1) +

2*x(t-2) +

3*x(t-3) + … +

Здесь:

—

константа (свободный член),

1,

2,

3

— параметры авторегрессии.

Вы видите, что каждое наблюдение есть сумма

случайной компоненты (случайное воздействие, ) и линейной

комбинации предыдущих наблюдений.

Требование стационарности. Заметим, что

процесс авторегрессии будет стационарным

только, если его параметры лежат в определенном

диапазоне. Например, если имеется только один

параметр, то он должен находиться в интервале -1<<+1. В противном случае,

предыдущие значения будут накапливаться и

значения последующих xt могут быть

неограниченными, следовательно, ряд не будет стационарным.

Если имеется несколько параметров

авторегрессии, то можно определить аналогичные

условия, обеспечивающие стационарность (см.

например, Бокс и Дженкинс, 1976; Montgomery, 1990).

Процесс скользящего среднего. В отличие от

процесса авторегрессии, в процессе скользящего

среднего каждый элемент ряда подвержен

суммарному воздействию предыдущих ошибок. В

общем виде это можно записать следующим образом:

xt = µ + t —

1*

(t-1) —

2*

(t-2) —

3*

(t-3) — …

Здесь:

µ —

константа,

1,

2,

3 —

параметры скользящего среднего.

Другими словами, текущее наблюдение ряда

представляет собой сумму случайной компоненты

(случайное воздействие, ) в данный момент и линейной

комбинации случайных воздействий в предыдущие

моменты времени.

Обратимость. Не вдаваясь в детали, отметим,

что существует «двойственность» между

процессами скользящего среднего и авторегрессии

(см. например, Бокс и Дженкинс, 1976; Montgomery, Johnson, and

Gardiner, 1990). Это означает, что приведенное выше

уравнение скользящего среднего можно переписать

(обратить) в виде уравнения авторегрессии

(неограниченного порядка), и наоборот. Это так

называемое свойство обратимости. Имеются

условия, аналогичные приведенным выше условиям стационарности,

обеспечивающие обратимость модели.

Модель АРПСС

Модель авторегрессии и скользящего среднего. Общая

модель, предложенная Боксом и Дженкинсом (1976)

включает как параметры авторегрессии, так и

параметры скользящего среднего. Именно, имеется

три типа параметров модели: параметры

авторегрессии (p), порядок разности (d), параметры

скользящего среднего (q). В обозначениях Бокса

и Дженкинса модель записывается как АРПСС (p, d, q).

Например, модель (0, 1, 2) содержит 0

(нуль) параметров авторегрессии (p) и 2

параметра скользящего среднего (q), которые

вычисляются для ряда после взятия разности с

лагом 1.

Идентификация. Как отмечено ранее, для

модели АРПСС необходимо, чтобы ряд был стационарным,

это означает, что его среднее постоянно, а

выборочные дисперсия и автокорреляция не

меняются во времени. Поэтому обычно необходимо

брать разности ряда до тех пор, пока он не станет

стационарным

(часто также применяют логарифмическое

преобразование для стабилизации дисперсии).

Число разностей, которые были взяты, чтобы

достичь стационарности, определяются параметром

d (см. предыдущий раздел). Для того чтобы

определить необходимый порядок разности, нужно

исследовать график ряда и автокоррелограмму.

Сильные изменения уровня (сильные скачки вверх

или вниз) обычно требуют взятия несезонной

разности первого порядка (лаг=1). Сильные

изменения наклона требуют взятия разности

второго порядка. Сезонная составляющая требует

взятия соответствующей сезонной разности (см.

ниже). Если имеется медленное убывание

выборочных коэффициентов автокорреляции в

зависимости от лага, обычно берут разность

первого порядка. Однако следует помнить, что для

некоторых временных рядов нужно брать разности

небольшого порядка или вовсе не брать их.

Заметим, что чрезмерное количество взятых

разностей приводит к менее стабильным оценкам

коэффициентов.

На этом этапе (который обычно называют идентификацией

порядка модели, см. ниже) вы также должны

решить, как много параметров авторегрессии (p)

и скользящего среднего (q) должно

присутствовать в эффективной и экономной модели

процесса. (Экономность модели означает, что в

ней имеется наименьшее число параметров и

наибольшее число степеней свободы среди всех

моделей, которые подгоняются к данным). На

практике очень редко бывает, что число

параметров p или q больше 2 (см. ниже более

полное обсуждение).

Оценивание и прогноз. Следующий, после

идентификации, шаг (Оценивание) состоит в

оценивании параметров модели (для чего

используются процедуры минимизации функции

потерь, см. ниже; более подробная информация о

процедурах минимизации дана в разделе Нелинейное оценивание).

Полученные оценки параметров используются на

последнем этапе (Прогноз) для того, чтобы

вычислить новые значения ряда и построить

доверительный интервал для прогноза. Процесс

оценивания проводится по преобразованным данным

(подвергнутым применению разностного оператора).

До построения прогноза нужно выполнить обратную

операцию (интегрировать данные). Таким

образом, прогноз методологии будет сравниваться

с соответствующими исходными данными. На

интегрирование данных указывает буква П в

общем названии модели (АРПСС = Авторегрессионное

Проинтегрированное Скользящее Среднее).

Константа в моделях АРПСС. Дополнительно

модели АРПСС могут содержать константу,

интерпретация которой зависит от подгоняемой

модели. Именно, если (1) в модели нет параметров

авторегрессии, то константа есть среднее значение ряда, если (2)

параметры авторегрессии имеются, то константа

представляет собой свободный член. Если бралась

разность ряда, то константа представляет собой

среднее или свободный член преобразованного

ряда. Например, если бралась первая разность

(разность первого порядка), а параметров

авторегрессии в модели нет, то константа

представляет собой среднее значение

преобразованного ряда и, следовательно, коэффициент

наклона линейного тренда исходного.

Идентификация

Число оцениваемых параметров. Конечно, до

того, как начать оценивание, вам необходимо

решить, какой тип модели будет подбираться к

данным, и какое количество параметров

присутствует в модели, иными словами, нужно

идентифицировать модель АРПСС. Основными

инструментами идентификации порядка модели

являются графики, автокорреляционная функция

(АКФ), частная автокорреляционная функция (ЧАКФ).

Это решение не является простым и требуется

основательно поэкспериментировать с

альтернативными моделями. Тем не менее,

большинство встречающихся на практике временных

рядов можно с достаточной степенью точности

аппроксимировать одной из 5 основных моделей (см.

ниже), которые можно идентифицировать по виду

автокорреляционной (АКФ) и частной

автокорреляционной функции (ЧАКФ). Ниже дается

список этих моделей, основанный на рекомендациях

Pankratz (1983); дополнительные практические советы

даны в Hoff (1983), McCleary and Hay (1980), McDowall, McCleary, Meidinger, and Hay

(1980), and Vandaele (1983). Отметим, что число параметров

каждого вида невелико (меньше 2), поэтому нетрудно

проверить альтернативные модели.

- Один параметр (p): АКФ — экспоненциально

убывает; ЧАКФ — имеет резко выделяющееся значение

для лага 1, нет корреляций на других лагах. - Два параметра авторегрессии (p): АКФ имеет

форму синусоиды или экспоненциально убывает;

ЧАКФ имеет резко выделяющиеся значения на лагах 1,

2, нет корреляций на других лагах. - Один параметр скользящего среднего (q): АКФ

имеет резко выделяющееся значение на лаге 1,

нет корреляций на других лагах. ЧАКФ

экспоненциально убывает. - Два параметра скользящего среднего (q): АКФ

имеет резко выделяющиеся значения на лагах 1, 2,

нет корреляций на других лагах. ЧАКФ имеет форму

синусоиды или экспоненциально убывает. - Один параметр авторегрессии (p) и один параметр

скользящего среднего (q): АКФ экспоненциально

убывает с лага 1; ЧАКФ — экспоненциально

убывает с лага 1.

Сезонные модели. Мультипликативная сезонная

АРПСС представляет естественное развитие и

обобщение обычной модели АРПСС на ряды, в которых

имеется периодическая сезонная компонента. В

дополнении к несезонным параметрам, в модель

вводятся сезонные параметры для определенного

лага (устанавливаемого на этапе идентификации

порядка модели). Аналогично параметрам простой

модели АРПСС, эти параметры называются: сезонная

авторегрессия (ps), сезонная разность (ds) и

сезонное скользящее среднее (qs). Таким

образом, полная сезонная АРПСС может быть

записана как АРПСС (p,d,q)(ps,ds,qs).

Например, модель (0,1,2)(0,1,1) включает 0

регулярных параметров авторегрессии, 2

регулярных параметра скользящего среднего и 1

параметр сезонного скользящего среднего. Эти

параметры вычисляются для рядов, получаемых

после взятия одной разности с лагом 1 и далее

сезонной разности. Сезонный лаг, используемый

для сезонных параметров, определяется на этапе

идентификации порядка модели.

Общие рекомендации относительно выбора

обычных параметров (с помощью АКФ и ЧАКФ)

полностью применимы к сезонным моделям. Основное

отличие состоит в том, что в сезонных рядах АКФ и

ЧАКФ имеют существенные значения на лагах,

кратных сезонному лагу (в дополнении к

характерному поведению этих функций,

описывающих регулярную (несезонную) компоненту

АРПСС).

Оценивание параметров

Существуют различные методы оценивания

параметров, которые дают очень похожие оценки, но

для данной модели одни оценки могут быть более

эффективны, а другие менее эффективны. В общем, во

время оценивания порядка модели используется

так называемый квазиньютоновский алгоритм

максимизации правдоподобия (вероятности)

наблюдения значений ряда по значениям

параметров (см. Нелинейное

оценивание). Практически это требует

вычисления (условных) сумм квадратов (SS)

остатков модели. Имеются различные способы

вычисления суммы квадратов остатков SS; вы

можете выбрать: (1) приближенный метод

максимального правдоподобия МакЛеода и Сейлза

(1983), (2) приближенный метод максимального

правдоподобия с итерациями назад, (3)точный метод

максимального правдоподобия по Meларду (1984).

Сравнение методов. В общем, все методы дают

очень похожие результаты. Также все методы

показали примерно одинаковую эффективность на

реальных данных. Однако метод 1 (см. выше) —

самый быстрый, и им можно пользоваться для

исследования очень длинных рядов (например,

содержащих более 30,000 наблюдений). Метод Меларда

(номер 3) может оказаться неэффективным, если

оцениваются параметры сезонной модели с большим

сезонным лагом (например, 365 дней). С другой

стороны, вы можете использовать вначале

приближенный метод максимального правдоподобия

(для того, чтобы найти прикидочные оценки

параметров), а затем точный метод; обычно

требуется только несколько итераций точного

метода (номер 3, выше), чтобы получить

окончательные оценки.

Стандартные ошибки оценок. Для всех оценок

параметров вычисляются так называемые асимптотические

стандартные ошибки, для вычисления которых

используется матрица частных производных

второго порядка, аппроксимируемая конечными

разностями (см. также раздел Нелинейное

оценивание).

Штраф. Процедура оценивания минимизирует

(условную) сумму квадратов остатков модели. Если

модель не является адекватной, может случиться

так, что оценки параметров на каком-то шаге

станут неприемлемыми — очень большими (например,

не удовлетворяют условию стационарности). В

таком случае, SS будет приписано очень большое

значение (штрафное значение). Обычно это

«заставляет» итерационный процесс удалить

параметры из недопустимой области. Однако в

некоторых случаях и эта стратегия может

оказаться неудачной, и вы все равно увидите на

экране (во время процедуры оценивания) очень

большие значения SS на серии итераций. В таких

случаях следует с осторожностью оценивать

пригодность модели. Если модель содержит много

параметров и, возможно, имеется интервенция (см.

ниже), то следует несколько раз испытать процесс

оценивания с различными начальными. Если модель

содержит много параметров и, возможно,

интервенцию (см. ниже), вам следует повторить

процедуру с различными начальными значениями

параметров.

Оценивание модели

Оценки параметров. Если значения

вычисляемой t статистики не значимы,

соответствующие параметры в большинстве случаев

удаляются из модели без ущерба подгонки.

Другой критерий качества. Другой обычной

мерой надежности модели является сравнение

прогноза, построенного по урезанному ряду с

«известными (исходными) данными».

Однако качественная модель должна не только

давать достаточно точный прогноз, но быть

экономной и иметь независимые остатки,

содержащие только шум без систематических

компонент (в частности, АКФ остатков не должна

иметь какой-либо периодичности). Поэтому

необходим всесторонний анализ остатков. Хорошей

проверкой модели являются: (a) график остатков и

изучение их трендов, (b) проверка АКФ остатков (на

графике АКФ обычно отчетливо видна

периодичность).

Анализ остатков. Если остатки

систематически распределены (например,

отрицательны в первой части ряда и примерно

равны нуля во второй) или включают некоторую

периодическую компоненту, то это

свидетельствует о неадекватности модели. Анализ

остатков чрезвычайно важен и необходим при

анализе временных рядов. Процедура оценивания

предполагает, что остатки не коррелированы и

нормально распределены.

Ограничения. Следует напомнить, что модель

АРПСС является подходящей только для рядов,

которые являются стационарными

(среднее, дисперсия и автокорреляция примерно

постоянны во времени); для нестационарных рядов

следует брать разности. Рекомендуется иметь, как

минимум, 50 наблюдений в файле исходных данных.

Также предполагается, что параметры модели

постоянны, т.е. не меняются во времени.

Прерванные временные ряды

Обычный вопрос, возникающий при анализе

временных рядов, состоит в следующем,

воздействует или нет внешнее событие на

последовательность наблюдений. Например,

привела ли новая экономическая политика к росту

экономики, как обещалось; изменил ли новый закон

интенсивность преступлений и т.д. В общем, нужно

оценивать воздействия одного или нескольких

дискретных событий на значения ряда. Этот вид

анализа прерванных временных рядов подробно

описан в книге McDowall, McCleary, Meidinger, and Hay (1980).

Различают следующие три типа воздействий: (1)

устойчивое скачкообразное, (2) устойчивое

постепенное, (3) скачкообразное временное. См.

также следующие разделы:

- Идентификация модели

временных рядов - АРПСС

- Экспоненциальное

сглаживание - Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Экспоненциальное сглаживание

- Общее введение

- Простое экспоненциальное

сглаживание - Выбор лучшего значения

параметра a (альфа) - Индексы качества подгонки

- Сезонная и несезонная модели

с трендом или без тренда

См. также:

- Идентификация модели

временных рядов - АРПСС (Бокс и Дженкинс) и

автокорреляции - Прерванные временные ряды

- Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Общее введение

Экспоненциальное сглаживание — это очень

популярный метод прогнозирования многих

временных рядов. Исторически метод был

независимо открыт Броуном и Холтом. Броун служил

на флоте США во время второй мировой войны, где

занимался обнаружением подводных лодок и

системами наведения. Позже он применил открытый

им метод для прогнозирования спроса на запасные

части. Свои идеи он описал в книге, вышедшей в

свет в 1959 году. Исследования Холта были

поддержаны Департаментом военно-морского флота

США. Независимо друг от друга, Броун и Холт

открыли экспоненциальное сглаживание для

процессов с постоянным трендом, с линейным

трендом и для рядов с сезонной составляющей.

Gardner (1985), предложил «единую» классификацию

методов экспоненциального сглаживания.

Превосходное введение в эти методы можно найти в

книгах Makridakis, Wheelwright, and McGee (1983), Makridakis and Wheelwright (1989),

Montgomery, Johnson, and Gardiner (1990).

Простое экспоненциальное

сглаживание

Простая и прагматически ясная модель

временного ряда имеет следующий вид: Xt = b + t, где b —

константа и

(эпсилон) — случайная ошибка. Константа b относительно

стабильна на каждом временном интервале, но

может также медленно изменяться со временем.

Один из интуитивно ясных способов выделения b

состоит в том, чтобы использовать сглаживание

скользящим средним, в котором последним

наблюдениям приписываются большие веса, чем

предпоследним, предпоследним большие веса, чем

пред-предпоследним и т.д. Простое

экспоненциальное именно так и устроено. Здесь

более старым наблюдениям приписываются

экспоненциально убывающие веса, при этом, в

отличие от скользящего среднего, учитываются все

предшествующие наблюдения ряда, а не те, что

попали в определенное окно. Точная формула

простого экспоненциального сглаживания имеет

следующий вид:

St = *Xt + (1-

)*St-1

Когда эта формула применяется рекурсивно, то

каждое новое сглаженное значение (которое

является также прогнозом) вычисляется как

взвешенное среднее текущего наблюдения и

сглаженного ряда. Очевидно, результат

сглаживания зависит от параметра (альфа). Если

равно 1, то

предыдущие наблюдения полностью игнорируются.

Если равно 0, то

игнорируются текущие наблюдения. Значения между 0, 1 дают

промежуточные результаты.

Эмпирические исследования Makridakis и др. (1982;

Makridakis, 1983) показали, что весьма часто простое

экспоненциальное сглаживание дает достаточно

точный прогноз.

Выбор лучшего значения

параметра (альфа)

Gardner (1985) обсуждает различные теоретические и

эмпирические аргументы в пользу выбора

определенного параметра сглаживания. Очевидно,

из формулы, приведенной выше, следует, что должно попадать в интервал между 0

(нулем) и 1 (хотя Brenner et al., 1968, для дальнейшего

применения анализа АРПСС считают, что 0<<2). Gardner (1985)

сообщает, что на практике обычно рекомендуется

брать меньше .30.

Однако в исследовании Makridakis et al., (1982), большее .30, часто

дает лучший прогноз. После обзора литературы,

Gardner (1985) приходит к выводу, что лучше оценивать

оптимально по данным

(см. ниже), чем просто «гадать» или

использовать искусственные рекомендации.

Оценивание лучшего значения с помощью данных. На

практике параметр сглаживания часто ищется с поиском

на сетке. Возможные значения параметра

разбиваются сеткой с определенным шагом.

Например, рассматривается сетка значений от = 0.1 до

= 0.9, с шагом 0.1.

Затем выбирается ,

для которого сумма квадратов (или средних

квадратов) остатков (наблюдаемые значения минус

прогнозы на шаг вперед) является минимальной.

Индексы качества подгонки

Самый прямой способ оценки прогноза,

полученного на основе определенного значения — построить график

наблюдаемых значений и прогнозов на один шаг

вперед. Этот график включает в себя также остатки

(отложенные на правой оси Y). Из графика ясно

видно, на каких участках прогноз лучше или хуже.

Такая визуальная проверка точности прогноза

часто дает наилучшие результаты. Имеются также

другие меры ошибки, которые можно использовать

для определения оптимального параметра (см. Makridakis, Wheelwright, and McGee,

1983):

Средняя ошибка. Средняя ошибка (СО)

вычисляется простым усреднением ошибок на

каждом шаге. Очевидным недостатком этой меры

является то, что положительные и отрицательные

ошибки аннулируют друг друга, поэтому она не

является хорошим индикатором качества прогноза.

Средняя абсолютная ошибка. Средняя

абсолютная ошибка (САО) вычисляется как среднее абсолютных

ошибок. Если она равна 0 (нулю), то имеем

совершенную подгонку (прогноз). В сравнении со

средней квадратической ошибкой, эта мера

«не придает слишком большого значения»

выбросам.

Сумма квадратов ошибок (SSE),

среднеквадратическая ошибка. Эти величины

вычисляются как сумма (или среднее) квадратов

ошибок. Это наиболее часто используемые индексы

качества подгонки.

Относительная ошибка (ОО). Во всех

предыдущих мерах использовались действительные

значения ошибок. Представляется естественным

выразить индексы качества подгонки в терминах относительных

ошибок. Например, при прогнозе месячных продаж,

которые могут сильно флуктуировать (например, по

сезонам) из месяца в месяц, вы можете быть вполне

удовлетворены прогнозом, если он имеет точность

?10%. Иными словами, при прогнозировании

абсолютная ошибка может быть не так интересна

как относительная. Чтобы учесть относительную

ошибку, было предложено несколько различных

индексов (см. Makridakis, Wheelwright, and McGee, 1983). В первом

относительная ошибка вычисляется как:

ООt = 100*(Xt — Ft )/Xt

где Xt — наблюдаемое

значение в момент времени t, и Ft — прогноз (сглаженное

значение).

Средняя относительная ошибка (СОО).

Это значение вычисляется как среднее

относительных ошибок.

Средняя абсолютная относительная ошибка

(САОО). Как и в случае с обычной средней

ошибкой отрицательные и положительные

относительные ошибки будут подавлять друг друга.

Поэтому для оценки качества подгонки в целом (для

всего ряда) лучше использовать среднюю абсолютную

относительную ошибку. Часто эта мера более

выразительная, чем среднеквадратическая ошибка.

Например, знание того, что точность прогноза ±5%,

полезно само по себе, в то время как значение 30.8

для средней квадратической ошибки не может быть

так просто проинтерпретировано.

Автоматический поиск лучшего параметра.

Для минимизации средней квадратической ошибки,

средней абсолютной ошибки или средней

абсолютной относительной ошибки используется

квази-ньютоновская процедура (та же, что и в АРПСС). В большинстве случаев

эта процедура более эффективна, чем обычный

перебор на сетке (особенно, если параметров

сглаживания несколько), и оптимальное значение можно быстро

найти.

Первое сглаженное значение S0.

Если вы взгляните снова на формулу простого

экспоненциального сглаживания, то увидите, что

следует иметь значение S0 для

вычисления первого сглаженного значения

(прогноза). В зависимости от выбора параметра (в частности, если

близко к 0), начальное

значение сглаженного процесса может оказать

существенное воздействие на прогноз для многих

последующих наблюдений. Как и в других

рекомендациях по применению экспоненциального

сглаживания, рекомендуется брать начальное

значение, дающее наилучший прогноз. С другой

стороны, влияние выбора уменьшается с длиной

ряда и становится некритичным при большом числе

наблюдений.

Сезонная и несезонная модели с

трендом или без тренда

В дополнение к простому экспоненциальному

сглаживанию, были предложены более сложные

модели, включающие сезонную компоненту и

трендом. Общая идея таких моделей состоит в том,

что прогнозы вычисляются не только по предыдущим

наблюдениям (как в простом экспоненциальном

сглаживании), но и с некоторыми задержками, что

позволяет независимо оценить тренд и сезонную

составляющую. Gardner (1985) обсудил различные модели в

терминах сезонности (отсутствует, аддитивная

сезонность, мультипликативная) и тренда

(отсутствует, линейный тренд, экспоненциальный,

демпфированный).

Аддитивная и мультипликативная

сезонность. Многие временные ряды имеют

сезонные компоненты. Например, продажи игрушек

имеют пики в ноябре, декабре и, возможно, летом,

когда дети находятся на отдыхе. Эта

периодичность имеет место каждый год. Однако

относительный размер продаж может слегка

изменяться из года в год. Таким образом, имеет

смысл независимо экспоненциально сгладить

сезонную компоненту с дополнительным

параметром, обычно обозначаемым как (дельта). Сезонные

компоненты, по природе своей, могут быть

аддитивными или мультипликативными. Например, в

течение декабря продажи определенного вида

игрушек увеличиваются на 1 миллион долларов

каждый год. Для того чтобы учесть сезонное

колебание, вы можете добавить в прогноз на каждый

декабрь 1 миллион долларов (сверх

соответствующего годового среднего). В этом

случае сезонность — аддитивная. Альтернативно,

пусть в декабре продажи увеличились на 40%, т.е. в 1.4

раза. Тогда, если общие продажи малы, то

абсолютное (в долларах) увеличение продаж в

декабре тоже относительно мало (процент роста

константа). Если в целом продажи большие, то

абсолютное (в долларах) увеличение продаж будет

пропорционально больше. Снова, в этом случае

продажи увеличатся в определенное число раз, и

сезонность будет мультипликативной (в данном

случае мультипликативная сезонная составляющая

была бы равна 1.4). На графике различие между двумя

видами сезонности состоит в том, что в аддитивной

модели сезонные флуктуации не зависят от

значений ряда, тогда как в мультипликативной

модели величина сезонных флуктуаций зависит от

значений временного ряда.

Параметр сезонного сглаживания . В общем, прогноз

на один шаг вперед вычисляется следующим образом

(для моделей без тренда; для моделей с линейным и

экспоненциальным трендом, тренд добавляется; см.

ниже):

Аддитивная модель:

Прогнозt = St + It-p

Мультипликативная модель:

Прогнозt = St*It-p

В этой формуле St

обозначает (простое) экспоненциально сглаженное

значение ряда в момент t, и It-p обозначает сглаженный

сезонный фактор в момент t

минус p (p —

длина сезона). Таким образом, в сравнении с

простым экспоненциальным сглаживанием, прогноз

«улучшается» добавлением или умножением

сезонной компоненты. Эта компонента оценивается

независимо с помощью простого экспоненциального

сглаживания следующим образом:

Аддитивная модель:

It = It-p + *(1-

)*et

Мультипликативная модель:

It = It-p + *(1-

)*et/St

Обратите внимание, что предсказанная сезонная

компонента в момент t

вычисляется, как соответствующая компонента на

последнем сезонном цикле плюс ошибка (et,

наблюдаемое минус прогнозируемое значение в

момент t). Ясно, что параметр принимает значения

между 0 и 1. Если он равен нулю, то сезонная

составляющая на следующем цикле та же, что и на

предыдущем. Если

равен 1, то сезонная составляющая

«максимально» меняется на каждом шаге из-за

соответствующей ошибки (множитель (1-) не

рассматривается из-за краткости введения). В

большинстве случаев, когда сезонность

присутствует, оптимальное значение лежит между 0 и 1.

Линейный, экспоненциальный,

демпфированный тренд. Возвращаясь к примеру

с игрушками, мы можем увидеть наличие линейного

тренда (например, каждый год продажи

увеличивались на 1 миллион), экспоненциального

(например, каждый год продажи возрастают в 1.3

раза) или демпфированного тренда (в первом году

продажи возросли на 1 миллион долларов; во втором

увеличение составило только 80% по сравнению с

предыдущим, т.е. на $800,000; в следующем году вновь

увеличение было только на 80%, т.е. на $800,000 * .8 = $640,000

и т.д.). Каждый тип тренда по-своему проявляется в

данных. В целом изменение тренда — медленное в

течение времени, и опять (как и сезонную

компоненту) имеет смысл экспоненциально

сгладить его с отдельным параметром

[обозначаемым (гамма)

— для линейного и экспоненциального тренда, (фи) — для

демпфированного тренда].

Параметры сглаживания (линейный и экспоненциальный тренд) и

(демпфированный тренд). Аналогично

сезонной компоненте компонента тренда

включается в процесс экспоненциального

сглаживания. Сглаживание ее производится в

каждый момент времени независимо от других

компонент с соответствующими параметрами. Если равно 0, то тренд

постоянен для всех значений временного ряда (и

для всех прогнозов). Если равно 1, то тренд «максимально»

определяется ошибками наблюдений. Параметр учитывает, как сильно

изменяется тренд, т.е. как быстро он

«демпфируется» или, наоборот, возрастает.

Сезонная декомпозиция (метод Census I)

- Общее введение

- Вычисления

См. также:

- Идентификация модели

временных рядов - АРПСС (Бокс и Дженкинс) и

автокорреляции - Прерванные временные ряды

- Экспоненциальное

сглаживание - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Общее введение

Предположим, что у вас имеются ежемесячные

данные о пассажиропотоке на международных

авиалиниях за 12 лет (см. Бокс и Дженкинс, 1976). Если

изобразить эти данные на графике, то будет хорошо

видно, что (1) объем пассажиропотока имеет во

времени возрастающий линейный тренд, и (2) в ряде

имеется ежегодно повторяющаяся закономерность — сезонность

(большинство перевозок приходится на летние

месяцы, кроме того, имеется пик меньшей высоты в

районе декабрьских каникул). Цель сезонной

декомпозиции и корректировки как раз и состоит в

том, чтобы отделить эти компоненты, то есть

разложить ряд на составляющую тренда, сезонную

компоненту и оставшуюся нерегулярную

составляющую. «Классический» прием,

позволяющий выполнить такую декомпозицию,

известен как метод Census I. Этот метод

описывается и обсуждается в работах Makridakis,

Wheelwright, and McGee (1983) и Makridakis and Wheelwright (1989).

Общая модель. Основная идея сезонной

декомпозиции проста. В общем случае временной

ряд типа того, который описан выше, можно

представить себе состоящим из четырех различных

компонент: (1) сезонной компоненты (обозначается St,

где t обозначает момент времени), (2) тренда (Tt),

(3) циклической компоненты (Ct) и (4)

случайной, нерегулярной компоненты или

флуктуации (It). Разница между

циклической и сезонной компонентой состоит в

том, что последняя имеет регулярную (сезонную)

периодичность, тогда как циклические факторы

обычно имеют более длительный эффект, который к

тому же меняется от цикла к циклу. В методе Census I

тренд и циклическую компоненту обычно

объединяют в одну тренд-циклическую компоненту

(TCt). Конкретные функциональные

взаимосвязи между этими компонентами могут

иметь самый разный вид. Однако, можно выделить

два основных способа, с помощью которых они могут

взаимодействовать: аддитивно и мультипликативно:

Аддитивная модель:

Xt = TCt + St + It

Мультипликативная модель:

Xt = Tt*Ct*St*It

Здесь Xt обозначает

значение временного ряда в момент времени t. Если имеются какие-то априорные сведения

о циклических факторах, влияющих на ряд

(например, циклы деловой конъюнктуры), то можно

использовать оценки для различных компонент для

составления прогноза будущих значений ряда.

(Однако для прогнозирования предпочтительнее экспоненциальное

сглаживание, позволяющее учитывать сезонную

составляющую и тренд.)

Аддитивная и мультипликативная

сезонность. Рассмотрим на примере различие

между аддитивной и мультипликативной сезонными

компонентами. График объема продаж детских

игрушек, вероятно, будет иметь ежегодный пик в

ноябре-декабре, и другой — существенно меньший по

высоте — в летние месяцы, приходящийся на

каникулы. Такая сезонная закономерность будет

повторяться каждый год. По своей природе

сезонная компонента может быть аддитивной или

мультипликативной. Так, например, каждый год

объем продаж некоторой конкретной игрушки может

увеличиваться в декабре на 3 миллиона долларов.

Поэтому вы можете учесть эти сезонные изменения, прибавляя

к своему прогнозу на декабрь 3 миллиона. Здесь

мы имеем аддитивную сезонность. Может

получиться иначе. В декабре объем продаж

некоторой игрушки может увеличиваться на 40%, то

есть умножаться на множитель 1.4. Это значит,

например, что если средний объем продаж этой

игрушки невелик, то абсолютное (в денежном

выражении) увеличение этого объема в декабре

также будет относительно небольшим (но в

процентном исчислении оно будет постоянным);

если же игрушка продается хорошо, то и абсолютный

(в долларах) рост объема продаж будет

значительным. Здесь опять, объем продаж

возрастает в число раз, равное определенному множителю,

а сезонная компонента, по своей природе,

мультипликативная компонента (в данном случае

равная 1.4). Если перейти к графикам временных

рядов, то различие между этими двумя видами

сезонности будет проявляться так: в аддитивном

случае ряд будет иметь постоянные сезонные

колебания, величина которых не зависит от общего

уровня значений ряда; в мультипликативном случае

величина сезонных колебаний будет меняться в

зависимости от общего уровня значений ряда.

Аддитивный и мультипликативный тренд-цикл. Рассмотренный

пример можно расширить, чтобы проиллюстрировать

понятия аддитивной и мультипликативной

тренд-циклических компонент. В случае с

игрушками, тренд «моды» может привести к

устойчивому росту продаж (например, это может

быть общий тренд в сторону игрушек

образовательной направленности). Как и сезонная

компонента, этот тренд может быть по своей

природе аддитивным (продажи ежегодно

увеличиваются на 3 миллиона долларов) или

мультипликативным (продажи ежегодно

увеличиваются на 30%, или возрастают в 1.3 раза).

Кроме того, объем продаж может содержать

циклические компоненты. Повторим еще раз, что

циклическая компонента отличается от сезонной

тем, что она обычно имеет большую временную

протяженность и проявляется через неравные

промежутки времени. Так, например, некоторая

игрушка может быть особенно «горячей» в

течение летнего сезона (например, кукла,

изображающая персонаж популярного мультфильма,

которая к тому же агрессивно рекламируется). Как

и в предыдущих случаях, такая циклическая

компонента может изменять объем продаж

аддитивно, либо мультипликативно.

Вычисления

В вычислительном отношении процедура метода Сезонной

декомпозиции (Census I) следует стандартным

формулам, см. Makridakis, Wheelwright, and McGee (1983) или Makridakis and

Wheelwright (1989).

Скользящее среднее. Сначала

вычисляется скользящее среднее для временного

ряда, при этом ширина окна берется равной периоду

сезонности. Если период сезонности — четное

число, пользователь может выбрать одну из двух

возможностей: брать скользящее среднее с

одинаковыми весами или же с неравными весами так,

что первое и последнее наблюдения в окне имеют

усредненные веса.

Отношения или разности. После взятия

скользящих средних вся сезонная (т.е. внутри

сезона) изменчивость будет исключена, и поэтому

разность (в случае аддитивной модели) или

отношение (для мультипликативной модели) между

наблюдаемым и сглаженным рядом будет выделять

сезонную составляющую (плюс нерегулярную

компоненту). Более точно, ряд скользящих средних

вычитается из наблюдаемого ряда (в аддитивной

модели) или же значения наблюдаемого ряда

делятся на значения скользящих средних (в

мультипликативной модели).

Сезонная составляющая. На следующем

шаге вычисляется сезонная составляющая, как

среднее (для аддитивных моделей) или урезанное

среднее (для мультипликативных моделей) всех

значений ряда, соответствующих данной точке

сезонного интервала.

Сезонная корректировка ряда. Исходный

ряд можно скорректировать, вычитая из него

(аддитивная модель) или деля его значения на

(мультипликативная модель) значения сезонной

составляющей.

Получающийся в результате ряд называется

сезонной корректировкой ряда (из ряда убрана

сезонная составляющая)..

Тренд-циклическая компонента.

Напомним, что циклическая компонента отличается

от сезонной компоненты тем, что

продолжительность цикла, как правило, больше, чем

один сезонный период, и разные циклы могут иметь

разную продолжительность. Приближение для

объединенной тренд-циклической компоненты можно

получить, применяя к ряду с сезонной поправкой

процедуру 5-точечного (центрированного)

взвешенного скользящего среднего с весами 1, 2, 3, 2,

1.

Случайная или нерегулярная компонента.

На последнем шаге выделяется случайная или

нерегулярная компонента (погрешность) путем

вычитания из ряда с сезонной поправкой

(аддитивная модель) или делением этого ряда

(мультипликативная модель) на тренд-циклическую

компоненту.

Сезонная корректировка X-11 (метод Census II)

Общие идеи, лежащие в основе сезонной

декомпозиции и корректировки, изложены в

разделе, посвященном методу сезонной

корректировки Census I (см. Сезонная

декомпозиция (метод Census I)). Метод Census II (2)

является развитием и уточнением обычного метода

корректировки. На протяжении многих лет

различные варианты метода Census II развивались в

Бюро Переписи США (US Census Bureau); один из вариантов

этого метода, получивший широкую известность и

наиболее часто применяемый в государственных

органах и сфере бизнеса, называется «вариант X-11

метода Census II» (см. Shiskin, Young, and Musgrave, 1967).

Впоследствии этот усовершенствованный вариант

метода Census II стал называться просто X-11.

Помимо документации, которую можно получить из

Census Bureau, подробное описание метода дано в работах

Makridakis, Wheelwright and McGee (1983), Makridakis and Wheelwright (1989).

За дополнительной информацией обратитесь к

следующим разделам:

- Сезонная корректировка:

основные идеи и термины - Метод Census II

- Таблицы результатов

корректировки X-11 - Подробное описание всех

таблиц результатов, вычисляемых в методе X-11

За дальнейшей информацией обратитесь к Анализу временных рядов и

следующим разделам:

- Идентификация модели

временных рядов - АРПСС (Бокс и Дженкинс) и

автокорреляции - Прерванные временные ряды

- Экспоненциальное

сглаживание - Сезонная декомпозиция (метод

Census I) - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Сезонная корректировка: основные идеи и

термины

Предположим, что у вас имеются ежемесячные

данные о пассажиропотоке на международных

авиалиниях за 12 лет (см. Бокс и Дженкинс, 1976). Если

изобразить эти данные на графике, то будет хорошо

видно, что (1) объем пассажиропотока имеет во

времени возрастающий линейный тренд, и что (2) в

ряде имеется ежегодно повторяющаяся

закономерность — сезонность (большинство

перевозок приходится на летние месяцы, кроме

того, имеется пик меньшей высоты в районе

декабрьских каникул). Цель сезонной декомпозиции

и корректировки как раз и состоит в том, чтобы

отделить эти компоненты, то есть разложить ряд на

составляющую тренда, сезонную компоненту и

оставшуюся нерегулярную составляющую.

«Классический» прием, позволяющий выполнить

такую декомпозицию, известен как метод Census I

(см. раздел Census I). Этот метод

описывается и обсуждается в работах Makridakis,

Wheelwright, and McGee (1983) и Makridakis and Wheelwright (1989).

Общая модель. Основная идея сезонной

декомпозиции проста. В общем случае временной

ряд типа того, который описан выше, можно

представить себе состоящим из четырех различных

компонент: (1) сезонной компоненты (обозначается St,

где t обозначает момент времени), (2) тренда (Tt),

(3) циклической компоненты (Ct) и (4)

случайной, нерегулярной компоненты или

флуктуации (It). Разница между

циклической и сезонной компонентой состоит в

том, что последняя имеет регулярную (сезонную)

периодичность, тогда как циклические факторы

обычно имеют более длительный эффект, который к

тому же меняется от цикла к циклу. В методе Census I

тренд и циклическую компоненту обычно

объединяют в одну тренд-циклическую компоненту

(TCt). Конкретные функциональные

взаимосвязи между этими компонентами могут

иметь самый разный вид. Однако, можно выделить

два основных способа, с помощью которых они могут

взаимодействовать: аддитивно и мультипликативно:

Аддитивная модель:

Xt = TCt + St + It

Мультипликативная модель:

Xt = Tt*Ct*St*It

Здесь Xt обозначает

значение временного ряда в момент времени t.

Если имеются какие-то априорные сведения о

циклических факторах, влияющих на ряд (например,

циклы деловой конъюнктуры), то можно

использовать оценки для различных компонент для

составления прогноза будущих значений ряда.

(Однако для прогнозирования предпочтительнее экспоненциальное

сглаживание, позволяющее учитывать сезонную

составляющую и тренд.)

Аддитивная и мультипликативная

сезонность. Рассмотрим на примере различие

между аддитивной и мультипликативной сезонными

компонентами. График объема продаж детских

игрушек, вероятно, будет иметь ежегодный пик в

ноябре-декабре, и другой — существенно меньший по

высоте — в летние месяцы, приходящийся на

каникулы. Такая сезонная закономерность будет

повторяться каждый год. По своей природе

сезонная компонента может быть аддитивной или

мультипликативной. Так, например, каждый год

объем продаж некоторой конкретной игрушки может

увеличиваться в декабре на 3 миллиона долларов.

Поэтому вы можете учесть эти сезонные изменения, прибавляя

к своему прогнозу на декабрь 3 миллиона. Здесь

мы имеем аддитивную сезонность. Может

получиться иначе. В декабре объем продаж

некоторой игрушки может увеличиваться на 40%, то

есть умножаться на множитель 1.4. Это значит,

например, что если средний объем продаж этой

игрушки невелик, то абсолютное (в денежном

выражении) увеличение этого объема в декабре

также будет относительно небольшим (но в

процентном исчислении оно будет постоянным);

если же игрушка продается хорошо, то и абсолютный

(в долларах) рост объема продаж будет

значительным. Здесь опять, объем продаж

возрастает в число раз, равное определенному множителю,

а сезонная компонента, по своей природе,

мультипликативная компонента (в данном случае

равная 1.4). Если перейти к графикам временных

рядов, то различие между этими двумя видами

сезонности будет проявляться так: в аддитивном

случае ряд будет иметь постоянные сезонные

колебания, величина которых не зависит от общего

уровня значений ряда; в мультипликативном случае

величина сезонных колебаний будет меняться в

зависимости от общего уровня значений ряда.

Аддитивный и мультипликативный тренд-цикл.

Рассмотренный пример можно расширить, чтобы

проиллюстрировать понятия аддитивной и

мультипликативной тренд-циклических компонент.

В случае с игрушками, тренд «моды» может

привести к устойчивому росту продаж (например,

это может быть общий тренд в сторону игрушек

образовательной направленности). Как и сезонная

компонента, этот тренд может быть по своей

природе аддитивным (продажи ежегодно

увеличиваются на 3 миллиона долларов) или

мультипликативным (продажи ежегодно

увеличиваются на 30%, или возрастают в 1.3 раза).

Кроме того, объем продаж может содержать

циклические компоненты. Повторим еще раз, что

циклическая компонента отличается от сезонной

тем, что она обычно имеет большую временную

протяженность и проявляется через неравные

промежутки времени. Так, например, некоторая

игрушка может быть особенно «горячей» в

течение летнего сезона (например, кукла,

изображающая персонаж популярного мультфильма,

которая к тому же агрессивно рекламируется). Как

и в предыдущих случаях, такая циклическая

компонента может изменять объем продаж

аддитивно, либо мультипликативно.

Метод Census II

Основной метод сезонной декомпозиции и

корректировки, рассмотренный в разделе Сезонная корректировка:

основные идеи и термины, может быть

усовершенствован различными способами. На самом

деле, в отличие от многих методов моделирования

временных рядов (в частности, АРПСС),

которые основаны на определенной теоретической

модели, вариант X-11 метода Census II представляет

собой просто результат многочисленных специально

разработанных приемов и усовершенствований,

которые доказали свою работоспособность в

многолетней практике решения реальных задач (см.

Burman, 1979, Kendall and Ord, 1990, Makridakis and Wheelwright, 1989; Wallis, 1974).

Некоторые из наиболее важных усовершенствований

перечислены ниже.

Поправка на число рабочих дней. В

месяцах разное число дней и разное число рабочих

дней. Если мы анализируем, например, цифры

ежемесячной выручки парка аттракционов, то

разница в числе суббот и воскресений (пиковые

дни) в разных месяцах существенным образом

скажется на различиях в ежемесячных показателях

дохода. Вариант X-11 метода Census II дает

пользователю возможность проверить,

присутствует ли во временном ряду этот эффект

числа рабочих дней, и если да, то внести

соответствующие поправки.

Выбросы. Большинство реальных

временных рядов содержит выбросы, то есть резко

выделяющиеся наблюдения, вызванные какими-то

исключительными событиями. Например, забастовка

персонала может сильно повлиять на месячные или

годовые показатели выпуска продукции фирмы.

Такие выбросы могут исказить оценки сезонной

компоненты и тренда. В процедуре X-11

предусмотрены корректировки на случай появления

выбросов, основанные на использовании

«принципов статистического контроля»:

значения, выходящие за определенный диапазон

(который определяется в терминах, кратных сигма,

т.е. стандартных отклонений), могут быть

преобразованы или вовсе пропущены, и только

после этого будут вычисляться окончательные

оценки параметров сезонности.

Последовательные уточнения.

Корректировки, связанные с наличием выбросов и

различным числом рабочих дней можно производить

многократно, чтобы последовательно получать для

компонент оценки все лучшего качества. В методе X-11

делается несколько последовательных уточнений

оценок для получения окончательных компонент

тренд-цикличности и сезонности, нерегулярной

составляющей, и самого временного ряда с

сезонными поправками.

Критерии и итоговые статистики. Помимо

оценки основных компонент ряда, можно вычислить

различные сводные статистики. Например, можно

сформировать таблицы дисперсионного анализа для

проверки значимости фактора сезонной

изменчивости и ряда и фактора рабочих дней (см.

выше), процедура метода X-11 вычисляет также

ежемесячные относительные изменения в случайной

и тренд-циклической компонентах. С увеличением

продолжительности временного промежутка,

измеряемого в месяцах или, в случае квартального

варианта метода X-11 — в кварталах года,

изменения в тренд-циклической компоненте, вообще

говоря, будут нарастать, в то время как изменения

случайной составляющей должны оставаться

примерно на одном уровне. Средняя длина

временного интервала, на котором изменения

тренд-циклической компоненты становятся

примерно равными изменениям случайной

компоненты, называется месяцем (кварталом)

циклического доминирования, или сокращенно

МЦД (соответственно КЦД). Например, если МЦД равно

двум, то на сроках более двух месяцев

тренд-циклическая компонента станет

доминировать над флуктуациями нерегулярной

(случайной) компоненты. Эти и другие результаты

более подробно будут обсуждаться далее.

Таблицы результатов

корректировки X-11

Вычисления, которые производятся в процедуре

X-11, лучше всего обсуждать в контексте

таблиц результатов, которые при этом выдаются.

Процедура корректировки разбивается на семь

этапов, которые обычно обозначаются буквами A

— G.

- Априорная корректировка (помесячная сезонная

корректировка). Перед тем, как к временному

ряду, содержащему ежемесячные значения, будет

применяться какая-либо сезонная корректировка,

могут быть произведены различные корректировки,

заданные пользователем. Можно ввести еще один

временной ряд, содержащий априорные

корректирующие факторы; значения этого ряда

будут вычитаться из исходного ряда (аддитивная

модель), или же значения исходного ряда будут

поделены на значения корректирующего ряда

(мультипликативная модель). В случае

мультипликативной модели пользователь может

также определить свои собственные поправочные

коэффициенты (веса) на число рабочих дней. Эти

веса будут использоваться для корректировки

ежемесячных наблюдений, так чтобы учитывалось

число рабочих дней в этом месяце. - Предварительное оценивание вариации числа

рабочих дней (месячный вариант X-11) и весов. На

следующем шаге вычисляются предварительные

поправочные коэффициенты на число рабочих дней

(только в месячном варианте X-11) и веса,

позволяющие уменьшить эффект выбросов. - Окончательное оценивание вариации числа

рабочих дней и нерегулярных весов (месячный

вариант X-11). Поправки и веса, вычисленные в

пункте B, используются для построения

улучшенных оценок тренд-циклической и сезонной

компонент. Эти улучшенные оценки используются

для окончательного вычисления факторов числа

рабочих дней (в месячном варианте X-11) и весов. - Окончательное оценивание сезонных факторов,

тренд-циклической, нерегулярной и сезонно

скорректированной компонент ряда. Окончательные

значения факторов рабочих дней и весов,

вычисленные в пункте C, используются для

вычисления окончательных оценок для компонент

ряда. - Модифицированные ряды: исходный, сезонно

скорректированный и нерегулярный. Исходный и

окончательный сезонно скорректированный ряды, а

также нерегулярная компонента модифицируются

путем сглаживания выбросов. Полученные в

результате этого, модифицированные ряды

позволяют пользователю проверить устойчивость

сезонной корректировки. - Месяц (квартал) циклического доминирования

(МЦД, КЦД), скользящее среднее и сводные

показатели. IНа этом этапе вычислений

рассчитываются различные сводные

характеристики (см. далее), позволяющие

пользователю исследовать относительную

важность разных компонент, среднюю флуктуацию от

месяца к месяцу (от квартала к кварталу), среднее

число идущих подряд изменений в одну сторону и

др. - Графики. Наконец, вы можете построить

различные графики итоговых результатов.

Например, можно построить окончательно

скорректированный ряд в хронологическом порядке

или по месяцам (см. ниже).

Подробное описание всех таблиц

результатов, вычисляемых в методе X-11

На каждом из этапов A — G (см. раздел Таблицы результатов

корректировки X-11) вычислялись различные

таблицы результатов. Обычно все они нумеруются, а

также им приписывается буква, соответствующая

этапу анализа. Например, таблица B 11 содержит

предварительно сезонно скорректированный ряд; C

11 — это более точно сезонно скорректированный

ряд, а D 11 — окончательный сезонно

скорректированный ряд. Далее приводится

перечень всех таблиц. Таблицы, помеченные

звездочкой (*), недоступны (или неприменимы) при

анализе квартальных показателей. Кроме того, в

случае квартальной корректировки некоторые из

описанных ниже вычислений несколько

видоизменяются. Так, например, для вычисления

сезонных факторов вместо 12-периодного (т.е.

12-месячного) скользящего среднего используется

4-периодное (4-квартальное) скользящее среднее;

предварительная тренд-циклическая компонента

вычисляется по центрированному 4-периодному

скользящему среднему, а окончательная оценка