Затем каждую из величин Σfxyax перемножаем на условные отклонения ряда у для данной строки (ay) и результаты записываем в графу 17. Суммируя полученные произведения, получаем величину Σ(Σfxyax)ay=417.

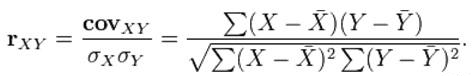

Теперь в нашем распоряжении имеются все необходимые величины для вычисления r по формуле:

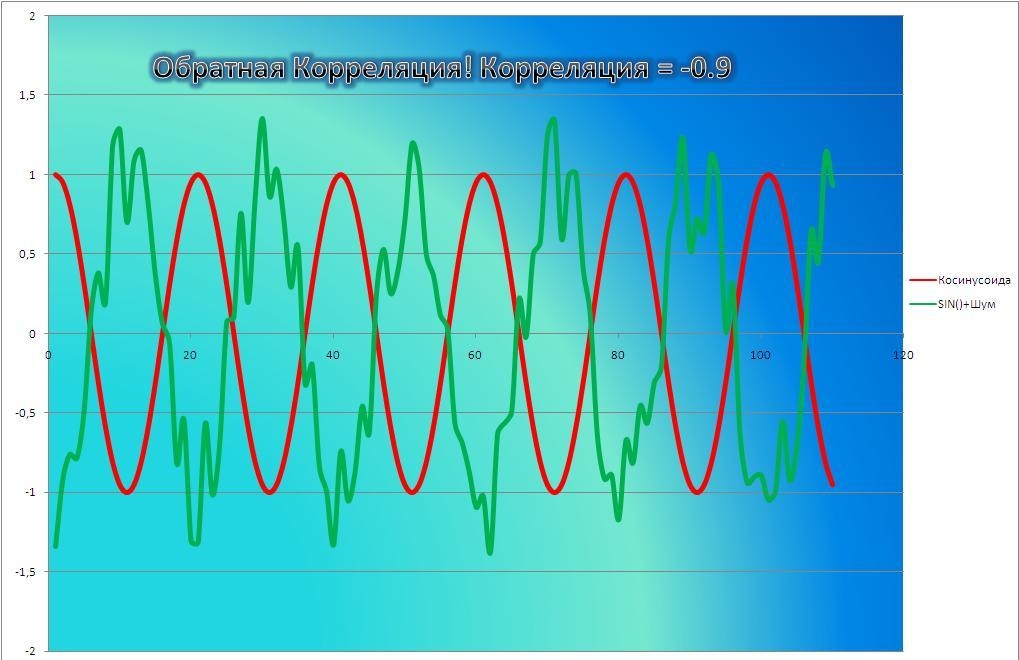

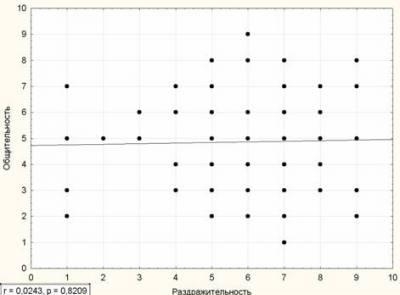

Величина полученного коэффициента корреляции говорит об умеренной тесноте связи исследованных признаков, а знак свидетельствует о прямом характере этой связи.

Иногда при наличии линейной связи можно, используя коэффициент корреляции, оценить влияние признака-фактора на результативный признак. Для этого применяется квадрат коэффициента корреляции, называемый коэффициентом детерминации (r2). Если выразить коэффициент детерминации в процентах, то он покажет долю влияния данного факториального признака на результативный. Например, коэффициент корреляции между ростом и весом детей равен +0,75, тогда коэффициент детерминации будет: rxy2=0,752=0,56. Если принять все факторы, влияющие на вес тела, за 100%, то на долю роста приходится 56%.

Поскольку коэффициент корреляции в клинических исследованиях рассчитывается обычно для ограниченного числа наблюдений, нередко возникает вопрос о надежности полученного коэффициента. С этой целью определяют сред-

нюю ошибку коэффициента корреляции. При достаточно большом числе на-

блюдений (больше 100) средняя ошибка коэффициента корреляции (тr) вычисляется по формуле:

|

1− r |

2 |

|||

|

mr |

= |

xy |

(1.37) |

|

|

n |

||||

где n — число парных наблюдений.

В том случае, если число наблюдений меньше 100, но больше 30, точнее определять среднюю ошибку коэффициента корреляции, пользуясь формулой:

|

1− r 2 |

|||

|

mr = |

xy |

(1.38) |

|

|

n −1 |

|||

66

С достаточной для медицинских исследований надежностью о наличии той или иной степени связи можно утверждать только тогда, когда величина коэффициента корреляции превышает или равняется величине трех своих ошибок (rxy>=3mr). Обычно это отношение коэффициента корреляции (rху) к его средней ошибке (тr) обозначают буквой t и называют критерием достоверности:

|

tr |

= |

rxy |

(1.39) |

|

|

mr |

||||

Если tr >= 3, то коэффициент корреляции достоверен. В рассмотренном выше примере число наблюдений 142, а коэффициент корреляции 0,68. Тогда

|

mr |

= |

1− rxy2 |

1−(0,68)2 |

||

|

n |

= |

142 |

= 0,045 |

||

|

r |

|||||

|

tr = |

= |

0,68 |

=15 , |

||

|

mr |

0,045 |

||||

т. е. коэффициент корреляции вполне достоверен.

В случае малой выборки (число наблюдений меньше 30) для оценки достоверности коэффициента корреляции, т. е. для определения соответствия коэффициента корреляции, вычисленного по выборочным данным, действительным размерам связи в генеральной совокупности, средняя ошибка коэффициента корреляции (тr) определяется по формуле:

|

1− r 2 |

|||

|

mr = |

xy |

(1.40) |

|

|

n − 2 |

|||

Значения критерия tr оцениваются по таблице t Стьюдента при числе степеней свободы v = п — 2. Если величина tr больше табличного значения t05, то коэффициент корреляции признается надежным с доверительной вероятностью больше 95%. Например, имеется коэффициент корреляции, равный +0,72 при числе наблюдений 28. Тогда

mr = 1−(0,72)2 = ±0,019 28 −2

tr = 0,0190,72 = 35,9

Полученное значение tr = 35,9 значительно больше табличного t01 = 2,779, следовательно, полученному коэффициенту корреляции можно доверять с высокой степенью вероятности (>99%).

В медицинской практике нередко возникает необходимость сравнить между собой два выборочных коэффициента корреляции и определить, существенна ли разница между ними. Ввиду того, что распределение коэффициента корреляции отличается от нормального, для оценки значимости различия между двумя коэффициентами корреляции рекомендуется использовать величину Z,

67

предложенную Р. Фишером. Величины Z, соответствующие различным значениям коэффициента корреляции, представлены в табл. 1.38.

Например, при исследовании тесноты связи между ростом и весом девочек и мальчиков было установлено, что у мальчиков коэффициент корреляции равен 0,5, а у девочек — 0,7. При этом обследовано 20 мальчиков и 30 девочек. Можно ли считать, что у девочек сильнее выражена связь между ростом и весом, чем у мальчиков? Для решения этого вопроса переведем значение наших коэффициентов корреляции (r) в величины Z. Находим по таблице, что r = 0,5 соответствует Z = 0,5493, а для r = 0,7 соответствует Z = 0,8673. Ошибка разности вычисляется по формуле:

|

mz |

= |

n1 |

1 |

+ |

1 |

= |

1 |

+ |

1 |

= 0,10 = 0,316 |

|

−3 |

n2 −3 |

20 −3 |

30 −3 |

Вычисляем критерий значимости различий:

|

tz |

= |

z1 − z2 |

= |

0,8673 −0,5493 |

= |

0,3188 |

=1,005 |

|

|

mz |

0,316 |

0,316 |

||||||

Разность признается значимой, если tz ≥ 3. В нашем примере tz < 3; следовательно, на основании полученных коэффициентов корреляции нельзя делать вывод о более выраженной связи между ростом и весом у девочек.

Таблица 1.38 — Таблица величин Z

|

r |

0,00 |

0,01 |

0,02 |

0,03 |

0,04 |

0,05 |

0,06 |

0,07 |

0,08 |

0,09 |

|

0,90 |

1,4722 |

1,5275 |

1,5890 |

1,6584 |

1,7380 |

1,8318 |

1,9459 |

2,0923 |

2,2976 |

2,6467 |

|

0,80 |

1,0986 |

1,1270 |

1,1568 |

1,1881 |

1,2212 |

1,2562 |

1,2933 |

1,3101 |

1,3758 |

1,4219 |

|

0,70 |

0,8673 |

0,8872 |

0,9076 |

0,9287 |

0,9505 |

0,9730 |

0,9962 |

1,0203 |

1,0454 |

1,0714 |

|

0,60 |

0,6931 |

0,7089 |

0,7250 |

0,7414 |

0,7582 |

0,7753 |

0,7623 |

0,8107 |

0,8291 |

0,8480 |

|

0,50 |

0,5493 |

0,5627 |

0,5763 |

0,5901 |

0,6042 |

0,6184 |

0,6328 |

0,6475 |

0,6625 |

0,6777 |

|

0,40 |

0,4236 |

0,4356 |

0,4477 |

0,4599 |

0,4722 |

0,4847 |

0,4973 |

0,5101 |

0,5230 |

0,5361 |

|

0,30 |

0,3045 |

0,3205 |

0,3316 |

0,3428 |

0,3541 |

0,3654 |

0,3769 |

0,3884 |

0,4001 |

0,4118 |

|

0,20 |

0,2027 |

0,2132 |

0,2237 |

0,2342 |

0,2448 |

0,2554 |

0,2661 |

0,2769 |

0,2877 |

0,2986 |

|

0,10 |

0,1003 |

0,1104 |

0,1205 |

0,1307 |

0,1409 |

0,1511 |

0,1614 |

0,1717 |

0,1820 |

0,1923 |

|

0,00 |

0,0000 |

0,0100 |

0,0200 |

0,0300 |

0,0400 |

0,0501 |

0,0600 |

0,0701 |

0,0802 |

0,0902 |

1.8.5 Определение тесноты связи между качественными признаками

При изучении зависимости качественных признаков используется коэффициент сопряженности. Для определения тесноты связи в случае альтернативной изменчивости двух сопоставляемых признаков имеющиеся данные сводятся в четырехпольную таблицу, и коэффициент сопряженности вычисляется по формуле:

|

C1 = |

ad −bc |

(1.41) |

|

(a +c)(b + d)(a +b)(c + d) |

68

Если ранее по данным этой таблицы был вычислен критерий χ2, то коэффициент сопряженности вычисляется по формуле:

|

C1 = |

χ2 |

= |

χ2 |

(1.42) |

|

a +b +c + d |

n |

Например, требуется установить, имеется ли связь между степенью тяжести ревматизма и эффективностью тонзиллэктомии (табл. 1.39).

Таблица 1.39 — Эффективность тонзиллэктомии в зависимости от симптоматики ревматизма

|

Симптоматика ревматизма |

Результат лечения |

Итого |

|||

|

успешное |

неэффективное |

||||

|

Больные, имевшие изменения со |

9 |

26 |

|||

|

cтороны сердца и суставов. |

|||||

|

Больные, имевшие изменения |

8 |

16 |

|||

|

только со cтороны сердца . . |

|||||

|

Всего |

25 |

17 |

42 |

||

Коэффициент сопряженности изменяется в пределах от +1 до -1 и оценивается аналогично коэффициенту корреляции.

При сопоставлении качественных признаков, имеющих три и больше групп, для определения тесноты связи, пользуются коэффициентом средней квадратичной сопряженности Пирсона:

и коэффициентом взаимной сопряженности Чупрова:

|

K = |

φ2 |

(1.44) |

|

(k1 −1) (k2 −1) |

где k1 — число групп по столбцам;

k2 — число групп по строкам таблицы;

ϕ2 + 1 — равно о сумме отношений квадратов частот каждой клетки таблицы к произведению итогов строк и соответствующих итогов столбцов

|

2 |

||||||||

|

ϕ2 |

+ 1 = |

∑ |

mxy |

(1.45) |

||||

|

m |

m |

|||||||

|

x |

||||||||

|

y |

Пример. Вычислим коэффициент средней квадратической сопряженности Пирсона между гистологической структурой и типом роста опухоли по данным таблицы 1.40.

Находим значение ϕ2 + 1:

69

|

φ |

2 |

+1 |

= |

∑ |

mxy2 |

= |

112 |

+ |

62 |

+ |

22 |

+ |

2 |

2 |

+ |

32 |

+ |

10 |

2 |

+ |

12 |

+ |

12 |

+ |

32 |

+ |

|||||||||||||||||||||||||||||||||||

|

mx |

my |

20 |

21 |

33 21 |

14 |

21 |

6 |

21 |

20 |

15 |

33 |

15 |

14 15 |

6 |

15 |

20 |

12 |

||||||||||||||||||||||||||||||||||||||||||||

|

+ |

52 |

+ |

32 |

+ |

12 |

+ |

12 |

+ |

72 |

+ |

32 |

+ |

12 |

+ |

52 |

+ |

2 |

2 |

+ |

4 |

2 |

+ |

22 |

=1,47 |

|||||||||||||||||||||||||||||||||||||

|

33 12 |

14 12 |

6 12 |

20 12 |

33 11 |

14 11 |

33 6 |

14 6 |

20 |

8 |

33 |

6 |

6 8 |

|||||||||||||||||||||||||||||||||||||||||||||||||

Отсюда находим ϕ2 =1,47 – 1 = 0,47.

Коэффициент средней квадратичной сопряженности Пирсона:

C1 =

Коэффициент взаимной сопряженности Чупрова равняется

|

K = |

0,47 |

= |

0,47 |

= |

0,47 |

= 0,12 = 0,348 |

|

(4 |

−1) (6 −1) |

3 5 |

15 |

Полученный коэффициент К также свидетельствует о наличии связи между рассматриваемыми признаками.

Таблица 1.40 — Зависимость между гистологической структурой опухоли и типом ее роста

|

Гистологическая |

Тип роста опухоли (х) |

Итого |

|||

|

структура (у) |

экзофит- |

язвенно- |

диффузно- |

переход- |

(my) |

|

ный |

инфиль- |

инфильтра- |

ный |

||

|

тративный |

тивный |

||||

|

Аденокарцинома |

11(mxy) |

6 |

2 |

2 |

21 |

|

Cr. simplex……… |

3 |

10 |

1 |

1 |

15 |

|

Солидный рак…… |

3 |

5 |

3 |

1 |

12 |

|

Слизистый……… |

1 |

7 |

3 |

─ |

11 |

|

Фиброзный рак… |

─ |

1 |

5 |

─ |

6 |

|

Смешанные формы |

2 |

4 |

─ |

2 |

8 |

|

Всего (mx)……… |

20 |

33 |

14 |

6 |

73 |

При применении коэффициента сопряженности С1 следует учитывать, что он всегда меньше 1 и теоретическая его величина зависит от числа строк и столбцов таблицы. Поэтому вычисление коэффициента С1 правомочно только тогда, когда каждый из сопоставляемых признаков имеет не менее 5 градаций (таблица 5×5 групп). Коэффициент Чупрова, который всегда меньше коэффициента С1 не имеет этого ограничения.

Достоверность выборочного коэффициента взаимной сопряженности оценивается с помощью критерия χ2. Полученная величина χ2=nϕ2 сопоставляется с табличными значениями χ2 при числе степеней свободы v=(k —1)(k2-1) и р = 0,05.

70

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

In statistics, the Pearson correlation coefficient (PCC, pronounced ) ― also known as Pearson’s r, the Pearson product-moment correlation coefficient (PPMCC), the bivariate correlation,[1] or colloquially simply as the correlation coefficient[2] ― is a measure of linear correlation between two sets of data. It is the ratio between the covariance of two variables and the product of their standard deviations; thus, it is essentially a normalized measurement of the covariance, such that the result always has a value between −1 and 1. As with covariance itself, the measure can only reflect a linear correlation of variables, and ignores many other types of relationships or correlations. As a simple example, one would expect the age and height of a sample of teenagers from a high school to have a Pearson correlation coefficient significantly greater than 0, but less than 1 (as 1 would represent an unrealistically perfect correlation).

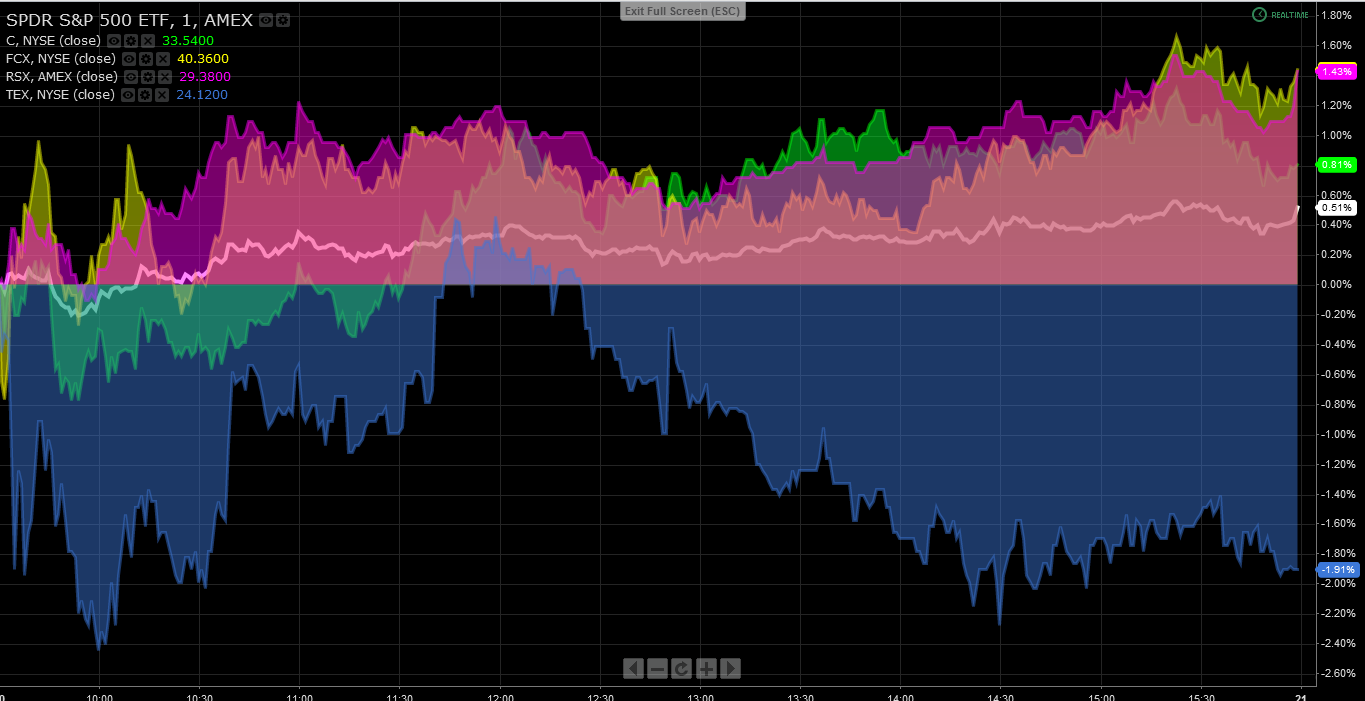

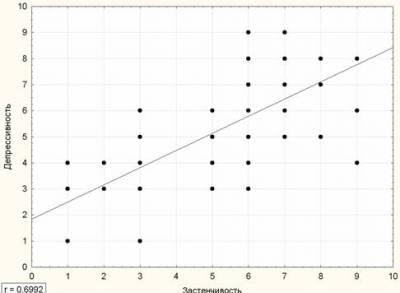

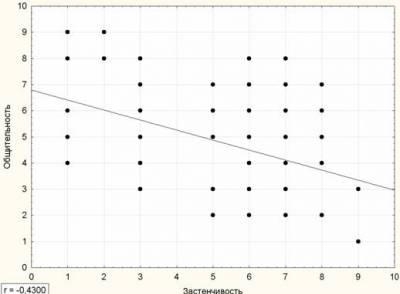

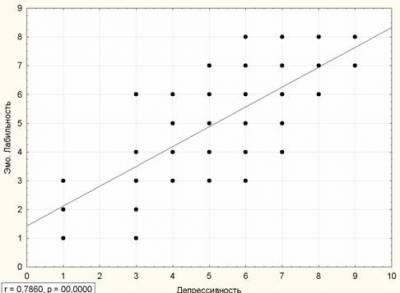

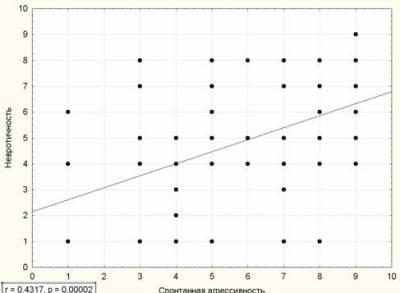

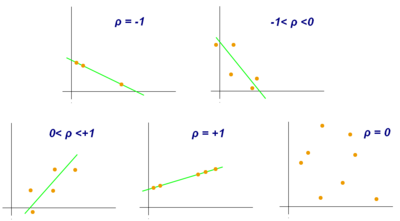

Examples of scatter diagrams with different values of correlation coefficient (ρ)

Several sets of (x, y) points, with the correlation coefficient of x and y for each set. Note that the correlation reflects the strength and direction of a linear relationship (top row), but not the slope of that relationship (middle), nor many aspects of nonlinear relationships (bottom). N.B.: the figure in the center has a slope of 0 but in that case the correlation coefficient is undefined because the variance of Y is zero.

Naming and history[edit]

It was developed by Karl Pearson from a related idea introduced by Francis Galton in the 1880s, and for which the mathematical formula was derived and published by Auguste Bravais in 1844.[a][6][7][8][9] The naming of the coefficient is thus an example of Stigler’s Law.

Definition[edit]

Pearson’s correlation coefficient is the covariance of the two variables divided by the product of their standard deviations. The form of the definition involves a «product moment», that is, the mean (the first moment about the origin) of the product of the mean-adjusted random variables; hence the modifier product-moment in the name.

For a population[edit]

Pearson’s correlation coefficient, when applied to a population, is commonly represented by the Greek letter ρ (rho) and may be referred to as the population correlation coefficient or the population Pearson correlation coefficient. Given a pair of random variables

where:

The formula for

the formula for

where:

The formula for

the formula for

Peason’s correlation coefficient does not exist when either

For a sample[edit]

Pearson’s correlation coefficient, when applied to a sample, is commonly represented by

where:

Rearranging gives us this formula for

where

This formula suggests a convenient single-pass algorithm for calculating sample correlations, though depending on the numbers involved, it can sometimes be numerically unstable.

Rearranging again gives us this[10] formula for

where

An equivalent expression gives the formula for

where:

Alternative formulae for

where:

Practical issues[edit]

Under heavy noise conditions, extracting the correlation coefficient between two sets of stochastic variables is nontrivial, in particular where Canonical Correlation Analysis reports degraded correlation values due to the heavy noise contributions. A generalization of the approach is given elsewhere.[12]

In case of missing data, Garren derived the maximum likelihood estimator.[13]

Some distributions (e.g., stable distributions other than a normal distribution) do not have a defined variance.

Mathematical properties[edit]

The values of both the sample and population Pearson correlation coefficients are on or between −1 and 1. Correlations equal to +1 or −1 correspond to data points lying exactly on a line (in the case of the sample correlation), or to a bivariate distribution entirely supported on a line (in the case of the population correlation). The Pearson correlation coefficient is symmetric: corr(X,Y) = corr(Y,X).

A key mathematical property of the Pearson correlation coefficient is that it is invariant under separate changes in location and scale in the two variables. That is, we may transform X to a + bX and transform Y to c + dY, where a, b, c, and d are constants with b, d > 0, without changing the correlation coefficient. (This holds for both the population and sample Pearson correlation coefficients.) Note that more general linear transformations do change the correlation: see § Decorrelation of n random variables for an application of this.

Interpretation[edit]

The correlation coefficient ranges from −1 to 1. An absolute value of exactly 1 implies that a linear equation describes the relationship between X and Y perfectly, with all data points lying on a line. The correlation sign is determined by the regression slope: a value of +1 implies that all data points lie on a line for which Y increases as X increases, and vice versa for −1.[14] A value of 0 implies that there is no linear dependency between the variables.[15]

More generally, note that (Xi − X)(Yi − Y) is positive if and only if Xi and Yi lie on the same side of their respective means. Thus the correlation coefficient is positive if Xi and Yi tend to be simultaneously greater than, or simultaneously less than, their respective means. The correlation coefficient is negative (anti-correlation) if Xi and Yi tend to lie on opposite sides of their respective means. Moreover, the stronger either tendency is, the larger is the absolute value of the correlation coefficient.

Rodgers and Nicewander[16] cataloged thirteen ways of interpreting correlation or simple functions of it:

- Function of raw scores and means

- Standardized covariance

- Standardized slope of the regression line

- Geometric mean of the two regression slopes

- Square root of the ratio of two variances

- Mean cross-product of standardized variables

- Function of the angle between two standardized regression lines

- Function of the angle between two variable vectors

- Rescaled variance of the difference between standardized scores

- Estimated from the balloon rule

- Related to the bivariate ellipses of isoconcentration

- Function of test statistics from designed experiments

- Ratio of two means

Geometric interpretation[edit]

Regression lines for y = gX(x) [red] and x = gY(y) [blue]

For uncentered data, there is a relation between the correlation coefficient and the angle φ between the two regression lines, y = gX(x) and x = gY(y), obtained by regressing y on x and x on y respectively. (Here, φ is measured counterclockwise within the first quadrant formed around the lines’ intersection point if r > 0, or counterclockwise from the fourth to the second quadrant if r < 0.) One can show[17] that if the standard deviations are equal, then r = sec φ − tan φ, where sec and tan are trigonometric functions.

For centered data (i.e., data which have been shifted by the sample means of their respective variables so as to have an average of zero for each variable), the correlation coefficient can also be viewed as the cosine of the angle θ between the two observed vectors in N-dimensional space (for N observations of each variable)[18]

Both the uncentered (non-Pearson-compliant) and centered correlation coefficients can be determined for a dataset. As an example, suppose five countries are found to have gross national products of 1, 2, 3, 5, and 8 billion dollars, respectively. Suppose these same five countries (in the same order) are found to have 11%, 12%, 13%, 15%, and 18% poverty. Then let x and y be ordered 5-element vectors containing the above data: x = (1, 2, 3, 5, and y = (0.11, 0.12, 0.13, 0.15, 0.18).

By the usual procedure for finding the angle θ between two vectors (see dot product), the uncentered correlation coefficient is:

This uncentered correlation coefficient is identical with the cosine similarity.

Note that the above data were deliberately chosen to be perfectly correlated: y = 0.10 + 0.01 x. The Pearson correlation coefficient must therefore be exactly one. Centering the data (shifting x by ℰ(x) = 3.8 and y by ℰ(y) = 0.138) yields x = (−2.8, −1.8, −0.8, 1.2, 4.2) and y = (−0.028, −0.018, −0.008, 0.012, 0.042), from which

as expected.

Interpretation of the size of a correlation[edit]

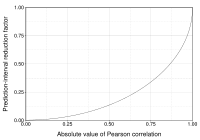

This figure gives a sense of how the usefulness of a Pearson correlation for predicting values varies with its magnitude. Given jointly normal X, Y with correlation ρ,

Several authors have offered guidelines for the interpretation of a correlation coefficient.[19][20] However, all such criteria are in some ways arbitrary.[20] The interpretation of a correlation coefficient depends on the context and purposes. A correlation of 0.8 may be very low if one is verifying a physical law using high-quality instruments, but may be regarded as very high in the social sciences, where there may be a greater contribution from complicating factors.

Inference[edit]

Statistical inference based on Pearson’s correlation coefficient often focuses on one of the following two aims:

- One aim is to test the null hypothesis that the true correlation coefficient ρ is equal to 0, based on the value of the sample correlation coefficient r.

- The other aim is to derive a confidence interval that, on repeated sampling, has a given probability of containing ρ.

We discuss methods of achieving one or both of these aims below.

Using a permutation test[edit]

Permutation tests provide a direct approach to performing hypothesis tests and constructing confidence intervals. A permutation test for Pearson’s correlation coefficient involves the following two steps:

- Using the original paired data (xi, yi), randomly redefine the pairs to create a new data set (xi, yi′), where the i′ are a permutation of the set {1,…,n}. The permutation i′ is selected randomly, with equal probabilities placed on all n! possible permutations. This is equivalent to drawing the i′ randomly without replacement from the set {1, …, n}. In bootstrapping, a closely related approach, the i and the i′ are equal and drawn with replacement from {1, …, n};

- Construct a correlation coefficient r from the randomized data.

To perform the permutation test, repeat steps (1) and (2) a large number of times. The p-value for the permutation test is the proportion of the r values generated in step (2) that are larger than the Pearson correlation coefficient that was calculated from the original data. Here «larger» can mean either that the value is larger in magnitude, or larger in signed value, depending on whether a two-sided or one-sided test is desired.

Using a bootstrap[edit]

The bootstrap can be used to construct confidence intervals for Pearson’s correlation coefficient. In the «non-parametric» bootstrap, n pairs (xi, yi) are resampled «with replacement» from the observed set of n pairs, and the correlation coefficient r is calculated based on the resampled data. This process is repeated a large number of times, and the empirical distribution of the resampled r values are used to approximate the sampling distribution of the statistic. A 95% confidence interval for ρ can be defined as the interval spanning from the 2.5th to the 97.5th percentile of the resampled r values.

Standard error[edit]

If

where

Testing using Student’s t-distribution[edit]

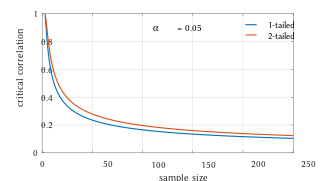

Critical values of Pearson’s correlation coefficient that must be exceeded to be considered significantly nonzero at the 0.05 level.

For pairs from an uncorrelated bivariate normal distribution, the sampling distribution of the studentized Pearson’s correlation coefficient follows Student’s t-distribution with degrees of freedom n − 2. Specifically, if the underlying variables have a bivariate normal distribution, the variable

has a student’s t-distribution in the null case (zero correlation).[23] This holds approximately in case of non-normal observed values if sample sizes are large enough.[24] For determining the critical values for r the inverse function is needed:

Alternatively, large sample, asymptotic approaches can be used.

Another early paper[25] provides graphs and tables for general values of ρ, for small sample sizes, and discusses computational approaches.

In the case where the underlying variables are not normal, the sampling distribution of Pearson’s correlation coefficient follows a Student’s t-distribution, but the degrees of freedom are reduced.[26]

Using the exact distribution[edit]

For data that follow a bivariate normal distribution, the exact density function f(r) for the sample correlation coefficient r of a normal bivariate is[27][28][29]

where

In the special case when

where

Using the exact confidence distribution[edit]

Confidence intervals and tests can be calculated from a confidence distribution. An exact confidence density for ρ is[30]

where

Using the Fisher transformation[edit]

In practice, confidence intervals and hypothesis tests relating to ρ are usually carried out using the Fisher transformation,

F(r) approximately follows a normal distribution with

and standard error

where n is the sample size. The approximation error is lowest for a large sample size

Using the approximation, a z-score is

under the null hypothesis that

To obtain a confidence interval for ρ, we first compute a confidence interval for F(

The inverse Fisher transformation brings the interval back to the correlation scale.

For example, suppose we observe r = 0.7 with a sample size of n=50, and we wish to obtain a 95% confidence interval for ρ. The transformed value is arctanh(r) = 0.8673, so the confidence interval on the transformed scale is 0.8673 ± 1.96/√47, or (0.5814, 1.1532). Converting back to the correlation scale yields (0.5237, 0.8188).

In least squares regression analysis[edit]

The square of the sample correlation coefficient is typically denoted r2 and is a special case of the coefficient of determination. In this case, it estimates the fraction of the variance in Y that is explained by X in a simple linear regression. So if we have the observed dataset

where the

The two summands above are the fraction of variance in Y that is explained by X (right) and that is unexplained by X (left).

Next, we apply a property of least square regression models, that the sample covariance between

Thus

where

In the derivation above, the fact that

can be proved by noticing that the partial derivatives of the residual sum of squares (RSS) over β0 and β1 are equal to 0 in the least squares model, where

.

In the end, the equation can be written as:

where

The symbol

Sensitivity to the data distribution[edit]

Existence[edit]

The population Pearson correlation coefficient is defined in terms of moments, and therefore exists for any bivariate probability distribution for which the population covariance is defined and the marginal population variances are defined and are non-zero. Some probability distributions, such as the Cauchy distribution, have undefined variance and hence ρ is not defined if X or Y follows such a distribution. In some practical applications, such as those involving data suspected to follow a heavy-tailed distribution, this is an important consideration. However, the existence of the correlation coefficient is usually not a concern; for instance, if the range of the distribution is bounded, ρ is always defined.

Sample size[edit]

- If the sample size is moderate or large and the population is normal, then, in the case of the bivariate normal distribution, the sample correlation coefficient is the maximum likelihood estimate of the population correlation coefficient, and is asymptotically unbiased and efficient, which roughly means that it is impossible to construct a more accurate estimate than the sample correlation coefficient.

- If the sample size is large and the population is not normal, then the sample correlation coefficient remains approximately unbiased, but may not be efficient.

- If the sample size is large, then the sample correlation coefficient is a consistent estimator of the population correlation coefficient as long as the sample means, variances, and covariance are consistent (which is guaranteed when the law of large numbers can be applied).

- If the sample size is small, then the sample correlation coefficient r is not an unbiased estimate of ρ.[10] The adjusted correlation coefficient must be used instead: see elsewhere in this article for the definition.

- Correlations can be different for imbalanced dichotomous data when there is variance error in sample.[31]

Robustness[edit]

Like many commonly used statistics, the sample statistic r is not robust,[32] so its value can be misleading if outliers are present.[33][34] Specifically, the PMCC is neither distributionally robust,[citation needed] nor outlier resistant[32] (see Robust statistics § Definition). Inspection of the scatterplot between X and Y will typically reveal a situation where lack of robustness might be an issue, and in such cases it may be advisable to use a robust measure of association. Note however that while most robust estimators of association measure statistical dependence in some way, they are generally not interpretable on the same scale as the Pearson correlation coefficient.

Statistical inference for Pearson’s correlation coefficient is sensitive to the data distribution. Exact tests, and asymptotic tests based on the Fisher transformation can be applied if the data are approximately normally distributed, but may be misleading otherwise. In some situations, the bootstrap can be applied to construct confidence intervals, and permutation tests can be applied to carry out hypothesis tests. These non-parametric approaches may give more meaningful results in some situations where bivariate normality does not hold. However the standard versions of these approaches rely on exchangeability of the data, meaning that there is no ordering or grouping of the data pairs being analyzed that might affect the behavior of the correlation estimate.

A stratified analysis is one way to either accommodate a lack of bivariate normality, or to isolate the correlation resulting from one factor while controlling for another. If W represents cluster membership or another factor that it is desirable to control, we can stratify the data based on the value of W, then calculate a correlation coefficient within each stratum. The stratum-level estimates can then be combined to estimate the overall correlation while controlling for W.[35]

Variants[edit]

Variations of the correlation coefficient can be calculated for different purposes. Here are some examples.

Adjusted correlation coefficient[edit]

The sample correlation coefficient r is not an unbiased estimate of ρ. For data that follows a bivariate normal distribution, the expectation E[r] for the sample correlation coefficient r of a normal bivariate is[36]

therefore r is a biased estimator of

The unique minimum variance unbiased estimator radj is given by[37]

-

(1)

where:

An approximately unbiased estimator radj can be obtained[citation needed] by truncating E[r] and solving this truncated equation:

-

(2)

An approximate solution[citation needed] to equation (2) is:

-

(3)

where in (3):

are defined as above,

- radj is a suboptimal estimator,[citation needed][clarification needed]

- radj can also be obtained by maximizing log(f(r)),

- radj has minimum variance for large values of n,

- radj has a bias of order 1⁄(n − 1).

Another proposed[10] adjusted correlation coefficient is:[citation needed]

Note that radj ≈ r for large values of n.

Weighted correlation coefficient[edit]

Suppose observations to be correlated have differing degrees of importance that can be expressed with a weight vector w. To calculate the correlation between vectors x and y with the weight vector w (all of length n),[38][39]

- Weighted mean:

- Weighted covariance

- Weighted correlation

Reflective correlation coefficient[edit]

The reflective correlation is a variant of Pearson’s correlation in which the data are not centered around their mean values.[citation needed] The population reflective correlation is

The reflective correlation is symmetric, but it is not invariant under translation:

The sample reflective correlation is equivalent to cosine similarity:

The weighted version of the sample reflective correlation is

Scaled correlation coefficient[edit]

Scaled correlation is a variant of Pearson’s correlation in which the range of the data is restricted intentionally and in a controlled manner to reveal correlations between fast components in time series.[40] Scaled correlation is defined as average correlation across short segments of data.

Let

The scaled correlation across the entire signals

where

By choosing the parameter

Pearson’s distance[edit]

A distance metric for two variables X and Y known as Pearson’s distance can be defined from their correlation coefficient as[41]

Considering that the Pearson correlation coefficient falls between [−1, +1], the Pearson distance lies in [0, 2]. The Pearson distance has been used in cluster analysis and data detection for communications and storage with unknown gain and offset.[42]

The Pearson «distance» defined this way assigns distance greater than 1 to negative correlations. In reality, both strong positive correlation and negative correlations are meaningful, so care must be taken when Pearson «distance» is used for nearest neighbor algorithm as such algorithm will only include neighbors with positive correlation and exclude neighbors with negative correlation. Alternatively, an absolute valued distance:

Circular correlation coefficient[edit]

For variables X = {x1,…,xn} and Y = {y1,…,yn} that are defined on the unit circle [0, 2π), it is possible to define a circular analog of Pearson’s coefficient.[43] This is done by transforming data points in X and Y with a sine function such that the correlation coefficient is given as:

where

Partial correlation[edit]

If a population or data-set is characterized by more than two variables, a partial correlation coefficient measures the strength of dependence between a pair of variables that is not accounted for by the way in which they both change in response to variations in a selected subset of the other variables.

Decorrelation of n random variables[edit]

It is always possible to remove the correlations between all pairs of an arbitrary number of random variables by using a data transformation, even if the relationship between the variables is nonlinear. A presentation of this result for population distributions is given by Cox & Hinkley.[44]

A corresponding result exists for reducing the sample correlations to zero. Suppose a vector of n random variables is observed m times. Let X be a matrix where

where an exponent of −+1⁄2 represents the matrix square root of the inverse of a matrix. The correlation matrix of T will be the identity matrix. If a new data observation x is a row vector of n elements, then the same transform can be applied to x to get the transformed vectors d and t:

This decorrelation is related to principal components analysis for multivariate data.

Software implementations[edit]

- R’s statistics base-package implements the correlation coefficient with

cor(x, y), or (with the P value also) withcor.test(x, y). - The SciPy Python library via

pearsonr(x, y). - The Pandas Python library implements Pearson correlation coefficient calculation as the default option for the method

pandas.DataFrame.corr - Wolfram Mathematica via the

Correlationfunction, or (with the P value) withCorrelationTest. - The Boost C++ library via the

correlation_coefficientfunction. - Excel has an in-built

correl(array1, array2)function for calculationg the pearson’s correlation coefficient.

See also[edit]

- Anscombe’s quartet

- Association (statistics)

- Coefficient of colligation

- Yule’s Q

- Yule’s Y

- Concordance correlation coefficient

- Correlation and dependence

- Correlation ratio

- Disattenuation

- Distance correlation

- Maximal information coefficient

- Multiple correlation

- Normally distributed and uncorrelated does not imply independent

- Odds ratio

- Partial correlation

- Polychoric correlation

- Quadrant count ratio

- RV coefficient

- Spearman’s rank correlation coefficient

Footnotes[edit]

- ^ As early as 1877, Galton was using the term «reversion» and the symbol «r» for what would become «regression».[3][4][5]

References[edit]

- ^ «SPSS Tutorials: Pearson Correlation».

- ^ «Correlation Coefficient: Simple Definition, Formula, Easy Steps». Statistics How To.

- ^ Galton, F. (5–19 April 1877). «Typical laws of heredity». Nature. 15 (388, 389, 390): 492–495, 512–514, 532–533. Bibcode:1877Natur..15..492.. doi:10.1038/015492a0. S2CID 4136393. In the «Appendix» on page 532, Galton uses the term «reversion» and the symbol r.

- ^ Galton, F. (24 September 1885). «The British Association: Section II, Anthropology: Opening address by Francis Galton, F.R.S., etc., President of the Anthropological Institute, President of the Section». Nature. 32 (830): 507–510.

- ^ Galton, F. (1886). «Regression towards mediocrity in hereditary stature». Journal of the Anthropological Institute of Great Britain and Ireland. 15: 246–263. doi:10.2307/2841583. JSTOR 2841583.

- ^ Pearson, Karl (20 June 1895). «Notes on regression and inheritance in the case of two parents». Proceedings of the Royal Society of London. 58: 240–242. Bibcode:1895RSPS…58..240P.

- ^ Stigler, Stephen M. (1989). «Francis Galton’s account of the invention of correlation». Statistical Science. 4 (2): 73–79. doi:10.1214/ss/1177012580. JSTOR 2245329.

- ^ «Analyse mathematique sur les probabilités des erreurs de situation d’un point». Mem. Acad. Roy. Sci. Inst. France. Sci. Math, et Phys. (in French). 9: 255–332. 1844 – via Google Books.

- ^ Wright, S. (1921). «Correlation and causation». Journal of Agricultural Research. 20 (7): 557–585.

- ^ a b c d e Real Statistics Using Excel: Correlation: Basic Concepts, retrieved 22 February 2015

- ^ Weisstein, Eric W. «Statistical Correlation». mathworld.wolfram.com. Retrieved 22 August 2020.

- ^ Moriya, N. (2008). «Noise-related multivariate optimal joint-analysis in longitudinal stochastic processes». In Yang, Fengshan (ed.). Progress in Applied Mathematical Modeling. Nova Science Publishers, Inc. pp. 223–260. ISBN 978-1-60021-976-4.

- ^ Garren, Steven T. (15 June 1998). «Maximum likelihood estimation of the correlation coefficient in a bivariate normal model, with missing data». Statistics & Probability Letters. 38 (3): 281–288. doi:10.1016/S0167-7152(98)00035-2.

- ^ «2.6 — (Pearson) Correlation Coefficient r». STAT 462. Retrieved 10 July 2021.

- ^ «Introductory Business Statistics: The Correlation Coefficient r». opentextbc.ca. Retrieved 21 August 2020.

- ^ Rodgers; Nicewander (1988). «Thirteen ways to look at the correlation coefficient» (PDF). The American Statistician. 42 (1): 59–66. doi:10.2307/2685263. JSTOR 2685263.

- ^ Schmid, John Jr. (December 1947). «The relationship between the coefficient of correlation and the angle included between regression lines». The Journal of Educational Research. 41 (4): 311–313. doi:10.1080/00220671.1947.10881608. JSTOR 27528906.

- ^ Rummel, R.J. (1976). «Understanding Correlation». ch. 5 (as illustrated for a special case in the next paragraph).

- ^ Buda, Andrzej; Jarynowski, Andrzej (December 2010). Life Time of Correlations and its Applications. Wydawnictwo Niezależne. pp. 5–21. ISBN 9788391527290.

- ^ a b Cohen, J. (1988). Statistical Power Analysis for the Behavioral Sciences (2nd ed.).

- ^ Bowley, A. L. (1928). «The Standard Deviation of the Correlation Coefficient». Journal of the American Statistical Association. 23 (161): 31–34. doi:10.2307/2277400. ISSN 0162-1459. JSTOR 2277400.

- ^ «Derivation of the standard error for Pearson’s correlation coefficient». Cross Validated. Retrieved 30 July 2021.

- ^ Rahman, N. A. (1968) A Course in Theoretical Statistics, Charles Griffin and Company, 1968

- ^ Kendall, M. G., Stuart, A. (1973) The Advanced Theory of Statistics, Volume 2: Inference and Relationship, Griffin. ISBN 0-85264-215-6 (Section 31.19)

- ^ Soper, H.E.; Young, A.W.; Cave, B.M.; Lee, A.; Pearson, K. (1917). «On the distribution of the correlation coefficient in small samples. Appendix II to the papers of «Student» and R.A. Fisher. A co-operative study». Biometrika. 11 (4): 328–413. doi:10.1093/biomet/11.4.328.

- ^ Davey, Catherine E.; Grayden, David B.; Egan, Gary F.; Johnston, Leigh A. (January 2013). «Filtering induces correlation in fMRI resting state data». NeuroImage. 64: 728–740. doi:10.1016/j.neuroimage.2012.08.022. hdl:11343/44035. PMID 22939874. S2CID 207184701.

- ^ Hotelling, Harold (1953). «New Light on the Correlation Coefficient and its Transforms». Journal of the Royal Statistical Society. Series B (Methodological). 15 (2): 193–232. doi:10.1111/j.2517-6161.1953.tb00135.x. JSTOR 2983768.

- ^ Kenney, J.F.; Keeping, E.S. (1951). Mathematics of Statistics. Vol. Part 2 (2nd ed.). Princeton, NJ: Van Nostrand.

- ^ Weisstein, Eric W. «Correlation Coefficient—Bivariate Normal Distribution». mathworld.wolfram.com.

- ^ Taraldsen, Gunnar (2020). «Confidence in Correlation». doi:10.13140/RG.2.2.23673.49769.

- ^ Lai, Chun Sing; Tao, Yingshan; Xu, Fangyuan; Ng, Wing W.Y.; Jia, Youwei; Yuan, Haoliang; Huang, Chao; Lai, Loi Lei; Xu, Zhao; Locatelli, Giorgio (January 2019). «A robust correlation analysis framework for imbalanced and dichotomous data with uncertainty» (PDF). Information Sciences. 470: 58–77. doi:10.1016/j.ins.2018.08.017. S2CID 52878443.

- ^ a b Wilcox, Rand R. (2005). Introduction to robust estimation and hypothesis testing. Academic Press.

- ^ Devlin, Susan J.; Gnanadesikan, R.; Kettenring J.R. (1975). «Robust estimation and outlier detection with correlation coefficients». Biometrika. 62 (3): 531–545. doi:10.1093/biomet/62.3.531. JSTOR 2335508.

- ^ Huber, Peter. J. (2004). Robust Statistics. Wiley.[page needed]

- ^ Katz., Mitchell H. (2006) Multivariable Analysis – A Practical Guide for Clinicians. 2nd Edition. Cambridge University Press. ISBN 978-0-521-54985-1. ISBN 0-521-54985-X

- ^ Hotelling, H. (1953). «New Light on the Correlation Coefficient and its Transforms». Journal of the Royal Statistical Society. Series B (Methodological). 15 (2): 193–232. doi:10.1111/j.2517-6161.1953.tb00135.x. JSTOR 2983768.

- ^ Olkin, Ingram; Pratt,John W. (March 1958). «Unbiased Estimation of Certain Correlation Coefficients». The Annals of Mathematical Statistics. 29 (1): 201–211. doi:10.1214/aoms/1177706717. JSTOR 2237306..

- ^ «Re: Compute a weighted correlation». sci.tech-archive.net.

- ^ «Weighted Correlation Matrix – File Exchange – MATLAB Central».

- ^ Nikolić, D; Muresan, RC; Feng, W; Singer, W (2012). «Scaled correlation analysis: a better way to compute a cross-correlogram» (PDF). European Journal of Neuroscience. 35 (5): 1–21. doi:10.1111/j.1460-9568.2011.07987.x. PMID 22324876. S2CID 4694570.

- ^ Fulekar (Ed.), M.H. (2009) Bioinformatics: Applications in Life and Environmental Sciences, Springer (pp. 110) ISBN 1-4020-8879-5

- ^ Immink, K. Schouhamer; Weber, J. (October 2010). «Minimum Pearson distance detection for multilevel channels with gain and / or offset mismatch». IEEE Transactions on Information Theory. 60 (10): 5966–5974. CiteSeerX 10.1.1.642.9971. doi:10.1109/tit.2014.2342744. S2CID 1027502. Retrieved 11 February 2018.

- ^ Jammalamadaka, S. Rao; SenGupta, A. (2001). Topics in circular statistics. New Jersey: World Scientific. p. 176. ISBN 978-981-02-3778-3. Retrieved 21 September 2016.

- ^ Cox, D.R.; Hinkley, D.V. (1974). Theoretical Statistics. Chapman & Hall. Appendix 3. ISBN 0-412-12420-3.

External links[edit]

- «cocor». comparingcorrelations.org. – A free web interface and R package for the statistical comparison of two dependent or independent correlations with overlapping or non-overlapping variables.

- «Correlation». nagysandor.eu. – an interactive Flash simulation on the correlation of two normally distributed variables.

- «Correlation coefficient calculator». hackmath.net. Linear regression. –

- «Critical values for Pearson’s correlation coefficient» (PDF). frank.mtsu.edu/~dkfuller. – large table.

- «Guess the Correlation». – A game where players guess how correlated two variables in a scatter plot are, in order to gain a better understanding of the concept of correlation.

In statistics, the Pearson correlation coefficient (PCC, pronounced ) ― also known as Pearson’s r, the Pearson product-moment correlation coefficient (PPMCC), the bivariate correlation,[1] or colloquially simply as the correlation coefficient[2] ― is a measure of linear correlation between two sets of data. It is the ratio between the covariance of two variables and the product of their standard deviations; thus, it is essentially a normalized measurement of the covariance, such that the result always has a value between −1 and 1. As with covariance itself, the measure can only reflect a linear correlation of variables, and ignores many other types of relationships or correlations. As a simple example, one would expect the age and height of a sample of teenagers from a high school to have a Pearson correlation coefficient significantly greater than 0, but less than 1 (as 1 would represent an unrealistically perfect correlation).

Examples of scatter diagrams with different values of correlation coefficient (ρ)

Several sets of (x, y) points, with the correlation coefficient of x and y for each set. Note that the correlation reflects the strength and direction of a linear relationship (top row), but not the slope of that relationship (middle), nor many aspects of nonlinear relationships (bottom). N.B.: the figure in the center has a slope of 0 but in that case the correlation coefficient is undefined because the variance of Y is zero.

Naming and history[edit]

It was developed by Karl Pearson from a related idea introduced by Francis Galton in the 1880s, and for which the mathematical formula was derived and published by Auguste Bravais in 1844.[a][6][7][8][9] The naming of the coefficient is thus an example of Stigler’s Law.

Definition[edit]

Pearson’s correlation coefficient is the covariance of the two variables divided by the product of their standard deviations. The form of the definition involves a «product moment», that is, the mean (the first moment about the origin) of the product of the mean-adjusted random variables; hence the modifier product-moment in the name.

For a population[edit]

Pearson’s correlation coefficient, when applied to a population, is commonly represented by the Greek letter ρ (rho) and may be referred to as the population correlation coefficient or the population Pearson correlation coefficient. Given a pair of random variables

where:

The formula for

the formula for

where:

The formula for

the formula for

Peason’s correlation coefficient does not exist when either

For a sample[edit]

Pearson’s correlation coefficient, when applied to a sample, is commonly represented by

where:

Rearranging gives us this formula for

where

This formula suggests a convenient single-pass algorithm for calculating sample correlations, though depending on the numbers involved, it can sometimes be numerically unstable.

Rearranging again gives us this[10] formula for

where

An equivalent expression gives the formula for

where:

Alternative formulae for

where:

Practical issues[edit]

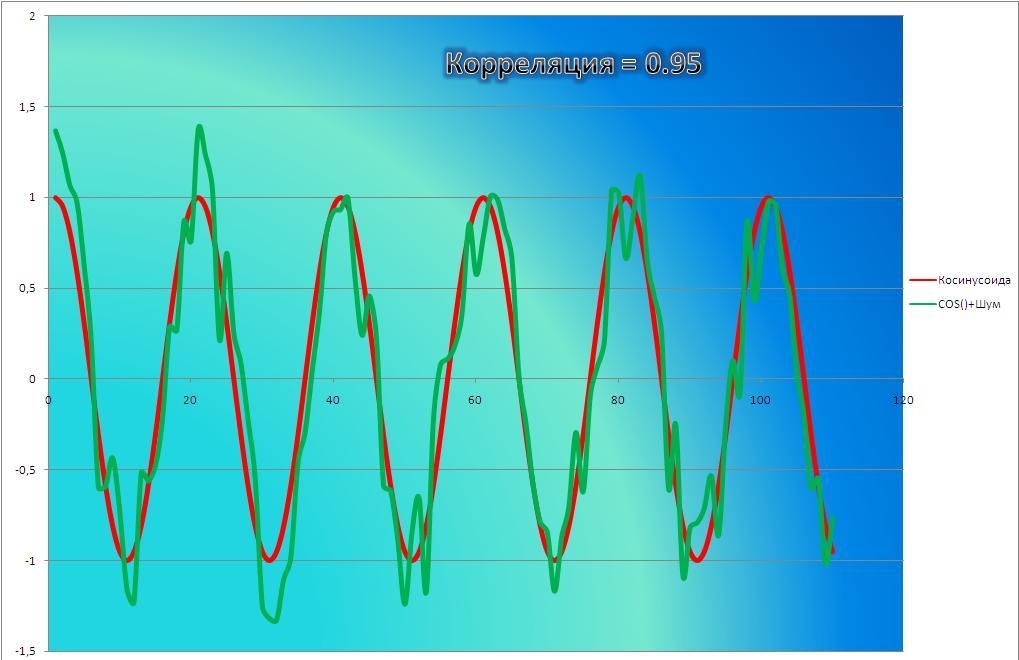

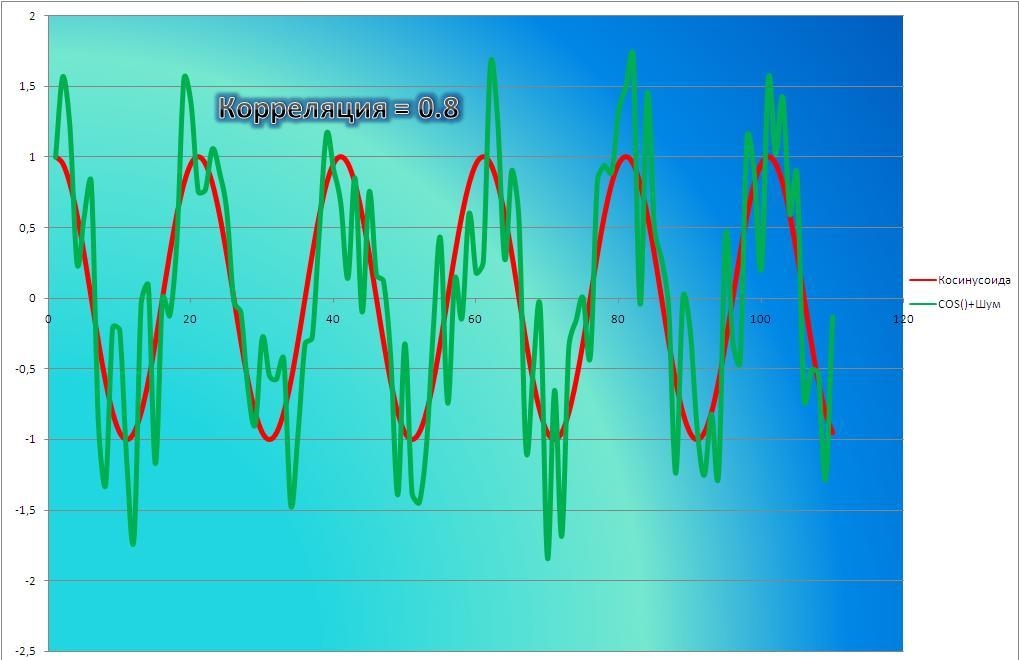

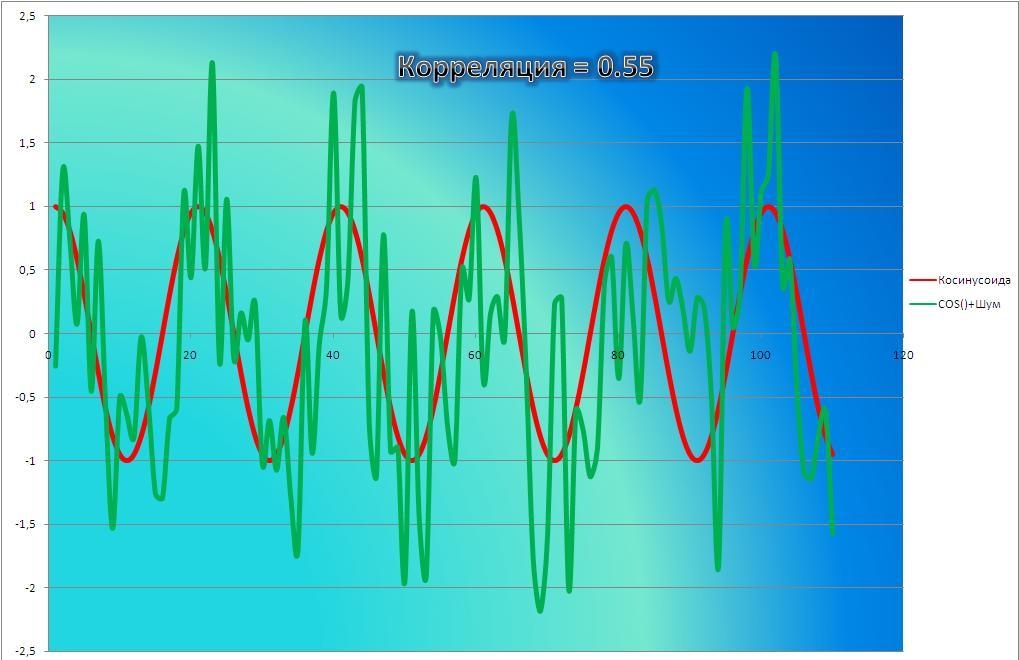

Under heavy noise conditions, extracting the correlation coefficient between two sets of stochastic variables is nontrivial, in particular where Canonical Correlation Analysis reports degraded correlation values due to the heavy noise contributions. A generalization of the approach is given elsewhere.[12]

In case of missing data, Garren derived the maximum likelihood estimator.[13]

Some distributions (e.g., stable distributions other than a normal distribution) do not have a defined variance.

Mathematical properties[edit]

The values of both the sample and population Pearson correlation coefficients are on or between −1 and 1. Correlations equal to +1 or −1 correspond to data points lying exactly on a line (in the case of the sample correlation), or to a bivariate distribution entirely supported on a line (in the case of the population correlation). The Pearson correlation coefficient is symmetric: corr(X,Y) = corr(Y,X).

A key mathematical property of the Pearson correlation coefficient is that it is invariant under separate changes in location and scale in the two variables. That is, we may transform X to a + bX and transform Y to c + dY, where a, b, c, and d are constants with b, d > 0, without changing the correlation coefficient. (This holds for both the population and sample Pearson correlation coefficients.) Note that more general linear transformations do change the correlation: see § Decorrelation of n random variables for an application of this.

Interpretation[edit]

The correlation coefficient ranges from −1 to 1. An absolute value of exactly 1 implies that a linear equation describes the relationship between X and Y perfectly, with all data points lying on a line. The correlation sign is determined by the regression slope: a value of +1 implies that all data points lie on a line for which Y increases as X increases, and vice versa for −1.[14] A value of 0 implies that there is no linear dependency between the variables.[15]

More generally, note that (Xi − X)(Yi − Y) is positive if and only if Xi and Yi lie on the same side of their respective means. Thus the correlation coefficient is positive if Xi and Yi tend to be simultaneously greater than, or simultaneously less than, their respective means. The correlation coefficient is negative (anti-correlation) if Xi and Yi tend to lie on opposite sides of their respective means. Moreover, the stronger either tendency is, the larger is the absolute value of the correlation coefficient.

Rodgers and Nicewander[16] cataloged thirteen ways of interpreting correlation or simple functions of it:

- Function of raw scores and means

- Standardized covariance

- Standardized slope of the regression line

- Geometric mean of the two regression slopes

- Square root of the ratio of two variances

- Mean cross-product of standardized variables

- Function of the angle between two standardized regression lines

- Function of the angle between two variable vectors

- Rescaled variance of the difference between standardized scores

- Estimated from the balloon rule

- Related to the bivariate ellipses of isoconcentration

- Function of test statistics from designed experiments

- Ratio of two means

Geometric interpretation[edit]

Regression lines for y = gX(x) [red] and x = gY(y) [blue]

For uncentered data, there is a relation between the correlation coefficient and the angle φ between the two regression lines, y = gX(x) and x = gY(y), obtained by regressing y on x and x on y respectively. (Here, φ is measured counterclockwise within the first quadrant formed around the lines’ intersection point if r > 0, or counterclockwise from the fourth to the second quadrant if r < 0.) One can show[17] that if the standard deviations are equal, then r = sec φ − tan φ, where sec and tan are trigonometric functions.

For centered data (i.e., data which have been shifted by the sample means of their respective variables so as to have an average of zero for each variable), the correlation coefficient can also be viewed as the cosine of the angle θ between the two observed vectors in N-dimensional space (for N observations of each variable)[18]

Both the uncentered (non-Pearson-compliant) and centered correlation coefficients can be determined for a dataset. As an example, suppose five countries are found to have gross national products of 1, 2, 3, 5, and 8 billion dollars, respectively. Suppose these same five countries (in the same order) are found to have 11%, 12%, 13%, 15%, and 18% poverty. Then let x and y be ordered 5-element vectors containing the above data: x = (1, 2, 3, 5, and y = (0.11, 0.12, 0.13, 0.15, 0.18).

By the usual procedure for finding the angle θ between two vectors (see dot product), the uncentered correlation coefficient is:

This uncentered correlation coefficient is identical with the cosine similarity.

Note that the above data were deliberately chosen to be perfectly correlated: y = 0.10 + 0.01 x. The Pearson correlation coefficient must therefore be exactly one. Centering the data (shifting x by ℰ(x) = 3.8 and y by ℰ(y) = 0.138) yields x = (−2.8, −1.8, −0.8, 1.2, 4.2) and y = (−0.028, −0.018, −0.008, 0.012, 0.042), from which

as expected.

Interpretation of the size of a correlation[edit]

This figure gives a sense of how the usefulness of a Pearson correlation for predicting values varies with its magnitude. Given jointly normal X, Y with correlation ρ,

Several authors have offered guidelines for the interpretation of a correlation coefficient.[19][20] However, all such criteria are in some ways arbitrary.[20] The interpretation of a correlation coefficient depends on the context and purposes. A correlation of 0.8 may be very low if one is verifying a physical law using high-quality instruments, but may be regarded as very high in the social sciences, where there may be a greater contribution from complicating factors.

Inference[edit]

Statistical inference based on Pearson’s correlation coefficient often focuses on one of the following two aims:

- One aim is to test the null hypothesis that the true correlation coefficient ρ is equal to 0, based on the value of the sample correlation coefficient r.

- The other aim is to derive a confidence interval that, on repeated sampling, has a given probability of containing ρ.

We discuss methods of achieving one or both of these aims below.

Using a permutation test[edit]

Permutation tests provide a direct approach to performing hypothesis tests and constructing confidence intervals. A permutation test for Pearson’s correlation coefficient involves the following two steps:

- Using the original paired data (xi, yi), randomly redefine the pairs to create a new data set (xi, yi′), where the i′ are a permutation of the set {1,…,n}. The permutation i′ is selected randomly, with equal probabilities placed on all n! possible permutations. This is equivalent to drawing the i′ randomly without replacement from the set {1, …, n}. In bootstrapping, a closely related approach, the i and the i′ are equal and drawn with replacement from {1, …, n};

- Construct a correlation coefficient r from the randomized data.

To perform the permutation test, repeat steps (1) and (2) a large number of times. The p-value for the permutation test is the proportion of the r values generated in step (2) that are larger than the Pearson correlation coefficient that was calculated from the original data. Here «larger» can mean either that the value is larger in magnitude, or larger in signed value, depending on whether a two-sided or one-sided test is desired.

Using a bootstrap[edit]

The bootstrap can be used to construct confidence intervals for Pearson’s correlation coefficient. In the «non-parametric» bootstrap, n pairs (xi, yi) are resampled «with replacement» from the observed set of n pairs, and the correlation coefficient r is calculated based on the resampled data. This process is repeated a large number of times, and the empirical distribution of the resampled r values are used to approximate the sampling distribution of the statistic. A 95% confidence interval for ρ can be defined as the interval spanning from the 2.5th to the 97.5th percentile of the resampled r values.

Standard error[edit]

If

where

Testing using Student’s t-distribution[edit]

Critical values of Pearson’s correlation coefficient that must be exceeded to be considered significantly nonzero at the 0.05 level.

For pairs from an uncorrelated bivariate normal distribution, the sampling distribution of the studentized Pearson’s correlation coefficient follows Student’s t-distribution with degrees of freedom n − 2. Specifically, if the underlying variables have a bivariate normal distribution, the variable

has a student’s t-distribution in the null case (zero correlation).[23] This holds approximately in case of non-normal observed values if sample sizes are large enough.[24] For determining the critical values for r the inverse function is needed:

Alternatively, large sample, asymptotic approaches can be used.

Another early paper[25] provides graphs and tables for general values of ρ, for small sample sizes, and discusses computational approaches.

In the case where the underlying variables are not normal, the sampling distribution of Pearson’s correlation coefficient follows a Student’s t-distribution, but the degrees of freedom are reduced.[26]

Using the exact distribution[edit]

For data that follow a bivariate normal distribution, the exact density function f(r) for the sample correlation coefficient r of a normal bivariate is[27][28][29]

where

In the special case when

where

Using the exact confidence distribution[edit]

Confidence intervals and tests can be calculated from a confidence distribution. An exact confidence density for ρ is[30]

where

Using the Fisher transformation[edit]

In practice, confidence intervals and hypothesis tests relating to ρ are usually carried out using the Fisher transformation,

F(r) approximately follows a normal distribution with

and standard error

where n is the sample size. The approximation error is lowest for a large sample size

Using the approximation, a z-score is

under the null hypothesis that

To obtain a confidence interval for ρ, we first compute a confidence interval for F(

The inverse Fisher transformation brings the interval back to the correlation scale.

For example, suppose we observe r = 0.7 with a sample size of n=50, and we wish to obtain a 95% confidence interval for ρ. The transformed value is arctanh(r) = 0.8673, so the confidence interval on the transformed scale is 0.8673 ± 1.96/√47, or (0.5814, 1.1532). Converting back to the correlation scale yields (0.5237, 0.8188).

In least squares regression analysis[edit]

The square of the sample correlation coefficient is typically denoted r2 and is a special case of the coefficient of determination. In this case, it estimates the fraction of the variance in Y that is explained by X in a simple linear regression. So if we have the observed dataset

where the

The two summands above are the fraction of variance in Y that is explained by X (right) and that is unexplained by X (left).

Next, we apply a property of least square regression models, that the sample covariance between

Thus

where

In the derivation above, the fact that

can be proved by noticing that the partial derivatives of the residual sum of squares (RSS) over β0 and β1 are equal to 0 in the least squares model, where

.

In the end, the equation can be written as:

where

The symbol

Sensitivity to the data distribution[edit]

Existence[edit]

The population Pearson correlation coefficient is defined in terms of moments, and therefore exists for any bivariate probability distribution for which the population covariance is defined and the marginal population variances are defined and are non-zero. Some probability distributions, such as the Cauchy distribution, have undefined variance and hence ρ is not defined if X or Y follows such a distribution. In some practical applications, such as those involving data suspected to follow a heavy-tailed distribution, this is an important consideration. However, the existence of the correlation coefficient is usually not a concern; for instance, if the range of the distribution is bounded, ρ is always defined.

Sample size[edit]

- If the sample size is moderate or large and the population is normal, then, in the case of the bivariate normal distribution, the sample correlation coefficient is the maximum likelihood estimate of the population correlation coefficient, and is asymptotically unbiased and efficient, which roughly means that it is impossible to construct a more accurate estimate than the sample correlation coefficient.

- If the sample size is large and the population is not normal, then the sample correlation coefficient remains approximately unbiased, but may not be efficient.

- If the sample size is large, then the sample correlation coefficient is a consistent estimator of the population correlation coefficient as long as the sample means, variances, and covariance are consistent (which is guaranteed when the law of large numbers can be applied).

- If the sample size is small, then the sample correlation coefficient r is not an unbiased estimate of ρ.[10] The adjusted correlation coefficient must be used instead: see elsewhere in this article for the definition.

- Correlations can be different for imbalanced dichotomous data when there is variance error in sample.[31]

Robustness[edit]

Like many commonly used statistics, the sample statistic r is not robust,[32] so its value can be misleading if outliers are present.[33][34] Specifically, the PMCC is neither distributionally robust,[citation needed] nor outlier resistant[32] (see Robust statistics § Definition). Inspection of the scatterplot between X and Y will typically reveal a situation where lack of robustness might be an issue, and in such cases it may be advisable to use a robust measure of association. Note however that while most robust estimators of association measure statistical dependence in some way, they are generally not interpretable on the same scale as the Pearson correlation coefficient.

Statistical inference for Pearson’s correlation coefficient is sensitive to the data distribution. Exact tests, and asymptotic tests based on the Fisher transformation can be applied if the data are approximately normally distributed, but may be misleading otherwise. In some situations, the bootstrap can be applied to construct confidence intervals, and permutation tests can be applied to carry out hypothesis tests. These non-parametric approaches may give more meaningful results in some situations where bivariate normality does not hold. However the standard versions of these approaches rely on exchangeability of the data, meaning that there is no ordering or grouping of the data pairs being analyzed that might affect the behavior of the correlation estimate.

A stratified analysis is one way to either accommodate a lack of bivariate normality, or to isolate the correlation resulting from one factor while controlling for another. If W represents cluster membership or another factor that it is desirable to control, we can stratify the data based on the value of W, then calculate a correlation coefficient within each stratum. The stratum-level estimates can then be combined to estimate the overall correlation while controlling for W.[35]

Variants[edit]

Variations of the correlation coefficient can be calculated for different purposes. Here are some examples.

Adjusted correlation coefficient[edit]

The sample correlation coefficient r is not an unbiased estimate of ρ. For data that follows a bivariate normal distribution, the expectation E[r] for the sample correlation coefficient r of a normal bivariate is[36]

therefore r is a biased estimator of

The unique minimum variance unbiased estimator radj is given by[37]

-

(1)

where:

An approximately unbiased estimator radj can be obtained[citation needed] by truncating E[r] and solving this truncated equation:

-

(2)

An approximate solution[citation needed] to equation (2) is:

-

(3)

where in (3):

are defined as above,

- radj is a suboptimal estimator,[citation needed][clarification needed]

- radj can also be obtained by maximizing log(f(r)),

- radj has minimum variance for large values of n,

- radj has a bias of order 1⁄(n − 1).

Another proposed[10] adjusted correlation coefficient is:[citation needed]

Note that radj ≈ r for large values of n.

Weighted correlation coefficient[edit]

Suppose observations to be correlated have differing degrees of importance that can be expressed with a weight vector w. To calculate the correlation between vectors x and y with the weight vector w (all of length n),[38][39]

- Weighted mean:

- Weighted covariance

- Weighted correlation

Reflective correlation coefficient[edit]

The reflective correlation is a variant of Pearson’s correlation in which the data are not centered around their mean values.[citation needed] The population reflective correlation is

The reflective correlation is symmetric, but it is not invariant under translation:

The sample reflective correlation is equivalent to cosine similarity:

The weighted version of the sample reflective correlation is

Scaled correlation coefficient[edit]

Scaled correlation is a variant of Pearson’s correlation in which the range of the data is restricted intentionally and in a controlled manner to reveal correlations between fast components in time series.[40] Scaled correlation is defined as average correlation across short segments of data.

Let

The scaled correlation across the entire signals

where

By choosing the parameter

Pearson’s distance[edit]

A distance metric for two variables X and Y known as Pearson’s distance can be defined from their correlation coefficient as[41]

Considering that the Pearson correlation coefficient falls between [−1, +1], the Pearson distance lies in [0, 2]. The Pearson distance has been used in cluster analysis and data detection for communications and storage with unknown gain and offset.[42]

The Pearson «distance» defined this way assigns distance greater than 1 to negative correlations. In reality, both strong positive correlation and negative correlations are meaningful, so care must be taken when Pearson «distance» is used for nearest neighbor algorithm as such algorithm will only include neighbors with positive correlation and exclude neighbors with negative correlation. Alternatively, an absolute valued distance:

Circular correlation coefficient[edit]

For variables X = {x1,…,xn} and Y = {y1,…,yn} that are defined on the unit circle [0, 2π), it is possible to define a circular analog of Pearson’s coefficient.[43] This is done by transforming data points in X and Y with a sine function such that the correlation coefficient is given as:

where

Partial correlation[edit]

If a population or data-set is characterized by more than two variables, a partial correlation coefficient measures the strength of dependence between a pair of variables that is not accounted for by the way in which they both change in response to variations in a selected subset of the other variables.

Decorrelation of n random variables[edit]

It is always possible to remove the correlations between all pairs of an arbitrary number of random variables by using a data transformation, even if the relationship between the variables is nonlinear. A presentation of this result for population distributions is given by Cox & Hinkley.[44]

A corresponding result exists for reducing the sample correlations to zero. Suppose a vector of n random variables is observed m times. Let X be a matrix where

where an exponent of −+1⁄2 represents the matrix square root of the inverse of a matrix. The correlation matrix of T will be the identity matrix. If a new data observation x is a row vector of n elements, then the same transform can be applied to x to get the transformed vectors d and t:

This decorrelation is related to principal components analysis for multivariate data.

Software implementations[edit]

- R’s statistics base-package implements the correlation coefficient with

cor(x, y), or (with the P value also) withcor.test(x, y). - The SciPy Python library via

pearsonr(x, y). - The Pandas Python library implements Pearson correlation coefficient calculation as the default option for the method

pandas.DataFrame.corr - Wolfram Mathematica via the

Correlationfunction, or (with the P value) withCorrelationTest. - The Boost C++ library via the

correlation_coefficientfunction. - Excel has an in-built

correl(array1, array2)function for calculationg the pearson’s correlation coefficient.

See also[edit]

- Anscombe’s quartet

- Association (statistics)

- Coefficient of colligation

- Yule’s Q

- Yule’s Y

- Concordance correlation coefficient

- Correlation and dependence

- Correlation ratio

- Disattenuation

- Distance correlation

- Maximal information coefficient

- Multiple correlation

- Normally distributed and uncorrelated does not imply independent

- Odds ratio

- Partial correlation

- Polychoric correlation

- Quadrant count ratio

- RV coefficient

- Spearman’s rank correlation coefficient

Footnotes[edit]

- ^ As early as 1877, Galton was using the term «reversion» and the symbol «r» for what would become «regression».[3][4][5]

References[edit]

- ^ «SPSS Tutorials: Pearson Correlation».

- ^ «Correlation Coefficient: Simple Definition, Formula, Easy Steps». Statistics How To.

- ^ Galton, F. (5–19 April 1877). «Typical laws of heredity». Nature. 15 (388, 389, 390): 492–495, 512–514, 532–533. Bibcode:1877Natur..15..492.. doi:10.1038/015492a0. S2CID 4136393. In the «Appendix» on page 532, Galton uses the term «reversion» and the symbol r.

- ^ Galton, F. (24 September 1885). «The British Association: Section II, Anthropology: Opening address by Francis Galton, F.R.S., etc., President of the Anthropological Institute, President of the Section». Nature. 32 (830): 507–510.

- ^ Galton, F. (1886). «Regression towards mediocrity in hereditary stature». Journal of the Anthropological Institute of Great Britain and Ireland. 15: 246–263. doi:10.2307/2841583. JSTOR 2841583.

- ^ Pearson, Karl (20 June 1895). «Notes on regression and inheritance in the case of two parents». Proceedings of the Royal Society of London. 58: 240–242. Bibcode:1895RSPS…58..240P.

- ^ Stigler, Stephen M. (1989). «Francis Galton’s account of the invention of correlation». Statistical Science. 4 (2): 73–79. doi:10.1214/ss/1177012580. JSTOR 2245329.

- ^ «Analyse mathematique sur les probabilités des erreurs de situation d’un point». Mem. Acad. Roy. Sci. Inst. France. Sci. Math, et Phys. (in French). 9: 255–332. 1844 – via Google Books.

- ^ Wright, S. (1921). «Correlation and causation». Journal of Agricultural Research. 20 (7): 557–585.

- ^ a b c d e Real Statistics Using Excel: Correlation: Basic Concepts, retrieved 22 February 2015

- ^ Weisstein, Eric W. «Statistical Correlation». mathworld.wolfram.com. Retrieved 22 August 2020.

- ^ Moriya, N. (2008). «Noise-related multivariate optimal joint-analysis in longitudinal stochastic processes». In Yang, Fengshan (ed.). Progress in Applied Mathematical Modeling. Nova Science Publishers, Inc. pp. 223–260. ISBN 978-1-60021-976-4.

- ^ Garren, Steven T. (15 June 1998). «Maximum likelihood estimation of the correlation coefficient in a bivariate normal model, with missing data». Statistics & Probability Letters. 38 (3): 281–288. doi:10.1016/S0167-7152(98)00035-2.

- ^ «2.6 — (Pearson) Correlation Coefficient r». STAT 462. Retrieved 10 July 2021.

- ^ «Introductory Business Statistics: The Correlation Coefficient r». opentextbc.ca. Retrieved 21 August 2020.

- ^ Rodgers; Nicewander (1988). «Thirteen ways to look at the correlation coefficient» (PDF). The American Statistician. 42 (1): 59–66. doi:10.2307/2685263. JSTOR 2685263.

- ^ Schmid, John Jr. (December 1947). «The relationship between the coefficient of correlation and the angle included between regression lines». The Journal of Educational Research. 41 (4): 311–313. doi:10.1080/00220671.1947.10881608. JSTOR 27528906.

- ^ Rummel, R.J. (1976). «Understanding Correlation». ch. 5 (as illustrated for a special case in the next paragraph).

- ^ Buda, Andrzej; Jarynowski, Andrzej (December 2010). Life Time of Correlations and its Applications. Wydawnictwo Niezależne. pp. 5–21. ISBN 9788391527290.

- ^ a b Cohen, J. (1988). Statistical Power Analysis for the Behavioral Sciences (2nd ed.).

- ^ Bowley, A. L. (1928). «The Standard Deviation of the Correlation Coefficient». Journal of the American Statistical Association. 23 (161): 31–34. doi:10.2307/2277400. ISSN 0162-1459. JSTOR 2277400.

- ^ «Derivation of the standard error for Pearson’s correlation coefficient». Cross Validated. Retrieved 30 July 2021.

- ^ Rahman, N. A. (1968) A Course in Theoretical Statistics, Charles Griffin and Company, 1968

- ^ Kendall, M. G., Stuart, A. (1973) The Advanced Theory of Statistics, Volume 2: Inference and Relationship, Griffin. ISBN 0-85264-215-6 (Section 31.19)

- ^ Soper, H.E.; Young, A.W.; Cave, B.M.; Lee, A.; Pearson, K. (1917). «On the distribution of the correlation coefficient in small samples. Appendix II to the papers of «Student» and R.A. Fisher. A co-operative study». Biometrika. 11 (4): 328–413. doi:10.1093/biomet/11.4.328.

- ^ Davey, Catherine E.; Grayden, David B.; Egan, Gary F.; Johnston, Leigh A. (January 2013). «Filtering induces correlation in fMRI resting state data». NeuroImage. 64: 728–740. doi:10.1016/j.neuroimage.2012.08.022. hdl:11343/44035. PMID 22939874. S2CID 207184701.

- ^ Hotelling, Harold (1953). «New Light on the Correlation Coefficient and its Transforms». Journal of the Royal Statistical Society. Series B (Methodological). 15 (2): 193–232. doi:10.1111/j.2517-6161.1953.tb00135.x. JSTOR 2983768.

- ^ Kenney, J.F.; Keeping, E.S. (1951). Mathematics of Statistics. Vol. Part 2 (2nd ed.). Princeton, NJ: Van Nostrand.

- ^ Weisstein, Eric W. «Correlation Coefficient—Bivariate Normal Distribution». mathworld.wolfram.com.

- ^ Taraldsen, Gunnar (2020). «Confidence in Correlation». doi:10.13140/RG.2.2.23673.49769.

- ^ Lai, Chun Sing; Tao, Yingshan; Xu, Fangyuan; Ng, Wing W.Y.; Jia, Youwei; Yuan, Haoliang; Huang, Chao; Lai, Loi Lei; Xu, Zhao; Locatelli, Giorgio (January 2019). «A robust correlation analysis framework for imbalanced and dichotomous data with uncertainty» (PDF). Information Sciences. 470: 58–77. doi:10.1016/j.ins.2018.08.017. S2CID 52878443.

- ^ a b Wilcox, Rand R. (2005). Introduction to robust estimation and hypothesis testing. Academic Press.

- ^ Devlin, Susan J.; Gnanadesikan, R.; Kettenring J.R. (1975). «Robust estimation and outlier detection with correlation coefficients». Biometrika. 62 (3): 531–545. doi:10.1093/biomet/62.3.531. JSTOR 2335508.

- ^ Huber, Peter. J. (2004). Robust Statistics. Wiley.[page needed]

- ^ Katz., Mitchell H. (2006) Multivariable Analysis – A Practical Guide for Clinicians. 2nd Edition. Cambridge University Press. ISBN 978-0-521-54985-1. ISBN 0-521-54985-X

- ^ Hotelling, H. (1953). «New Light on the Correlation Coefficient and its Transforms». Journal of the Royal Statistical Society. Series B (Methodological). 15 (2): 193–232. doi:10.1111/j.2517-6161.1953.tb00135.x. JSTOR 2983768.

- ^ Olkin, Ingram; Pratt,John W. (March 1958). «Unbiased Estimation of Certain Correlation Coefficients». The Annals of Mathematical Statistics. 29 (1): 201–211. doi:10.1214/aoms/1177706717. JSTOR 2237306..

- ^ «Re: Compute a weighted correlation». sci.tech-archive.net.

- ^ «Weighted Correlation Matrix – File Exchange – MATLAB Central».

- ^ Nikolić, D; Muresan, RC; Feng, W; Singer, W (2012). «Scaled correlation analysis: a better way to compute a cross-correlogram» (PDF). European Journal of Neuroscience. 35 (5): 1–21. doi:10.1111/j.1460-9568.2011.07987.x. PMID 22324876. S2CID 4694570.

- ^ Fulekar (Ed.), M.H. (2009) Bioinformatics: Applications in Life and Environmental Sciences, Springer (pp. 110) ISBN 1-4020-8879-5

- ^ Immink, K. Schouhamer; Weber, J. (October 2010). «Minimum Pearson distance detection for multilevel channels with gain and / or offset mismatch». IEEE Transactions on Information Theory. 60 (10): 5966–5974. CiteSeerX 10.1.1.642.9971. doi:10.1109/tit.2014.2342744. S2CID 1027502. Retrieved 11 February 2018.