Результат любого измерения не определён однозначно и имеет случайную составляющую.

Поэтому адекватным языком для описания погрешностей является язык вероятностей.

Тот факт, что значение некоторой величины «случайно», не означает, что

она может принимать совершенно произвольные значения. Ясно, что частоты, с которыми

возникает те или иные значения, различны. Вероятностные законы, которым

подчиняются случайные величины, называют распределениями.

2.1 Случайная величина

Случайной будем называть величину, значение которой не может быть достоверно определено экспериментатором. Чаще всего подразумевается, что случайная величина будет изменяться при многократном повторении одного и того же эксперимента. При интерпретации результатов измерений в физических экспериментах, обычно случайными также считаются величины, значение которых является фиксированным, но не известно экспериментатору. Например смещение нуля шкалы прибора. Для формализации работы со случайными величинами используют понятие вероятности. Численное значение вероятности того, что какая-то величина примет то или иное значение определяется либо как относительная частота наблюдения того или иного значения при повторении опыта большое количество раз, либо как оценка на основе данных других экспериментов.

Замечание.

Хотя понятия вероятности и случайной величины являются основополагающими, в литературе нет единства в их определении. Обсуждение формальных тонкостей или построение строгой теории лежит за пределами данного пособия. Поэтому на начальном этапе лучше использовать «интуитивное» понимание этих сущностей. Заинтересованным читателям рекомендуем обратиться к специальной литературе: [5].

Рассмотрим случайную физическую величину x, которая при измерениях может

принимать непрерывный набор значений. Пусть

P[x0,x0+δx] — вероятность того, что результат окажется вблизи

некоторой точки x0 в пределах интервала δx: x∈[x0,x0+δx].

Устремим интервал

δx к нулю. Нетрудно понять, что вероятность попасть в этот интервал

также будет стремиться к нулю. Однако отношение

w(x0)=P[x0,x0+δx]δx будет оставаться конечным.

Функцию w(x) называют плотностью распределения вероятности или кратко

распределением непрерывной случайной величины x.

Замечание. В математической литературе распределением часто называют не функцию

w(x), а её интеграл W(x)=∫w(x)𝑑x. Такую функцию в физике принято

называть интегральным или кумулятивным распределением. В англоязычной литературе

для этих функций принято использовать сокращения:

pdf (probability distribution function) и

cdf (cumulative distribution function)

соответственно.

Гистограммы.

Проиллюстрируем наглядно понятие плотности распределения. Результат

большого числа измерений случайной величины удобно представить с помощью

специального типа графика — гистограммы.

Для этого область значений x, размещённую на оси абсцисс, разобьём на

равные малые интервалы — «корзины» или «бины» (англ. bins)

некоторого размера h. По оси ординат будем откладывать долю измерений w,

результаты которых попадают в соответствующую корзину. А именно,

пусть k — номер корзины; nk — число измерений, попавших

в диапазон x∈[kh,(k+1)h]. Тогда на графике изобразим «столбик»

шириной h и высотой wk=nk/n.

В результате получим картину, подобную изображённой на рис. 2.1.

σ=1,0, h=0,1, n=104)

Высоты построенных столбиков будут приближённо соответствовать значению

плотности распределения w(x) вблизи соответствующей точки x.

Если устремить число измерений к бесконечности (n→∞), а ширину корзин

к нулю (h→0), то огибающая гистограммы будет стремиться к некоторой

непрерывной функции w(x).

Самые высокие столбики гистограммы будут группироваться вблизи максимума

функции w(x) — это наиболее вероятное значение случайной величины.

Если отклонения в положительную и отрицательную стороны равновероятны,

то гистограмма будет симметрична — в таком случае среднее значение ⟨x⟩

также будет лежать вблизи этого максимума. Ширина гистограммы будет характеризовать разброс

значений случайной величины — по порядку величины

она, как правило, близка к среднеквадратичному отклонению sx.

Свойства распределений.

Из определения функции w(x) следует, что вероятность получить в результате

эксперимента величину x в диапазоне от a до b

можно найти, вычислив интеграл:

| Px∈[a,b]=∫abw(x)𝑑x. | (2.1) |

Согласно определению вероятности, сумма вероятностей для всех возможных случаев

всегда равна единице. Поэтому интеграл распределения w(x) по всей области

значений x (то есть суммарная площадь под графиком w(x)) равен единице:

Это соотношение называют условием нормировки.

Среднее и дисперсия.

Вычислим среднее по построенной гистограмме. Если размер корзин

h достаточно мал, все измерения в пределах одной корзины можно считать примерно

одинаковыми. Тогда среднее арифметическое всех результатов можно вычислить как

Переходя к пределу, получим следующее определение среднего значения

случайной величины:

где интегрирование ведётся по всей области значений x.

В теории вероятностей x¯ также называют математическим ожиданием

распределения.

Величину

| σ2=(x-x¯)2¯=∫(x-x¯)2w𝑑x | (2.3) |

называют дисперсией распределения. Значение σ есть

срекднеквадратичное отклонение в пределе n→∞. Оно имеет ту

же размерность, что и сама величина x и характеризует разброс распределения.

Именно эту величину, как правило, приводят как характеристику погрешности

измерения x.

Доверительный интервал.

Обозначим как P|Δx|<δ вероятность

того, что отклонение от среднего Δx=x-x¯ составит величину,

не превосходящую по модулю значение δ:

| P|Δx|<δ=∫x¯-δx¯+δw(x)𝑑x. | (2.4) |

Эту величину называют доверительной вероятностью для

доверительного интервала |x-x¯|≤δ.

2.2 Нормальное распределение

Одним из наиболее примечательных результатов теории вероятностей является

так называемая центральная предельная теорема. Она утверждает,

что сумма большого количества независимых случайных слагаемых, каждое

из которых вносит в эту сумму относительно малый вклад, подчиняется

универсальному закону, не зависимо от того, каким вероятностным законам

подчиняются её составляющие, — так называемому нормальному

распределению (или распределению Гаусса).

Доказательство теоремы довольно громоздко и мы его не приводим (его можно найти

в любом учебнике по теории вероятностей). Остановимся

кратко на том, что такое нормальное распределение и его основных свойствах.

Плотность нормального распределения выражается следующей формулой:

| w𝒩(x)=12πσe-(x-x¯)22σ2. | (2.5) |

Здесь x¯ и σ

— параметры нормального распределения: x¯ равно

среднему значению x, a σ —

среднеквадратичному отклонению, вычисленным в пределе n→∞.

Как видно из рис. 2.1, распределение представляет собой

симметричный

«колокол», положение вершины которого

соответствует x¯ (ввиду симметрии оно же

совпадает с наиболее вероятным значением — максимумом

функции w𝒩(x)).

При значительном отклонении x от среднего величина

w𝒩(x)

очень быстро убывает. Это означает, что вероятность встретить отклонения,

существенно большие, чем σ, оказывается пренебрежимо

мала. Ширина «колокола» по порядку величины

равна σ — она характеризует «разброс»

экспериментальных данных относительно среднего значения.

Замечание. Точки x=x¯±σ являются точками

перегиба графика w(x) (в них вторая производная по x

обращается в нуль, w′′=0), а их положение по высоте составляет

w(x¯±σ)/w(x¯)=e-1/2≈0,61

от высоты вершины.

Универсальный характер центральной предельной теоремы позволяет широко

применять на практике нормальное (гауссово) распределение для обработки

результатов измерений, поскольку часто случайные погрешности складываются из

множества случайных независимых факторов. Заметим, что на практике

для приближённой оценки параметров нормального распределения

случайной величины используются выборочные значения среднего

и дисперсии: x¯≈⟨x⟩, sx≈σx.

Вычислим некоторые доверительные вероятности (2.4) для нормально Замечание. Значение интеграла вида ∫e-x2/2𝑑x Вероятность того, что результат отдельного измерения x окажется Вероятность отклонения в пределах x¯±2σ: а в пределах x¯±3σ: Иными словами, при большом числе измерений нормально распределённой Пример. В сообщениях об открытии бозона Хиггса на Большом адронном коллайдере Полученные значения доверительных вероятностей используются при означает, что измеренное значение лежит в диапазоне (доверительном Замечание. Хотя нормальный закон распределения встречается на практике довольно Теперь мы можем дать количественный критерий для сравнения двух измеренных Пусть x1 и x2 (x1≠x2) измерены с Допустим, одна из величин известна с существенно большей точностью: Пусть погрешности измерений сравнимы по порядку величины: Замечание. Изложенные здесь соображения применимы, только если x¯ иx-x0σ2=2w(x)σ1=1

Доверительные вероятности.

распределённых случайных величин.

(его называют интегралом ошибок) в элементарных функциях не выражается,

но легко находится численно.

в пределах x¯±σ оказывается равна

P|Δx|<σ=∫x¯-σx¯+σw𝒩𝑑x≈0,68.

величины можно ожидать, что лишь треть измерений выпадут за пределы интервала

[x¯-σ,x¯+σ]. При этом около 5%

измерений выпадут за пределы [x¯-2σ;x¯+2σ],

и лишь 0,27% окажутся за пределами

[x¯-3σ;x¯+3σ].

говорилось о том, что исследователи ждали подтверждение результатов

с точностью «5 сигма». Используя нормальное распределение (2.5)

нетрудно посчитать, что они использовали доверительную вероятность

P≈1-5,7⋅10-7=0,99999943. Такую точность можно назвать фантастической.

стандартной записи результатов измерений. В физических измерениях

(в частности, в учебной лаборатории), как правило, используется P=0,68,

то есть, запись

интервале) x∈[x¯-δx;x¯+δx] с

вероятностью 68%. Таким образом погрешность ±δx считается

равной одному среднеквадратичному отклонению: δx=σ.

В технических измерениях чаще используется P=0,95, то есть под

абсолютной погрешностью имеется в виду удвоенное среднеквадратичное

отклонение, δx=2σ. Во избежание разночтений доверительную

вероятность следует указывать отдельно.

часто, стоит помнить, что он реализуется далеко не всегда.

Полученные выше соотношения для вероятностей попадания значений в

доверительные интервалы можно использовать в качестве простейшего

признака нормальности распределения: в частности, если количество попадающих

в интервал ±σ результатов существенно отличается от 2/3 — это повод

для более детального исследования закона распределения ошибок.Сравнение результатов измерений.

величин или двух результатов измерения одной и той же величины.

погрешностями σ1 и σ2 соответственно.

Ясно, что если различие результатов |x2-x1| невелико,

его можно объяснить просто случайными отклонениями.

Если же теория предсказывает, что вероятность обнаружить такое отклонение

слишком мала, различие результатов следует признать значимым.

Предварительно необходимо договориться о соответствующем граничном значении

вероятности. Универсального значения здесь быть не может,

поэтому приходится полагаться на субъективный выбор исследователя. Часто

в качестве «разумной» границы выбирают вероятность 5%,

что, как видно из изложенного выше, для нормального распределения

соответствует отклонению более, чем на 2σ.

σ2≪σ1 (например, x1 — результат, полученный

студентом в лаборатории, x2 — справочное значение).

Поскольку σ2 мало, x2 можно принять за «истинное»:

x2≈x¯. Предполагая, что погрешность измерения

x1 подчиняется нормальному закону с и дисперсией σ12,

можно утверждать, что

различие считают будет значимы, если

σ1∼σ2. В теории вероятностей показывается, что

линейная комбинация нормально распределённых величин также имеет нормальное

распределение с дисперсией σ2=σ12+σ22

(см. также правила сложения погрешностей (2.7)). Тогда

для проверки гипотезы о том, что x1 и x2 являются измерениями

одной и той же величины, нужно вычислить, является ли значимым отклонение

|x1-x2| от нуля при σ=σ12+σ22.

Пример. Два студента получили следующие значения для теплоты испарения

некоторой жидкости: x1=40,3±0,2 кДж/моль и

x2=41,0±0,3 кДж/моль, где погрешность соответствует

одному стандартному отклонению. Можно ли утверждать, что они исследовали

одну и ту же жидкость?

Имеем наблюдаемую разность |x1-x2|=0,7 кДж/моль,

среднеквадратичное отклонение для разности

σ=0,22+0,32=0,36 кДж/моль.

Их отношение |x2-x1|σ≈2. Из

свойств нормального распределения находим вероятность того, что измерялась

одна и та же величина, а различия в ответах возникли из-за случайных

ошибок: P≈5%. Ответ на вопрос, «достаточно»

ли мала или велика эта вероятность, остаётся на усмотрение исследователя.

его стандартное отклонение σ получены на основании достаточно

большой выборки n≫1 (или заданы точно). При небольшом числе измерений

(n≲10) выборочные средние ⟨x⟩ и среднеквадратичное отклонение

sx сами имеют довольно большую ошибку, а

их распределение будет описываться не нормальным законом, а так

называемым t-распределением Стъюдента. В частности, в зависимости от

значения n интервал ⟨x⟩±sx будет соответствовать несколько

меньшей доверительной вероятности, чем P=0,68. Особенно резко различия

проявляются при высоких уровнях доверительных вероятностей P→1.

2.3 Независимые величины

Величины x и y называют независимыми если результат измерения одной

из них никак не влияет на результат измерения другой. Для таких величин вероятность того, что x окажется в некоторой области X, и одновременно y — в области Y,

равна произведению соответствующих вероятностей:

Обозначим отклонения величин от их средних как Δx=x-x¯ и

Δy=y-y¯.

Средние значения этих отклонений равны, очевидно, нулю: Δx¯=x¯-x¯=0,

Δy¯=0. Из независимости величин x и y следует,

что среднее значение от произведения Δx⋅Δy¯

равно произведению средних Δx¯⋅Δy¯

и, следовательно, равно нулю:

| Δx⋅Δy¯=Δx¯⋅Δy¯=0. | (2.6) |

Пусть измеряемая величина z=x+y складывается из двух независимых

случайных слагаемых x и y, для которых известны средние

x¯ и y¯, и их среднеквадратичные погрешности

σx и σy. Непосредственно из определения (1.1)

следует, что среднее суммы равно сумме средних:

Найдём дисперсию σz2. В силу независимости имеем

| Δz2¯=Δx2¯+Δy2¯+2Δx⋅Δy¯≈Δx2¯+Δy2¯, |

то есть:

Таким образом, при сложении независимых величин их погрешности

складываются среднеквадратичным образом.

Подчеркнём, что для справедливости соотношения (2.7)

величины x и y не обязаны быть нормально распределёнными —

достаточно существования конечных значений их дисперсий. Однако можно

показать, что если x и y распределены нормально, нормальным

будет и распределение их суммы.

Замечание. Требование независимости

слагаемых является принципиальным. Например, положим y=x. Тогда

z=2x. Здесь y и x, очевидно, зависят друг от друга. Используя

(2.7), находим σ2x=2σx,

что, конечно, неверно — непосредственно из определения

следует, что σ2x=2σx.

Отдельно стоит обсудить математическую структуру формулы (2.7).

Если одна из погрешностей много больше другой, например,

σx≫σy,

то меньшей погрешностью можно пренебречь, σx+y≈σx.

С другой стороны, если два источника погрешностей имеют один порядок

σx∼σy, то и σx+y∼σx∼σy.

Эти обстоятельства важны при планирования эксперимента: как правило,

величина, измеренная наименее точно, вносит наибольший вклад в погрешность

конечного результата. При этом, пока не устранены наиболее существенные

ошибки, бессмысленно гнаться за повышением точности измерения остальных

величин.

Пример. Пусть σy=σx/3,

тогда σz=σx1+19≈1,05σx,

то есть при различии двух погрешностей более, чем в 3 раза, поправка

к погрешности составляет менее 5%, и уже нет особого смысла в учёте

меньшей погрешности: σz≈σx. Это утверждение

касается сложения любых независимых источников погрешностей в эксперименте.

2.4 Погрешность среднего

Выборочное среднее арифметическое значение ⟨x⟩, найденное

по результатам n измерений, само является случайной величиной.

Действительно, если поставить серию одинаковых опытов по n измерений,

то в каждом опыте получится своё среднее значение, отличающееся от

предельного среднего x¯.

Вычислим среднеквадратичную погрешность среднего арифметического

σ⟨x⟩.

Рассмотрим вспомогательную сумму n слагаемых

Если {xi} есть набор независимых измерений

одной и той же физической величины, то мы можем, применяя результат

(2.7) предыдущего параграфа, записать

| σZ=σx12+σx22+…+σxn2=nσx, |

поскольку под корнем находится n одинаковых слагаемых. Отсюда с

учётом ⟨x⟩=Z/n получаем

Таким образом, погрешность среднего значения x по результатам

n независимых измерений оказывается в n раз меньше погрешности

отдельного измерения. Это один из важнейших результатов, позволяющий

уменьшать случайные погрешности эксперимента за счёт многократного

повторения измерений.

Подчеркнём отличия между σx и σ⟨x⟩:

величина σx — погрешность отдельного

измерения — является характеристикой разброса значений

в совокупности измерений {xi}, i=1..n. При

нормальном законе распределения примерно 68% измерений попадают в

интервал ⟨x⟩±σx;

величина σ⟨x⟩ — погрешность

среднего — характеризует точность, с которой определено

среднее значение измеряемой физической величины ⟨x⟩ относительно

предельного («истинного») среднего x¯;

при этом с доверительной вероятностью P=68% искомая величина x¯

лежит в интервале

⟨x⟩-σ⟨x⟩<x¯<⟨x⟩+σ⟨x⟩.

2.5 Результирующая погрешность опыта

Пусть для некоторого результата измерения известна оценка его максимальной

систематической погрешности Δсист и случайная

среднеквадратичная

погрешность σслуч. Какова «полная»

погрешность измерения?

Предположим для простоты, что измеряемая величина в принципе

может быть определена сколь угодно точно, так что можно говорить о

некотором её «истинном» значении xист

(иными словами, погрешность результата связана в основном именно с

процессом измерения). Назовём полной погрешностью измерения

среднеквадратичное значения отклонения от результата измерения от

«истинного»:

Отклонение x-xист можно представить как сумму случайного

отклонения от среднего δxслуч=x-x¯

и постоянной (но, вообще говоря, неизвестной) систематической составляющей

δxсист=x¯-xист=const:

Причём случайную составляющую можно считать независимой от систематической.

В таком случае из (2.7) находим:

| σполн2=⟨δxсист2⟩+⟨δxслуч2⟩≤Δсист2+σслуч2. | (2.9) |

Таким образом, для получения максимального значения полной

погрешности некоторого измерения нужно квадратично сложить максимальную

систематическую и случайную погрешности.

Если измерения проводятся многократно, то согласно (2.8)

случайная составляющая погрешности может быть уменьшена, а систематическая

составляющая при этом остаётся неизменной:

Отсюда следует важное практическое правило

(см. также обсуждение в п. 2.3): если случайная погрешность измерений

в 2–3 раза меньше предполагаемой систематической, то

нет смысла проводить многократные измерения в попытке уменьшить погрешность

всего эксперимента. В такой ситуации измерения достаточно повторить

2–3 раза — чтобы убедиться в повторяемости результата, исключить промахи

и проверить, что случайная ошибка действительно мала.

В противном случае повторение измерений может иметь смысл до

тех пор, пока погрешность среднего

σ⟨x⟩=σxn

не станет меньше систематической.

Замечание. Поскольку конкретная

величина систематической погрешности, как правило, не известна, её

можно в некотором смысле рассматривать наравне со случайной —

предположить, что её величина была определена по некоторому случайному

закону перед началом измерений (например, при изготовлении линейки

на заводе произошло некоторое случайное искажение шкалы). При такой

трактовке формулу (2.9) можно рассматривать просто

как частный случай формулы сложения погрешностей независимых величин

(2.7).

Подчеркнем, что вероятностный закон, которому подчиняется

систематическая ошибка, зачастую неизвестен. Поэтому неизвестно и

распределение итогового результата. Из этого, в частности, следует,

что мы не можем приписать интервалу x±Δсист какую-либо

определённую доверительную вероятность — она равна 0,68

только если систематическая ошибка имеет нормальное распределение.

Можно, конечно, предположить,

— и так часто делают — что, к примеру, ошибки

при изготовлении линеек на заводе имеют гауссов характер. Также часто

предполагают, что систематическая ошибка имеет равномерное

распределение (то есть «истинное» значение может с равной вероятностью

принять любое значение в пределах интервала ±Δсист).

Строго говоря, для этих предположений нет достаточных оснований.

Пример. В результате измерения диаметра проволоки микрометрическим винтом,

имеющим цену деления h=0,01 мм, получен следующий набор из n=8 значений:

Вычисляем среднее значение: ⟨d⟩≈386,3 мкм.

Среднеквадратичное отклонение:

σd≈9,2 мкм. Случайная погрешность среднего согласно

(2.8):

σ⟨d⟩=σd8≈3,2

мкм. Все результаты лежат в пределах ±2σd, поэтому нет

причин сомневаться в нормальности распределения. Максимальную погрешность

микрометра оценим как половину цены деления, Δ=h2=5 мкм.

Результирующая полная погрешность

σ≤Δ2+σd28≈6,0 мкм.

Видно, что σслуч≈Δсист и проводить дополнительные измерения

особого смысла нет. Окончательно результат измерений может быть представлен

в виде (см. также правила округления

результатов измерений в п. 4.3.2)

d=386±6мкм,εd=1,5%.

Заметим, что поскольку случайная погрешность и погрешность

прибора здесь имеют один порядок величины, наблюдаемый случайный разброс

данных может быть связан как с неоднородностью сечения проволоки,

так и с дефектами микрометра (например, с неровностями зажимов, люфтом

винта, сухим трением, деформацией проволоки под действием микрометра

и т. п.). Для ответа на вопрос, что именно вызвало разброс, требуются

дополнительные исследования, желательно с использованием более точных

приборов.

Пример. Измерение скорости

полёта пули было осуществлено с погрешностью δv=±1 м/c.

Результаты измерений для n=6 выстрелов представлены в таблице:

Усреднённый результат ⟨v⟩=162,0м/с,

среднеквадратичное отклонение σv=13,8м/c, случайная

ошибка для средней скорости

σv¯=σv/6=5,6м/с.

Поскольку разброс экспериментальных данных существенно превышает погрешность

каждого измерения, σv≫δv, он почти наверняка связан

с реальным различием скоростей пули в разных выстрелах, а не с ошибками

измерений. В качестве результата эксперимента представляют интерес

как среднее значение скоростей ⟨v⟩=162±6м/с

(ε≈4%), так и значение σv≈14м/с,

характеризующее разброс значений скоростей от выстрела к выстрелу.

Малая инструментальная погрешность в принципе позволяет более точно

измерить среднее и дисперсию, и исследовать закон распределения выстрелов

по скоростям более детально — для этого требуется набрать

бо́льшую статистику по выстрелам.

Пример. Измерение скорости

полёта пули было осуществлено с погрешностью δv=10 м/c. Результаты

измерений для n=6 выстрелов представлены в таблице:

Усреднённый результат ⟨v⟩=163,3м/с,

σv=12,1м/c, σ⟨v⟩=5м/с,

σполн≈11,2м/с. Инструментальная

погрешность каждого измерения превышает разброс данных, поэтому в

этом опыте затруднительно сделать вывод о различии скоростей от выстрела

к выстрелу. Результат измерений скорости пули:

⟨v⟩=163±11м/с,

ε≈7%. Проводить дополнительные выстрелы при такой

большой инструментальной погрешности особого смысла нет —

лучше поработать над точностью приборов и методикой измерений.

2.6 Обработка косвенных измерений

Косвенными называют измерения, полученные в результате расчётов,

использующих результаты прямых (то есть «непосредственных»)

измерений физических величин. Сформулируем основные правила пересчёта

погрешностей при косвенных измерениях.

2.6.1 Случай одной переменной

Пусть в эксперименте измеряется величина x, а её «наилучшее»

(в некотором смысле) значение равно x⋆ и оно известно с

погрешностью σx. После чего с помощью известной функции

вычисляется величина y=f(x).

В качестве «наилучшего» приближения для y используем значение функции

при «наилучшем» x:

Найдём величину погрешности σy. Обозначая отклонение измеряемой

величины как Δx=x-x⋆, и пользуясь определением производной,

при условии, что функция y(x) — гладкая

вблизи x≈x⋆, запишем

где f′≡dydx — производная фукнции f(x), взятая в точке

x⋆. Возведём полученное в квадрат, проведём усреднение

(σy2=⟨Δy2⟩,

σx2=⟨Δx2⟩), и затем снова извлечём

корень. В результате получим

Пример. Для степенной функции

y=Axn имеем σy=nAxn-1σx, откуда

σyy=nσxx,или εy=nεx,

то есть относительная погрешность степенной функции возрастает пропорционально

показателю степени n.

Пример. Для y=1/x имеем ε1/x=εx

— при обращении величины сохраняется её относительная

погрешность.

Упражнение. Найдите погрешность логарифма y=lnx, если известны x

и σx.

Упражнение. Найдите погрешность показательной функции y=ax,

если известны x и σx. Коэффициент a задан точно.

2.6.2 Случай многих переменных

Пусть величина u вычисляется по измеренным значениям нескольких

различных независимых физических величин x, y, …

на основе известного закона u=f(x,y,…). В качестве

наилучшего значения можно по-прежнему взять значение функции f

при наилучших значениях измеряемых параметров:

Для нахождения погрешности σu воспользуемся свойством,

известным из математического анализа, — малые приращения гладких

функции многих переменных складываются линейно, то есть справедлив

принцип суперпозиции малых приращений:

где символом fx′≡∂f∂x обозначена

частная производная функции f по переменной x —

то есть обычная производная f по x, взятая при условии, что

все остальные аргументы (кроме x) считаются постоянными параметрами.

Тогда пользуясь формулой для нахождения дисперсии суммы независимых

величин (2.7), получим соотношение, позволяющее вычислять

погрешности косвенных измерений для произвольной функции

u=f(x,y,…):

| σu2=fx′2σx2+fy′2σy2+… | (2.11) |

Это и есть искомая общая формула пересчёта погрешностей при косвенных

измерениях.

Отметим, что формулы (2.10) и (2.11) применимы

только если относительные отклонения всех величин малы

(εx,εy,…≪1),

а измерения проводятся вдали от особых точек функции f (производные

fx′, fy′ … не должны обращаться в бесконечность).

Также подчеркнём, что все полученные здесь формулы справедливы только

для независимых переменных x, y, …

Остановимся на некоторых важных частных случаях формулы

(2.11).

Пример. Для суммы (или разности) u=∑i=1naixi имеем

σu2=∑i=1nai2σxi2.

(2.12)

Пример. Найдём погрешность степенной функции:

u=xα⋅yβ⋅…. Тогда нетрудно получить,

что

σu2u2=α2σx2x2+β2σy2y2+…

или через относительные погрешности

εu2=α2εx2+β2εy2+…

(2.13)

Пример. Вычислим погрешность произведения и частного: u=xy или u=x/y.

Тогда в обоих случаях имеем

εu2=εx2+εy2,

(2.14)

то есть при умножении или делении относительные погрешности складываются

квадратично.

Пример. Рассмотрим несколько более сложный случай: нахождение угла по его тангенсу

u=arctgyx.

В таком случае, пользуясь тем, что (arctgz)′=11+z2,

где z=y/x, и используя производную сложной функции, находим

ux′=uz′zx′=-yx2+y2,

uy′=uz′zy′=xx2+y2, и наконец

σu2=y2σx2+x2σy2(x2+y2)2.

Упражнение. Найти погрешность вычисления гипотенузы z=x2+y2

прямоугольного треугольника по измеренным катетам x и y.

По итогам данного раздела можно дать следующие практические рекомендации.

-

•

Как правило, нет смысла увеличивать точность измерения какой-то одной

величины, если другие величины, используемые в расчётах, остаются

измеренными относительно грубо — всё равно итоговая погрешность

скорее всего будет определяться самым неточным измерением. Поэтому

все измерения имеет смысл проводить примерно с одной и той же

относительной погрешностью. -

•

При этом, как следует из (2.13), особое внимание

следует уделять измерению величин, возводимых при расчётах в степени

с большими показателями. А при сложных функциональных зависимостях

имеет смысл детально проанализировать структуру формулы

(2.11):

если вклад от некоторой величины в общую погрешность мал, нет смысла

гнаться за высокой точностью её измерения, и наоборот, точность некоторых

измерений может оказаться критически важной. -

•

Следует избегать измерения малых величин как разности двух близких

значений (например, толщины стенки цилиндра как разности внутреннего

и внешнего радиусов): если u=x-y, то абсолютная погрешность

σu=σx2+σy2

меняется мало, однако относительная погрешность

εu=σux-y

может оказаться неприемлемо большой, если x≈y.

Ошибки первого и второго рода

Выдвинутая гипотеза

может быть правильной или неправильной,

поэтому возникает необходимость её

проверки. Поскольку проверку производят

статистическими методами, её называют

статистической. В итоге статистической

проверки гипотезы в двух случаях может

быть принято неправильное решение, т.

е. могут быть допущены ошибки двух родов.

Ошибка первого

рода состоит в том, что будет отвергнута

правильная гипотеза.

Ошибка второго

рода состоит в том, что будет принята

неправильная гипотеза.

Подчеркнём, что

последствия этих ошибок могут оказаться

весьма различными. Например, если

отвергнуто правильное решение «продолжать

строительство жилого дома», то эта

ошибка первого рода повлечёт материальный

ущерб: если же принято неправильное

решение «продолжать строительство»,

несмотря на опасность обвала стройки,

то эта ошибка второго рода может повлечь

гибель людей. Можно привести примеры,

когда ошибка первого рода влечёт более

тяжёлые последствия, чем ошибка второго

рода.

Замечание 1.

Правильное решение может быть принято

также в двух случаях:

-

гипотеза принимается,

причём и в действительности она

правильная; -

гипотеза отвергается,

причём и в действительности она неверна.

Замечание 2.

Вероятность совершить ошибку первого

рода принято обозначать через

;

её называют уровнем значимости. Наиболее

часто уровень значимости принимают

равным 0,05 или 0,01. Если, например, принят

уровень значимости, равный 0,05, то это

означает, что в пяти случаях из ста

имеется риск допустить ошибку первого

рода (отвергнуть правильную гипотезу).

Статистический

критерий проверки нулевой гипотезы.

Наблюдаемое значение критерия

Для проверки

нулевой гипотезы используют специально

подобранную случайную величину, точное

или приближённое распределение которой

известно. Обозначим эту величину в целях

общности через

.

Статистическим

критерием

(или просто критерием) называют случайную

величину

,

которая служит для проверки нулевой

гипотезы.

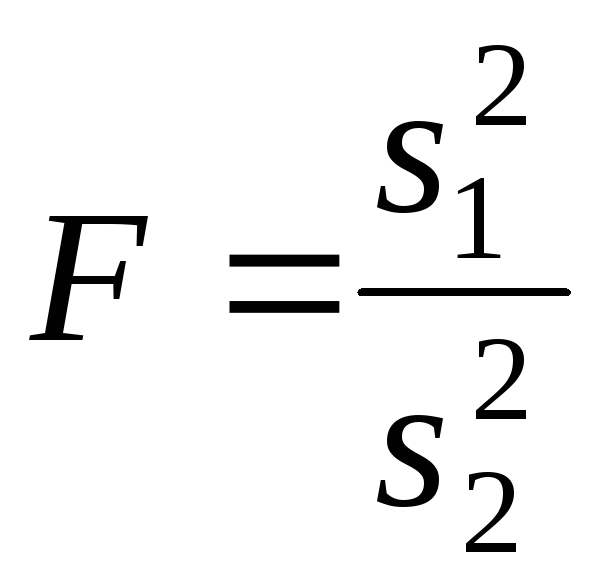

Например, если

проверяют гипотезу о равенстве дисперсий

двух нормальных генеральных совокупностей,

то в качестве критерия

принимают отношение исправленных

выборочных дисперсий:

Эта величина

случайная, потому что в различных опытах

дисперсии принимают различные, наперёд

неизвестные значения, и распределена

по закону Фишера – Снедекора.

Для проверки

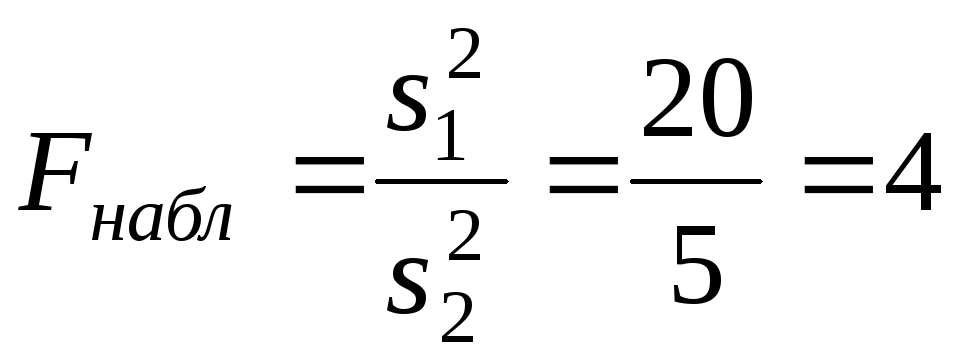

гипотезы по данным выборок вычисляют

частные значения входящих в критерий

величин и таким образом получают частное

(наблюдаемое) значение критерия.

Наблюдаемым

значением

называют значение критерия, вычисленное

по выборкам. Например, если по двум

выборкам найдены исправленные выборочные

дисперсиии

,

то наблюдаемое значение критерия

Критическая

область. Область принятия гипотезы.

Критические точки

После выбора

определённого критерия множество всех

его возможных значений разбивают на

два непересекающихся подмножества:

одно из них содержит значения критерия,

при которых нулевая гипотеза отвергается,

а другая – при которых она принимается.

Критической

областью называют совокупность значений

критерия, при которых нулевую гипотезу

отвергают.

Областью принятия

гипотезы (областью допустимых значений)

называют совокупность значений критерия,

при которых гипотезу принимают.

Основной принцип

проверки статистических гипотез можно

сформулировать так: если наблюдаемое

значение критерия принадлежит критической

области – гипотезу отвергают, если

наблюдаемое значение критерия принадлежит

области принятия гипотезы – гипотезу

принимают.

Поскольку критерий

— одномерная случайная величина, все её

возможные значения принадлежат некоторому

интервалу. Поэтому критическая область

и область принятия гипотезы также

являются интервалами и, следовательно,

существуют точки, которые их разделяют.

Критическими

точками (границами)

называют точки, отделяющие критическую

область от области принятия гипотезы.

Различают

одностороннюю (правостороннюю или

левостороннюю) и двустороннюю критические

области.

Правосторонней

называют критическую область, определяемую

неравенством

>

,

где— положительное число.

Левосторонней

называют критическую область, определяемую

неравенством

<

,

где— отрицательное число.

Односторонней

называют правостороннюю или левостороннюю

критическую область.

Двусторонней

называют критическую область, определяемую

неравенствами

где

.

В частности, если

критические точки симметричны относительно

нуля, двусторонняя критическая область

определяется неравенствами ( в

предположении, что

>0):

,

или равносильным неравенством

.

Отыскание

правосторонней критической области

Как найти критическую

область? Обоснованный ответ на этот

вопрос требует привлечения довольно

сложной теории. Ограничимся её элементами.

Для определённости начнём с нахождения

правосторонней критической области,

которая определяется неравенством

>

,

где>0.

Видим, что для отыскания правосторонней

критической области достаточно найти

критическую точку. Следовательно,

возникает новый вопрос: как её найти?

Для её нахождения

задаются достаточной малой вероятностью

– уровнем значимости

.

Затем ищут критическую точку,

исходя из требования, чтобы при условии

справедливости нулевой гипотезы

вероятность того, критерийпримет значение, большее

,

была равна принятому уровню значимости:

Р(>

)=

.

Для каждого критерия

имеются соответствующие таблицы, по

которым и находят критическую точку,

удовлетворяющую этому требованию.

Замечание 1.

Когда

критическая точка уже найдена, вычисляют

по данным выборок наблюдаемое значение

критерия и, если окажется, что

>

,

то нулевую гипотезу отвергают; если же<

,

то нет оснований, чтобы отвергнуть

нулевую гипотезу.

Пояснение. Почему

правосторонняя критическая область

была определена, исходя из требования,

чтобы при справедливости нулевой

гипотезы выполнялось соотношение

Р(>

)=

?

(*)

Поскольку вероятность

события

>

мала (

— малая вероятность), такое событие при

справедливости нулевой гипотезы, в силу

принципа практической невозможности

маловероятных событий, в единичном

испытании не должно наступить. Если всё

же оно произошло, т.е. наблюдаемое

значение критерия оказалось больше,

то это можно объяснить тем, что нулевая

гипотеза ложна и, следовательно, должна

быть отвергнута. Таким образом, требование

(*) определяет такие значения критерия,

при которых нулевая гипотеза отвергается,

а они и составляют правостороннюю

критическую область.

Замечание 2.

Наблюдаемое значение критерия может

оказаться большим

не потому, что нулевая гипотеза ложна,

а по другим причинам (малый объём выборки,

недостатки методики эксперимента и

др.). В этом случае, отвергнув правильную

нулевую гипотезу, совершают ошибку

первого рода. Вероятность этой ошибки

равна уровню значимости.

Итак, пользуясь требованием (*), мы с

вероятностьюрискуем совершить ошибку первого рода.

Замечание 3. Пусть

нулевая гипотеза принята; ошибочно

думать, что тем самым она доказана.

Действительно, известно, что один пример,

подтверждающий справедливость некоторого

общего утверждения, ещё не доказывает

его. Поэтому более правильно говорить,

«данные наблюдений согласуются с нулевой

гипотезой и, следовательно, не дают

оснований её отвергнуть».

На практике для

большей уверенности принятия гипотезы

её проверяют другими способами или

повторяют эксперимент, увеличив объём

выборки.

Отвергают гипотезу

более категорично, чем принимают.

Действительно, известно, что достаточно

привести один пример, противоречащий

некоторому общему утверждению, чтобы

это утверждение отвергнуть. Если

оказалось, что наблюдаемое значение

критерия принадлежит критической

области, то этот факт и служит примером,

противоречащим нулевой гипотезе, что

позволяет её отклонить.

Отыскание

левосторонней и двусторонней критических

областей***

Отыскание

левосторонней и двусторонней критических

областей сводится (так же, как и для

правосторонней) к нахождению соответствующих

критических точек. Левосторонняя

критическая область определяется

неравенством

<

(

<0).

Критическую точку находят, исходя из

требования, чтобы при справедливости

нулевой гипотезы вероятность того, что

критерий примет значение, меньшее,

была равна принятому уровню значимости:

Р(<

)=

.

Двусторонняя

критическая область определяется

неравенствами

Критические

точки находят, исходя из требования,

чтобы при справедливости нулевой

гипотезы сумма вероятностей того, что

критерий примет значение, меньшееили большее

,

была равна принятому уровню значимости:

.

(*)

Ясно, что критические

точки могут быть выбраны бесчисленным

множеством способов. Если же распределение

критерия симметрично относительно нуля

и имеются основания (например, для

увеличения мощности) выбрать симметричные

относительно нуля точки (-

)и

(

>0),

то

Учитывая (*), получим

.

Это соотношение

и служит для отыскания критических

точек двусторонней критической области.

Критические точки находят по соответствующим

таблицам.

Дополнительные

сведения о выборе критической области.

Мощность критерия

Мы строили

критическую область, исходя из требования,

чтобы вероятность попадания в неё

критерия была равна

при условии, что нулевая гипотеза

справедлива. Оказывается целесообразным

ввести в рассмотрение вероятность

попадания критерия в критическую область

при условии, что нулевая гипотеза неверна

и, следовательно, справедлива конкурирующая.

Мощностью критерия

называют вероятность попадания критерия

в критическую область при условии, что

справедлива конкурирующая гипотеза.

Другими словами, мощность критерия есть

вероятность того, что нулевая гипотеза

будет отвергнута, если верна конкурирующая

гипотеза.

Пусть для проверки

гипотезы принят определённый уровень

значимости и выборка имеет фиксированный

объём. Остаётся произвол в выборе

критической области. Покажем, что её

целесообразно построить так, чтобы

мощность критерия была максимальной.

Предварительно убедимся, что если

вероятность ошибки второго рода (принять

неправильную гипотезу) равна

,

то мощность равна 1-.

Действительно, если— вероятность ошибки второго рода, т.е.

события «принята нулевая гипотеза,

причём справедливо конкурирующая», то

мощность критерия равна 1 —.

Пусть мощность 1

—

возрастает; следовательно, уменьшается

вероятностьсовершить ошибку второго рода. Таким

образом, чем мощность больше, тем

вероятность ошибки второго рода меньше.

Итак, если уровень

значимости уже выбран, то критическую

область следует строить так, чтобы

мощность критерия была максимальной.

Выполнение этого требования должно

обеспечить минимальную ошибку второго

рода, что, конечно, желательно.

Замечание 1.

Поскольку вероятность события «ошибка

второго рода допущена» равна

,

то вероятность противоположного события

«ошибка второго рода не допущена» равна

1 —,

т.е. мощности критерия. Отсюда следует,

что мощность критерия есть вероятность

того, что не будет допущена ошибка

второго рода.

Замечание 2. Ясно,

что чем меньше вероятности ошибок

первого и второго рода, тем критическая

область «лучше». Однако при заданном

объёме выборки уменьшить одновременно

и

невозможно; если уменьшить

,

тобудет возрастать. Например, если принять

=0,

то будут приниматься все гипотезы, в

том числе и неправильные, т.е. возрастает

вероятностьошибки второго рода.

Как же выбрать

наиболее целесообразно? Ответ на этот

вопрос зависит от «тяжести последствий»

ошибок для каждой конкретной задачи.

Например, если ошибка первого рода

повлечёт большие потери, а второго рода

– малые, то следует принять возможно

меньшее.

Если

уже выбрано, то, пользуясь теоремой Ю.

Неймана и Э.Пирсона, можно построить

критическую область, для которойбудет минимальным и, следовательно,

мощность критерия максимальной.

Замечание 3.

Единственный способ одновременного

уменьшения вероятностей ошибок первого

и второго рода состоит в увеличении

объёма выборок.

Соседние файлы в папке Лекции 2 семестр

- #

- #

- #

- #

Результат любого измерения не определён однозначно и имеет случайную составляющую.

Поэтому адекватным языком для описания погрешностей является язык вероятностей.

Тот факт, что значение некоторой величины «случайно», не означает, что

она может принимать совершенно произвольные значения. Ясно, что частоты, с которыми

возникает те или иные значения, различны. Вероятностные законы, которым

подчиняются случайные величины, называют распределениями.

2.1 Случайная величина

Случайной будем называть величину, значение которой не может быть достоверно определено экспериментатором. Чаще всего подразумевается, что случайная величина будет изменяться при многократном повторении одного и того же эксперимента. При интерпретации результатов измерений в физических экспериментах, обычно случайными также считаются величины, значение которых является фиксированным, но не известно экспериментатору. Например смещение нуля шкалы прибора. Для формализации работы со случайными величинами используют понятие вероятности. Численное значение вероятности того, что какая-то величина примет то или иное значение определяется либо как относительная частота наблюдения того или иного значения при повторении опыта большое количество раз, либо как оценка на основе данных других экспериментов.

Замечание.

Хотя понятия вероятности и случайной величины являются основополагающими, в литературе нет единства в их определении. Обсуждение формальных тонкостей или построение строгой теории лежит за пределами данного пособия. Поэтому на начальном этапе лучше использовать «интуитивное» понимание этих сущностей. Заинтересованным читателям рекомендуем обратиться к специальной литературе: [5].

Рассмотрим случайную физическую величину x, которая при измерениях может

принимать непрерывный набор значений. Пусть

P[x0,x0+δx] — вероятность того, что результат окажется вблизи

некоторой точки x0 в пределах интервала δx: x∈[x0,x0+δx].

Устремим интервал

δx к нулю. Нетрудно понять, что вероятность попасть в этот интервал

также будет стремиться к нулю. Однако отношение

w(x0)=P[x0,x0+δx]δx будет оставаться конечным.

Функцию w(x) называют плотностью распределения вероятности или кратко

распределением непрерывной случайной величины x.

Замечание. В математической литературе распределением часто называют не функцию

w(x), а её интеграл W(x)=∫w(x)𝑑x. Такую функцию в физике принято

называть интегральным или кумулятивным распределением. В англоязычной литературе

для этих функций принято использовать сокращения:

pdf (probability distribution function) и

cdf (cumulative distribution function)

соответственно.

Гистограммы.

Проиллюстрируем наглядно понятие плотности распределения. Результат

большого числа измерений случайной величины удобно представить с помощью

специального типа графика — гистограммы.

Для этого область значений x, размещённую на оси абсцисс, разобьём на

равные малые интервалы — «корзины» или «бины» (англ. bins)

некоторого размера h. По оси ординат будем откладывать долю измерений w,

результаты которых попадают в соответствующую корзину. А именно,

пусть k — номер корзины; nk — число измерений, попавших

в диапазон x∈[kh,(k+1)h]. Тогда на графике изобразим «столбик»

шириной h и высотой wk=nk/n.

В результате получим картину, подобную изображённой на рис. 2.1.

σ=1,0, h=0,1, n=104)

Высоты построенных столбиков будут приближённо соответствовать значению

плотности распределения w(x) вблизи соответствующей точки x.

Если устремить число измерений к бесконечности (n→∞), а ширину корзин

к нулю (h→0), то огибающая гистограммы будет стремиться к некоторой

непрерывной функции w(x).

Самые высокие столбики гистограммы будут группироваться вблизи максимума

функции w(x) — это наиболее вероятное значение случайной величины.

Если отклонения в положительную и отрицательную стороны равновероятны,

то гистограмма будет симметрична — в таком случае среднее значение ⟨x⟩

также будет лежать вблизи этого максимума. Ширина гистограммы будет характеризовать разброс

значений случайной величины — по порядку величины

она, как правило, близка к среднеквадратичному отклонению sx.

Свойства распределений.

Из определения функции w(x) следует, что вероятность получить в результате

эксперимента величину x в диапазоне от a до b

можно найти, вычислив интеграл:

| Px∈[a,b]=∫abw(x)𝑑x. | (2.1) |

Согласно определению вероятности, сумма вероятностей для всех возможных случаев

всегда равна единице. Поэтому интеграл распределения w(x) по всей области

значений x (то есть суммарная площадь под графиком w(x)) равен единице:

Это соотношение называют условием нормировки.

Среднее и дисперсия.

Вычислим среднее по построенной гистограмме. Если размер корзин

h достаточно мал, все измерения в пределах одной корзины можно считать примерно

одинаковыми. Тогда среднее арифметическое всех результатов можно вычислить как

Переходя к пределу, получим следующее определение среднего значения

случайной величины:

где интегрирование ведётся по всей области значений x.

В теории вероятностей x¯ также называют математическим ожиданием

распределения.

Величину

| σ2=(x-x¯)2¯=∫(x-x¯)2w𝑑x | (2.3) |

называют дисперсией распределения. Значение σ есть

срекднеквадратичное отклонение в пределе n→∞. Оно имеет ту

же размерность, что и сама величина x и характеризует разброс распределения.

Именно эту величину, как правило, приводят как характеристику погрешности

измерения x.

Доверительный интервал.

Обозначим как P|Δx|<δ вероятность

того, что отклонение от среднего Δx=x-x¯ составит величину,

не превосходящую по модулю значение δ:

| P|Δx|<δ=∫x¯-δx¯+δw(x)𝑑x. | (2.4) |

Эту величину называют доверительной вероятностью для

доверительного интервала |x-x¯|≤δ.

2.2 Нормальное распределение

Одним из наиболее примечательных результатов теории вероятностей является

так называемая центральная предельная теорема. Она утверждает,

что сумма большого количества независимых случайных слагаемых, каждое

из которых вносит в эту сумму относительно малый вклад, подчиняется

универсальному закону, не зависимо от того, каким вероятностным законам

подчиняются её составляющие, — так называемому нормальному

распределению (или распределению Гаусса).

Доказательство теоремы довольно громоздко и мы его не приводим (его можно найти

в любом учебнике по теории вероятностей). Остановимся

кратко на том, что такое нормальное распределение и его основных свойствах.

Плотность нормального распределения выражается следующей формулой:

| w𝒩(x)=12πσe-(x-x¯)22σ2. | (2.5) |

Здесь x¯ и σ

— параметры нормального распределения: x¯ равно

среднему значению x, a σ —

среднеквадратичному отклонению, вычисленным в пределе n→∞.

Как видно из рис. 2.1, распределение представляет собой

симметричный

«колокол», положение вершины которого

соответствует x¯ (ввиду симметрии оно же

совпадает с наиболее вероятным значением — максимумом

функции w𝒩(x)).

При значительном отклонении x от среднего величина

w𝒩(x)

очень быстро убывает. Это означает, что вероятность встретить отклонения,

существенно большие, чем σ, оказывается пренебрежимо

мала. Ширина «колокола» по порядку величины

равна σ — она характеризует «разброс»

экспериментальных данных относительно среднего значения.

Замечание. Точки x=x¯±σ являются точками

перегиба графика w(x) (в них вторая производная по x

обращается в нуль, w′′=0), а их положение по высоте составляет

w(x¯±σ)/w(x¯)=e-1/2≈0,61

от высоты вершины.

Универсальный характер центральной предельной теоремы позволяет широко

применять на практике нормальное (гауссово) распределение для обработки

результатов измерений, поскольку часто случайные погрешности складываются из

множества случайных независимых факторов. Заметим, что на практике

для приближённой оценки параметров нормального распределения

случайной величины используются выборочные значения среднего

и дисперсии: x¯≈⟨x⟩, sx≈σx.

x-x0σ2=2w(x)σ1=1

Доверительные вероятности.

Вычислим некоторые доверительные вероятности (2.4) для нормально

распределённых случайных величин.

Замечание. Значение интеграла вида ∫e-x2/2𝑑x

(его называют интегралом ошибок) в элементарных функциях не выражается,

но легко находится численно.

Вероятность того, что результат отдельного измерения x окажется

в пределах x¯±σ оказывается равна

| P|Δx|<σ=∫x¯-σx¯+σw𝒩𝑑x≈0,68. |

Вероятность отклонения в пределах x¯±2σ:

а в пределах x¯±3σ:

Иными словами, при большом числе измерений нормально распределённой

величины можно ожидать, что лишь треть измерений выпадут за пределы интервала

[x¯-σ,x¯+σ]. При этом около 5%

измерений выпадут за пределы [x¯-2σ;x¯+2σ],

и лишь 0,27% окажутся за пределами

[x¯-3σ;x¯+3σ].

Пример. В сообщениях об открытии бозона Хиггса на Большом адронном коллайдере

говорилось о том, что исследователи ждали подтверждение результатов

с точностью «5 сигма». Используя нормальное распределение (2.5)

нетрудно посчитать, что они использовали доверительную вероятность

P≈1-5,7⋅10-7=0,99999943. Такую точность можно назвать фантастической.

Полученные значения доверительных вероятностей используются при

стандартной записи результатов измерений. В физических измерениях

(в частности, в учебной лаборатории), как правило, используется P=0,68,

то есть, запись

означает, что измеренное значение лежит в диапазоне (доверительном

интервале) x∈[x¯-δx;x¯+δx] с

вероятностью 68%. Таким образом погрешность ±δx считается

равной одному среднеквадратичному отклонению: δx=σ.

В технических измерениях чаще используется P=0,95, то есть под

абсолютной погрешностью имеется в виду удвоенное среднеквадратичное

отклонение, δx=2σ. Во избежание разночтений доверительную

вероятность следует указывать отдельно.

Замечание. Хотя нормальный закон распределения встречается на практике довольно

часто, стоит помнить, что он реализуется далеко не всегда.

Полученные выше соотношения для вероятностей попадания значений в

доверительные интервалы можно использовать в качестве простейшего

признака нормальности распределения: в частности, если количество попадающих

в интервал ±σ результатов существенно отличается от 2/3 — это повод

для более детального исследования закона распределения ошибок.

Сравнение результатов измерений.

Теперь мы можем дать количественный критерий для сравнения двух измеренных

величин или двух результатов измерения одной и той же величины.

Пусть x1 и x2 (x1≠x2) измерены с

погрешностями σ1 и σ2 соответственно.

Ясно, что если различие результатов |x2-x1| невелико,

его можно объяснить просто случайными отклонениями.

Если же теория предсказывает, что вероятность обнаружить такое отклонение

слишком мала, различие результатов следует признать значимым.

Предварительно необходимо договориться о соответствующем граничном значении

вероятности. Универсального значения здесь быть не может,

поэтому приходится полагаться на субъективный выбор исследователя. Часто

в качестве «разумной» границы выбирают вероятность 5%,

что, как видно из изложенного выше, для нормального распределения

соответствует отклонению более, чем на 2σ.

Допустим, одна из величин известна с существенно большей точностью:

σ2≪σ1 (например, x1 — результат, полученный

студентом в лаборатории, x2 — справочное значение).

Поскольку σ2 мало, x2 можно принять за «истинное»:

x2≈x¯. Предполагая, что погрешность измерения

x1 подчиняется нормальному закону с и дисперсией σ12,

можно утверждать, что

различие считают будет значимы, если

Пусть погрешности измерений сравнимы по порядку величины:

σ1∼σ2. В теории вероятностей показывается, что

линейная комбинация нормально распределённых величин также имеет нормальное

распределение с дисперсией σ2=σ12+σ22

(см. также правила сложения погрешностей (2.7)). Тогда

для проверки гипотезы о том, что x1 и x2 являются измерениями

одной и той же величины, нужно вычислить, является ли значимым отклонение

|x1-x2| от нуля при σ=σ12+σ22.

Пример. Два студента получили следующие значения для теплоты испарения

некоторой жидкости: x1=40,3±0,2 кДж/моль и

x2=41,0±0,3 кДж/моль, где погрешность соответствует

одному стандартному отклонению. Можно ли утверждать, что они исследовали

одну и ту же жидкость?

Имеем наблюдаемую разность |x1-x2|=0,7 кДж/моль,

среднеквадратичное отклонение для разности

σ=0,22+0,32=0,36 кДж/моль.

Их отношение |x2-x1|σ≈2. Из

свойств нормального распределения находим вероятность того, что измерялась

одна и та же величина, а различия в ответах возникли из-за случайных

ошибок: P≈5%. Ответ на вопрос, «достаточно»

ли мала или велика эта вероятность, остаётся на усмотрение исследователя.

Замечание. Изложенные здесь соображения применимы, только если x¯ и

его стандартное отклонение σ получены на основании достаточно

большой выборки n≫1 (или заданы точно). При небольшом числе измерений

(n≲10) выборочные средние ⟨x⟩ и среднеквадратичное отклонение

sx сами имеют довольно большую ошибку, а

их распределение будет описываться не нормальным законом, а так

называемым t-распределением Стъюдента. В частности, в зависимости от

значения n интервал ⟨x⟩±sx будет соответствовать несколько

меньшей доверительной вероятности, чем P=0,68. Особенно резко различия

проявляются при высоких уровнях доверительных вероятностей P→1.

2.3 Независимые величины

Величины x и y называют независимыми если результат измерения одной

из них никак не влияет на результат измерения другой. Для таких величин вероятность того, что x окажется в некоторой области X, и одновременно y — в области Y,

равна произведению соответствующих вероятностей:

Обозначим отклонения величин от их средних как Δx=x-x¯ и

Δy=y-y¯.

Средние значения этих отклонений равны, очевидно, нулю: Δx¯=x¯-x¯=0,

Δy¯=0. Из независимости величин x и y следует,

что среднее значение от произведения Δx⋅Δy¯

равно произведению средних Δx¯⋅Δy¯

и, следовательно, равно нулю:

| Δx⋅Δy¯=Δx¯⋅Δy¯=0. | (2.6) |

Пусть измеряемая величина z=x+y складывается из двух независимых

случайных слагаемых x и y, для которых известны средние

x¯ и y¯, и их среднеквадратичные погрешности

σx и σy. Непосредственно из определения (1.1)

следует, что среднее суммы равно сумме средних:

Найдём дисперсию σz2. В силу независимости имеем

| Δz2¯=Δx2¯+Δy2¯+2Δx⋅Δy¯≈Δx2¯+Δy2¯, |

то есть:

Таким образом, при сложении независимых величин их погрешности

складываются среднеквадратичным образом.

Подчеркнём, что для справедливости соотношения (2.7)

величины x и y не обязаны быть нормально распределёнными —

достаточно существования конечных значений их дисперсий. Однако можно

показать, что если x и y распределены нормально, нормальным

будет и распределение их суммы.

Замечание. Требование независимости

слагаемых является принципиальным. Например, положим y=x. Тогда

z=2x. Здесь y и x, очевидно, зависят друг от друга. Используя

(2.7), находим σ2x=2σx,

что, конечно, неверно — непосредственно из определения

следует, что σ2x=2σx.

Отдельно стоит обсудить математическую структуру формулы (2.7).

Если одна из погрешностей много больше другой, например,

σx≫σy,

то меньшей погрешностью можно пренебречь, σx+y≈σx.

С другой стороны, если два источника погрешностей имеют один порядок

σx∼σy, то и σx+y∼σx∼σy.

Эти обстоятельства важны при планирования эксперимента: как правило,

величина, измеренная наименее точно, вносит наибольший вклад в погрешность

конечного результата. При этом, пока не устранены наиболее существенные

ошибки, бессмысленно гнаться за повышением точности измерения остальных

величин.

Пример. Пусть σy=σx/3,

тогда σz=σx1+19≈1,05σx,

то есть при различии двух погрешностей более, чем в 3 раза, поправка

к погрешности составляет менее 5%, и уже нет особого смысла в учёте

меньшей погрешности: σz≈σx. Это утверждение

касается сложения любых независимых источников погрешностей в эксперименте.

2.4 Погрешность среднего

Выборочное среднее арифметическое значение ⟨x⟩, найденное

по результатам n измерений, само является случайной величиной.

Действительно, если поставить серию одинаковых опытов по n измерений,

то в каждом опыте получится своё среднее значение, отличающееся от

предельного среднего x¯.

Вычислим среднеквадратичную погрешность среднего арифметического

σ⟨x⟩.

Рассмотрим вспомогательную сумму n слагаемых

Если {xi} есть набор независимых измерений

одной и той же физической величины, то мы можем, применяя результат

(2.7) предыдущего параграфа, записать

| σZ=σx12+σx22+…+σxn2=nσx, |

поскольку под корнем находится n одинаковых слагаемых. Отсюда с

учётом ⟨x⟩=Z/n получаем

Таким образом, погрешность среднего значения x по результатам

n независимых измерений оказывается в n раз меньше погрешности

отдельного измерения. Это один из важнейших результатов, позволяющий

уменьшать случайные погрешности эксперимента за счёт многократного

повторения измерений.

Подчеркнём отличия между σx и σ⟨x⟩:

величина σx — погрешность отдельного

измерения — является характеристикой разброса значений

в совокупности измерений {xi}, i=1..n. При

нормальном законе распределения примерно 68% измерений попадают в

интервал ⟨x⟩±σx;

величина σ⟨x⟩ — погрешность

среднего — характеризует точность, с которой определено

среднее значение измеряемой физической величины ⟨x⟩ относительно

предельного («истинного») среднего x¯;

при этом с доверительной вероятностью P=68% искомая величина x¯

лежит в интервале

⟨x⟩-σ⟨x⟩<x¯<⟨x⟩+σ⟨x⟩.

2.5 Результирующая погрешность опыта

Пусть для некоторого результата измерения известна оценка его максимальной

систематической погрешности Δсист и случайная

среднеквадратичная

погрешность σслуч. Какова «полная»

погрешность измерения?

Предположим для простоты, что измеряемая величина в принципе

может быть определена сколь угодно точно, так что можно говорить о

некотором её «истинном» значении xист

(иными словами, погрешность результата связана в основном именно с

процессом измерения). Назовём полной погрешностью измерения

среднеквадратичное значения отклонения от результата измерения от

«истинного»:

Отклонение x-xист можно представить как сумму случайного

отклонения от среднего δxслуч=x-x¯

и постоянной (но, вообще говоря, неизвестной) систематической составляющей

δxсист=x¯-xист=const:

Причём случайную составляющую можно считать независимой от систематической.

В таком случае из (2.7) находим:

| σполн2=⟨δxсист2⟩+⟨δxслуч2⟩≤Δсист2+σслуч2. | (2.9) |

Таким образом, для получения максимального значения полной

погрешности некоторого измерения нужно квадратично сложить максимальную

систематическую и случайную погрешности.

Если измерения проводятся многократно, то согласно (2.8)

случайная составляющая погрешности может быть уменьшена, а систематическая

составляющая при этом остаётся неизменной:

Отсюда следует важное практическое правило

(см. также обсуждение в п. 2.3): если случайная погрешность измерений

в 2–3 раза меньше предполагаемой систематической, то

нет смысла проводить многократные измерения в попытке уменьшить погрешность

всего эксперимента. В такой ситуации измерения достаточно повторить

2–3 раза — чтобы убедиться в повторяемости результата, исключить промахи

и проверить, что случайная ошибка действительно мала.

В противном случае повторение измерений может иметь смысл до

тех пор, пока погрешность среднего

σ⟨x⟩=σxn

не станет меньше систематической.

Замечание. Поскольку конкретная

величина систематической погрешности, как правило, не известна, её

можно в некотором смысле рассматривать наравне со случайной —

предположить, что её величина была определена по некоторому случайному

закону перед началом измерений (например, при изготовлении линейки

на заводе произошло некоторое случайное искажение шкалы). При такой

трактовке формулу (2.9) можно рассматривать просто

как частный случай формулы сложения погрешностей независимых величин

(2.7).

Подчеркнем, что вероятностный закон, которому подчиняется

систематическая ошибка, зачастую неизвестен. Поэтому неизвестно и

распределение итогового результата. Из этого, в частности, следует,

что мы не можем приписать интервалу x±Δсист какую-либо

определённую доверительную вероятность — она равна 0,68

только если систематическая ошибка имеет нормальное распределение.

Можно, конечно, предположить,

— и так часто делают — что, к примеру, ошибки

при изготовлении линеек на заводе имеют гауссов характер. Также часто

предполагают, что систематическая ошибка имеет равномерное

распределение (то есть «истинное» значение может с равной вероятностью

принять любое значение в пределах интервала ±Δсист).

Строго говоря, для этих предположений нет достаточных оснований.

Пример. В результате измерения диаметра проволоки микрометрическим винтом,

имеющим цену деления h=0,01 мм, получен следующий набор из n=8 значений:

Вычисляем среднее значение: ⟨d⟩≈386,3 мкм.

Среднеквадратичное отклонение:

σd≈9,2 мкм. Случайная погрешность среднего согласно

(2.8):

σ⟨d⟩=σd8≈3,2

мкм. Все результаты лежат в пределах ±2σd, поэтому нет

причин сомневаться в нормальности распределения. Максимальную погрешность

микрометра оценим как половину цены деления, Δ=h2=5 мкм.

Результирующая полная погрешность

σ≤Δ2+σd28≈6,0 мкм.

Видно, что σслуч≈Δсист и проводить дополнительные измерения

особого смысла нет. Окончательно результат измерений может быть представлен

в виде (см. также правила округления

результатов измерений в п. 4.3.2)

d=386±6мкм,εd=1,5%.

Заметим, что поскольку случайная погрешность и погрешность

прибора здесь имеют один порядок величины, наблюдаемый случайный разброс

данных может быть связан как с неоднородностью сечения проволоки,

так и с дефектами микрометра (например, с неровностями зажимов, люфтом

винта, сухим трением, деформацией проволоки под действием микрометра

и т. п.). Для ответа на вопрос, что именно вызвало разброс, требуются

дополнительные исследования, желательно с использованием более точных

приборов.

Пример. Измерение скорости

полёта пули было осуществлено с погрешностью δv=±1 м/c.

Результаты измерений для n=6 выстрелов представлены в таблице:

Усреднённый результат ⟨v⟩=162,0м/с,

среднеквадратичное отклонение σv=13,8м/c, случайная

ошибка для средней скорости

σv¯=σv/6=5,6м/с.

Поскольку разброс экспериментальных данных существенно превышает погрешность

каждого измерения, σv≫δv, он почти наверняка связан

с реальным различием скоростей пули в разных выстрелах, а не с ошибками

измерений. В качестве результата эксперимента представляют интерес

как среднее значение скоростей ⟨v⟩=162±6м/с

(ε≈4%), так и значение σv≈14м/с,

характеризующее разброс значений скоростей от выстрела к выстрелу.

Малая инструментальная погрешность в принципе позволяет более точно

измерить среднее и дисперсию, и исследовать закон распределения выстрелов

по скоростям более детально — для этого требуется набрать

бо́льшую статистику по выстрелам.

Пример. Измерение скорости

полёта пули было осуществлено с погрешностью δv=10 м/c. Результаты

измерений для n=6 выстрелов представлены в таблице:

Усреднённый результат ⟨v⟩=163,3м/с,

σv=12,1м/c, σ⟨v⟩=5м/с,

σполн≈11,2м/с. Инструментальная

погрешность каждого измерения превышает разброс данных, поэтому в

этом опыте затруднительно сделать вывод о различии скоростей от выстрела

к выстрелу. Результат измерений скорости пули:

⟨v⟩=163±11м/с,

ε≈7%. Проводить дополнительные выстрелы при такой

большой инструментальной погрешности особого смысла нет —

лучше поработать над точностью приборов и методикой измерений.

2.6 Обработка косвенных измерений

Косвенными называют измерения, полученные в результате расчётов,

использующих результаты прямых (то есть «непосредственных»)

измерений физических величин. Сформулируем основные правила пересчёта

погрешностей при косвенных измерениях.

2.6.1 Случай одной переменной

Пусть в эксперименте измеряется величина x, а её «наилучшее»

(в некотором смысле) значение равно x⋆ и оно известно с

погрешностью σx. После чего с помощью известной функции

вычисляется величина y=f(x).

В качестве «наилучшего» приближения для y используем значение функции

при «наилучшем» x:

Найдём величину погрешности σy. Обозначая отклонение измеряемой

величины как Δx=x-x⋆, и пользуясь определением производной,

при условии, что функция y(x) — гладкая

вблизи x≈x⋆, запишем

где f′≡dydx — производная фукнции f(x), взятая в точке

x⋆. Возведём полученное в квадрат, проведём усреднение

(σy2=⟨Δy2⟩,

σx2=⟨Δx2⟩), и затем снова извлечём

корень. В результате получим

Пример. Для степенной функции

y=Axn имеем σy=nAxn-1σx, откуда

σyy=nσxx,или εy=nεx,

то есть относительная погрешность степенной функции возрастает пропорционально

показателю степени n.

Пример. Для y=1/x имеем ε1/x=εx

— при обращении величины сохраняется её относительная

погрешность.

Упражнение. Найдите погрешность логарифма y=lnx, если известны x

и σx.

Упражнение. Найдите погрешность показательной функции y=ax,

если известны x и σx. Коэффициент a задан точно.

2.6.2 Случай многих переменных

Пусть величина u вычисляется по измеренным значениям нескольких

различных независимых физических величин x, y, …

на основе известного закона u=f(x,y,…). В качестве

наилучшего значения можно по-прежнему взять значение функции f

при наилучших значениях измеряемых параметров:

Для нахождения погрешности σu воспользуемся свойством,

известным из математического анализа, — малые приращения гладких

функции многих переменных складываются линейно, то есть справедлив

принцип суперпозиции малых приращений:

где символом fx′≡∂f∂x обозначена

частная производная функции f по переменной x —

то есть обычная производная f по x, взятая при условии, что

все остальные аргументы (кроме x) считаются постоянными параметрами.

Тогда пользуясь формулой для нахождения дисперсии суммы независимых

величин (2.7), получим соотношение, позволяющее вычислять

погрешности косвенных измерений для произвольной функции

u=f(x,y,…):

| σu2=fx′2σx2+fy′2σy2+… | (2.11) |

Это и есть искомая общая формула пересчёта погрешностей при косвенных

измерениях.

Отметим, что формулы (2.10) и (2.11) применимы

только если относительные отклонения всех величин малы

(εx,εy,…≪1),

а измерения проводятся вдали от особых точек функции f (производные

fx′, fy′ … не должны обращаться в бесконечность).

Также подчеркнём, что все полученные здесь формулы справедливы только

для независимых переменных x, y, …

Остановимся на некоторых важных частных случаях формулы

(2.11).

Пример. Для суммы (или разности) u=∑i=1naixi имеем

σu2=∑i=1nai2σxi2.

(2.12)

Пример. Найдём погрешность степенной функции:

u=xα⋅yβ⋅…. Тогда нетрудно получить,

что

σu2u2=α2σx2x2+β2σy2y2+…

или через относительные погрешности

εu2=α2εx2+β2εy2+…

(2.13)

Пример. Вычислим погрешность произведения и частного: u=xy или u=x/y.

Тогда в обоих случаях имеем

εu2=εx2+εy2,

(2.14)

то есть при умножении или делении относительные погрешности складываются

квадратично.

Пример. Рассмотрим несколько более сложный случай: нахождение угла по его тангенсу

u=arctgyx.

В таком случае, пользуясь тем, что (arctgz)′=11+z2,

где z=y/x, и используя производную сложной функции, находим

ux′=uz′zx′=-yx2+y2,

uy′=uz′zy′=xx2+y2, и наконец

σu2=y2σx2+x2σy2(x2+y2)2.

Упражнение. Найти погрешность вычисления гипотенузы z=x2+y2

прямоугольного треугольника по измеренным катетам x и y.

По итогам данного раздела можно дать следующие практические рекомендации.

- •

Как правило, нет смысла увеличивать точность измерения какой-то одной

величины, если другие величины, используемые в расчётах, остаются

измеренными относительно грубо — всё равно итоговая погрешность

скорее всего будет определяться самым неточным измерением. Поэтому

все измерения имеет смысл проводить примерно с одной и той же

относительной погрешностью. - •

При этом, как следует из (2.13), особое внимание

следует уделять измерению величин, возводимых при расчётах в степени

с большими показателями. А при сложных функциональных зависимостях

имеет смысл детально проанализировать структуру формулы

(2.11):

если вклад от некоторой величины в общую погрешность мал, нет смысла

гнаться за высокой точностью её измерения, и наоборот, точность некоторых

измерений может оказаться критически важной. - •

Следует избегать измерения малых величин как разности двух близких

значений (например, толщины стенки цилиндра как разности внутреннего

и внешнего радиусов): если u=x-y, то абсолютная погрешность

σu=σx2+σy2

меняется мало, однако относительная погрешность

εu=σux-y

может оказаться неприемлемо большой, если x≈y.

5.3. Ошибки первого и второго рода

Ошибка первого рода состоит в том, что гипотеза будет отвергнута, хотя на самом деле она правильная. Вероятность

допустить такую ошибку называют уровнем значимости и обозначают буквой («альфа»).

Ошибка второго рода состоит в том, что гипотеза будет принята, но на самом деле она неправильная. Вероятность

совершить эту ошибку обозначают буквой («бета»). Значение

называют мощностью критерия – это вероятность отвержения неправильной

гипотезы.

В практических задачах, как правило, задают уровень значимости, наиболее часто выбирают значения .

И тут возникает мысль, что чем меньше «альфа», тем вроде бы лучше. Но это только вроде: при уменьшении

вероятности —

отвергнуть правильную гипотезу растёт вероятность — принять неверную гипотезу (при прочих равных условиях).

Поэтому перед исследователем стоит задача грамотно подобрать соотношение вероятностей и

, при этом учитывается тяжесть последствий, которые

повлекут за собой та и другая ошибки.

Понятие ошибок 1-го и 2-го рода используется не только в статистике, и для лучшего понимания я приведу пару

нестатистических примеров.

Петя зарегистрировался в почтовике. По умолчанию, – он считается добропорядочным пользователем. Так считает антиспам

фильтр. И вот Петя отправляет письмо. В большинстве случаев всё произойдёт, как должно произойти – нормальное письмо дойдёт до

адресата (правильное принятие нулевой гипотезы), а спамное – попадёт в спам (правильное отвержение). Однако фильтр может

совершить ошибку двух типов:

1) с вероятностью ошибочно отклонить нулевую гипотезу (счесть нормальное письмо

за спам и Петю за спаммера) или

2) с вероятностью ошибочно принять нулевую гипотезу (хотя Петя редиска).

Какая ошибка более «тяжелая»? Петино письмо может быть ОЧЕНЬ важным для адресата, и поэтому при настройке фильтра

целесообразно уменьшить уровень значимости , «пожертвовав» вероятностью

(увеличив её). В результате в основной ящик будут попадать все

«подозрительные» письма, в том числе особо талантливых спаммеров. …Такое и почитать даже можно, ведь сделано с любовью

Существует примеры, где наоборот – более тяжкие последствия влечёт ошибка 2-го рода, и вероятность следует увеличить (в пользу уменьшения

вероятности ). Не хотел я

приводить подобные примеры, и даже отшутился на сайте, но по какой-то мистике через пару месяцев сам столкнулся с непростой

дилеммой. Видимо, таки, надо рассказать:

У человека появилась серьёзная болячка. В медицинской практике её принято лечить (основное «нулевое» решение). Лечение

достаточно эффективно, однако не гарантирует результата и более того опасно (иногда приводит к серьёзному пожизненному

увечью). С другой стороны, если не лечить, то возможны осложнения и долговременные функциональные нарушения.

Вопрос: что делать? И ответ не так-то прост – в разных ситуациях разные люди могут принять разные

решения (упаси вас).

Если болезнь не особо «мешает жить», то более тяжёлые последствия повлечёт ошибка 2-го рода – когда человек соглашается

на лечение, но получает фатальный результат (принимает, как оказалось, неверное «нулевое» решение). Если же…, нет, пожалуй,

достаточно, возвращаемся к теме:

| Оглавление |